研表究明,文字的序顺并不定一能响影GPT-4读阅

深度学习自然语言处理 原创

作者:yy

很多年前,你一定在互联网上看过这张图,展示了人脑能够阅读和理解打乱顺序的单词和句子!而最近东京大学的研究发现,大语言模型(LLMs) 尤其是 GPT-4,也可以读懂打乱顺序的单词,甚至是在人脑都难以分辨的情况下!

论文:Unnatural Error Correction: GPT-4 Can Almost Perfectly Handle Unnatural Scrambled Text

地址:https://arxiv.org/pdf/2311.18805.pdf

代码:https://github.com/ccqq77/unnatural-error-correction.

前言

“Typoglycemia” 这个词曾在互联网上风靡一时,它是由“打字错误(Typo)”和“低血糖(Hypoglycemia)” 这两个单词拼凑而成。通俗地讲,”Typoglycemia“ 指一个有趣的现象:只要每个单词的首尾字母正确,即使中间的字母顺序是完全打乱的,也不影响人类的正常阅读与理解。

而这篇研究发现,大多数强大的 LLMs 都具备类似于 “typoglycemia” 的超能力。更令人惊讶的是,作者发现,即使每个单词中的所有字母都是乱序, 仍有且并仅有 GPT-4 能近乎完美地从乱序中恢复原始句子,将编辑距离减少 95%!尽管乱码文本对输入 tokenization 造成了严重破坏,但 LLMs 仍能表现出如此强大的恢复能力!

任务设计

为了评估 LLMs 处理乱序文本的能力,作者提出了 Scrambled Bench ,包含两个任务(如图所示)。

1. 乱序句子恢复(ScrRec)

提供包含乱序词的句子,要求LLMs恢复出原始句子。这项任务可以直接评估 LLMs 识别和重建句子中乱序词的能力。

2. 乱序问题解答(ScrQA)

如果模型在 ScrRec 任务中表现不佳,可能有两个原因:

(1) 模型难以遵循指令;

(2) 模型无法恢复句子。

为了区分这两种情况,作者设计了 ScrQA 任务来评估模型在乱序语境下完成标准任务(即 QA )的能力。具体而言,作者将包含了回答问题所需基本信息的文本打乱,并根据模型表现的差异对其进行评估。

数据集构建

RealtimeQA(2022年)

RealtimeQA 是一个动态的问题解答数据集,每周都会公布有关近期新闻的问题。为了缓解数据污染,作者从 RealtimeQA 中收集最近的数据(2023/03/17-2023/08/04),并对证据句进行加扰处理,以构建 ScrRec 和 ScrQA 任务的样本。

DREAM(2019年)

DREAM 是一个基于对话的多选阅读理解数据集。作者对每个问题的对话部分进行了加扰处理。

AQuARAT(2017年)

AQuA-RAT 是一个数学单词问题数据集,需要多步推理才能解决。作者采用了 few-shot Chain of Thought(CoT),并对主问题和示例问题都加入扰动。

对于每个数据集,作者使用不同的扰动类型和比例生成扰动文本。

1. 随机扰动(RS)

对于每个句子,随机选择一定比例(20%、50%、100%)的单词,并随机扰乱每个选定单词中的所有字母(阿拉伯数字保持不变)。

2. 保留第一个字母(KF)

保持每个单词的第一个字母不变,并随机扰乱其他位置的字母。

3. 保留首尾字母(KFL)

保持每个单词的第一个和最后一个字母不变,并随机扰乱其他位置的字母。

评价指标

Recovery Rate (RR)

对于 ScrRec 任务,原始句子与恢复句子之间的平均编辑距离(ED)是一种自然的性能度量指标。

此外,作者还定义了 Recovery Rate(RR)来衡量 ED 在恢复的句子中所占的比例,从而可以更简明地比较不同设置下模型的性能:

Relative Performance Gain (RPG)

对于 ScrQA 而言,accuracy 是衡量性能的一个自然指标。但是由于不同模型在处理原始问题时的能力存在差异,很难比较不同模型的性能。

因此,作者引入了 Relative Performance Gain(RPG),将评估重点放在与原始文本相比,模型理解扰动文本的能力上:

实验设置

作者评估了最强大的闭源 LLM,包括 text-davinci-003、GPT-3.5-turbo 和 GPT-4,以及 Falcon 系列、Llama-2 系列、MPT 系列、UL2 系列、T5 系列等开源模型。对于各数据集和任务,采取了以下设置:

RealtimeQA

ScrRec:zero-shot + few-shot

ScrQA:zero-shot

DREAM

ScrQA :zero-shot

AQuA

ScrQA :few-shot COT

结果分析

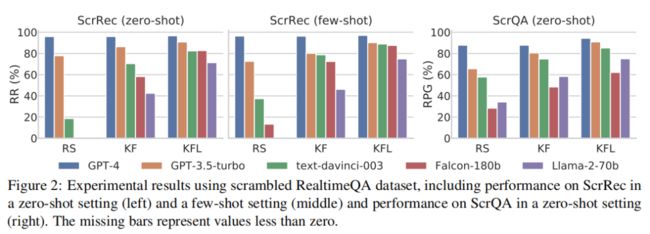

由于篇幅等原因,仅展示性能最好的五种 LLM(即 GPT4、GPT-3.5-turbo、text-davinci-003、Falcon-180b 和 Llama-2-70b)的结果。

结果 1:扰动类型

实验结果表明,在 KFL 设置下,各模型之间的性能差距不大。然而,除 GPT-4 外,随着扰动类型难度的增加(KFL ➡ KF ➡ RS),模型性能明显下降。相比之下,GPT-4 的性能始终保持在较高水平,而与扰动类型无关。在 ScrRec 任务上,GPT-4 的 RR 在所有设置下都保持在 95% 以上。在 ScrQA 任务上,GPT-4 的表现一直优于其他模型,即使扰动的难度增加,也能保持较高的准确率。

结果 2:扰动比例

随着扰动比例的增加,text-davinci-003、Falcon-180b 和 Llama-2-70b 的 RR 会降低。GPT-3.5-turbo 和 GPT-4 的 RR 变化不大。GPT-4 的表现远远优于其他模型,大多数设置下的 RR 都高于 95%(20% 扰动率除外)。

所有模型的 RPG 都随着扰动比例的增加而下降。但 GPT-4 即使在 100%加扰证据的情况下,仍能保持 87.8% 的原有性能。随着扰动比例的增加,不同模型之间的性能差距也越来越大。

结果 3:其他数据集

在加扰的 DREAM 数据集上,除了评估整体性能,作者还评估了不同类别问题的性能。结果显示,GPT-4 与其他模型间的差异比在 RealtimeQA 上更加突出,这可能由于 DREAM 需要对较长文本进行深层次理解。与其他类别相比,模型在算术问题上的表现往往更容易受到乱序文本的影响,即使是 GPT-4 也是如此。

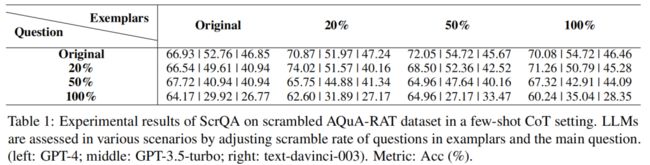

下表展示了在加扰的 AQuA-RAT 数据集上进行 4-shot CoT 设置的实验结果。结果表明,加扰示例的影响相对较小。但当主问题的加扰率达到 100%时,GPT-3.5-turbo 和 text-davinci-003 的性能明显下降,而 GPT-4 基本保持了最初的性能。

结论

本研究提出了 Scrambled Bench 来衡量 LLMs 处理乱序文本的能力,包括两个任务(乱序句子恢复 ScrRec 和乱序问题解答 ScrQA),并基于 RealtimeQA、DREAM 和 AQuA-RAT 构建了乱序数据集。尽管乱序文本显著改变了 tokenization,大多数强大的 LLMs 仍能在不同程度上处理乱序文本,不过它们在面对极端乱序的文本时会显得力不从心。在这两项任务中,GPT-4 都表现出了良好的性能,显著优于其他模型。

未来的改进空间也很大。首先,对于 LLMs,还有多种方法可以破坏单词的 tokenization(如插入字母、替换字母等)。其次,ScrRec 和 ScrQA 这两项任务适用于多种数据集且易于扩展分析。最后,由于无法直接访问闭源模型,作者没有总结出 LLMs 能够处理这些任务的具体原因。特别地,GPT-4 可以近乎完美地完成任务,其背后的原因值得深究!

备注:昵称-学校/公司-方向/会议(eg.ACL),进入技术/投稿群

id:DLNLPer,记得备注呦