物流实时数仓:采集通道搭建

系列文章目录

物流实时数仓:环境搭建

文章目录

- 系列文章目录

- 前言

- 一、环境准备

-

- 1.前置环境

- 2.hbase安装

-

- 1.上传并解压

- 2.配置环境变量

- 3.拷贝jar包

- 4.编写配置文件

- 5.分发配置文件

- 3.Redis安装

-

- 1.安装需要的编译环境

- 2.上传并解压文件

- 3.编译安装

- 4.后台访问

- 4.ClickHouse安装

- 5.Flink安装

- 二、数据采集

-

- 1.上传文件

- 2.创建数据库

- 3.模拟数据

- 总结

前言

之前学校安排了实训,所以有一堆事情要处理。现在基本算是搞完了,继续进行学习的提升,这次进行的是实时数仓的学习,可以算是大数据学习的最后阶段了。

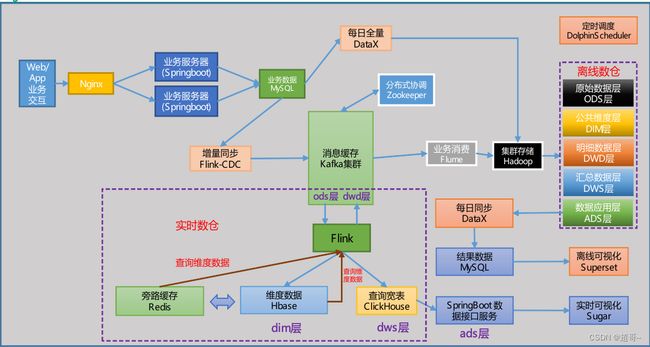

以下是实时数仓的框架图。

一、环境准备

1.前置环境

我们需要准备好以下环境

jdk、hadoop、zookeeper、kafka、mysql。

这些环境在之前的离线数仓都安装过,这里就不再重复了。

线上问诊

2.hbase安装

hbase专栏

接下来整合phoenix,这个软件可以让我们用SQL操作hbase

1.上传并解压

2.配置环境变量

# PHOENIX_HOME

export PHOENIX_HOME=/opt/module/phoenix

export PHOENIX_CLASSPATH=$PHOENIX_HOME

export PATH=$PATH:$PHOENIX_HOME/bin

3.拷贝jar包

cp phoenix-server-hbase-2.4-5.1.3.jar /opt/module/hbase/lib/

4.编写配置文件

vim /opt/module/hbase/conf/hbase-site.xml

<property>

<name>phoenix.schema.isNamespaceMappingEnabled</name>

<value>true</value>

</property>

<property>

<name>phoenix.schema.mapSystemTablesToNamespace</name>

<value>true</value>

</property>

vim /opt/module/phoenix/bin/hbase-site.xml

<property>

<name>phoenix.schema.isNamespaceMappingEnabled</name>

<value>true</value>

</property>

<property>

<name>phoenix.schema.mapSystemTablesToNamespace</name>

<value>true</value>

</property>

5.分发配置文件

xsync /opt/module/hbase/lib/phoenix-server-hbase-2.4-5.1.3.jar

xsync /opt/module/hbase/conf/hbase-site.xml

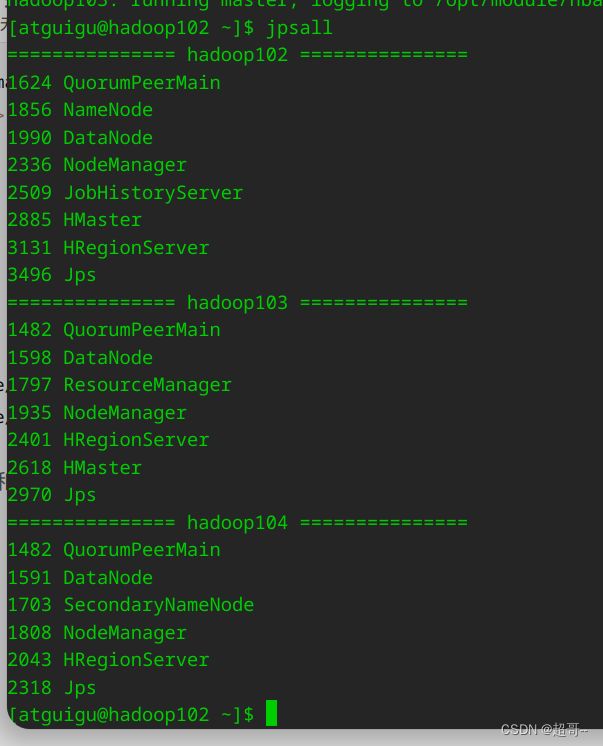

之后我们启动zk、hadoop和hbase测试一下。

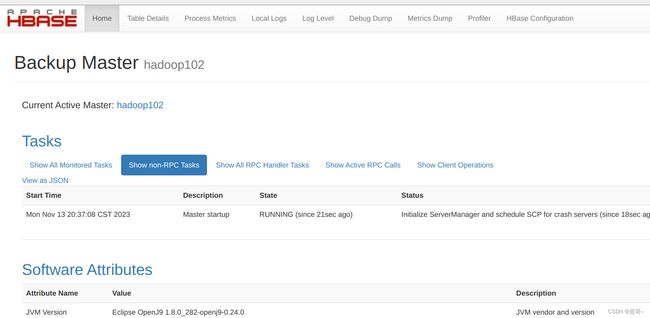

然后访问以下hbase的webui

http://hadoop102:16010/

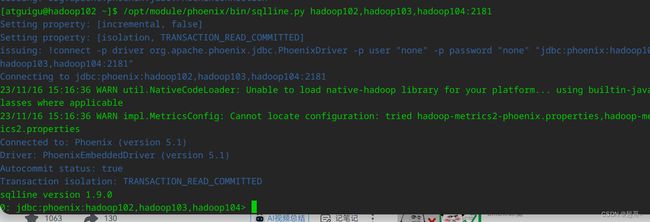

之后连接Phoenix

/opt/module/phoenix/bin/sqlline.py hadoop102,hadoop103,hadoop104:2181

3.Redis安装

1.安装需要的编译环境

sudo yum install centos-release-scl scl-utils-build

sudo yum install -y devtoolset-8-toolchain

sudo scl enable devtoolset-8 bash

2.上传并解压文件

tar -xvf redis-6.0.8.tar.gz -C /opt/module/

cd ../module/redis-6.0.8/

3.编译安装

make

make install

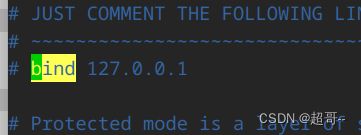

4.后台访问

注意上边命令是用root完成,现在我们用atguigu进行下边的命令。

- 备份redis.conf

cp /opt/module/redis-6.0.8/redis.conf ~/my_redis.conf

- 修改设置

vim ~/my_redis.conf

- Redis启动

redis-server ./my_redis.conf

4.ClickHouse安装

具体内容参考之前的博客不写了

ClickHouse

5.Flink安装

Flink安装

二、数据采集

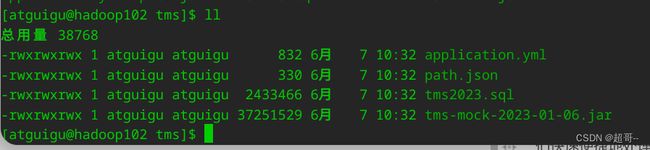

1.上传文件

cd /opt/module/

mkdir tms

cd tms

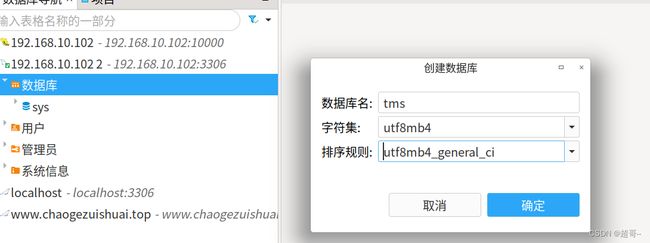

2.创建数据库

3.模拟数据

修改一下

application.yml

这里的信息根据自己的数据库信息进行修改。

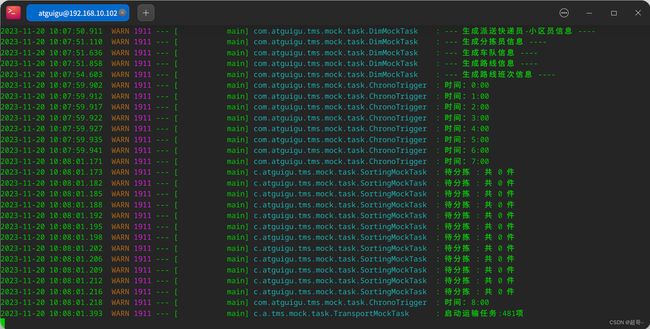

java -jar tms-mock-2023-01-06.jar

由于我们模拟的是实时数仓,所以他会不停的生成数据,所以等个半分钟,就可以终止进程然后去数据库看数据了。

这就是生成数据的实时时间,说明数据进行了更新,但这不是模拟数据的时间,模拟数据的时间可以在application.yml设置。

总结

至此,物流实时数仓采集通道搭建完成。