NLP论文阅读记录-ACL 2023 | 09 Improving Factuality of Abstractive Summarization without Sacrificing Summar

文章目录

- 前言

- 0、论文摘要

- 一、Introduction

-

- 1.1目标问题

- 1.2相关的尝试

- 1.3本文贡献

- 二.相关工作

- 三.本文方法

-

- 3.1 候选集生成

- 3.2 排名策略

- 四 实验效果

-

- 4.1数据集

- 4.2 对比模型

- 4.3实施细节

- 4.4评估指标

- 4.5 实验结果

-

- 真实性与抽象性的权衡

- 消融研究

-

- 候选人选择过程。

- 双重评分技术

- 五 总结

-

- 局限性

前言

在不牺牲摘要质量的情况下提高抽象摘要的真实性(2305)

code

paper

0、论文摘要

提高抽象概括的事实一致性一直是一个广泛研究的话题。然而,大多数先前关于训练事实感知模型的工作都忽略了它对摘要质量的负面影响。我们提出了 EFACTSUM(即有效事实摘要),这是一种候选摘要生成和排名技术,可在不牺牲摘要质量的情况下提高摘要事实性。

我们表明,使用对比学习框架和我们完善的候选人摘要可以在事实性和基于相似性的指标上带来显着的收益。具体来说,我们提出了一种排名策略,其中我们有效地结合了两个指标,从而防止训练期间出现任何冲突。

使用我们的方法训练的模型在 XSUM 上的 FactCC 上比基本模型绝对提高了 6 点,在 CNN/DM 上提高了 11 点,并且不会对基于相似性的指标或抽象性产生负面影响。1

一、Introduction

1.1目标问题

尽管最近的方法在抽象概括方面取得了显着的进步(Lewis et al., 2020;Raffel et al., 2020;Zhang et al., 2020),但它们仍然缺乏一个非常关键的组成部分——事实一致性。最近的研究(Cao et al., 2020;Kryscinski et al., 2019;Maynez et al., 2020)表明,大多数模型生成的摘要都是不忠实的,并且存在多种幻觉(Tang et al., 2020)。 ,2022)。使摘要模型事实上一致对于其在实际应用中的可信度至关重要。

1.2相关的尝试

最近的研究已经做出了一些尝试,通过修改最大似然估计(MLE)训练目标来提高抽象概括的真实性(Cao 和 Wang,2021;Goyal 和 Durrett,2021),使用强化学习直接优化事实性指标(Cao 等人,2022)或提高训练数据的质量(Goyal 和 Durrett,2021;Nan 等人,2021a)。然而,大多数这些著作都报告了事实一致性和摘要质量之间的负相关关系2。例如,Goyal 和 Durrett(2021)以 ROUGE-L 下降 6 个点为代价提高了真实性,Wan 和 Bansal(2022)也观察到 ROUGE-L 下降了 2 个点。先前的方法也以抽象性为代价优化了事实性(Ladhak 等人,2022)。

这就引出了一个关键问题:我们能否在不牺牲摘要质量的情况下提高摘要的真实性?

1.3本文贡献

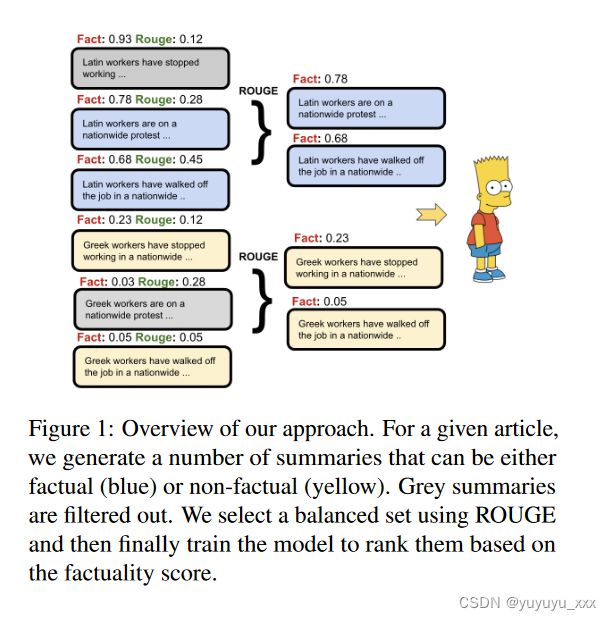

为此,我们提出了EFACTSUM(即有效事实摘要):一种用于对比摘要训练的候选摘要生成和排序技术(图1),它不仅在抽象摘要的真实性方面取得了显着的进步,而且还提高了摘要的准确性。与之前的作品不同,之前的作品常常为了提高忠实度而牺牲摘要质量,我们采取另一种方法来提高忠实度和摘要质量。

我们利用 Liu 等人的微调策略。 (2022)并对排名过程进行重大修改。

如图 1 所示,我们首先使用现有的微调模型生成许多候选摘要。使用这些摘要,我们通过有效组合两个不同标准的两个评估指标(§2)来选择一个子集,从而避免以牺牲另一个为代价来优化一个子集。与简单优化一个指标的方法相比,该技术有助于获得收益(第 3.4 节)。

EFACTSUM 在 XSUM 和 CNN/DM 上取得的有希望的结果表明,在两个方面都比强大的基线有了持续的改进,证明在不牺牲质量的情况下有效增强了摘要的真实性。

二.相关工作

抽象概括中的事实一致性最近引起了广泛关注(Goyal 和 Durrett,2020;Zhu 等,2021)。现有的工作分别探索了在微调、推理和预训练阶段提高事实一致性。对于事实微调,作品应用了对比学习(Cao 和 Wang,2021;Nan 等人,2021b)、强化学习(Gunasekara 等人,2021)或知识整合(Zhu 等人,2021)来教授模型识别高度事实一致性的摘要,而 Wan 和 Bansal (2022) 修改预训练过程以引入事实意识。一些作品还通过推理中的后处理提高了摘要事实性,例如纠正错误和按事实分数重新排名(Cao et al., 2020; Dong et al., 2020; Balachandran et al., 2022; Chen et al., 2021;朱等人,2021)。

我们的工作与上述工作不同,因为我们提高了事实性和摘要质量,这与其他方法不同,后者经常牺牲一种方法。

三.本文方法

给定文档 (D),摘要任务旨在生成满足某些条件(如事实性、连贯性等)的摘要 (S)。标准微调过程涉及使用最大似然估计 (MLE)。受到刘等人的启发。 (2022),除了交叉熵损失之外,我们还引入了对比损失,鼓励模型为更真实的摘要提供更高的概率质量。形式上,对于每个训练文档 D 和最可能的候选摘要的排名列表 [S1,S2,. 。 。 Sn],模型学习根据事实分数对摘要进行排序。为了实现这一目标,我们利用以下损失:

其中 Si 和 Sj 是两个不同的候选摘要,Si 的排名高于 Sj,λij = (j−i)*λ 是基于排名的余量,f (.) 是按长度归一化的估计对数概率:

3.1 候选集生成

为了生成候选摘要集 {Si},我们利用现有模型和使用波束搜索的样本摘要(Vijayakumar 等人,2018)。我们观察到,仅仅使用交叉熵训练的模型就会导致生成许多不忠实的摘要。为了生成更忠实的摘要,我们使用经过事实改进的模型。

3.2 排名策略

由于我们的主要目标是在不不利地影响摘要质量的情况下优化事实性,因此我们在决定理想排名时需要考虑两个指标。为了衡量 Si 的真实性,我们选择 FactCC (Kryscinski et al., 2020),因为它与人类对忠诚度的判断有很好的相关性 (Pagnoni et al., 2021),而且它在计算上也比其他基于问答的方法更高效指标(Scialom 等人,2021)。为了衡量摘要质量,我们使用流行的 ROUGE 指标(Lin,2004)。现在,在已被评分为忠实的候选摘要集中,我们进一步选择具有最高 ROUGE 分数的前 m 个摘要。我们以与选择 ROUGE 分数最低的 m 个摘要相同的方式选择一组不忠实摘要。这种结合两个评估指标的技术有助于克服固有的冲突(Chaudhury 等人,2022)。我们强调了第 3.4 节中提议的步骤的重要性。最后,这 2m 个摘要用于为训练集中的每篇文章创建候选摘要的排名列表。这种方法背后的直觉是,由于 FactCC 分数不是置信度分数,因此仅来自一组的摘要无法提供足够的监督信号。相反,使用两组的平衡摘要来训练模型将是有益的。

最后,我们的训练目标结合了交叉熵损失和对比损失

其中 γ 是对比损失的权重。

四 实验效果

4.1数据集

为了了解 EFACTSUM 的有效性,我们使用了两个广泛使用的新闻摘要数据集:XSUM(Narayan 等人,2018)和 CNN/DM(Hermann 等人,2015)。

4.2 对比模型

除了使用交叉熵和竞争性微调技术进行微调的模型:BRIO(Liu et al., 2022)之外,我们还将 EFACTSUM 与之前修改微调过程以提高真实性的作品进行比较,包括

(1) CLIFF(Cao 和 Wang,2021)使用对比学习来训练摘要模型,以区分一致摘要和幻觉摘要;

(2)FASum(Zhu 等人,2021)通过合并知识图来修改 Transformer 架构以实现事实一致性;

以及(3) DAE(Goyal 和 Durrett,2021)在训练期间掩盖非事实标记。此比较仅适用于 XSUM 数据集。

4.3实施细节

我们使用 CLIFF 和交叉熵训练模型来生成候选摘要集(S1、S2、…、Sn)。我们使用 n = 6,并且仅保留那些包含至少 2 个事实和非事实候选人摘要的训练文章。使用这个新的训练数据子集,我们对 CNN/DM 上的 BART-Large(Lewis 等人,2020)和 XSUM 上的 PEGASUS(Zhang 等人,2020)进行微调。更多详细信息请参见附录。 §A。

4.4评估指标

为了评估事实性,我们使用 FactCC(Kryscinski 等人,2020),这是一种流行的指标,它使用基于 BERT 的指标来衡量生成的输出是否忠实。我们还考虑 DAE(Goyal 和 Durrett,2020),这是一种基于文本蕴含的度量,与人类对事实的判断密切相关(Tang 等人,2022)。它使用弧蕴涵模型来评估摘要的真实性。我们利用标记级分数来补充 FactCC 的句子级分数。

对于质量评估,我们使用 ROUGE(Lin,2004)和 BERTScore(Zhang 等人,2019)根据参考来评估摘要。

所有实验均使用 4 个 24GB NVIDIA RTX A5000 GPU 进行实验是使用私人基础设施进行的,其碳效率为 0.432 kgCO2eq/kWh。总排放量估计为 4.84 kgCO2eq,其中 0% 被直接抵消。使用 (Lacoste et al., 2019) 中介绍的机器学习影响计算器进行估计。

4.5 实验结果

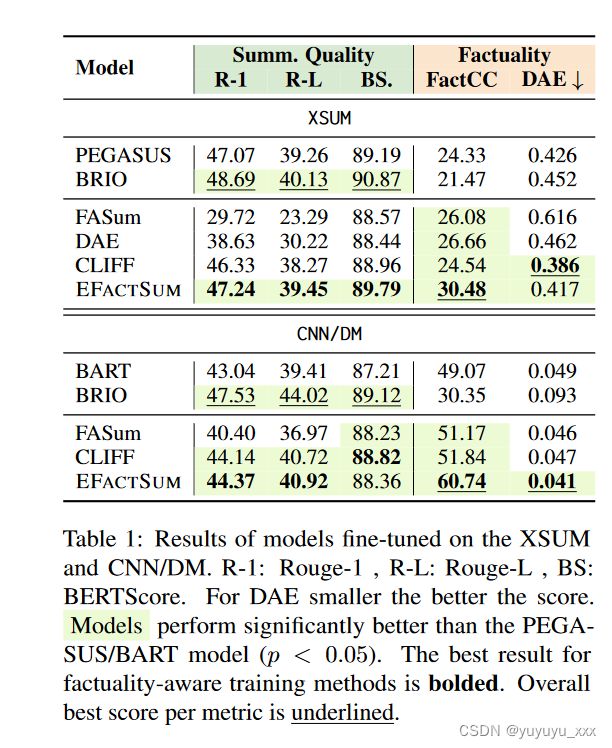

我们在表中报告了使用我们的方法微调模型的结果。 1. 使用我们的策略微调的模型的输出如表 1 所示。 2 和附录。 §C。总的来说,我们可以观察到所提出的 EFACTSUM 可以改善事实性指标,同时保留或改善基于参考的相似性指标的性能。

对于 XSUM,与 PEGASUS 相比,EFACTSUM 在 FactCC 上实现了 25% 的相对增益,在 DAE(代币)上实现了 3% 的显着相对增益,同时在 ROUGE 和 BERTScore 上显示了不小的增益。尽管 EFACTSUM 经过训练来优化 FactCC,但它在其他评估指标上也表现良好,因此指出训练过程不会利用与评估指标相关的任何偏差。应该注意的是,尽管 CLIFF 在 DAE 上做得更好,但它牺牲了摘要质量。

CNN/DM 的情况也类似,EFACTSUM 在 FactCC 和 DAE 上分别实现了 20% 和 16% 的相对增益。与之前的一些作品不同,这种事实性的提高并没有以牺牲摘要质量或抽象性为代价(第 3.3 节)。尽管 BRIO 在 ROUGE 和 BERTScore 上的表现优于我们的方法,但它大大降低了事实性得分,这是不可取的。我们的方法旨在在事实性和摘要质量之间取得平衡。

真实性与抽象性的权衡

拉达克等人。 (2022)表明,通过增加提取性(减少抽象性)来增加生成摘要的真实性是天真的可能的。因此,我们分析生成的摘要的提取水平,以了解我们的方法是否受到这种权衡的影响。除了提取性分数(Grusky 等人,2018)之外,我们还计算 MINT(生成文本的词汇独立性度量)分数和抽象性调整后的度量分数(Dreyer 等人,2023)。图 2 描述了各种摘要系统的提取水平。分数是也在Appx中提出。 §B。我们可以观察到我们的模型 (EFACTSUM) 的提取性得分低于其他模型;它还获得了更高的 MINT 分数(表 3),该分数衡量摘要的抽象性。此外,EFACTSUM 在两个数据集的抽象性校准 FactCC 指标 (μFactCC) 上显示出更高的分数。这澄清了事实性的额外收益并不以抽象性为代价。

消融研究

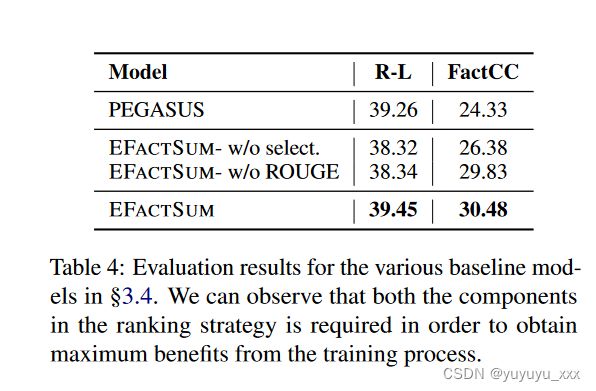

为了证明 EFACTSUM 候选排序过程中所做修改的合理性,我们计算了突出每个单独组件重要性的基线。我们使用在 XSUM 上微调的 PEGASUS 进行以下研究。

候选人选择过程。

我们限制候选人摘要的数量,以保持班级平衡。我们通过使用 FactCC 对所有候选摘要进行简单评分来放宽这一限制。这由 EFACTSUM-w/o select 表示。在选项卡中。 4. 我们可以观察到,这个过程提高了模型的真实性,但仍与主要方法相差 4 个点。因此强调了专注于生成高质量训练数据的优势。

双重评分技术

为了理解使用 ROUGE 从事实和非事实集中选择最佳候选者的重要性,我们通过使用 FactCC 本身选择最佳事实和非事实摘要来省略此步骤。这在选项卡中标记为 EFACTSUM- w/o ROUGE。 4. 虽然该模型在事实性方面的收益与 EFACTSUM 几乎相同,但它对 ROUGE 分数产生负面影响。

五 总结

我们提出了 EFACTSUM(有效事实摘要),这是一种用于对比摘要训练的候选摘要生成和排名技术,有助于使模型更加忠实,而不会对摘要质量产生不利影响。结果表明,这种简单而有效的方法可以在事实性和基于相似性的指标上获得一致的收益,而不会对抽象程度产生负面影响。我们希望我们的研究结果能够鼓励未来对事实一致摘要的研究,更多地关注摘要质量和事实性之间的权衡。

局限性

虽然我们的方法有助于训练事实感知摘要模型,但它需要额外的计算成本。与普通交叉熵模型相比,训练时间增加了 3 倍。

**为训练数据集中的每篇文章生成和评分候选摘要也会产生额外的计算开销,**但我们相信这些收益证明了额外的计算成本是合理的。提高摘要模型的忠实度是一项具有挑战性的任务。

尽管我们通过提高事实性指标来改进之前的工作,就像比较之前的工作一样,但我们的工作并没有关注数字一致性。这可能是后续工作一个有意义的研究方向。