helm部署ELK及pod日志收集

文章目录

- 0 准备

-

- 1)下载chart

- 2)创建namespace

- 1. 部署elasticsearch

-

- 1.1 修改配置文件

- 1.2 启动ES

- 2. Kibana

-

- 2.1 修改配置文件

- 2.2 创建服务

- 3. logstash

-

- 3.1 修改配置文件

- 3.2 为ES创建一个service

- 3.2 启动服务

- 4. filebeat

-

- 4.1 修改配置文件

- 4.2 启动服务

- 5. Kibana查看结果

-

- 5.1 查看结果

- 5.2 查看日志

- 5.3 查看实时日志如图

前言:

本文从k8s平台层面收集pod日志,最终得到的是每个pod前台输出的日志。

其本质是在每个节点上启动了filebeat,收集该节点docker服务在 docker/containers 目录(containers 目录说明见 《docker的目录》一章)下的日志。

另外,收集pod中服务打印到文件中的日志将在下一篇中说明。

0 准备

1)下载chart

说明,我通常都是使用 https://github.com/helm/charts 里边的chart,但ELK是感觉不是很好,最后直接用 elastic的。

# git clone https://github.com/elastic/helm-charts.git

# ll

total 1

drwxr-xr-x 12 root root 4096 Sep 30 11:06 helm-charts

2)创建namespace

# kubectl create namespace elk

1. 部署elasticsearch

1.1 修改配置文件

说明:按需要修改 values.yaml文件,以下方案仅供参考

- 修改镜像(非必需)

官方镜像 docker.elastic.co/beats/xxx 下载慢,提前下载到了我的私有仓库,在变量中修改如下

image: "harborcto.xxx.com.cn/pulic/elasticsearch"

imageTag: "7.10.0"

imagePullPolicy: "IfNotPresent"

- 副本和主节点(非必要)

如果要单节点启动修改如下

replicas: 1

minimumMasterNodes: 1

- 端口映射(非必要)

一般情况下没有必要将elasticsearch的端口对外映射出来,以下提供一个改法:

service:

……

# (1)修改type类型

type: NodePort

# (2)修改端口号

nodePort: "31009"

# (3)添加下边这行,模板没有给这个变量,我们自己定义

tra_nodePort: "31010"

……

- 资源限制(建议修改)

resources:

requests:

cpu: "1000m"

memory: "2Gi"

limits:

cpu: "4000m"

memory: "8Gi"

- 磁盘限制(建议修改)

注意:ES磁盘使用达到85%将变成只读,因此这里要结合日志清理计划规划好。

volumeClaimTemplate:

accessModes: [ "ReadWriteOnce" ]

resources:

requests:

storage: 200Gi

1.2 启动ES

# cd helm-charts/elasticsearch

# helm install elasticsearch -n elk ./

NAME: elasticsearch

LAST DEPLOYED: Wed Sep 30 13:27:41 2020

NAMESPACE: elk

STATUS: deployed

REVISION: 1

NOTES:

1. Watch all cluster members come up.

$ kubectl get pods --namespace=elk -l app=elasticsearch-master -w

2. Test cluster health using Helm test.

$ helm test elasticsearch --cleanup

2. Kibana

2.1 修改配置文件

说明:按需要修改 values.yaml文件,以下方案仅供参考

- 修改镜像(非必要)

官方镜像 docker.elastic.co/beats/xxx 下载慢,提前下载到了我的私有仓库,在变量中修改如下

image: "harborcto.xxx.com.cn/public/kibana"

imageTag: "8.0.0-SNAPSHOT"

imagePullPolicy: "IfNotPresent"

- 健康检查(必要)

默认目录过不去,做如下修改。

healthCheckPath: "/app/status"

- 资源限制(建议)

根据实际情况修改

resources:

requests:

cpu: "1000m"

memory: "2Gi"

limits:

cpu: "2000m"

memory: "8Gi"

- 修改service

修改为NodePort以提供外网访问。全部搭建好之后在web上访问30026这个端口。

service:

#type: ClusterIP

type: NodePort

loadBalancerIP: ""

port: 5601

nodePort: "30026"

2.2 创建服务

# cd helm-charts/kibana

# helm install kibana -n elk ./

3. logstash

3.1 修改配置文件

说明:按需要修改 values.yaml文件,没有什么必须修改的,修改和之前差不多。

3.2 为ES创建一个service

- 遇到问题

说明:logstach默认链接 elasticsearch,但是ES并没有创建这个service,而默认创建了elasticsearch-master,查看如下:

[root@DoM01 elk]# kubectl get service -n elk

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

elasticsearch-master ClusterIP 10.1.104.188 <none> 9200/TCP,9300/TCP 37h

elasticsearch-master-headless ClusterIP None <none> 9200/TCP,9300/TCP 37h

但是我又没有在logstach的chart中找到修改的位置,所以自己为ES写了一个叫elasticsearch的service。

- 创建的yml文件如下:

这里用 NodePort为了在web上看看通不通,生产用ClusterIP即可。

apiVersion: v1

kind: Service

metadata:

name: elasticsearch

namespace: elk

labels:

name: elasticsearch

spec:

type: NodePort

ports:

- port: 9200

targetPort: 9200

nodePort: 30028

selector:

app: elasticsearch-master

- 创建service

[root@DoM01 elk]# kubectl create -f es-service.yml

- 再次查看如下

[root@DoM01 elk]# kubectl get service -n elk

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

elasticsearch NodePort 10.1.4.111 <none> 9200:30028/TCP 2d7h

elasticsearch-master ClusterIP 10.1.104.188 <none> 9200/TCP,9300/TCP 37h

elasticsearch-master-headless ClusterIP None <none> 9200/TCP,9300/TCP 37h

3.2 启动服务

# cd helm-charts/logstash

# helm install logstash -n elk ./

4. filebeat

说明:

1)会在每个节点上启动一个filebeat的pod,用来收集每个节点 docker/containers 目录下每个容器打印的日志。这些日志都是容器前台输出的。这样就将所有pod的日志汇总到es上

2)此处没有使用logstash,直接推给ES

4.1 修改配置文件

说明:按需要修改 values.yaml文件,没有什么必须修改的,修改和之前差不多。

4.2 启动服务

[root@DoM01 filebeat]# helm install filebeat -n elk ./

NAME: filebeat

LAST DEPLOYED: Sat Feb 20 22:47:33 2021

NAMESPACE: elk

STATUS: deployed

REVISION: 1

TEST SUITE: None

NOTES:

1. Watch all containers come up.

$ kubectl get pods --namespace=elk -l app=filebeat-filebeat -w

- 查看结果如下:

可见每个节点上启动了一个filebeat

[root@DoM01 filebeat]# kubectl get pod -n elk -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

elasticsearch-master-0 1/1 Running 0 37h 10.244.7.250 don05 <none> <none>

filebeat-filebeat-4k5j8 1/1 Running 0 98s 10.10.239.104 don01 <none> <none>

filebeat-filebeat-72gf6 1/1 Running 0 98s 10.10.239.108 don05 <none> <none>

filebeat-filebeat-8dkwm 1/1 Running 0 98s 10.10.239.107 don04 <none> <none>

filebeat-filebeat-mqbjq 1/1 Running 0 98s 10.10.239.106 don03 <none> <none>

filebeat-filebeat-z55kh 1/1 Running 0 98s 10.10.239.105 don02 <none> <none>

kibana-kibana-55945d944b-26rtv 1/1 Running 0 37h 10.244.5.244 don03 <none> <none>

logstash-logstash-0 1/1 Running 0 2d8h 10.244.7.238 don05 <none> <none>

5. Kibana查看结果

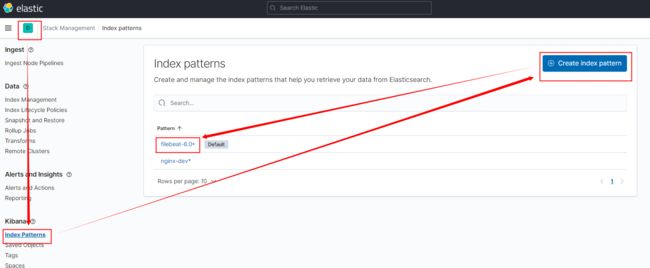

5.1 查看结果

-

访问地址

前文2.1中 修改Kibana service的时候,NodePort 指定的那个端口即是服务端口 -

查看结果

如下图可见刚才的 filebeat 已经链接上来了

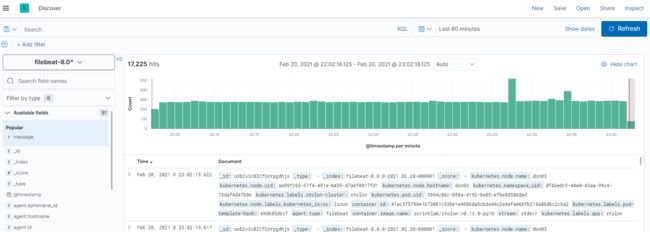

5.2 查看日志

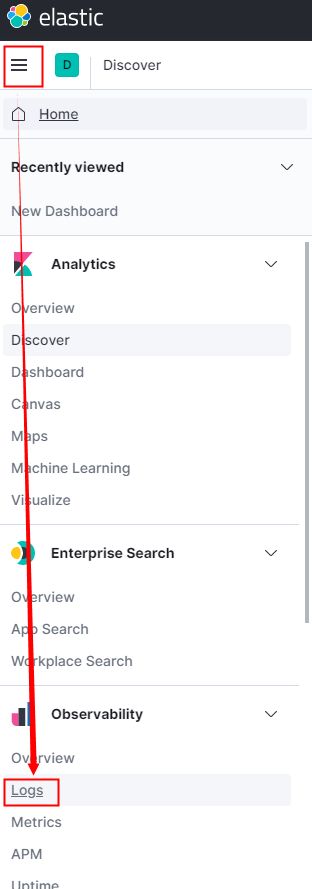

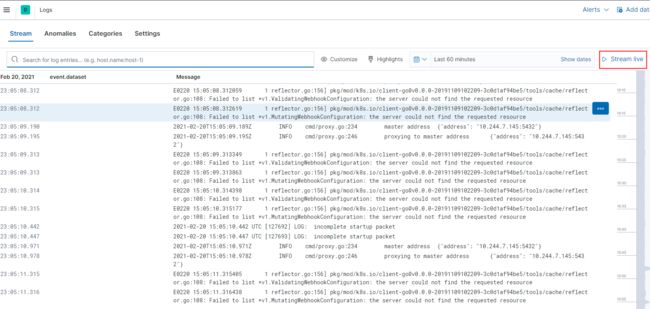

5.3 查看实时日志如图

服务搭建完毕,可以对容器日志做监控了,kibana的使用和日志筛选不在此说明。另外,logstash已经连接到ES但是我们现在并没有使用。