一篇文章让你真正搞懂epoll机制

1.epoll简介

epoll是Linux内核为处理大批量文件描述符而作了改进的poll,它能显著提高程序在大量并发连接中只有少量活跃的情况下的系统CPU利用率。

epoll可以理解为event poll,它是一种事件驱动的I/O模型,可以用来替代传统的select和poll模型。epoll的优势在于它可以同时处理大量的文件描述符,而且不会随着文件描述符数量的增加而降低效率。

epoll的实现机制是通过内核与用户空间共享一个事件表,这个事件表中存放着所有需要监控的文件描述符以及它们的状态,当文件描述符的状态发生变化时,内核会将这个事件通知给用户空间,用户空间再根据事件类型进行相应的处理。

epoll的接口和工作模式相对于select和poll更加简单易用,因此在高并发场景下被广泛使用。

2.epoll实现原理

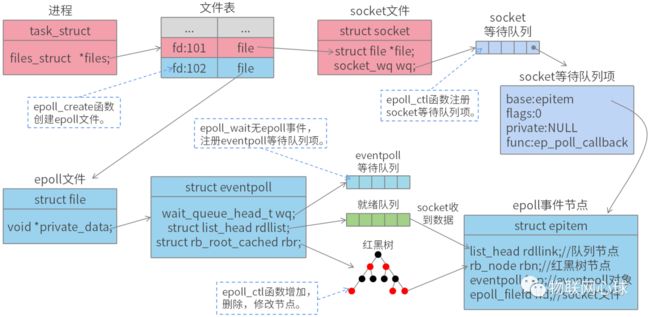

-

socket等待队列

socket等待队列用于在socket接收到数据后添加就绪epoll事件节点和唤醒eventpoll等待队列项。

socket收到数据后,唤醒socket等待队列项,并执行等待队列项注册的回调函数ep_poll_callback,ep_poll_callback函数将就绪epoll事件节点添加至就绪队列,并唤醒eventpoll等待队列项。

-

eventpoll等待队列

eventpoll等待队列用于阻塞当前进程,用于epoll_wait未检测到就绪epoll事件节点的情况。

epoll_wait检测就绪队列是否有epoll事件节点,没有epoll事件节点,则使用等待队列将当前进程挂起,后续ep_poll_callback函数会唤醒当前进程。

-

就绪队列

就绪队列用于存储就绪epoll事件节点,用户通过epoll_wait函数获取就绪epoll事件节点。

-

红黑树

红黑树用于存储通过epoll_ctl函数注册的epoll事件节点。

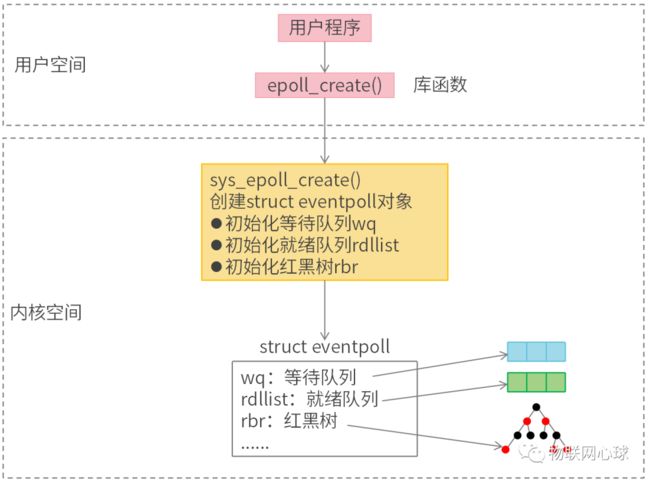

3.创建epoll文件

epoll_create函数原型

int epoll_create(int size);

功能:epoll_create函数用于创建epoll文件。

参数:

size:目前内核还没有实际使用,只要大于0就行。

返回值:

成功:返回epoll文件描述符。

失败:返回-1,并设置errno。

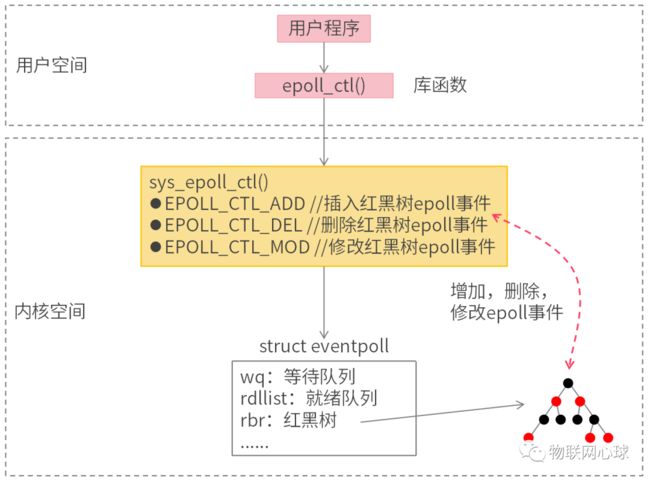

4.增加,删除,修改epoll事件

epoll_ctl函数原型

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

功能:epoll_ctl函数用于增加,删除,修改epoll事件,epoll事件会存储于内核epoll结构体红黑树中。

参数:

epfd:epoll文件描述符。

op:操作码

-

EPOLL_CTL_ADD:插入事件

-

EPOLL_CTL_DEL:删除事件

-

EPOLL_CTL_MOD:修改事件

fd:epoll事件绑定的套接字文件描述符。

events:epoll事件结构体。

返回值:

成功:返回0。

失败:返回-1,并设置errno。

struct epoll_event结构体

struct epoll_event{

uint32_t events; //epoll事件,参考事件列表

epoll_data_t data;

} ;

typedef union epoll_data {

void *ptr;

int fd; //套接字文件描述符

uint32_t u32;

uint64_t u64;

} epoll_data_t;

epoll事件列表

enum EPOLL_EVENTS

{

EPOLLIN = 0x001, //socket可读。

EPOLLPRI = 0x002, //socket有紧急数据。

EPOLLOUT = 0x004, //socket可写。

EPOLLRDNORM = 0x040,

EPOLLRDBAND = 0x080,

EPOLLWRNORM = 0x100,

EPOLLWRBAND = 0x200,

EPOLLMSG = 0x400,

EPOLLERR = 0x008, //socket文件出错。

EPOLLHUP = 0x010, //socket文件被挂起。

EPOLLRDHUP = 0x2000, //socket文件被关闭或者关闭读端。

EPOLLEXCLUSIVE = 1u << 28,

EPOLLWAKEUP = 1u << 29,

EPOLLONESHOT = 1u << 30, //单次模式,执行完epoll_wait后需重新调用epoll_ctl注册事件。

EPOLLET = 1u << 31 //边缘触发,默认为水平触发。

};

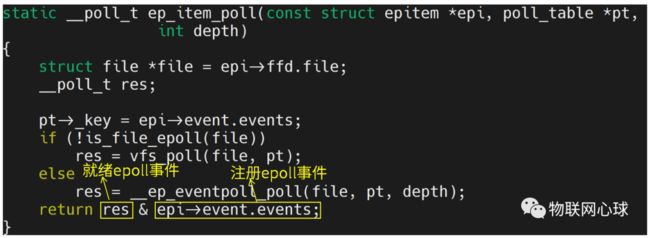

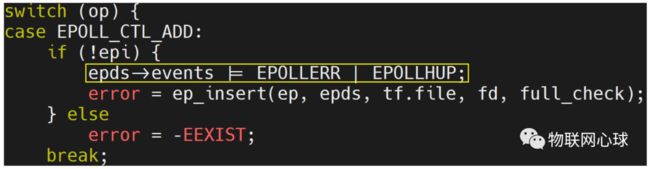

epoll事件如何处理?

epoll事件处理原则:epoll_wait获取epoll事件 = 注册epoll事件 & 就绪epoll事件

epoll_ctl函数增加epoll事件时,系统默认注册EPOLLERR和EPOLLHUP事件。

epoll事件处理示例:

-

注册epoll事件

struct epoll_event ev;

ev.data.fd = sock_fd;

ev.events = EPOLLIN; //注册EPOLLIN事件

epoll_ctl(efd, EPOLL_CTL_ADD, sock_fd, &ev);

-

就绪epoll事件

res = EPOLLIN | EPOLLRDNORM;

-

epoll_wait获取事件

events=(EPOLLIN|EPOLLERR|EPOLLHUP)&(EPOLLIN|EPOLLRDNORM) = EPOLLIN;

注意:只有注册的事件才能通过epoll_wait获取。

5.epoll事件就绪

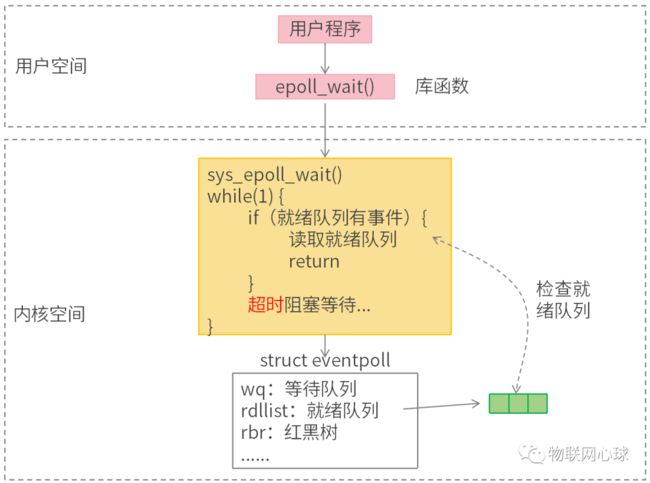

epoll_wait函数原型

int epoll_wait(int epfd, struct epoll_event *events, int maxevents, int timeout);

功能:epoll_wait用于监听epoll事件。

参数:

epfd:epoll文件描述符。

events:epoll事件数组。

maxevents:epoll事件数组长度。

timeout:超时时间,

-

小于0:一直等待。

-

等于0:立即返回。

-

大于0:等待超时时间返回,单位毫秒。

返回值:

小于0:出错。

等于0:超时。

大于0:返回就绪事件个数。

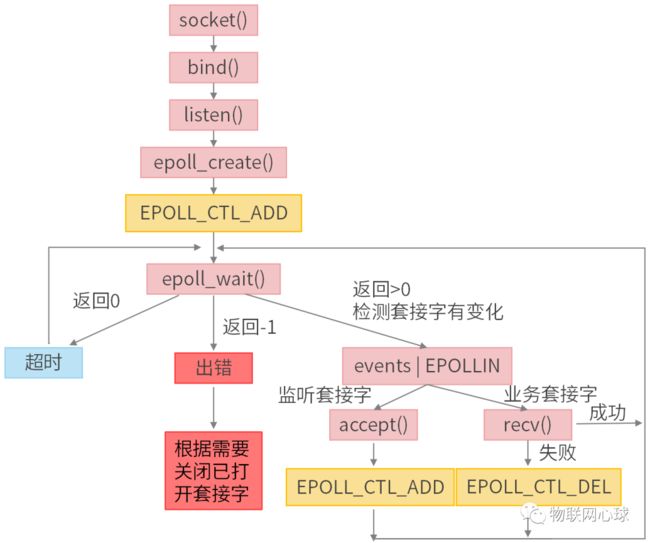

6.epoll编程流程

7.epoll常见问题?

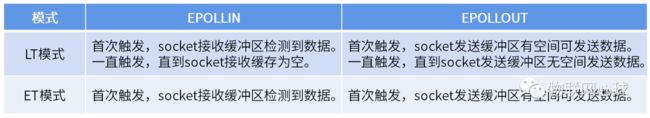

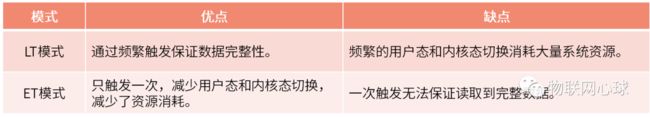

问题1:LT模式和ET模式区别?

LT模式又称水平触发,ET模式又称边缘触发。

LT模式只不过比ET模式多执行了一个步骤,就是当epoll_wait获取完就绪队列epoll事件后,LT模式会再次将epoll事件添加到就绪队列。

LT模式多了这样一个步骤会让LT模式调用epoll_wait时会一直检测到epoll事件,直到socket缓冲区数据清空为止。

ET模式则只会在缓冲区满足特定情况下才会触发epoll_wait获取epoll事件。

LT模式和ET模式优缺点。

问题2:epoll为什么高效?

-

eventpoll等待队列机制,当就绪队列没有epoll事件时主动让出CPU,阻塞进程,提高CPU利用率。

-

socket等待队列机制,只有接收到数据时才会将epoll事件插入就绪队列,唤醒进程获取epoll事件。

-

红黑树提高epoll事件增加,删除,修改效率。

-

任务越多,进程出让CPU概率越小,进程工作效率越高,所以epoll非常适合高并发场景。

问题3:epoll采用阻塞方式是否影响性能?

epoll机制本身也是阻塞的,当epoll_wait未检测到epoll事件时,会出让CPU,阻塞进程,这种阻塞是非常有必要的,如果不及时出让CPU会浪费CPU资源,导致其他任务无法抢占CPU,只要epoll机制能够在检测到epoll事件后,及时唤醒进程处理,并不会影响epoll性能。

问题4:socket采用阻塞还是非阻塞?

socket采用非阻塞方式。

epoll机制属于IO多路复用机制,这种机制的特点是一个进程处理多路IO请求,如果socket设置成阻塞模式会存在以下几个问题:

-

一个进程同一时间只能处理一个socket数据,如果socket被阻塞,那么该进程无法处理其他的socket数据,严重影响了性能。

-

阻塞的本质是进程状态和上下文的切换,频繁的阻塞会把让CPU一直处于上下文切换的状态,导致CPU瞎忙。