Learning to Enhance Low-Light Imagevia Zero-Reference Deep Curve Estimation

基于零参考深曲线估计的微光图像增强学习

本文提出了一种新的方法,零参考深度曲线估计(Zero DCE),该方法将光增强定义为使用深度网络进行图像特定曲线估计的任务。我们的方法训练一个轻量级的深度网络DCE-Net,以估计给定图像的动态范围调整的逐像素和高阶曲线。曲线估计是专门设计的,考虑了像素值范围、单调性和可微性。Zero DCE在其对参考图像的宽松假设中很有吸引力,即在训练过程中不需要任何成对甚至不成对的数据。这是通过一组精心制定的非参考损失函数来实现的,这些函数隐含地测量增强质量并驱动网络的学习。尽管它很简单,但我们证明它能很好地适用于各种照明条件。我们的方法是有效的,因为图像增强可以通过直观简单的非线性曲线映射来实现。我们进一步介绍了Zero DCE的加速和轻型版本,称为Zero DCE++,它利用了只有10K参数的微小网络。Zero DCE具有快速的推理速度(对于1200×900×3大小的图像,在单个GPU/CPU上为1000/11 FPS),同时保持Zero DCE的增强性能。在各种基准上进行的大量实验从定性和定量上证明了我们的方法优于最先进的方法。此外,还讨论了我们的方法在黑暗中人脸检测方面的潜在优势。

1 INTRODUCTION

由于不可避免的环境和/或技术限制,许多照片通常是在次优照明条件下拍摄的。这些问题包括环境中照明条件不足和不平衡、物体在极端背光下的不正确放置以及图像捕获过程中曝光不足。这样的低光照照片存在美学质量受损和信息传输不令人满意的问题。前者会影响观众的体验,而后者会导致传达错误的信息,如不准确的物体/人脸检测和识别。此外,尽管深度神经网络在图像增强和恢复方面表现出了令人印象深刻的性能[1]、[2]、[3]、[4]、[5],但由于参数空间巨大,它们不可避免地会导致高内存占用和长推理时间。在实际应用中,特别是对于资源有限的实时设备,如移动平台,需要深度模型的低计算成本和快速推理速度。

在这项研究中,我们提出了一种新的基于深度学习的方法,即零参考深度曲线估计(Zero DCE),用于微光图像增强。它可以应对各种照明条件,包括不均匀和较差的照明情况。我们不执行图像到图像的映射,而是将任务重新表述为图像特定的曲线估计问题。特别地,所提出的方法以低光图像作为输入,并产生高阶曲线作为输出。然后使用这些曲线对输入的动态范围进行逐像素调整,以获得增强的图像。曲线估计被精心制定,以保持增强图像的范围并保持相邻像素的对比度。重要的是,它是可微分的,因此我们可以通过深度卷积神经网络学习曲线的可调参数。所提出的网络是轻量级的,设计的曲线可以迭代地应用于逼近更高阶的曲线,以实现更强大和准确的动态范围调整。

我们基于深度学习的方法的一个独特优势是零参考,即在训练过程中不需要任何配对甚至不配对的数据,如现有的基于CNN的[6]、[7]、[8]和基于GAN的方法[9]、[10]。这是通过一组专门设计的非参考损失函数实现的,包括空间一致性损失、曝光控制损失、颜色恒定性损失和照明平滑度损失,所有这些都考虑了光增强的多因素。我们表明,即使使用零参考训练,zero DCE仍然可以与其他需要成对或不成对数据进行训练的方法相比具有竞争力。所提出的方法是灵活的。我们为Zero DCE的实际应用提供了平衡增强性能和计算成本的选项,并提出了一个加速和轻版本的Zero DCE。这是通过重新设计网络结构、重新制定曲线估计和控制输入图像的大小来实现的。

图1显示了增强包含不均匀照明的微光图像的示例。与最先进的方法相比,Zero-DCE和Zero-DCE++ 都能使图像变亮,同时保留固有的颜色和细节。相反,基于CNN的方法[6]和基于GAN的方法[9]都产生了低于(面部)和高于(橱柜)的增强。我们在本文中表明,我们的方法在定性和定量度量方面都获得了最先进的性能。此外,它能够改进高级视觉任务,例如人脸检测,而不会造成高计算负担。

我们的贡献总结如下。

我们提出了第一个独立于成对和不成对训练数据的微光增强网络,从而避免了过拟合的风险。因此,我们的方法可以很好地推广到各种照明条件。•我们设计了一条特定于图像的曲线,该曲线能够通过迭代应用自身来近似像素和高阶曲线。这样的图像特定曲线可以在宽动态范围内有效地执行映射。•我们展示了在没有参考图像的情况下,通过间接评估增强质量的特定任务非参考损失函数来训练深度图像增强模型的潜力。•所提出的Zero DCE可以显著加速,同时仍然保持令人印象深刻的增强性能。我们提供了多种选项来平衡增强性能和计算资源成本。

这项工作是我们在CVRP2020[11]中出现的早期会议版本的扩展。与会议版本相比,我们引入了大量新材料。1) 我们研究了增强性能与网络结构、曲线估计和输入大小之间的关系。根据调查,我们重新设计了网络结构,重新制定了曲线的形成方式,并控制了输入图像的大小,从而提出了一个加速的轻版本,称为Zero DCE++,它更适合在资源有限的设备上进行实时增强。2) 与我们早期的工作相比,在不影响增强性能的情况下,Zero DCE的1200×900×3大小的输入图像的可训练参数(79K)和浮点运算(FLOP)(84.99G)在Zero DCE++上分别减少到10K和0.115G。这意味着在单个NVIDIA 2080Ti GPU上处理1200×900×3大小的图像时,运行时速度提高了两倍,从Zero DCE中的500 FPS提高到Zero DCE中的1000 FPS。此外,即使只有英特尔酷睿[email protected],Zero DCE的处理时间也可以从10s减少到0.09s,在单个CPU设置下速度提高了111倍。训练时间也从30分钟减少到20分钟。3) 我们进行了更多的实验、设计分析和消融研究,以证明零参考学习在微光图像增强中的优势,并展示了我们的方法相对于现有最先进方法的有效性。4) 我们对微光图像增强进行了更全面的文献调查,并讨论了当前方法的优势和局限性。

2 Related Work

我们的工作是将零参考学习与深度曲线估计相结合进行微光图像增强的一种新尝试,这在以前的工作中很少涉及。在下文中,我们回顾了微光图像增强的相关工作,包括传统方法和数据驱动方法。

Conventional Methods. 基于直方图均衡(HE)的方法通过扩展图像的动态范围来执行光增强。在全局[12]、[13]和局部[14]、[15]水平上调整图像的直方图分布。还有各种方法采用Retinex理论[16],通常将图像分解为反射率和照度。通常假设反射率分量在任何照明条件下都是一致的;因此,光增强被公式化为照明估计问题。在Retinex理论的基础上,已经提出了几种方法。王等人[17]设计了一种在处理不均匀光照图像时保持自然度和信息的方法;傅等人[18]提出了一种加权变化模型来同时估计图像的反射率和照度。估计的反射率被视为增强的结果;郭等人[19]首先通过搜索每个像素位置的最大强度来估计粗略的照明图,然后通过结构先验来细化照明图;李等人[20]提出了一种新的考虑噪声的Retinex模型。通过求解优化问题来估计照明图。

与偶然改变图像直方图分布或依赖于潜在的不准确物理模型的传统方法相反,所提出的方法通过特定于图像的曲线映射产生增强的结果。这样的策略能够在不产生不切实际的伪影的情况下对图像进行光增强。袁和孙[21]提出了一种自动曝光校正方法,其中通过全局优化算法估计给定图像的S形曲线,并通过曲线映射将每个分割区域推送到其最佳区域。与[21]不同的是,我们的方法是纯数据驱动的,在设计非参考损失函数时考虑了多个光增强因子,因此具有更好的鲁棒性、更宽的图像动态范围调整和更低的计算负担。

Data-Driven Methods. 数据驱动方法主要分为两个分支,即基于卷积神经网络(CNN)的方法和基于生成对抗网络(GAN)的方法。大多数基于CNN的解决方案依赖于成对数据进行监督训练,因此它们需要大量资源。通常,成对数据是通过自动光降解、在数据采集过程中更改相机设置,或通过图像修饰合成来详尽收集的。例如,LL-Net [22] 和 MBLLEN [23] 是在模拟随机Gamma校正的数据上进行训练的;LOL数据集 [7] 包含经过改变曝光时间和ISO而收集的成对低光/正常光图像;MIT-Adobe FiveK数据集 [24] 包括5,000张原始图像,每张图像都有经过训练专家制作的五张修饰图像。MIT-Adobe FiveK数据集最初是为了图像整体修饰而收集的;SID [25] 提供成对的低光/正常光原始数据;在 [26] 中收集了一组带有相应正常光速率拍摄的原始低光视频的数据集。

受Retinex模型的启发,最近的深度模型设计了网络,通过配对数据的监督学习来估计输入图像的反射率和照度。Ren等人[27]提出了一种用于微光图像增强的深度混合网络,该网络由两个流组成,用于在统一的网络中学习全局内容和显著结构。王等人[6]通过估计光照图提出了一种曝光不足的光增强网络。这个网络是根据三位专家重新整理的成对数据进行训练的。张等人[28]建立了一个点燃图像黑暗的网络,称为KinD,它将图像分解为两个成分。照明组件负责光调节,而反射率组件负责降解去除。基于Retinex模型的深度模型仍然受到与传统基于Retines的方法相同的限制,例如理想假设。

最近,Xu等人[8]提出了一种用于微光图像增强的基于频率的分解和增强模型。该模型首先恢复低频层中的图像内容,然后基于恢复的图像内容增强高频细节。该模型是在真实有噪声的低光和地面实况sRGB图像对的低光数据集上训练的。

可以理解的是,考虑到收集足够的配对数据所涉及的高成本,以及在训练深度模型时包含虚假和不切实际的数据,基于配对数据的光增强解决方案在许多方面都是不切实际的。这种约束反映在基于CNN的方法的泛化能力较差。当这些方法与各种光强度的真实世界图像一起呈现时,通常会生成伪影和颜色投射。

基于无监督GAN的方法具有消除成对数据进行训练的优点。一种基于GAN的无监督方法,EnlightenGAN[9],学习使用未配对的低光/正常光数据增强低光图像。通过考虑精心设计的鉴别器和损失函数来训练网络。然而,基于无监督GAN的解决方案通常需要仔细选择未配对的训练数据(无监督GAN的训练涉及学习从未标记的数据中生成样本,而不是从配对的数据中学习。这种情况下,仔细选择未配对的训练数据变得至关重要,以确保生成器可以捕捉数据的真实分布,并且判别器能够有效地区分生成的样本和真实数据)。

为了综合细胞神经网络和GANs的优势,Yang等人[29]提出了一种微光图像增强的半监督模型,该模型分两个阶段进行增强。在第一阶段中,学习从粗到细的频带表示,并在具有配对数据的递归过程中联合推断不同的频带信号。在第二阶段,通过对抗性学习重新组合波段表示。尽管半监督学习框架可以有效地提高深度模型的泛化能力,但它仍然存在对成对训练数据过拟合的风险,并导致高内存占用。

所提出的方法在三个方面优于现有的数据驱动方法。首先,它探索了一种新的学习策略,即无需参考,从而消除了对成对和不成对数据的需求。其次,通过考虑仔细定义的非参考损失函数来训练网络。该策略允许隐式地评估输出图像质量,其结果将被重申用于网络学习。第三,我们的方法效率高,成本效益高。加速版和轻型版Zero DCE仅包含10K可训练参数和0.115G FLOP,实现1000/11 FPS推理时间在单个GPU/CPU上,需要20分钟的训练时间。我们的方法的效率在很大程度上领先于当前的深度模型[6]、[7]、[9]、[23]。这些优势得益于我们的零参考学习框架、轻量级的网络结构和有效的非参考损失函数。

3 METHODOLOGY

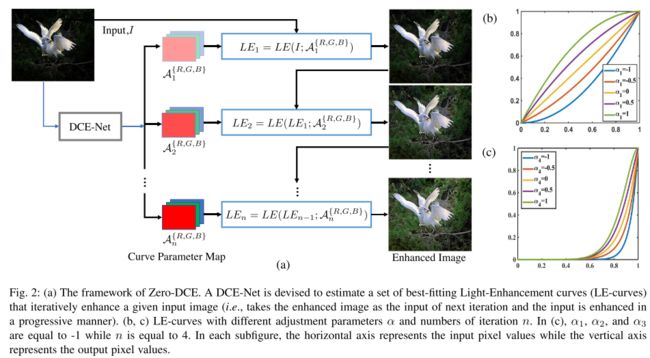

我们在图2中展示了Zero DCE的框架。设计了一种深度曲线估计网络(DCE-Net)来估计给定输入图像的一组最佳拟合的光增强曲线(LE曲线)。然后,该框架通过迭代地应用曲线来映射输入的RGB通道的所有像素,以获得最终的增强图像。在下文中,我们详细介绍了关键组件,即LE曲线、DCE-Net和非参考损耗函数。

3.1 Light-Enhancement Curve

受照片编辑软件中使用的曲线调整的启发,我们设计了一种可以自动将弱光图像映射到增强版本的曲线,其中自适应曲线参数仅取决于输入图像。这种曲线的设计有三个目标:

1) 增强图像的每个像素值应该落在[0,1]的归一化范围内,以避免溢出截断引起的信息丢失;2) 该曲线应当是单调的,以保持相邻像素的差异(对比度);3)在梯度反向传播过程中,该曲线的形式应尽可能简单且可微。

为了实现这三个目标,我们设计了一条二次曲线,可以表示为:

其中x表示像素坐标LE(I(x);α) 是给定输入I(x)的增强版本,可训练曲线参数α∈[-1,1]调整LE曲线的大小,并控制曝光水平。输入的每个像素被归一化到[0,1]的范围,并且所有操作都是逐像素的。我们将LE曲线分别应用于三个RGB通道,而不是仅应用于亮度通道。三通道调节可以更好地保留固有颜色,并降低过饱和的风险。我们在消融研究中报告了更多细节。

具有不同调整参数α的LE曲线如图2(b)所示。很明显,LEcurve符合上述三个目标。

增强图像的每个像素值在[0,1]的范围内。此外,LE曲线使我们能够增加或减少输入图像的动态范围。这种能力不仅有助于增强低光区域,而且有助于去除过度曝光的伪影。我们为二次型选择了一个特定的单参数形式,因为1)单参数形式可以降低计算成本并加快我们的方法;2)专门设计的二次型满足了我们设计的三个目标,并且已经获得了令人满意的增强性能。

Higher-Order Curve.

方程(1)中定义的LE曲线可以迭代应用,以实现更通用的调整,以应对具有挑战性的低光条件。明确地

其中n是控制曲率的迭代次数。在本文中,我们将n的值设置为8,这可以令人满意地处理大多数情况。当n等于1时,等式(2)可以退化为等式(1)。图2(c)提供了一个示例,显示了具有不同α和n的高阶曲线。与图2(b)中的曲线相比,这种高阶曲线提供了更强大的调整能力(即更大的曲率)。

Pixel-Wise Curve. 与单阶曲线相比,高阶曲线在更宽的动态范围内调整图像。尽管如此,它仍然是一个全局调整,因为α用于所有像素。全局映射往往会过度/不足地增强局部区域。为了解决这个问题,我们将α公式化为逐像素参数,即给定输入图像的每个像素都有一条具有最佳拟合α的对应曲线,以调整其动态范围。因此,方程(2)可以重新表述为:

其中A是具有与给定图像相同大小的参数图。这里,假设局部区域中的像素具有相同的强度(也具有相同的调整曲线),因此输出结果中的相邻像素仍然保持单调关系。以这种方式,逐像素的高阶曲线也符合上述三个目标。结果,增强图像的每个像素值仍然在[0,1]的范围内。

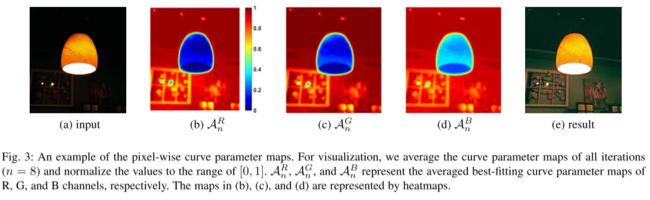

我们在图3中给出了一个估计曲线参数图的例子。如图所示,不同颜色通道的最佳拟合参数图具有相似的调整趋势,但值不同,这表明了微光图像的三个通道之间的相关性和差异。曲线参数图准确地指示了不同区域的亮度(例如,墙上的两个闪光点)。可以通过逐像素曲线映射直接获得图像。如图3(e)所示,增强版显示了暗区域的内容,并保留了亮区域。

3.2 DCE-Net

为了学习输入图像与其最佳拟合曲线参数图之间的映射,我们提出了一种深度曲线估计网络(DCE-Net)。在图4中,我们展示了DCE-Net的详细网络架构和参数设置。

DCE-Net的输入是微光图像,而输出是对应高阶曲线的一组逐像素曲线参数图。我们没有使用需要固定输入大小的完全连接层,而是使用具有对称跳跃级联的七个卷积层的普通CNN。在前六个卷积层中,每个卷积层由32个大小为3×3、步长为1的卷积核组成,然后是ReLU激活函数。最后一个卷积层由大小为3×3和步长为1的24个卷积核组成,然后是Tanh激活函数,该函数为八次迭代生成24个曲线参数图,其中每次迭代为三个通道(即RGB通道)生成三个曲线参数表。我们丢弃了破坏相邻像素关系的下采样和批量归一化层。值得注意的是,对于1200×900×3的输入图像,DCE-Net只有79K可训练参数和85G FLOP,这已经小于现有的微光图像增强深度模型,如RetinexNet[7]:555K/587G、EnlightenGAN[9]:8M/273G)和MBLLEN[23]:450K/301G。

3.3 Non-Reference Loss Functions

为了在DCE-Net中实现零参考学习,我们提出了一组可微分的非参考损失,使我们能够评估增强图像的质量。采用以下四种类型的损失来训练我们的DCE-Net。

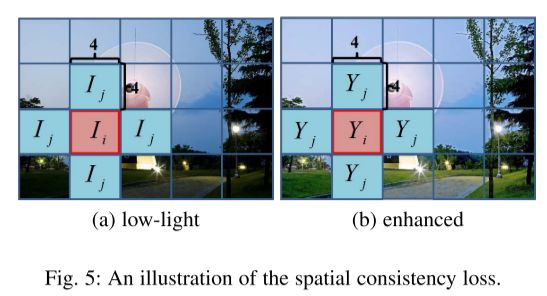

Spatial Consistency Loss. 空间一致性损失 Lspa 通过保留输入图像与其增强版本之间的相邻区域的差异来促进增强图像的空间一致性:

其中K是局部区域的数目,并且Ω(i) 是以区域i为中心的四个相邻区域(上、下、左、右)。我们将Y和i分别表示为增强版本和输入图像中局部区域的平均强度值

根据经验将局部区域的大小设置为4×4。在给定其他区域大小的情况下,这种损失是稳定的。我们在图5中说明了计算空间一致性损失的过程。

Exposure Control Loss. 为了抑制曝光不足/过度的区域,我们设计了曝光控制损失Lexp来控制曝光水平。曝光控制损失测量局部区域的平均强度值与良好曝光度水平E之间的距离。我们遵循现有实践[30]、[31],将E设置为RGB颜色空间中的灰度级。我们在实验中根据经验将E设置为0.6。损失Lexp可以表示为:

其中,M表示大小为16×16的非重叠局部区域的数量,增强图像中局部区域的平均强度值表示为Y。

Color Constancy Loss. 根据灰度世界颜色恒定性假设[32],即每个传感器通道中的颜色在整个图像上平均为灰色,我们设计了颜色恒定性损失,以校正增强图像中的潜在颜色偏差,并建立三个调整通道之间的关系。颜色恒定性损失Lcol可以表示为:

其中Jp表示增强图像中p个通道的平均强度值,一对通道表示为(p,q)。

Illumination Smoothness Loss. 为了保持相邻像素之间的单调性关系,我们为每个曲线参数添加了照明平滑度损失

4 ZERO-DCE++

尽管Zero DCE已经比现有的基于深度学习的模型[7]、[9]、[23]更快、更小,但实际应用中仍然需要降低计算成本和更快的推理速度。尤其是在处理由现代移动设备捕获的大图像时。我们提出了一种称为Zero DCE++的加速轻量化版本,以实现上述特性。

为此,我们仔细研究了增强性能与网络结构、曲线估计和输入大小之间的关系。我们观察到,1)DCE-Net中使用的卷积层可以用更有效的深度可分离卷积[33]代替,这些卷积通常用于计算机视觉任务[34]、[35]、[36],以减少网络参数,而不会对性能造成很大影响;2) 不同迭代阶段(Zero DCE中总共八次迭代)中的估计曲线参数在大多数情况下是相似的。在图6中,我们展示了不同迭代阶段的估计曲线参数图及其差异图的示例。如所观察到的,曲线参数图是相似的,并且差异图中的值很小。这些结果表明,曲线参数图可以在不同的迭代阶段重复使用,以处理大多数情况,因此我们可以将估计的曲线参数图从24个减少到3个;以及3)我们的方法对输入图像的大小不敏感。因此,我们可以使用下采样的输入作为曲线参数估计网络的输入,然后将估计的曲线参数映射上采样回原始分辨率以进行图像增强。低分辨率输入可以显著降低计算成本。基于这些观察结果,我们从三个方面修改了Zero DCE。

首先,我们通过用深度可分离卷积代替卷积层来重新设计DEC网络,以减少网络参数。每个深度可分离卷积层由具有大小为3×3和步长为1的核的深度卷积组成。其次,我们重新公式化了曲线估计,只估计了3个曲线参数图,然后在不同的迭代阶段重用它们,而不是在8次迭代中估计24个参数图。因此,方程(3)可以重新表述为

其中使用相同的曲线参数映射A来调整不同迭代阶段中的曲线。尽管我们重用了曲线参数映射,但由于迭代过程,它仍然保留了高阶特性。第三,我们可以使用下采样的图像作为我们的网络的输入来估计曲线参数图。默认情况下,我们在Zero DCE++中将输入下采样因子为12,以平衡增强性能和计算成本。即使在极端的下采样因素下,我们的方法保持了良好的性能。原因简述如下。首先,尽管我们采用下采样输入来估计曲线参数,但基于局部区域中的像素具有相同强度(以及相同的调整曲线)的假设,我们将小曲线参数映射调整回与原始输入图像相同的大小。从输入图像到增强图像的映射是在原始分辨率上进行的。其次,所提出的空间一致性损失鼓励结果保留输入图像的内容。第三,我们框架中采用的损失是区域性的,但不是像素性的。我们在消融研究中提出了更多的讨论和结果。

这些修改为Zero DCE ++提供了具有微小网络(10K可训练参数,对于1200×900×3大小的图像为0.115G FLOP)、实时推理速度(对于1200×900x3大小的图像,单个GPU/CPU上的1000/11 FPS)和快速训练(20分钟)的优势。

5 EXPERIMENTS

5.1 Implementation Details

基于CNN的模型通常使用自捕获的配对数据进行网络训练[7],[25],而基于GAN的模型则精心选择未配对的数据[9],[37]。为了充分发挥宽动态范围调整的能力,我们将低光和过度曝光的图像纳入训练集。为此,我们使用SICE数据集[38]的第1部分中的360个多重暴露序列来训练我们的模型。该数据集也被用作EnlightenGAN[9]中训练数据的一部分。我们将第1部分子集[38]中3022张不同曝光水平的图像随机分为两部分(2422张用于训练,其余用于验证)。我们将训练和测试图像的大小调整为512×512×3。

我们在NVIDIA 2080Ti GPU上使用MindSpore实现了我们的框架。应用的批量大小为8。用标准零均值和0.02标准差高斯函数初始化每层的滤波器权重。偏置初始化为常量。我们使用具有默认参数和固定学习率1e−4的ADAM优化器进行网络优化。权重Wcol和WtvA分别设置为0.5和20,以平衡损失的规模。Zero-DCE和Zero-DCE++在训练过程中采用相同的训练数据集和配置。

5.2 Experimental Settings

我们将我们的方法与几种最先进的方法进行了比较:三种传统方法(SRIE[18],LIME[19],Li等人[20]),四种基于CNN的方法(Wang等人[6],RetinexNet[7],LightenNet[39],MBLLEN[23]),以及一种基于GAN的方法(EnlightenGAN[9])。使用具有推荐参数的公开可用源代码来再现结果。

我们对先前工作中使用的标准图像集进行了定性和定量实验,包括NPE[17](84幅图像)、LIME[19](10幅图像),MEF[40](17幅图像)和DICM[41](64幅图像)以及VV3(24幅图像)。此外,我们在SICE数据集[38]的第2部分子集上定量验证了我们的方法,该数据集由229个多重曝光序列和每个多重曝光序列的相应参考图像组成。为了进行公平的比较,我们只使用第2部分子集[38]的低光图像进行测试,因为基线不能很好地处理过度曝光的图像。具体来说,如果多重曝光序列中有七个(分别为九个)图像,我们选择前三个(分别是四个)微光图像,并将所有图像的大小调整为1200×900×3。最后,我们获得了767张成对的低光/正常光图像,表示为第二部分测试集。

[42]中提到的低/正常光图像数据集被丢弃,因为RetinexNet[7]和EnlightenGAN[9]的训练数据集由该数据集的一些图像组成。我们没有使用MIT Adobe FiveK数据集[24],因为它不是主要为曝光不足的照片增强而设计的,并且在地面实况集中仍然包含一些弱光图像。请注意,本文只关注RGB图像的微光图像增强,因此我们没有包括需要原始数据作为输入的方法,而是为通用照片增强而设计的。

5.3 Ablation Study

我们进行消融研究,以证明Zero DCE的每个组件的有效性。此外,在本节末尾,还对Zero DCE和Zero DCE++进行了比较,以分析加速版和轻型版的优缺点。

Contribution of Each Loss.

我们在图7中展示了由各种损失组合训练的ZeroDCE的结果。没有空间一致性损失Lspa的结果具有比完整结果相对更低的对比度(例如,云区域)。这表明了Lspa在保留输入图像和增强图像之间的相邻区域的差异方面的重要性。去除曝光控制损失Lexp未能恢复低光区域。当丢弃颜色恒定性损失Lcol时,会出现严重的颜色投射。当应用曲线映射时,此变体会忽略三个通道之间的关系。最后,去除照明平滑损失 LtvA 会削弱相邻区域之间的相关性,导致明显的伪影。这样的结果表明,在我们的零参考学习框架中使用的每个损失在实现最终令人满意的视觉效果中都发挥着重要作用。

Advantage of Three Channels Adjustment.

为了证明三通道调整的优势,我们尝试使用与RGB颜色空间中的调整相同的配置,仅在CIE Lab和YCbCr颜色空间中调整照明相关通道,除了去除仅可用于三通道调整中的颜色恒定性损失。

具体来说,我们首先将输入从RGB颜色空间转移到CIE Lab(YCbCr)颜色空间,然后将L(Y)分量馈送到DCE-Net,用于估计一组曲线参数图,其中我们在训练阶段计算L(Y)通道中的每个损耗。最后,我们使用方程3和估计的曲线参数来调整L(Y)分量。在L(Y)分量的调整之后,相应地调整对应的ab(CbCr)分量(等比例调整)。在图8中,我们展示了一个示例来演示三通道调整的优势。如所观察到的,所有结果都显示出改善的亮度和对比度,这表明单通道调节(CIE Lab和YCbCr颜色空间)和三通道调节(RGB颜色空间)在改善给定微光图像的亮度方面的有效性。然而,如图8(c)和(d)所示,在CIE Lab和YCbCr颜色空间中调整的结果具有明显的颜色偏差(例如,墙壁的颜色)和过饱和(例如,灯笼的区域)。视觉对比表明,三通道调节可以更好地保留固有颜色,并降低过饱和的风险。

Effect of Parameter Settings. 我们评估了Zero DCE中参数的影响,包括DCENet的深度和宽度以及迭代次数。图9给出了一个可视化示例。如图9(b)所示,只有三个卷积层,Zero-DCEl3−f32−n8已经可以产生令人满意的结果,这表明了零参考学习的有效性。Zero-DCEl7−f32−n8和Zero-DCEl 7−f33−n16通过自然曝光和适当的对比度产生了最令人视觉愉悦的效果。通过将迭代次数减少到1,Zero-DCEl7−f32−n1的性能明显下降,如图9(d)所示。这是因为只有一次迭代的曲线具有有限的调整能力。这表明在我们的方法中需要更高阶的曲线。

同样的趋势也可以在表1中的定量比较中找到。Zero-DCEl3−f32−n8的输入和增强结果之间的比较表明,尽管网络仅包含三个卷积层,但所提出的方法是有效的。Zero-DCEl7−f32−n1由于仅一次迭代(即n=1)的调整能力有限,实现了最差的量化性能,这表明使用更多迭代的重要性。当我们将每层的特征图数量从16个增加到32个时,定量性能得到了改善(即Zero-DCEl7−f16−n8和ZeroDCEl7−f32−n8)。将迭代次数从8增加到16只会略微提高平均PSNR值(即ZeroDCEl7−f32−n8和Zero-DCEl7−f33−n16)。因此,基于Zero-DCEf7−l32−n8在效率和恢复性能之间的良好权衡,我们选择它作为最终模型。

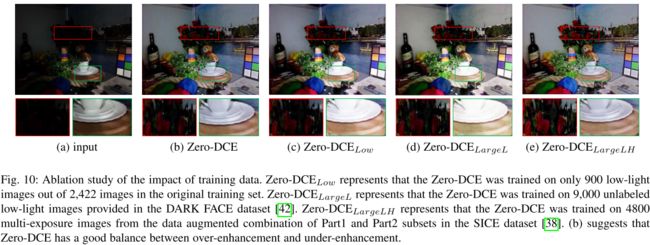

Impact of Training Data. 为了测试训练数据的影响,我们在不同于第5.1节所述的数据集上重新训练Zero DCE。如图10(c)和(d)所示,在去除过度暴露的训练数据后,Zero DCE倾向于过度增强良好照明的区域(例如Zero DCELow和Zero DCLargeL的结果中的杯状),尽管使用了更多的低光图像(即Zero DCeLageL)。这些结果表明了其合理性和在我们网络的训练过程中使用多曝光训练数据的必要性。此外,如图10(e)所示,当使用更多的多曝光训练数据(即Zero DCELageLH)时,Zero DCE可以更好地恢复暗区域(例如玫瑰)。

Effect of Well-Exposedness Level. 我们研究了在曝光控制损失中使用的良好曝光度水平E对我们的方法的增强性能的影响。我们设置了四个不同的井暴露度水平E(即0.4、0.5、0.6、0.7)来训练我们的网络,分别表示为Zero-DCEE0.4、Zero-DCEE5.5、Zero-DCE 0.6(即我们的最终Zero-DCE模型)和Zero-DCE 0.7。一组可视化结果如图11所示。定量比较如表2所示。如表2所示,Zero-DCEE0.6获得了最好的定量分数。Zero-DCEE0.5获得了与Zero-DCEE6.6相当的性能。Zero-DCEE-04和Zero-DCEE0.7的量化性能略逊于Zero-DCEE6.6和Zero-DCE 0.5。如图11所示,Zero-DCEE0.5和Zero-DCEE6.6获得了视觉上令人愉悦的亮度。相反,Zero-DCEE0.4会产生曝光不足,而Zero-DCEE7会过度增强输入图像。最后,基于Zero-DCEE0.6良好的定性和定量性能,我们选择它作为最终模型。

Zero-DCE VS. Zero-DCE++. 我们首先分析了输入尺寸对我们方法的影响。如第4节所述,我们首先用深度分离卷积替换DCE-Net的卷积层,并在八次迭代中重用曲线参数图。然后,我们将不同大小的输入提供给修改后的框架。表3总结了增强性能和输入大小之间的统计关系。在图12中,我们还通过向修改后的框架提供不同大小的输入来显示几个结果。如表3和图12所示,对输入大小进行下采样对增强性能有不明显的影响,但显著节省了计算成本(以FLOP为单位)。如图所示,结果为12×↓实现了最高的平均PSNR值,因此我们将其作为Zero DCE中的默认操作。然后,我们进行了一项消融研究,通过更换修改后的组件来比较Zero DCE和Zero DCE++之间的网络结构。消融模型包括具有深度可分离卷积的Zero-DCE(表示为DSconv)和在不同迭代阶段共享曲线参数图的Zero-DEC(表示为Pshared)。Zero DC的输入是原始分辨率图像,而在“DSconv”和“Pshared”中默认使用12×下采样操作。烧蚀模型的定量比较结果如表4所示。

如表4所示,“DSconv”和“Pshared”的可训练参数和FLOP都比Zero DCE少。引入“DSconv”和“Pshared”会略微降低PSNR值。“DSconv”和“Pshared”(即零DCE)组合的可训练参数和FLOP显著降低,PSNR值的降低可以忽略不计。结果表明了这种修改的有效性。在图13中,Zero DCE在一些具有挑战性的情况下仍然优于Zero DCE。例如,与Zero-DCE++相比,Zero-DCE可以更有效地处理具有挑战性的照明,而不会引入过度/不足曝光。根据质量和效率的具体要求,可以在Zero DCE和ZeroDCE++之间进行选择。

5.4 Benchmark Evaluations

在本节中,我们进行了定性和定量实验,以比较不同的方法。我们还研究了不同方法在黑暗中人脸检测的性能。

5.4.1 Visual andPerceptual Comparisons

我们在图14中展示了典型微光图像的视觉比较。对于具有挑战性的背光区域(例如,图14(a)中的面部),Zero DCE可产生自然曝光和清晰的细节,而SRIE[18]、LIME[19]、LightenNet[39]、MBLLEN[23]、Wang等人[6]和EnlightenGAN[9]不能清楚地恢复面部。相比之下,RetinexNet[7]会产生过度暴露的伪影。在以室内场景为特征的第二个示例中,我们的方法增强了暗区域并同时保留了输入图像的颜色。结果在视觉上令人愉悦,没有明显的噪音和颜色投射。相比之下,Li等人[20]和MBLLEN[23]对细节进行了过度平滑,而其他基线方法会放大噪声,甚至产生颜色偏差(例如墙壁的颜色)。总体而言,Zero DCE在室内和室外场景中都获得了与Zero DCE相当的性能。我们还展示了不同方法对从第二部分子集测试集采样的图像的结果。比较结果如图15所示。与保留低光区域或引入明显伪影的其他方法的结果相比,所提出的Zero-DCE和Zero-DCE不仅产生了更清晰的细节,而且不引入阻塞伪影。我们的方法倾向于生成具有适当对比度、清晰细节、生动色彩和较少噪声的结果。

我们进行了一项用户研究,以量化各种方法的主观视觉质量。我们通过不同的方法处理来自图像集(NPE、LIME、MEF、DICM、VV)的微光图像。对于每个增强的结果,我们将其显示在屏幕上,并提供输入图像作为参考。总共邀请15名人类受试者对增强图像的视觉质量进行独立评分。这些受试者通过观察

1) 结果是否包含过度/不足暴露的伪影或过度/不足增强的区域;2) 结果是否引入颜色偏差;以及3)结果是否具有不自然的纹理和明显的噪声,视觉质量的得分范围从1到5(最差到最好的质量)。步长设置为1。表5中报告了每个图像集的平均主观得分。如表5所示,Zero DCE在上述图像集中总共199张测试图像中获得了最高的平均用户研究(US)得分,而Zero DCE++获得了第二高的US得分。Zero-DCE和Zero-DCE获得了相似的受试者得分,这进一步表明了Zero-DCE的有效性和稳健性。对于MEF、DICM和VV集合,我们的结果最受受受试者的青睐。总之,用户研究表明,从人类主观视觉角度来看,我们的方法可以在不同的微光图像上产生更好的性能。除了US分数外,我们还使用非参考感知指数(PI)[44]、[45]、[46]来评估感知质量。PI度量最初用于测量图像超分辨率中的感知质量。它还被用于评估其他图像恢复任务的性能,例如图像去雾。较低的PI值表示更好的感知质量。表5中也报告了PI值。与用户研究类似,所提出的Zero DCE在平均PI值方面优于其他竞争方法。它在LIME、MEF和DICM集合上获得了最佳的感知质量。Zero DCE++也会产生相互竞争的平均PI值。

5.4.2 Quantitative Comparisons

我们使用全参考图像质量评估指标PSNR、SSIM[43]和MAE指标来定量比较不同方法在第2部分测试集上的性能。SSIM值越高表示在结构特性方面结果越接近基本事实。较高的PSNR(较低的MAE)值指示结果在像素级图像内容方面更接近基本事实。在表6中,所提出的Zero DCE在所有情况下都实现了最佳值,尽管它不使用任何成对或不成对的训练数据。相反,Zero-DCE++获得了与Zero-DCE相当的性能,例如在第2部分测试集上的PSNR和SSIM值的第二好定量得分。我们的Zero DCE计算效率高,得益于简单的曲线映射形式和轻量级的网络结构。此外,Zero-DCE++极大地加快了Zero-DCE的速度,并且只花费很少的计算资源。表7显示了在32张1200×900×3大小的图像上平均的不同方法的运行时间、可训练参数和FLOP。对于传统方法和LightenNet[39],只有CPU版本的代码可用。

与目前的方法相比,我们的方法以较大的裕度实现了最快的运行时间(即Zero DCE:0.0025s和Zero DCE++:0.0012s)。此外,Zero DCE++的运行时间仅为0.0012s,确实比目前的方法快。Zero DCE的运行时间分别是最近基于深度学习的方法Wang等人[6]和EnlightenGAN[9]的17.5倍和6.5倍。Zero DCE++仅包含一个微小的网络结构,该结构具有10561个可训练参数,成本为0.12G FLOP,非常适合实际应用。

5.4.3 Face Detection in the Dark

我们研究了弱光条件下弱光图像增强方法在人脸检测任务中的性能。具体而言,我们使用DARK FACE数据集[42],该数据集由10000张在黑暗中拍摄的图像组成。由于测试集的边界框不是公开的,我们对训练集和验证集进行了评估,训练集和校验集总共由6000张图像组成。使用在WIDER face数据集[49]上训练的最先进的深度人脸检测器,双镜头人脸检测器(DSFD)[48]作为基线模型。我们将不同微光图像增强方法的结果提供给DSFD[48]。我们在图16中描绘了IoU阈值0.5下的精度召回(P-R)曲线,并使用DARK FACE数据集[42]中提供的评估工具5比较了不同IoU阈值(即0.5、0.7、0.9)下的平均精度(AP)。AP结果如表8所示。Zero-DCE++在高召回率区域表现更好。如表8所示,当我们设置更高的IoU阈值时,所有方法的AP得分都会下降。当IoU阈值设置为0.9时,所有方法的性能都非常差。在0.5和0.7的IoU阈值下,Zero-DCE和Zero-DCE获得了相似的AP分数,仅略低于RetinexNet产生的最佳结果[7]。然而,如前所述,RetinexNet[7]的主观和定量结果并不令人满意。相反,我们的方法不需要成对的训练数据,并很好地平衡了主题增强性能、应用程序性能和计算成本。通过观察这些例子,我们的ZeroDCE和ZeroDCE使极端黑暗区域的人脸变亮,并保留了光线充足的区域,从而提高了人脸检测器在黑暗中的性能。

6 CONCLUSION

我们提出了一种用于微光图像增强的深度网络。它可以使用零参考图像进行端到端训练。这是通过将微光图像增强任务公式化为图像特定曲线估计问题,并设计一组可微分的非参考损耗来实现的。通过重新设计网络结构、重新公式化曲线估计和控制输入图像的大小,可以进一步改进所提出的Zero DCE,这对于实际应用来说是非常轻量级和快速的。我们的方法在增强性能和效率方面都很出色。实验证明了我们的方法相对于现有的光增强方法的优越性。