aigc修复美颜学习笔记

目录

GFPGAN进行图像人脸修复

美颜

修复畸形手势

GFPGAN进行图像人脸修复

原文:本地使用GFPGAN进行图像人脸修复_人相修复处理网页 csdn-CSDN博客

人脸修复

1.下载项目和权重文件

2.部署环境

3.下载权重文件

4.运行代码

5.网页端体验

首先来看一下效果图

1.下载项目和权重文件

https://github.com/iptop/GFPGAN-for-Video.git

1

2.部署环境

根据README文件部署好环境,额外还需要:

cd GFPGAN-1.3.8

python setup.py develop

1

2

3.下载权重文件

可提前下载好权重文件(也可以等运行代码的时候,自动下载)权重文件的url:

https://ghproxy.com/https://github.com/TencentARC/GFPGAN/releases/download/v1.3.0/GFPGANv1.3.pth

https://github.com/xinntao/facexlib/releases/download/v0.1.0/detection_Resnet50_Final.pth

https://github.com/xinntao/facexlib/releases/download/v0.2.2/parsing_parsenet.pth

下载好的权重文件放在路径./GFPGAN-for-Video/gfpgan/weights下

安利一个github文件下载加速网站:https://ghproxy.com/

4.运行代码

原代码是用来修复视频,但是我用了后没发现有啥效果,所以暂时只是用来修复图片

在./GFPGAN-for-Video/src路径下创建脚本image_enhance.py

import argparse

import cv2

from utils.restorer import Restorer

def videoEnhance (image_path , output_image_path):

restorer = Restorer()

image = cv2.imread(image_path)

frame = restorer.enhance(image)

cv2.imwrite(output_image_path, frame)

return True

def main():

parser = argparse.ArgumentParser()

parser.add_argument(

'-i',

'--input',

type=str,

required=True,

metavar='请输入要处理的图片文件路径',

help='请输入要处理的图片文件路径')

parser.add_argument(

'-o',

'--output',

type=str,

required=True,

metavar='请输入输出图片的路径',

help='请输入输出图片的路径')

args = parser.parse_args()

videoEnhance(args.input, args.output)

if __name__ == '__main__':

main()

运行脚本就可得到修复后的图片了

python src/image_enhance.py -i input.png -o output.png

1

5.网页端体验

Hugging Face网页端:https://huggingface.co/spaces/Xintao/GFPGAN

我试了下速度很慢

————————————————

版权声明:本文为CSDN博主「咚咚锵咚咚锵」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/weixin_45977690/article/details/132695954

美颜

参考:

AIGC-照片美颜精修解决方案_WebUI_效果_模型

这个方案中的难点:如何有效保留用户原图信息,如何使用有效的磨皮美颜prompt达到美颜效果;

具体实现

1.StableDiffusion大模型选择

美颜效果主要表现为皮肤白皙,没有褶皱,斑点,雀斑,法令纹,眼角纹,痣等等,为了达到这类效果,我们首先要选择合适的SD模型,这里我们选择ChilloutMix模型,具体下载地址:

C站地址:ChilloutMix | Stable Diffusion Checkpoint | Civitai

huggingface地址:swl-models/chilloutmix at main (huggingface.co)

这个模型的效果举例如下:

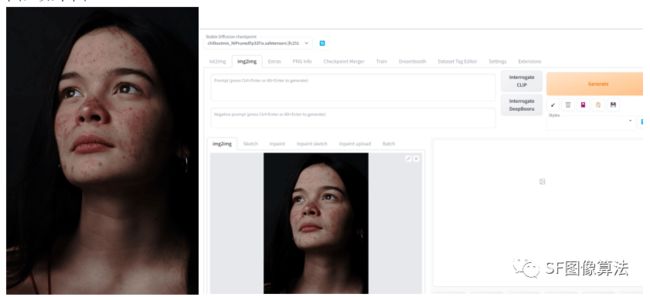

2.有了大模型之后,我们以WebUI为例,进行分析,打开WebUI,由于我们要进行修图,所以,我们需要选择img2img模式,在该模式下选择ChilloutMix大模型。我们选择一张测试图,如下图:

导入WebUI后,如图所示。

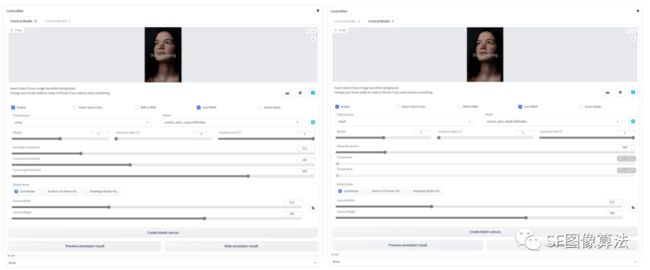

3.叠加两个Controlnet控制,分别为canny边缘控制、depth深度信息控制,参数设置分别如下( 选用canny和depth的原因是我们需要通过边缘和深度信息尽可能的保留用户原图信息):

4.img2img参数设置

这里提供美颜专用的prompt:

positive:masterpiece,best quality,high res, (photorealistic:1.4),(red face blush:1.2),red lips,extremely detailed

negative:(worst quality:2), (low quality:2), (normal quality:2), lowres, normal quality,(skin spots:2), acne,acne marks,mole (skin blemishes:2), (age spot:2), watermark,signature water mark

主要描述说明:

face blush:腮红

red lips:红色唇彩

skin spots:皮肤斑点

acne:雀斑

age spot:老年斑

skin blemishes:皮肤瑕疵

mole:痣

对于Prompt描述,我们可以自行研究,这里给的主要是磨皮和简单的唇彩腮红效果,实际上可以定义各种人脸效果,包括肤色调节,美白,妆容等等,这也就是AIGC做人像美颜的优越性体现。除了这些参数之外,其他参数设置:

5.基于上述参数设置,点击运行,效果图如下:

原图 AIGC生成效果

通过修改描述词,微调效果如下:

上述效果我们仔细看会发现,其实与原图还是有一些差别的,这些差别在某些情况下会导致不像用户,为此,我们做到这里并没有结束,我们需要挑选我们想要的美颜区域,叠加到用户原图之上,以此来保证用户ID相似性。

4.img2img参数设置

这里提供美颜专用的prompt:

positive:masterpiece,best quality,high res, (photorealistic:1.4),(red face blush:1.2),red lips,extremely detailed

negative:(worst quality:2), (low quality:2), (normal quality:2), lowres, normal quality,(skin spots:2), acne,acne marks,mole (skin blemishes:2), (age spot:2), watermark,signature water mark

主要描述说明:

face blush:腮红

red lips:红色唇彩

skin spots:皮肤斑点

acne:雀斑

age spot:老年斑

skin blemishes:皮肤瑕疵

mole:痣

对于Prompt描述,我们可以自行研究,这里给的主要是磨皮和简单的唇彩腮红效果,实际上可以定义各种人脸效果,包括肤色调节,美白,妆容等等,这也就是AIGC做人像美颜的优越性体现。除了这些参数之外,其他参数设置:

修复畸形手势

听说这个不是特别好:

1. **HandRefiner 修复畸形手势**

优点:免费,提示词

Huggingface平台AI应用:https://huggingface.co/spaces/fffiloni/HandRefiner