Rethinking Deep Neural NetworkOwnership Verification: Embedding Passports toDefeat Ambiguity Attacks

重新思考深度神经网络所有权验证:嵌入护照以抵御模糊攻击

Abstract

随着大量时间、资源和人力(团队)投入到探索和开发成功的深度神经网络(DNN)中,迫切需要保护这些发明免受非法复制、重新分发或滥用的侵害,同时尊重合法所有者的知识产权。在沿着这一方向取得的最新进展后,我们研究了一系列基于水印的DNN所有权验证方法,面对模糊攻击,这些攻击旨在通过伪造伪造水印来对所有权验证产生质疑。研究表明,模糊攻击对现有的DNN水印方法构成严重威胁。作为对上述漏洞的解决方案,本文提出了新颖的基于护照的DNN所有权验证方案,即对网络修改具有鲁棒性,又能抵御模糊攻击。嵌入数字护照的要点在于以一种方式设计和训练DNN模型,使得原始任务的DNN推断性能由于伪造的护照而显著恶化。换句话说,真实的护照不仅通过寻找预定义的签名进行验证,而且还通过坚定不移的DNN模型推断性能来重新确认。大量实验证明了提出的基于护照的DNN所有权验证和方案的有效性。

1 Introduction

随着深度神经网络(DNN)的迅速发展,机器学习即任务(MLaaS)已经成为一种可行且有利可图的商业模式。然而,构建成功的DNN并非一项微不足道的任务,通常需要在专业知识、时间和资源方面进行大量的投资。因此,迫切需要保护发明的DNN模型免受非法复制、重新分发或滥用(即知识产权侵权)。最近,例如,数字水印技术已被采用,通过在训练阶段将水印嵌入DNN模型中,提供这种保护。随后,通过检测嵌入的水印来验证这些发明的所有权,这些水印应该对多种类型的修改具有鲁棒性,如模型微调、模型剪枝和水印覆写。

在嵌入水印的深度学习方法方面,现有的方法可以广泛分为两类:a)基于特征的方法,通过引入额外的正则化项将指定的水印嵌入到DNN权重中;b)基于触发集的方法,依赖于带有特定标签的对抗训练样本(即后门触发集)。使用这两种方法嵌入的水印成功的展示了对抵抗DNN权重修改(如微调或剪枝)的强鲁棒性。然而,我们的研究揭示了模糊攻击的存在性和有效性,这些攻击旨在通过为涉及的DNN模型伪造额外的水印来对所有权验证产生质疑(见图1)。我们还展示了以较小的计算成本总是可能对伪造的水印进行逆向工程,而无需原始训练数据集。

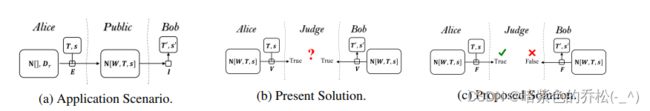

图1:面对模糊攻击的DNN模型所有权验证。 (a): 所有者Alice使用嵌入过程E来训练带有水印(T, s)的DNN模型,并公开发布该模型;攻击者Bob使用反演过程I伪造伪造水印(T0, s0);(b): 由于验证过程V检测到原始水印和伪造水印,所有权受到质疑(第2.2节);(c): 当我们提出的护照被嵌入并通过忠实度评估过程F进行网络性能评估,支持原始护照时,模糊性得以解决(见定义1和第3.3节)。

作为对上述漏洞的补救措施,本文提出了一种新颖的基于护照的方法。提出的护照相对于传统水印具有独特的优势,即预训练的DNN模型的推断性能在存在有效护照的情况下将保持完好,或者在存在修改或伪造护照的情况下显著恶化。换句话说,我们建议根据呈现的护照调制DNN模型的推断性能,通过这样做,可以开发出既对抗去除攻击又对抗模糊攻击的所有权验证方案。

我们的工作贡献有三个方面:有(1)我们提出了DNN所有权验证方案的一般公式,并在经验上展示了现有DNN水印方法对模糊攻击的脆弱性;(2)我们提出了新颖的基于护照的验证方案,并通过大量实验结果展示了这些方案成功抵御了模糊攻击;(3)从方法学的角度看,基于呈现的护照调制DNN推断性能的提出在控制DNN模型行为抵御对抗性攻击方面发挥了不可或缺的作用。

1.1 Related work

内田等人可能是第一篇提出在DNN模型中嵌入水印的工作,通过对权重参数施加额外的正则化项。【2,6】提出在对抗样本的分类标签中嵌入水印,形成触发集,以便可以通过服务API远程提取水印,而无需访问网络权重(即黑盒设置)。在黑盒和白盒设置下,【3,5,7】同时演示了如何嵌入对各种类型攻击都具有鲁棒性的水印(或指纹)。特别是,它表明嵌入的水印通常对通过微调或剪枝修改网络权重的去除攻击具有鲁棒性。另一方面,水印覆写更为问题复杂,因为它旨在同时嵌入新水印并破坏现有水印。尽管【5】表明对抗覆写攻击具有鲁棒性,但未解决由伪造水印引起的模糊性。Adi等人还讨论了如何处理对手使用新触发集图像微调已添加水印网络的情况。然而,【2】要求新图像集必须与真实触发集图像可区分。然而,在实践中,这一要求通常无法满足,我们的实验结果显示,现有水印方法都无法处理本文中探讨的模糊攻击。

触发集:在机器学习和深度学习中,“触发集”通常是指一组特殊设计的输入样本,这些样本能够导致模型产生误导的输出。这样的集合通常被用于对抗性攻击和对抗性训练。在对抗性攻击中,攻击者通过向原始输入样本中添加微小的扰动,生成具有特定标签的对抗性样本,这些样本属于触发集。当这些对抗性样本被输入到模型中时,模型的输出结果可能与原始输入的标签相反。对抗性训练则是通过在训练数据中引入触发集样本,使得模型能够更好地抵御对抗性攻击。通过训练模型使其能够正确处理这些触发集样本,可以提高模型地鲁棒性。触发集数据是一组用于测试或训练模型对抗性攻击特殊设计地样本。在某些上下文中,触发集也可能用于其他目的,例如评估模型的安全性或鲁棒性。

在数字图像水印领域,【8,9】研究了旨在通过利用伪造水印的可逆性从已添加的水印的图像中逆向工程出水印的模糊攻击。有人认为,强大的水印并不一定意味着能够建立所有权,除非采用不可逆的水印方案(有关我们提出的解决方案,请参见命题2)。

2 Rethinking Deep Neural Network Ownership Verification(重新思考深度神经网络所有权验证)

本节分析并概括了现有的DNN水印方法在面对模糊攻击时的情况。我们必须强调,分析主要集中在三个方面,即所有权验证方案的忠实度、鲁棒性和可逆性,我们将读者引用到代表性的先前工作,其中包括整个水印的知识产权(IP)保护方案的公式和其他期望的特性,这些特性不在本文的范围内。

2.1 Reformulation of DNN ownership verification schemes(DNN所有权验证方案的重构)

图1总结了水印方案提供的DNN模型所有权验证的应用场景。受【10】启发,我们还描绘了一个模糊的情况,即仅通过当前的水印方案无法唯一解决正当所有权。这个漏洞主要是由于水印方法固有的弱点,即可逆性。形式上,DNN模型所有权验证方案的定义概括如下。

定义1:一个DNN模型所有权验证方案是由四个过程组成的元组V=(E,F,V,I):

(1)嵌入过程E(Dr,T,s,N[·],L)=N[W,T,s]是一个DNN学习过程,它将训练数据Dr={Xr,yr}作为输入,并可选地选择触发集数据T={XT,yT}或签名s,通过最小化给定损失L来输出模型N[W,T,s]。

注:DNN架构是由N[·]事先确定地,在学习了DNN权重W后,触发集T或签名s将被嵌入,并可以通过下面定义地验证过程进行验证。

(2)保真度评估过程F(N[W,·,·],Dt,Mt,∈f)={True,False}是评估差异是否小于预定义的阈值,即|M(N[W,·,·],Dt)-Mt|<=∈f,其中,M(N[W,·,·],Dt)是针对一组测试数据Dt测试的DNN推理性能,其中Mt是目标推理性能。

注:通常期望表现良好的嵌入过程不会引入大于预定义阈值∈f的显著推理性变化。然而,在去除攻击或模糊攻击下,DNN模型的保真度条件仍有待验证。

(3)验证过程V(N[W,·,·],T,s,∈s)={True,False}检查对于给定的DNN模型N[W,·,·],期望签名s或触发集T是否成功验证。

注:对于基于特征的方案,V是对嵌入签名s={P,B}进行检测,且检测误检率小于预定义阈值∈s。具体来说,检测可归结为测量目标特征B与由P参数化的变换函数fe(W,P)提取的特征之间的距离Df(fe(W,P))。

注:对于基于触发集的方案,V首先调用DNN推理过程,将触发集样本T作为输入,然后检查预测f(W,XT)是否产生指定标签Ty,并且误检率小于阈值∈s。

(4)存在一个反转过程I(N[W,T,s])=N[W,T',s'],并且构成一个成功的歧义攻击,如果

(a)一组新的触发集T'和签名s'可以对给定的DNN模型进行逆向工程;

(b)对于给定的DNN权重W,可以成功地验证伪造的T',s',即V(I(N[W,T,s]),T',s',∈s)=True;

(c)定义1定义的保真度评价结果F(N[W,·,·],Dt,Mt,∈f)。Ⅱ仍然正确。

注:此条件在设计不可逆验证方案以挫败歧义攻击时起着不可或缺的作用。

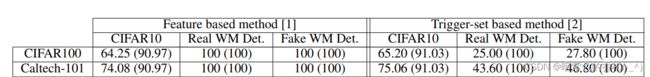

表格1:两种代表性基于水印的DNN方法[1, 2]在DNN权重微调进行迁移学习任务前后,检测嵌入水印的准确度(以百分比表示)。顶行表示使用CIFAR10训练的DNN模型,对CIFAR100进行权重微调;底行表示对Caltech-101进行权重微调。括号外的准确度表示迁移任务,括号内的准确度表示原始任务。WM Det.表示实际和伪造水印的检测准确度。

(5)如果DNN验证方案V至少存在一个反转过程,则称该方案为可逆方案,记为VI=(E,F,V,I≠空);否则称为不可逆,记为V空=(E,F,V,空)。

这样的定义是抽象的,可以通过过程和函数的具体实现来实现实例化。例如,下面的组合损失函数概括了基于特征和基于触发集的水印方法所采用的损失函数:

其中,λt,λr是相对权重超参数,f(W,X_)为输入Xr或XT的网络预测。Le是像交叉熵一样的损失函数,用于惩罚预测和目标标签yr或者yT之间的差异。签名s={P,B}由护照P和签名字符串B组成。正则化项可以是R=Lc(σ(W,P),B),如【1】或R=MSE(B-pw),如【3】。

必须指出的是,对于那些将用于分类任务的DNN模型,它们的推理性能M(N[W,· ,·],Dt)=Lc(f(W,Xt),yt)针对数据集Dt={Xt,yt}进行测试,与嵌入签名s或触发集t无关。整是这种独立性导致了如下所述的现有基于水印的方法的可逆过程。

提案1(可逆过程)对于定义1中的DNN所有权验证方案V,如果保真度过程F()独立于签名s或触发集T,则总存在一个可逆过程I(),即方案可逆V=(E,F,V,I≠空)。

2.2 Watermarking in the face of ambiguity attacks(面对模糊攻击的水印技术)

正如命题1所证明的,人们能够构建对任何已添加水印的网络都有效的伪造水印。我们测试了两种代表性的DNN水印方法【1,2】的性能,表1显示对给定的DNN模型可以伪造出100%检测准确率的伪造水印,并且在原始任务中也可以重建100%的伪造触发集图像。鉴于在微调后,对于伪造的触发集的检测准确度略优于原始触发集,所有权的声明变得模糊,并且无法通过基于特征或基于触发集的水印方法解决。令人震惊的是,伪造伪造水印的计算成本非常小,仅需不到100个时期的优化,最糟糕的是,这是在不需要原始训练数据的情况下实现的。

总之,针对DNN水印方法的模糊攻击是有效的,而且计算成本非常小,无需原始训练数据集。我们将这个漏洞归因于原始任务的缺失,即Lc是独立于伪造水印的,我们建议读者参阅我们的扩展版本,以了解我们采用的模糊攻击方法的详细说明和更详细的实验结果。在下一节中,我们将阐述一种解决方案来抵御模糊攻击。

3 Embedding passports for DNN ownership verification(嵌入数字护照进行DNN所有权验证)

嵌入数字护照的主要动机是以一种设计和训练DNN模型的方式,使得它们在原始任务(即分类准确度)的推断性能由于伪造的签名而显著恶化。接下来,我们将首先说明如何通过引入所谓的护照层来实现所需的属性,然后介绍利用嵌入的护照来有效抵御模糊攻击的不同所有权保护方案。

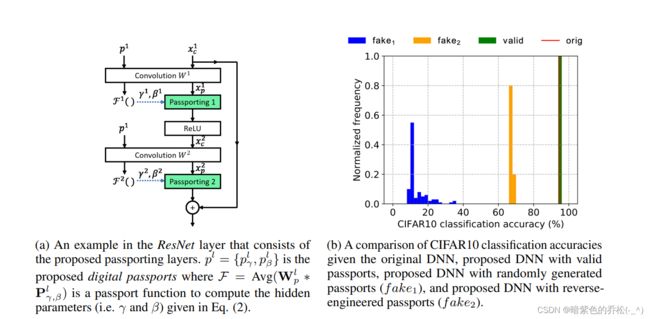

(a) ResNet层中包含了提出的护照层的示例。pl = {plγ, plβ} 是提出的数字护照,其中 F = Avg(Wlp ∗ Plγ,β) 是一个护照函数,用于计算隐藏参数(即γ和β),如公式(2)所示。

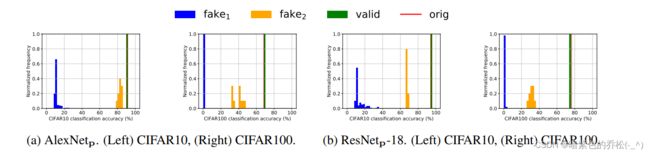

(b) CIFAR10分类准确度的比较,包括原始DNN、带有效护照提出的DNN、带随机生成护照(fake1)的提出DNN,以及带反向工程护照(fake2)的提出DNN。

图2:(a) ResNet架构中的护照层,以及(b) CIFAR10中通过不同护照调制的分类准确度,例如,给定伪造护照,DNN模型的性能将立即下降,以防止非法使用。

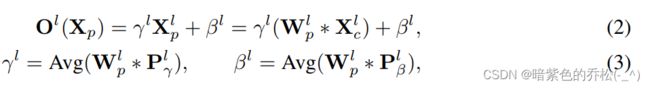

为了通过嵌入的数字签名,即护照,控制DNN模型的功能,我们提出在卷积层之后追加一个护照层,其缩放因子γ和偏移项β取决于卷积核Wp和指定的护照P,具体如下:

其中,*代表卷积操作,I是层编号,Xp是护照层的输入,Xc是卷积层的输入。O()是相应的输出的线性变换,而Plγ和PIβ分别是用于得到缩放因子和偏移项的护照。图2a描述了在ResNet层中使用的数字护照层的结构。

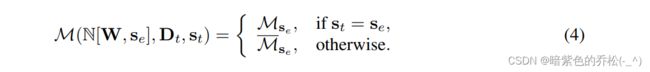

备注:对于使用护照se={Plγ,PIβ}训练的DNN模型,它们的推断性能M(N[W,se],Dt,st)取决于运行时间的护照st,即

如果没有呈现真实的护照st≠se,则运行时性能Mse会明显下降,因为相应的缩放因子γ和偏移项β是基于错误的护照计算的,例如,如图2b所示,一个带有有效护照的提出的DNN模型(绿色)将表现出几乎与原始DNN模型(红色)相同的准确性。相反,同一个提出的DNN模型使用伪造护照(蓝色)呈现,准确性将仅下降到约%。

备注:提出的护照层的要点是强制在缩放因子、偏移项和网络权重之间建立依赖关系。正如命题2所示,正是这种依赖关系确保了所需的不可逆性,以抵御模糊攻击。

命题2(非可逆过程)。如定义1中所述的DNN所有权验证方案V是非可逆的,如果

(1)保真度过程F(N[W,T,s],Dt,Mt,∈f)取决于所呈现的签名s或触发集T,

(2)在伪造护照st≠se,公式4中的DNN推理性能M(N[W,se],Dt,st)会恶化,以至于差异大于阈值,即|Mse-_Mse|>∈f。

3.2 缩放因子的符号作为签名

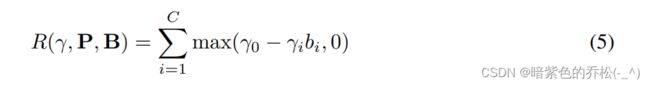

在学习DNN过程中,为了进一步保护DNN模型免受内部威胁(例如,一名前员工利用从创始人窃取的所有资源创立新的创业公司),可以强制缩放因子γ采用指定的正负号(+-),以形成一个唯一的签名字符串(类似指纹)。这一过程通过将以下符号损失正则化项添加到综合损失(公式1)中来完成:

其中,B = {b1, · · · , bC } ∈ {−1, 1},C 包含了用于C个卷积核的指定二进制位,γ0 是一个正控制参数(默认为0.1,除非另有说明),旨在鼓励缩放因子具有大于γ0的幅度。

必须强调的是,加入符号损失(公式5)强制缩放因子γ采用正值或负值,并且以这种方式强制的符号在面对各种敌对攻击时仍然相当持久。这一特征解释了在第4.2节中展示的通过反向工程的模糊攻击中嵌入护照的卓越鲁棒性。

3.3 Ownership verification with passports(使用护照进行所有权验证)

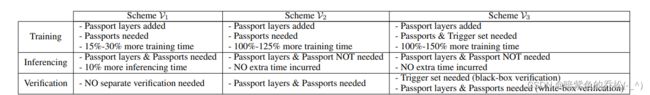

利用提出的基于护照的方法,我们设计了三种新的所有权验证方案V,下面进行总结并将读者引向第4节以获取实验结果。

V1:护照于训练好的DNN模型一起分发

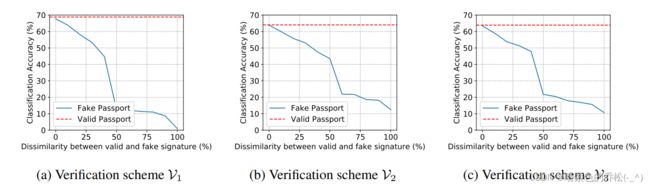

在这种情况下,学习过程旨在最小化综合损失函数(公式1),其中λt=0,因为在此方案中未使用触发集图像,而符号损失(公式5)被添加为正则化项。然后将训练好的DNN模型与护照一起分发给合法用户,他们通过将给定的护照馈送到护照层中进行网络推理,如图2a所示。网络所有权将通过分发的护照自动进行验证。如表2和图3所示,这种所有权验证对DNN模型的修改具有鲁棒性。此外,如图4所示,模糊攻击无法伪造一组可以维持DNN推理性能的护照和签名。

这种方案的缺点是在推断期间需要使用护照,这会导致额外的计算成本增加约10%(见4.3节)。此外,将护照分发给最终用户是具有侵入性的,并且需要额外的责任来安全保护这些护照。

V2:嵌入私有护照但不分发

在这种情况下,学习过程旨在同时实现两个目标,其中第一个目标是在不包含护照层时最小化原始任务损失(例如分类准确性差异);第二个目标是最小化包括护照正则化在内的综合损失函数(公式1)。从算法上来讲,通过在这两个目标之间交替最小化来实现这种多任务学习。然后,成功训练的DNN模型被分发给最终用户,他们可以在不需要护照的情况下进行网络推理。请注意,这是可能的,因为在分发的网络中没有包含护照层。只有在执法机构提出要求时,才会进行所有权验证,通过将护照层添加到相关网络并检测嵌入的签名来验证,同时保持原始网络推理性能的不变性。

与V1方案相比,这种方案对于最终用户来说易于使用,因为不需要护照,也不会产生额外的计算成本。与此同时,这种所有权验证对于删除攻击以及模糊攻击都具有鲁棒性。然而,缺点是需要访问DNN权重并附加护照层进行所有权验证,即如【2】中讨论的白盒保护模式的缺点。因此,我们建议将其与接下来将要描述的基于触发集的验证相结合。

V3:嵌入了私有护照和触发集,但不分发

这种方案与V2方案的区别仅在于,除了嵌入的护照外,还嵌入了一组触发图像。正如【2】中讨论的那样,这样做的好处是通过远程调用服务API来探测和声明可疑DNN模型的所有权。这种能力使得首先可以以黑盒模式声明所有权,然后通过白盒模式中的护照验证重新声明所有权。从算法的角度看,触发集图像的嵌入是通过与在V2方案中嵌入护照的相同最小化过程共同实现的。最后,必须注意的是,在V2和V3方案中嵌入护照是通过多任务学习任务实现的,其中我们采用了组归一化,而不是由于其依赖于批次训练样本的平均而无法应用的批次归一化。

在机器学习和网络安全领域,黑河模式和白盒模式通常用来描述对系统的理解程度或者攻击的知识水平。

黑盒模式:在黑盒模式中,用户或攻击者对系统内部的结构和工作原理一无所知,只能通过输入和输出的观察来理解系统。在机器学习中,黑盒模型指的是模型的内部结构和参数对用户来说是不可见的,用户只能通过输入数据和模型的输出来进行推断。黑盒攻击意味着攻击者对系统内部结构一无所知,仅仅通过试错和观察来进行攻击。

白盒模式:在白盒模式中,用户或攻击者具有对系统内部结构和工作原理的完全了解。在机器学习中,白盒模型指的是模型的结构和参数是可见和可解释的,用户可以直接查看模型的内部,了解每个组件的作用。白盒攻击则是指攻击者对系统内部结构有详细的了解,可以有针对性地进行攻击。

在文章中提到地黑盒模式可能是指在不了解模型内部结构地情况下对其进行所有权验证或攻击。白盒模式可能是指在了解模型内部结构地情况下进行验证或攻击。

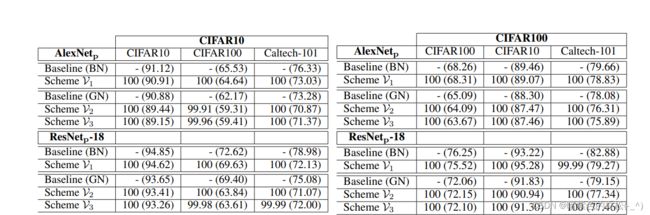

表2:去除攻击(微调):不同护照网络的检测/分类准确度(以%表示),其中BN = 批次归一化,GN = 组归一化。(左侧:使用CIFAR10训练并微调为CIFAR100/Caltech-101。右侧:使用CIFAR100训练并微调为CIFAR10/Caltech-101。)括号外的准确性是签名检测率,而括号内是分类率。

4 Experiment results

本节介绍了基于护照的DNN模型的实验结果,比较了各种方案在对抗去除攻击和模糊攻击方面的鲁棒性。我们调查的网络架构包括著名的AlexNet和ResNet-18,他们在典型的CIFAR10和CIFAR100分类任务中进行测试。这些中等大小的公共数据集允许我们对DNN模型性能进行广泛的测试。除非另有说明,所有实验均重复5次,并针对50个伪造护照进行测试以获得平均推理性能。此外,为了避免与原始的AlexNet和ResNet模型混淆,我们将AlexNetp和ResNetp-18表示为我们提出的基于护照的DNN模型。

4.1 Robustness against removal attacks(对去除攻击的鲁棒性)

微调

表2显示,所有权验证方案在原始任务中对签名的检测准确率接近100%。即使对提出的DNN模型进行新任务的微调(例如,从CIFAR10到Caltech-101),几乎仍然保持100%的准确率。请注意,只有在所有二进制位完全匹配的情况下,才会声明检测到的签名。我们归因于尺度因子的独特控制性质,即如果尺度因子的值接近零,通道输出将几乎为零,因此其梯度消失,并失去朝相反值移动的动力。在经验上,我们并未观察到反例来反驳这一解释。

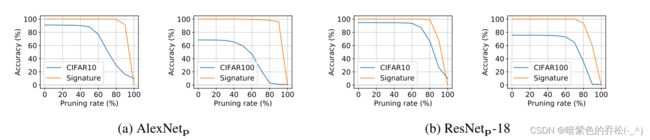

模型修剪

模型修剪的目的是减少冗余参数而不影响性能。在这里,我们采用【14】中的类盲修剪方案,并测试我们提出的DNN模型在不同修建率下的性能。图3显示,总体上,即使剪掉60%的参数,我们提出DNN模型仍然保持接近100%的准确率,而测试数据的准确率下降约5%-25%。即使我们剪掉90%的参数,我们提出的DNN模型的准确率仍然远高于测试数据的准确率。正如前面所述,我们归功于嵌入在尺度因子符号的签名的出色持久性,这使其对模型修剪具有鲁棒性。

尺度因子:在深度学习中,尺度因子通常指的是在神经网络的每个层中与权重相乘的系数。这个系数用来缩放层的输出,影响网络的表示能力和学习能力。具体来说,在神经网络的每个层中,输入通过与权重矩阵的乘法进行线性变换,然后通过激活函数进行非线性变换。尺度因子就是这个线性变换的一部分,用来调整每个输入特征的权重。尺度因子越大,相应特征对最终输出的影响就越大;尺度因子越小,对应特征的影响就越小。在某些情况下,尺度因子也可以被加入到神经网络的训练中,使得网络可以学习到每个特征的合适的权重。这种情况下,尺度因子可能被整合到网络的参数中,并通过反向传播算法进行调整。在上下文中,文章提到的尺度因子可能指的是在提出的DNN模型中用于嵌入数字护照的系数,以及在文中描述的对抗性攻击和模糊攻击的鲁棒性。

图3:去除攻击(模型修剪):我们基于护照的DNN模型在CIFAR10/CIFAR100上的分类准确度以及在不同修剪率下对签名检测准确度。

图4:模糊攻击:我们的护照网络在CIFAR10和CIFAR100上的分类准确度,包括具有有效护照的网络、随机攻击(fake1)和反向工程攻击(fake2)。

表3:在三种不同的模糊攻击模式(fake)下,方案V1、V2和V3中总体护照网络性能的总结。

4.2 Resilience against ambiguity attacks(对模糊攻击的鲁棒性)

如图4所示,我们提出的DNN模型在CIFAR10/100分类任务上的检测准确性显著依赖于有效或伪造的护照的存在-提出的DNN模型使用有效护照呈现的准确性几乎与原始DNN模型相同。相反,同样的提出的DNN模型使用无效护照(在这种情况下是fake1=随机攻击)的情况下只达到了10%的准确性,仅相当于随机猜测。在fake2的情况下,我们假设攻击者可以访问原始训练数据集,并尝试通过冻结训练后的DNN权重来反向工程尺度因子和偏置项。如图4所示,在CIFAR10中,反向工程攻击最多只能在AlexNetp上达到84%的准确性,而在ResNetp-18上达到70%的准确性。而在CIFAR100中,对于fake1的情况,对我们提出的DNN模型的攻击只能达到1%的准确性;对于fake2的情况,这种攻击只能在AlexNetp上达到44%的准确性,在ResNetp-18上达到35%的准确性。

表3总结了在三种不同的模糊攻击模式fake下,提出的方法的准确性,这取决于攻击者对保护机制的了解。表明所有相应的基于护照的DNN模型的准确性都在不同程度上恶化。因此,通过忠诚度评估过程F(),成功击败了模糊攻击。我们想要强调的是,即使在最恶劣的条件下,即冻结权重、最大化与原始护照P的距离并最小化准确性损失(通俗地说,这意味着由于内部威胁而利用了原始护照和尺度符号,我们将其视为fake3),攻击者仍然无法使用新的(修改后的)尺度符号而不影响网络准确性。

如图5所示,当原始尺度符号的10%和50%被修改时,CIFAR100的分类准确度分别下降了约5%和50%。在原始尺度符号保持不变的情况下,可以通过预定义的符号字符串轻松验证DNN模型的所有权。此外,表3显示攻击者无法利用Dt来伪造模糊的护照。

图5:模糊攻击:CIFAR100上三种验证方案的内部威胁下的分类准确率(fake3)。图中显示,当使用正确的签名时,分类准确率保持不变,而对于部分正确的签名(标度符号修改约为10%),性能将立即下降约5%,而完全错误的签名将获得无意义的准确率(1%-10%)。基于对AlexNetp的阈值≤ ∈f = 3%以及忠诚度评估过程F,任何潜在的模糊攻击(即使具有部分正确的签名)都能够被有效地击败。

表4:我们提出的V1、V2和V3方案的护照网络复杂性摘要

基于这些经验研究,我们决定在Definition1中将阈值∈f设为分别为3%的AlexNetp和20%的ResNetp-18。通过这个忠诚度评估过程,任何潜在的模糊攻击都能够被有效地击败。总的来说,广泛地经验研究表明,无论对手是随机生成的还是使用原始训练数据集反向工程生成的,他们都无法通过使用伪造的护照来保持原始DNN模型的准确性。这种依赖护照的性能在设计安全的所有权验证方案中发挥着不可或缺的作用。

4.3 Network Complexity

表4总结了各种方案中护照网络的复杂性。我们认为,需要最小化的是推断阶段的计算成本,因为最终用户将频繁执行网络推断。另一方面,培训和验证阶段的额外成本并不是禁止性的,因为它们由网络所有者执行,其动机是保护DNN模型的所有权。尽管如此,我们测试了一个更大的网络(即ResNetp-50)和其培训时间分别增加了10%、182%和191%。这个增加与较小的模型(即AlexNetp和ResNetp-18)一致。

5 Discussions and conclusions

考虑到巨头和初创公司每秒都在投入数十亿美元来探索新的DNN模型,我们认为有必要保护这些发明免受盗窃。虽然可以通过向中央机构注册模型来解决DNN模型的所有权问题,但已经认识到这些规定是不足的,迫切需要技术解决方案来支持执法和法律保护。正是这个动机凸显了所提方法在明确验证DNN模型所有权方面的独特贡献。

在方法学上,我们的实证研究再次表明,过度参数化的DNN模型可以成功地学习具有任意分配地标签和约束地多个任务。尽管这一断言已经在理论上得到证明,并且从网络泛化地角度进行了经验性研究,但其对网络安全的一般影响仍有待讨论。我们相信,所提出的基于呈现的护照调制DNN性能的方法将在控制DNN行为抵抗对抗性攻击方面发挥不可或缺的作用,正如它在DNN所有权验证中所展示的那样。