大模型日报-20240119

这里写目录标题

-

- 机器人领域首个开源视觉-语言操作大模型,RoboFlamingo框架激发开源VLMs更大潜能

- 用大模型帮程序员找Bug,中科院剖析102篇论文总结出这些方案

- Nature 子刊 | 化学家和机器人都可以读懂,用于机器人合成可重复性的通用化学编程语言

- Stability AI发布Stable Code 3B模型,没有GPU也能本地运行

- 上海AI实验室书生·浦语2.0正式开源,回归语言建模本质

- OpenAI 组建新团队,收集公众意见以确保 AI 大模型与人类价值观保持一致

- 大的要来了*2!Sanseviero:这可能是自Code Llama以来,代码大型语言模型最激动人心的一周之一

- Karpathy调侃:购买我们的令牌包,让AI成为你的超级粉丝!

- Mollick分享微软Copilot Pro应用程序简要评测:一套相当令人印象深刻的工具

- Huyen分享帖子《文本生成的采样》:当今与人工智能合作中的许多挑战(和机遇)源于模型输出采样的方式

- JumpCoder: 通过在线修改超越自回归编码

- 大语言模型能够学习时间推理

- EmoLLMs:一系列情感大语言模型和全面情感分析的注释工具

- 小的语言模型可以自我纠正

- Allchemy

- AI Town - RWKV Proxy

- 深入浅出 LoRA

- Transformer推理优化综述

- Web3 + AI 赛道全景盘点

- Python中LLM输出的结构化存储与解析

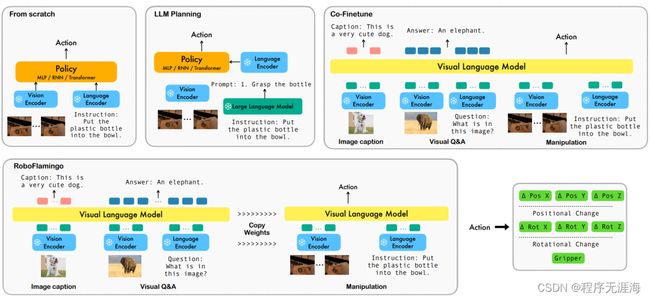

机器人领域首个开源视觉-语言操作大模型,RoboFlamingo框架激发开源VLMs更大潜能

https://mp.weixin.qq.com/s/rJ5nuV4Og_2BWJbLncHOiw

近年来,大模型的研究正在加速推进,它逐渐在各类任务上展现出多模态的理解和时间空间上的推理能力。机器人的各类具身操作任务天然就对语言指令理解、场景感知和时空规划等能力有着很高的要求,这自然引申出一个问题:能不能充分利用大模型能力,将其迁移到机器人领域,直接规划底层动作序列呢?OpenFlamingo 在机器人操作数据集 CALVIN 上进行了验证,实验结果表明,RoboFlamingo 只利用了 1% 的带语言标注的数据即在一系列机器人操作任务上取得了 SOTA 的性能。随着 RT-X 数据集开放,采用开源数据预训练 RoboFlamingo 并 finetune 到不同机器人平台,将有希望成为一个简单有效的机器人大模型 pipeline。论文还测试了各种不同 policy head、不同训练范式和不同 Flamingo 结构的 VLM 在 Robotics 任务上微调的表现,得到了一些有意思的结论。

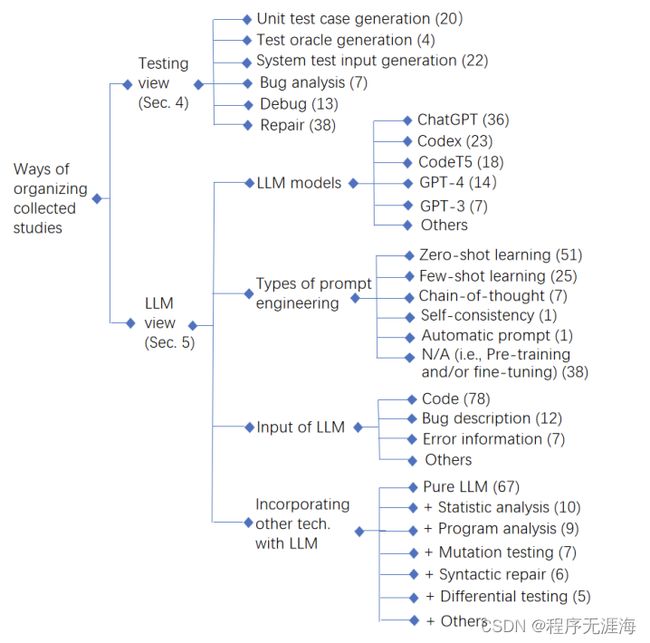

用大模型帮程序员找Bug,中科院剖析102篇论文总结出这些方案

https://mp.weixin.qq.com/s/_8x7eKir_fqCj2g5rzRNbw

大模型由于其卓越的自然语言理解、推理等能力,已经被应用于各种场景,取得了前所未有的效果。类似的,软件测试领域也受益于其强大的能力,能够帮助生成逼真且多样化测试输入,模拟各种异常,加速缺陷的发现,提升测试效率,进行潜在提高软件质量。来自中国科学院软件研究所、澳大利亚Monash大学、加拿大York大学的研究团队收集了截止到2023年10月30日发表的102篇相关论文,并分别从软件测试和大模型视角进行了全面分析,总结出一篇关于大模型在软件测试领域应用的全面综述。

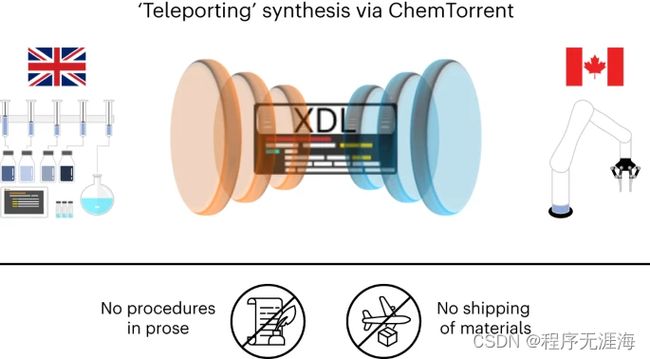

Nature 子刊 | 化学家和机器人都可以读懂,用于机器人合成可重复性的通用化学编程语言

https://mp.weixin.qq.com/s/Bg0CQ9UDfvNqZ8Oj6Jtezg

有关化学合成的文献数量快速增长;然而,实验室之间共享和评估新流程需要很长时间。在此,来自加拿大不列颠哥伦比亚大学(UBC)和英国格拉斯哥大学的研究团队,提出了一种方法,使用通用化学编程语言(χDL)在两个实验室的四种不同硬件系统上编码和执行各种化学反应的合成程序,包括还原胺化、成环、酯化、碳-碳键形成和酰胺偶联。每个反应大约有 50 行代码,所提方法使用抽象来有效地压缩化学协议。不同的机器人平台始终如一地产生预期的合成,每步产量高达 90%,从而实现更快、更安全的研究工作流程,可以通过数量增加而不是规模扩大来提高过程的吞吐量。

Stability AI发布Stable Code 3B模型,没有GPU也能本地运行

https://mp.weixin.qq.com/s/K8eiK6ygHfJpWUBiRyKFZw

在文生图领域大火的 Stability AI,今天宣布了其 2024 年的第一个新 AI 模型:Stable Code 3B。顾名思义,Stable Code 3B 是一个拥有 30 亿参数的模型,专注于辅助代码任务。 无需专用 GPU 即可在笔记本电脑上本地运行,同时仍可提供与 Meta 的 CodeLLaMA 7B 等大型模型具有竞争力的性能。2023 年底,Stability AI 便开始推动更小、更紧凑、更强大模型的发展,比如用于文本生成的 StableLM Zephyr 3B 模型。随着 2024 年的到来,Stability AI 开年便马不停蹄的发布 2024 年第一个大型语言模型 Stable Code 3B,其实这个模型早在去年八月就发布了预览版 Stable Code Alpha 3B,此后 Stability AI 一直在稳步改进该技术。新版的 Stable Code 3B 专为代码补全而设计,具有多种附加功能。

上海AI实验室书生·浦语2.0正式开源,回归语言建模本质

https://www.thepaper.cn/newsDetail_forward_26040295

1月17日,书生·浦语2.0(InternLM2)发布会暨书生·浦源大模型挑战赛启动仪式在上海举行。上海人工智能实验室与商汤科技联合香港中文大学和复旦大学正式发布新一代大语言模型书⽣·浦语2.0。InternLM2是在2.6万亿token的高质量语料上训练得到的。沿袭第一代书生·浦语(InternLM)的设定,InternLM2包含7B及20B两种参数规格及基座、对话等版本,满足不同复杂应用场景需求。秉持“以高质量开源赋能创新”理念,上海人工智能实验室继续提供InternLM2免费商用授权。

OpenAI 组建新团队,收集公众意见以确保 AI 大模型与人类价值观保持一致

https://www.ithome.com/0/745/634.htm

1 月 17 日消息,美国当地时间周二,人工智能领域的佼佼者 OpenAI 在其博客上宣布,他们正在组建一个名为“集体对齐”(Collective Alignment)的全新团队。这个团队主要由研究人员和工程师构成,将专注于设计和实施收集公众意见的流程,以帮助训练和塑造其人工智能模型的行为,从而解决潜在的偏见和其他问题。

大的要来了*2!Sanseviero:这可能是自Code Llama以来,代码大型语言模型最激动人心的一周之一

https://x.com/osanseviero/status/1747356927040815397?s=20

Omar Sanseviero:

剧透警告:这可能是自Code Llama以来,代码大型语言模型最激动人心的一周之一。

Karpathy调侃:购买我们的令牌包,让AI成为你的超级粉丝!

https://x.com/karpathy/status/1747411855520481400?s=20

Andrej Karpathy:

下一代搜索引擎优化

通过购买我们的高级加值令牌包,让所有的大型语言模型都了解并喜欢你(或你的公司)!只需100美元的极低价格,我们将在互联网上生成并散布10亿个合成数据令牌,赞美你(或你的企业)是非凡的。

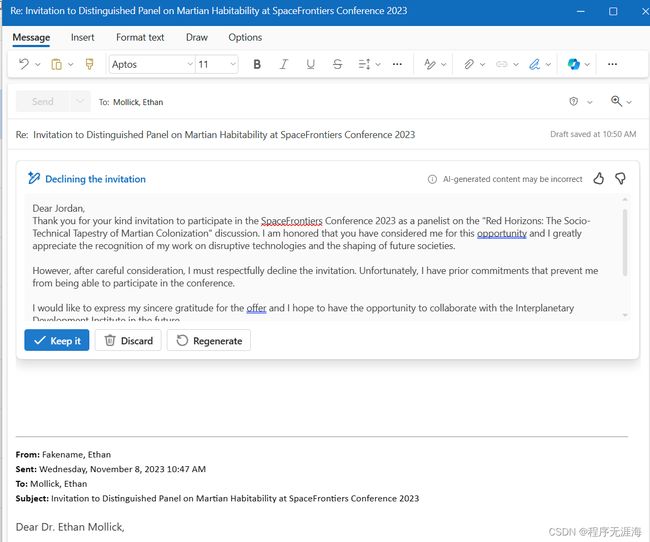

Mollick分享微软Copilot Pro应用程序简要评测:一套相当令人印象深刻的工具

https://x.com/emollick/status/1747359731595763817?s=20

鉴于它们现已出售,以下是我尝试过的微软Copilot Pro应用程序的简要评测:

Outlook:在核心应用程序中深度集成方面,这是最流畅的Copilot之一,在很多方面也是最显而易见的用例。它基本上让GPT-4回答和总结你的电子邮件。它在起草电子邮件回复方面做得很好(尽管要注意幻觉),但我希望它能处理约会和日程安排。

Word:一个更友好(但功能较弱)的方式,让ChatGPT-4为你写作。这可能最终会成为Pro应用程序中的大热门,因为许多人似乎没有意识到GPT-4作为写作工具的强大功能,而Word使其变得显而易见。如果你是一个ChatGPT-4的高级用户,你可能会转而使用它,但它的确表现得相当好。

PowerPoint:从技术上讲,最令人印象深刻的Copilot是PowerPoint中的那个:它能够直接从文档(附有演讲者备注!)创建一个完全插图的初稿演示文稿,尽管这些演示文稿并不那么令人兴奋。人们如何以及何时使用它将非常有趣。我想知道创建扎实演示文稿的便利性是否会使PowerPoint更普遍,或者打破它在各处办公室的控制。

Excel:它目前做得不多,有很多限制。这尤其令人失望,因为Excel支持Python,而GPT-4在Python和数据方面做得非常好。有很大的潜力改变电子表格的性质,但今天没有真正的用例。

OneNote:我玩得最少,所以没什么可说的。

总而言之,这是一套相当令人印象深刻的工具,特别是如果你不是GPT-4的高级用户。同样清楚的是,内置在每个人最常用的办公工具中的易用用户体验将使AI生成的内容无处不在,无论是好是坏。

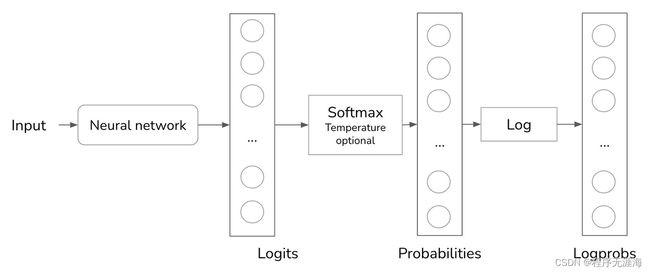

Huyen分享帖子《文本生成的采样》:当今与人工智能合作中的许多挑战(和机遇)源于模型输出采样的方式

https://x.com/chipro/status/1747472205796303306?s=20

Chip Huyen:文本生成的采样

https://huyenchip.com/2024/01/16/sampling.html

当今与人工智能合作中的许多挑战(和机遇)源于模型输出采样的方式。

本帖涵盖:

1.采样策略和变量,包括温度、top-k和top-p。

2.如何采样多个输出以提高模型的性能。

3.如何让模型按照特定格式生成输出。

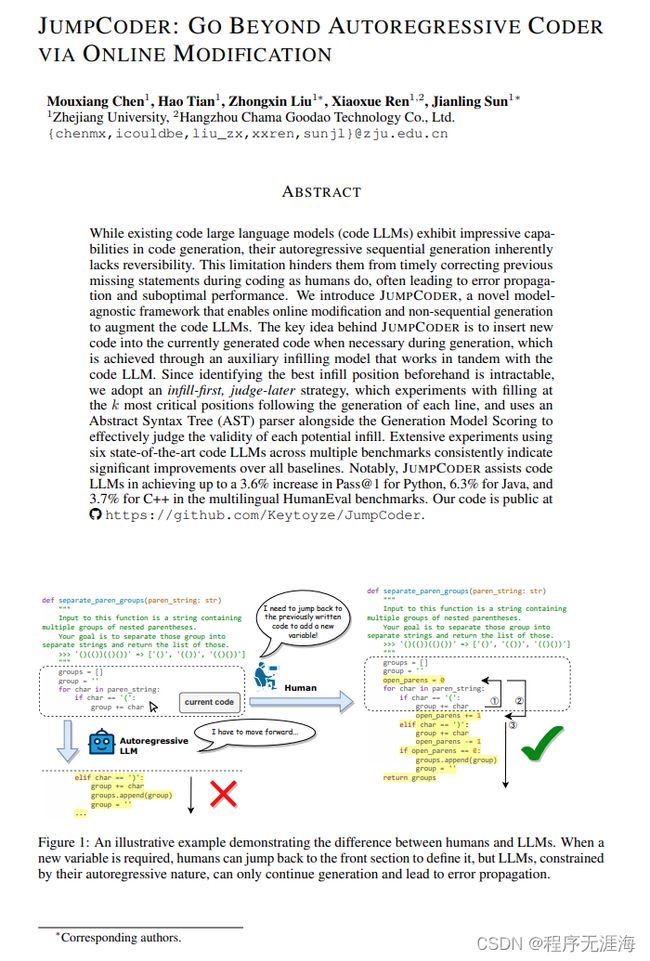

JumpCoder: 通过在线修改超越自回归编码

链接:http://arxiv.org/abs/2401.07870v1

现有的大型代码语言模型(Code LLM)在代码生成方面具有令人印象深刻的能力,但它们的自回归顺序生成方法本质上缺乏可逆性。这个限制阻碍了它们像人类一样及时纠正编码中的缺失语句,往往导致错误传播和次优性能。我们引入了JumpCoder,这是一个创新的模型不可知框架,可以实现在线修改和非顺序生成以增强代码LLM。JumpCoder的关键思想是在生成过程中在必要时插入新的代码,并通过辅助填充模型与代码LLM协同工作来实现。由于事先确定最佳填充位置是困难的,我们采取先填充后评估的策略,通过在生成每行后实验填充k个最关键位置,并使用抽象语法树(AST)解析器和生成模型评分来有效评估每个潜在填充的有效性。在多个基准测试中使用六个最先进的代码LLM进行的广泛实验一致表明,相对于所有基准线,JumpCoder显著改善了效果。值得注意的是,JumpCoder在多语言HumanEval基准测试中帮助代码LLM实现了Python的Pass@1的增加了3.6%,Java的增加了6.3%,C++的增加了3.7%。我们的代码可以在https://github.com/Keytoyze/JumpCoder上公开访问。

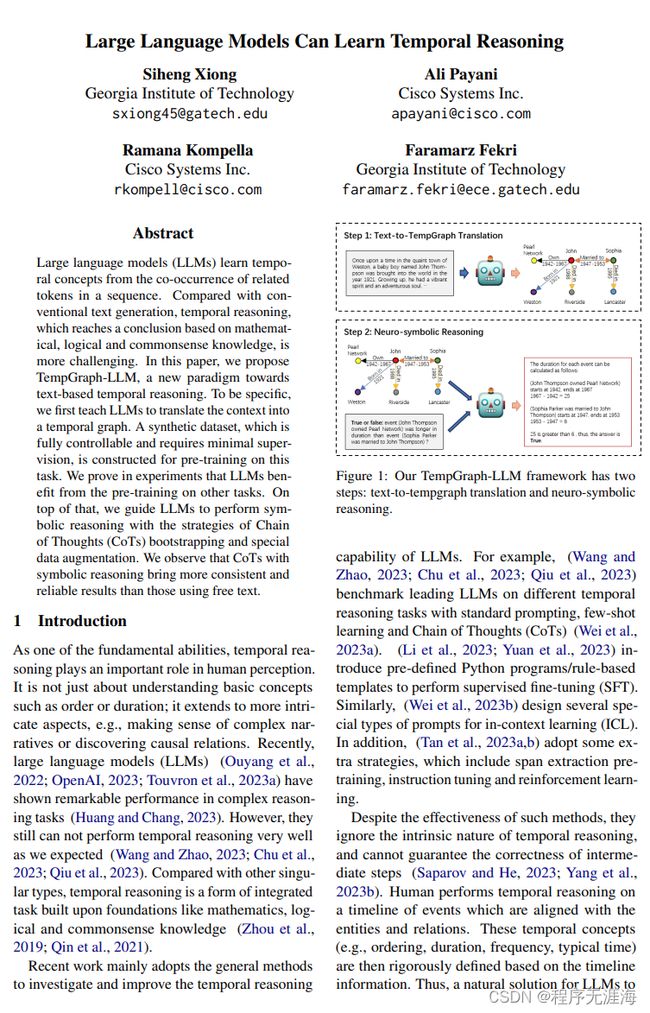

大语言模型能够学习时间推理

链接:http://arxiv.org/abs/2401.06853v1

大语言模型 (LLMs) 通过序列中相关token的共现学习时间概念。与传统的文本生成相比,基于数学、逻辑和常识知识得出结论的时间推理更具挑战性。在本文中,我们提出了一种新的基于文本的时间推理范式TempGraph-LLM。具体来说,我们首先教导LLMs将上下文转化为一个时间图。为了对这个任务进行预训练,我们构建了一个完全可控并且需要最少监督的合成数据集。实验证明LLMs受益于其他任务的预训练。在此基础上,我们通过"CoTs启动式链条思维"和特殊的数据增强策略来引导LLMs进行符号推理。我们观察到,符号推理的CoTs相比使用自由文本的方法带来了更加一致可靠的结果。

EmoLLMs:一系列情感大语言模型和全面情感分析的注释工具

链接:http://arxiv.org/abs/2401.08508v1

情感分析和情绪检测是自然语言处理(NLP)中的重要研究课题,并且在许多下游任务中发挥着作用。随着LLM的广泛应用,研究人员开始探索基于指导微调的LLM在情感分析领域的应用。然而,这些模型只关注情感分类任务的单个方面(例如情感极性或分类情绪),而忽视了回归任务(例如情感强度或情绪强度),这导致下游任务的性能较差。主要原因是缺乏综合的情感指导微调数据集和评估基准,这些数据集涵盖了各种情感分类和回归任务。此外,尽管情感信息对于下游任务是有用的,但现有的下游数据集缺乏高质量和综合的情感注释。在本文中,我们提出了EmoLLMs,这是第一个基于使用指导数据对各种LLM进行微调的综合情感分析的开源LLM系列。我们还提出了第一个多任务情感分析指导数据集(AAID),其中包含234K个数据样本,涵盖了各种分类和回归任务,以支持LLM指导微调,并提供了一个涵盖了来自各种来源和领域的14个任务的综合情感评估基准(AEB),以测试LLM的泛化能力。我们通过使用AAID对LLM进行微调,提出了一系列EmoLLM来解决各种情感指导任务。我们在AEB上将我们的模型与各种LLM进行了比较,其中我们的模型优于所有其他开源LLM,并在大多数任务中超过了ChatGPT和GPT-4,这表明EmoLLM系列在情感分析任务上实现了与ChatGPT和GPT-4相当的泛化能力,并证明了我们的模型可以用作情感注释工具。

小的语言模型可以自我纠正

链接:http://arxiv.org/abs/2401.07301v1

生成式语言模型(Generative Language Models,LMs),如ChatGPT,在各种下游任务中展现出了卓越的性能。然而,它们最显著的缺点之一是生成不准确或错误的信息,并以自信的语气陈述。以前的研究已经设计了复杂的管道和提示,以促使大型语言模型展示自我纠正的能力。然而,大型语言模型是显式提示验证和修改答案,而非像人类一样自发地完成所有步骤。此外,这些复杂的提示对于小型语言模型来说极具挑战性。在本文中,我们引入了生成式语言模型中的内在自我纠正(Intrinsic Self-Correction,ISC)的概念,旨在通过自触发的方式纠正LMs的初始输出,即使对于只有60亿参数的小型LMs也是如此。具体而言,我们设计了一种构建自我纠正数据的管道,并提出部分答案屏蔽(Partial Answer Masking,PAM)的方法,旨在通过微调赋予模型内在自我纠正的能力。我们在两个任务中,包括常识推理和事实知识推理,使用参数规模从60亿到130亿的LMs进行了实验。我们的实验表明,使用ISC生成的输出优于没有自我纠正的输出。我们相信,通过赋予小型LMs内在自我纠正的能力,甚至可以进一步提高其输出质量。

Allchemy

https://allchemy.io/

AI 合成小游戏,发挥自己的脑洞进行合成。

AI Town - RWKV Proxy

https://github.com/recursal/ai-town-rwkv-proxy

通过RWKV在本地运行一个大型AI城镇。

深入浅出 LoRA

https://zhuanlan.zhihu.com/p/650197598?utm_medium=social&utm_oi=56635854684160&utm_psn=1729848684886454272&utm_source=wechat_timeline

LoRA是一种针对大型语言模型的高效微调技术,它通过低秩分解优化权重更新,仅对特定子空间进行调整以适应新任务。这种方法减少了全量参数微调的资源消耗,同时保持了模型性能。LoRA在Transformer模型的注意力模块中应用,通过优化秩分解矩阵来实现微调,提高了推理速度和训练效率。PeFT库提供了LoRA的实现,使得在共享预训练模型参数的基础上切换下游任务变得容易。

Transformer推理优化综述

https://zhuanlan.zhihu.com/p/677595064?utm_medium=social&utm_oi=56635854684160&utm_psn=1729778043844005888&utm_source=wechat_timeline

综述Transformer模型在推理过程中的全栈优化策略,包括分析模型架构瓶颈、硬件设计考量、模型优化技术(如量化和稀疏化)、映射到硬件的方法以及使用神经结构搜索(NAS)调整模型架构。通过案例研究展示了在开源加速器Gemmini上应用这些优化方法,可以实现高达88.7倍的加速,同时将性能退化降至最低。

Web3 + AI 赛道全景盘点

https://mp.weixin.qq.com/s/ty5m3G_Q2FJauKu9KYu9lg

文章全面盘点了Web3与AI结合的赛道,涵盖了基础设施、数据、预测市场、计算与算力、教育、DeFi与跨链、安全、NFT与游戏、元宇宙、搜索引擎、社交与创作者经济、AI聊天机器人、DID与消息传递、治理、医疗和交易机器人等多个领域。文章提到,至少有140多个Web3+AI概念项目,其中85个已发币。这些项目得到了众多知名风险投资公司的支持,如a16z Crypto、Jump Crypto等。文章还详细介绍了部分项目,如Olas、Bittensor、Cortex、Fetch.ai、SingularityNET等,并提到了它们的发展情况和融资情况。此外,文章还探讨了Web3+AI的潜在应用和用例,以及对未来发展趋势的展望。

Python中LLM输出的结构化存储与解析

https://mp.weixin.qq.com/s/0B6LhCJ9KUN7HKrRv_9_AQ

文章介绍了如何使用LangChain库在Python中存储和解析大型语言模型(LLM)的输出。通过LangChain的输出解析器,可以将LLM生成的非结构化文本转换为结构化格式,如JSON。文章通过实例演示了如何使用Pydantic创建自定义数据结构,并通过提示模板和输出解析器将LLM的输出解析为Pydantic对象。这种方法简化了从LLM输出中提取有用信息的过程,适用于产品投诉分析、客户支持和职位发布信息等多种应用场景。