[docker] Docker资源管理

一、docker资源控制

Docker通过Cgroup 来控制容器使用的资源配额,包括CPU、内存、磁盘三大方面,基本覆盖了常见的资源配额和使用量控制。Caroup 是ControlGroups的缩写,是Linux 内核提供的一种可以限制、记录、隔离进程组所使用的物理资源(如 cpu、内存、磁盘,io等等)的机制,被LXC、docker等很多项目用于实现进程资源控制。Cgroup本身是提供将进程进行分组化管理的功能和接口的基础结构,I/O或内存的分配控制等具体的资源管理是通过该功能来实现的。

- 资源限制:可以对任务使用的资源总额进行限制。

- 优先级分配:通过分配的cpu时间片数量以及磁盘IO带宽大小,实际上相当于控制了任务运行优先级。

- 资源统计:可以统计系统的资源使用量,如cpu时长,内存用量等。

- 任务控制: cgroup可以对任务 执行挂起、恢复等操作。

二、docker占用宿主机cpu的限制

2.1 cpu的使用率上限

Linux通过CFS (Completely Fair Scheduler,完全公平调度器)来调度各个进程对ceu的使用。CFS默认的调度周期是100ms 。我们可以设置每个容器进程的调度周期,以及在这个周期内各个容器最多能使用多少CPU时间。

使用--cpu-period 即可设置调度周期,使用--cpu-quota即可设置在每个周期内容器能使用的CPU时间。两者可以配合使用。CFS周期的有效范围是 1ms~1s,对应的--cpu-period 的数值范围是1000~1000000。而容器的CPU配额必须不小于1ms,即--cpu-quota的值必须>= 1000。而容器的CPU配额必须不小于1ms,即--cpu-quota的值必须>= 1000。

docker run -itd --name test5 centos:7 /bin/bash

docker ps -a

cd/sys/fs/cgroup/cpu/docker/9d415515c01e61a335bdc841e19b60a1ce54dd3cbaefeab7844fdcf785cd5aa4/

cd /sys/fs/cgroup/cpu/docker/

-1

cat cpu.cfs_period_us

100000

#cpu.cfs_period_us:cpu分配的周期(微秒,所以文件名中用 us 表示),默认为100000。

#cpu.cfs_quota_us:表示该cgroups限制占用的时间(微秒),默认为-1,表示不限制。 如果设为50000,表示占用50000/100000=50%的CPU。进行CPU压力测试

docker exec -it test5 bash

vi /cpu.sh

#!/bin/bash

i=0

while true

do

let i++

done

chmod +x /cpu.sh

./cpu.sh

top #可以看到这个脚本占了很多的cpu资源设置50%的比例分配CPU使用时间上限

docker run -itd --name test6 --cpu-quota 50000 centos:7 /bin/bash #可以重新创建一个容器并设置限额

或者

cd/sys/fs/cgroup/cpu/docker/9d415515c01e61a335bdc841e19b60a1ce54dd3cbaefeab7844fdcf785cd5aa4/

echo 50000 > cpu.cfs_quota_us

docker exec -it 3ed82355f811 /bin/bash

./cpu.sh

top #可以看到cpu占用率接近50%,cgroups对cpu的控制起了效果

#在多核情况下,如果允许容器进程完全占用两个 CPU, 则可以将 cpu-period 设置为 100000( 即 0.1 秒), cpu-quota设置为 200000(0.2 秒)。2.2 设置CPU资源占用比(设置多个容器时才有效)

注意:该方式需要设置多个容器时才会生效

创建容器时可以使用选项 --cpu-shares 数值(该数值要为1024的倍数,1024代表一份,当个容器占用cpu的份额由自身分配的份数除于所有容器占用cpu的份数,就为该容器所占用cpu资源的百分比)

[root@localhost ~]#docker run -id --name b1 --cpu-shares 2048 centos:7

[root@localhost ~]#docker run -id --name b2 --cpu-shares 1024 centos:7

[root@localhost ~]#docker run -id --name b3 --cpu-shares 1024 centos:7

创建三个容器为 b1 和 b2 和 b3,设置容器的权重,使得b1和b2和b3的CPU资源占比为1/2和1/4和1/4。#三个容器均为以下压测操作

#下载压测工具依赖环境

yum install -y epel-release

#下载压测工具

yum install -y stress

#进行四个线程压测

stress -c 2

#再开启一个终端查看测试结果

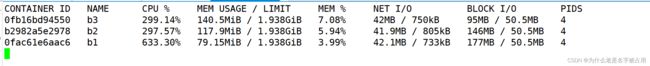

docker stats查看容器运行状态(动态更新)

由测试结果, 可以看到在cPU进行时间片分配的时候,容器b1比容器b2和b3多一倍的机会获得cpu的时间片。但分配的结果取决于当时主机和其他容器的运行状态,实际上也无法保证容器 b2和b3一定能获得cpu时间片

比如容器b2和b3的进程一直是空闲的,那么容器b1是可以获取比容器b2和b3更多的cpu时间片的。极端情况下,例如主机上只运行了一个容器,即使它的cpu份额只有50,它也可以独占整个主机的cpu资源。

Cgroups 只在容器分配的资源紧缺时,即在需要对容器使用的资源进行限制时,才会生效。因此,无法单纯根据某个容器的cpu 份额来确定有多少cpu资源分配给它,资源分配结果取决于同时运行的其他容器的CPU分配和容器中进程运行情况。

2.3 设置容器绑定指定的cpu

查看主机中的cpu编号

top

按数字“1”进行绑核创建容器

[root@localhost ~]#docker run -id --name b4 --cpuset-cpus 1 centos:7

yum install -y epel-release

yum install -y stress

stress -c 1三、内存使用的限制

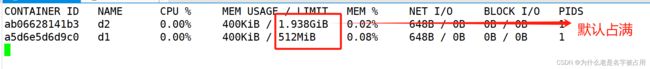

3.1 限制容器可以使用的最大内存

m (或--memory=)选项用于限制容器可以使用的最大内存

docker run -itd --name d1 -m 512m centos:7 /bin/bash

docker stats3.2 限制容器可用的swap 大小

#限制可用的swap 大小,--memory-swap

●强调一下, --memory-swap是必须要与 --memory(或-m)一起使用的。

●正常情况下, --memory-swap 的值包含容器可用内存和可用swap 。

●所以 -m 300m --memory-swap=1g 的含义为:容器可以使用300M 的物理内存,并且可以使用700M (1G - 300M)的swap。 设置为0或者不设置,则容器可以使用的 swap 大小为 -m 值的两倍。 如果 --memory-swap 的值和 -m 值相同,则容器不能使用swap。 如果 --memory-swap 值为 -1,它表示容器程序使用的内存受限,而可以使用的swap空间使用不受限制(宿主机有多少swap 容器就可以使用多少)。

#--memory-swap 的值包含容器可用内存和可用swap,减去-m的值才是可用swap的值。

#表示容器可以使用512M的物理内存,并且可以使用512M的swap。因为1g减去512m的物理内存,剩余值才是可用swap。

docker run -itd --name d2 -m 512m --memory-swap=1g centos:7 bash

#--memoryswap值和 -m 的值相同,表示容器无法使用swap

docker run -itd --name d3 -m 512m --memory-swap=512m centos:7 bash

# --memory-swap 的值设置为0或者不设置,则容器可以使用的 swap 大小为 -m 值的两倍。

docker run -itd --name d4 -m 512m centos:7 bash

# --memory-swap 值为 -1,它表示容器程序使用的内存受限,但可以使用的swap空间使用不受限制(宿主机有多少swap 容器就可以使用多少)。

docker run -itd --name d5 -m 512m --memory-swap=-1 centos:7 bash

四、对磁盘IO的配置控制(blkio)的限制

-device-read-bps:限制某个设备上的读速度bps ( 数据量),单位可以是kb、mb (M)或者gb。

--device-write-bps : 限制某个设备上的写速度bps ( 数据量),单位可以是kb、mb (M)或者gb。

该速度是指每秒钟进行读写操作1M,1G或者是1kb

--device-read-iops :限制读某个设备的iops (次数)

--device-write-iops :限制写入某个设备的iops ( 次数)

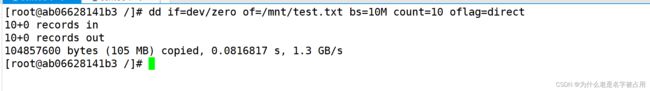

4.1 默认情况下容器的写速度

[root@localhost ~]#docker run -id --name e1 centos:7

[root@localhost ~]#docker exec -it e1 bash

[root@8657384cb483 /]# dd if=dev/zero of=/mnt/test.txt bs=10M count=10 oflag=direct

## oflag=direct 规避文件读写系统中所带来的缓存,避免影响测试结果4.2 进行写速度限制的容器创建

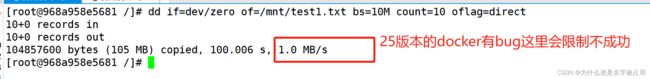

docker run -it --name test10 --device-write-bps /dev/sda:1mb centos:7 /bin/bash

dd if=dev/zero of=/mnt/test.txt bs=10M count=10 oflag=direct五、清除docker占用的磁盘空间

docker system prune -a 可用于清理磁盘,删除关闭的容器、无用的数据卷和网络。

docker system prune -a 总结

对cpu的限制参数

设置单个容器进程能够使用的CPU使用率上限

针对新建的容器:

docker run --cpu-period 单个CPU调度周期时间(1000~1000000) --cpu-quota 容器进程能够使用的最大CPU时间(>=1000)

针对已存在的容器:

修改 /sys/fs/cgroup/cpu/docker/容器ID/ 目录下的 cpu.cfs_period_us(单个CPU调度周期时间) cpu.cfs_quota_us(容器进程能够使用的最大CPU时间) 文件的值

设置多个容器的CPU占用份额(只能在多个容器同时运行且CPU资源紧张时生效)

docker run --cpu-shares 容器进程最大占用CPU的份额(值为1024的倍数)

设置容器绑定指定的CPU

docker run --cpuset-cpus CPUID1[,CPUID2,....]

对内存的限制

设置容器能够使用的内存和swap的值

docker run -m 内存值 --memory-swap 内存和swap的总值

设置 0 或 不设置,表示swap为内存的2倍

设置 -1,表示不限制swap的值,宿主机有多少容器即可使用多少

设置 与 -m 一样的值,表示不使用swap对磁盘IO的限制

docker run --device-read-bps 磁盘设备文件路径:速率 #限制容器在某个磁盘上读的速度

--device-write-bps 磁盘设备文件路径:速率 #限制容器在某个磁盘上写的速度

--device-read-iops 磁盘设备文件路径:次数 #限制容器在某个磁盘上读的次数

--device-write-iops 磁盘设备文件路径:次数 #限制容器在某个磁盘上写的速度![[docker] Docker资源管理_第1张图片](http://img.e-com-net.com/image/info8/2e628e9a9a2b4ff98f3d306c98b0fd5f.jpg)

![[docker] Docker资源管理_第2张图片](http://img.e-com-net.com/image/info8/fa65062b5aa944519db3c11099e31fb4.jpg)

![[docker] Docker资源管理_第3张图片](http://img.e-com-net.com/image/info8/9c6382123da54fac8621303c4e9930a6.jpg)

![[docker] Docker资源管理_第4张图片](http://img.e-com-net.com/image/info8/effd8fa6a6484528ac2cf1233dbe8472.jpg)

![[docker] Docker资源管理_第5张图片](http://img.e-com-net.com/image/info8/030d1023f7b749ec961ed6045d046b3f.jpg)

![[docker] Docker资源管理_第6张图片](http://img.e-com-net.com/image/info8/5db03c24bdee4122992dbe69c413e43a.jpg)

![[docker] Docker资源管理_第7张图片](http://img.e-com-net.com/image/info8/560bc37582a2455f90b101f2373a58bd.jpg)

![[docker] Docker资源管理_第8张图片](http://img.e-com-net.com/image/info8/dc6bcfbb665f4647867e6d9d60fb4d75.jpg)

![[docker] Docker资源管理_第9张图片](http://img.e-com-net.com/image/info8/8d4c5ba871934404b8e6ac6f9b9852c3.jpg)

![[docker] Docker资源管理_第10张图片](http://img.e-com-net.com/image/info8/3e58d46907f348a9b12cf84791869feb.jpg)

![[docker] Docker资源管理_第11张图片](http://img.e-com-net.com/image/info8/5a47b28cf0e8417ebf4ef49f9279475d.jpg)

![[docker] Docker资源管理_第12张图片](http://img.e-com-net.com/image/info8/aa6667cbe60340a98ec5d08a24c0be8d.jpg)

![[docker] Docker资源管理_第13张图片](http://img.e-com-net.com/image/info8/92e9af58c8984232a7c3738d56131807.jpg)

![[docker] Docker资源管理_第14张图片](http://img.e-com-net.com/image/info8/0f23bba4797e4504a5adede496930142.jpg)

![[docker] Docker资源管理_第15张图片](http://img.e-com-net.com/image/info8/4211c8343baf461891eea061176eab84.jpg)

![[docker] Docker资源管理_第16张图片](http://img.e-com-net.com/image/info8/5a6de2c559fc489192964ffd7d97b848.jpg)

![[docker] Docker资源管理_第17张图片](http://img.e-com-net.com/image/info8/9ec3b41ef1db499185023d48d48c245f.jpg)