【论文收集】

Collaborative Diffusion for Multi-Modal Face Generation and Editing

https://arxiv.org/abs/2304.10530

code:https://github.com/ziqihuangg/collaborative-diffusion

现有的扩散模型主要集中在单模态控制上,即扩散过程仅由一种状态模态驱动。为了进一步释放用户的创造力,希望模型可以同时被多种模态控制,例如,通过描述年龄(文本驱动)生成和编辑人脸,同时绘制人脸形状(面具驱动)。本文提出协同扩散,预训练单模态扩散模型协同实现多模态人脸生成和编辑,而不需要重新训练。本文的关键见解是,不同模态驱动的扩散模型在潜在去噪步骤方面具有内在的互补性,可以在其基础上建立双边连接。本文提出dynamic diffuser,一种元网络,通过预测每个预训练单模态模型的时空影响函数,自适应地幻觉多模态去噪步骤。协同扩散不仅协同单模态扩散模型的生成能力,而且集成多个单模态操作以执行多模态编辑。广泛的定性和定量实验证明了所提出框架在图像质量和条件一致性方面的优越性。

Efficient Region-Aware Neural Radiance Fields for High-Fidelity Talking Portrait Synthesis

https://arxiv.org/abs/2307.09323

https://github.com/fictionarry/er-nerf

ER-NeRF,一种新的基于条件神经辐射场(NeRF)的说话人像合成架构,可以同时实现快速收敛、实时渲染和最先进的性能,且模型尺寸较小。本文的想法是明确地利用空间区域的不平等贡献来指导说话人像建模。具体而言,为了提高动态头部重建的精度,通过使用三个平面哈希编码器修剪空空间区域,引入了一种紧凑且具有表达力的基于nerf的三平面哈希表示。对于语音音频,本文提出了一个区域注意力模块,通过注意力机制生成区域感知的条件特征。不同于现有利用mlp编码器隐式学习跨模态关系的方法,注意力机制在音频特征和空间区域之间建立显式联系,以捕获局部运动的先验。此外,通过将复杂的头部姿态变换映射到空间坐标中,引入一种直接快速的自适应姿态编码来优化头-躯干分离问题。广泛的实验表明,与之前的方法相比,所提出方法渲染了更好的高保真和音频嘴唇同步的说话人像视频,具有真实的细节和高效率。

DCFace: Synthetic Face Generation with Dual Condition Diffusion Model

https://arxiv.org/abs/2304.07060

https://github.com/mk-minchul/dcface

生成用于训练人脸识别模型的合成数据集具有挑战性,因为数据集的生成需要的不仅仅是创建高保真图像。它涉及生成同一受试者在不同因素(\textit{如}姿态、光照、表情、老化和遮挡)下的多幅图像,这些图像遵循真实的图像条件分布。之前的工作研究了使用GAN或3D模型生成合成数据集。本文从结合受试者外观(ID)和外部因素(风格)条件的角度来研究该问题。这两个条件提供了一种直接控制类间和类内变化的方法。为此,提出一种基于扩散模型的双条件人脸生成器(DCFace)。新的块风格提取器和时间步长依赖的ID损失使DCFace能够在精确控制下一致地产生相同主题在不同风格下的人脸图像。在所提出的DCFace合成图像上训练的人脸识别模型比之前的工作提供了更高的验证精度

Diffusion Video Autoencoders: Toward Temporally Consistent Face Video Editing via Disentangled Video Encoding

https://arxiv.org/abs/2212.02802

https://github.com/man805/Diffusion-Video-Autoencoders?tab=readme-ov-file

扩散视频自编码器:通过解耦视频编码实现连续性的人脸视频编辑 受到最近人脸图像编辑方法令人印象深刻的性能启发,已经提出了几项研究来将这些方法自然地扩展到人脸视频编辑任务。在这里,主要的挑战之一是编辑帧之间的时间连续性,这个问题仍未解决。为此,我们提出了一种基于扩散自编码器的新型人脸视频编辑框架,该框架可以成功地从给定视频中提取分解的特征(作为人脸视频编辑模型的首次尝试)- 身份和运动。这种建模使我们能够通过简单地操纵在时间上不变的特征以达到所需的一致性方向来编辑视频。我们模型的另一个独特优势是,由于我们的模型基于扩散模型,它可以同时满足重构和编辑能力,并且对野外人脸视频中的边缘情况(例如遮挡的人脸)具有鲁棒性,而不像现有的基于GAN的方法那样容易受到影响。

sadtalker

https://github.com/OpenTalker/SadTalker?tab=readme-ov-file

VideoReTalking: Audio-based Lip Synchronization for Talking Head Video Editing In the Wild

https://arxiv.org/abs/2211.14758

https://github.com/OpenTalker/video-retalking?tab=readme-ov-file

VideoReTalking:基于音频的唇同步,用于野外说话头视频编辑

本文提出VideoReTalking,一种新的系统,根据输入音频编辑真实世界的说话头视频的人脸,即使具有不同的情感,也能产生高质量的和对口型的输出视频。该系统将这一目标分解为三个顺序的任务:(1)具有规范表情的人脸视频生成;(2)音频驱动的口型同步;(3)人脸增强,以提高照片的真实感。给定一个说话人视频,首先使用表情编辑网络根据相同的表情模板修改每一帧的表情,得到一个标准表情的视频。然后将这个视频和给定的音频一起输入到唇同步网络以生成一个唇同步视频。最后,通过身份感知人脸增强网络和后处理来提高合成人脸的照片真实感。我们对所有三个步骤都使用基于学习的方法,我们的所有模块都可以在没有任何用户干预的情况下在顺序管道中处理。此外,该系统是一种通用方法,不需要对特定的人进行重新训练。在两个广泛使用的数据集和真实例子上的评估表明,该框架在唇同步精度和视觉质量方面优于其他最新的方法。

DPE: Disentanglement of Pose and Expression for General Video Portrait Editing

https://arxiv.org/abs/2301.06281

https://github.com/OpenTalker/DPE?tab=readme-ov-file

DPE:通用视频人像编辑的姿态和表情解缠

单镜头视频驱动的说话人脸生成旨在通过将面部运动从视频转移到任意人像图像来生成合成的说话视频。头部姿态和面部表情往往在面部运动中纠缠并同时传递。然而,纠缠为这些方法直接用于视频肖像编辑设置了障碍,其中可能只需要修改表情,而保持姿态不变。解耦姿态和表情的一个挑战是缺乏成对的数据,例如相同的姿态但不同的表情。只有少数方法试图通过3D可变形模型(3dmm)的显式解缠来解决这一挑战。但由于Blenshapes数量有限,3dmm在捕捉面部细节方面不够准确,对运动迁移有副作用。本文提出一种新的自监督解缠框架,在没有3dmm和配对数据的情况下解耦姿态和表情,由运动编辑模块、姿态生成器和表情生成器组成。编辑模块将人脸投影到一个可以解耦姿态运动和表情运动的潜空间中,通过添加可以方便地在潜空间中进行姿态或表情迁移。两个生成器分别将修改后的潜代码渲染为图像。此外,为了保证解缠性,本文提出了一种双向循环训练策略,并设计了良好的约束条件。实验表明,所提出方法可以独立控制姿态或表情,可用于一般视频编辑。

T2M-GPT: Generating Human Motion from Textual Descriptions with Discrete Representations

https://github.com/Mael-zys/T2M-GPT?tab=readme-ov-file

https://arxiv.org/abs/2301.06052

本文研究了一种简单且必须知道的基于矢量量化变分自编码器(VQ-VAE)和生成式预训练Transformer (GPT)的条件生成框架,用于从纹理描述中生成人体运动。一个简单的基于cnn的VQ-VAE和常用的训练方法(EMA和代码重置)可以获得高质量的离散表示。对于GPT,在训练过程中纳入了一个简单的分解策略,以缓解训练-测试差异。尽管简单,T2M-GPT显示出比竞争方法(包括最近的基于扩散的方法)更好的性能。例如,在目前最大的数据集HumanML3D上,在文本和生成运动之间的一致性(R-Precision)方面取得了相当的性能,但FID 0.116在很大程度上超过了0.630的MotionDiffuse。对HumanML3D进行了分析,并观察到数据集大小是该方法的一个限制。本文工作表明,VQ-VAE在人体运动生成方面仍然是一种有竞争力的方法。

StyleHEAT: One-Shot High-Resolution Editable Talking Face Generation via Pretrained StyleGAN (ECCV 2022)

StyleHEAT

https://github.com/OpenTalker/StyleHEAT?tab=readme-ov-file

研究了预训练StyleGAN的潜特征空间,发现了一些优秀的空间变换特性。基于观察,本文提出一种新的统一框架,基于预训练的StyleGAN,实现一套强大的功能,即高分辨率视频生成,通过驱动视频或音频来解耦控制,以及灵活的人脸编辑。

Diffusion Models and Semi-Supervised Learners Benefit Mutually with Few Labels

提出了双重伪训练这种训练策略,简单有效,原则上能够结合任何一种半监督分类器和生成模型。

Palette: Image-to-Image Diffusion Models

Palette从pix2pix GANs中获取灵感,能够实现图像着色、图像修复、图像剪裁恢复、图像解压缩(超分)等等任务,最大的意义在于让更多人看到了diffusion models在图像翻译领域的潜力。

Scalable Diffusion Models with Transformers

Unet本来是发源于医疗图像分割的backbone,后来pix2pix GANs开始引入到生成领域,diffusion models的研究者们一直想替换掉这个backbone,用更原生的方法。最近的一项研究成果成功用改进版本的transformer替换掉Unet,并取得了更好的效果。

DiffiT: Diffusion Vision Transformers for Image Generation

去噪网络架构的作用并没有得到很好的研究,大多数工作都依赖于卷积残差U-Nets。

本文研究了视觉transformer在基于扩散的生成学习中的有效性。本文提出一种新模型,称为扩散视觉transformer (DiffiT),由一个具有U形编码器和解码器的混合分层架构组成。本文提出一种新的依赖时间的自注意力模块,允许注意力层以有效的方式自适应其在去噪过程的不同阶段的行为。

此外,本文还提出了LatentDiffiT,由transformer模型和所提出的自注意力层组成,用于高分辨率图像生成。结果表明,DiffiT在生成高保真图像方面惊人地有效,并在各种类条件和无条件合成任务中实现了最先进的(SOTA)基准。在潜空间中,DiffiT在ImageNet256数据集上取得了新的SOTA FID分数1.73。

LATENT CONSISTENCY MODELS: SYNTHESIZING HIGH-RESOLUTION IMAGES WITH FEW-STEP INFERENCE

LCM 的全称是 Latent Consistency Models(潜在一致性模型),由清华大学交叉信息研究院的研究者们构建。在这个模型发布之前,Stable Diffusion 等潜在扩散模型(LDM)由于迭代采样过程计算量大,生成速度非常缓慢。通过一些创新性的方法,LCM 只用少数的几步推理就能生成高分辨率图像。据统计,LCM 能将主流文生图模型的效率提高 5-10 倍,所以能呈现出实时的效果。

LCM-LORA: A UNIVERSAL STABLE-DIFFUSION ACCELERATION MODULE

潜在一致性模型的快速生成能力为图像生成技术开辟了新的应用领域。这种模型可以快速地根据输入的文本(Prompt)处理和渲染实时捕捉到的画面,从而实现高速图像生成。这意味着用户可以自定义他们想要展示的场景或视觉效果。

Video Diffusion Models

这篇论文需要注意两个点:一是怎样引入时序信息的方法,很值得借鉴。二是梯度引导法是首次被提出。它将传统的图像扩散 U-Net 结构扩展为 3D U-Net 结构,并采用图像和视频的联合训练。它采用的条件采样技术使其能够生成质量更高且持续时间更长的视频。作为 T2V 扩散模型的首次尝试,它还支持无条件生成和视频预测等任务。

Make-A-Video: Text-to-Video Generation without Text-Video Data

网络从成对的图像文本数据中学习视觉文本相关性,并从无监督的视频数据中捕获视频运动信息。这种创新方法减少了对数据收集的依赖,从而实现了多样性和逼真性视频的生成。此外,通过使用多个超分辨率模型和插值网络,它实现了更高清晰度和帧率的生成视频。

MagicVideo: Efficient Video Generation With Latent Diffusion Models

MagicVideo 则是最早采用潜在扩散模型(Latent Diffusion Model,LDM)来进行潜在空间的 T2V 生成的工作之一。通过在低维潜在空间中利用扩散模型,它显著降低了计算复杂性,从而加快了处理速度。引入的逐帧轻量级 adaptor 对齐了图像和视频的分布,使所提出的定向注意力(directed attention)能够更好地建模时间关系以确保视频的时序一致性。

Photorealistic Video Generation with Diffusion Models

本文提出一种名为W.A.L.T的方法,该方法基于transformer,通过扩散建模生成逼真视频。该方法有两个关键设计决定:首先,使用因果编码器将图像和视频压缩到统一的潜在空间中,实现跨模态的训练和生成;其次,为了提高内存和训练效率,使用专为联合空间和时空生成建模设计的窗口注意力架构。这些设计决策使得在不使用CFG的情况下,在既定的视频(UCF-101 和 Kinetics-600)和图像(ImageNet)生成基准测试中取得了SOTA性能。作者还训练了一个由三个模型级联组成的模型,用于文本到视频的生成,包括一个基本的潜在视频扩散模型和两个视频超分辨率扩散模型,以每秒 8 帧的速度生成分辨率为512x896的视频。

Text2Video-Zero: Text-to-Image Diffusion Models are Zero-Shot Video Generators

Text2Video-Zero 利用了预训练的 T2I 模型 Stable Diffusion 来进行视频合成。为了保持不同帧之间的一致性,它在每一帧和第一帧之间执行交叉注意力机制。此外,它通过修改潜在码本的采样方法来丰富运动动态。此方法还可以与条件生成和编辑技术(如 ControlNet 和 InstructPix2Pix)结合使用,实现对视频的受控生成。

DirecT2V 和 Free-Bloom

引入了大型语言模型(LLM),以基于单个抽象用户提示生成逐帧描述。LLM 导演用于将用户输入分解为帧级别的描述。

LLM-grounded Video Diffusion Models

LVD 首先利用大型语言模型(LLM)生成动态场景布局,然后使用这些布局来引导视频生成。它的方法无需训练,通过根据布局调整注意力图,来引导视频扩散模型,从而实现复杂动态视频的生成。

HyperLips: Hyper Control Lips with High Resolution Decoder for Talking Face Generation

GitHub - semchan/HyperLips: Pytorch official implementation for our paper "HyperLips: Hyper Control Lips with High Resolution Decoder for Talking Face Generation".

[2310.05720] HyperLips: Hyper Control Lips with High Resolution Decoder for Talking Face Generation (arxiv.org)

可说话人脸生成在虚拟数字人领域具有广泛的潜在应用。然而,对于现有的音频驱动的人脸说话生成方法来说,在渲染高保真人脸视频的同时确保嘴唇同步仍然是一个挑战。为解决这个问题,本文提出HyperLips,一个两阶段框架,由一个用于控制嘴唇的超网络和一个用于渲染高保真人脸的高分辨率解码器组成。在第一阶段,构建了一个基本的人脸生成网络,该网络使用超网络来控制视觉人脸信息在音频上的编码潜码。首先,使用FaceEncoder从包含人脸帧的视频源中提取视觉人脸信息,并从中提取特征以获取潜在代码;然后,以音频特征为输入,由HyperNet更新权重参数的HyperConv将修改隐代码,使唇动与音频同步;最后,FaceDecoder将修改并同步的潜代码解码为视觉人脸内容。在第二阶段,通过高分辨率解码器获得更高质量的人脸视频。为了进一步提高人脸生成的质量,使用人脸图像训练了一个高分辨率解码器HRDecoder,并检测了从第一阶段生成的草图作为输入。广泛的定量和定性实验表明,所提出方法优于最先进的工作,具有更真实、高保真和唇形同步。

Taming Diffusion Models for Audio-Driven Co-Speech Gesture Generation (CVPR 2023)

GitHub - Advocate99/DiffGesture: [CVPR 2023] Taming Diffusion Models for Audio-Driven Co-Speech Gesture Generation

将虚拟化身动画化以进行共语手势有助于人机交互中的各种应用。现有方法主要依赖生成对抗网络(GANs),但往往受到臭名昭著的模式崩溃和不稳定训练的困扰,因此难以学习准确的音频-手势联合分布。在这项工作中,我们提出了一个新颖的基于扩散的框架,命名为扩散共语手势(DiffGesture),以有效地捕捉跨模态的音频到手势关联,并保持高保真度的音频驱动共语手势生成的时序一致性。具体而言,我们首先在骨骼序列和音频片段上建立了扩散条件生成过程,以启用整个框架。然后,我们设计了一种新颖的扩散音频-手势Transformer,以更好地关注来自多个模态的信息并建模长期时序依赖关系。此外,为了消除时序不一致性,我们提出了一种有效的扩散手势稳定器,并采用渐变噪声采样策略。由于扩散模型的结构优势,我们进一步引入了隐式无分类器指导,以在多样性和手势质量之间进行权衡。广泛的实验证明DiffGesture实现了最先进的性能,产生了连贯的手势,具有更好的模式覆盖率和更强的音频相关性。

OTAvatar: One-shot Talking Face Avatar with Controllable Tri-plane Rendering

GitHub - theEricMa/OTAvatar: This is the official repository for OTAvatar: One-shot Talking Face Avatar with Controllable Tri-plane Rendering [CVPR2023].

可控性、泛化性和效率是构建由神经隐式场表示的面部虚拟形象的主要目标。然而,现有方法尚未能够同时满足这三个要求。它们要么专注于静态肖像,限制了表示能力只适用于特定主题,要么计算成本巨大,限制了其灵活性。在本文中,我们提出了一种一次性说话面部虚拟形象(OTAvatar),通过一种广义的可控三平面渲染解决方案构建面部虚拟形象,使得每个个性化的虚拟形象可以仅从一个肖像作为参考来构建。具体而言,OTAvatar首先将肖像图像反演为无动作的身份代码。其次,利用身份代码和动作代码调节高效的卷积神经网络生成三平面体积,该体积编码所需动作的主题。最后,采用体积渲染来生成任意视角下的图像。我们解决方案的核心是一种新颖的反演解耦策略,通过基于优化的反演来解开潜在代码中的身份和动作。由于高效的三平面表示,我们在A100上以35 FPS实现了对泛化面部虚拟形象的可控渲染。实验证明,我们的方法在训练集之外的主题上展示出了良好的跨身份再现性能和更好的三维一致性。

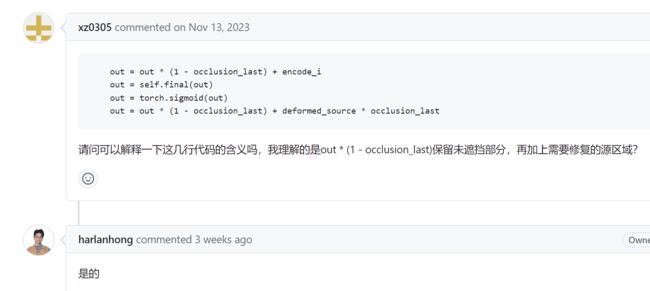

DINet: Deformation Inpainting Network for Realistic Face Visually Dubbing on High Resolution Video (AAAI2023)

文字驱动:

Txt2Vid: Ultra-Low Bitrate Compression of Talking-Head Videos via Text

GitHub - tpulkit/txt2vid

集合版:GitHub - Kedreamix/Awesome-Talking-Head-Synthesis: An extensive collection of exceptional resources dedicated to the captivating world of talking face synthesis! ⭐ If you find this repo useful, please give it a star!

talking-head · GitHub Topics · GitHub

GitHub - Jason-cs18/awesome-avatar: A curated list of resources dedicated to avatar.

参考:AIGC中的视觉生成文献整理_video editing with cross-attention control-CSDN博客