AIGC内容分享(二):全球大模型技术与应用分析

目录

前言

人工智能技术回顾

AIGC近期动态梳理

1. 国内动态

2. 国外动态

3. OpenAI的关键动作

4. AIGC的技术变革

AIGC的关键应用

1. AIGC应用背后的驱动力

2. AIGC的三大原能力

3. AIGC的四大产品形态

大模型如何融入行业?

1. 通用行业融合

2. 垂直行业融合

前言

这篇文章主要阅读者是产品经理、业务负责人、AIGC核心参与者等。

现在AIGC技术发展太快,每天都有不同的变化。刚才我看Google发布的Gemini多模态能力,着实被惊喜(吓)到了:AI可以看图说话、理解和推理、预测事情的发展动态,简直无所不能。

所以这篇文章是想站在2023年底这个节点,系统性梳理下AIGC的技术现状和行业应用,方便我们对AIGC技术、产品和商业有个全局的理解。

警示: 不论行业热度如何,企业AIGC布局始终需要保持理性和克制。尤其针对关键业务环节投入,秉承先建数字基础设施,再引入大模型能力的原则;综合业务价值和成本投入,形成客观决议。

以下内容,敬请享用。

本文主要包含四个方向的内容:

● 人工智能技术回顾

● AIGC近期动态梳理

● AIGC的关键应用

● 大模型如何融入行业

人工智能技术回顾

人工智能的发展经历几次大的技术变革,总结起来主要有三个范式:逻辑学、概率论、深度学习。

1. 逻辑学:由逻辑规则构建的专家系统,这时候AI就像一位经验丰富的‘老专家’,能基于以往的经验提供解决方案。

这种模式带来的问题,是专家知识和经验总会有局限性,因此AI所能处理的问题也存在边界。

专家系统被广泛应用在不同的领域,例如在工业领域实现生产质量监控,生产过程控制等;在金融领域实现风险评估、投资决策等。

2. 概率论(机器学习):由数据统计构建的概率系统,这时候AI就像一位能通灵的‘算命先生’,能基于概率分布提供决策辅助。

例如以贝叶斯网络,隐马尔可夫模型等为代表的概率统计算法逐步被应用后,形成ASR(语音识别)、NLP(自然语言处理)、CV(计算机视觉)、垃圾邮件监测、信用评估等领域。

3. 深度学习:由神经网络构建的决策系统,这时候AI就像一位有学问的‘智者’,能通过数据特征形成精准决策。

例如以小样本学习、强化学习、迁移学习为代表的深度学习框架已经成为移动应用的支撑。包括游戏AI、自动驾驶、智能推荐、内容生成、人脸识别等领域。

早期的逻辑控制、概率统计,包括深度学习主要以感知和理解世界,为人类提供决策辅助为主,因此也被称为‘决策式智能’。

‘决策式智能’的目标相对聚焦,主要通过特征抽象和映射关系解决单场景决策问题。例如过去AI下围棋、识别人脸都是决策式智能的应用范畴。

随着深度学习的广泛应用,逐步衍生出一种新的技术范式‘生成式智能’。‘生成式智能’主要以知识构建和推理演绎,为人类提供创造力支撑为主。

‘生成式智能’的目标更加泛化,主要通过推理能力和思维链的构建,解决跨域多场景问题。例如ChatGPT知识问答、代码生成,DALL-E的图片生成都属于生成式智能的应用范畴。

要详细了解‘生成式智能’,我们需要从一种特殊的算法框架‘Transformer’谈起。

Transformer由2017年谷歌在《Attention is All YouNeed》一文中发布,这无疑是AI界重要的里程碑,因为它使得深度学习参数突破1亿。

那Transformer到底有哪些神奇之处呢?

Transformer首先是一种基于‘自注意力机制’的神经网络模型。

稍微解释下‘自注意力机制’,它的核心思想是:确保在处理序列中的每个单词时,始终把注意力同时放在其他位置,以保证能理解单词之间的依赖关系。

简单来讲,就是对于输入的每个序列单词形成一个查询(Query)矩阵,一个键(Key)矩阵,一个值(Value)矩阵,通过矩阵的乘积和权重的加权,得到最终的输出结论,让AI由‘单点思维’变成‘全局思维’。

毫无疑问,系统思维更有利于做出正确的决策。

Transformer最初主要用来完成语言翻译任务,包括Encoder(编码器)和Decoder(解码器)两部分。

后来发展为两条路径,一条路径就是大家熟知的BERT家族,主要使用Encoder作为预训练模型,原理是“理解输入序列的信息,并将其编码为隐藏表示向量”。

这种模式有点像让模型学习做‘完型填空’,先前AI语音的核心技术链条主要基于BERT家族。

另一条路径就是大名鼎鼎的GPT家族,主要使用Decoder方式,原理是“根据已经生成的输出序列,实时预测下一个位置的词”。

它的成功之处在于扩大了语言模型的规模,显著提升小样本(Few-Shot)和零样本(Zero-Shot)状态下的学习能力。

这种模式有点像‘自然对话’,这也是为什么ChatGPT会展现出惊人的理解力和共情能力的原因。

‘完形填空’实现起来简单,但无法穷尽所有的场景;‘自然对话’虽然实现起来更复杂,但应用效果更好。

例如你可以让GPT按照特定风格写小说,做数学逻辑题,识别一张图中有趣的部分,做复杂的意图识别等。

GPT家族主要用三步法解决了这个难题。

1. 开卷有益:无监督学习。让AI学会从海量知识库中学习知识,让它成为最强大脑。

2. 模板微调:监督学习。让AI学会在既定的规范下形成回答,让它成为最懂规矩的机器人。

3. 价值引导:RLHF基于人类反馈的强化学习。用人类对它的回答评分调整模型,引导它生成更有价值的回答。

所以说生成式智能更接近人的成长模式,除了海量吸收知识,还要基于知识的实践应用进行复盘和反思,不断改善思考和行为模式,朝着最优方向去进化。

区别在于人要承认错误、颠覆认知,就得克服‘人性’。AI则不同,你只需要帮它构建模式,它会自动执行。

AIGC近期动态梳理

随着ChatGPT爆火,各大科技公司可一刻不敢闲着。

1. 国内动态

国内就形成了三大矩阵,云厂商、科技公司、新生企业。

第一类,以传统云厂商为主的大模型产品矩阵(比如百度文心、千帆大模型,阿里通义大模型、华为盘古大模型等),主要依托原有云服务形成大模型底座和MaaS解决方案。

第二类,以AI科技公司为主的大模型产品矩阵(比如讯飞的星火认知大模型、理想的MindGPT、出门问问的猴子序列大模型等),主要提供大模型底座及AI行业应用,包括一部分智能硬件产品。例如讯飞在语音基础上形成教育类大模型应用和智能硬件。

第三类,以新生创业公司为主的大模型产品矩阵(比如清华系月之暗面推出Moonshot大模型,智谱AI推出GLM大模型等),主要提供大模型底座、特定领域的垂直应用。

2. 国外动态

国外大模型更是风起云涌,比如Meta的羊驼(LLAMA)大语言模型,面向音频生成的Voicebox,谷歌推出的Gemini多模态大模型。

包括随着类似Stable Diffusion这样的图像大模型的出现,AI绘画应用相继诞生,其中包括了 MidJourney、Dall-E2、 Imagen 等。以及各种视频生成(Make-a-Video、ImagenVideo),3D模型生成(DreamFusion、Magic3D 和 Get3D),包括代码生成工具 GitHub Copilot 都开始受到广泛关注。

OpenAI并未止步于ChatGPT取得的成就,而是快马加鞭推出GPT4、GPT4 Turbo、GPT Plugin、GPTs等一系列‘王炸’级别的技术。

当然费用也高了不少,其中GPT4(3.3元/次)的费用比GPT3.5(6分/次)高近60倍,GPT4 Turbo的费用则比GPT4高8倍左右,也难怪大家都说OpenAI在抢钱。

我们看看这么贵的技术,功能上到底牛在哪。

3. OpenAI的关键动作

首先在如何将大模型能力应用化这件事上,OpenAI非常坚定。ChatGPT推出Plugins插件系统,插件可以将ChatGPT连接到第三方应用程序,一方面可以访问最新的互联网信息,另外也可以执行多场景任务,例如实时信息检索、订餐、订酒店、购物等。

微软Newbing就通过OpenAI的插件能力支撑,结合第三方内容和服务生态的融入,形成了强大的大模型应用能力。ChatGPT插件的逻辑和微信生态的小程序,Appstore的生态应用如出一辙,核心让AI不仅提供人性化交互能力 ,还能提供全流程的服务能力,要知道交互只是手段,本质是为用户提供完整服务。

除了插件能力,GPT4基础大模型的能力升级也非常惊人,彻底打破了大语言模型的魔咒,融入视觉和多模态能力,包括语音的对话和理解,图片的读取和推理。

其中语音对话能力直接秒杀行业现有交互机器人,能够通过情感识别、对话模式调整进行情感互动。比如如果AI识别到聊天对象是受了委屈的小孩子,会自动切换成儿童安抚模式。

此外,GPT4的多模态能力更是让人眼前一亮,比如旅行时可以拍摄地标咨询人文历史,拍摄冰箱生鲜图片咨询菜谱方案,拍摄数学题询问解题方法等等,这些丰富的应用场景支撑无疑让产品经理激动不已。

OpenAI更是在11月的开发者大会上推出GPT4 Turbo,GPT4 Turbo除了拥有更新更全的数据库之外,还在多模态推理能力上做了深化。

包括支撑视觉到文本转换,支撑指令遵循(instruction following)、思维链(chain-of-thoughts)、 上下文少样本学习(in-context few-shot learning)能力,可以理解图片中人和物体间的关系,事件的先后顺序,包括计数、生成字幕和描述,解释笑话,回答科学问题等。

例如用户输入一张网站设计草图,它可以直接输出前端实现代码。此外GPT4 Turbo在图片识别和理解能力上的进化也非常激进,例如当你输入一张山地自行车图片,并询问如何调整座椅高低位置时,它能根据正确理解图片逻辑信息并给出整方案。

再比如针对一些专业问题例如医疗领域,用户可以上传CT影响,AI能根据图片理解识别是否有肿瘤(当然这部分的应用还需暂缓,究其原因你懂的)。

4. AIGC的技术变革

过去CV大模型主要应用于‘文生图’,通过输入文字意图生成对应的图片。多模态区别大语言模型或者CV大模型的核心在于模态之间的转换,AI将图片翻译成语言文字,进而利用新的文字组合生成图片或视频。这样的做法,可以有效提升复杂交互过程,AI对用户意图的判断力。

过去我们在传统AI例如图像识别、视频理解包括语音交互等领域遇到的稀疏样本和cornercase决策难题,今天看起来都可以通过多模态融合来解决,逻辑很好解释,就是你输入的数据源头越多、AI对信息的理解越充分,自然能与用户产生更好的互动。

目前从实现原理来看,多模态主要有五类架构实现方式:

a)合并注意力架构(Merge-attention):多个输入模态调整为统一的特征表示,多个模态的特征在自注意力之前被合并,共同进入Transformer。

b)共同注意力架构(Co-attention):每个输入模态都具备私有自注意力通道,用于模态独立特征的导入,然后再使用共同的交叉注意力层融合多模态特征。

c)交叉注意力架构(Cross-attention):对于多模态任务,将图像与语言分别结合,实现图文信息的相互嵌入与问答。

d)三角 Transformer 架构(Tangled-transformer):使用三组 Transformer 模块同时处理 动作、图形对象和语言特征,通过特定的三角连接关系,注入其他模态的 Transformer 网络, 以不同模态的信息融合。

e)模态间对比学习架构(Inter-Modality Contrastive Learning):不同模态的信息被分解, 通过矩阵结构建立多模态对比学习关联。

业内猜测GPT4所使用的架构方法正是‘交叉注意力架构’。

核心思路为:不是直接训练一个多模态模型,而是在已经预训练好的语言大模型中引入图像理解能力。

1)引入预训练好的视觉模型用来提取图像的语义特征,并且嵌入预训练好的语言模型中。

2)引入一个包含图像和文本的多模态数据集来 finetune模型。 这种做法可以有效节省成本,可以最大化使用 已有资源,例如ChatGPT中已经构建好的语言模块。

相比 Open AI 早期持续投入大语言模型LLM,Google更多探索图像和多模态大模型边界。

今年三月google 和德国柏林工业大学公布了当时全球最大视觉语言模型 PaLM-E(Pathways Language Model with Embodied)。

PaLM-E 不仅可以理解图像,还能理解、生成语言,且可以用于多个具体任务,包括顺序机器人操作规划、视觉问题解答和图像视频字幕描述等。

此外Google近期发布的新一代多模态大模型 Gemini 可谓惊艳全场,它的训练算力是 GPT4 的 5 倍、数据集是GPT4的2倍。

长期来看Google 体系独有的消费场景数据有望增强 Gemini 训练效果,减少大模型幻觉。Gemini 可以访问 YouTube 视频、谷歌图书、搜索索引以及 Google Scholar 的学术资料,这些数据大部分都是谷歌独有的,这可能会让谷歌在创建比其他公司更智能的模型方面更具优势。

与单模态大模型相比,多模态的进入门槛更高。这也就对大模型安全体系提出更高要求,主要包含以下可能存在的风险:

- 1) 科学专业知识的风险,例如让AI识别芬太尼、卡芬太尼和可卡因等物质的化学结构图像,它可能会出现错误回答,所以让AI辅助科学研究,会变得可圈可点。

- 2) 医学应用的风险,当我们将AI应用在医学领域,比如协助医生做辅助诊断时,它可能做出错误的决策。这是人命关天的事情,真要广泛应用还需从长计议。

- 3) 无依据推理和虚假信息,大模型的幻觉性依然是行业难题,尽管随着GPT版本升级这个问题比例被降低,但依然不排除AI会时不时提供虚假信息,误导人类。

- 4) 伦理道理、隐私问题,AI再怎么聪明,毕竟不是人类,很多有关伦理道德的常识性问题,不是靠灌输数据就可以解决,因此要杜绝AI刻板印象,解决常识性问题,尚需时日。

AIGC的关键应用

1. AIGC应用背后的驱动力

是什么在驱动AIGC的关键应用呢?主要包含三个方面:模型、算力和生态。

1) 模型:更大、更优、更精准。

例如OpenAI的GPT家族可谓全球最大的大语言模型,随着技术发展,大模型在广度上又衍生出代码生成、音频生成、图像生成、视频生成、3D生成、多模态等等。

目前基础大模型分为开源和闭源两种应用模式,例如GPT4,以及谷歌的 Bard、Claude 等大模型均是闭源模型,优势在于性能强大和易于上手, 目前依然是绝大多数海外主流生成式 AI 应用的首选;

而由 LLaMA2、Stable Diffusion,GLM130B,OPT,BLOOM 引领的开源模型,其优势在于灵活性和低成本,特别是llama2的发布,让应用层公司可以基于开源模型进行私有化部署,更低成本实现差异化应用。

2) 算力:更快、更好、更便宜。

AI界的传奇不属于大模型厂商,而应属于芯片公司。因为任何一个大模型的训练都需要巨大的芯片成本。

因此随着大模型应用的普及,芯片厂商也在紧锣密鼓进行新品研发,例如国内有华为麒麟芯片,百度昆仑芯片;海外有英伟达最新的人工智能芯片GH20,微软自研芯片Athena,谷歌第五代AI芯片TPU等。

大模型厂商为什么要自主研发AI芯片,第一是提升软件和硬件平台的一致性和协同性,第二就是降低硬件成本,加速大模型规模化普及。

3) 工具集:更全、更多、更高效。

AI 组件层(AI Stack)工具包含应用框架、数据处理、模型训练、模型评估、应用部署等几个关键环节,随着头部云厂商不断拓展大模型行业应用,AI工具的平台化和一体化程度也会越来越高。

a) 应用框架:通过提供一套统一组件和接口,将开源模型、API 和数据库等不同的外部组件链接在一起,能够帮助应用开发者快速构建基于大模型的AI 应用,简化应用的开发和创建过程,代表厂商包括 LangChain, GPT Index 和 Cognosis等。

b) 数据处理:基础大模型仅限基于通用数据集的推理,针对行业垂类模型和应用,需要使用时效性强的垂直领域(私有)数据进行训练,特别是在金融、医疗等领域,包括对实时性要求高的领域,例如天气、体育、新闻等。

开发人员需要通过外挂方式来调用专业数据,实现高效的基础数据融合。涉及工具包括向量数据库 Pinecore 、 Chroma、Redis等 、 上下文窗口 LangChain 、 LlamaIndex 等。

c) 模型训练:由于各大模型的尺寸、 支撑模态、输出质量、上下文窗口大小、成本和延迟各不相同,针对不同的应用、开发者可以选择多种基础底大模型,包括开源和闭源模型,也可以针对性训练自己业务领域的专属模型。

涉及到的AI组件包括:模型库 Hugging Face、Replicate等、深度学习框架 TensorFlow、PyTorch等、训练工具 Mosaic、Cerebras 等,托管服务 OctoML、Vertex AI 等。

d) 模型评估:一方面,在模型训练过程中,开发人员需要基于数据来驱动提示工程、超参数、微调等工作,相关工具包括 Statsig、 Comet、Mlflow 等;

另一方面,在应用部署后,应用厂商需要跟踪底层大模型的性能、成本、延迟和行为随时间的变化,了解模型输出的质量,防止恶意使用以及控制大模型的成本,相关工具包括 WhyLabs、datadog等。

e) 应用部署:通过行业工具集将 AI 应用部署到实际应用环境中,例如Fixie 、Gradio 等框架,或者采取第三方厂商的服务来完成应用的部署实施。

整体来讲大模型厂商都配备了比较完善的工具集,帮助开发者完成大模型的一站式应用开发。

从应用范围的演进看,最早主要以大语言模型为核心应用,后期不断延伸到视觉、语音、代码和3D等方向,如今多模态应用时炙手可热的话题。

从行业商业化逻辑来讲,也从一开始2C订阅式应用,2B接口调用;逐步过度到2B行业级解决方案应用,AI大模型与行业数字化系统的结合将越来越紧密,与2C端应用相比,2B的增长潜力巨大。

我们在选择大模型应用方案时,在考虑采用公有云接口调用,还是私有化部署方案时,要尤为谨慎。尤其当自身的业务模式和业务发展不明朗,且企业内部研发资源有限的情形下,建议采用轻量级公有云的服务模式。很多特殊的业务形态例如政务、公安系统包括金融行业,对信息安全要求较高,会优先考虑私有化部署的模式。

2. AIGC的三大原能力

接着我们来看看大模型的三大元能力:感知、决策和生成。

1)感知:对用户输入内容、周边环境状况的实时感知,未来进化方向会从单模感知变为多模感知融合,AI会逐步提升对人类需求理解能力。

2)决策:也有将这个能力称为‘分析’,但我更愿意称之为‘决策’;因为分析是过程,决策是结果。主要包含对信息和知识的检索、归纳与推理能力,未来进化方向会从‘感知智能’走向‘认知智能’。

3)生成:目前较为成熟的是文本生成,例如ChatGPT的能力;其中音频、图片、视频、3D等生成能力还在持续进化中,未来的发展方向为多模态生成能力。

3. AIGC的四大产品形态

基于三大底层元能力,未来的大模型应用将沿着 AIGC(内容生成)、Copilot(智能助手)、Insight(知识洞察)、Agent(数字代理)四个重要方向演进:

1) AIGC(内容生成):内容生成是生成式 AI 创造力得以展现的核心,包括文本、图像、视频、代码、3D 模型等。

其中文本生成已经广泛应用于教育、法律以及对话业务中;图像和视频生成和3D则被营销、影视创作、游戏等领域所应用。

2)Insight(知识洞察):生成式AI可以有效解决决策式AI数据样本稀疏的问题,基于大模型实现对数据、信息、知识进行充分整合,为用户提供精准的研究分析和辅助决策。

知识洞察将应用于制造、教育、金融、医疗、军事等领域。例如AI协助医生针对特定病灶进行洞察分析、针对诊断方案进行辅助决策。

3)Copilot(智能助手):Copilot是生成式AI应用最广泛的产品形态,主要是将AI能力嵌入具体应用场景中,让AI像小助手一样,主动理解用户意图并提供成型的方案。

例如微软的Office 365 Copilot系列,可以支持word文本内容生成,excel可视化图表,包括ppt智能排版,邮件自动回复等。

4) Agent(数字代理):相较于Copilot的工具型辅助能力,Agent更强调对环境的实时感知和判断能力,AI能像人类一样形成自己的独立决策及行动方案。

此外Agent更关注AI的独立性和场景泛化,能培养自适应学习能力和持续进化能力,目前主要应用在智能终端、智能座舱、汽车自动驾驶、工业机器人、人形机器人等领域。

看到这里,是否有点眼花缭乱了?

确实AIGC对行业和经济产生的影响面是巨大的。但显然这个过程也一定是循序渐进的,并且我们看到技术要素在突变的过程中,很有可能会影响产品形态以及商业模式的变化。

接着我们尝试从行业视角,来看看大模型对它们的具体影响。

大模型如何融入行业?

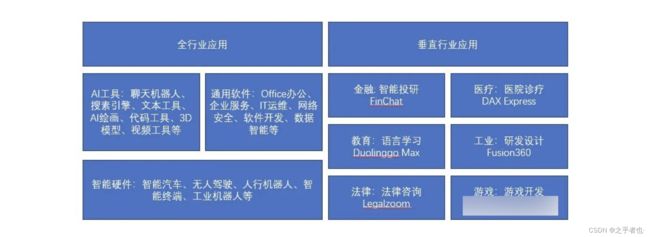

大模型融入行业,主要分为通用领域和垂直领域。

其中通用领域包含AI工具、企业软件和智能硬件。垂直领域则包含像金融、教育、游戏、医疗等领域。我们先看行业通用的都有哪些大模型产品。

1. 通用行业融合

1) 最先融入行业的,实际上是一些通用的AI工具,它们没有行业知识库的限制,并且使用成本比较低,因此也会最先融入各大行业。

其次就是通用软件,尤其在数字化转型过程中已经被企业所引入的软件,它们会很自然集成AIGC能力,并形成面向B端的增值服务。

通用AI工具包括像ChatGPT这一类的聊天机器人,搜索引擎Bing Chat,文本工具Notion AI,AI绘画工具Stable diffusion,代码工具 GitHub,3D模型工具Magic3D,视频工具Imagen video等。

它们主要以AIGC和Copilot的产品形态出现,其中头部应用虽然实现了商业化(订阅式,或者按量计费),但明显已经过了飞速增长期,进入到增长瓶颈。

它们的核心问题是对底层基础大模型高度依赖,产品同质化程度很高。比如GPT4出现后,就对很多基础模型不如GPT4的工具应用进行了碾压式的打击。

如果你是一位工具AI的创业者,很明显要拥抱基础大模型的大腿,才可能有生存之地。再或者就是寻求差异化产品和场景定位,满足未被满足的市场需求,例如针对教师做一款教学工具。

2)第二类是以数字化为核心的通用软件,它们的商业进程比AI工具要慢,主要包括像Office 365 copilot(全流程办公),Salesforce的面向企业服务的管理软件(邮件生成、智能客服、营销推广等),类似Adobe Firefly(图片精修、草图或脚本生成动画)这样的创意软件,以及类似OutSystems(代码辅助开发、代码架构自动审查、安全性能审查)这样的软件开发工具,类似ServiceNow(案例总结、对话交流、代码生成)这样的IT运维软件。

它们的产品形态还是以Copilot为主,商业模式是订阅制和解决方案付费。从竞争模式来讲,他们对底层大模型依赖不如AI工具强,竞争力主要取决于AI能力与企业场景的深度融合,以及如何低成本高效率实现相似功能。

3)第三类就是智能硬件。因为正处在萌芽期,因此也是目前商业化进程最不明朗的方向。加上它的商业模式就是产品销售,因此大模型应用的投入产出比至今还是本糊涂账。但这并不妨碍大家对它的期许,目前主要包含智能汽车的无人驾驶,智能座舱,包括智慧家庭的智能硬件,人行机器人,工业领域的工业机器人等应用。

它的主要产品形态是Copilot和Agent。因为产品竞争力取决于硬件能力,模型和算法能力。例如以大模型为底座的语音助手目前已经在智能座舱、智能音箱、家用机器人等领域逐步应用。其中AI Agent在基础感知和决策能力上依旧存在技术瓶颈,要大规模推广还需要解决技术和成本问题。

整体来讲行业通用大模型产品的实现相对容易,它的难点在于如何降低成本,并做出产品差异化。

2. 垂直行业融合

而接下来我要介绍的行业垂直应用,则非常依赖行业独有的领域数据,并且能否在特定领域取得爆发式增长,主要取决于切入场景的价值含量。

怎么评估大模型的场景应用价值呢?一般我们会选三个维度,第一:场景是否足够标准化,数据基础如何,能否进行大规模数据应用;第二:该场景是否需要大量人工作业,那么AI替代人工之后,能否提升作业质量;第三:人工作业和AI作业相比,能否达到降本提效。

头部大模型厂商基本都针对不同行业推出大模型解决方案,例如金融领域包含数据分析和知识洞察、智能投顾、智能风控等应用。医院领域包含药物研发、病例解析、智慧诊疗、手术机器人等应用。

教育行业包含语言学习、教学辅助、教育机器人等应用。工业领域包含研发设计、运维管理、生产制造、安全监控等应用。法律行业包含文书制作、法律咨询顾问、司法辅助等应用。游戏领域包含游戏开发、角色创作、场景生成等应用。

面向行业垂直应用的产品形态主要是Copilot和Insight,目前来看比较有前景的是以数据分析和知识洞察为核心的Insight应用,很多头部厂商也在开始构建属于自己的领域大模型。类似像医疗,教育和工业等领域,因为它们本身数字化进程比较慢,因此大模型的融入周期也会比较长。

参考资料:

《腾讯研究院:大模型时代的AI十大趋势观察》

《GPT_4v如何实现强大多模态,从文生图到图生文》

《全球生成式AI应用全景图》