机器学习面试题目分享面试经验分享 机器学习算法工程师深度学习 经典问题

标题机器学习面经

总结的常见面试题目等

作业帮实习视觉算法一面凉凉经

3.16号投递图像算法实习生,昨天hr打电话约了今早上牛客面试

面试官还是很和蔼的,问了很多基础和细节,平时我都没有注意到的,肯定凉了,在这里记录一下,分享给大家

由于我本科研究生都是计算机的,因此问了一些计算机基础的东西,但是由于年代久远,我都不记得了

机器学习方面知识因为缺少一些动手实践,因此很多细节都不了解

感谢面试官让我了解到这么多不足,好好查缺补漏

算法题都没做出来,面试官给了提示也没啥思路

最后面试官给了一道改错题,让我找错误,我还是没找出来

我真是太菜了

(不过最后面试官给的改错题的答案是错了,我下来自己跑了验证了一下,错误不在那里)

数据库:left join和right join、union是怎么操作的

http中的get、post区别,是怎么做的

机器学习:

LR中的连续值特征是如何处理的

为什么LR要先对数据进行归一化处理

LR用了sigmoid函数,那么LR是线性模型还是非线性模型,为什么

决策树对连续值和离散值特征是否会重复利用作为分割特征

svm为什么要转成对偶问题进行求解,为什么对偶问题的解是原问题的解

svm如何进行多分类,多分类hinge loss什么形式

cv:

BN是怎么做,作用是什么

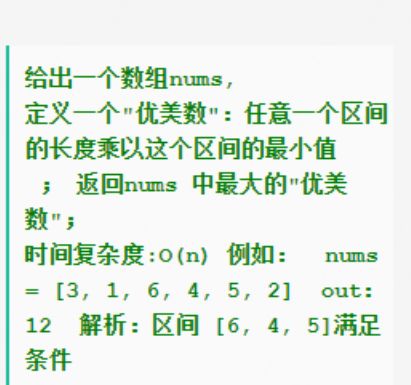

提示:使用单调栈

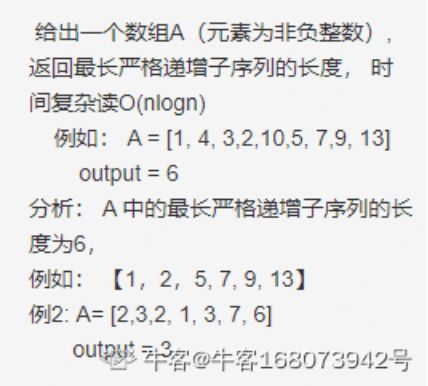

提示:使用二分法查找

改错题:

def quick_sorted_error1(array, left, right):

"""

快速排序

:param array:

:param left:

:param right:

:return:

"""

if not array: return

if left > right: return

l = left

r = right

tmp_key = array[l]

while l != r:

while (l < r and array[r] > tmp_key): r = r - 1

while (l < r and array[l] <= tmp_key): l = l + 1

array[l],array[r] = array[r], array[l]

array[l] = tmp_key

quick_sorted(array, 0, l-1)

quick_sorted(array,l+1, right)

小米机器学习面经

一面

自我介绍

结合项目描述RNN、LSTM结构,描述模型改进原理

残差连接的优势

梯度消失问题——对比深度网络的梯度消失和循环网络的梯度消失

数据不平衡问题原因与解决措施

性能指标F1分数的计算方式

DDQN项目的环境介绍与网络模型

深度学习和强化学习的关联

Adam优化器的原理,SGD的原理

手撕:

最长有效的括号字符子序列(返回所有最长的子序列)(10分钟)

反问:

1分钟

emmm手撕hard,反问草率结束,结束时还问了一句是否拿到别家offer(一面问?),咱也不懂比较看重什么。

不到24小时后:

挂

美团机器学习岗面经

分享面经集好运!

首先自我介绍,然后开始深挖项目,很细节。之后开始八股,之前准备了很多机器学习的东西,结果只问了深度学习的,比如BN,LN,优化器,ResNet,VIT。最后有个手撕,全程五十分钟左右。

面试体验还可以,就是好多没准备实在不会,非常尴尬。

阿里大文娱 机器学习算法岗面经

三面:

面试持续了不到40分钟,提问了一些论文相关知识和基础业务知识。

概率题:一根绳子随机切3段,能够构成三角形的概率是多大?(答案是1/4)

HR面:

面试官是一位和善的姐姐,主要聊了未来职业规划和期待的工作岗位。

询问了目前的求职进展,并安慰了我在其他岗位被简历挂掉的情况。

第二天进入offer流程。

负责人加面:

在开始offer流程后第二天被HR告知需要加面,理由是因为是核心业务部门,现部门负责人想要亲自加面。

面试首先以自我介绍和询问论文内容开场。

主要问题围绕具体的业务,询问常见的业务流程和业务基础知识,例如KNN算法等。

开放题:如何利用深度学习来重参数化K-means,它的前向、反向和优化目标是什么样的?

业务问题:相似图像、相似商品搜索的流程是什么样的,以及个人的知识能如何为优化流程提供见解。

微步在线 机器学习 三四面面经

微步的三面是技术面,四面是业务面,连在一起连面两个小时(理论上)。

也许是为了平衡一二面逆天的难度,微步的三面异常简单,浅浅问了问项目,八股问了几个机器学习算法基本原理,理论上1h但实际30min搞定。

业务面实打实问了1个h,主要是各种项目中的问题质询,额外问了些比较常规的大模型相关场景题,,以及对整个AIGC行业的理解。

许愿一个HR面。

美团机器学习面经

美团 机器学习

走进去的时候 面试官对着简历反复看了好几遍 感觉没有兴趣点 ,隐隐约约的觉得马上要GG了

1 问了 卷积层和池化层的区别

卷积层:用它来进行特征提取。

池化层:对输入的特征图进行压缩,一方面使特征图变小,简化网络计算复杂度;一方面进行特征压缩,提取主要特征

2 卷积公式 手写 撸了一个二维的卷积 ,一维的忘了

/f(t)g(x-t)dt /表示积分

3你对传统的机器学习有了解吗?比如?

4哦 逻辑斯地回归 说一下目标函数 ( 说了对数损失)

5 为什么用这个目标函数

6 平方误差可以用在这个损失函数上吗? 为啥?

( 说平方误差不好 ,解释了为啥 问能用吗? 我想回去看统计学习了)

7 你的研究课题是啥? 懵逼中 ,你做了啥?(。。。)

8 大数据

(没深入)

9 输入正整数N 打印2^ n值

首先说移位,然后大数怎么办 ?最后算法没写出来。

GG

总结: 传统的机器学习方法有待提升 ,需要看大数据的东西

百度 提前批机器学习 二面面经

自我介绍到一半打断了,直接问八股……

关注的点和一面一样有点奇怪,特别喜欢问我记不记得base模型的d_models和seq_len以及各种各样的参数……

项目里一直纠结我训的1.5B模型,我跟她说我还训了3.8B和72B版本,没让我讲下去,说1.5B已经很大,可以满足我们项目需求了……

代码题做了lc. 236的变体最近公共子节点,和lc. 15三数之和,手撕的没什么问题,但这三数之和在一面已经考过一遍了……

贝壳机器学习算法面经

国庆刚过就接到了淳儿姐的offer call,开心。写个面经,机器学习算法工程师。

一面,基础面:

1.precision和recall的定义和公式;

2.不平衡数据集的适用指标有哪些;

3.AUC、ROC的定义、实际意义、画法;

4.画ROC曲线,依照曲线上某点解释意义;

5.除了修改mercy,还可以用哪些方法来处理不平衡数据集;

6.写贝叶斯公式,解释先验、似然、后验;

7.写vc dimension的公式,解释其意义、作用;

8.简单介绍神经网络和CNN,介绍一下CNN对NN的改进之处;

9.介绍inception、VGG、Resnet;

10.为什么VGG要使用小的kernel代替大kernel;

11.目标检测RCNN系列介绍;

补:介绍HMM模型,手推前向后向算法

12.手撕代码,剑指offer原题,分析时间复杂度;

13.场景应用题,我用了simnet解决;

14.simnet介绍;

15.有什么问题问他;

二面,感觉面能力:

1.自我介绍;

2.项目介绍;

3.挑了三个项目详细介绍了使用的方法、思路等等;

4.深度学习与传统方法的区别;

5.深度学习和机器学习各自的适用场景、举例说明;

6.在CV中用到的机器学习方法介绍;

7.对CV、NLP和ML的偏好、看法;

8.找工作时对公司哪个方面更加看重,为什么要来贝壳面试(汗);

9.有什么问题问他;

三面hr面,姐姐超漂亮,一切和谐顺利,聊得很开心,感觉过了CVTE的hr面之后,其他公司的hr面都是so easy难度的。

S面是boss面,聊的项目和学校生活经历。

嗯…贝壳面试体验很好,但当时连现场的吃的都没好意思吃,饿着肚子面了一下午,更不用说搭讪了,后悔,没有去要小姐姐们的微信、