ELK7.8部署:Elasticsearch+Logstash+Kibana搭建分布式日志平台

ELK7.8部署:Elasticsearch+Logstash+Kibana搭建分布式日志平台

- 一、前言

-

- 1、ELK简介

- 2、ELK工作流

- 二、准备工作

-

- 1、服务器&软件环境说明

- 2、ELK环境准备

- 三、Elasticsearch 部署

-

- 1、准备工作

- 2、配置

- 四、Logstash 部署

-

- 1、准备工作

- 2、Logstash配置

- 五、Kibana 部署

-

- 1、准备工作

- 2、Kibana配置与访问测试

- 六、测试

-

- 1、日志写入

- 2、 访问

- 七、备注

-

- 1、Kibana使用教程

- 2、如果遇到问题,可以查看以下网站:

一、前言

1、ELK简介

ELK是Elasticsearch+Logstash+Kibana的简称

- ElasticSearch是一个基于Lucene的分布式全文搜索引擎,提供 RESTful API进行数据读写

- Logstash是一个收集,处理和转发事件和日志消息的工具

- Kibana是Elasticsearch的开源数据可视化插件,为查看存储在ElasticSearch提供了友好的Web界面,并提供了条形图,线条和散点图,饼图和地图等分析工具

总的来说,ElasticSearch负责存储数据,Logstash负责收集日志,并将日志格式化后写入ElasticSearch,Kibana提供可视化访问ElasticSearch数据的功能。

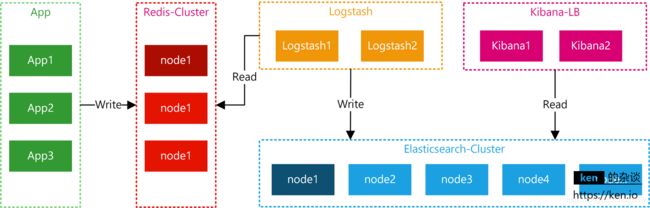

2、ELK工作流

应用将日志按照约定的Key写入Redis,Logstash从Redis中读取日志信息写入ElasticSearch集群。Kibana读取ElasticSearch中的日志,并在Web页面中以表格/图表的形式展示。

二、准备工作

1、服务器&软件环境说明

- 软件环境

这里为了节省,Elasticsearch + Logstash + Kibana + Redis部署在了一台机器上。

如果在生产环境部署,可以按照自己的需求调整。

| 项 | 说明 |

|---|---|

| Linux Server | Ubuntu 20.04 server |

| Elasticsearch | 7.8.1 |

| Logstash | 7.8.1 |

| Kibana | 7.8.1 |

| Redis | 6.0.3 |

| JDK | 14.0.2 |

2、ELK环境准备

由于Elasticsearch、Logstash、Kibana均不能以root账号运行。但是Linux对非root账号可并发操作的文件、线程都有限制。所以,部署ELK相关的机器都要调整:

- 增加最大文件打开数

永久生效方法echo “* - nofile 65536” >> /etc/security/limits.conf - 修改文件限制

vim /etc/security/limits.conf ---在文件最后面添加如下内容

* soft nofile 65536 #代表警告的设定,可以超过这个设定值,但是超过后会有警告。

* hard nofile 131072 #代表严格的设定,不允许超过这个设定的值。

* soft nproc 2048 #是每个进程可以打开的文件数的限制

* hard nproc 4096 #是操作系统级别对每个用户创建的进程数的限制

- 调整进程数

#修改系统文件,如果没有20-nproc.conf,则创建一个

vim /etc/security/limits.d/20-nproc.conf

#调整成以下配置

* soft nproc 4096

root soft nproc unlimited

- 调整虚拟内存&最大并发连接

#增大用户使用内存的空间(临时)

sysctl -w vm.max_map_count=262144

#永久

vim /etc/sysctl.conf ---添加如下

vm.max_map_count=655360

fs.file-max=655360

vm.swappiness=0

- 以上操作重启系统后生效

reboot

-

JDK安装

Ubuntu 安装JDK:https://blog.csdn.net/Asia1752/article/details/104505189/ -

创建运行ES的普通用户

useradd -s "/bin/bash" elk

- 创建ELK相关目录并赋权

#创建ELK APP目录

mkdir /usr/elk

#创建ELK 数据目录

mkdir /elk

#更改目录Owner

chown -R elk:elk /usr/elk

chown -R elk:elk /elk

- 下载ELK包并解压

#打开文件夹

cd /home/download

#下载

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-7.8.1-linux-x86_64.tar.gz

wget https://artifacts.elastic.co/downloads/logstash/logstash-7.8.1.tar.gz

wget https://artifacts.elastic.co/downloads/kibana/kibana-7.8.1-linux-x86_64.tar.gz

#解压

tar -zvxf elasticsearch-7.8.1.tar.gz

tar -zvxf logstash-7.8.1.tar.gz

tar -zvxf kibana-7.8.1-linux-x86_64.tar.gz

三、Elasticsearch 部署

1、准备工作

- 移动Elasticsearch到统一目录

#移动目录

mv /home/download/elasticsearch-7.8.1 /usr/elk

#赋权

chown -R elk:elk /usr/elk/elasticsearch-7.8.1/

- 切换账号

#账号切换到 elk

su - elk

- 数据&日志目录

创建Elasticsearch主目录

mkdir /elk/es

#创建Elasticsearch数据目录

mkdir /elk/es/data

#创建Elasticsearch日志目录

mkdir /elk/es/logs

2、配置

#打开目录

cd /usr/elk/elasticsearch-7.8.1

#修改配置

vim config/elasticsearch.yml

- 配置文件内容如下:

cluster.name: elk

node.name: elk01

node.master: true

node.data: true

cluster.initial_master_nodes: ["elk01"]

path.data: /elk/es/data

path.logs: /elk/es/logs

bootstrap.memory_lock: false

bootstrap.system_call_filter: false

network.host: 0.0.0.0

http.port: 9200

#discovery.zen.ping.unicast.hosts: ["192.168.146.128"]

#discovery.zen.minimum_master_nodes: 2

#discovery.zen.ping_timeout: 150s

#discovery.zen.fd.ping_retries: 10

#client.transport.ping_timeout: 60s

http.cors.enabled: true

http.cors.allow-origin: "*"

- 配置文件含义

cluster.name 集群名称,各节点配成相同的集群名称。

node.name 节点名称,各节点配置不同。

node.master 指示某个节点是否符合成为主节点的条件。

node.data 指示节点是否为数据节点。数据节点包含并管理索引的一部分。

path.data 数据存储目录。

path.logs 日志存储目录。

bootstrap.memory_lock 内存锁定,是否禁用交换。

bootstrap.system_call_filter 系统调用过滤器。

network.host 绑定节点IP。

http.port 端口。

discovery.zen.ping.unicast.hosts 提供其他 Elasticsearch 服务节点的单点广播发现功能。

discovery.zen.minimum_master_nodes 集群中可工作的具有Master节点资格的最小数量,官方的推荐值是(N/2)+1,其中N是具有master资格的节点的数量。

discovery.zen.ping_timeout 节点在发现过程中的等待时间。

discovery.zen.fd.ping_retries 节点发现重试次数。

http.cors.enabled 是否允许跨源 REST 请求,用于允许head插件访问ES。

http.cors.allow-origin 允许的源地址。

- 设置JVM堆大小

vim /usr/elk/elasticsearch-7.8.1/config/jvm.options

-Xms1g ----修改成 -Xms2g

-Xmx1g ----修改成 -Xms2g

#一般设置为虚拟机内存的一半,最少为2G,推荐设置为4G

注意:确保堆内存最小值(Xms)与最大值(Xmx)的大小相同,防止程序在运行时改变堆内存大小。堆内存大小不要超过系统内存的50%

- 启动ES

#进入elasticsearch根目录

cd /usr/elk/elasticsearch-7.8.1

#启动

./bin/elasticsearch

#如需后台启动,则用

nohup ./bin/elasticsearch &

浏览器访问http://192.168.146.128:9200/ 返回如下参数

{

"name" : "elk01",

"cluster_name" : "elk",

"cluster_uuid" : "ixCxBDIkQA2WFtjTdKBXNQ",

"version" : {

"number" : "7.8.1",

"build_flavor" : "default",

"build_type" : "tar",

"build_hash" : "b5ca9c58fb664ca8bf9e4057fc229b3396bf3a89",

"build_date" : "2020-07-21T16:40:44.668009Z",

"build_snapshot" : false,

"lucene_version" : "8.5.1",

"minimum_wire_compatibility_version" : "6.8.0",

"minimum_index_compatibility_version" : "6.0.0-beta1"

},

"tagline" : "You Know, for Search"

}

四、Logstash 部署

1、准备工作

- 部署Redis

Redis6 安装与配置: https://www.cnblogs.com/somegenki/p/13098723.html - 移动Logstash到统一目录

#移动目录

mv /home/download/logstash-7.8.1 /usr/elk

#赋权

chown -R elk:elk /usr/elk/logstash-7.8.1/

- 切换账号

#账号切换到 elk

su - elk

- 数据&日志目录

#创建Logstash主目录

mkdir /elk/logstash

#创建Logstash数据目录

mkdir /elk/logstash/data

#创建Logstash日志目录

mkdir /elk/logstash/logs

2、Logstash配置

- 配置数据&日志目录

#打开目录

cd /usr/elk/logstash-7.8.1

#修改配置

vim config/logstash.yml

#增加以下内容

path.data: /elk/logstash/data

path.logs: /elk/logstash/logs

- 配置Redis&Elasticsearch

vim config/input-output.conf

input {

redis {

data_type => "list"

key => "logstash"

host => "192.168.1.80"

port => 6379

threads => 5

codec => "json"

password => "1234"

}

}

filter {

}

output {

elasticsearch {

hosts => ["192.168.1.80:9200"]

index => "logstash-%{type}-%{+YYYY.MM.dd}"

}

stdout {

}

}

该配置就是从redis中读取数据,然后写入指定的elasticsearch

Redis核心配置项说明:

data_type => “list” 数据类型为list

key => “logstash” 缓存key为:logstash

codec => “json” 数据格式为:json

- 启动

#进入Logstash根目录

cd /usr/elk/logstash-7.8.1

#启动

./bin/logstash -f config/input-output.conf

五、Kibana 部署

1、准备工作

- 移动Kibana到统一目录

#移动目录

mv /home/download/kibana-7.8.1-linux-x86_64 /usr/elk/kibana-7.8.1

#赋权

chown -R elk:elk /usr/elk/kibana-7.8.1/

- 安装依赖包

apt install libnss3-dev

- 切换账号

#账号切换到 elk

su - elk

2、Kibana配置与访问测试

- 修改配置

#进入kibana-7.8.1根目录

cd /usr/elk/kibana-7.8.1

#修改配置

vim config/kibana.yml

#增加以下内容

i18n.locale: "zh-CN"

server.port: 5601

server.host: "192.168.1.80" #kibana本机的地址

elasticsearch.hosts: "http://192.168.1.80:9200" #ES主节点地址+端口

kibana.index: ".kibana"

- 启动

#进入kibana-7.8.1根目录

cd /usr/elk/kibana-7.8.1

#启动

./bin/kibana

六、测试

1、日志写入

日历写入的话,写入到logstash监听的redis即可。

数据类型之前在/usr/elk/logstash-6.0.0/config/input-uput.conf中有配置

- redis命令方式

#启动redis客户端

#执行以下命令

lpush logstash '{"host":"127.0.0.1","type":"logtest","message":"hello"}'

2、 访问

七、备注

1、Kibana使用教程

- https://segmentfault.com/a/1190000002972420

2、如果遇到问题,可以查看以下网站:

- https://zhang0peter.com/2020/02/07/linux-chrome-bug/