【精选】基于RFCBAMConv与YOLOv8优化的杂草分割系统 农业智能检测平台、深度学习图像分割与注意力机制融合 杂草智能识别与分类系统、深度学习目标分割优化改、进型YOLOv8杂草图像分割系统

博主介绍:

✌我是阿龙,一名专注于Java技术领域的程序员,全网拥有10W+粉丝。作为CSDN特邀作者、博客专家、新星计划导师,我在计算机毕业设计开发方面积累了丰富的经验。同时,我也是掘金、华为云、阿里云、InfoQ等平台的优质作者。通过长期分享和实战指导,我致力于帮助更多学生完成毕业项目和技术提升。技术范围:

我熟悉的技术领域涵盖SpringBoot、Vue、SSM、HLMT、Jsp、PHP、Nodejs、Python、爬虫、数据可视化、小程序、安卓app、大数据、物联网、机器学习等方面的设计与开发。如果你有任何技术难题,我都乐意与你分享解决方案。为什么选择阅读我:

我是程序阿龙,专注于软件开发,拥有丰富的编程能力和实战经验。在过去的几年里,我辅导了上千名学生,帮助他们顺利完成毕业项目,同时我的技术分享也吸引了超过50W+的粉丝。我是CSDN特邀作者、博客专家、新星计划导师,并在Java领域内获得了多项荣誉,如博客之星。我的作品也被掘金、华为云、阿里云、InfoQ等多个平台推荐,成为各大平台的优质作者。

获取源码请在文末联系我

目录:

一、详细操作演示视频 在文章的尾声,您会发现一张电子名片,欢迎通过名片上的联系方式与我取得联系,以获取更多关于项目演示的详尽视频内容。视频将帮助您全面理解项目的关键点和操作流程。期待与您的进一步交流!

1. 研究背景与意义

2. 研究目标

3. YOLOv8算法与问题分析

4. 解决方案:融合感受野注意力卷积RFCBAMConv

4.1 感受野注意力机制(RFCBAMConv)

4.2 RFCBAMConv卷积层

4.3 结合YOLOv8的改进

5. 研究意义

1. 图片的收集

数据集的采集与标注和整理

1. 图片的收集

2. 图片标注

2.1 使用 eiseg 工具进行标注

2.2 将VOC格式转换为YOLO格式

3. 数据集划分与格式化

3.1 数据划分

1. 卷积运算的限制

2. 注意力机制的引入

3. 感受野注意力机制(RFA)

4. RFAConv(感受野注意力卷积)

5. 快速提取感受野特征

6. 轻量级设计

7. 新的卷积神经网络架构:RFCBAMConv 和 RFCAConv

为什么选择我(我可以给你的定制项目推荐核心功能,一对一推荐)实现定制!!!

博主提供的项目均为博主自己收集和开发的!所有的源码都经由博主检验过,能过正常启动并且功能都没有问题!同学们拿到后就能使用!且博主自身就是高级开发,可以将所有的代码都清晰讲解出来。编辑编辑

源码获取

文章下方名片联系我即可~大家点赞、收藏、关注、评论啦 、查看获取联系方式精彩专栏推荐订阅:在下方专栏

一、详细操作演示视频

在文章的尾声,您会发现一张电子名片,欢迎通过名片上的联系方式与我取得联系,以获取更多关于项目演示的详尽视频内容。视频将帮助您全面理解项目的关键点和操作流程。期待与您的进一步交流!

1. 研究背景与意义

随着计算机视觉和深度学习技术的快速发展,图像分割已经成为视觉领域的核心任务之一,广泛应用于医学影像、自动驾驶、智能监控等多个领域。图像分割的目标是将图像中的不同区域或对象进行有效分离,对于精准检测和识别至关重要。在农业领域,杂草分割尤其重要,它能够帮助农民有效地区分作物与杂草,从而精准地进行农药喷洒,减少资源浪费并控制杂草生长。

然而,现有的图像分割方法在农业应用,尤其是杂草分割任务中,还存在一些问题:

- 感受野的局限性:现有的分割网络在处理不同尺度的杂草时,感受野无法自适应调整,导致较小或较大的杂草难以准确分割。

- 细节信息的丢失:在分割任务中,细节信息的捕捉尤为重要,尤其是对于杂草这样形态多变的目标,传统的深度学习方法往往无法很好地捕捉到这些细节,导致分割精度较低。

因此,如何在保持高效的同时,增强模型对不同尺度目标的感知和细节信息的提取,成为了一个亟待解决的难题。

2. 研究目标

本研究旨在提出一种改进的YOLOv8算法,通过融合感受野注意力机制和RFCBAMConv卷积层,构建一个更加高效和精确的杂草分割系统。具体来说,研究目标如下:

- 提高杂草分割的准确性:通过引入感受野注意力机制,自适应地调整网络的感受野大小,从而更好地适应不同尺度的杂草分割任务。

- 增强细节信息提取能力:通过引入RFCBAMConv卷积层,提升对细节信息的捕捉能力,确保细小和边缘部位的准确分割。

- 提高分割效率:在提高分割精度的同时,优化算法的计算效率,降低大规模农田应用中的时间和计算成本。

3. YOLOv8算法与问题分析

YOLOv8是当前较为先进的目标检测算法,能够在保持较高精度的同时,完成快速检测任务。然而,YOLOv8在杂草分割任务中存在如下问题:

- 感受野限制:YOLOv8采用的是固定大小的卷积核,在处理尺度变化较大的杂草时,容易造成识别不清晰或者漏检。

- 细节信息提取不足:由于卷积层的设计并未针对细节信息进行专门优化,因此在处理细节复杂的杂草时,算法容易忽略或模糊杂草的边缘和细小部分。

这些问题使得YOLOv8在杂草分割任务中的表现不如其他传统的分割算法,如U-Net等。

4. 解决方案:融合感受野注意力卷积RFCBAMConv

为了克服YOLOv8在杂草分割中的局限性,本研究提出一种改进的YOLOv8算法,融合感受野注意力机制(RFCBAMConv),具体改进如下:

4.1 感受野注意力机制(RFCBAMConv)

感受野是卷积神经网络中的重要概念,它决定了网络在处理图像时能够“看到”的范围。为了有效处理杂草这种尺度差异较大的目标,本研究提出一种自适应感受野注意力机制,能够根据输入图像的不同区域自适应地调整感受野大小。这一机制能够:

- 自适应调整感受野:通过感受野注意力机制,模型能够针对不同大小的杂草自适应调整感受野,以获得最佳的感知效果。

- 多尺度特征融合:通过对不同尺度的特征进行有效融合,增强对小尺寸和大尺寸杂草的检测能力,避免漏检和错误分类。

4.2 RFCBAMConv卷积层

RFCBAMConv(Radial Field-based Convolutional Block Attention Module)是本研究设计的一个新型卷积层,旨在提升网络对图像细节的敏感度。该模块的核心思想是在传统卷积核的基础上引入径向场的自适应调节,模拟生物视觉系统对图像细节的关注机制。具体来说:

- 局部细节捕捉:通过在卷积操作中引入径向场变换,能够增强卷积核对细节部分的捕捉能力,特别是在杂草的细节和边缘区域。

- 全局与局部信息融合:RFCBAMConv能够有效地结合全局和局部的特征信息,提升对杂草复杂形态的理解能力。

4.3 结合YOLOv8的改进

本研究将RFCBAMConv卷积层集成到YOLOv8的骨干网络中,结合感受野注意力机制和卷积层的增强功能,优化YOLOv8在杂草分割任务中的表现:

- 在YOLOv8的特征提取阶段,使用改进后的RFCBAMConv替代传统卷积层,从而更好地提取细节信息。

- 在YOLOv8的检测头部分,加入基于多尺度特征的自适应注意力机制,增强对杂草不同尺寸目标的分割能力。

5. 研究意义

改进的YOLOv8算法,融合感受野注意力卷积RFCBAMConv的杂草分割系统,具有如下研究意义:

- 提高杂草分割准确性:通过改进的感受野调整和细节信息提取,能够显著提高杂草分割的精度,减少漏检和误检,帮助农民更精准地分离作物与杂草。

- 提升分割效率:在保证高精度的同时,优化算法的计算性能,减少大规模农田应用中的计算负担和时间成本。

- 推动深度学习在农业中的应用:为农业领域提供了一种有效的杂草分割解决方案,推动了深度学习技术在农业智能化中的应用。

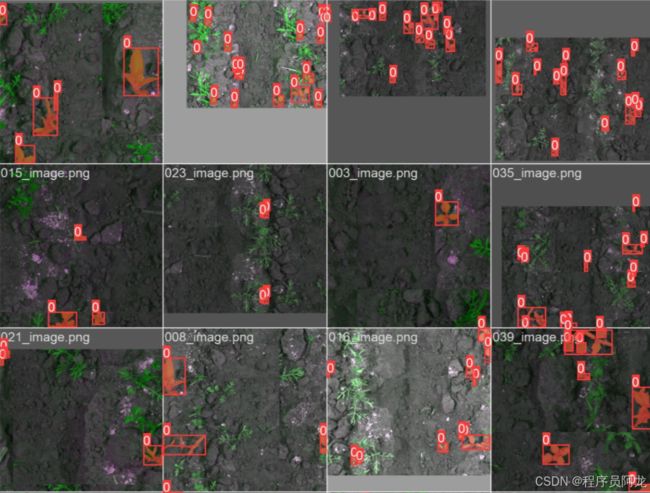

在本研究中,数据集的采集、标注与整理是至关重要的步骤。为了保证杂草分割任务的数据质量,数据集的采集与标注需遵循一套标准流程。以下是详细的步骤和代码示例。

1. 图片的收集

数据集的收集可以通过公开数据集或自行拍摄得到,具体方法有:

- 使用公开数据集: 可以选择现有的图像数据集,如

ZCDatasets等,专门用于杂草分割任务。 - 自主拍摄: 可以在实际农田中拍摄杂草和作物的图像,确保数据集的多样性,包含不同的气候、季节、杂草种类等因素。

数据集的采集与标注和整理

在本研究中,数据集的采集、标注与整理是至关重要的步骤。为了保证杂草分割任务的数据质量,数据集的采集与标注需遵循一套标准流程。以下是详细的步骤和代码示例。

1. 图片的收集

数据集的收集可以通过公开数据集或自行拍摄得到,具体方法有:

- 使用公开数据集: 可以选择现有的图像数据集,如

ZCDatasets等,专门用于杂草分割任务。 - 自主拍摄: 可以在实际农田中拍摄杂草和作物的图像,确保数据集的多样性,包含不同的气候、季节、杂草种类等因素。

2. 图片标注

图片标注是图像分割任务中的关键步骤。为了使用YOLO等深度学习算法进行训练,需要将图片的标注信息转换为YOLO格式。以下是使用图形化工具 eiseg 标注数据并转换为YOLO格式的步骤:

2.1 使用 eiseg 工具进行标注

eiseg 是一个支持图形化标注的工具,支持COCO和YOLO格式。下面是具体的标注步骤:

- 下载并安装

eiseg。 - 打开

eiseg,点击“Open Dir”选择图片文件夹。 - 设置目标对象标签,例如“杂草”。

- 使用矩形框在图片中标注杂草区域,选择相应标签。

- 保存标注信息,

eiseg会生成一个JSON文件,包含图像的标注信息。

2.2 将VOC格式转换为YOLO格式

YOLO格式的标注文件要求每个标注文件为一个文本文件(.txt),文件中的每一行代表一个标注框,格式为:

在标注完成后,可以使用以下 Python 脚本将标注从VOC格式(XML)转换为YOLO格式:

import json

import os

import glob

from pathlib import Path

from PIL import Image

import numpy as np

from tqdm import tqdm

# 定义转换函数

def convert_infolks_json(name, files, img_path):

# 创建输出目录

path = make_dirs()

# 导入json文件

data = []

for file in glob.glob(files):

with open(file) as f:

jdata = json.load(f)

jdata['json_file'] = file

data.append(jdata)

# 获取图片和标注信息

name = path + os.sep + name

file_id, file_name, wh, cat = [], [], [], []

for x in tqdm(data, desc='Files and Shapes'):

f = glob.glob(img_path + Path(x['json_file']).stem + '.*')[0]

file_name.append(f)

wh.append(exif_size(Image.open(f))) # (width, height)

cat.extend(a['classTitle'].lower() for a in x['output']['objects']) # categories

# 写入文件

with open(name + '.txt', 'a') as file:

file.write('%s\n' % f)

# 写入分类文件

names = sorted(np.unique(cat))

with open(name + '.names', 'a') as file:

[file.write('%s\n' % a) for a in names]

# 写入标注文件

for i, x in enumerate(tqdm(data, desc='Annotations')):

label_name = Path(file_name[i]).stem + '.txt'

with open(path + '/labels/' + label_name, 'a') as file:

for a in x['output']['objects']:

category_id = names.index(a['classTitle'].lower())

# 将VOC格式的bounding box转换为YOLO格式

box = np.array(a['points']['exterior'], dtype=np.float32).ravel()

box[[0, 2]] /= wh[i][0] # x归一化

box[[1, 3]] /= wh[i][1] # y归一化

box = [box[[0, 2]].mean(), box[[1, 3]].mean(), box[2] - box[0], box[3] - box[1]] # xywh格式

# 如果宽度和高度有效,写入标注文件

if (box[2] > 0.) and (box[3] > 0.):

file.write('%g %.6f %.6f %.6f %.6f\n' % (category_id, *box))

# 将数据集划分为训练集、测试集和验证集

split_files(name, file_name)

write_data_data(name + '.data', nc=len(names))

print(f'Done. Output saved to {os.getcwd() + os.sep + path}')

# 调用转换函数

convert_infolks_json(name='out', files='../data/sm4/json/*.json', img_path='../data/sm4/images/')

3. 数据集划分与格式化

在标注完成后,我们需要将数据集划分为训练集、验证集和测试集。通常的比例是70%用于训练,15%用于验证,15%用于测试。

3.1 数据划分

为了方便模型训练,我们将图像文件和标注文件按照一定比例划分为训练、测试和验证集。

import random

import shutil

def split_files(output_path, image_files):

# 打乱图像文件顺序

random.shuffle(image_files)

# 计算划分比例

train_size = int(len(image_files) * 0.7)

val_size = int(len(image_files) * 0.15)

test_size = len(image_files) - train_size - val_size

# 创建目录

os.makedirs(output_path + '/train', exist_ok=True)

os.makedirs(output_path + '/val', exist_ok=True)

os.makedirs(output_path + '/test', exist_ok=True)

# 划分图像文件

for i, file in enumerate(image_files):

if i < train_size:

shutil.copy(file, output_path + '/train/')

elif i < train_size + val_size:

shutil.copy(file, output_path + '/val/')

else:

shutil.copy(file, output_path + '/test/')

1. 卷积运算的限制

卷积神经网络通过共享卷积核参数降低计算开销,但共享参数的策略也导致了卷积神经网络无法适应不同位置、不同感受野的特征差异。这一问题在不同的深度学习任务(如分类、目标检测、语义分割等)中尤其突出,限制了模型的表达能力和性能。

2. 注意力机制的引入

注意力机制的核心思想是使模型能够专注于输入数据中的关键部分,从而增强特征提取的有效性。现有的注意力机制,如Squeeze-and-Excitation (SE)、CBAM(卷积块注意力模块)等,能够通过加权不同通道或空间特征来提升网络的表现。然而,这些方法在处理卷积核的共享参数问题时,仍然存在不足。

3. 感受野注意力机制(RFA)

为了更有效地解决卷积运算中的参数共享问题,提出了感受野注意力(RFA)机制。与传统的空间注意力机制不同,RFA不仅关注每个特征的重要性,还重视感受野空间特征,从而彻底解决了卷积核共享参数的问题。通过动态生成感受野空间特征,RFA能够为每个特征分配不同的注意力权重,避免了大卷积核带来的参数共享问题。

4. RFAConv(感受野注意力卷积)

基于RFA设计的卷积运算(RFAConv)是一种创新的卷积方式,它通过为每个感受野的特征生成独立的注意力图,有效地提高了网络性能。与传统的卷积操作相比,RFAConv不仅解决了参数共享的问题,而且能够根据每个感受野的空间特性动态调整权重。实验表明,RFAConv在多个标准数据集(如ImageNet、COCO和VOC)上的表现优于传统的卷积操作。

5. 快速提取感受野特征

提取感受野特征的速度通常较慢,为了提高效率,RFAConv使用分组卷积替代传统方法,通过池化每个感受野特征的全局信息,并用1×1卷积来进行信息交互。这种方法在提高性能的同时,降低了计算开销。

6. 轻量级设计

与一些传统的基于自注意力的卷积方法相比,RFAConv的设计更加轻量级,减少了计算开销,并且有效避免了自注意力机制所带来的复杂性。通过将注意力机制专注于感受野空间特征,RFAConv不仅提高了特征提取能力,还提升了网络的效率。

7. 新的卷积神经网络架构:RFCBAMConv 和 RFCAConv

为进一步优化卷积神经网络的架构,提出了基于感受野注意力的卷积块注意力(RFCBAMConv)和感受野注意力的通道注意力(RFCAConv)。这些新模块结合了空间和通道注意力,同时加权每个通道的特征,以提高网络性能并减少计算开销。

为什么选择我(我可以给你的定制项目推荐核心功能,一对一推荐)实现定制!!!

博主提供的项目均为博主自己收集和开发的!所有的源码都经由博主检验过,能过正常启动并且功能都没有问题!同学们拿到后就能使用!且博主自身就是高级开发,可以将所有的代码都清晰讲解出来。

-

源码获取

文章下方名片联系我即可~

大家点赞、收藏、关注、评论啦 、查看获取联系方式

精彩专栏推荐订阅:在下方专栏