智能体/Agent概念详解

智能体/Agent概念详解

1.1AI Agent体系介绍

1.1.1什么是AI Agent

![]()

Agent在接触AI前大部分人对这个词的定义是代理

而在AI模型领域更愿意称之为智能体

代理我们都知道是什么意思,那么智能体呢?

Logan Kilpatrick,OpenAI 开发者关系负责人给出的介绍如下

Agent(智能体) = 一个设置了一些目标或任务,可以迭代运行的大型语言模型。这与大型语言模型(LLM)在像ChatGPT这样的工具中“通常”的使用方式不同。在ChatGPT中,你提出一个问题并获得一个答案作为回应。而Agent拥有复杂的工作流程,模型本质上可以自我对话,而无需人类驱动每一部分的交互。 -Logan Kilpatrick,OpenAI 开发者关系负责人

用通俗语言解释

chat类型gpt接受单一输入查询,并返回结果,他不能一次完成超过一个任务.

而AI Agent则是可以自驱定义工作流程,并规划任务进行解决

比如:

"你有一个天气查询的系统,用户输入NYC(纽约的缩写)的温度是多少"传统的模型无法识别到NYC是什么意思?,

但是使用AI Agent可以在他获取到模型不具备NYC的知识的情况下,去思考NYC是什么,在哪里查到NYC是什么,

去查地区城市缩写,最后返回结果

而在上一章的内容中有提到

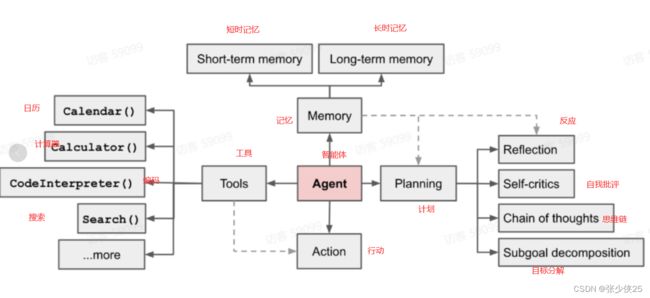

智能体 = 大语言模型(LLM) + 观察 + 思考 + 行动 + 记忆

下面用一张图来表达一下

-

记忆

-

短期记忆:我认为所有的上下文学习(参见提示工程)都是利用模型的短期记忆来学习。

-

长期记忆:这为Agents提供了长时间保留和回忆(无限)信息的能力,通常是通过利用外部向量存储和快速检索来实现。

一句话解释长期记忆和短期记忆,当我问你1+1等于几你不需要考虑他就是你的长时记忆,当我问你99*55等于多少你需要用脑子想一下算一下这就是你的短时记忆

-

-

规划

- 子目标和分解:Agents将大型任务分解为更小的、可管理的子目标,从而能够有效处理复杂的任务。

- 反思和完善:Agents可以对过去的行为进行自我批评和自我反思,从错误中吸取教训,并针对未来的步骤进行完善,从而提高最终结果的质量。

-

工具使用

- Agents学习调用外部 API 来获取模型权重中缺失的额外信息(通常在预训练后很难更改),包括当前信息、代码执行能力、对专有信息源的访问等

1.1.2智能体用例

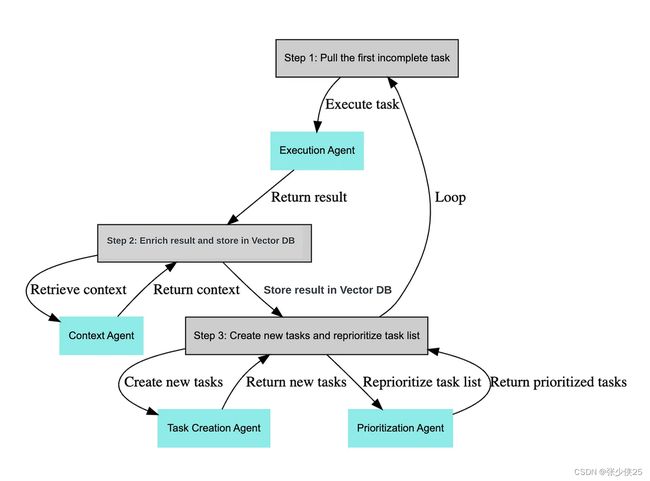

概念验证Agent-BabyAGI

Baby AGI 是一个 python 脚本,它使用 OpenAI 和 Pinecone API 以及 LangChain 框架来创建、组织、确定优先级以及执行任务。Baby AGI 背后的过程是,它将使用基于上一个任务结果的预定义目标创建一个任务。

这是通过使用 OpenAI 的自然语言处理 (NLP) 功能实现的,该功能允许系统根据目标创建新任务。它使用 Pinecone 来存储该特定任务的结果并检索上下文,并使用 LangChain 框架来处理决策过程。

来自 https://github.com/yoheinakajima/babyagi 的图片

这个过程在为智能体创建一个目标或主任务后,主要分为以下三个步骤:

- 获取第一个未完成的任务

- 丰富结果并存储在向量数据库中(如果你不清楚这意味着什么,没关系)

- 创建新的任务并重新设置任务列表的优先级

根据目标开始任务,然后转到从内存中获取上下文的查询。然后将其发送到创建代理,创建代理获取数据并将其发送到内存。然后,它将通过一个队列,该队列将完成任务的优先级排序。

让我们一起来看一个具体的例子。我们可以从一个任务开始,例如"编写一篇关于ChatGPT以及功能的1500字博客文章"。作为控制agent的用户,你可以写出这个目标,尽可能详细地提供要求,然后你就完成了。

模型接收这些要求,并执行如下操作:

sub_tasks = openai.ChatCompletion.create(

model="gpt-4",

messages=[

{"role": "system", "content": "You are an world class assistant designed to help people accomplishh tasks"},

{"role": "user", "content": "Create a 1500 word blog post on ChatGPT and what it can do"},

{"role": "user", "content": "Take the users request above and break it down into simple sub-tasks which can be easily done."}

]

)

在这个例子中,我们使用OpenAI API来驱动agent。系统消息允许你在一定程度上定义你的agent,但在这个例子中,我们并没有真正使用它。然后,我们添加用户查询和关键的下一步,即在其上添加一个任务,该任务是将查询分解成子任务。

然后,你可以将子任务放入一个循环中,并进行额外的调用以执行这些子任务,所有这些都带有不同的系统消息(想想不同的agents,可能是一个写作agent,一个研究agent等)。你可能会想要“将这个任务分解成更简单的子任务,直到你100%清楚需要做什么并且可以高精度地执行任务”,这样模型就不会陷入添加更多任务的无限循环中(如果你没有正确地进行提示工程,今天的agents就会常常出现这个问题)。

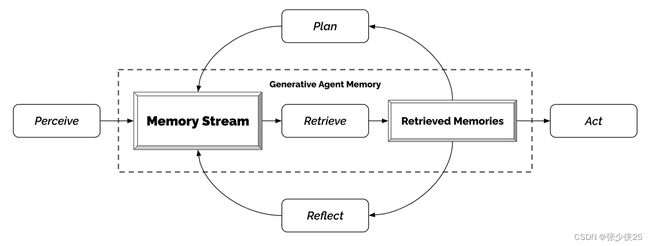

生成Agents模拟

Generative Agents(Park 等人,2023)是一个超级有趣的实验,其中 25 个虚拟角色,每个角色都由 LLM 支持的Agents控制,在沙盒环境中生活和交互,其灵感来自《模拟人生》。生成Agents为交互式应用程序创建可信的人类行为模拟。

生成Agents的设计将 LLM 与记忆、规划和反射机制相结合,使Agents能够根据过去的经验进行行为,并与其他Agents进行交互。

- 记忆流:是一个长期记忆模块(外部数据库),用自然语言记录智能体经验的完整列表。

- 每个元素都是一个观察结果,是由 Agent 直接提供的事件。代理人之间的交流可以引发新的自然语言陈述。

- 检索模型:根据相关性、新近度和重要性,呈现上下文以告知Agents的行为。

- 新近度:最近发生的事件得分较高

- 重要性:区分平凡记忆和核心记忆。直接问LM。

- 相关性:基于它与当前情况/查询的相关程度。

- 反射机制:随着时间的推移将记忆合成更高层次的推论,并指导智能体未来的行为。它们是对过去事件的更高层次的总结(<-注意,这与上面的自我反思有点不同)

- 提示 LM 提供 100 个最新观察结果,并根据这些观测/陈述生成3个最重要的高层次问题。然后让LM回答这些问题。

- 规划与反应:将反思和环境信息转化为行动

图 13. 生成Agents架构。(图片来源:Park 等人,2023)

这种有趣的模拟会产生新兴的社交行为,例如信息传播、关系记忆(例如,两个Agents继续讨论话题)和社交活动的协调(例如举办聚会并邀请许多其他人)。

1.1.3苏格拉底式推理(重点)

「苏格拉底式推理」有5种强大的提示模式:演绎、转换、分解、验证、整合。

![]()

这更多是一种思想

当我提出一个问题"大象喜欢吃什么?"

1.大象是什么? 哪里有大象? 大象应该吃什么?

2.大象是动物 动物园有大象 大象应该吃草

3.你想一想你的回答正确吗

4.A回答 大象喜欢吃草 B回答 大象喜欢吃草 C 大象喜欢吃草

5.整合一下上面的三个答案 大象喜欢吃草

人会疲惫,机器不会

下面最后贴一张自己画的图

![]()

还可以更复杂一点画的太累了 把AI当人看,AI不会疲倦

1.2多智能体框架介绍

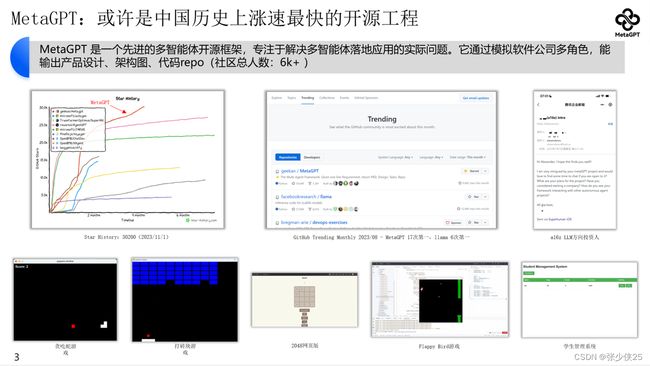

1.2.1什么是MetaGPT

MetaGPT是一个多智能体协作框架,将标准化操作(SOP) 程序编码为提示确保解决问题时采用结构化方法。要求智能体以专家形式参与协作,并按要求生成结构化的输出,例如高质量的需求文档、架构设计图和流程图等。结构化的输出对于单个智能体即是更高层次的思维链(Chain-of-Thought),对于下游角色则是语义清晰、目标明确的上下文(Context)。通过明确定义的角色分工,复杂的工作得以分解为更小、更具体的任务。从而提升了LLMs的输出质量。

主要特点:

- 稳定的解决方案:借助SOP,与其他 Agents 相比,MetaGPT 已被证明可以生成更一致和正确的解决方案。

- 多样化的角色分配:为LLM分配不同角色的能力确保了解决问题的全面性。

在MetaGPT中多智能体 = 智能体+环境+SOP+评审+路由+订阅+经济

- 智能体:在单个智能体的基础上,扩展了多智能体定义。在多智能体系统中,可以由多个单智能体协同工作,每个智能体都具备独特有的LLM、观察、思考、行动和记忆。

- 环境:环境是智能体生存和互动的公共场所。智能体从环境中观察到重要信息,并发布行动的输出结果以供其他智能体使用。

- 标准流程(SOP):这些是管理智能体行动和交互的既定程序,确保系统内部的有序和高效运作。

- **评审:**评审是为了解决幻觉问题。人类的幻觉实际高于大语言模型,但人类已经习惯了幻觉与错误,日常中会通过大量评审来保障复杂工作每一步的可靠性。严谨有效的评审过程能将复杂工作整体的错误率降低90%

- 路由:通信是智能体之间信息交流的过程。它对于系统内的协作、谈判和竞争至关重要。

- **订阅:**需求说了一个制度改革或市场变化,所有人都应该关注/判断影响/修改计划

- 经济:这指的是多智能体环境中的价值交换系统,决定资源分配和任务优先级。

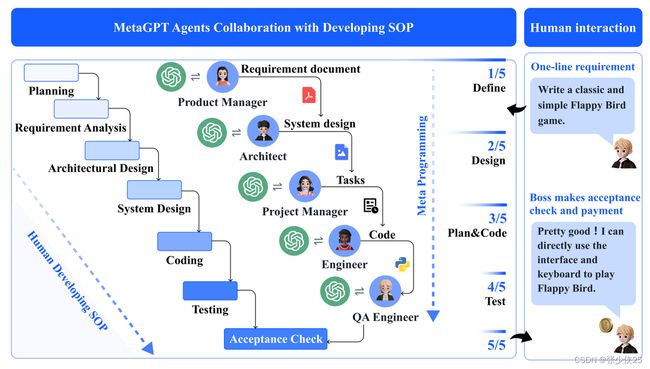

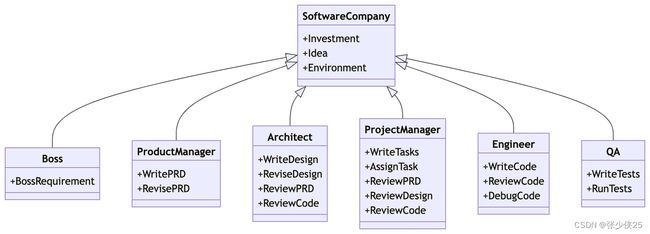

1.2.2经典案例:软件公司

MetaGPT 以一行需求为输入,输出用户故事/竞争分析/需求/数据结构/API/文档等。

在内部,MetaGPT 包括产品经理/架构师/项目经理/工程师。它提供了软件公司的整个过程以及精心编排的 SOP。

- 需求分析:收到需求后,该过程开始。这一阶段致力于明确软件所需的功能和要求。

- 产品经理:产品经理以需求和可行性分析为基础,开启整个流程。他们负责理解需求,并为项目制定明确的方向。

- 架构师:一旦需求明确,架构师将为项目创建技术设计方案。他们负责构建系统接口设计,确保技术实现符合需求。在MetaGPT中,架构 Agent 可以自动生成系统界面设计,如内容推荐引擎的开发。

- 项目经理:项目经理使用序列流程图来满足每个需求。他们确保项目按计划前行,每个阶段都得到适时执行。

- 工程师:工程师负责实际的代码开发。他们使用设计和流程图,将其转化为功能完备的代码。

- 质量保证(QA)工程师:在开发阶段结束后,QA工程师进行全面的测试。他们确保软件符合所需标准,不存在任何错误或问题。

1.2.3更多MetaGPT

详见我们的开源仓库:https://github.com/geekan/MetaGPT/

以及对应文章:ICLR 2024 Oral | MetaGPT: LLM Agent领域第一高分论文,全网Star数最高的多智能体框架

- 现状:MetaGPT目前解决了软件工程的中程任务,让用户不再只是与ChatGPT聊天,而是真正与智能体协作。因此,MetaGPT获得了来自全世界的广泛好评(多天世界第一),也带来了全世界工程师、投资人的诸多关注,吸引了多位顶级贡献者(背景有字节AILab / 叮咚算法 / 小红书算法 / 百度 / MSRA / TikTok / bloomgpt infra / bilibili / CUHK / 港科 / CMU / UCB等背景)

- **目标:**希望能够拓展到任意行业任意天数的任务

- **关键点:**ChatGPT只解决了聊天,并没有解决协作。而智能体可以与人类协作,意味着智能体会成为互联网级别的入口,并且会存在于大量的IM、硬件之中,取代已有的大量SaaS