docker安装Open WebUI详解-遇到的坑OSError: We couldn‘t connect to ‘https://huggingface.co‘ to load this file

一、Open WebUI简介

Open WebUI(https://openwebui.com)是一个用户友好的Web界面,专为本地大语言模型(LLMs)设计。它支持多种模型,包括Ollama和OpenAI兼容的API,并允许用户通过图形界面轻松调试和调用模型。Open WebUI的功能丰富,包括代码高亮、数学公式支持、网页浏览、预设提示词、本地RAG集成、对话标记、模型下载、聊天记录查看以及语音支持等。

二、环境准备

1. 硬件要求

- GPU服务器:由于大模型运算量大,推荐使用配备高性能GPU的服务器。

- 内存与存储:确保服务器有足够的内存和存储空间以支持模型运行和数据存储。

2. 软件环境

- 操作系统:支持Linux、Windows等多种操作系统,但Linux环境通常更为稳定。

- Docker:Open WebUI通过Docker进行部署,因此需要在服务器上安装Docker。

- Node.js(可选):如果需要在本地进行Open WebUI的二次开发,需要安装Node.js。

三、Docker部署Open WebUI

1. 拉取Open WebUI镜像

由于国内网络环境,建议从国内镜像源拉取Open WebUI镜像,以提高下载速度。可以使用如下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v C:\ollama-web-ui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main注意:

C:\ollama-web-ui应替换为实际挂载存储Open WebUI数据的目录路径。

问题:运行了上面的命令还是不能正常访问。看了日志才知道(OSError: We couldn't connect to 'https://huggingface.co' to load this file),原来是open-webui启动时期需要首先在线安装transformers库,但是huggingface.co对于国内来说是经常不可访问):

于是赶紧求助bing,找到一个镜像网站,"hf-mirror.com",于是给docker启动命令中增加一个环境变量"HF_ENDPOINT",经测试完美解决了。后来又想到开始虽然运行镜像启动成功了,但是启动特别慢,2、3分钟服务才能访问,看来也是需要访问huggingface网站的原因。

注意这里设置环境变量HF_ENDPOINT,必须设置为”https://hf-mirror.com“,否则依然会报错,大概是说未知的scheme,我已经趟过这个坑了。完整的命令行如下:

docker run -d -e HF_ENDPOINT=https://hf-mirror.com -p 3000:8080 --add-host=host.docker.internal:host-gateway -v C:\ollama-web-ui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main2. 访问Open WebUI

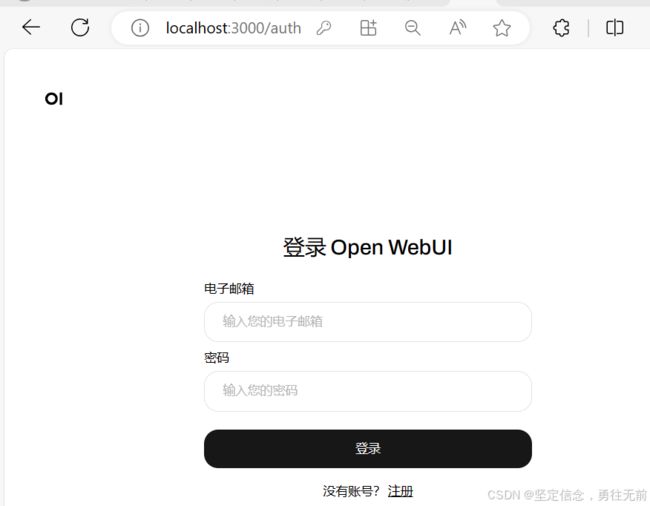

部署完成后,通过浏览器访问http://<服务器IP>:3000即可进入Open WebUI界面。首次访问可能需要注册账号,并配置模型服务的相关信息。

第一次点击注册:可以注册自己账号admin 密码:123456 邮箱: (注意:这个是自己要求注册哈)

四、配置与调试

1. 模型配置

在Open WebUI的设置中,可以配置连接的模型服务。如果模型服务部署在同一台服务器上,可以直接使用localhost和相应的端口号进行连接。如果模型服务部署在远程服务器上,则需要填写相应的IP地址和端口号。

2. 调试与测试

使用Open WebUI提供的界面进行模型测试,观察输出结果是否符合预期。可以通过预设提示词、输入文本等方式与模型进行交互,并根据需要进行参数调整和优化。

五、实际应用

Open WebUI不仅适用于研究和开发阶段,还可以广泛应用于实际场景中,如智能客服、文本创作、知识问答等。通过集成Open WebUI,可以快速构建出功能强大的大模型Web服务,提升用户体验和业务效率。

六、注意事项

- 安全性:确保模型服务的安全性,避免敏感数据泄露。

- 性能优化:根据实际需求调整模型参数和服务器配置,以优化性能。

- 备份与恢复:定期备份模型数据和服务配置,以防数据丢失或损坏。

结语

通过本文的实战指导,相信读者已经掌握了使用Open WebUI部署大模型Web服务的基本步骤和技巧。Open WebUI以其丰富的功能和便捷的操作方式,为开发者提供了强大的支持。希望读者能够在实际应用中充分发挥其优势,创造出更多有价值的应用场景。