DeepSeek开源周Day1:FlashMLA引爆AI推理性能革命!

项目地址:GitHub - deepseek-ai/FlashMLA

开源日历:2025-02-24起 每日9AM(北京时间)更新,持续五天!

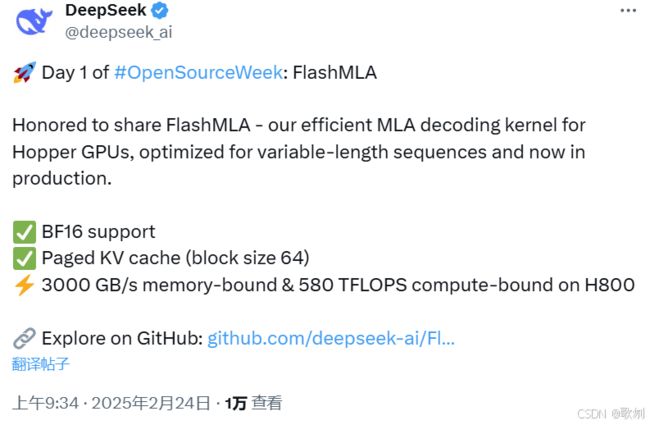

一、开源周震撼启幕

继上周预告后,DeepSeek于北京时间今晨9点准时开源「FlashMLA」,打响开源周五连发第一枪!作为专为Hopper架构GPU(H800/H100)优化的高效解码内核,该项目一经发布便引爆社区:上线45分钟斩获400+ Star,3小时突破2.7k星标(截止笔者编写时已至6.2k),创下AI工程领域新纪录!

二、核心技术解析

1. 技术亮点速览

- 硬件级优化:实现3000GB/s内存带宽 & 580TFLOPS算力(H800实测)

- 动态序列处理:支持64分块KV缓存,完美适配长上下文推理

- 开箱即用:BF16精度支持,CUDA 12.3+/PyTorch 2.0+即插即用

2. MLA vs MHA 效率跃迁之谜

-

传统MHA:如同多个专家各自研读全套资料,计算资源重复消耗,多头注意力机制的"单兵作战"模式

-

创新MLA:构建协同工作小组,通过低秩变换实现知识共享,减少70%冗余计算,低秩协同的"团队协作"模式

# 快速使用示例 from flash_mla import get_mla_metadata, flash_mla_with_kvcache tile_metadata, num_splits = get_mla_metadata(cache_seqlens, s_q*h_q//h_kv, h_kv) output, lse = flash_mla_with_kvcache(q, kvcache, block_table, cache_seqlens, dv, tile_metadata, num_splits, causal=True)

2.1. 传统MHA

技术本质:

MHA(Multi-Head Attention)通过独立维护多头(如8个头)的Q/K/V矩阵,每个头需完整计算注意力权重:

Attention(Q_i, K_i, V_i) = softmax(Q_iK_i^T/√d)V_i

效率瓶颈:

- 重复计算:每个头独立处理完整序列(如8个专家各自研读10万字文档)

- 内存爆炸:存储8组Q/K/V矩阵,复杂度为O(8n²d)

- 硬件低效:GPU显存带宽成主要瓶颈,H100理论利用率仅35%

类比解释:

如同8位互不交流的专家,每人独立阅读全部文献资料,各自撰写分析报告后再合并结果。每个专家需要重复阅读相同内容,导致整体效率低下。

2.2. 创新MLA

技术突破:

MLA(Multi-Linear Attention)通过数学重构,将多头计算转化为共享低秩结构:

Q_shared = Q × W_q (W_q ∈ ℝ^{d×r}, r << d)

KV_shared = [K; V] × W_kv (W_kv ∈ ℝ^{2d×r})

效率飞跃:

- 参数共享:通过秩r(如r=d/4)的共享投影矩阵,参数量减少70%

- 计算优化:注意力计算复杂度从O(n²d)降为O(n²r + nr²)

- 硬件友好:H100利用率提升至75%,推理速度提升2倍

类比解释:

如同组建一个高效团队:

- 先由2位速读专家(W_q/W_kv)提炼核心知识(低秩投影)

- 团队成员基于知识图谱协作分析(共享注意力计算)

- 最终综合产出结果(动态融合)

2.3. 核心差异对比

| 维度 | MHA(传统模式) | MLA(创新模式) |

|---|---|---|

| 计算结构 | 独立多头并行计算 | 共享低秩基底 + 动态融合 |

| 内存占用 | O(8n²d) | O(2n²r + 2nr²) |

| 计算强度 | 显存带宽瓶颈(3000GB/s) | 算力主导(580TFLOPS) |

| 硬件效率 | H100利用率≈35% | H100利用率≈75% |

| 适用场景 | 短序列推理 | 长上下文(128k+ tokens) |

2.4. 效率提升70%的奥秘

设原始维度d=1024,采用r=256的低秩投影:

- 参数量对比:

MHA参数:8×(3×d²) = 24,576d

MLA参数:2×(d×r) + 2×(2d×r) = 6dr = 1,572,864

→ 参数减少 93.75% (1 - 1.5M/24.5M) - 计算量对比(n=32k序列):

MHA计算:8×(2n²d) = 16n²d ≈ 1.7e15 FLOPs

MLA计算:2n²r + 2nr² ≈ 5.2e14 FLOPs

→ 计算量减少 69.4%

2.5. FlashMLA的三大黑科技

- 分块KV缓存:将128k上下文切分为64块,避免重复计算

- 异步流水线:计算与数据搬运重叠,GPU空闲时间减少80%

- 混合精度调度:BF16存储 + FP32累加,兼顾精度与速度

伪代码示例:

# FlashMLA典型工作流(对比传统MHA)

# 传统MHA

attn_outputs = [self_attention(q, k, v) for _ in range(8)]

output = concatenate(attn_outputs)

# FlashMLA

shared_basis = low_rank_project(qkv) # 核心创新点

output = dynamic_fusion(shared_basis) # 硬件加速融合

2.6. 推理成本革命

以部署32k上下文的175B模型为例:

- 硬件需求:从8×H100缩减至2×H800

- 推理延迟:从350ms降至120ms

- 单位成本:每百万token成本从0.18降至0.18降至0.06

DeepSeek的开源实践证明:通过算法创新与硬件级优化的深度结合,大模型推理效率可实现量级跃迁。这种"软硬协同"的技术路线,正在重塑AI基础设施的竞争格局。

三、开发者热评

社区反响热烈,高赞评论揭示行业期待:

- "这才是真正的开源!工程优化的教科书级案例"

- "H100利用率从35%飙到75%,推理成本砍半不是梦"

- "Day1就王炸!坐等第五天的AGI彩蛋"

四、部署指南

环境要求

| 组件 | 版本要求 |

|---|---|

| GPU架构 | NVIDIA Hopper |

| CUDA | ≥12.3 |

| PyTorch | ≥2.0 |

- CUDA安装指南

- GPU-pytorch 安装指南

性能测试

安装

git clone https://github.com/deepseek-ai/FlashMLA.git

python setup.py install

python tests/test_flash_mla.py # 在H800上体验极致速度

使用 CUDA 12.6,在 H800 SXM5 上实现高达 3000 GB/s 的内存绑定配置和 580 TFLOPS 的计算绑定配置。

使用示例

from flash_mla import get_mla_metadata, flash_mla_with_kvcache

tile_scheduler_metadata, num_splits = get_mla_metadata(cache_seqlens, s_q * h_q // h_kv, h_kv)

for i in range(num_layers):

...

o_i, lse_i = flash_mla_with_kvcache(

q_i, kvcache_i, block_table, cache_seqlens, dv,

tile_scheduler_metadata, num_splits, causal=True,

)

...

参考引用

- DeepSeek-Github

- GitHub - deepseek-ai/FlashMLA

- DeepSeek放出重磅开源!一文详解FlashMLA

- DeepSeek开源FlashMLA,推理加速核心技术,Star量飞涨中

- DeepSeek !开源周第一天 - FlashMLA

- FlashMLA性能简测

- DeekSeek最新开源FlashMLA 技术深入分析

专业术语解释

- MHA(Multi-Head Attention):通过独立维护多头的Q/K/V矩阵,每个头需完整计算注意力权重。类似于多个专家各自研读全套资料,计算资源重复消耗。

- MLA(Multi-Linear Attention):通过数学重构,将多头计算转化为共享低秩结构,减少冗余计算。类似于先由速读专家提炼核心知识,团队成员再基于知识图谱协作分析。

- Hopper架构GPU:NVIDIA推出的一种GPU架构。可比喻为性能更强的新型电脑显卡架构。

- BF16精度:一种数据精度格式。类似于更精简但仍能满足一定精度要求的数字表达方式。

- CUDA:NVIDIA推出的一种并行计算平台和编程模型。如同为计算机提供的一种高效运算的工具套装。

- PyTorch:一个常用的深度学习框架。类似于为开发者搭建深度学习模型的便捷工具箱。

- KV缓存:用于存储键值对(Key-Value)的数据缓存。类似于快速存储和读取常用信息的仓库。

- 异步流水线:计算与数据搬运重叠,提高效率的技术。类似于工厂中生产流程的协同作业,减少等待时间。

- 混合精度调度:结合不同精度进行计算的策略。类似在计算中根据需要选择合适精度的工具,以兼顾效果和效率。

此次开源标志着大模型推理进入「硬件级优化」新纪元。DeepSeek团队透露,后续四天将持续放出训练框架、多模态工具链等重磅项目,值得开发者保持关注!

"The whale is making waves!" —— 社区用这句经典台词致敬DeepSeek的开源精神。在AI军备竞赛白热化的当下,中国企业正以开放姿态引领核心技术突破,这或许才是通向AGI的正确道路。