Transposed convolution(2016 IEEE)

| 论文标题 | Fully Convolutional Networks for Semantic Segmentation |

|---|---|

| 论文作者 | Evan Shelhamer, Jonathan Long, Trevor Darrell |

| 发表日期 | 2016年05月01日 |

| GB引用 | > Shelhamer Evan, Long Jonathan, Darrell Trevor. Fully Convolutional Networks for Semantic Segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651. |

| DOI | 10.1109/TPAMI.2016.2572683 |

论文地址:https://arxiv.org/pdf/1605.06211v1

摘要

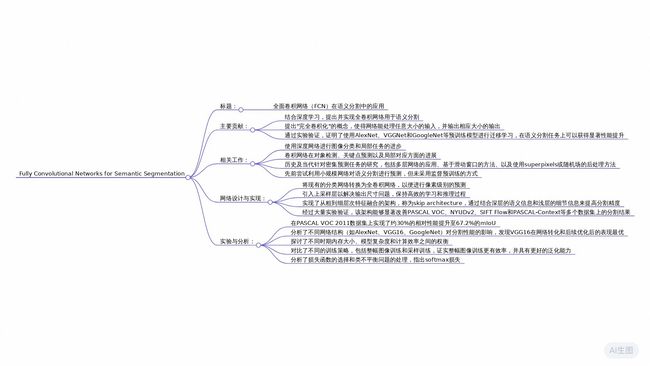

本文提出了一种完全卷积网络(Fully Convolutional Network, FCN),用于像素级别的语义分割任务。研究者们展示了通过端到端训练的卷积网络可以超越之前最好的语义分割结果。关键在于构建“完全卷积”的网络结构,该结构能够处理任意大小的输入并生成相应尺寸的输出,同时保持高效的学习与推理过程。作者们对现有的分类网络(如AlexNet、VGG Net和GoogLeNet)进行了改造,使其成为完全卷积网络,并通过微调将它们的特征表示迁移到分割任务上。此外,还设计了一种跳跃连接架构,结合深层语义信息和浅层外观信息,从而实现精确且详细的分割结果。实验表明,所提出的FCN在PASCAL VOC、NYUDv2等多个数据集上的表现优于现有方法,且推理时间显著缩短。这项工作不仅提升了语义分割的性能,还简化了学习与推理流程。

全文摘要

这篇论文的主题是“全卷积网络(Fully Convolutional Networks, FCNs)在语义分割任务中的应用与改革”。作者 Evan Shelhamer、Jonathan Long 和 Trevor Darrell提出了一种新的网络架构,旨在提升语义分割的准确性,并且与以往的方法相比,它能够直接处理任意大小的输入,并生成相应大小的输出。

论文的主要结论是,FCNs 通过端到端的训练(pixels-to-pixels),在语义分割任务中超越了以往的最佳性能。这一架构的关键在于将传统的卷积神经网络(如AlexNet、VGG Net和GoogLeNet)改造为全卷积形式,能够实现更高效的推理和学习。通过结合“跳跃结构”,FCNs能够从深层次的粗糙特征和浅层的细节特征中提取信息,从而生成更加准确和详细的分割结果。

该论文的独特之处在于,首次实现了全卷积网络的端到端训练,并且利用跳跃连接有效结合了不同层次的信息,提升了网络的表现。实验中,FCNs在PASCAL VOC、NYUDv2、SIFT Flow和PASCAL-Context等数据集上取得了显著的进步,例如在PASCAL VOC 2011数据集上相对提高了30%的均值交并比(mean IU)。同时,其推理速度也大幅提升,典型图像的处理时间仅需0.1秒。

总的来说,这篇论文提供了一种新颖而有效的解法,推动了视觉任务中密集预测的研究,特别是在语义分割领域,为后续的研究奠定了基础,并展示了全卷积网络的广泛适用性。

研究问题

- 如何通过端到端的像素级训练提升语义分割的准确性?

- 在语义分割任务中,如何有效地结合全局语义信息与局部外观信息以提高分割精度?

- 完全卷积网络(FCN)在处理不同尺度输入时,如何平衡特征图的分辨率与计算效率?

- 在完全卷积网络中,跳跃连接(skip connections)的具体作用是什么,以及它们如何改进空间细节的预测?

- 完全卷积网络如何通过上下采样操作实现高效的端到端学习?

- 在语义分割任务中,背景模型是否是必要的,或者分类模型本身是否足以完成任务?

研究方法

实验研究: 通过将经典的分类网络(如AlexNet、VGG net和GoogLeNet)转化为全卷积网络,并利用迁移学习从预训练模型中微调参数,实现端到端的像素级预测。

混合方法研究: 结合深度特征层次结构的不同层信息,通过跳跃连接融合语义信息和外观信息,构建多尺度非线性表示,从而提高分割精度。

模拟研究: 通过在不同分辨率下对真实标签图像进行降采样和升采样,计算不同分辨率下的均交并比(mean IU)上界,验证全卷积网络在粗粒度语义预测上的性能极限。

元分析: 通过对多种网络架构(如FCN-AlexNet、FCN-VGG16和FCN-GoogLeNet)的性能对比分析,评估不同网络在PASCAL VOC等数据集上的表现,同时探索网络设计选择对任务准确性的影响。

纵向研究: 通过分阶段训练(如从FCN-32s到FCN-16s再到FCN-8s),逐步添加跳跃连接并联合优化,观察网络在不同训练阶段的表现变化,验证多流网络结构对分割精度提升的效果。

研究思路

该论文的研究目的是通过全卷积网络(Fully Convolutional Networks, FCNs)来显著提升语义分割任务的准确性。为了达成这一目的,研究人员采取了以下具体步骤和方法:

1. 将分类网络转换为全卷积网络

- 传统分类网络的局限性:传统的卷积神经网络(CNNs)主要用于图像分类任务,其输入尺寸固定,输出为非空间信息(例如类别标签)。这些网络在处理像素级预测任务(如语义分割)时存在局限性,因为它们丢失了空间信息。

- 解决方案:研究人员将现有的分类网络(如AlexNet、VGG、GoogLeNet)转换为全卷积网络(FCNs)。通过将全连接层替换为卷积层,使得网络能够接受任意大小的输入,并生成相应大小的空间输出图。这一步骤使得网络可以直接用于像素级预测任务。

2. 端到端训练

- 直接从监督预训练中微调:与之前的许多工作不同,本文首次尝试对FCNs进行端到端的训练,直接从监督预训练的分类网络中微调以适应语义分割任务。这种方法不仅简化了训练流程,还提高了模型的性能。

- 实验验证:通过实验验证,这种方法在多个数据集上(如PASCAL VOC、NYUDv2、SIFT Flow等)都取得了显著优于之前最佳结果的表现。

3. 结合多层次特征

- 引入跳跃结构(Skip Architecture):为了更好地结合全局语义信息和局部外观信息,研究人员设计了一种跳跃结构,将浅层网络的细粒度特征与深层网络的粗粒度特征结合起来。这种结构可以有效地提高分割结果的细节精度。

- 具体实现:通过在不同层次的特征图之间添加跳跃连接(skip connections),使得网络可以在推理过程中融合来自不同层次的信息。例如,FCN-8s通过结合pool3、pool4和最终层的特征,实现了更精细的分割结果。

4. 优化训练策略

- 在线学习与动量调整:研究人员发现,在线学习(即每次只使用一张图片进行更新)结合高动量(momentum)可以加速收敛并提高模型的准确性。他们通过调整动量和批量大小之间的关系,找到了一种高效的训练策略。

- 损失函数的选择:研究人员选择了像素级别的softmax损失函数来进行训练,这种损失函数能够在不同类别的预测之间引入竞争机制,从而促进更自信的预测。

5. 多模态输入与多任务学习

- RGB-D数据的处理:对于包含深度信息的数据集(如NYUDv2),研究人员探索了多种方式来结合RGB和深度信息。他们发现,通过“晚期融合”(late fusion)的方式,即将RGB和深度信息分别处理后再合并,可以获得最佳效果。

- 多任务学习:在SIFT Flow数据集上,研究人员展示了FCNs可以同时学习多个任务(如语义分割和几何标签预测),并且性能与单独训练的模型相当。

总结

通过上述方法,研究人员成功地解决了语义分割任务中的几个关键问题:

- 输入尺寸的灵活性:FCNs能够处理任意大小的输入图像。

- 端到端的学习:从分类任务直接微调到分割任务,简化了训练流程并提高了性能。

- 结合全局和局部信息:通过跳跃结构,有效地融合了不同层次的特征,提升了分割结果的细节精度。

- 高效的训练策略:通过在线学习和动量调整,加速了模型的收敛速度并提高了最终的准确性。

这些改进使得FCNs在多个基准数据集上的表现超过了之前的最佳结果,并且推理时间大幅缩短。

全卷积网络

每个卷积层的输出是一个大小为 h×w×d 的三维数组,其中 h 和 w 是空间维度,而 d 则是特征或通道维度。第一层是图像,像素尺寸为 h×w,并且有 d 个通道。更高层的位置对应于它们连接到的图像中的位置,这些位置被称为它们的感受野。

卷积神经网络本质上具有平移不变性。它们的基本组成部分(卷积、池化和激活函数)作用于局部输入区域,并且只依赖于相对的空间坐标。将 x i j \mathbf{x}_{ij} xij 表示为特定层中位置 ( i , j ) (i, j) (i,j) 的数据向量,将 y i j \mathbf{y}_{ij} yij 表示为下一层,这些函数通过计算输出 y i j \mathbf{y}_{ij} yij 来实现:

y i j = f k s ( { x s i + δ i , s j + δ j } 0 ≤ δ i , δ j < k ) \mathbf{y}_{ij}=f_{ks}\left(\{\mathbf{x}_{si+\delta i,sj+\delta j}\}_{0\leq\delta i,\delta j