Python开发从入门到精通(下) - 人工智能实战

本书全卷:

Python开发从入门到精通(上) - 基础编程

Python开发从入门到精通(下) - 人工智能实战

全书目录

第一部分:初识Python——从“Hello, World!”开始

第一章:Python的魅力与起源

- 为什么Python这么受欢迎?

- 从蛇到编程语言:Python的成长故事。

- Python和其他语言的对比(Python是如何一鸣惊人的)。

第二章:安装与开发环境配置

- 让Python住进你的电脑:安装与配置指南。

- 理想的开发环境:IDE vs. 代码编辑器的选择。

第三章:基础语法与数据类型

- 你最亲密的伙伴:变量、常量与数据类型。

- 列表、元组、字典:你身边的“智能集合”。

- 数据类型转换:Python是怎样“变魔术”的!

第四章:控制流——让程序像你一样思考

- 判断、循环:让代码在不同情况下做出决策。

- 理解“缩进”魔法:Python如何让你“看得见”代码的逻辑。

第二部分:数据处理与操作——Python与数据的亲密接触

第五章:函数与模块:让代码更有条理

- 函数的定义与调用:让代码更简洁易读。

- 模块与包:如何让你的代码变成一个大“宝藏”。

第六章:字符串与正则表达式:文本背后的艺术

- 字符串的魔法:切片、格式化、操作。

- 正则表达式:如何让Python帮你解锁“隐藏文本”。

第七章:文件操作:你的代码也能“存档”

- 打开、读取与写入文件:如何和文件“亲密接触”。

- CSV、JSON文件:如何让Python帮你整理数据。

第三部分:面向对象编程(OOP)——让代码更“优雅”

第八章:类与对象:用代码创建世界

- 类的定义:给对象们一个家。

- 面向对象的优势:让你的代码有条理、有结构。

第九章:继承与多态:让Python“继承”智慧

- 继承:如何让新类“继承”父类的能力。

- 多态:一个对象多个表现,Python怎么做到的?

第十章:封装与抽象:保护代码的隐私

- 封装:让数据和函数合二为一,保护你的代码隐私。

- 抽象:隐藏复杂性,展示简单易用的接口。

第四部分:高级特性与技巧——让你成为“Python大佬”

第十一章:装饰器与闭包:让Python更具“魔法感”

- 装饰器:如何为现有函数增加功能(不修改原函数!)。

- 闭包:Python是怎么“记住”你的函数的。

第十二章:生成器与迭代器:Python的懒人模式

- 生成器:如何用更少的内存做更多的事。

- 迭代器:一步一步走,获取无限数据。

第十三章:上下文管理器与异常处理:应对突发状况的“万能钥匙”

- 上下文管理器:如何确保资源被安全释放。

- 异常处理:Python如何优雅地应对错误。

第五部分:Python与外部世界的沟通——网络、数据库与Web开发

第十四章:Python与网络:让代码“畅游互联网”

- 网络请求与响应:如何让你的Python和服务器沟通。

- 基础网络协议:HTTP、FTP,Python怎么应对这些?

第十五章:Python与数据库:给数据存个“家”

- 连接数据库:如何让Python和数据库建立联系。

- SQL与ORM:Python如何与数据库高效互动。

第十六章:Web开发:如何用Python做一个简单的Web应用

- Flask与Django:Python的Web开发框架大比拼。

- 搭建一个小网站:用Flask做个“Hello, World!”。

第六部分:Python与数据采集、清洗、搜索——从零开始处理大数据

第十七章:数据采集:用Python做爬虫

- 爬虫入门:如何用Python抓取网页数据

- 动态网页爬取与Selenium

- 反爬虫技术与应对策略

第十八章:数据清洗:让脏数据变得有价值

- 数据预处理:如何清洗和准备数据

- 文本数据清洗:从噪音中提取有用信息

- 如何对数据进行标注与分类

第十九章:数据存储:如何存放和管理大数据

- 使用SQL数据库存储数据

- 向量数据库:如何存储高维数据

- 使用Elasticsearch进行全文搜索

第二十章:搜索引擎与数据索引

- 如何创建一个简易的搜索引擎

- 向量检索与相似度匹配

第七部分:Python在数据科学与人工智能中的应用——你也可以成为“数据科学家”

第二十一章:数据科学入门:Python如何处理大数据

- NumPy与Pandas:让你操作数据如虎添翼。

- 数据清洗与分析:Python如何帮你发现数据背后的“秘密”。

第二十二章:机器学习与人工智能:Python的智能进化

- 使用Scikit-learn做机器学习:让Python为你“预测未来”。

- TensorFlow与PyTorch:Python如何驾驭深度学习。

第八部分:Python人工智能实战——AI的挑战与机遇

第二十三章:深入AI实战:加载与微调预训练模型

- 从TensorFlow到HuggingFace:开源AI模型的加载与微调

- 数据准备与预处理:为微调做好准备

- 模型选择与评估策略

- 微调技巧与最佳实践

- 部署与优化:将模型投入生产环境

第二十四章:计算机视觉(CV)实战

- 如何用Python执行图像识别与处理任务

- 物体检测与语义分割:从YOLO到Mask R-CNN

- 图像增强与数据增广技术

- 实时视频分析与流媒体处理

- 深度学习架构优化与超参数调整

- 高级主题:生成对抗网络(GANs)与自监督学习

第二十五章:自然语言处理(NLP)实战

- 从BERT到GPT:如何处理文本并生成内容

- 文本分类与情感分析

- 命名实体识别(NER)与关系抽取

- 序列标注任务:POS Tagging与Dependency Parsing

- 对话系统与聊天机器人开发

- 机器翻译与跨语言处理

- 实战案例:NLP项目从数据准备到部署上线

第二十六章:多模态模型应用:跨越文本、图像与声音的界限

- 跨模态的AI应用:图像+文本=理解

- 多模态融合方法与策略

- 视觉语言预训练模型:CLIP及其应用

- 基于多模态数据的生成任务

- 音频与视觉信息的联合处理

- 实战案例:构建一个简单的多模态交互系统

第二十七章:AI模型的部署与上线

- 从训练到生产:如何将AI模型部署为Web服务

- 模型优化与加速:提高推理效率

- 容器化与微服务架构

- 监控与维护:确保服务的稳定性和可靠性

- 安全考量与隐私保护

- 实战案例:从训练到部署一个安全的AI服务

第二十八章:AI项目中的常见问题与挑战

- 模型过拟合、数据不均衡问题的解决

- 数据质量问题及其改进策略

- 特征工程的重要性与实践技巧

- 模型解释性与可解释AI(XAI)

- 性能瓶颈分析与优化

- 道德伦理与法律合规考量

第二十九章:实践项目:打造一个AI助手

- 从零到一:开发一个人工智能助手

- 对话管理系统的设计与实现

- 自然语言处理模块的集成与优化

- 用户界面与交互体验设计

- 部署与持续改进:让AI助手上线并不断进化

第九部分:Python的最佳实践——代码优化与项目管理

第三十章:编写高效代码:Python如何跑得更快

- 时间复杂度与空间复杂度:如何用Python写出“高效代码”。

- 性能调优与内存管理:如何让Python为你“省心”。

第三十一章:代码的可维护性:如何写出“别人看得懂”的代码

- 良好的代码风格:PEP8标准与代码重构。

- 单元测试与调试技巧:如何让你的代码无懈可击。

第三十二章:项目管理与部署:将代码推向“实战”

- 使用Git进行版本控制与团队协作。

- 部署Python应用:如何把代码变成实际可用的应用。

附录部分:Python开发的实用资源

-

常见Python库与框架

-

Python工具链与开发环境

-

开源预训练模型的资源库

-

AI与深度学习领域的重要论文与研究资源

-

Python开发者社区与学习资源

-

Python开发中的调试工具与技巧

第七部分:Python在数据科学与人工智能中的应用——你也可以成为“数据科学家”

第二十一章:数据科学入门:Python如何处理大数据

- NumPy与Pandas:让你操作数据如虎添翼。

- 数据清洗与分析:Python如何帮你发现数据背后的“秘密”。

21.1 NumPy与Pandas:让你操作数据如虎添翼

欢迎来到“数据科学”的魔法世界!在当今这个数据驱动的时代,数据科学就像是一位能够从海量数据中提取有价值信息的“数据魔法师”。Python作为数据科学领域中最受欢迎的编程语言,提供了强大的工具和库来帮助你处理和分析大数据。今天,我们将深入探讨Python中两个最重要的数据处理库——NumPy和Pandas,看看它们如何让你在数据处理的旅程中如虎添翼。

21.1.1 NumPy:Python中的数值计算基石

NumPy(Numerical Python)是Python中用于科学计算的基础库,提供了支持多维数组和矩阵运算的功能,以及大量的数学函数库。NumPy是许多其他数据科学库(如Pandas、SciPy、Matplotlib等)的基础。

21.1.1.1 NumPy的主要特点

1. 多维数组对象(ndarray):

NumPy的核心是ndarray对象,它是一个具有固定大小和相同数据类型的多维数组。

示例:

import numpy as np

# 创建一个一维数组

array_1d = np.array([1, 2, 3, 4, 5])

print(array_1d) # 输出: [1 2 3 4 5]

# 创建一个二维数组

array_2d = np.array([[1, 2, 3], [4, 5, 6]])

print(array_2d)

# 输出:

# [[1 2 3]

# [4 5 6]]

2. 广播机制:

NumPy支持广播机制,允许不同形状的数组进行算术运算。

示例:

a = np.array([1, 2, 3])

b = 2

c = a * b

print(c) # 输出: [2 4 6]

3. 丰富的数学函数:dddd

NumPy提供了大量的数学函数,如sin、cos、exp、log等。

示例:

a = np.array([0, np.pi/2, np.pi])

print(np.sin(a)) # 输出: [0.0000000e+00 1.0000000e+00 1.2246468e-16]

4. 线性代数运算:

NumPy支持矩阵运算,如矩阵乘法、矩阵转置、逆矩阵等。

示例:

A = np.array([[1, 2], [3, 4]])

B = np.array([[5, 6], [7, 8]])

C = np.dot(A, B)

print(C)

# 输出:

# [[19 22]

# [43 50]]

21.1.1.2 NumPy的优势

- 高性能:

- NumPy的底层实现是用C语言编写的,具有很高的计算性能。

- 内存效率:

- NumPy数组在内存中是连续存储的,节省内存空间。

- 丰富的功能:

- NumPy提供了大量的函数和工具,适用于各种科学计算任务。

21.1.2 Pandas:Python中的数据处理利器

Pandas是Python中用于数据分析和数据处理的强大库,提供了DataFrame和Series两种主要的数据结构。Pandas建立在NumPy之上,提供了更高级的数据操作功能。

21.1.2.1 Pandas的主要特点

1. DataFrame:

DataFrame是Pandas的核心数据结构,是一个类似于电子表格的二维表,具有行和列标签。

示例:

import pandas as pd

data = {

'姓名': ['张三', '李四', '王五'],

'年龄': [25, 30, 22],

'城市': ['北京', '上海', '广州']

}

df = pd.DataFrame(data)

print(df)

输出:

姓名 年龄 城市

0 张三 25 北京

1 李四 30 上海

2 王五 22 广州

2. Series:

Series是Pandas的一维数组结构,类似于列表,但具有标签。

示例:

s = pd.Series([1, 2, 3, 4], index=['a', 'b', 'c', 'd'])

print(s)

输出:

a 1

b 2

c 3

d 4

dtype: int64

3. 数据清洗与处理:

Pandas提供了丰富的数据清洗和处理功能,如缺失值处理、数据过滤、数据聚合等。

示例:

# 填充缺失值

df['年龄'].fillna(df['年龄'].mean(), inplace=True)

# 数据过滤

df_filtered = df[df['年龄'] > 23]

# 数据聚合

df_grouped = df.groupby('城市').agg({'年龄': 'mean'})

4. 数据导入与导出:

Pandas支持多种数据格式的导入和导出,如CSV、Excel、SQL数据库等。

示例:

# 导入CSV文件

df = pd.read_csv('data.csv')

# 导出到Excel

df.to_excel('output.xlsx', index=False)

21.1.2.2 Pandas的优势

- 易于使用:

- Pandas的API设计简洁,易于学习和使用。

- 强大的数据处理能力:

- Pandas提供了丰富的数据操作功能,适用于各种数据处理任务。

- 高效的数据分析:

- Pandas支持快速的数据分析和探索性数据分析(EDA)。

21.1.3 小结:数据科学的魔法工具

通过本节,你已经学习了NumPy和Pandas的基本概念和功能,就像掌握了“数据科学”的魔法工具。NumPy和Pandas是Python数据科学领域中最基础和最重要的库,它们提供了强大的数据处理和分析功能。希望你能灵活运用这些“魔法工具”,让你的数据处理和分析工作更加高效和高效,为编写更强大的数据科学程序打下坚实的基础。

21.2 数据清洗与分析:Python如何帮你发现数据背后的“秘密”

欢迎来到“数据洞察”的魔法实验室!在数据科学的世界中,数据清洗和数据分析就像是魔法师用来揭示数据背后隐藏信息的“魔法工具”。通过数据清洗,你可以去除数据中的噪音和错误,而数据分析则帮助你从数据中提取有价值的见解和模式。今天,我们将深入探讨如何使用Python进行数据清洗和分析,以及如何利用这些技术来发现数据背后的“秘密”。

21.2.1 数据清洗:去除噪音,净化数据

数据清洗是数据分析的第一步,旨在识别和纠正数据中的错误、不一致和缺失值。就像魔法师在施展魔法前需要净化魔法材料一样,数据清洗可以确保你的数据质量,从而提高分析结果的准确性。

21.2.1.1 处理缺失值

缺失值是数据集中常见的“噪音”,需要进行处理。

删除缺失值:

- 如果缺失值较少,可以选择删除包含缺失值的行或列。

示例:

import pandas as pd

df = pd.read_csv('data.csv')

df_cleaned = df.dropna()

填充缺失值:

- 使用均值、中位数、众数或插值法填充缺失值。

示例:

df['age'].fillna(df['age'].mean(), inplace=True)

21.2.1.2 处理重复数据

重复数据会干扰分析结果,需要进行去重处理。

示例:

df.drop_duplicates(inplace=True)

21.2.1.3 处理异常值

异常值是指数据集中与其他数据点显著不同的值,可能影响分析结果。

识别异常值:

- 使用统计方法(如IQR方法)或可视化方法(如箱形图)识别异常值。

示例:

Q1 = df['salary'].quantile(0.25)

Q3 = df['salary'].quantile(0.75)

IQR = Q3 - Q1

outliers = df[((df['salary'] < (Q1 - 1.5 * IQR)) | (df['salary'] > (Q3 + 1.5 * IQR)))]

处理异常值:

- 删除异常值或使用合理值进行替换。

示例:

df = df[~((df['salary'] < (Q1 - 1.5 * IQR)) | (df['salary'] > (Q3 + 1.5 * IQR)))]

21.2.1.4 数据转换

数据转换涉及将数据从一种格式转换为另一种格式,以满足分析需求。

标准化和归一化:

- 将数据缩放到特定范围(如0到1)或标准化为均值为0、标准差为1。

示例:

from sklearn.preprocessing import StandardScaler, MinMaxScaler

scaler = StandardScaler()

df['age_scaled'] = scaler.fit_transform(df[['age']])

scaler = MinMaxScaler()

df['salary_normalized'] = scaler.fit_transform(df[['salary']])

编码分类数据:

- 将分类变量转换为数值形式,如使用独热编码(One-Hot Encoding)或标签编码(Label Encoding)。

示例:

df = pd.get_dummies(df, columns=['gender', 'country'])

21.2.2 数据分析:揭示数据背后的“秘密”

数据分析是数据科学的核心,旨在从数据中提取有价值的见解和模式。通过数据分析,你可以发现数据中的趋势、关系和异常,从而为决策提供支持。

21.2.2.1 描述性统计分析

描述性统计分析用于总结和描述数据集的基本特征。

常用指标:

- 均值(Mean)、中位数(Median)、众数(Mode)。

- 标准差(Standard Deviation)、方差(Variance)。

- 范围(Range)、四分位数(Quartiles)。

示例:

import pandas as pd

df = pd.read_csv('data.csv')

print(df.describe())

21.2.2.2 可视化分析

可视化分析通过图表和图形来展示数据,帮助识别趋势和模式。

常用图表:

- 柱状图(Bar Chart)、折线图(Line Chart)、饼图(Pie Chart)。

- 散点图(Scatter Plot)、箱形图(Box Plot)、直方图(Histogram)。

示例:

import matplotlib.pyplot as plt

import seaborn as sns

sns.histplot(df['age'], kde=True)

plt.title('Age Distribution')

plt.xlabel('Age')

plt.ylabel('Frequency')

plt.show()

21.2.2.3 相关性分析

相关性分析用于衡量两个变量之间的线性关系。

相关系数:

- 皮尔逊相关系数(Pearson Correlation Coefficient)、斯皮尔曼相关系数(Spearman Correlation Coefficient)。

示例:

correlation_matrix = df.corr()

print(correlation_matrix)

21.2.2.4 回归分析

回归分析用于建模和分析变量之间的关系。

线性回归:

- 建模两个变量之间的线性关系。

示例:

from sklearn.linear_model import LinearRegression

X = df[['age']]

y = df['salary']

model = LinearRegression()

model.fit(X, y)

predictions = model.predict(X)

21.2.2.5 机器学习

机器学习算法可以用于更复杂的分析和预测任务。

示例:

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

X = df[['age', 'income']]

y = df['purchase']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

model = RandomForestClassifier()

model.fit(X_train, y_train)

predictions = model.predict(X_test)

21.2.3 小结:数据清洗与分析的魔法

通过本节,你已经学习了数据清洗和分析的基本概念和方法,就像掌握了“数据洞察”的魔法技巧。数据清洗和分析是数据科学中至关重要的一环,它们可以帮助你从数据中提取有价值的见解和模式。希望你能灵活运用这些“数据洞察魔法”,让你的数据分析工作更加高效和准确,为编写更强大的数据科学程序打下坚实的基础。

第二十二章:机器学习与人工智能:Python的智能进化

- 使用Scikit-learn做机器学习:让Python为你“预测未来”。

- TensorFlow与PyTorch:Python如何驾驭深度学习。

22.1 使用Scikit-learn做机器学习:让Python为你“预测未来”

欢迎来到“智能预测”的魔法课堂!在人工智能和机器学习的世界里,预测未来不再只是科幻小说中的情节。通过机器学习,我们可以让计算机从数据中学习模式,并利用这些模式进行预测和决策。而Scikit-learn是Python中最受欢迎的机器学习库之一,它提供了简单而强大的工具来实现各种机器学习任务。今天,我们将深入探讨如何使用Scikit-learn进行机器学习,让Python为你“预测未来”。

22.1.1 什么是机器学习?

机器学习是人工智能的一个分支,它通过算法和统计模型使计算机能够从数据中学习,并在没有明确编程指令的情况下进行预测和决策。机器学习可以分为以下几类:

1. 监督学习(Supervised Learning):

- 使用带标签的数据进行训练,目标是预测新数据的标签。

示例:分类(预测离散标签,如垃圾邮件检测)、回归(预测连续值,如房价预测)。

2. 无监督学习(Unsupervised Learning):

- 使用无标签的数据进行训练,目标是发现数据中的模式和结构。

示例:聚类(将数据分组,如客户细分)、降维(减少数据维度,如PCA)。

3. 半监督学习(Semi-supervised Learning):

- 结合少量带标签数据和大量无标签数据进行训练。

4. 强化学习(Reinforcement Learning):

- 通过与环境的交互进行学习,目标是最大化累积奖励。

示例:游戏AI、机器人控制。

22.1.2 Scikit-learn简介

Scikit-learn(也称为sklearn)是一个开源的Python机器学习库,提供了简单而高效的工具来实现数据挖掘和分析。它建立在NumPy、SciPy和Matplotlib之上,提供了广泛的机器学习算法和工具。

22.1.2.1 Scikit-learn的主要特点

1. 简洁的API:

Scikit-learn的API设计简洁,易于学习和使用。

示例:

from sklearn.linear_model import LogisticRegression

model = LogisticRegression()

model.fit(X_train, y_train)

predictions = model.predict(X_test)

2. 丰富的算法:

提供了多种监督学习和无监督学习算法,如线性回归、逻辑回归、决策树、支持向量机(SVM)、K近邻(KNN)、聚类算法等。

3. 数据预处理工具:

提供了丰富的数据预处理工具,如标准化、归一化、编码分类变量等。

4. 模型评估与选择:

提供了多种模型评估指标和交叉验证工具,帮助选择最佳模型。

5. 管道(Pipeline):

支持将多个步骤(如预处理、模型训练)组合成一个管道,简化工作流程。

22.1.3 使用Scikit-learn进行机器学习的基本步骤

22.1.3.1 数据准备

首先,需要准备用于训练和测试的数据集。

示例:

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

22.1.3.2 数据预处理

对数据进行预处理,如标准化、归一化、编码分类变量等。

示例:

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

22.1.3.3 选择模型

选择合适的机器学习模型进行训练。

示例:

from sklearn.linear_model import LogisticRegression

model = LogisticRegression()

22.1.3.4 模型训练

使用训练数据对模型进行训练。

示例:

model.fit(X_train_scaled, y_train)

22.1.3.5 模型评估

使用测试数据评估模型的性能。

示例:

from sklearn.metrics import accuracy_score, classification_report

predictions = model.predict(X_test_scaled)

print(f"准确率: {accuracy_score(y_test, predictions)}")

print(f"分类报告:\n{classification_report(y_test, predictions)}")

22.1.3.6 模型预测

使用训练好的模型对新数据进行预测。

示例:

new_data = [[5.1, 3.5, 1.4, 0.2]]

new_data_scaled = scaler.transform(new_data)

prediction = model.predict(new_data_scaled)

print(f"预测结果: {prediction}")

22.1.4 示例:使用Scikit-learn进行鸢尾花分类

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score, classification_report

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 数据预处理

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

# 选择模型并训练

model = LogisticRegression()

model.fit(X_train_scaled, y_train)

# 模型评估

predictions = model.predict(X_test_scaled)

print(f"准确率: {accuracy_score(y_test, predictions)}")

print(f"分类报告:\n{classification_report(y_test, predictions)}")

# 预测新数据

new_data = [[5.1, 3.5, 1.4, 0.2]]

new_data_scaled = scaler.transform(new_data)

prediction = model.predict(new_data_scaled)

print(f"预测结果: {prediction}")

22.1.5 小结:机器学习的魔法

通过本节,你已经学习了如何使用Scikit-learn进行机器学习,就像掌握了“智能预测”的魔法技巧。机器学习是人工智能的重要组成部分,它可以帮助我们从数据中提取有价值的信息,并进行预测和决策。希望你能灵活运用这些“机器学习魔法”,让你的Python程序能够智能地分析和预测,为编写更强大的数据科学和人工智能应用打下坚实的基础。

22.2 TensorFlow与PyTorch:Python如何驾驭深度学习

欢迎来到“深度学习”的魔法殿堂!在人工智能的快速发展中,深度学习已经成为推动技术进步的核心力量。深度学习通过模拟人脑的神经网络结构,能够处理复杂的任务,如图像识别、自然语言处理、语音识别等。而TensorFlow和PyTorch是Python中最受欢迎的深度学习框架,它们各自拥有独特的优势和广泛的应用场景。今天,我们将深入探讨这两个框架,看看它们如何帮助Python驾驭深度学习。

22.2.1 什么是深度学习?

深度学习是机器学习的一个子领域,它使用多层神经网络来模拟人脑的工作方式,从而实现对复杂数据的自动特征提取和模式识别。深度学习模型通常具有多个隐藏层,能够学习到数据中的高层次抽象特征。

比喻:如果机器学习是一个魔法师学习基础魔法咒语,那么深度学习就是学习更复杂、更强大的魔法组合。

22.2.2 TensorFlow:深度学习的“瑞士军刀”

TensorFlow是由Google开发的开源深度学习框架,广泛应用于研究和生产环境。它提供了丰富的工具和库,支持从构建模型到部署的整个流程。

22.2.2.1 TensorFlow的主要特点

1. 灵活性高:

- TensorFlow支持多种编程范式,如符号式编程和命令式编程。

- 比喻:就像一个多功能的魔法工具箱,可以根据需要选择不同的工具。

2. 强大的计算图:

- TensorFlow使用计算图(Computational Graph)来表示和执行计算,适合大规模分布式训练。

- 示例:

import tensorflow as tf # 定义计算图 a = tf.constant(2) b = tf.constant(3) c = a + b print(c) # 输出: Tensor("add:0", shape=(), dtype=int32) # 执行计算图 with tf.compat.v1.Session() as sess: print(sess.run(c)) # 输出: 5

3. 丰富的预训练模型:

- TensorFlow Hub提供了大量预训练的模型,如BERT、ResNet等,方便快速构建应用。

4. 生产环境支持:

- TensorFlow Extended(TFX)提供了从数据准备到模型部署的完整生产环境支持。

5. 广泛的社区和文档:

- TensorFlow拥有庞大的社区和丰富的文档资源,方便学习和解决问题。

22.2.2.2 TensorFlow的应用场景

-

大规模深度学习模型训练:

- TensorFlow适合训练复杂的深度学习模型,如卷积神经网络(CNN)、循环神经网络(RNN)等。

-

生产环境部署:

- TensorFlow提供了强大的部署工具,适合将模型部署到服务器、移动设备、嵌入式系统等。

-

研究与应用开发:

- TensorFlow广泛应用于学术研究和工业应用,如自动驾驶、医疗影像分析等。

22.2.3 PyTorch:深度学习的“动态魔法师”

PyTorch是由Facebook开发的开源深度学习框架,以其动态计算图和易用性而闻名。PyTorch在研究和快速原型开发中非常受欢迎。

22.2.3.1 PyTorch的主要特点

1. 动态计算图:

- PyTorch使用动态计算图(Dynamic Computational Graph),允许在运行时定义和修改计算图,适合快速迭代和调试。

- 比喻:就像一个可以随时调整的魔法卷轴,开发者可以灵活地修改和优化模型。

2. 易于调试:

- 由于其动态特性,PyTorch的调试体验更接近于传统的Python编程,易于使用Python调试工具。

3. 广泛的社区和库支持:

- PyTorch拥有庞大的社区和丰富的第三方库,如torchvision、torchtext等,方便快速构建应用。

4. 易用性高:

- PyTorch的API设计简洁,易于学习和使用,适合快速原型开发和研究。

22.2.3.2 PyTorch的应用场景

-

研究和快速原型开发:

- PyTorch适合进行深度学习研究、快速迭代和模型验证。

-

自然语言处理(NLP):

- PyTorch在NLP领域应用广泛,许多先进的模型(如BERT、GPT)都是基于PyTorch实现的。

-

计算机视觉:

- PyTorch也广泛应用于计算机视觉任务,如图像分类、目标检测、图像生成等。

22.2.4 TensorFlow vs. PyTorch:如何选择?

| 特性 | TensorFlow | PyTorch |

|---|---|---|

| 计算图 | 静态计算图(默认),支持动态图(TensorFlow 2.x) | 动态计算图 |

| 易用性 | 中,需要学习计算图的概念 | 高,接近传统Python编程 |

| 性能 | 高,适合大规模分布式训练 | 高,适合快速迭代和调试 |

| 生态系统 | 丰富,TensorFlow Hub、TFX等 | 丰富,torchvision、torchtext等 |

| 社区支持 | 庞大,Google支持 | 庞大,Facebook支持 |

| 应用场景 | 大规模模型训练、生产环境部署 | 研究、快速原型开发 |

22.2.5 小结:深度学习的魔法工具

通过本节,你已经了解了TensorFlow和PyTorch的特点和适用场景,就像掌握了“深度学习”的魔法工具。TensorFlow和PyTorch都是强大的深度学习框架,各有其独特的优势:

- TensorFlow适合大规模模型训练和生产环境部署,拥有丰富的工具和库。

- PyTorch适合研究和快速原型开发,以其动态计算图和易用性著称。

希望你能根据项目需求和个人偏好选择合适的框架,灵活运用这些“深度学习魔法”,让你的Python程序能够驾驭深度学习,为编写更强大的智能应用打下坚实的基础。

第八部分:Python人工智能实战——AI的挑战与机遇

第二十三章:深入AI实战:加载与微调预训练模型

- 从TensorFlow到HuggingFace:开源AI模型的加载与微调

- 数据准备与预处理:为微调做好准备

- 模型选择与评估策略

- 微调技巧与最佳实践

- 部署与优化:将模型投入生产环境

23.1 从TensorFlow到HuggingFace:开源AI模型的加载与微调

欢迎来到“AI实战”的魔法实验室!在人工智能领域,预训练模型就像是一位已经掌握了大量知识和技能的“魔法学徒”。通过加载和微调这些预训练模型,你可以利用它们已经学到的知识,快速构建和优化自己的AI应用。今天,我们将深入探讨如何从TensorFlow到Hugging Face,加载并微调开源的AI模型,让你的Python程序变得更加智能和强大。

23.1.1 什么是预训练模型?

预训练模型是指已经在大量数据上训练好的机器学习或深度学习模型。这些模型通常在大规模数据集(如ImageNet、Wikitext等)上训练,学习到了丰富的特征和模式。通过加载预训练模型,你可以节省大量的训练时间和计算资源,并利用其已经学到的知识来加速你的AI应用开发。

比喻:如果AI模型是一个学徒,那么预训练模型就是一个已经完成了基础训练的学徒,你可以直接让它学习更高级的技能。

注意:加载大模型,进行预训练和推理需要高级 GPU,在普通计算机上可能无法正常运行。可以适当选择蒸馏后的小参数模型继续开发测试验证。

23.1.2 TensorFlow Hub:TensorFlow的模型库

TensorFlow Hub是一个由Google维护的模型库,提供了大量预训练的TensorFlow模型,涵盖图像、文本、音频等多种数据类型。

23.1.2.1 加载预训练模型

使用TensorFlow Hub加载预训练模型非常简单。

示例:加载预训练的文本嵌入模型

import tensorflow as tf

import tensorflow_hub as hub

# 加载预训练的文本嵌入模型

embed = hub.load("https://tfhub.dev/google/universal-sentence-encoder/4")

# 使用模型进行文本嵌入

sentences = ["你好,世界!", "TensorFlow Hub is great."]

embeddings = embed(sentences)

print(embeddings)

23.1.2.2 微调预训练模型

微调是指在特定任务的数据集上对预训练模型进行进一步的训练,以适应特定的应用需求。

示例:微调预训练的图像分类模型

import tensorflow as tf

import tensorflow_hub as hub

# 加载预训练的图像分类模型

model = tf.keras.Sequential([

hub.KerasLayer("https://tfhub.dev/google/imagenet/mobilenet_v2_100_224/feature_vector/5",

trainable=True), # 设置trainable=True以微调模型

tf.keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 假设train_data和test_data是已经准备好的数据集

model.fit(train_data, epochs=5)

model.evaluate(test_data)

23.1.3 Hugging Face Transformers:深度学习模型的宝库

Hugging Face Transformers是一个由Hugging Face维护的开源库,提供了大量预训练的深度学习模型,涵盖自然语言处理(NLP)、计算机视觉(CV)等领域。

23.1.3.1 加载预训练模型

Hugging Face Transformers提供了简单易用的API来加载和微调预训练模型。

示例:加载预训练的BERT模型进行文本分类

from transformers import BertTokenizer, TFBertForSequenceClassification

import tensorflow as tf

# 加载预训练的BERT tokenizer和模型

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = TFBertForSequenceClassification.from_pretrained('bert-base-uncased')

# 准备数据

sentences = ["Hello, world!", "TensorFlow is awesome."]

labels = [1, 0]

# 编码输入

encodings = tokenizer(sentences, truncation=True, padding=True, return_tensors='tf')

# 训练模型

train_dataset = tf.data.Dataset.from_tensor_slices((

dict(encodings),

labels

)).shuffle(100).batch(32)

model.compile(optimizer='adam',

loss=model.compute_loss, # 使用模型自带的损失函数

metrics=['accuracy'])

model.fit(train_dataset, epochs=3)

23.1.3.2 微调预训练模型

微调预训练模型可以显著提高特定任务的性能。

示例:微调BERT模型进行情感分析

from transformers import BertTokenizer, TFBertForSequenceClassification

import tensorflow as tf

# 加载预训练的BERT tokenizer和模型

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = TFBertForSequenceClassification.from_pretrained('bert-base-uncased', num_labels=2)

# 准备数据

train_encodings = tokenizer(train_texts, truncation=True, padding=True, return_tensors='tf')

train_labels = tf.constant(train_labels)

# 创建数据集

train_dataset = tf.data.Dataset.from_tensor_slices((

dict(train_encodings),

train_labels

)).shuffle(1000).batch(32)

# 编译模型

model.compile(optimizer='adam',

loss=model.compute_loss,

metrics=['accuracy'])

# 训练模型

model.fit(train_dataset, epochs=3)

23.1.3.3 使用预训练模型进行预测

加载和微调后的模型可以用于对新数据进行预测。

示例:使用微调的BERT模型进行预测

import tensorflow as tf

# 准备新数据

new_sentences = ["I love Python!", "I hate bugs."]

new_encodings = tokenizer(new_sentences, truncation=True, padding=True, return_tensors='tf')

# 进行预测

predictions = model.predict(dict(new_encodings))

predicted_labels = tf.argmax(predictions.logits, axis=1)

print(predicted_labels)

大模型开发电脑配置对比表(报价参考2025年)

| 类别 | CPU | GPU | RAM | 存储 | 价格范围 | 参数规模 | 备注 |

|---|---|---|---|---|---|---|---|

| 2万内 | AMD Ryzen 7 5800X | RTX 3060 | 32GB | 1TB NVMe SSD | 约1.2-1.5万 | 小至中等(约1亿-10亿参数) | 良好的性价比,适合初学者及小规模实验 |

| Intel i5-12600KF | RTX 3060 Ti | 32GB | 1TB NVMe SSD | 约1.3-1.6万 | 中等(约1亿-15亿参数) | 更强的CPU性能,适合复杂任务 | |

| AMD Ryzen 5 5600X | RTX 3070 | 32GB | 1TB NVMe SSD | 约1.4-1.7万 | 中等至较大(约5亿-20亿参数) | 强大的多任务处理能力 | |

| Intel i7-12700KF | RTX 3070 Ti | 64GB | 1TB NVMe SSD | 约1.6-1.9万 | 较大(约10亿-30亿参数) | 适用于更复杂的模型微调 | |

| 2万以上 | AMD Ryzen 9 7900X | RTX 4080 | 64GB | 2TB NVMe SSD | >2万 | 大(约20亿-50亿参数) | 高端选择,适用于大规模数据集 |

| Intel i9-13900KF | RTX 4090 | 128GB | 2TB NVMe SSD | >2.5万 | 极大(约50亿参数及以上) | 极致性能,适合专业研究 | |

| AMD Threadripper PRO 3955WX | A6000 | 128GB | 4TB NVMe SSD | >3万 | 巨型(超过50亿参数) | 顶级工作站级别,适合高级研究 | |

| 云服务器 | AWS EC2 p4d.24xlarge | NVIDIA A100*8 | 根据需求定制 | EBS或S3存储 | 按需计费 | 可扩展(支持超大规模模型) | 高灵活性,适合临时高性能需求 |

| Google Cloud TPU v4 | TPU Pods | 根据需求定制 | 根据需求定制 | 按需计费 | 专为深度学习优化 | 特别适合需要TPU加速的任务 | |

| Azure NC A100 v4 Series | A100*4 | 根据需求定制 | 根据需求定制 | 按需计费 | 高效且灵活 | 提供强大的GPU支持 |

推荐说明:

-

1万到2万元区间:这类配置适合大多数学生使用,可以满足基础的模型微调和推理需求。对于预训练来说,可能更适合较小规模的模型或是在现有基础上进行改进。

-

2万元以上区间:这些高端配置能够支持更大规模的数据集和更复杂的模型架构,非常适合需要进行大量实验的研究人员。特别是对于那些涉及大规模数据集和高维度模型的研究项目,这样的硬件配置是非常必要的。

-

云服务器:如果你的研究工作具有高度的不确定性和波动性,或者你需要访问特别强大的计算资源来进行短期的高强度计算任务,那么租用云服务是一个非常理想的选择。它允许你根据实际需求动态调整资源配置,并且无需担心硬件维护问题。

23.1.4 小结:AI实战的魔法

通过本节,你已经学习了如何加载和微调预训练模型,就像掌握了“AI实战”的魔法技巧。预训练模型是构建强大AI应用的重要工具,它们可以为你节省大量的时间和计算资源,并提供强大的功能。希望你能灵活运用这些“AI实战魔法”,让你的Python程序变得更加智能和强大,为编写更先进的AI应用打下坚实的基础。

23.2 数据准备与预处理:为微调做好准备

在人工智能模型的微调过程中,数据准备与预处理是至关重要的一环。它不仅决定了模型能否有效学习到目标任务的特征,还直接影响最终的性能和泛化能力。以下,我们将深入探讨数据准备与预处理的各个环节,并结合实际案例,展示如何为预训练模型的微调做好充分准备。

23.2.1. 数据收集与选择

数据是AI模型的燃料,没有高质量的数据,模型的表现将大打折扣。在进行微调之前,我们需要收集与目标任务相关的数据。这些数据应具备以下特点:

- 相关性:数据应与目标任务高度相关。例如,如果我们要微调一个用于情感分析的情感模型,数据应包含丰富的情感表达。

- 多样性:数据应涵盖各种可能的场景和情况,以增强模型的泛化能力。

- 规模:数据量应足够大,以避免过拟合。通常,微调所需的数据量比从头训练模型要少,但仍然需要一定的规模。

案例:假设我们要微调一个用于医疗文本分类的模型,我们需要收集包含各种医疗术语、疾病描述和治疗方案的文本数据。

数据收集与选择的Python实现

在人工智能模型的微调过程中,数据收集与选择是奠定成功基础的关键步骤。数据质量直接影响模型的性能,因此我们需要谨慎地选择和收集数据。以下将详细讲解数据收集与选择的过程,并结合Python代码示例,展示如何高效地进行数据收集与选择。

23.2.1.1. 数据收集

数据收集是指从各种来源获取与目标任务相关的数据。数据来源可以是公开数据集、API、网页爬取、数据库等。以下是几种常见的数据收集方法:

23.2.1.1.1 使用公开数据集

许多组织和机构提供了丰富的公开数据集,可以直接下载使用。例如:

- Kaggle:提供大量开源数据集,涵盖各种领域。

- UCI Machine Learning Repository:提供各种经典数据集。

- HuggingFace Datasets:提供多种NLP相关的数据集。

示例:使用HuggingFace Datasets加载公开数据集

from datasets import load_dataset

# 加载IMDB电影评论数据集

dataset = load_dataset('imdb')

# 查看数据集结构

print(dataset)

23.2.1.1.2 使用API获取数据

许多网站和服务提供了API接口,可以通过编程方式获取数据。例如,使用Twitter API获取推文数据。

示例:使用Tweepy库获取Twitter数据

import tweepy

# 认证信息(需要申请Twitter开发者账号)

API_KEY = 'your_api_key'

API_SECRET = 'your_api_secret'

ACCESS_TOKEN = 'your_access_token'

ACCESS_SECRET = 'your_access_secret'

# 认证

auth = tweepy.OAuth1UserHandler(API_KEY, API_SECRET, ACCESS_TOKEN, ACCESS_SECRET)

api = tweepy.API(auth)

# 获取推文

query = '人工智能'

tweets = api.search_tweets(q=query, lang='zh', count=100)

# 提取推文文本

tweet_texts = [tweet.text for tweet in tweets]

23.2.1.1.3 网页爬取

对于没有提供API的数据,可以通过网页爬取获取数据。需要注意的是,爬取数据时应遵守网站的robots.txt协议和相关法律法规。

示例:使用BeautifulSoup库爬取网页数据

import requests

from bs4 import BeautifulSoup

# 目标网页URL

url = 'https://example.com/articles'

# 发送请求

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

# 提取文章标题和链接

articles = []

for article in soup.find_all('article'):

title = article.find('h2').text

link = article.find('a')['href']

articles.append({'title': title, 'link': link})

print(articles)

23.2.1.1.4 数据库查询

如果数据存储在数据库中,可以使用SQL查询语句获取数据。

示例:使用SQLAlchemy库连接数据库并查询数据

from sqlalchemy import create_engine

# 创建数据库引擎

engine = create_engine('mysql+pymysql://user:password@localhost:3306/database')

# 执行查询

query = "SELECT * FROM articles WHERE category = '人工智能'"

results = engine.execute(query).fetchall()

# 提取数据

articles = []

for row in results:

articles.append({'id': row[0], 'title': row[1], 'content': row[2]})

print(articles)

23.2.1.2. 数据选择

数据选择是指从收集到的数据中筛选出与目标任务相关的数据。以下是几种常见的数据选择方法:

23.2.1.2.1 基于关键词筛选

通过关键词匹配筛选出相关的数据。

示例:使用关键词筛选推文

# 关键词列表

keywords = ['人工智能', '机器学习', '深度学习']

# 筛选推文

filtered_tweets = [tweet for tweet in tweet_texts if any(keyword in tweet for keyword in keywords)]

print(filtered_tweets)

23.2.1.2.2 基于主题模型筛选

使用主题模型(如LDA)将数据划分为不同主题,然后选择与目标任务相关的主题。

示例:使用Gensim库进行主题建模

from gensim import corpora, models

# 文本预处理

texts = [tweet.split() for tweet in filtered_tweets]

# 创建词典

dictionary = corpora.Dictionary(texts)

# 生成语料库

corpus = [dictionary.doc2bow(text) for text in texts]

# 训练LDA模型

lda_model = models.LdaModel(corpus, num_topics=5, id2word=dictionary, passes=10)

# 选择与人工智能相关的主题

relevant_topic = lda_model.print_topics(num_topics=5, num_words=5)

print(relevant_topic)

23.2.1.2.3 基于情感分析筛选

对于需要特定情感倾向的数据,可以使用情感分析模型进行筛选。

示例:使用TextBlob库进行情感分析

from textblob import TextBlob

# 情感分析函数

def get_sentiment(text):

return TextBlob(text).sentiment.polarity

# 筛选正面情感的推文

positive_tweets = [tweet for tweet in filtered_tweets if get_sentiment(tweet) > 0.5]

print(positive_tweets)

23.2.1.3. 数据清洗与预处理

在数据选择之后,需要对数据进行清洗与预处理,包括去除噪声、标准化文本、去除停用词等。

示例:使用NLTK库进行文本预处理

import nltk

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

# 下载所需资源

nltk.download('stopwords')

nltk.download('wordnet')

# 初始化分词器和词形还原器

lemmatizer = WordNetLemmatizer()

stop_words = set(stopwords.words('english'))

# 文本预处理函数

def preprocess(text):

# 分词

tokens = nltk.word_tokenize(text)

# 去除停用词和标点符号

tokens = [token for token in tokens if token.isalnum()]

# 去除停用词

tokens = [token for token in tokens if token not in stop_words]

# 词形还原

tokens = [lemmatizer.lemmatize(token) for token in tokens]

return ' '.join(tokens)

# 应用预处理

cleaned_tweets = [preprocess(tweet) for tweet in positive_tweets]

print(cleaned_tweets)

23.2.1.4. 数据存储

最后,将清洗和预处理后的数据存储起来,以便后续使用。可以使用CSV、JSON、数据库等方式存储。

示例:使用Pandas库将数据存储为CSV文件

import pandas as pd

# 创建DataFrame

df = pd.DataFrame(cleaned_tweets, columns=['text'])

# 存储为CSV文件

df.to_csv('filtered_tweets.csv', index=False)

通过本小节:数据收集与选择 的学习,您将能够掌握数据收集与选择的关键步骤,并将其应用于AI模型的微调实战中。Python提供了丰富的库和工具,可以大大简化数据收集与选择的过程,提高工作效率。在实际应用中,选择合适的数据收集方法和预处理技术,是确保模型性能的关键。

23.2.2. 数据清洗

数据清洗是去除数据中噪声和不相关信息的步骤。以下是一些常见的数据清洗操作:

- 去除无关字符:如HTML标签、特殊符号等。

- 处理缺失值:填补或删除缺失的数据。

- 标准化文本:统一文本的格式,如将所有文本转换为小写,去除多余的空格等。

案例:在医疗文本中,可能存在大量的缩写和术语,需要进行标准化处理。例如,将“COVID-19”统一为“COVID”。

数据清洗的Python实现

数据清洗是数据预处理过程中至关重要的一步,旨在提高数据质量,确保模型能够从数据中学习到有用的信息。数据清洗涉及识别和纠正(或删除)数据中的错误、不一致和噪声。以下将详细讲解数据清洗的各个环节,并结合Python代码示例,展示如何高效地进行数据清洗。

23.2.2.1. 数据清洗的主要步骤

23.2.2.1.1 处理缺失值

缺失值是指数据集中某些字段为空或不存在的情况。处理缺失值的方法包括:

- 删除缺失值:如果缺失值比例较小,可以直接删除包含缺失值的记录。

- 填补缺失值:使用统计方法(如均值、中位数、众数)或机器学习方法填补缺失值。

示例:使用Pandas处理缺失值

import pandas as pd

# 读取数据

df = pd.read_csv('data.csv')

# 查看缺失值情况

print(df.isnull().sum())

# 删除包含缺失值的行

df_cleaned = df.dropna()

# 或者,用列的均值填补数值型缺失值

df['age'].fillna(df['age'].mean(), inplace=True)

# 用众数填补分类变量

df['gender'].fillna(df['gender'].mode()[0], inplace=True)

23.2.2.1.2 处理重复数据

重复数据是指数据集中存在完全相同或几乎相同的记录。处理重复数据的方法包括:

- 删除重复记录:使用Pandas的

drop_duplicates()方法删除重复行。

示例:删除重复数据

# 删除完全重复的行

df_cleaned = df.drop_duplicates()

# 删除基于特定列的重复行,例如基于'name'和'email'列

df_cleaned = df.drop_duplicates(subset=['name', 'email'])

23.2.2.1.3 处理异常值

异常值是指数据集中与大多数数据点显著不同的值。处理异常值的方法包括:

- 删除异常值:如果异常值是由于数据录入错误或测量错误导致的,可以直接删除。

- 修正异常值:使用统计方法(如Z-score、IQR)识别并修正异常值。

示例:使用Z-score方法识别并删除异常值

from scipy import stats

import numpy as np

# 计算Z-score

df['z_score'] = np.abs(stats.zscore(df['age']))

# 删除Z-score大于3的行

df_cleaned = df[df['z_score'] < 3]

# 删除辅助列

df_cleaned = df_cleaned.drop(columns=['z_score'])

23.2.2.1.4 标准化文本数据

文本数据通常包含大小写不一致、标点符号、特殊字符等问题。标准化文本数据的方法包括:

- 统一大小写:将所有文本转换为小写或大写。

- 去除标点符号和特殊字符:使用正则表达式去除不需要的字符。

- 去除停用词:去除常见的无意义词汇(如“的”、“是”等)。

示例:使用NLTK和正则表达式进行文本清洗

import re

import nltk

from nltk.corpus import stopwords

# 下载停用词

nltk.download('stopwords')

stop_words = set(stopwords.words('chinese'))

# 文本清洗函数

def clean_text(text):

# 转为小写

text = text.lower()

# 去除数字和特殊字符

text = re.sub(r'[^a-zA-Z\u4e00-\u9fa5]', ' ', text)

# 去除多余空格

text = re.sub(r'\s+', ' ', text).strip()

# 去除停用词

tokens = text.split()

tokens = [word for word in tokens if word not in stop_words]

return ' '.join(tokens)

# 应用清洗函数

df['clean_text'] = df['text'].apply(clean_text)

23.2.2.1.5 去除HTML标签

如果数据中包含HTML内容,需要去除HTML标签以获取纯文本。

示例:使用BeautifulSoup去除HTML标签

from bs4 import BeautifulSoup

# 去除HTML标签函数

def remove_html(text):

soup = BeautifulSoup(text, "html.parser")

return soup.get_text()

# 应用函数

df['clean_text'] = df['text'].apply(remove_html)

23.2.2.1.6 编码与解码

处理文本数据时,可能需要进行编码转换。例如,将UTF-8编码转换为GBK编码,或反之。

示例:编码转换

# 将文本转换为UTF-8编码

df['text'] = df['text'].apply(lambda x: x.encode('utf-8').decode('utf-8'))

# 将文本转换为GBK编码

df['text'] = df['text'].apply(lambda x: x.encode('gbk', errors='ignore').decode('gbk', errors='ignore'))

23.2.2.2. 综合示例

以下是一个综合的数据清洗示例,涵盖了缺失值处理、重复数据删除、异常值处理和文本标准化。

import pandas as pd

import re

import nltk

from nltk.corpus import stopwords

from scipy import stats

import numpy as np

from bs4 import BeautifulSoup

# 下载停用词

nltk.download('stopwords')

stop_words = set(stopwords.words('chinese'))

# 读取数据

df = pd.read_csv('data.csv')

# 1. 处理缺失值

df['age'].fillna(df['age'].mean(), inplace=True)

df['gender'].fillna(df['gender'].mode()[0], inplace=True)

# 2. 删除重复数据

df_cleaned = df.drop_duplicates()

# 3. 处理异常值

df_cleaned['z_score'] = np.abs(stats.zscore(df_cleaned['age']))

df_cleaned = df_cleaned[df_cleaned['z_score'] < 3]

df_cleaned = df_cleaned.drop(columns=['z_score'])

# 4. 去除HTML标签

df_cleaned['clean_text'] = df_cleaned['text'].apply(remove_html)

# 5. 标准化文本数据

def clean_text(text):

# 转为小写

text = text.lower()

# 去除数字和特殊字符

text = re.sub(r'[^a-zA-Z\u4e00-\u9fa5]', ' ', text)

# 去除多余空格

text = re.sub(r'\s+', ' ', text).strip()

# 去除停用词

tokens = text.split()

tokens = [word for word in tokens if word not in stop_words]

return ' '.join(tokens)

df_cleaned['clean_text'] = df_cleaned['clean_text'].apply(clean_text)

# 6. 编码转换(如果需要)

df_cleaned['clean_text'] = df_cleaned['clean_text'].apply(lambda x: x.encode('utf-8').decode('utf-8'))

# 保存清洗后的数据

df_cleaned.to_csv('cleaned_data.csv', index=False)

数据清洗是数据预处理的核心环节,直接影响模型的学习效果和最终性能。通过系统化的数据清洗步骤,包括处理缺失值、删除重复数据、处理异常值、标准化文本数据等,可以显著提高数据质量,为后续的模型训练和评估打下坚实的基础。Python提供了丰富的库和工具,如Pandas、NLTK、BeautifulSoup等,可以简化数据清洗过程,提高工作效率。通过本章的学习,您将能够掌握数据清洗的关键步骤,并将其应用于AI模型的微调实战中,确保数据的高质量和一致性,从而提升模型的性能和可靠性。

23.2.3. 数据标注

对于监督学习任务,数据标注是必不可少的步骤。标注的质量直接影响模型的性能。以下是一些常见的标注方法:

- 人工标注:由专家或标注人员手动标注数据。这种方法质量高,但成本高且耗时。

- 半自动标注:结合人工和自动方法进行标注。例如,使用预训练模型进行初步标注,再由人工进行校正。

- 自动标注:使用现有的规则或模型进行自动标注。这种方法速度快,但可能引入误差。

案例:在医疗文本分类中,我们需要标注每条文本所属的疾病类别。可以使用半自动方法,先使用预训练模型进行初步分类,再由医学专家进行校正。

数据标注的Python实现

数据标注是将原始数据转换为机器学习模型可理解的形式的过程。对于监督学习任务,标注数据是必不可少的步骤。数据标注的质量直接影响模型的性能,因此需要谨慎对待。以下将详细讲解数据标注的各个环节,并结合Python代码示例,展示如何高效地进行数据标注。

23.2.3.1. 数据标注的主要类型

根据任务的不同,数据标注可以分为以下几种主要类型:

23.2.3.1.1 分类标注

分类标注是指将数据分配到预定义的类别中。例如,情感分析中将文本分为正面、负面或中性。

示例:文本情感分类

import pandas as pd

# 读取数据

df = pd.read_csv('tweets.csv')

# 假设我们有一个简单的规则来标注情感

def label_sentiment(text):

if 'happy' in text or 'joy' in text:

return 'positive'

elif 'sad' in text or 'angry' in text:

return 'negative'

else:

return 'neutral'

# 应用标注函数

df['sentiment'] = df['text'].apply(label_sentiment)

print(df.head())

23.2.3.1.2 命名实体识别(NER)

命名实体识别是指识别文本中的实体,如人名、地名、组织机构等。

示例:使用spaCy进行NER标注

import spacy

# 加载预训练的spaCy模型

nlp = spacy.load('zh_core_web_sm')

# 读取数据

df = pd.read_csv('articles.csv')

# 定义NER函数

def extract_entities(text):

doc = nlp(text)

entities = [(ent.text, ent.label_) for ent in doc.ents]

return entities

# 应用NER函数

df['entities'] = df['text'].apply(extract_entities)

print(df.head())

23.2.3.1.3 问答标注

问答标注是指为给定的问题提供相应的答案,常用于问答系统。

示例:简单的问答对标注

import pandas as pd

# 创建问答对数据

data = {

'question': [

'中国的首都是哪里?',

'人工智能的定义是什么?',

'Python的作者是谁?'

],

'answer': [

'北京',

'人工智能是计算机科学的一个分支,涉及使机器能够执行通常需要人类智能的任务。',

'Guido van Rossum'

]

}

df = pd.DataFrame(data)

print(df)

23.2.3.1.4 序列标注

序列标注是指对序列中的每个元素进行标注,常用于词性标注、句法分析等。

示例:使用spaCy进行词性标注

import spacy

# 加载预训练的spaCy模型

nlp = spacy.load('zh_core_web_sm')

# 读取数据

df = pd.read_csv('sentences.csv')

# 定义词性标注函数

def pos_tagging(text):

doc = nlp(text)

return [(token.text, token.pos_) for token in doc]

# 应用词性标注函数

df['pos_tags'] = df['sentence'].apply(pos_tagging)

print(df.head())

23.2.3.2. 数据标注的方法

23.2.3.2.1 人工标注

人工标注是指由人工对数据进行标注。这种方法可以获得高质量的标注数据,但成本高且耗时。

示例:人工标注情感分析数据

import pandas as pd

# 读取数据

df = pd.read_csv('tweets.csv')

# 人工标注函数

def manual_label(text):

# 这里可以添加人工标注的逻辑,例如通过GUI界面进行标注

# 这里为了示例,假设我们有一个简单的规则

if 'happy' in text or 'joy' in text:

return 'positive'

elif 'sad' in text or 'angry' in text:

return 'negative'

else:

return 'neutral'

# 应用人工标注函数

df['sentiment'] = df['text'].apply(manual_label)

print(df.head())

23.2.3.2.2 半自动标注

半自动标注是指结合人工和自动方法进行标注。例如,使用预训练模型进行初步标注,再由人工进行校正。

示例:使用预训练模型进行半自动情感分析标注

import pandas as pd

from textblob import TextBlob

# 读取数据

df = pd.read_csv('tweets.csv')

# 定义半自动标注函数

def semi_automatic_label(text):

blob = TextBlob(text)

polarity = blob.sentiment.polarity

if polarity > 0.1:

return 'positive'

elif polarity < -0.1:

return 'negative'

else:

return 'neutral'

# 应用半自动标注函数

df['sentiment'] = df['text'].apply(semi_automatic_label)

# 人工校正(假设我们有一个校正函数)

def manual_correction(text, label):

# 这里可以添加人工校正的逻辑

return label

# 应用人工校正

df['sentiment'] = df.apply(lambda row: manual_correction(row['text'], row['sentiment']), axis=1)

print(df.head())

23.2.3.2.3 自动标注

自动标注是指使用现有的规则或模型进行自动标注。这种方法速度快,但可能引入误差。

示例:使用规则进行自动情感分析标注

import pandas as pd

# 读取数据

df = pd.read_csv('tweets.csv')

# 定义自动标注函数

def automatic_label(text):

if 'happy' in text or 'joy' in text:

return 'positive'

elif 'sad' in text or 'angry' in text:

return 'negative'

else:

return 'neutral'

# 应用自动标注函数

df['sentiment'] = df['text'].apply(automatic_label)

print(df.head())

23.2.3.3. 数据标注工具

有许多开源和商业的数据标注工具可以帮助简化标注过程:

23.2.3.3.1 LabelImg

LabelImg是一个开源的图像标注工具,支持多种格式的标注。

官网:GitHub - HumanSignal/labelImg

23.2.3.3.2 Prodigy

Prodigy是一个由Explosion开发的商业数据标注工具,支持文本、图像等多种类型的标注。

官网:Prodigy · An annotation tool for AI, Machine Learning & NLP

23.2.3.3.3 BRAT

BRAT是一个开源的文本标注工具,支持多种类型的文本标注任务。

官网:brat rapid annotation tool

23.2.3.3.4 Snorkel

Snorkel是一个用于弱监督学习的工具,可以帮助生成标注数据。

官网:Snorkel

23.2.3.4. 数据标注的最佳实践

- 一致性:确保标注标准的一致性,避免不同标注者之间的差异。

- 标注指南:制定详细的标注指南,明确标注标准和流程。

- 质量控制:定期进行质量检查,确保标注数据的准确性。

- 迭代优化:根据模型反馈,不断优化标注标准和流程。

23.2.3.5 数据标注小结

数据标注是数据预处理的重要环节,直接影响模型的学习效果和最终性能。通过系统化的数据标注步骤,包括分类标注、命名实体识别、问答标注、序列标注等,可以为模型提供高质量的标注数据。Python提供了丰富的库和工具,如spaCy、TextBlob等,可以简化数据标注过程,提高工作效率。通过本章的学习,您将能够掌握数据标注的关键步骤,并将其应用于AI模型的微调实战中,确保数据的高质量和一致性,从而提升模型的性能和可靠性。

23.2.4. 数据分割

为了评估模型的性能,我们需要将数据划分为训练集、验证集和测试集:

- 训练集:用于模型训练。

- 验证集:用于模型调优和超参数选择。

- 测试集:用于最终的性能评估。

常见的分割比例为70%训练集、15%验证集和15%测试集,但具体比例应根据数据量和任务需求进行调整。

案例:在医疗文本分类中,我们可以将收集到的数据按比例分割为训练集、验证集和测试集,以确保模型的泛化能力。

数据分割的Python实现

数据分割是数据预处理中的关键步骤,旨在将整个数据集划分为不同的子集,以便在模型训练、调优和评估过程中使用。合理的数据分割可以有效评估模型的泛化能力,避免过拟合并确保模型的可靠性。以下将详细讲解数据分割的各个环节,并结合Python代码示例,展示如何高效地进行数据分割。

23.2.4.1. 数据分割的主要类型

根据模型训练和评估的需求,数据分割通常包括以下几种主要类型:

23.2.4.1.1 训练集(Training Set)

训练集用于模型的训练过程。模型通过学习训练集中的数据来调整其参数,以最小化预测误差。

23.2.4.1.2 验证集(Validation Set)

验证集用于在训练过程中评估模型的性能,调整模型的超参数(如学习率、模型复杂度等),以防止过拟合并优化模型性能。

23.2.4.1.3 测试集(Test Set)

测试集用于最终评估模型的泛化能力,确保模型在未见过的数据上也能表现良好。测试集应与训练集和验证集完全独立。

23.2.4.2. 数据分割的比例

数据分割的比例可以根据数据集的大小和任务的复杂性进行调整。以下是一些常见的分割比例:

- 小型数据集(如几百到几千条数据):通常采用70%训练集,15%验证集,15%测试集。

- 中型数据集(如几千到几万条数据):通常采用80%训练集,10%验证集,10%测试集。

- 大型数据集(如几十万到几百万条数据):可以减少验证集和测试集的比例,如98%训练集,1%验证集,1%测试集。

注意:具体比例应根据数据集的大小和任务的复杂性进行调整。

23.2.4.1.3. 数据分割的方法

23.2.4.1.3.1 随机分割

随机分割是指将数据集随机划分为训练集、验证集和测试集。这种方法适用于数据分布较为均匀的情况。

示例:使用Scikit-learn进行随机分割

import pandas as pd

from sklearn.model_selection import train_test_split

# 读取数据

df = pd.read_csv('data.csv')

# 假设我们要分割的特征和标签

X = df['text']

y = df['label']

# 第一次分割:训练集和临时集(验证集+测试集)

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.3, random_state=42)

# 第二次分割:验证集和测试集

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, random_state=42)

print(f'Training set size: {X_train.shape[0]}')

print(f'Validation set size: {X_val.shape[0]}')

print(f'Test set size: {X_test.shape[0]}')

23.2.4.1.3.2 分层分割

分层分割是指在分割时保持数据集中各个类别的比例不变。这对于类别不平衡的数据集尤为重要。

示例:使用Scikit-learn进行分层分割

import pandas as pd

from sklearn.model_selection import train_test_split

# 读取数据

df = pd.read_csv('data.csv')

# 假设我们要分割的特征和标签

X = df['text']

y = df['label']

# 第一次分割:训练集和临时集(验证集+测试集)

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.3, stratify=y, random_state=42)

# 第二次分割:验证集和测试集

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, stratify=y_temp, random_state=42)

print(f'Training set size: {X_train.shape[0]}')

print(f'Validation set size: {X_val.shape[0]}')

print(f'Test set size: {X_test.shape[0]}')

23.2.4.1.3.3 时间序列分割

对于时间序列数据,传统的随机分割方法可能会导致数据泄漏。因此,需要按照时间顺序进行分割。

示例:时间序列数据分割

import pandas as pd

# 读取时间序列数据

df = pd.read_csv('time_series_data.csv', parse_dates=['date'])

# 按日期排序

df = df.sort_values('date')

# 假设我们按80%训练,10%验证,10%测试分割

train_end = int(0.8 * len(df))

val_end = int(0.9 * len(df))

train_df = df[:train_end]

val_df = df[train_end:val_end]

test_df = df[val_end:]

print(f'Training set size: {len(train_df)}')

print(f'Validation set size: {len(val_df)}')

print(f'Test set size: {len(test_df)}')

23.2.4.1.4. 数据分割的注意事项

23.2.4.1.4.1 数据泄漏

数据泄漏是指在模型训练过程中使用了不应该使用的信息,导致模型性能虚高。为避免数据泄漏,应确保:

- 训练集、验证集和测试集完全独立。

- 在分割数据后再进行特征工程,避免在训练过程中使用验证集或测试集的信息。

23.2.4.1.4.2 类别不平衡

对于类别不平衡的数据集,应使用分层分割方法,以确保各个类别在训练集、验证集和测试集中的比例一致。

23.2.4.1.4.3 数据量

对于小数据集,过小的验证集和测试集可能导致评估结果不稳定。可以考虑使用交叉验证方法,如K折交叉验证。

示例:使用K折交叉验证

import pandas as pd

from sklearn.model_selection import KFold

# 读取数据

df = pd.read_csv('data.csv')

# 假设我们要分割的特征和标签

X = df['text']

y = df['label']

# 初始化K折交叉验证

kf = KFold(n_splits=5, shuffle=True, random_state=42)

for train_index, val_index in kf.split(X):

X_train, X_val = X[train_index], X[val_index]

y_train, y_val = y[train_index], y[val_index]

# 在这里可以进行模型训练和评估

print(f'Training set size: {len(X_train)}')

print(f'Validation set size: {len(X_val)}')

23.2.4.1.5. 综合示例

以下是一个综合的数据分割示例,涵盖了随机分割、分层分割和时间序列分割。

import pandas as pd

from sklearn.model_selection import train_test_split, KFold

# 读取数据

df = pd.read_csv('data.csv')

# 1. 随机分割

X = df['text']

y = df['label']

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.3, random_state=42)

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, random_state=42)

print('随机分割结果:')

print(f'Training set size: {X_train.shape[0]}')

print(f'Validation set size: {X_val.shape[0]}')

print(f'Test set size: {X_test.shape[0]}')

# 2. 分层分割

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.3, stratify=y, random_state=42)

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.5, stratify=y_temp, random_state=42)

print('分层分割结果:')

print(f'Training set size: {X_train.shape[0]}')

print(f'Validation set size: {X_val.shape[0]}')

print(f'Test set size: {X_test.shape[0]}')

# 3. 时间序列分割

df_sorted = df.sort_values('date')

train_end = int(0.8 * len(df_sorted))

val_end = int(0.9 * len(df_sorted))

train_df = df_sorted[:train_end]

val_df = df_sorted[train_end:val_end]

test_df = df_sorted[val_end:]

print('时间序列分割结果:')

print(f'Training set size: {len(train_df)}')

print(f'Validation set size: {len(val_df)}')

print(f'Test set size: {len(test_df)}')

23.2.4.1.6. 总结

数据分割是数据预处理的重要环节,直接影响模型的训练和评估效果。通过合理的数据分割方法,如随机分割、分层分割和时间序列分割,可以有效评估模型的泛化能力,确保模型在未见过的数据上也能表现良好。Python提供了丰富的库和工具,如Scikit-learn,可以简化数据分割过程,提高工作效率。

23.2.5. 数据增强

数据增强是通过对现有数据进行变换,生成新的训练样本的方法。常见的数据增强技术包括:

- 文本替换:使用同义词或近义词替换文本中的某些词语。

- 随机删除:随机删除文本中的某些词语。

- 句子重组:重新排列句子的顺序。

- 回译:将文本翻译成另一种语言,再翻译回原语言。

案例:在医疗文本中,可以通过同义词替换来生成新的训练样本。例如,将“发热”替换为“高烧”。

数据增强:详细讲解与Python实现

数据增强(Data Augmentation)是提高模型泛化能力的重要技术,尤其在数据量有限或类别不平衡的情况下,数据增强可以显著提升模型的性能。数据增强通过对现有数据进行各种变换,生成新的训练样本,从而增加数据的多样性。以下将详细讲解数据增强的各个环节,并结合Python代码示例,展示如何高效地进行数据增强。

23.2.5.1. 数据增强的主要类型

根据任务的不同,数据增强可以分为以下几种主要类型:

23.2.5.1.1 文本数据增强

对于自然语言处理(NLP)任务,文本数据增强可以通过以下方法实现:

- 同义词替换:将文本中的某些词语替换为它们的同义词。

- 随机插入:在文本中随机插入一些词语。

- 随机删除:随机删除文本中的某些词语。

- 句子重组:重新排列句子的顺序。

- 回译:将文本翻译成另一种语言,再翻译回原语言。

示例:使用NLPAug库进行文本数据增强

import nlpaug.augmenter.word as naw

# 初始化同义词替换增强器

aug = naw.SynonymAug(aug_min=1, aug_max=3, aug_p=0.3, lang='zh')

# 原始文本

text = '人工智能是计算机科学的一个分支,涉及使机器能够执行通常需要人类智能的任务。'

# 生成增强文本

augmented_text = aug.augment(text)

print(augmented_text)

23.2.5.1.2 图像数据增强

对于计算机视觉任务,图像数据增强可以通过以下方法实现:

- 旋转:将图像旋转一定角度。

- 缩放:对图像进行缩放。

- 翻转:水平或垂直翻转图像。

- 裁剪:随机裁剪图像的一部分。

- 颜色抖动:改变图像的亮度、对比度、饱和度等。

示例:使用Albumentations库进行图像数据增强

import albumentations as A

from PIL import Image

import matplotlib.pyplot as plt

# 读取图像

image = Image.open('image.jpg')

image = np.array(image)

# 定义增强变换

transform = A.Compose([

A.Rotate(limit=40, p=1),

A.RandomBrightnessContrast(p=0.2),

A.HorizontalFlip(p=0.5),

])

# 应用增强变换

augmented_image = transform(image=image)['image']

# 显示原图和增强图

plt.subplot(1, 2, 1)

plt.imshow(image)

plt.title('Original Image')

plt.subplot(1, 2, 2)

plt.imshow(augmented_image)

plt.title('Augmented Image')

plt.show()

23.2.5.1.3 音频数据增强

对于音频处理任务,音频数据增强可以通过以下方法实现:

- 音量调整:改变音频的音量。

- 添加噪声:向音频中添加背景噪声。

- 时间拉伸:改变音频的播放速度。

- 音调变换:改变音频的音调。

示例:使用librosa库进行音频数据增强

import librosa

import numpy as np

import matplotlib.pyplot as plt

# 读取音频文件

y, sr = librosa.load('audio.wav')

# 定义增强函数

def augment_audio(y, sr):

# 音量调整

y_aug = y * 1.5 # 增加音量

# 添加噪声

noise = np.random.randn(len(y))

y_aug += 0.005 * noise

# 时间拉伸

y_aug = librosa.effects.time_stretch(y_aug, rate=1.2)

return y_aug

# 生成增强音频

y_aug = augment_audio(y, sr)

# 绘制波形图

plt.subplot(2, 1, 1)

librosa.display.waveplot(y, sr=sr)

plt.title('Original Audio')

plt.subplot(2, 1, 2)

librosa.display.waveplot(y_aug, sr=sr)

plt.title('Augmented Audio')

plt.show()

23.2.5.2. 数据增强的最佳实践

- 多样性:使用多种增强方法,以增加数据的多样性。

- 适度性:避免过度增强,导致数据失真或引入噪声。

- 一致性:确保增强后的数据与原始数据在分布上保持一致。

- 验证:在验证集和测试集上验证增强方法的效果,避免对模型性能产生负面影响。

23.2.5.3. 数据增强的应用场景

- 数据量有限:当训练数据量较少时,数据增强可以有效增加数据量,提升模型性能。

- 类别不平衡:对于类别不平衡的数据集,可以通过数据增强增加少数类别的样本数量,改善模型对少数类别的识别能力。

- 提高泛化能力:数据增强可以增加数据的多样性,帮助模型学习到更丰富的特征,提高泛化能力。

23.2.5.4. 综合示例

以下是一个综合的数据增强示例,涵盖了文本和图像数据的增强。

import nlpaug.augmenter.word as naw

import albumentations as A

from PIL import Image

import matplotlib.pyplot as plt

import numpy as np

# 1. 文本数据增强

# 初始化同义词替换增强器

text_aug = naw.SynonymAug(aug_min=1, aug_max=3, aug_p=0.3, lang='zh')

# 原始文本

text = '人工智能是计算机科学的一个分支,涉及使机器能够执行通常需要人类智能的任务。'

# 生成增强文本

augmented_text = text_aug.augment(text)

print('原始文本:', text)

print('增强文本:', augmented_text)

# 2. 图像数据增强

# 读取图像

image = Image.open('image.jpg')

image = np.array(image)

# 定义增强变换

transform = A.Compose([

A.Rotate(limit=40, p=1),

A.RandomBrightnessContrast(p=0.2),

A.HorizontalFlip(p=0.5),

])

# 应用增强变换

augmented_image = transform(image=image)['image']

# 显示原图和增强图

plt.subplot(1, 2, 1)

plt.imshow(image)

plt.title('Original Image')

plt.subplot(1, 2, 2)

plt.imshow(augmented_image)

plt.title('Augmented Image')

plt.show()

23.2.5.5 小结

数据增强是提升模型性能的重要手段,通过对现有数据进行各种变换,生成新的训练样本,增加数据的多样性。Python提供了丰富的库和工具,如NLPAug、Albumentations、librosa等,可以简化数据增强过程,提高工作效率。通过合理的数据增强方法,可以有效提升模型的泛化能力和鲁棒性。通过本章的学习,您将能够掌握数据增强的关键步骤,并将其应用于AI模型的微调实战中,确保数据的高质量和多样性,从而提升模型的性能和可靠性。

23.2.6. 特征工程

特征工程是将原始数据转换为模型可用的特征的过程。在自然语言处理中,常见的特征工程方法包括:

- 词袋模型(Bag of Words):将文本表示为词频向量。

- TF-IDF:计算词语在文档中的重要性。

- 词嵌入(Word Embeddings):使用预训练的词向量,如Word2Vec、GloVe等。

- 上下文嵌入(Contextual Embeddings):使用预训练的语言模型,如BERT、GPT等。

案例:在医疗文本分类中,我们可以使用BERT的上下文嵌入作为特征,因为BERT能够捕捉到词语的上下文信息,这对于理解医疗术语非常重要。

特征工程的Python实现

特征工程(Feature Engineering)是将原始数据转换为机器学习模型可理解的特征的过程。它是数据预处理的核心环节,直接影响模型的性能。特征工程的目标是提取和创造能够更好地表示数据本质的特征,从而提升模型的预测能力和泛化能力。以下将详细讲解特征工程的各个环节,并结合Python代码示例,展示如何高效地进行特征工程。

23.2.6.1. 特征工程的主要步骤

23.2.6.1.1 特征选择

特征选择是指从原始特征中选择对模型最有用的特征,去除冗余或不相关的特征。特征选择可以减少模型的复杂度,提高训练速度,并防止过拟合。

常用方法:

- 过滤法(Filter Methods):基于统计指标(如相关性、互信息等)选择特征。

- 包装法(Wrapper Methods):通过模型性能评估选择特征,如递归特征消除(RFE)。

- 嵌入法(Embedded Methods):在模型训练过程中进行特征选择,如Lasso回归。

示例:使用Scikit-learn进行特征选择

import pandas as pd

from sklearn.feature_selection import SelectKBest, f_classif

# 读取数据

df = pd.read_csv('data.csv')

# 假设我们要选择的特征和标签

X = df.drop('label', axis=1)

y = df['label']

# 选择前10个最重要的特征

selector = SelectKBest(score_func=f_classif, k=10)

X_new = selector.fit_transform(X, y)

# 获取选择的特征名称

selected_features = X.columns[selector.get_support()]

print('Selected Features:', selected_features)

23.2.6.1.2 特征提取

特征提取是指从原始数据中提取新的特征,以更好地表示数据本质。例如,从文本数据中提取词向量,从图像数据中提取像素值等。

常用方法:

- 文本数据:词袋模型(Bag of Words)、TF-IDF、词嵌入(Word Embeddings)。

- 图像数据:主成分分析(PCA)、线性判别分析(LDA)、卷积神经网络(CNN)特征提取。

示例:使用TF-IDF进行文本特征提取

from sklearn.feature_extraction.text import TfidfVectorizer

# 读取文本数据

df = pd.read_csv('text_data.csv')

# 初始化TF-IDF向量化器

vectorizer = TfidfVectorizer(max_features=1000)

# 应用TF-IDF向量化

X = vectorizer.fit_transform(df['text'])

print('Feature Matrix Shape:', X.shape)

23.2.6.1.3 特征变换

特征变换是指对特征进行数学变换,以满足模型对数据分布的要求。例如,对数变换、标准化、归一化等。

常用方法:

- 标准化(Standardization):将特征转换为均值为0,标准差为1的分布。

- 归一化(Normalization):将特征缩放到一个特定的范围,如[0,1]。

- 对数变换(Log Transformation):对特征进行对数变换,以减少偏度的数据分布。

示例:使用Scikit-learn进行特征标准化

from sklearn.preprocessing import StandardScaler

# 读取数据

df = pd.read_csv('data.csv')

# 假设我们要标准化的特征

X = df[['feature1', 'feature2', 'feature3']]

# 初始化标准化器

scaler = StandardScaler()

# 应用标准化

X_scaled = scaler.fit_transform(X)

# 转换为DataFrame

X_scaled = pd.DataFrame(X_scaled, columns=['feature1_scaled', 'feature2_scaled', 'feature3_scaled'])

print(X_scaled.head())

23.2.6.1.4 特征构造

特征构造是指从现有特征中构造新的特征,以捕捉数据中的复杂关系。例如,构造交互特征、多项式特征等。

示例:构造交互特征

import pandas as pd

# 读取数据

df = pd.read_csv('data.csv')

# 构造交互特征

df['feature1_feature2'] = df['feature1'] * df['feature2']

df['feature1_feature3'] = df['feature1'] / df['feature3']

print(df.head())

23.2.6.2. 特征工程的最佳实践

- 理解数据:深入理解数据的本质和业务背景,以便选择合适的特征工程方法。

- 多样性:尝试多种特征工程方法,以找到最能提升模型性能的特征。

- 避免过拟合:在特征选择和构造过程中,避免引入过多复杂特征,导致过拟合。

- 自动化:使用自动化工具和库,简化特征工程过程,提高效率。

23.2.6.3. 特征工程的工具和库

- Scikit-learn:提供了丰富的特征选择、提取和变换工具。

- Pandas:用于数据操作和特征构造。

- Numpy:用于数值计算和特征变换。

- Featuretools:一个用于自动化特征工程的库。

示例:使用Featuretools进行自动化特征工程

import featuretools as ft

import pandas as pd

# 读取数据

customers = pd.read_csv('customers.csv')

sessions = pd.read_csv('sessions.csv')

transactions = pd.read_csv('transactions.csv')

# 定义实体集

es = ft.EntitySet(id='customers')

# 添加实体

es = es.add_dataframe(dataframe_name='customers', dataframe=customers, index='customer_id')

es = es.add_dataframe(dataframe_name='sessions', dataframe=sessions, index='session_id')

es = es.add_dataframe(dataframe_name='transactions', dataframe=transactions, index='transaction_id')

# 定义关系

relationships = [('customers', 'customer_id', 'sessions', 'customer_id'),

('sessions', 'session_id', 'transactions', 'session_id')]

es = es.add_relationships(relationships)

# 进行深度特征合成

feature_matrix, feature_defs = ft.dfs(entityset=es, target_dataframe_name='customers', max_depth=2)

print(feature_matrix.head())

23.2.6.4. 综合示例

以下是一个综合的特征工程示例,涵盖了特征选择、特征提取和特征变换。

import pandas as pd

from sklearn.feature_selection import SelectKBest, f_classif

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.preprocessing import StandardScaler

# 读取数据

df = pd.read_csv('data.csv')

# 1. 特征选择

X = df.drop('label', axis=1)

y = df['label']

selector = SelectKBest(score_func=f_classif, k=10)

X_selected = selector.fit_transform(X, y)

selected_features = X.columns[selector.get_support()]

print('Selected Features:', selected_features)

# 2. 特征提取(以文本数据为例)

vectorizer = TfidfVectorizer(max_features=1000)

X_text = vectorizer.fit_transform(df['text'])

print('Text Feature Matrix Shape:', X_text.shape)

# 3. 特征变换(标准化)

scaler = StandardScaler()

X_selected_scaled = scaler.fit_transform(X_selected)

# 4. 合并特征

from scipy.sparse import hstack

X_final = hstack([X_selected_scaled, X_text])

print('Final Feature Matrix Shape:', X_final.shape)

23.2.6.5. 小结

特征工程是数据预处理的核心环节,直接影响模型的性能。通过合理的特征选择、提取、变换和构造,可以有效提升模型的预测能力和泛化能力。Python提供了丰富的库和工具,如Scikit-learn、Pandas、Featuretools等,可以简化特征工程过程,提高工作效率。通过本章的学习,您将能够掌握特征工程的关键步骤,并将其应用于AI模型的微调实战中,确保特征的高质量和多样性,从而提升模型的性能和可靠性。

23.2.7. 数据标准化与归一化

为了加速模型训练并提高性能,我们需要对特征进行标准化或归一化处理:

- 标准化(Standardization):将特征转换为均值为0,标准差为1的分布。

- 归一化(Normalization):将特征缩放到一个特定的范围,如[0,1]。

案例:在医疗文本分类中,我们可以对BERT的嵌入向量进行标准化处理,以加速模型训练。

数据标准化与归一化的Python实现

数据标准化(Standardization)和 归一化(Normalization)是数据预处理中的关键步骤,旨在调整数据的尺度,使其适合机器学习模型的训练。这两个过程虽然目的相似,但方法不同,适用于不同的场景。以下将详细讲解数据标准化与归一化的各个环节,并结合Python代码示例,展示如何高效地进行数据标准化与归一化。

23.2.7.1. 数据标准化的定义与目的

数据标准化是指将数据转换为均值为0,标准差为1的分布。标准化的目的是消除不同特征之间的量纲差异,使得每个特征对模型的影响相对均衡。

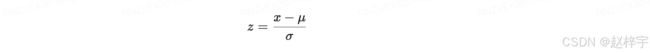

标准化公式:

其中:

- x 是原始数据点。

- μ 是数据的均值。

- σ 是数据的标准差。

- z 是标准化后的数据点。

标准化适用场景:

- 当数据分布不满足正态分布时,标准化可以使其更接近正态分布。

- 当使用基于距离的算法(如K近邻、支持向量机)时,标准化可以提高模型性能。

23.2.7.2. 数据归一化的定义与目的

数据归一化是指将数据缩放到一个特定的范围,通常是[0,1]。归一化的目的是消除不同特征之间的量纲差异,使得每个特征对模型的影响相对均衡。

归一化公式(Min-Max Scaling):

其中:

- X是原始数据点。

- Xmin 是数据的最小值。

- Xmax 是数据的最大值。

- Xnorm 是归一化后的数据点。

归一化适用场景:

- 当需要将数据限制在一个特定范围内时,如[0,1]。

- 当使用梯度下降算法时,归一化可以加快收敛速度。

23.2.7.3. 数据标准化与归一化的区别

| 特性 | 标准化 | 归一化 |

|---|---|---|

| 目标 | 使数据均值为0,标准差为1 | 将数据缩放到[0,1]范围 |

| 适用场景 | 基于距离的算法、模型对数据分布有要求 | 需要将数据限制在特定范围内 |

| 对异常值的敏感性 | 较不敏感 | 较敏感 |

| 实现方法 | 使用均值和标准差 | 使用最小值和最大值 |

23.2.7.4. Python实现

23.2.7.4.1 使用Scikit-learn进行标准化与归一化

import pandas as pd

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 读取数据

df = pd.read_csv('data.csv')

# 假设我们要处理的数据

X = df[['feature1', 'feature2', 'feature3']]

# 1. 数据标准化

scaler = StandardScaler()

X_standardized = scaler.fit_transform(X)

X_standardized = pd.DataFrame(X_standardized, columns=['feature1_std', 'feature2_std', 'feature3_std'])

print('标准化后的数据:\n', X_standardized.head())

# 2. 数据归一化

min_max_scaler = MinMaxScaler()

X_normalized = min_max_scaler.fit_transform(X)

X_normalized = pd.DataFrame(X_normalized, columns=['feature1_norm', 'feature2_norm', 'feature3_norm'])

print('归一化后的数据:\n', X_normalized.head())

23.2.7.4.2 使用Pandas进行标准化与归一化

import pandas as pd

# 读取数据

df = pd.read_csv('data.csv')

# 假设我们要处理的数据

X = df[['feature1', 'feature2', 'feature3']]

# 1. 数据标准化

X_standardized = (X - X.mean()) / X.std()

print('标准化后的数据:\n', X_standardized.head())

# 2. 数据归一化

X_normalized = (X - X.min()) / (X.max() - X.min())

print('归一化后的数据:\n', X_normalized.head())

23.2.7.4.3 使用Scikit-learn的Pipeline进行标准化与归一化

from sklearn.pipeline import Pipeline

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

# 读取数据

df = pd.read_csv('data.csv')

# 特征和标签

X = df.drop('label', axis=1)

y = df['label']

# 定义Pipeline

pipeline = Pipeline([

('scaler', StandardScaler()),

('classifier', LogisticRegression())

])

# 分割数据

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 训练模型

pipeline.fit(X_train, y_train)

# 评估模型

accuracy = pipeline.score(X_test, y_test)

print('模型准确率:', accuracy)

23.2.7.5. 数据标准化与归一化的注意事项

- 选择合适的方法:根据任务需求选择标准化或归一化。例如,基于距离的算法通常需要标准化,而梯度下降算法则受益于归一化。

- 处理异常值:标准化和归一化对异常值较为敏感,处理数据时应先进行异常值检测和清洗。

- 避免数据泄漏:在进行标准化或归一化时,应在训练集上拟合Scaler,然后在测试集上应用,以避免数据泄漏。

示例:避免数据泄漏

from sklearn.preprocessing import StandardScaler

# 分割数据

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 初始化Scaler

scaler = StandardScaler()

# 在训练集上拟合Scaler

X_train_scaled = scaler.fit_transform(X_train)

# 在测试集上应用Scaler

X_test_scaled = scaler.transform(X_test)

23.2.7.6 小结

数据标准化与归一化是数据预处理的重要环节,旨在调整数据的尺度,使其适合机器学习模型的训练。通过合理的标准化和归一化,可以有效提升模型的性能和稳定性。Python提供了丰富的库和工具,如Scikit-learn、Pandas等,可以简化数据标准化与归一化的过程,提高工作效率。通过本章的学习,您将能够掌握数据标准化与归一化的关键步骤,并将其应用于AI模型的微调实战中,确保数据的高质量和一致性,从而提升模型的性能和可靠性。

23.2.8. 加载与预处理工具

在Python中,有许多强大的工具和库可以简化数据加载与预处理的过程:

- TensorFlow Data API:提供了高效的数据加载和预处理功能。

- PyTorch DataLoader:用于加载和预处理数据,支持多线程和批处理。

- HuggingFace Datasets:提供了丰富的数据集和预处理工具,支持多种NLP任务。

- Pandas:用于数据清洗和预处理,支持多种数据格式。

案例:我们可以使用HuggingFace Datasets库来加载和预处理医疗文本数据,因为它提供了许多便捷的函数和工具。

加载与预处理工具的Python实现

在人工智能模型的开发过程中,数据加载与预处理是至关重要的一环。为了高效地处理各种类型的数据,Python生态系统提供了许多强大的工具和库。这些工具不仅简化了数据加载和预处理的过程,还提供了丰富的功能以满足不同的需求。以下将详细讲解常用的加载与预处理工具,并结合Python代码示例,展示如何高效地使用这些工具。

23.2.8.1. 数据加载工具

23.2.8.1.1 Pandas

Pandas是Python中最流行的数据处理和分析库,提供了高效的数据结构(如DataFrame)和丰富的数据操作功能,适用于处理结构化数据。

主要功能:

- 读取和写入多种数据格式(如CSV、Excel、SQL数据库等)。

- 数据清洗和预处理(如处理缺失值、重复数据等)。

- 数据转换和聚合。

示例:使用Pandas读取CSV文件

import pandas as pd

# 读取CSV文件

df = pd.read_csv('data.csv')

# 查看前5行数据

print(df.head())

# 查看数据基本信息

print(df.info())

# 处理缺失值

df = df.dropna()

# 保存处理后的数据

df.to_csv('cleaned_data.csv', index=False)

23.2.8.1.2 NumPy

NumPy是Python中用于科学计算的基础库,提供了强大的多维数组对象和丰富的数学函数,适用于处理数值数据。

主要功能:

- 高效的数组运算。

- 线性代数、傅里叶变换、随机数生成等。

示例:使用NumPy进行数组操作

import numpy as np

# 创建数组

array = np.array([[1, 2, 3], [4, 5, 6]])

# 数组运算

array_squared = array ** 2

print(array_squared)

# 矩阵运算

matrix = np.matrix([[1, 2], [3, 4]])

inverse_matrix = np.linalg.inv(matrix)

print(inverse_matrix)

23.2.8.1.3 TensorFlow Data API

TensorFlow Data API提供了高效的数据加载和预处理功能,适用于大规模数据集和分布式训练。

主要功能:

- 数据管道构建。

- 数据批处理和打乱。

- 数据预处理(如映射、过滤等)。

示例:使用TensorFlow Data API加载数据

import tensorflow as tf

# 创建TensorFlow数据集

dataset = tf.data.Dataset.from_tensor_slices([1, 2, 3, 4, 5])

# 数据预处理

dataset = dataset.map(lambda x: x * 2)

dataset = dataset.batch(2)

# 迭代数据集

for batch in dataset:

print(batch)

23.2.8.1.4 PyTorch DataLoader

PyTorch DataLoader是PyTorch中用于加载和预处理数据的工具,支持多线程和批处理,适用于深度学习模型的训练。

主要功能:

- 数据加载和批处理。

- 数据打乱。

- 多线程数据加载。

示例:使用PyTorch DataLoader加载数据

import torch

from torch.utils.data import DataLoader, TensorDataset

# 创建数据

data = torch.tensor([[1, 2], [3, 4], [5, 6], [7, 8]])

labels = torch.tensor([0, 1, 0, 1])

# 创建TensorDataset

dataset = TensorDataset(data, labels)

# 创建DataLoader

dataloader = DataLoader(dataset, batch_size=2, shuffle=True, num_workers=2)

# 迭代DataLoader

for batch_data, batch_labels in dataloader:

print(batch_data, batch_labels)

23.2.8.1.5 HuggingFace Datasets

HuggingFace Datasets提供了丰富的数据集和预处理工具,支持多种NLP任务,适用于大规模数据集的处理。

主要功能:

- 访问和下载多种公开数据集。

- 数据预处理和转换。

- 数据集缓存和版本控制。

示例:使用HuggingFace Datasets加载IMDB数据集

from datasets import load_dataset

# 加载IMDB数据集

dataset = load_dataset('imdb')

# 查看数据集结构

print(dataset)

# 访问训练集

train_dataset = dataset['train']

# 查看前5条数据

print(train_dataset[:5])

23.2.8.2. 数据预处理工具

23.2.8.2.1 Scikit-learn

Scikit-learn是Python中用于机器学习的库,提供了丰富的预处理工具,如标准化、归一化、编码等。

主要功能:

- 数据标准化和归一化。

- 特征编码(如独热编码、标签编码)。

- 特征选择和降维。

示例:使用Scikit-learn进行数据预处理

from sklearn.preprocessing import StandardScaler, OneHotEncoder

from sklearn.compose import ColumnTransformer

from sklearn.pipeline import Pipeline

# 读取数据

df = pd.read_csv('data.csv')

# 特征和标签

X = df.drop('label', axis=1)

y = df['label']

# 定义预处理步骤

preprocessor = ColumnTransformer(

transformers=[

('num', StandardScaler(), ['feature1', 'feature2']),

('cat', OneHotEncoder(), ['category'])

]

)

# 创建Pipeline

pipeline = Pipeline(steps=[

('preprocessor', preprocessor),

('classifier', LogisticRegression())

])

# 训练模型

pipeline.fit(X, y)

23.2.8.2.2 NLTK

NLTK是Python中用于自然语言处理的库,提供了丰富的文本预处理工具,如分词、去除停用词、词形还原等。

主要功能:

- 分词。

- 去除停用词。

- 词形还原。

- 词性标注。

示例:使用NLTK进行文本预处理

import nltk

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

# 下载资源

nltk.download('stopwords')

nltk.download('wordnet')

# 初始化分词器和词形还原器

lemmatizer = WordNetLemmatizer()

stop_words = set(stopwords.words('english'))

# 文本预处理函数

def preprocess(text):

tokens = nltk.word_tokenize(text)

tokens = [word for word in tokens if word.isalnum()]

tokens = [word for word in tokens if word not in stop_words]

tokens = [lemmatizer.lemmatize(word) for word in tokens]

return ' '.join(tokens)

# 应用预处理

df['clean_text'] = df['text'].apply(preprocess)

23.2.8.2.3 spaCy

spaCy是Python中用于高级自然语言处理的库,提供了高效的文本预处理和深度学习模型支持。

主要功能:

- 分词。

- 命名实体识别(NER)。

- 词性标注。

- 依存句法分析。

示例:使用spaCy进行文本预处理

import spacy

# 加载预训练的spaCy模型

nlp = spacy.load('en_core_web_sm')

# 文本预处理函数

def preprocess(text):

doc = nlp(text)

tokens = [token.lemma_ for token in doc if token.is_alpha and not token.is_stop]

return ' '.join(tokens)

# 应用预处理

df['clean_text'] = df['text'].apply(preprocess)

23.2.8.3. 综合示例

以下是一个综合的数据加载与预处理示例,涵盖了数据读取、数据清洗、特征编码和特征标准化。

import pandas as pd

from sklearn.preprocessing import StandardScaler, OneHotEncoder

from sklearn.compose import ColumnTransformer

from sklearn.pipeline import Pipeline

# 1. 数据加载

df = pd.read_csv('data.csv')

# 2. 数据清洗

df = df.dropna()

# 3. 特征和标签

X = df.drop('label', axis=1)

y = df['label']

# 4. 定义预处理步骤

preprocessor = ColumnTransformer(

transformers=[

('num', StandardScaler(), ['feature1', 'feature2']),

('cat', OneHotEncoder(), ['category'])

]

)

# 5. 创建Pipeline

pipeline = Pipeline(steps=[

('preprocessor', preprocessor),

('classifier', LogisticRegression())

])

# 6. 训练模型

pipeline.fit(X, y)

# 7. 评估模型

accuracy = pipeline.score(X, y)

print('模型准确率:', accuracy)

23.2.8.4. 小结

数据加载与预处理是AI模型开发中的关键步骤,Python生态系统提供了丰富的工具和库,如Pandas、NumPy、TensorFlow Data API、PyTorch DataLoader、HuggingFace Datasets、Scikit-learn、NLTK和spaCy等,可以简化数据处理过程,提高工作效率。通过合理使用这些工具,可以有效提升数据质量,为模型训练和评估打下坚实的基础。

23.2.9. 实践案例

以下是一个使用HuggingFace Datasets进行数据加载与预处理的示例:

from datasets import load_dataset

from transformers import BertTokenizer

# 加载数据集

dataset = load_dataset('medical_text_dataset')

# 初始化BERT分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 定义预处理函数

def preprocess_function(examples):

return tokenizer(examples['text'], padding='max_length', truncation=True)

# 应用预处理

tokenized_dataset = dataset.map(preprocess_function, batched=True)

# 划分训练集和测试集

train_dataset = tokenized_dataset['train']

test_dataset = tokenized_dataset['test']

在这个示例中,我们首先加载了医疗文本数据集,然后使用BERT分词器对文本进行分词和编码,最后将数据划分为训练集和测试集。

实践案例:基于Python的文本分类任务实战

在本节中,我们将通过一个文本分类任务的完整实践案例,展示如何将前面所学的数据加载与预处理技巧应用到实际项目中。我们将使用Python及其相关库,完成从数据收集到模型训练的全过程。以下是详细的步骤和代码示例。

23.2.9.1. 项目概述

任务:构建一个文本分类模型,能够根据给定的文本内容,将其分类为不同的类别。例如,新闻文章分类、情感分析、产品评论分类等。

目标:使用Python及其相关库,完成数据加载、预处理、特征工程、模型训练和评估的全过程。

23.2.9.2. 数据收集与选择

在本案例中,我们将使用Kaggle上的20 Newsgroups数据集,这是一个经典的文本分类数据集,包含20个不同的新闻组类别。

步骤:

1. 安装必要的库:

pip install pandas scikit-learn

2. 加载数据:

import pandas as pd

from sklearn.datasets import fetch_20newsgroups

# 加载20 Newsgroups数据集

newsgroups = fetch_20newsgroups(subset='all', remove=('headers', 'footers', 'quotes'))

# 创建DataFrame

df = pd.DataFrame({

'text': newsgroups.data,

'label': newsgroups.target

})

print(df.head())

3. 数据探索:

# 查看类别分布

print(df['label'].value_counts())

# 查看文本长度分布

df['text_length'] = df['text'].apply(len)

print(df['text_length'].describe())

23.2.9.3. 数据清洗与预处理

步骤:

1.去除噪声:去除HTML标签、特殊字符等。

2.标准化文本:统一文本格式,如转换为小写。

3.去除停用词:去除常见的无意义词汇。

4.分词与词形还原:将文本分割成词语,并进行词形还原。

代码示例:

import re

import nltk

from nltk.corpus import stopwords

from nltk.stem import WordNetLemmatizer

# 下载资源

nltk.download('stopwords')

nltk.download('wordnet')

# 初始化分词器和词形还原器

lemmatizer = WordNetLemmatizer()

stop_words = set(stopwords.words('english'))

# 文本清洗与预处理函数

def clean_text(text):

# 去除HTML标签

text = re.sub(r'<.*?>', '', text)

# 转换为小写

text = text.lower()

# 去除特殊字符和数字

text = re.sub(r'[^a-zA-Z\s]', '', text)

# 分词

tokens = text.split()

# 去除停用词

tokens = [word for word in tokens if word not in stop_words]

# 词形还原

tokens = [lemmatizer.lemmatize(word) for word in tokens]

# 合并词语

return ' '.join(tokens)

# 应用预处理

df['clean_text'] = df['text'].apply(clean_text)

print(df['clean_text'].head())

23.2.9.4. 特征工程

步骤:

1.文本向量化:将文本转换为数值特征。常用的方法包括TF-IDF、词嵌入(如Word2Vec、BERT等)。

2.特征选择:选择对模型最有用的特征。

代码示例:

from sklearn.feature_extraction.text import TfidfVectorizer

# 初始化TF-IDF向量化器

vectorizer = TfidfVectorizer(max_features=10000)

# 应用TF-IDF向量化

X = vectorizer.fit_transform(df['clean_text'])

print('特征矩阵形状:', X.shape)

23.2.9.5. 数据分割

步骤:

1.划分训练集和测试集:将数据集划分为训练集和测试集,以评估模型性能。

2.使用分层分割:保持类别比例一致。

代码示例:

from sklearn.model_selection import train_test_split

# 标签

y = df['label']

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, stratify=y, random_state=42)

print('训练集大小:', X_train.shape[0])

print('测试集大小:', X_test.shape[0])

23.2.9.6. 模型训练与评估

步骤:

1.选择模型:选择合适的机器学习模型,如逻辑回归、支持向量机(SVM)、随机森林等。

2.训练模型:使用训练集训练模型。

3.评估模型:使用测试集评估模型性能。

代码示例:

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import classification_report, accuracy_score

# 初始化模型

model = LogisticRegression(max_iter=1000)

# 训练模型

model.fit(X_train, y_train)

# 预测

y_pred = model.predict(X_test)

# 评估

accuracy = accuracy_score(y_test, y_pred)

print('模型准确率:', accuracy)

# 详细分类报告

print(classification_report(y_test, y_pred, target_names=newsgroups.target_names))

23.2.9.7. 模型优化

步骤:

1.超参数调优:使用网格搜索(Grid Search)或随机搜索(Random Search)优化模型超参数。

2.交叉验证:使用交叉验证评估模型性能。

代码示例:

from sklearn.model_selection import GridSearchCV

# 定义超参数范围

param_grid = {

'C': [0.1, 1, 10],

'solver': ['liblinear', 'lbfgs']

}

# 初始化Grid Search

grid = GridSearchCV(LogisticRegression(max_iter=1000), param_grid, cv=5, scoring='accuracy')

# 训练模型

grid.fit(X_train, y_train)

# 最佳参数

print('最佳参数:', grid.best_params_)

# 最佳模型评估

y_pred = grid.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print('优化后模型准确率:', accuracy)

23.2.9.8. 结果分析与总结

通过上述步骤,我们成功构建了一个文本分类模型,并对其进行了训练和评估。以下是一些关键点总结:

- 数据清洗与预处理:有效的文本清洗和预处理可以显著提升模型性能。

- 特征工程:选择合适的文本向量化方法(如TF-IDF)是关键。

- 模型选择与优化:通过超参数调优和交叉验证,可以进一步提升模型性能。

- 评估指标:除了准确率,还应关注其他评估指标,如精确率、召回率、F1-score等,以全面评估模型性能。

23.2.9.9. 扩展与未来工作

- 使用深度学习模型:尝试使用深度学习模型(如BERT)进行文本分类,以提升性能。

- 处理不平衡数据:如果类别分布不均衡,可以采用过采样、欠采样或生成对抗网络(GAN)等方法进行处理。

- 模型部署:将训练好的模型部署为Web服务或API,以便实际应用。

23.2.9.10 小结

通过本案例的实践,您将能够掌握从数据收集到模型评估的完整流程,并将其应用于实际的文本分类任务中。Python及其相关库提供了丰富的工具和功能,可以大大简化数据处理和模型训练过程,提高工作效率。

23.2.10 数据准备与预处理小结

数据准备与预处理是AI模型微调过程中不可或缺的一环。通过有效的数据收集、清洗、标注、分割、增强和特征工程,我们可以为模型提供高质量的训练数据,从而提升模型的性能。在实际应用中,选择合适的工具和库可以大大简化数据处理过程,提高工作效率。通过本章的学习,您将能够掌握数据准备与预处理的关键步骤,并将其应用于AI模型的微调实战中,为后续的模型选择、评估和部署打下坚实的基础。

23.3 模型选择与评估策略

在微调预训练模型的过程中,模型选择和评估策略是确保模型性能的关键步骤。选择合适的模型架构和评估方法,不仅能提升模型的预测能力,还能有效避免过拟合并确保模型的泛化能力。以下将详细讲解模型选择与评估策略的各个环节,并结合实际案例,展示如何进行有效的模型选择与评估。

23.3.1. 模型选择

23.3.1.1 预训练模型的选择

预训练模型是指在大规模数据集上预先训练好的模型,这些模型已经学习到了丰富的语言或视觉特征。选择合适的预训练模型是微调成功的关键。以下是一些常用的预训练模型:

- BERT(Bidirectional Encoder Representations from Transformers):适用于多种NLP任务,如文本分类、命名实体识别、问答系统等。

- GPT(Generative Pre-trained Transformer):适用于生成任务,如文本生成、对话系统等。

- RoBERTa:BERT的改进版本,在更大规模的数据集上训练,性能更优。

- T5(Text-To-Text Transfer Transformer):将所有NLP任务统一为文本到文本的格式,适用于多种任务。

- ResNet(Residual Networks):适用于计算机视觉任务,如图像分类、目标检测等。

- EfficientNet:在参数量和计算量之间取得平衡,性能优异。

示例:选择BERT作为预训练模型

from transformers import BertTokenizer, BertForSequenceClassification

# 加载预训练的BERT tokenizer和模型

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForSequenceClassification.from_pretrained('bert-base-uncased', num_labels=20)

23.3.1.2 模型架构调整

根据目标任务的不同,可能需要对预训练模型的架构进行调整。例如,修改输出层以适应特定的任务。

示例:修改BERT的输出层用于文本分类

from transformers import BertModel, BertTokenizer

# 加载预训练的BERT模型和tokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

bert = BertModel.from_pretrained('bert-base-uncased')

# 添加一个全连接层用于分类

import torch.nn as nn

class TextClassificationModel(nn.Module):

def __init__(self, bert, num_labels):

super(TextClassificationModel, self).__init__()

self.bert = bert

self.dropout = nn.Dropout(0.3)

self.classifier = nn.Linear(bert.config.hidden_size, num_labels)

def forward(self, input_ids, attention_mask):

outputs = self.bert(input_ids=input_ids, attention_mask=attention_mask)

pooled_output = outputs[1] # CLS token

dropout_output = self.dropout(pooled_output)

logits = self.classifier(dropout_output)

return logits

# 初始化模型

num_labels = 20

model = TextClassificationModel(bert, num_labels)

23.3.2. 评估策略

23.3.2.1 评估指标

选择合适的评估指标对于评估模型性能至关重要。以下是一些常用的评估指标:

- 准确率(Accuracy):正确预测的比例。

- 精确率(Precision):正类预测中实际为正类的比例。

- 召回率(Recall):实际为正类的样本中被正确预测为正类的比例。

- F1-score:精确率和召回率的调和平均数。

- ROC-AUC:接收者操作特征曲线下面积,用于评估分类模型的区分能力。

示例:使用Scikit-learn计算评估指标

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, roc_auc_score

# 假设y_true是真实标签,y_pred是预测标签,y_scores是预测概率

y_true = [0, 1, 1, 0, 1]

y_pred = [0, 1, 0, 0, 1]

y_scores = [0.2, 0.8, 0.6, 0.3, 0.9]

accuracy = accuracy_score(y_true, y_pred)

precision = precision_score(y_true, y_pred)

recall = recall_score(y_true, y_pred)

f1 = f1_score(y_true, y_pred)

roc_auc = roc_auc_score(y_true, y_scores)

print(f'准确率: {accuracy}')

print(f'精确率: {precision}')

print(f'召回率: {recall}')

print(f'F1-score: {f1}')

print(f'ROC-AUC: {roc_auc}')

23.3.2.2 交叉验证

交叉验证是一种评估模型性能的方法,通过将数据集划分为多个子集,轮流使用其中一个子集作为验证集,其余子集作为训练集,进行多次训练和评估。

示例:使用K折交叉验证

from sklearn.model_selection import cross_val_score

from sklearn.linear_model import LogisticRegression

# 假设X是特征矩阵,y是标签

X = df.drop('label', axis=1).values

y = df['label'].values

# 初始化模型

model = LogisticRegression(max_iter=1000)

# 进行5折交叉验证

scores = cross_val_score(model, X, y, cv=5, scoring='accuracy')

print('交叉验证准确率:', scores)

print('平均准确率:', scores.mean())

23.3.2.3 混淆矩阵

混淆矩阵用于展示分类模型的预测结果,包括正确和错误的预测情况。

示例:绘制混淆矩阵

import matplotlib.pyplot as plt

from sklearn.metrics import confusion_matrix

import seaborn as sns

# 假设y_true是真实标签,y_pred是预测标签

y_true = [0, 1, 1, 0, 1]

y_pred = [0, 1, 0, 0, 1]

# 计算混淆矩阵

cm = confusion_matrix(y_true, y_pred)

# 绘制热图

sns.heatmap(cm, annot=True, fmt='d', cmap='Blues')

plt.xlabel('Predicted')

plt.ylabel('True')

plt.show()

23.3.3. 模型选择与评估的最佳实践

- 选择合适的预训练模型:根据目标任务选择最合适的预训练模型。例如,BERT适用于多种NLP任务,而ResNet则适用于图像分类。

- 调整模型架构:根据需要调整预训练模型的架构,如修改输出层以适应特定任务。

- 使用多种评估指标:不要仅依赖单一指标,综合使用多种评估指标以全面评估模型性能。

- 进行交叉验证:使用交叉验证评估模型性能,确保模型的泛化能力。

- 分析混淆矩阵:通过分析混淆矩阵,了解模型在哪些类别上表现良好,哪些类别上存在不足。

23.3.4. 综合示例

以下是一个综合的模型选择与评估示例,展示了如何选择预训练模型、调整模型架构并进行评估。

import pandas as pd

from transformers import BertTokenizer, BertForSequenceClassification, Trainer, TrainingArguments

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, precision_recall_fscore_support

# 1. 数据加载与预处理

df = pd.read_csv('data.csv')

X = df['text']

y = df['label']

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, stratify=y, random_state=42)

# 加载tokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 编码文本

train_encodings = tokenizer(X_train.tolist(), truncation=True, padding=True, max_length=128)

test_encodings = tokenizer(X_test.tolist(), truncation=True, padding=True, max_length=128)

# 转换为TensorDataset

import torch

from torch.utils.data import TensorDataset, DataLoader

train_dataset = TensorDataset(torch.tensor(train_encodings['input_ids']),

torch.tensor(train_encodings['attention_mask']),

torch.tensor(y_train.tolist()))

test_dataset = TensorDataset(torch.tensor(test_encodings['input_ids']),

torch.tensor(test_encodings['attention_mask']),

torch.tensor(y_test.tolist()))

# 2. 模型选择与训练

model = BertForSequenceClassification.from_pretrained('bert-base-uncased', num_labels=20)

# 定义训练参数

training_args = TrainingArguments(

output_dir='./results',

num_train_epochs=3,

per_device_train_batch_size=16,

per_device_eval_batch_size=32,

evaluation_strategy='epoch',

logging_dir='./logs',

)

# 定义Trainer

trainer = Trainer(

model=model,

args=training_args,

train_dataset=train_dataset,

eval_dataset=test_dataset,

compute_metrics=lambda preds: {

'accuracy': accuracy_score(y_test, preds[0].argmax(axis=1)),

'precision', precision_recall_fscore_support(y_test, preds[0].argmax(axis=1), average='weighted')[:3]

}

)

# 训练模型

trainer.train()

# 评估模型

results = trainer.evaluate()

print(results)

23.3.5. 小结

通过本小节的学习,您将能够掌握模型选择与评估的关键步骤,并将其应用于AI模型的微调实战中。选择合适的预训练模型和评估策略,不仅能提升模型的性能,还能确保模型的泛化能力和稳定性。Python及其相关库提供了丰富的工具和功能,可以大大简化模型选择与评估的过程,提高工作效率。

23.4 微调技巧与最佳实践

微调预训练模型是将一个在大规模数据集上预先训练好的模型适配到特定任务上的过程。虽然预训练模型已经具备丰富的语言或视觉特征,但为了在特定任务上取得最佳性能,仍需进行精细的微调。以下将详细介绍微调过程中的一些关键技巧与最佳实践,并通过具体示例展示如何高效地进行模型微调。

23.4.1. 选择合适的预训练模型

技巧:根据目标任务选择最合适的预训练模型。

- NLP任务:对于文本分类、命名实体识别等任务,BERT、RoBERTa、ALBERT等模型是不错的选择。

- 生成任务:对于文本生成、对话系统等任务,GPT系列模型(如GPT-2、GPT-3)更为适用。

- 计算机视觉任务:对于图像分类、目标检测等任务,ResNet、EfficientNet、Vision Transformer(ViT)等模型表现优异。

示例:选择BERT用于文本分类

from transformers import BertForSequenceClassification, BertTokenizer

# 加载预训练的BERT模型和tokenizer

model_name = 'bert-base-uncased'

tokenizer = BertTokenizer.from_pretrained(model_name)

model = BertForSequenceClassification.from_pretrained(model_name, num_labels=20)

23.4.2. 数据集准备与预处理

技巧:确保数据集的质量和多样性,并进行适当的预处理。

- 数据清洗:去除噪声数据、标准化文本等。

- 数据增强:通过同义词替换、随机插入等方法增加数据多样性。

- 标签编码:将文本标签转换为数值形式,如使用独热编码或标签编码。

示例:使用HuggingFace的Tokenizer进行文本编码

from transformers import BertTokenizer

import pandas as pd

# 读取数据

df = pd.read_csv('data.csv')

# 初始化tokenizer

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

# 编码文本

def encode_text(text):

return tokenizer(text, truncation=True, padding='max_length', max_length=128, return_tensors='pt')

# 应用编码

df['input_ids'] = df['text'].apply(lambda x: encode_text(x)['input_ids'].squeeze())