动态规划与贝尔曼方程 —— 理论、案例与交互式 GUI 实现

目录

- 动态规划与贝尔曼方程 —— 理论、案例与交互式 GUI 实现

-

- 一、引言

- 二、动态规划基本原理

-

- 2.1 动态规划的思想

- 2.2 贝尔曼方程

- 2.3 值迭代与策略迭代

- 三、贝尔曼方程的数学推导

-

- 3.1 最优性原理

- 3.2 离散时间问题中的贝尔曼方程

- 3.3 无穷时域折扣动态规划

- 四、动态规划在控制与决策中的应用

-

- 4.1 最优控制问题

- 4.2 强化学习与最优策略求解

- 4.3 资源分配与调度问题

- 五、数值求解与算法实现

-

- 5.1 值迭代算法

- 5.2 策略迭代算法

- 5.3 算法实现中的注意事项

- 六、典型案例分析

-

- 6.1 案例一:最短路径问题

-

- 6.1.1 案例描述

- 6.1.2 分析结论

- 6.2 案例二:库存控制问题

-

- 6.2.1 案例描述

- 6.2.2 分析结论

- 6.3 案例三:机器人路径规划

-

- 6.3.1 案例描述

- 6.3.2 分析结论

- 七、基于 PyQt6 的交互式 GUI 演示

-

- 7.1 系统架构说明

- 7.2 Python 代码实现

- 八、结语

动态规划与贝尔曼方程 —— 理论、案例与交互式 GUI 实现

一、引言

在现代控制理论、运筹学以及人工智能领域,动态规划(Dynamic Programming, DP) 是一种求解多阶段决策问题的重要方法。由理查德·贝尔曼在20世纪50年代提出的动态规划思想,不仅为最优控制、强化学习等领域奠定了理论基础,而且在经济学、工程学等众多领域都有着广泛的应用。动态规划的核心思想在于将一个复杂的决策问题分解为一系列子问题,并利用递归思想来求解每个子问题,其基本数学工具便是贝尔曼方程。

贝尔曼方程描述了在最优策略下,每个状态的最优值与其后继状态之间的递归关系,为求解最优控制问题和强化学习中的值函数提供了有效的途径。本文将从动态规划和贝尔曼方程的基本原理出发,系统介绍其数学推导、数值求解方法以及在控制系统和决策问题中的应用。为了使理论内容更加直观,我们还设计了一套基于 Python 与 PyQt6 的交互式 GUI 演示系统,用户可通过界面实时调整参数、观察最优值函数和策略的变化,从而加深对动态规划及贝尔曼方程的理解。

二、动态规划基本原理

2.1 动态规划的思想

动态规划的基本思想是将一个复杂的决策问题分解为若干个阶段,每个阶段都对应一个状态,且每个阶段的最优解可以通过后续阶段的最优解递归得到。设状态空间为 X \mathcal{X} X,控制空间为 U \mathcal{U} U,目标在于求解如下最优化问题:

min u ( 0 ) , u ( 1 ) , … , u ( N − 1 ) J = ∑ k = 0 N − 1 g ( x ( k ) , u ( k ) ) + h ( x ( N ) ) , \min_{u(0), u(1), \dots, u(N-1)} \; J = \sum_{k=0}^{N-1} g(x(k), u(k)) + h(x(N)), u(0),u(1),…,u(N−1)minJ=k=0∑N−1g(x(k),u(k))+h(x(N)),

其中 x ( 0 ) x(0) x(0) 为已知初始状态,状态转移满足

x ( k + 1 ) = f ( x ( k ) , u ( k ) ) , k = 0 , 1 , … , N − 1. x(k+1) = f(x(k), u(k)), \quad k=0,1,\dots, N-1. x(k+1)=f(x(k),u(k)),k=0,1,…,N−1.

动态规划方法将问题分解为多个子问题,通过递归求解的方式,从末端向前得到整个问题的最优解。这一过程的核心在于 贝尔曼最优性原理,即每个子问题的最优策略都应当包含后续子问题的最优策略。

2.2 贝尔曼方程

贝尔曼方程是动态规划的数学表达式,其一般形式为:

V ( x ) = min u ∈ U { g ( x , u ) + V ( f ( x , u ) ) } , V(x) = \min_{u \in \mathcal{U}} \left\{ g(x, u) + V\big(f(x, u)\big) \right\}, V(x)=u∈Umin{g(x,u)+V(f(x,u))},

其中 V ( x ) V(x) V(x) 表示在状态 x x x 下的最优代价函数(或值函数)。在有限时域问题中,终端值函数通常为 V N ( x ) = h ( x ) V_N(x) = h(x) VN(x)=h(x),而对于无限时域问题,则可引入折扣因子 γ ∈ ( 0 , 1 ) \gamma \in (0,1) γ∈(0,1) 得到:

V ( x ) = min u ∈ U { g ( x , u ) + γ V ( f ( x , u ) ) } . V(x) = \min_{u \in \mathcal{U}} \left\{ g(x, u) + \gamma V\big(f(x, u)\big) \right\}. V(x)=u∈Umin{g(x,u)+γV(f(x,u))}.

贝尔曼方程的关键在于递归关系:一个状态的最优值取决于在该状态下做出的最优决策及后续状态的最优值。利用这一方程,可以通过迭代方法(如值迭代、策略迭代)求解最优值函数和最优策略。

2.3 值迭代与策略迭代

- 值迭代:通过不断更新值函数 V ( x ) V(x) V(x) 的估计值,直到收敛为止。更新公式为:

V k + 1 ( x ) = min u ∈ U { g ( x , u ) + γ V k ( f ( x , u ) ) } . V_{k+1}(x) = \min_{u \in \mathcal{U}} \left\{ g(x, u) + \gamma V_k\big(f(x, u)\big) \right\}. Vk+1(x)=u∈Umin{g(x,u)+γVk(f(x,u))}. - 策略迭代:先固定策略求解值函数,再根据值函数改进策略,交替迭代直到最优策略收敛。其过程可分为策略评估和策略改进两个步骤。

三、贝尔曼方程的数学推导

3.1 最优性原理

贝尔曼最优性原理指出,对于任意最优策略 π ∗ \pi^* π∗ 和任意状态 x x x,总有:

V ∗ ( x ) = min u ∈ U { g ( x , u ) + V ∗ ( f ( x , u ) ) } . V^*(x) = \min_{u \in \mathcal{U}} \left\{ g(x, u) + V^*\big(f(x, u)\big) \right\}. V∗(x)=u∈Umin{g(x,u)+V∗(f(x,u))}.

直观地说,最优策略在任一状态下做出的决策都必须保证从当前状态到终端状态的总成本最小。

3.2 离散时间问题中的贝尔曼方程

对于离散时间动态规划问题,设 N N N 为决策阶段数,终端代价函数为 h ( x ) h(x) h(x)。贝尔曼方程可写为:

- 终端条件: V N ( x ) = h ( x ) V_N(x) = h(x) VN(x)=h(x);

- 递归关系:

V k ( x ) = min u ∈ U { g ( x , u ) + V k + 1 ( f ( x , u ) ) } , k = 0 , 1 , … , N − 1. V_k(x) = \min_{u \in \mathcal{U}} \left\{ g(x, u) + V_{k+1}\big(f(x, u)\big) \right\}, \quad k=0,1,\dots,N-1. Vk(x)=u∈Umin{g(x,u)+Vk+1(f(x,u))},k=0,1,…,N−1.

通过从终端向前递归求解 V k ( x ) V_k(x) Vk(x),最终可得初始状态下的最优代价 V 0 ( x ( 0 ) ) V_0(x(0)) V0(x(0)) 以及对应的最优策略。

3.3 无穷时域折扣动态规划

在无穷时域问题中,为了保证值函数有限,引入折扣因子 γ ∈ ( 0 , 1 ) \gamma \in (0,1) γ∈(0,1),贝尔曼方程写为:

V ( x ) = min u ∈ U { g ( x , u ) + γ V ( f ( x , u ) ) } . V(x) = \min_{u \in \mathcal{U}} \left\{ g(x, u) + \gamma V\big(f(x, u)\big) \right\}. V(x)=u∈Umin{g(x,u)+γV(f(x,u))}.

这种形式广泛应用于强化学习(如 Q-learning)和最优控制问题中。

四、动态规划在控制与决策中的应用

4.1 最优控制问题

动态规划是求解最优控制问题的理论基石。在连续时间最优控制问题中,贝尔曼方程演化为哈密尔顿-雅可比-贝尔曼(Hamilton–Jacobi–Bellman, HJB)方程,而在离散时间中则采用上述离散贝尔曼方程。利用动态规划方法,可以针对线性和非线性系统设计最优控制律。

4.2 强化学习与最优策略求解

在强化学习中,智能体通过与环境的交互,利用贝尔曼方程更新状态值函数或动作值函数,从而获得最优策略。Q-learning、SARSA 等算法均基于贝尔曼方程的思想,实现对最优策略的在线学习。

4.3 资源分配与调度问题

动态规划方法在资源分配、生产调度、路径规划等决策问题中同样发挥着重要作用。通过将复杂问题分解为一系列子问题,动态规划能够求解全局最优解,为实际工程中的调度问题提供有效方案。

五、数值求解与算法实现

5.1 值迭代算法

值迭代是求解贝尔曼方程最直观的方法,其基本步骤如下:

- 初始化值函数 V 0 ( x ) V_0(x) V0(x)(通常取为零或任意初始值)。

- 对每个状态 x x x,更新:

V k + 1 ( x ) = min u ∈ U { g ( x , u ) + γ V k ( f ( x , u ) ) } . V_{k+1}(x) = \min_{u \in \mathcal{U}} \left\{ g(x, u) + \gamma V_k\big(f(x, u)\big) \right\}. Vk+1(x)=u∈Umin{g(x,u)+γVk(f(x,u))}. - 重复迭代直到 V k V_k Vk 收敛至某一容差范围内。

5.2 策略迭代算法

策略迭代包括策略评估和策略改进两个步骤:

- 策略评估:固定策略 π \pi π,求解值函数 V π ( x ) V^\pi(x) Vπ(x) 使得

V π ( x ) = g ( x , π ( x ) ) + γ V π ( f ( x , π ( x ) ) ) . V^\pi(x) = g(x, \pi(x)) + \gamma V^\pi\big(f(x, \pi(x))\big). Vπ(x)=g(x,π(x))+γVπ(f(x,π(x))). - 策略改进:更新策略为

π new ( x ) = arg min u ∈ U { g ( x , u ) + γ V π ( f ( x , u ) ) } . \pi_{\text{new}}(x) = \arg\min_{u \in \mathcal{U}} \left\{ g(x, u) + \gamma V^\pi\big(f(x, u)\big) \right\}. πnew(x)=argu∈Umin{g(x,u)+γVπ(f(x,u))}. - 重复上述过程直到策略收敛。

5.3 算法实现中的注意事项

- 状态空间离散化:在实际数值求解中,连续状态空间常需要离散化,从而构造状态网格。

- 计算复杂度:动态规划可能面临“维数灾难”,高维问题计算量呈指数级增长。

- 折扣因子选择:折扣因子 γ \gamma γ 的选择直接影响值函数的收敛性和策略的质量。

六、典型案例分析

为了更直观地说明动态规划与贝尔曼方程的应用,下面介绍三个典型案例。

6.1 案例一:最短路径问题

6.1.1 案例描述

最短路径问题是动态规划最经典的应用之一。在一个图中,节点代表状态,边的权重代表转移代价,目标是从起始节点找到一条到达目标节点的最短路径。贝尔曼方程在此问题中的表达为:

V ( i ) = min j ∈ neighbors ( i ) { c ( i , j ) + V ( j ) } , V(i) = \min_{j \in \text{neighbors}(i)} \{ c(i,j) + V(j) \}, V(i)=j∈neighbors(i)min{c(i,j)+V(j)},

其中 c ( i , j ) c(i,j) c(i,j) 为从节点 i i i 到节点 j j j 的代价。

6.1.2 分析结论

利用动态规划求解最短路径问题可以确保全局最优性,且算法复杂度较低(如 Dijkstra 算法便是其中一种高效实现)。

6.2 案例二:库存控制问题

6.2.1 案例描述

在库存管理中,需要在满足需求的前提下,最小化库存持有和缺货成本。设库存状态为 x x x,订购量为 u u u,库存转移方程为

x ( k + 1 ) = x ( k ) + u ( k ) − d ( k ) , x(k+1)=x(k)+u(k)-d(k), x(k+1)=x(k)+u(k)−d(k),

其中 d ( k ) d(k) d(k) 为需求量。目标是通过动态规划确定最优订购策略,使得总成本最小。

6.2.2 分析结论

通过构造贝尔曼方程,可以求得不同库存状态下的最优订购量,从而有效降低库存成本并提高服务水平。

6.3 案例三:机器人路径规划

6.3.1 案例描述

在机器人路径规划中,动态规划被用于求解机器人从起点到终点的最优路径问题。状态为机器人的位置,转移代价可由路径长度或能耗决定。贝尔曼方程为:

V ( x ) = min u ∈ U ( x ) { c ( x , u ) + V ( f ( x , u ) ) } . V(x) = \min_{u \in \mathcal{U}(x)} \{ c(x,u) + V\big(f(x,u)\big) \}. V(x)=u∈U(x)min{c(x,u)+V(f(x,u))}.

6.3.2 分析结论

利用动态规划方法,机器人可实现全局最优路径规划,并在面对障碍和复杂环境时具有较好的鲁棒性。

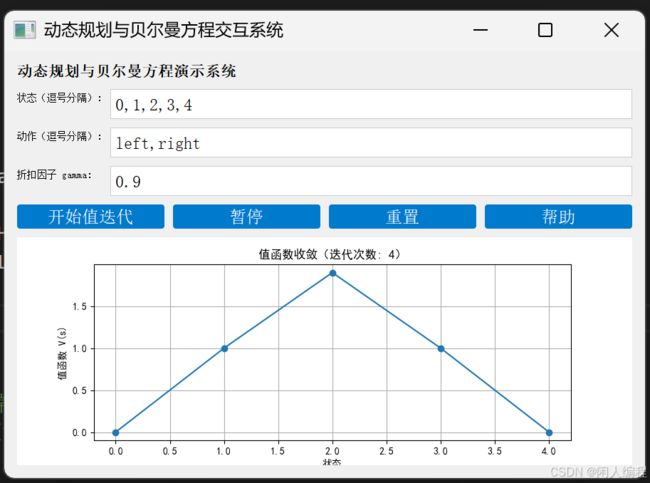

七、基于 PyQt6 的交互式 GUI 演示

为了帮助工程师和研究者更直观地理解动态规划与贝尔曼方程的数值求解过程,我们设计了一套基于 Python 与 PyQt6 的交互式 GUI 系统。该系统主要功能包括:

- 参数输入:用户可以通过文本框输入状态空间的离散化参数、奖励函数以及折扣因子等。

- 算法选择:支持值迭代和策略迭代两种求解方法。

- 实时仿真:动态绘制值函数随迭代次数的变化曲线和最优策略图示。

- 交互控制:提供开始、暂停、重置等按钮,用户可以在线调整参数并观察算法收敛过程。

- 帮助说明:内置帮助按钮,详细解释动态规划与贝尔曼方程的原理、公式推导及算法实现。

7.1 系统架构说明

系统主要分为以下几个模块:

- 参数输入模块:负责获取初始状态、奖励函数、折扣因子等基本参数。

- 动态规划模块:基于值迭代或策略迭代算法求解贝尔曼方程,并实时更新值函数。

- 绘图模块:利用 Matplotlib 动态绘制值函数收敛过程和最优策略示意图。

- 控制模块:实现开始、暂停、重置等操作,便于用户控制仿真进程。

7.2 Python 代码实现

以下给出基于 PyQt6 的交互式 GUI 系统代码示例,代码中附有详细注释,确保逻辑清晰且易于理解。

"""

动态规划与贝尔曼方程交互式演示系统

本程序基于 PyQt6 实现了一个交互式动态规划系统,

用户可输入状态离散化参数、奖励函数、折扣因子等,

并选择值迭代算法求解贝尔曼方程,实时观察值函数的收敛过程。

作者:控制与优化算法100讲

日期:2025-04-02

"""

import sys

import numpy as np

import matplotlib.pyplot as plt

from matplotlib.backends.backend_qt5agg import FigureCanvasQTAgg as FigureCanvas

from PyQt5.QtWidgets import (

QApplication, QMainWindow, QWidget, QVBoxLayout, QHBoxLayout,

QLabel, QPushButton, QLineEdit, QMessageBox, QFormLayout, QTabWidget

)

from PyQt5.QtCore import QTimer

# ------------------------- 动态规划求解(值迭代)函数 -------------------------

def value_iteration(states, actions, transition_prob, reward, gamma, theta=1e-6):

"""

使用值迭代算法求解贝尔曼方程

参数:

states: 状态列表

actions: 动作列表

transition_prob: 转移概率字典,格式 {(s, a, s'): probability}

reward: 奖励函数字典,格式 {(s, a, s'): reward}

gamma: 折扣因子

theta: 收敛阈值

返回:

V: 值函数字典,格式 {s: value}

policy: 最优策略字典,格式 {s: optimal_action}

"""

V = {s: 0 for s in states}

policy = {s: actions[0] for s in states}

while True:

delta = 0

for s in states:

v = V[s]

action_values = {}

for a in actions:

action_value = 0

for s_prime in states:

prob = transition_prob.get((s, a, s_prime), 0)

r = reward.get((s, a, s_prime), 0)

action_value += prob * (r + gamma * V[s_prime])

action_values[a] = action_value

V[s] = min(action_values.values()) # 求最小化代价

delta = max(delta, abs(v - V[s]))

if delta < theta:

break

# 根据最终值函数求最优策略

for s in states:

action_values = {}

for a in actions:

action_value = 0

for s_prime in states:

prob = transition_prob.get((s, a, s_prime), 0)

r = reward.get((s, a, s_prime), 0)

action_value += prob * (r + gamma * V[s_prime])

action_values[a] = action_value

policy[s] = min(action_values, key=action_values.get)

return V, policy

# ------------------------- GUI 交互界面实现 -------------------------

class DPWidget(QWidget):

"""

动态规划与贝尔曼方程交互式界面

用户可输入状态、动作、转移概率、奖励、折扣因子等参数,

并采用值迭代求解贝尔曼方程,实时显示值函数收敛曲线

"""

def __init__(self):

super().__init__()

self.initUI()

self.timer = QTimer(self)

self.timer.timeout.connect(self.iterate_dp)

self.simulation_running = False

self.iteration = 0

def initUI(self):

layout = QVBoxLayout()

title = QLabel("动态规划与贝尔曼方程演示系统

")

layout.addWidget(title)

# 参数输入区域(此处简化为离散状态和动作)

form_layout = QFormLayout()

self.states_edit = QLineEdit("0,1,2,3,4")

self.actions_edit = QLineEdit("left,right")

self.gamma_edit = QLineEdit("0.9")

form_layout.addRow("状态(逗号分隔):", self.states_edit)

form_layout.addRow("动作(逗号分隔):", self.actions_edit)

form_layout.addRow("折扣因子 gamma:", self.gamma_edit)

layout.addLayout(form_layout)

# 按钮区域

btn_layout = QHBoxLayout()

self.start_btn = QPushButton("开始值迭代")

self.start_btn.clicked.connect(self.start_dp)

self.pause_btn = QPushButton("暂停")

self.pause_btn.clicked.connect(self.pause_dp)

self.reset_btn = QPushButton("重置")

self.reset_btn.clicked.connect(self.reset_dp)

self.help_btn = QPushButton("帮助")

self.help_btn.clicked.connect(self.show_help)

btn_layout.addWidget(self.start_btn)

btn_layout.addWidget(self.pause_btn)

btn_layout.addWidget(self.reset_btn)

btn_layout.addWidget(self.help_btn)

layout.addLayout(btn_layout)

# Matplotlib 绘图区域

self.figure, self.ax = plt.subplots(figsize=(8, 4))

self.canvas = FigureCanvas(self.figure)

layout.addWidget(self.canvas)

self.setLayout(layout)

self.setStyleSheet("""

QLabel { font-size: 14px; }

QLineEdit { padding: 4px; border: 1px solid #ccc; }

QPushButton { background-color: #007acc; color: white; padding: 5px 10px; border-radius: 4px; }

QPushButton:hover { background-color: #3399ff; }

""")

def show_help(self):

help_text = (

"【帮助说明】\n\n"

"1. 在“状态”文本框中输入所有状态,用逗号分隔,例如:0,1,2,3,4\n"

"2. 在“动作”文本框中输入所有可选动作,用逗号分隔,例如:left,right\n"

"3. 在“折扣因子 gamma”中输入一个折扣因子(0到1之间),例如:0.9\n"

"4. 本示例中,转移概率和奖励采用预设值(示例中简单定义),\n"

" 值迭代算法将计算各状态下的最优值函数,并动态绘制收敛曲线。"

)

QMessageBox.information(self, "帮助", help_text)

def start_dp(self):

try:

self.states = [int(s.strip()) for s in self.states_edit.text().split(",")]

self.actions = [a.strip() for a in self.actions_edit.text().split(",")]

self.gamma = float(self.gamma_edit.text())

except Exception as e:

QMessageBox.warning(self, "输入错误", f"参数输入错误:{e}")

return

# 构造简单的转移概率与奖励(此处为示例)

# 假设状态转移为:执行“right”时状态+1,执行“left”时状态-1,边界处不变

self.transition_prob = {}

self.reward = {}

for s in self.states:

for a in self.actions:

for s_next in self.states:

if a == "right":

if s < max(self.states) and s_next == s+1:

self.transition_prob[(s, a, s_next)] = 1.0

self.reward[(s, a, s_next)] = 1 # 奖励为1

elif s == max(self.states) and s_next == s:

self.transition_prob[(s, a, s_next)] = 1.0

self.reward[(s, a, s_next)] = 0

elif a == "left":

if s > min(self.states) and s_next == s-1:

self.transition_prob[(s, a, s_next)] = 1.0

self.reward[(s, a, s_next)] = 1

elif s == min(self.states) and s_next == s:

self.transition_prob[(s, a, s_next)] = 1.0

self.reward[(s, a, s_next)] = 0

self.V, self.policy = value_iteration(self.states, self.actions, self.transition_prob, self.reward, self.gamma)

self.iteration = 0

self.plot_values()

if not self.simulation_running:

self.simulation_running = True

self.timer.start(1000)

def iterate_dp(self):

# 这里简单模拟多次迭代后值函数变化(实际值迭代已在 start_dp 中收敛)

self.iteration += 1

self.V, self.policy = value_iteration(self.states, self.actions, self.transition_prob, self.reward, self.gamma)

self.plot_values()

if self.iteration > 10:

self.pause_dp()

def plot_values(self):

self.ax.clear()

states = self.states

values = [self.V[s] for s in states]

self.ax.plot(states, values, marker='o')

self.ax.set_xlabel("状态")

self.ax.set_ylabel("值函数 V(s)")

self.ax.set_title(f"值函数收敛(迭代次数: {self.iteration})")

self.ax.grid(True)

self.canvas.draw()

def pause_dp(self):

self.simulation_running = False

self.timer.stop()

def reset_dp(self):

self.pause_dp()

self.states_edit.setText("")

self.actions_edit.setText("")

self.gamma_edit.setText("")

self.ax.clear()

self.canvas.draw()

# ------------------------- 主窗口 -------------------------

class DPMainWindow(QMainWindow):

def __init__(self):

super().__init__()

self.setWindowTitle("动态规划与贝尔曼方程交互系统")

self.setGeometry(100, 100, 900, 600)

self.initUI()

def initUI(self):

self.dp_widget = DPWidget()

self.setCentralWidget(self.dp_widget)

# ------------------------- 主函数 -------------------------

def main():

app = QApplication(sys.argv)

window = DPMainWindow()

window.show()

sys.exit(app.exec())

if __name__ == "__main__":

main()

八、结语

本文系统地介绍了动态规划与贝尔曼方程的基本原理和应用。从理论角度,我们阐述了如何利用贝尔曼最优性原理将复杂的多阶段决策问题分解为子问题,并通过值迭代和策略迭代算法求解最优值函数;从应用角度,通过最短路径、库存控制和机器人路径规划等案例,展示了动态规划在实际工程和决策问题中的广泛应用。此外,为了帮助工程师和研究者直观理解这一方法,本文还提供了一套基于 Python 与 PyQt6 的交互式 GUI 演示系统代码示例,用户可在线调节参数,观察值函数的收敛过程和最优策略的变化,从而加深对动态规划及贝尔曼方程的理解。

随着最优控制、强化学习和运筹学的发展,动态规划与贝尔曼方程在现代决策和控制中的作用将越来越重要。希望本文能为广大控制工程师、自动化专家及科研工作者提供有价值的理论指导和实践参考,激发更多对动态规划算法在复杂系统中应用的深入探索与创新。

温馨提示:

- 本文中所用的模型和示例均为简化版本,实际问题可能需要更精细的状态空间离散化和复杂的奖励设计。

- 提供的 GUI 演示代码经过初步自查,如在运行过程中遇到问题,请检查 Python 环境和 PyQt6 版本。

- 欢迎广大读者结合实际工程需求对本文内容进行扩展和优化,共同推动动态规划及贝尔曼方程在各领域中的深入应用。

以上即为本篇关于 动态规划与贝尔曼方程 的完整博客文章。希望本文能帮助您深入理解动态规划的核心原理及贝尔曼方程的数学基础,并在实际工程和决策问题中获得有益启示。