银行业双活数据中心-F5在双活数据中心中的应用

随着移动互联、云计算及大数据等新技术与应用的飞速增长,金融机构对于数据中心的依赖程度也在日益加强,7*24全天业务连续运营已经成为核心关键业务的最基本需求之一。同时随着国家法规的不断健全,同城灾备、两地三中心以及多数据中心正在成为银行的标配。正常情况下,主中心和备中心各司其职,发生灾难时,主数据中心宕机、备份数据中心可以快速恢复数据和应用,从而减轻因灾难给用户带来的损失。但是,灾备中心建设的投资巨大及每年高昂的运维成本,加之其灾备的角色,往往成为了企业的闲置资源,进而变成了“空转”数据中心。

另一方面,随着微博、微信等互联网公司纷纷拿到国家支付牌照。支付宝的金融产品也已在年轻用户间取得了极大的进展……互联网金融化正在以其雄厚的IT技术与多样化的应用不断的向传统金融业渗透。如何盘活闲置资源,如何更好、更高效的发挥先有数据中心,使其不仅在必要时进行灾备,同时可以在闲时提升企业核心应用的效率,成为了每个金融业CIO共同关心的话题。

作为应用交付领域的长期领导者,F5于日前推出了其革命性基于软件定应用服务(SDAS)的新融合架构(Synthesis) ,旨在促进数据中心、云和混合环境中应用服务的交付和协调。通过部署F5的解决方案,用户的基础架构将具备全面的设备灵活性和弹性,可智能分配资源,支持在物理和虚拟解决方案之间按需扩展系统。与其他方式不同,F5可向特定应用、服务或实例分配专用资源,能够支持企业动态管理资源。因此,IT 管理员可自由地部署高度灵活的系统,根据应用要求将资源扩展至任何云或数据中心,并在不需要时快速回收这些资源。与此同时,用户将能够根据业务策略智能地利用资源,并可将应用交付服务与新兴 SDN、云及网络虚拟化计划相结合。通过这种方式,采用双活数据中心,甚至两地三中心网络架构的用户,不仅可以更高效的盘活资源提高投资回报率,更可以在容灾备份时,真正达到分钟级的全面切换、甚至是“一键切换”,使应用真正的安全、快速、高可用。

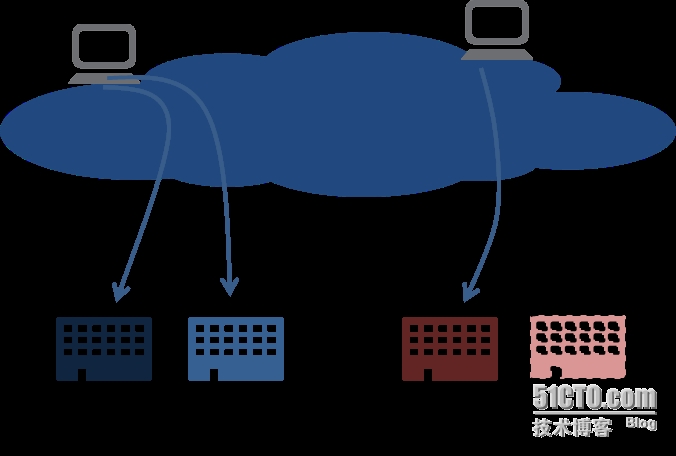

双活数据中心区别于传统主备数据中心,前者是两个数据中心都处于运行当中、都有实时交易的业务,且互为备份,所以称为“双活”;后者是一个数据中心投入运行,另外一个数据中心处于非工作状态,只有当灾难发生时,生产数据中心瘫痪,灾备中心才会启动。

双活数据中心有二个最大的特点。一是有效利用资源,避免了一个数据中心长期处于闲置状态而造成浪费。通过资源整合与有效负载,双活数据中心的服务能力远远高于单活数据中心。二是在一个数据中心发生故障时,另外一个数据中心还在运行,对用户提供不间断的业务,保证用户体验与业务持续性。而一个灾备中心的模式,如果生产数据中心瘫痪,需要半个小时、两个小时、甚至更长时间才能启动灾备中心,在启动灾备中心的时间里,用户交易会严重受损。

在国内的商业银行当中,部署了双活数据中心的银行还为数甚少,光大银行是最早开始这方面探索的银行之一。光大银行灾备体系是典型的“两地三中心”模式,目前在北京有两个规模相当的双活中心,在武汉有一个异地灾备中心。

光大银行的双活数据中心的模式始建于2002年。当时还没有出现云计算的概念,但是这个思路和今天云计算的思路不谋而合。“云”的目的就是把数据中心的所有资源整合成一个资源,成为一朵云。双活数据中心的效果也是一样的。而在这种数据中心双活的模式下,对网络的灵活性要求就会更高:如何实现数据中心间的流量负载与业务的冗余?怎么将用户定位到最近、响应最快的数据中心?如何实现双活数据中心业务的灵活切换?这些问题成为基础网络架构面临的主要问题。在此,我们只针对双活数据中心使用F5 GTM与LTM实现应用交付进行介绍,包括双活数据中心互联网业务负载均衡与双活数据中内部应用跨中心的负载均衡。

双活数据中心互联网业务负载均衡与冗余的设计

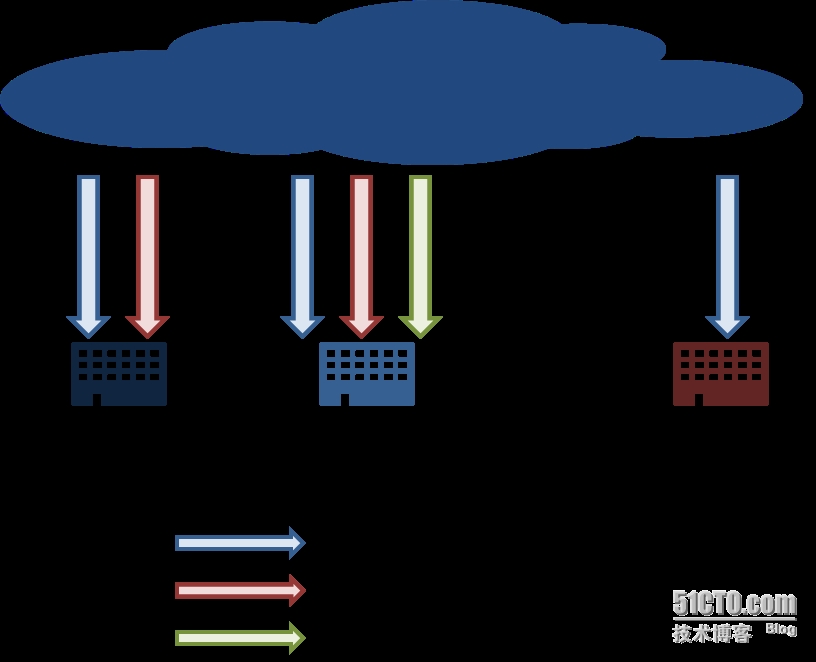

互联网的负载均衡目前比较成熟的方式是DNS智能解析和路由注入,在此主要讨论第一种方式即通过F5 GTM的DNS智能解析在数据中心之间如何实现流量负载与冗余。DNS智能解析的思路是在DNS服务器中动态维持几个后台数据中心的出口IP地址,针对用户请求按照算法返回最适合的出口IP。如果其中一个数据中心出口出现问题,DNS服务器便将其对应的IP地址暂停使用,并将后续的用户DNS请求引导到其他仍在正常工作的数据中心出口,从在广域网上实现后台资源的负载均衡。

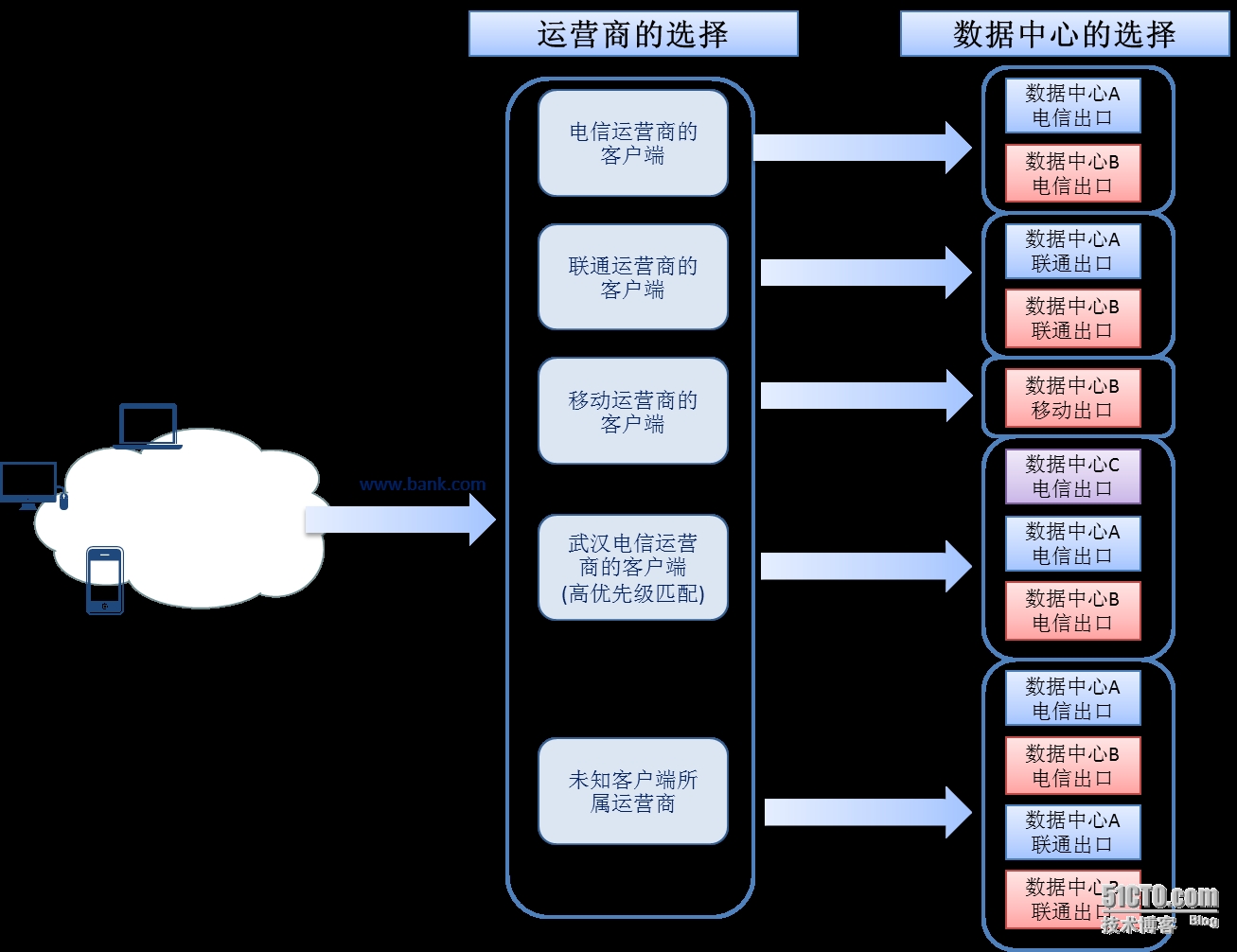

在金融行业的“两地三中心”数据中心模式下,每个数据中心为互联网业务提供多个互联网接口,北京数据中心A包含电信出口与联通出口;北京数据中心B包含电信出口、联通出口和移动出口;武汉数据中心C包含电信出口。北京数据中心A与北京数据中心B为同城双活数据中心,武汉数据中心为灾备数据中心,同时武汉数据中心C也发布部分互联网业务。

在DNS智能解析选择出口时,不仅需要考虑哪个数据中心距离用户较近,还要考虑跨运营商网络限制的问题,目前国内主要的电信运营商有电信、网通、移动三大运营商,跨运营商的访问往往很慢,最好的方式是将客户流量定向到与客户端相同运营商的数据中心。

同时考虑地域就近性原则,将南方电信客户定向到武汉数据中心电信出口。将北方电信客户定向到北京数据中心电信出口;同运营商的两个数据中心的选择依据是RTT(Round Trip Time)算法:在每个数据中心对客户端进行反向探测,根据探测响应结果进行选择。

最终形成两层逻辑算法的DNS智能解析方式:首先根据互联网客户端所属运营商选择满足条件的数据中心,再根据客户端与数据中心间网络链路质量选择数据中心链路,从而将客户端端定向到最合适的数据中心出口。

双活数据中心内部应用跨中心的负载均衡与冗余设计

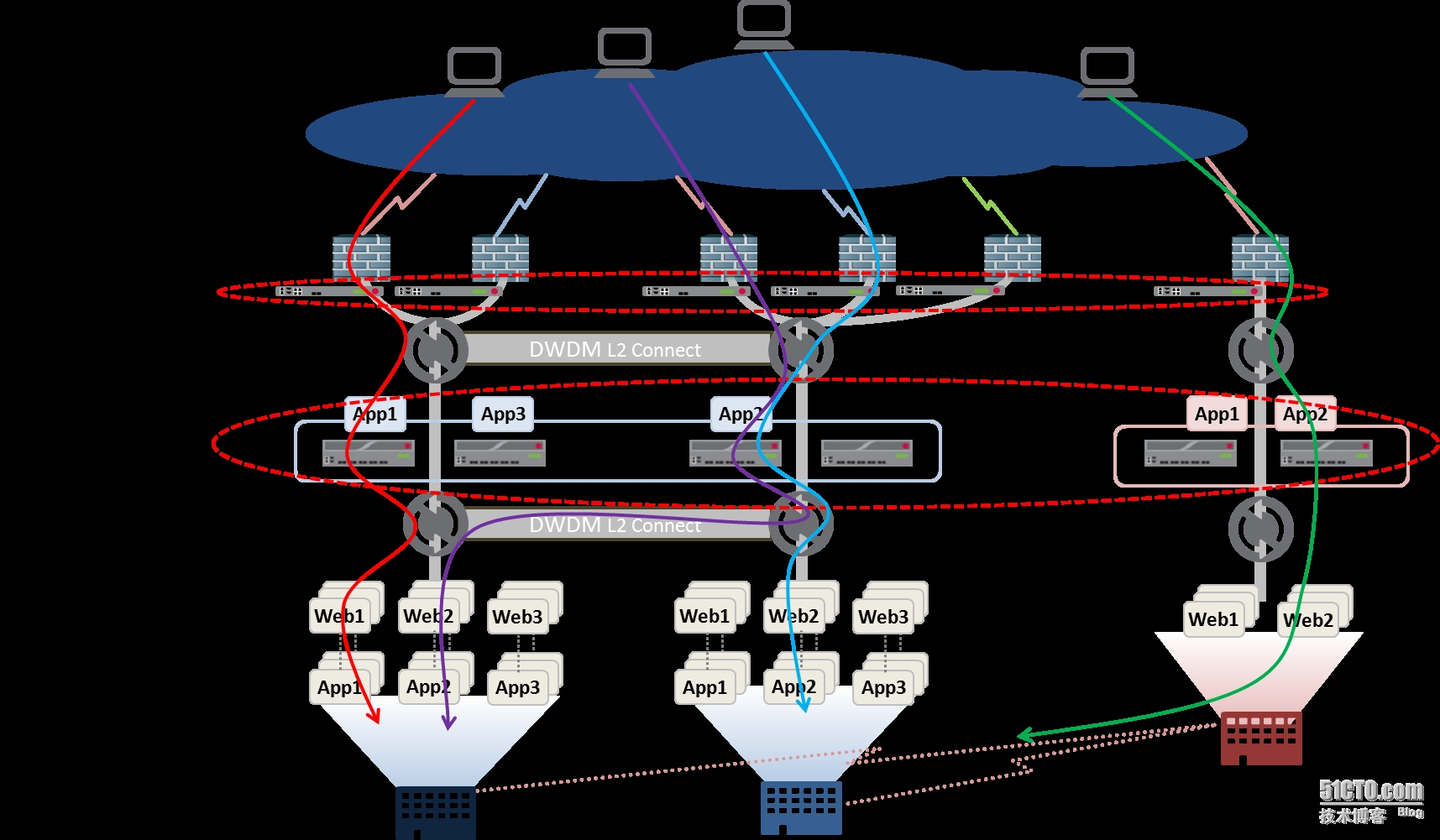

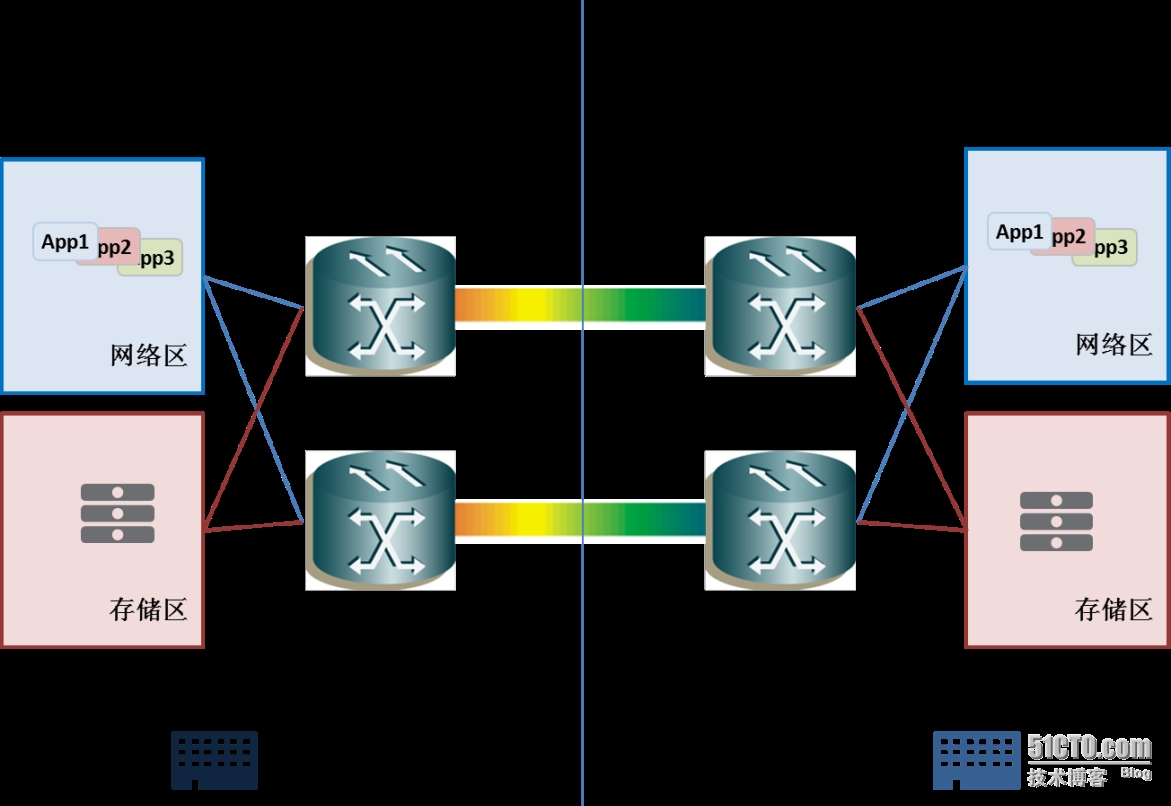

数据中心的双活通过Cisco DWDM(密集波分多路复用)设备之间的连接实现,对两个数据中心之间的互连设备而言,DWDM是透明的,等同于使用光纤直接连接。利用DWDM设备,实现了两个数据中心间同网段二层vlan互通,紧密结合了目前云计算中的“大二层”的概念。

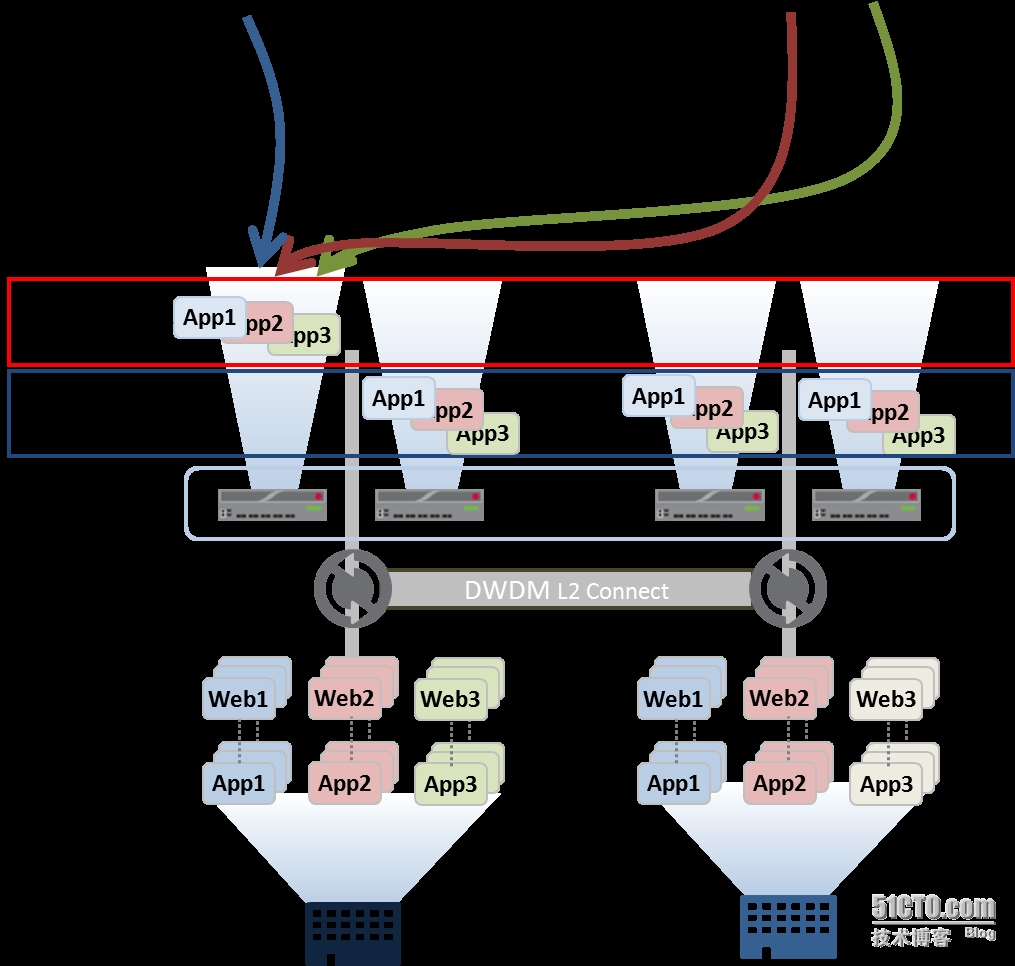

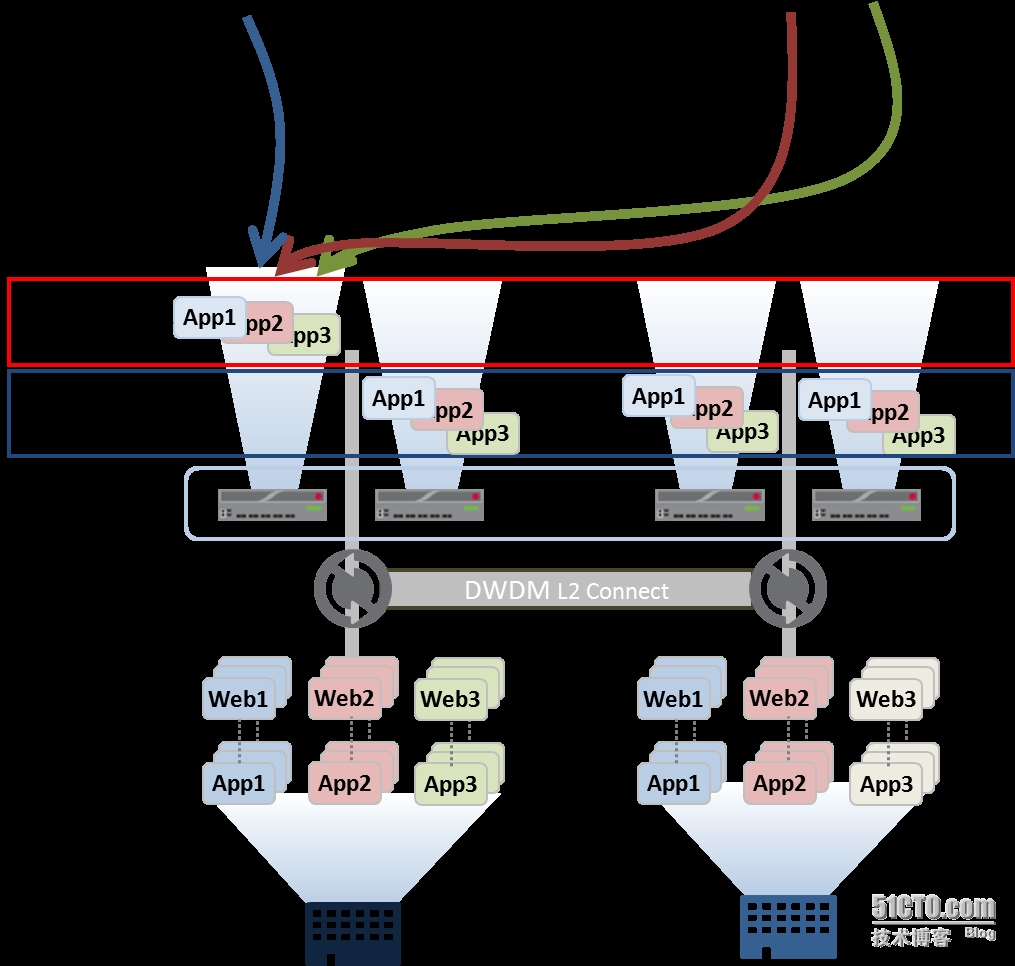

每个应用系统的服务器可以按需部署在两个的数据中心内,而且不必关心所处的物理位置。通过负载均衡设备,对分布在两个数据中心的系统进行流量负载,在某台系统服务器产生故障时,负载均衡设备可以将客户流量转发至其他服务器上。但在这种模式下,虽然业务系统分布在两个数据中心,但由于负载均衡设备的主备模式,业务流量还需要汇聚到主负载均衡设备上再转发至两个数据中心的服务器上,同时服务器的回复流量也需要汇聚至主负载均衡设备上再转回给客户端,这样不仅增加了业务数据流的复杂度与风险集中化。同时在主设备发生故障需要切换时候,业务数据流会跟随负载均衡系统一同切换至另外的数据中心。为了避免上述问题带来的影响,产生了负载均衡设备的“2+2结构”:即同中心两台负载均衡设备为主备模式,另外数据中心为冷备的A。这种情况下,当一台设备产生故障优先在本中心内部主备切换,当两台设备都有问题的情况下才会切换至第二数据中心。

但不论上述那种方式,真正发布服务的只有一台设备,这样导致即使是双活数据中心,数据仍需要汇聚至Active设备上,加剧了风险集中。同时设备利用率低,处于冷备的Active+Standy两台设备切换也需要人为干预,不能在设备或者业务出现问题时候自动切换。

F5负载均衡系统的新版本支持N+M Cluster多活的架构,在同一个Group中的负载均衡设备可以自由分配“Active”与“Standby”比例,且可以指定Group中多台负载均衡设备的接管顺序,这种模式完全解决了2+2模式下冷备的两台设备利用率低的问题。同时可以将应用发布在不同的Active的设备上,在设备出现故障的时候指定同数据中心的负载均衡设备优先接管,带来的好处是双活数据中心业务不再集中化,不必将所有业务流量都汇聚至一个数据中心再分发。避免了风险集中同时均衡两个数据中心间的业务流量。

通过F5 GTM与LTM实现的应用交付网络,在数据中心之间实现灵活的流量负载与无缝切换,在数据中心内部实现智能的流量管理与分配。GTM的双层逻辑算法,不仅为客户选择用户体验最佳的数据中心互联网接口,也同时对互联网流量进行负载均衡至多个数据中心。当某个数据中心互联网接口故障时候,能够立即将客户流量引导至次优的数据中心互联网接口。在数据中心内部,利用LTM对应用系统进行智能流量分配与管理,新的“N+M”clustr架构不仅解决了应用集中风险问题,同时提供灵活应用部署与无缝的业务切换,为双活数据中心的应用交付网络再添活力。

在F5看来,任何IT资产的闲置,不仅是企业的巨大浪费,同时也会对其商业模式的发展与转换产生制约,数据中心尤其如此。双活、多活数据中心不仅可以盘活企业闲置资源,同时可以帮助金融机构在业内与业外的双重竞争压力下,不断发展更多优良的业务,吸引用户。开源与节流的双管齐下,才能使得传统金融行业在金融网络化的道路上越走越远。