分类算法

本文总结了数据挖掘以及机器学习中常见算法如神经网络算法、随机森林算法以及决策树等,希望能对数据挖掘爱好者有一定帮助。

BP神经网络

BP网络能学习和存贮大量的输入-输出模式映射关系,而无需事前揭示描述这种映射关系的数学方程。它的学习规则是使用最速下降法,通过反向传播来不断调整网络的权值和阈值,使网络的误差平方和最小。BP神经网络模型拓扑结构包括输入层(input)、隐层(hidelayer)和输出层(outputlayer)。BP神经网络算法是在BP神经网络现有算法的基础上提出的,是通过任意选定一组权值,将给定的目标输出直接作为线性方程的代数和来建立线性方程组,解得待求权,不存在传统方法的局部极小及收敛速度慢的问题,且更易理解。

其基本思想是:由所给的输入、输出模式对通过作用于神经网络来建立线性方程组,运用高斯消元法解线性方程组来求得未知权值,而未采用传统BP网络的非线性函数误差反馈寻优的思想。

对给定的样本模式对,随机选定一组自由权,作为输出层和隐含层之间固定权值,通过传递函数计算隐层的实际输出,再将输出层与隐层间的权值作为待求量,直接将目标输出作为等式的右边建立方程组来求解。

决策树

简介

项目风险,判断其可行性的决策分析方法,是直观运用概率分析的一种图解法。由于这种决策分支画成图形很像一棵树的枝干,故称决策树。在机器学习中,决策树是一个预测模型,他代表的是对象属性与对象值之间的一种映射关系。Entropy=系统的凌乱程度,使用算法ID3, C4.5和C5.0生成树算法使用熵。这一度量是基于信息学理论中熵的概念。

决策树是一种树形结构,其中每个内部节点表示一个属性上的测试,每个分支代表一个测试输出,每个叶节点代表一种类别。

分类树(决策树)是一种十分常用的分类方法。他是一种监管学习,所谓监管学习就是给定一堆样本,每个样本都有一组属性和一个类别,这些类别是事先确定的,那么通过学习得到一个分类器,这个分类器能够对新出现的对象给出正确的分类。这样的机器学习就被称之为监督学习。

组成

□——决策点,是对几种可能方案的选择,即最后选择的最佳方案。如果决策属于多级决策,则决策树的中间可以有多个决策点,以决策树根部的决策点为最终决策方案。

○——状态节点,代表备选方案的经济效果(期望值),通过各状态节点的经济效果的对比,按照一定的决策标准就可以选出最佳方案。由状态节点引出的分支称为概率枝,概率枝的数目表示可能出现的自然状态数目每个分枝上要注明该状态出现的概率。

△——结果节点,将每个方案在各种自然状态下取得的损益值标注于结果节点的右端。

画法

机器学习中,决策树是一个预测模型;他代表的是对象属性与对象值之间的一种映射关系。树中每个节点表示某个对象,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。决策树仅有单一输出,若欲有复数输出,可以建立独立的决策树以处理不同输出。数据挖掘中决策树是一种经常要用到的技术,可以用于分析数据,同样也可以用来作预测。

从数据产生决策树的机器学习技术叫做决策树学习,通俗说就是决策树。

一个决策树包含三种类型的节点:

决策节点:通常用矩形框来表示

机会节点:通常用圆圈来表示

终结点:通常用三角形来表示

决策树学习也是资料探勘中一个普通的方法。在这里,每个决策树都表述了一种树型结构,它由它的分支来对该类型的对象依靠属性进行分类。每个决策树可以依靠对源数据库的分割进行数据测试。这个过程可以递归式的对树进行修剪。当不能再进行分割或一个单独的类可以被应用于某一分支时,递归过程就完成了。另外,随机森林分类器将许多决策树结合起来以提升分类的正确率。

决策树同时也可以依靠计算条件概率来构造。

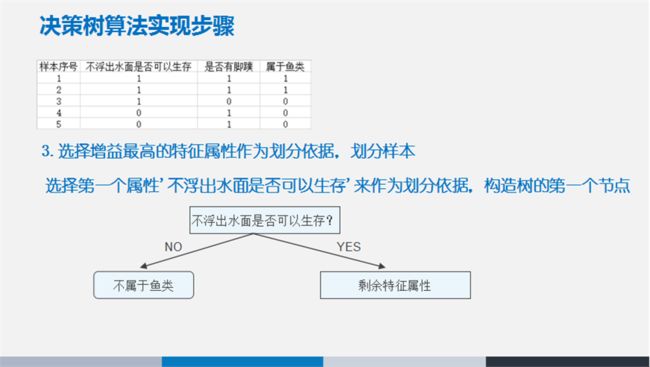

决策树如果依靠数学的计算方法可以取得更加理想的效果。数据库已如下所示:

(x,y)=(x1,x2,x3…,xk,y)

相关的变量Y表示我们尝试去理解,分类或者更一般化的结果。其他的变量x1,x2,x3等则是帮助我们达到目的的变量。

决策树实际上是将空间用超平面进行划分的一种方法,每次分割的时候,都将当前的空间一分为二,比如说下面的决策树:

就是将空间划分成下面的样子:

决策树的剪枝

剪枝是决策树停止分支的方法之一,剪枝有分预先剪枝和后剪枝两种。预先剪枝是在树的生长过程中设定一个指标,当达到该指标时就停止生长,这样做容易产生“视界局限”,就是一旦停止分支,使得节点N成为叶节点,就断绝了其后继节点进行“好”的分支操作的任何可能性。不严格的说这些已停止的分支会误导学习算法,导致产生的树不纯度降差最大的地方过分靠近根节点。后剪枝中树首先要充分生长,直到叶节点都有最小的不纯度值为止,因而可以克服“视界局限”。然后对所有相邻的成对叶节点考虑是否消去它们,如果消去能引起令人满意的不纯度增长,那么执行消去,并令它们的公共父节点成为新的叶节点。这种“合并”叶节点的做法和节点分支的过程恰好相反,经过剪枝后叶节点常常会分布在很宽的层次上,树也变得非平衡。后剪枝技术的优点是克服了“视界局限”效应,而且无需保留部分样本用于交叉验证,所以可以充分利用全部训练集的信息。但后剪枝的计算量代价比预剪枝方法大得多,特别是在大样本集中,不过对于小样本的情况,后剪枝方法还是优于预剪枝方法的。

决策树总结

代码实现

Decisiontree.py

from sklearn import tree

x = [[1,1],[1,1],[1,0],[0,1],[0,1]]

y= [1,1,0,0,0]

clf=tree.DecisionTreeClassifier()

clf= clf.fit(x,y)

print clf.predict([[1,1]])

随机森林

树的投票

当你要做预测的时候,新的观察到的特征随着决策树自上而下走下来,这样一组观察到的特征将会被贴上一个预测值/标签。一旦森林中的每棵树都给出了预测值/签,所有的预测结果将被归总到一起,所有树的模式投票被返回做为最终的预测结果。

简单来说,99.9%不相关的树做出的预测结果涵盖所有的情况,这些预测结果将会彼此抵消。少数优秀的树的预测结果将会超脱于芸芸“噪音”,做出一个好的预测。

一个映射的例子

随机森林在没有精心准备的数据映射的情况下也能学习。以方程f(x) = log(x)为例。制造一些假数据,并且加上一点儿噪音。

import numpy as np x = np.random.uniform(1, 100, 1000) y = np.log(x) + np.random.normal(0, .3, 1000)

如果我们建立了一个基本的线性模型通过使用 x 来预测y,我们需要作一条直线,算是平分log (x)函数。而如果我们使用一个随机的森林,它不会更好的逼近 log (x)曲线并能够使得它更像实际函数。

你也许会说随机森林有点扰乱log(x)函数。不管怎样我都认为这做了一个很好的说明如何随机森林并未绑定于线性约束 。

变量选择

随机森林最好的用例之一是特征选择。尝试很多决策树变种的一个副产品就是你可以检测每棵树中哪个变量最合适/最糟糕。

当一棵树使用一个变量,而另一棵不使用这个变量,你就可以从是否包含这个变量来比较价值的减少或增加。优秀的随机森林实现将为你做这些事情,所以你需要做的仅仅是知道去看那个方法或参数。

在下述的例子中,我们尝试去指出对于将酒分为红酒或者白酒哪个变量是最重要的。

回归

随机森林不像其它算法对分类变量或者分类变量和真实变量混合学习的非常好。具有高基数(可能值的#)的分类变量是很棘手的,所以在你的口袋中放点儿这样的东西将会是非常有用的。

随机森林相当容易使用,而且很强大。对于任何建模,都要注意过拟合。如果你有兴趣用R语言开始使用随机森林,那么就签出randomForest包。

代码实现

RandomForest.py

from sklearn.cross_validation import cross_val_score

from sklearn.datasets import make_blobs

from sklearn.ensemble import RandomForestClassifier

x,y=make_blobs(n_samples=10000,n_features=10,centers=100,random_state=0)

clf=RandomForestClassifier(n_estimators=10,max_depth=None,min_samples_split=1,random_state=0)

scores = cross_val_score(clf,x,y)

print scores.mean()

PageRank算法

代码实现

PageRank.py

import networkx as nx

g=nx.DiGraph()

g.add_edge(1,2)

g.add_edge(1,3)

g.add_edge(1,4)

g.add_edge(2,1)

g.add_edge(2,4)

g.add_edge(3,1)

g.add_edge(4,2)

g.add_edge(4,3)

pr=nx.pagerank(g,alpha=0.8)

print pr

K-core

代码实现

Kmeans.py

from numpy import *

import time

import matplotlib.pyplot as plt

# calculate Euclidean distance

def euclDistance(vector1, vector2):

return sqrt(sum(power(vector2 - vector1, 2)))

# init centroids with random samples

def initCentroids(dataSet, k):

numSamples, dim = dataSet.shape

centroids = zeros((k, dim))

for i in range(k):

index = int(random.uniform(0, numSamples))

centroids[i, :] = dataSet[index, :]

return centroids

# k-means cluster

def kmeans(dataSet, k):

numSamples = dataSet.shape[0]

# first column stores which cluster this sample belongs to,

# second column stores the error between this sample and its centroid

clusterAssment = mat(zeros((numSamples, 2)))

clusterChanged = True

## step 1: init centroids

centroids = initCentroids(dataSet, k)

while clusterChanged:

clusterChanged = False

## for each sample

for i in xrange(numSamples):

minDist = 100000.0

minIndex = 0

## for each centroid

## step 2: find the centroid who is closest

for j in range(k):

distance = euclDistance(centroids[j, :], dataSet[i, :])

if distance < minDist:

minDist = distance

minIndex = j

## step 3: update its cluster

if clusterAssment[i, 0] != minIndex:

clusterChanged = True

clusterAssment[i, :] = minIndex, minDist**2

## step 4: update centroids

for j in range(k):

pointsInCluster = dataSet[nonzero(clusterAssment[:, 0].A == j)[0]]

centroids[j, :] = mean(pointsInCluster, axis = 0)

print 'Congratulations, cluster complete!'

return centroids, clusterAssment

# show your cluster only available with 2-D data

def showCluster(dataSet, k, centroids, clusterAssment):

numSamples, dim = dataSet.shape

if dim != 2:

print "Sorry! I can not draw because the dimension of your data is not 2!"

return 1

mark = ['or', 'ob', 'og', 'ok', '^r', '+r', 'sr', 'dr', '<r', 'pr']

if k > len(mark):

print "Sorry! Your k is too large! please contact Zouxy"

return 1

# draw all samples

for i in xrange(numSamples):

markIndex = int(clusterAssment[i, 0])

plt.plot(dataSet[i, 0], dataSet[i, 1], mark[markIndex])

mark = ['Dr', 'Db', 'Dg', 'Dk', '^b', '+b', 'sb', 'db', '<b', 'pb']

# draw the centroids

for i in range(k):

plt.plot(centroids[i, 0], centroids[i, 1], mark[i], markersize = 12)

plt.show()

print "step 1: load data..."

dataSet = []

fileIn = open('C:/Users/Administrator/test/testSet.txt')

for line in fileIn.readlines():

lineArr = line.strip().split('\t')

dataSet.append([float(lineArr[0]), float(lineArr[1])])

## step 2: clustering...

print "step 2: clustering..."

dataSet = mat(dataSet)

k = 4

centroids, clusterAssment = kmeans(dataSet, k)

## step 3: show the result

print "step 3: show the result..."

showCluster(dataSet, k, centroids, clusterAssment)

testSet.txt

1.658985 4.285136

-3.453687 3.424321 4.838138 -1.151539

-5.379713 -3.362104 0.972564 2.924086

-3.567919 1.531611 0.450614 -3.302219

-3.487105 -1.724432 2.668759 1.594842

-3.156485 3.191137 3.165506 -3.999838

-2.786837 -3.099354 4.208187 2.984927

-2.123337 2.943366 0.704199 -0.479481

-0.392370 -3.963704 2.831667 1.574018

-0.790153 3.343144 2.943496 -3.357075

-3.195883 -2.283926 2.336445 2.875106

-1.786345 2.554248 2.190101 -1.906020

-3.403367 -2.778288 1.778124 3.880832

-1.688346 2.230267 2.592976 -2.054368

-4.007257 -3.207066 2.257734 3.387564

-2.679011 0.785119 0.939512 -4.023563

-3.674424 -2.261084 2.046259 2.735279

-3.189470 1.780269 4.372646 -0.822248

-2.579316 -3.497576 1.889034 5.190400

-0.798747 2.185588 2.836520 -2.658556

-3.837877 -3.253815 2.096701 3.886007

-2.709034 2.923887 3.367037 -3.184789

-2.121479 -4.232586 2.329546 3.179764

-3.284816 3.273099 3.091414 -3.815232

-3.762093 -2.432191 3.542056 2.778832

-1.736822 4.241041 2.127073 -2.983680

-4.323818 -3.938116 3.792121 5.135768

-4.786473 3.358547 2.624081 -3.260715

-4.009299 -2.978115 2.493525 1.963710

-2.513661 2.642162 1.864375 -3.176309

-3.171184 -3.572452 2.894220 2.489128

-2.562539 2.884438 3.491078 -3.947487

-2.565729 -2.012114 3.332948 3.983102

-1.616805 3.573188 2.280615 -2.559444

-2.651229 -3.103198 2.321395 3.154987

-1.685703 2.939697 3.031012 -3.620252

-4.599622 -2.185829 4.196223 1.126677

-2.133863 3.093686 4.668892 -2.562705

-2.793241 -2.149706 2.884105 3.043438

-2.967647 2.848696 4.479332 -1.764772

-4.905566 -2.911070 AdaBoost算法

代码实现

AdaBoost.py

from sklearn.cross_validation import cross_val_score

from sklearn.datasets import load_iris

from sklearn.ensemble import AdaBoostClassifier

iris = load_iris()

clf= AdaBoostClassifier(n_estimators=100)

scores = cross_val_score(clf,iris.data,iris.target)

print scores.mean()