Corosync + Pacemaker 搭建高可用MariaDB服务

实验描述

1.本实验的目的是为了通过手动配置corosync配置文件,实现MariaDB服务的高可用,集群心跳传递使用组播方式。

2.三个节点的主机名分别为:node5.redhat.com、node6.redhat.com、node7.redhat.com。地址为172.16.100.5、172.16.100.6、172.16.100.7。

3.利用nfs做后端存储,NFS地址为172.16.0.254。

3.VIP地址为172.16.100.100

4.三个节点系统全部为CentOS7.2,NFS节点为CentOS6.5。

5.配置高可用集群的前三个步骤:节点时间同步、主机名解析和SSH互信这里就再演示了。

配置步骤

一、NFS节点的配置

1.首先在此节点安装NFS服务并创建共享目录

[root@centos6 ~]# yum install nfs-utils -y

[root@centos6 ~]# mkdir /data/{mydata,logs} -pv

mkdir: created directory “data”

mkdir: created directory “/data/mydata”

mkdir: created directory “/data/logs”

[root@centos6 ~]# vim /etc/exports

/data 172.16.0.0/16(rw,no_root_squash)设置共享目录及其权限3.

配置完成之后启动NFS服务service nfs restart。

2.创建mysql用户和用户组,并赋予共享目录权限。注意:所有节点上的mysql用户和组的ID号一定要一样

[root@centos6 ~]# groupadd -r -g 240 mysql

[root@centos6 ~]# useradd -r -u 240 -g 240 mysql[root@centos6 ~]# chmod -R 775 /data

[root@centos6 ~]# chown -R mysql.root /data

二、将MariaDB服务在三个节点都配置好

1.首先在node5.redhat.com节点上安装nfs-utils包,以支持挂载nfs格式的文件系统。

[root@node5 ~]# yum install nfs-utils -y

2.在node5.redhat.com节点上创建mysql用户和组。

[root@node5 ~]# groupadd -r -g 240 mysql

[root@node5 ~]# useradd -r -u 240 -g 240 mysql

3.创建/data目录并挂载NFS服务到/data。

[root@node5 ~]# mkdir /data

[root@node5 ~]# mount -t nfs 172.16.0.254:/data /data

4.解压mariadb的二进制程序包并创建链接。

[root@node5 ~]# tar xf mariadb-10.0.24-linux-x86_64.tar.gz -C /usr/local/

[root@node5 ~]# cd /usr/local/

[root@node5 local]# ln -sv mariadb-10.0.24-linux-x86_64 mysql

‘mysql’ -> ‘mariadb-10.0.24-linux-x86_64’

5.安装并配置mariadb服务。

[root@node5 local]# cd mysql/

[root@node5 mysql]# ./scripts/mysql_install_db �datadir=/data/mydata �user=mysql脚本安装过程这里就省略了。。。

[root@node5 mysql]# cp support-files/mysql.server /etc/init.d/mysqld

[root@node5 mysql]# cp support-files/my-large.cnf /etc/my.cnf

cp: overwrite ‘/etc/my.cnf’? y

[root@node5 mysql]# echo “export PATH=/usr/local/mysql/bin:$PATH” > /etc/profile.d/mysqld.sh

[root@node5 mysql]# . /etc/profile.d/mysqld.sh

[root@node5 mysql]# vim /etc/my.cnf

my.cnf文件示例。

[client] port = 3306 socket = /tmp/mysql.sock [mysqld] port = 3306 socket = /tmp/mysql.sock skip-external-locking key_buffer_size = 256M max_allowed_packet = 1M table_open_cache = 256 sort_buffer_size = 1M read_buffer_size = 1M read_rnd_buffer_size = 4M myisam_sort_buffer_size = 64M thread_cache_size = 8 query_cache_size= 16M thread_concurrency = 2 datadir = /data/mydata innodb_file_per_table = 1 log-bin=/data/logs/mysql-bin binlog_format=mixed server-id = 1 [mysqldump] quick max_allowed_packet = 16M [mysql] no-auto-rehash [myisamchk] key_buffer_size = 128M sort_buffer_size = 128M read_buffer = 2M write_buffer = 2M [mysqlhotcopy] interactive-timeout

6.启动mariadb服务并创建一个测试用户,方便最后我们测试使用。之后将mariadb服务关闭。并将NFS共享目录卸载。

[root@node5 mysql]# /etc/init.d/mysqld start

Starting MySQL.. SUCCESS!

[root@node5 mysql]# mysql

Welcome to the MariaDB monitor. Commands end with ; or \g.

Your MariaDB connection id is 4

Server version: 10.0.24-MariaDB MariaDB ServerCopyright (c) 2000, 2016, Oracle, MariaDB Corporation Ab and others.

Type ‘help;’ or ‘\h’ for help. Type ‘\c’ to clear the current input statement.

MariaDB [(none)]>

GRANT ALL ON *.* TO 'ha'@'%' IDENTIFIED BY 'redhat';

Query OK, 0 rows affected (0.04 sec)MariaDB [(none)]>

FLUSH PRIVILEGES;

Query OK, 0 rows affected (0.03 sec)MariaDB [(none)]> quit

Bye

[root@node5 mysql]# /etc/init.d/mysqld stop

Shutting down MySQL… SUCCESS![root@node5 ~]# umount /data

5.将my.cnf复制到其它节点,并在其它节点上配置上述1、2、3、4步骤.。注意:在执行第三步的时候只要创建目录即可、不需要再挂载了,并且需要再多执行一步:cp /usr/local/mysql/support-files/mysql.server /etc/init.d/mysqld#复制mariadb启动脚本。

[root@node5 ~]# scp /etc/my.cnf node6.redhat.com:/etc/my.cnf

[root@node5 ~]# scp /etc/my.cnf node7.redhat.com:/etc/my.cnf

node6.redhat.com

[root@node6 ~]# yum install nfs-utils -y

[root@node6 ~]# groupadd -r -g 240 mysql

[root@node6 ~]# useradd -r -u 240 -g 240 mysql

[root@node6 ~]# mkdir /data

[root@node6 ~]# tar xf mariadb-10.0.24-linux-x86_64.tar.gz -C /usr/local/

[root@node6 ~]# cd /usr/local/

[root@node6 local]# ln -sv mariadb-10.0.24-linux-x86_64 mysql

[root@node6 local]# cp /usr/local/mysql/support-files/mysql.server /etc/init.d/mysqld

node7.redhat.com

[root@node7 ~]# yum install nfs-utils -y

[root@node7 ~]# groupadd -r -g 240 mysql

[root@node7 ~]# useradd -r -u 240 -g 240 mysql

[root@node7 ~]# mkdir /data

[root@node7 ~]# tar xf mariadb-10.0.24-linux-x86_64.tar.gz -C /usr/local/

[root@node7 ~]# cd /usr/local/

[root@node7 local]# ln -sv mariadb-10.0.24-linux-x86_64 mysql

[root@node7 local]# cp /usr/local/mysql/support-files/mysql.server /etc/init.d/mysqld

三、配置corosync集群,实现MariaDB的高可用

1.在三个节点都安装上corosync+pacemaker服务

[root@node5 ~]# yum install corosync pacemaker -y

[root@node6 ~]# yum install corosync pacemaker -y

[root@node7 ~]# yum install corosync pacemaker -y

2.然后我们在一个节点上创建并配置corosync.conf文件,文件路径为/etc/corosync/corosync.conf(默认没有这个文件)。

配置文件示例:

totem {

version: 2

crypto_cipher: aes128

crypto_hash: sha1

secauth: on

interface {

ringnumber: 0

bindnetaddr: 172.16.0.0

mcastaddr: 239.255.1.1

mcastport: 5405

ttl: 1

}

}

nodelist {

node {

ring0_addr: 172.16.100.5

nodeid: 1

}

node {

ring0_addr: 172.16.100.6

nodeid: 2

}

node {

ring0_addr: 172.16.100.7

nodeid: 3

}

}

logging {

fileline: off

to_stderr: no

to_logfile: yes

logfile: /var/log/cluster/corosync.log

to_syslog: yes

debug: off

timestamp: on

logger_subsys {

subsys: QUORUM

debug: off

}

}

quorum {

provider: corosync_votequorum

}

3.之后使用corosync-keygen命令,会自动在/etc/corosync/目录下创建一个authkey文件。注意:如果遇到卡在生成随机数的地方,可以用如下方法解决:

[root@node5 corosync]# cd /dev/

[root@node5 dev]# mv random random.bak

[root@node5 dev]# ln -sv urandom random

‘random’ -> ‘urandom’[root@node5 dev]# corosync-keygen

Corosync Cluster Engine Authentication key generator.

Gathering 1024 bits for key from /dev/random.

Press keys on your keyboard to generate entropy.

Writing corosync key to /etc/corosync/authkey.[root@node5 dev]# rm -rf random

[root@node5 dev]# mv random.bak random

4.之后将corosync.conf和authkey都复制到另外的节点上去。

[root@node5 ~]# cd /etc/corosync/

[root@node5 corosync]# scp corosync.conf authkey node6.redhat.com:/etc/corosync/

[root@node5 corosync]# scp corosync.conf authkey node7.redhat.com:/etc/corosync/

5.在所有节点启动corosync和pacemaker服务。

[root@node5 ~]# systemctl start corosync.service

[root@node5 ~]# systemctl start pacemaker.service[root@node6 ~]# systemctl start corosync.service

[root@node6 ~]# systemctl start pacemaker.service[root@node7 ~]# systemctl start corosync.service

[root@node7 ~]# systemctl start pacemaker.service

使用crm_mon查看节点是否全部加了进来

可以看到三个节点已经全部加进了集群里面。

6.,在node5.redhat.com上面安装crmsh,完成资源配置。注意:”CentOS 7以后默认不自带crmsh,需要自己去网上下载,这里我使用的是在网上找到的crmsh-scripts-2.2.0-7.1.noarch.rpm,crmsh-2.2.0-7.1.noarch.rpm,python-parallax-1.0.1-10.1.noarch.rpm。”

[root@node5 ~]# yum install crmsh-2.2.0-7.1.noarch.rpm crmsh-scripts-2.2.0-7.1.noarch.rpm python-parallax-1.0.1-10.1.noarch.rpm -y

[root@node5 ~]# crm configure

关闭stonith

crm(live)configure# property stonith-enabled=false配置VIP资源

crm(live)configure# primitive mysqlip ocf:heartbeat:IPaddr params ip=’172.16.100.100’ op start timeout=60s op stop timeout=60s op monitor interval=20s timeout=40s配置NFS资源

crm(live)configure# primitive mysqlstore ocf:heartbeat:Filesystem params device=’172.16.0.254:/data’ directory=’/data’ fstype=’nfs’ op start timeout=60s op stop timeout=60s op monitor interval=20s timeout=40s配置Mariadb资源,这里我们使用的是lsb脚本

crm(live)configure# primitive mysqlserver lsb:mysqld params op start timeout=60s op stop timeout=60s op monitor interval=20s timeout=40s将三个资源加入到同一组

crm(live)configure# group mysqlservice mysqlip mysqlstore mysqlserver设置排序约束

crm(live)configure# order mysqlip_before_mysqlstore Mandatory: mysqlip mysqlstore

crm(live)configure# order mysqlstore_before_mysqlserver Mandatory: mysqlstore mysqlserver检测语法错误

crm(live)configure# verify检测语法没有报错的话就可以提交配置了

crm(live)configure# commit

crm(live)configure# bye

这样我们整个集群的资源就配置好了。

测试步骤

1.首先使用crm status查看节点状态

显示没有问题.

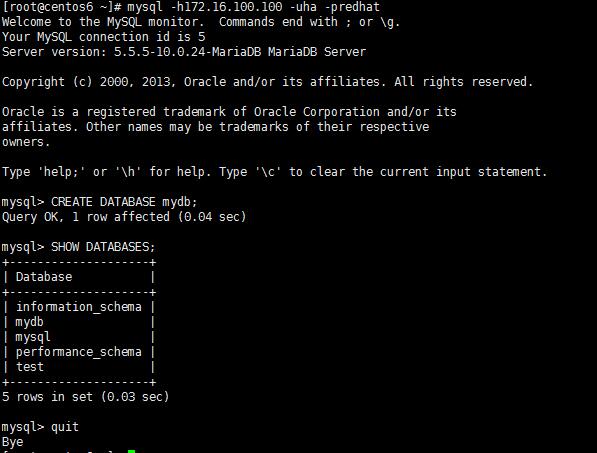

2.这里将NFS服务器当作测试节点,在节点上安装mysql的客户端并进行测试。

[root@centos6 ~]# yum install mysql -y

[root@centos6 ~]# mysql -h172.16.100.100 -uha -predhat

能够正常访问,并且我们在里面创建了一个mydb库。

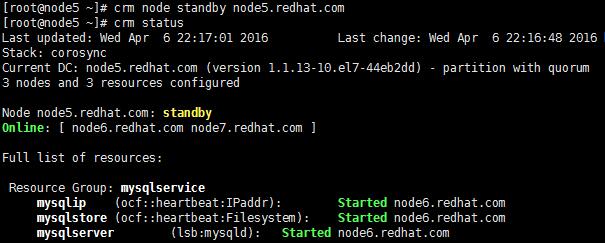

3.现在我们将node5设置为standby状态,测试资源是否能够迁移成功

[root@node5 ~]# crm node standby node5.redhat.com

[root@node5 ~]# crm status可以看到资源迁移成功。

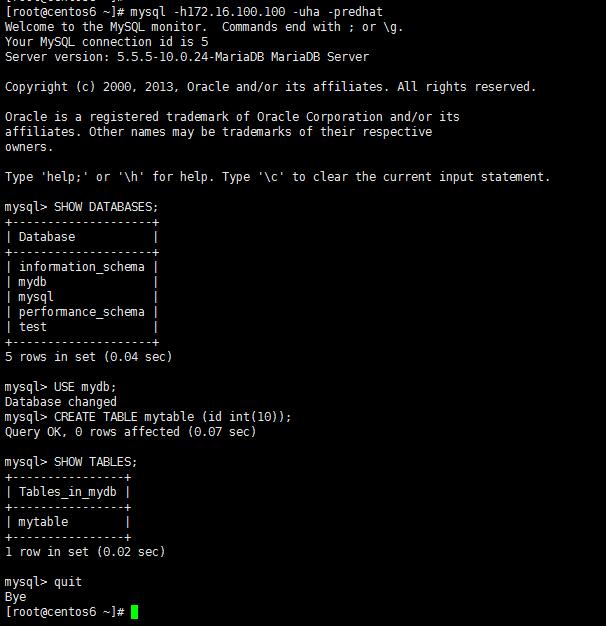

4.再次进行测试。

[root@centos6 ~]# mysql -h172.16.100.100 -uha -predhat

还是访问我们的VIP172.16.100.100能够正常访问,并且成功的在之前创建的mydb库上又创建了一个测试表。

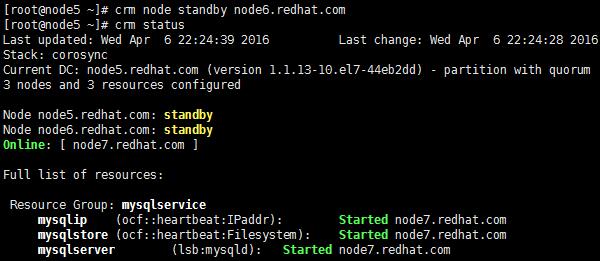

5.现在我们将node6也设置为standby状态,测试资源是否还能够迁移成功

[root@node5 ~]# crm node standby node6.redhat.com

[root@node5 ~]# crm status

可以看到资源被成功的迁移到了node7上。

现在我们将node5和node6全部设置回online状态。

[root@node5 ~]# crm node online node5.redhat.com

[root@node5 ~]# crm node online node6.redhat.com

[root@node5 ~]# crm status

可以看到节点又成功的回来了,这样就成功的实现了MariaDB的高可用。

菜鸟一枚,以上配置如有问题,欢迎指正。谢谢!!!