Python与机器学习(五)朴素贝叶斯分类

1.安装中文分词器

由于本文是对中文文本进行分类,故需要用到中文分词器,而结巴分词则是Python支持较好的一款分词器。

使用命令安装:

pip3 install jieba3k

或者下载结巴分词文件【下载】

结巴分词测试:

结巴分词支持三种分词模式:

- 精确模式,也是结巴分词的默认模式,可以将句子以最精确的方式分开;

- 全模式,可以将句子中所有能够组成词语的词分割开来,速度较快,但有些词语并不正确;

- 搜索引擎模式,该模式可以说是对精确模式的加深,即对精确模式产生的长词进一步分割。

结巴分词是基于Trie树结构实现高效的词图扫描,采用动态规划找最大概率路径,找出基于词频的最大切分组合,对于词典中不存在的词,则采用基于汉字成词能力的HMM模型,使用Viterbi算法。

import jieba

seg = jieba.cut("这里的樱花真美丽,还是去武大看樱花,听说那里的计算机科学学院还不错",cut_all=True)

print('全模式:',"/".join(seg))

seg = jieba.cut("这里的樱花真美丽,还是去武大看樱花,听说那里的计算机科学学院还不错",cut_all=False)

print('精确模式:',"/".join(seg))

seg = jieba.cut_for_search("这里的樱花真美丽,还是去武大看樱花,听说那里的计算机科学学院还不错")

print('搜索引擎模式:',"/".join(seg))

结巴分词的分词方法有两种形式,一种是cut(),一种是cut_for_search()

cut()方法包含两个参数,第一个是待切分的字符串,第二个是切分的模式,True表示全模式,False表示精确模式

cut_for_search()方式只有一个参数,即待切分的字符串

从上图的输出可以看出,全模式的分词结果很多,有的词还不能成词,如"科学学"等;精确模式就相对要少很多,而且切分的也比较准确;搜索引擎模式对精确模式的结果进一步切分,如“计算机科学”就被切分出了“计算”、“科学”等。

当然,结巴分词除了分词功能外,还有词性标注、关键词提取等功能,具体内容可以参考Python结巴分词

2.朴素贝叶斯概念

概率论是许多机器学习算法的基础,前面说到的决策树也是用概率来判断数据属于某一类别。朴素贝叶斯是贝叶斯决策理论的一部分,其分类的整个形式化过程只做最简单最原始的假设。

贝叶斯决策理论的思想是给定两个类别数据的统计参数,然后计算另给的数据点分别属于这两个类别的概率,选择最大的概率作为该数据点的分类。

下面先来熟悉一下几个公式:

先验概率P(c),是从已有训练集中计算分类为c类样本占总样本的概率;

条件概率P(x|c),表示已知x在c中,从c中得到x的概率;

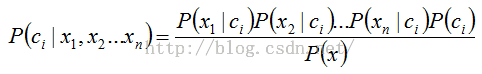

贝叶斯准则

如果已知P(x|c),那么就可以计算出P(c|x),该概率表示样本x属于类别c的概率

那么,当一个样本中有多个特征(x1,x2,x3......xn)时,则有:

【这里的每个特征都是独立的】

然后根据i个类别的概率大小,选择概率最大的那个类别

2.朴素贝叶斯优缺点

优点:在数据较少的请胯下仍然有效,可以处理多类别问题;

缺点:对于输入数据的准备方式较为敏感。

使用数据类型:标称型数据

3.使用朴素贝叶斯进行文档分类

实验文本:

negative

positive

#bayes.py

#coding=utf-8

def createVocabList(dataSet):

vocabSet = set([]) #创建一个空集

for document in dataSet:

vocabSet = vocabSet | set(document) #创建两个空集的并集

return list(vocabSet)

def setOfWord2Vec(vocabList,inputSet):#词集模型

returnVec = [0]*len(vocabList) #创建一个元素都是0的向量

for word in inputSet:

if word in vocabList:

returnVec[vocabList.index(word)] = 1

else:

print('the word: %s is not in my Vocabulary!'%word)

return returnVec

def bagOfWords2VecMN(vocabList,inputSet): #词袋模型

returnVec = [0]*len(vocabList)

for word in inputSet:

if word in vocabList:

returnVec[vocabList.index(word)] +=1

return returnVec

def trainNB0(trainMatrix,trainCategory):

numTrainDocs = len(trainMatrix)

numWords = len(trainMatrix[0])

pAbusive = sum(trainCategory)/float(numTrainDocs)

p0Num = ones(numWords) #初始化概率

p1Num = ones(numWords)

p0Denom = 2.0

p1Denom = 2.0

for i in range(numTrainDocs):

if trainCategory[i] == 1:

p1Num += trainMatrix[i] #向量相加

p1Denom += sum(trainMatrix[i])

else:

p0Num += trainMatrix[i]

p0Denom += sum(trainMatrix[i])

p1Vect = log(p1Num/p1Denom) #对每个元素做除法

p0Vect = log(p0Num/p0Denom)

return p0Vect,p1Vect,pAbusive

def classifyNB(vec2Classify,p0Vec,p1Vec,pClass1):

p1 = sum(vec2Classify*p1Vec)+log(pClass1) #元素对应相乘

p0 = sum(vec2Classify*p0Vec)+log(1.0-pClass1)

if p1>p0:

return 1

else:

return 0

def testingNB():

listOPosts,listClasses = loadDataSet()

myVocabList = createVocabList(listOPosts)

trainMat = []

for postinDoc in listOPosts:

trainMat.append(setOfWord2Vec(myVocabList, postinDoc))

p0V,p1V,pAb = trainNB0(array(trainMat), array(listClasses))

testEntry = ['love','my','dalmation']

thisDoc = array(setOfWord2Vec(myVocabList, testEntry))

print(testEntry,' classified as: ',classifyNB(thisDoc, p0V, p1V, pAb))

testEntry = ['stupid','garbage']

thisDoc = array(setOfWord2Vec(myVocabList, testEntry))

print(testEntry,' classified as: ',classifyNB(thisDoc, p0V, p1V, pAb))

def textParse(bigString):

import re

import jieba

listOfTokens = jieba.cut(bigString)

return [tok for tok in listOfTokens if len(tok)>1]

def spamTest():

import linecache

docList = []

classList = []

fullText = []

#linecache.clearcache() 清楚缓存,当文件有变更时

#file = open('data/negative.txt')

for i in range(1,26): #导入并解析文本文件

linecache.clearcache()

string = linecache.getline('data/negative.txt', i)

wordList = textParse(string)

docList.append(wordList)

fullText.extend(wordList)

classList.append(1)

linecache.clearcache()

string = linecache.getline('data/positive.txt', i)

wordList = textParse(string)

docList.append(wordList)

fullText.extend(wordList)

classList.append(0)

print(docList)

vocabList = createVocabList(docList)

trainingSet = list(range(50))

testSet = []

print(trainingSet)

for i in range(10): #随机构建训练集

randIndex = int(random.uniform(0,len(trainingSet)))

print(randIndex)

testSet.append(trainingSet[randIndex])

del(trainingSet[randIndex])

trainMat = []

trainClasses = []

for docIndex in trainingSet:

trainMat.append(setOfWord2Vec(vocabList, docList[docIndex]))

trainClasses.append(classList[docIndex])

p0V,p1V,pSpam = trainNB0(array(trainMat),array(trainClasses) )

print(pSpam)

errorCount = 0

for docIndex in testSet:#对测试集分类

wordVector = setOfWord2Vec(vocabList, docList[docIndex])

if classifyNB(array(wordVector), p0V, p1V, pSpam) != classList[docIndex]:

errorCount += 1

print('the error rate is : ',float(errorCount)/len(testSet))

return float(errorCount)/len(testSet)

#test.py

import bayes

rate = 0.0

for i in range(10):

rate += bayes.spamTest()

print('rate = ',rate/10)

在此进行了10次交叉验证,由于每次的训练样本和测试样本是随机选取的,因此计算10次的平均值也有所不同,这里得到的结果是rate = 0.14。