Hadoop集群搭建工作日志

(红色字为关键部分)

一、配置host

每一台服务器上更改配置文件

1.vim /etc/hosts

127.0.0.1 localhost

10.10.135.63 master

10.10.120.134 slave01

10.10.134.153 slave02

2.vim /etc/hostname(写入每台机器别名)如master的机器写入master为slave的机器写为slave01等。

3.vim /etc/sysconfig/network将文件内Hostname修改成对应的别名。

4.init 6重启服务器

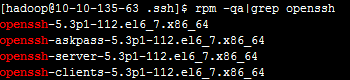

二、确认Linux上安装SSH

检测命令rpm -qa|grep openssh 和rpm -qa|grep rsync如果有安装则会出现如下:

.

如果没有则需要安装:

yum install ssh

yum install rsync

yum install askpass

三、创建Hadoop用户和生成服务器秘钥对

a.创建 hadoop用户组和用户参考命令:

groupadd hadoop

useradd -g hadoop hadoop

创建用户密码passwd hadoop在光标下重复输入密码即可。

创建完用户后,切换到hadoop用户下:su - hadoop

b.创建密钥对。

ssh-keygen -t rsa -P ''

注意点:ssh-keygen为ssh生成密钥对命令,-t为秘钥算法,可以为rsa或者dsa,-P ‘’为密码为空。生成id_rsa、id_rsa.pub文件在当前用户目录下/home/hadoop/.ssh/

c.将id_rsa.pub复制到slave下:

scp ~/.ssh/id_rsa.pub [email protected]:~/

讲公钥写入ssh默认key文件内

cat ~/.ssh/id_rsa.pub >>authorized_keys

并更改权限!!!:

chmod 600 authorized_keys

chmod 700 .ssh(更改.ssh文件夹权限)

d.修改ssh配置文件

切换到root用户下面:su - 或者exit

1.编辑系统文件:vim /etc/ssh/sshd_config

将如下配置的注释去掉

RSAAuthentication yes

PubkeyAuthentication yes

AuthorizedKeysFile .ssh/authorized_keys

保存:wq!

2.编辑系统文件:vim /etc/ssh/ssh_config

在配置文件中添加:

StrictHostKeyChecking no

UserKnownHostsFile /dev/null

保存:wq!

重启服务:service sshd restart

四、验证

在master或者客户机上ssh 10.10.134.153,如果不需要密码就登入则说明是成功的。

五、下载并配置Hadoop

1.下载

http://mirror.bit.edu.cn/apache/hadoop/common/

传到服务器后同步到其他几台机器用scp

如果下的tar包,就地解压tar -xvf hadop-xxx.tar.gz

2.配置参数

在hadoop解压包下面

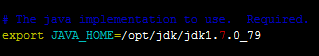

a.conf/hadoop-env.xml

![]()

b.conf/core-site.xml

c.hdfs.site.xml

d.mapred-site.xml

e.master和slaves

写入master和slave01 slave02

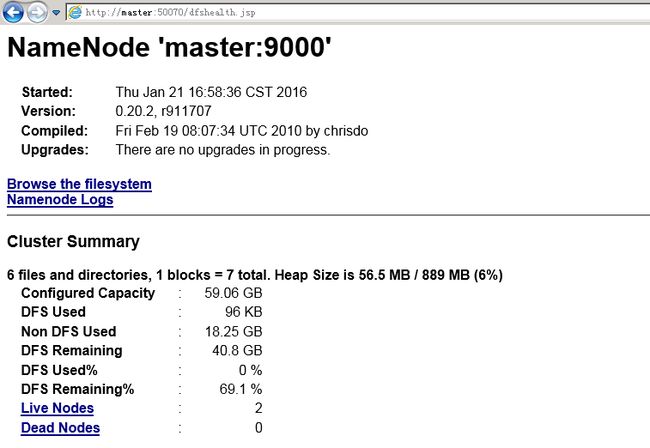

3.启动

./hadoop namenode -format

./start-all.sh

测试启动

./hadoop dfsadmin -report

or

http://master:50070 ---dfs状态

http://master:50030 ---jobTracker状态

4.遇到borted错误无法被format的情况,配置一下dfs.name.dir就可以了。

5.http://hadoop.apache.org/docs/r2.7.1/hadoop-project-dist/hadoop-hdfs/hdfs-default.xml ---hdfs配置参数表