人工智能写手,好用吗?

作者 | 王树义

来源 | 玉树芝兰(ID:nkwangshuyi)

1、印象

之前给学生上课的时候,我介绍过利用循环神经网络,仿照作家风格进行创作的机器学习模型。不过,那模型写出来的东西嘛……

我的评价是:望之,不似人语。

因为这种限制,人们并没有把“机器写作”当成一回事儿。总觉得机器要写成那种以假乱真的高度,可能还需要等上很久远的一段时间。

然而,这世界变化快。

2、工具

早上,我尝试了一个新工具。

一个在线编辑器界面里,输入或长或短的一段话,然后按一下 Tab 键。

后面的内容,机器就帮你自动逐步填充。

填充的过程里,系统每次给你3个备选方案,这样你可以控制写作思路的走向。

当然,你也可以根本不管其他选项,一直走默认路径。机器照样文思泉涌。

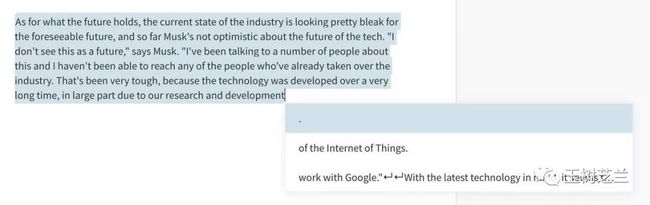

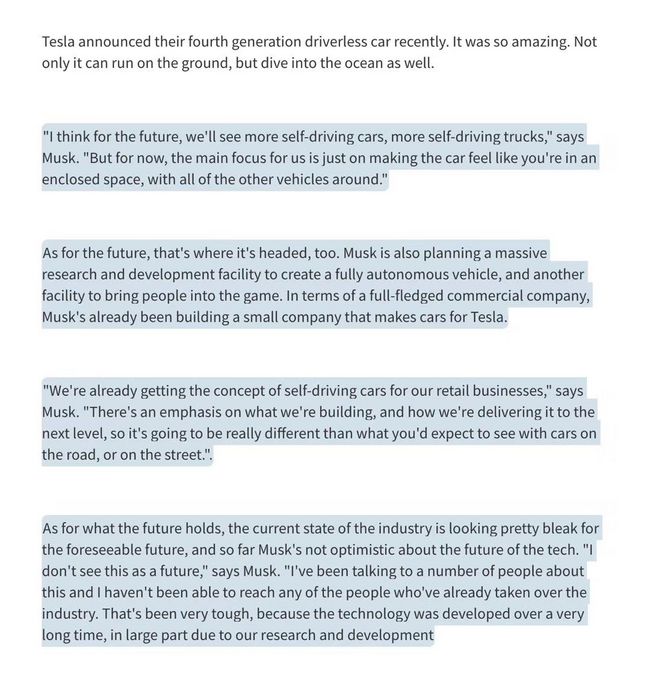

最后生成的文章,是这个样子的。

其中,第一段落是我自己随便瞎写的。后面高亮段落,都是电脑模型自己编出来的。不但标点符号、语法修辞用得有鼻子有眼儿,就连我那段里根本没有提到过的创始人,都跳了出来长篇大论。

3、尝试

大家也可以通过下面的链接进行尝试,智能写作编辑器的链接:

https://transformer.huggingface.co/

不知道你尝试过后的感觉是什么。反正我觉得,以后学校里的英文写作课,怕是没有办法判作业了。原本需要学生花半个小时完成的任务,现在他可以轻点几下按键,就能搞定交差。更要命的是,从原理来讲,查重系统面对这种作品,是无效的。

因为这并非抄袭。机器每一次的“创作”,几乎都能保证是全新的。

4、原理

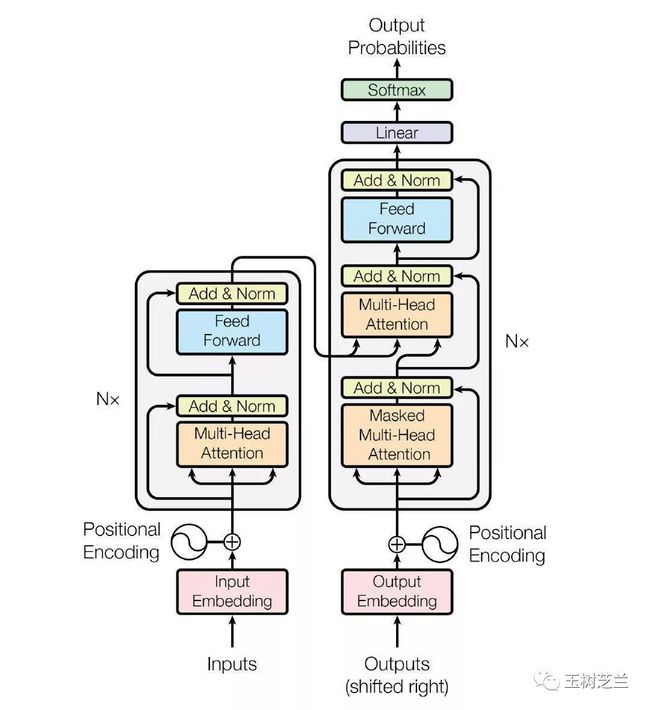

你一定想知道这背后的原理吧?其实,在我们之前的教程里,我多次给你介绍过它。就是目前最火的自然语言模型架构——Transformer。

(上图来自于经典之作“Attention is All You Need”)

我们详细介绍过使用方法的 BERT ,当初用的就是这种技术,才产生了野蛮霸榜的效果。不过咱们用的这个编辑器,底层并不是 BERT ,而是我们之前提及的 GPT 2。

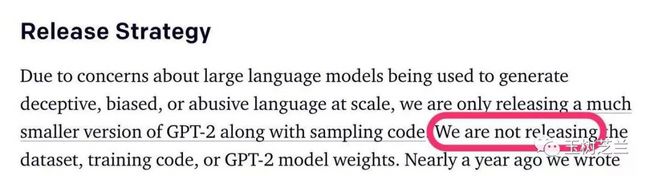

大多数人提到它的时候,介绍往往不是那么正面。并不是因为 GPT 2 这种技术不够好。而是因为它“太好了”。好到足够让人眼馋。好到开发者决定,不开放训练数据集、代码、甚至模型参数……

要知道,在当今这样一个开源开放的趋势下,这么做会招致多少非议。当时 OpenAI 做出这种决定和解释,有人便认为是出于饥饿营销的目的,赚眼球。但是,你刚刚自己尝试过语言生成模型的威力之后,还会保持这么单纯的想法吗?

5、威胁

仅举一例。互联网上,假新闻是一个非常严重的问题。原先,用机器造假新闻出来,成本固然低,但专业人士还是很容易通过语言特征和统计规律来识别的。

而一旦,假新闻不但生产成本低廉,分分钟可搞定,还完全具备了真新闻的语言特征,要分辨出来,就不容易了。假新闻有可能多点大规模爆发,因从众和沉默螺旋等社会心理机制,对大众轻易造成误导。

面对这种潜在威胁,我们真的已有完善的应对之策吗?正因为这种威胁实际存在,数据伦理才愈发成为重要的研究课题。

如果你做数据科学研究,这个方向大有可为。

6、魔盒

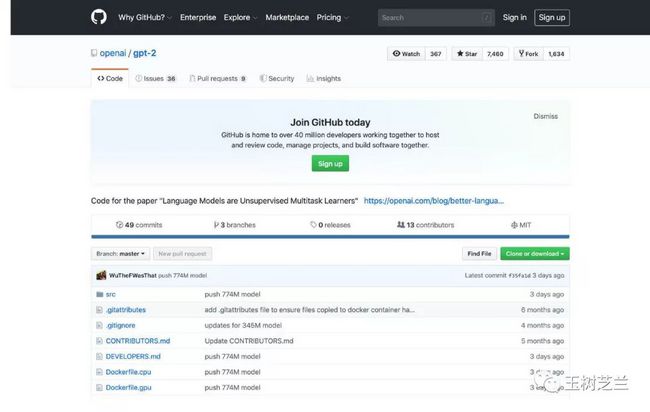

风险是显著的。而技术的进步与发展,真的能够因为一家机构决定“不开放模型”的举措,就能停滞吗?

当然不会。OpenAI 因为压力,不断释放出更为强大的开源模型。目前开放的预训练模型版本,达到了 774M 个参数。距离完全版本模型的释放,也就是临门一脚的事儿了。

曾经,普通人即便拿到了这种开源工具,也需要一定的门槛,才能使用。

然而“有好事者”,在整合包装了若干种主流的 Transformer 模型之后,降低了 GPT2 机器写作的门槛。于是,就有你看到的这个编辑器了。

7、波澜

我把 GPT2 自动写作的结果,发到了朋友圈。

(图来源于作者发布的朋友圈)”第一段落是作者自己随便瞎写的。后面高亮段落,都是电脑模型自己编出来的。不但标点符号、语法修辞用得有鼻子有眼儿,就连我那段里根本没有提到过的创始人,都跳了出来长篇大论。"

惊艳之余,小伙伴想到的,主要是以下两个问题:

什么时候出中文的?

能否和写字机器人配合使用?

我看后很无语。好在这一位的留言,让我看到了光明的一面:

以后英语老师出阅读题,可方便多了。

(*本文为 AI科技大本营转载文章,转载请联系作者)

◆

福利时刻

◆

入群参与每周抽奖~

扫码添加小助手,回复:大会,加入福利群,参与抽奖送礼!

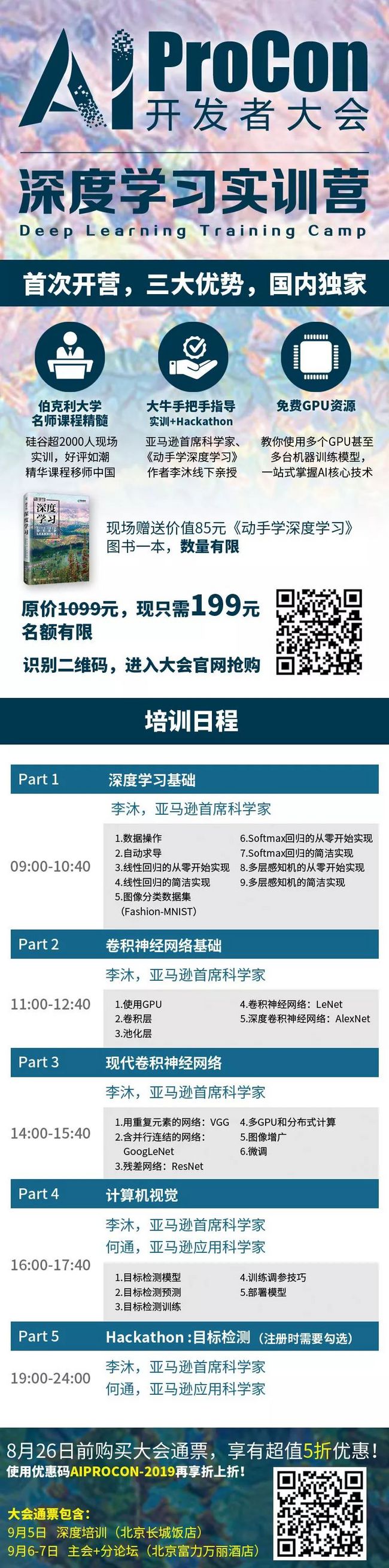

大会5折优惠票倒计时 2 天! 团购还享立减优惠,倒计时 2 天!此外,伯克利大学名师精髓课程移师北京。《动手学深度学习》作者、亚马逊首席科学家李沐线下亲授「深度学习实训营」,免费GPU资源,现场还将限量赠送价值85元的配套书籍一本,先到先得。原价1099元,限时专享CSDN 独家福利价199元!识别海报二维码,即刻购票~

推荐阅读

2019 AI ProCon日程出炉:Amazon首席科学家李沐亲授「深度学习」

玩嗨的2亿快手“老铁”和幕后的极致视觉算法

与旷视、商汤等上百家企业同台竞技?AI Top 30+案例评选等你来秀

从不温不火到炙手可热:语音识别技术简史

入门大爆炸式发展的深度学习,你先要了解这6个著名框架

用Python的算法工程师们,编码问题搞透彻了吗?

Python冷知识,不一样的技巧带给你不一样的乐趣

我是如何通过开源项目月入 10 万的?

撬动百亿台设备,让物联网“造”起来!

程序员离无人值班有多远?

你点的每个“在看”,我都认真当成了喜欢