Spark02——Spark集群安装部署

Spark集群搭建

- 集群安装

- 1.1 下载Spark安装包

- 1.2 上传并解压安装包

- 1.3 可选择重命名解压后的安装目录

- 1.4 修改配置文件

- 修改配置文件spark-env.sh

- 修改配置文件slaves

- 1.5 拷贝安装包到其他主机

- 1.6 配置spark环境变量

- 1.7 spark启动

- 1.8 停止spark

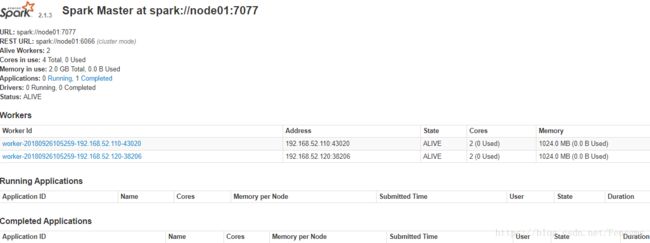

- 1.9 spark的web界面

集群安装

本集群搭建为三台虚拟机,分别在hosts中命名为node01,node02,node03.

已提前安装好zookeeper和hadoop环境。

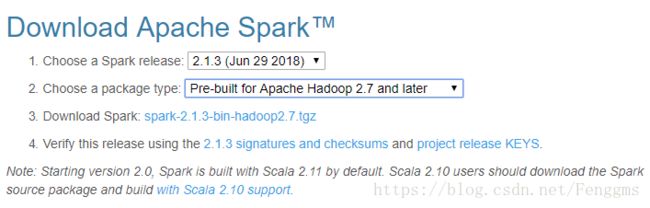

1.1 下载Spark安装包

下载地址spark官网:http://spark.apache.org/downloads.html

下载时应考虑尽量和Hadoop版本匹配。

目前最新版本为2.3.2;2018年9月24日更新。【Spark 2.3.2 released (Sep 24, 2018)】

这里我使用 spark-2.1.3-bin-hadoop2.7版本.

1.2 上传并解压安装包

先选择node01进行文件上传及安装。后续将安装包进行分发到其他主机。

上传目录按照之前安装Hadoop等软件时统一好的安装目录进行。

cd /export/softwares/

tar -zvxf spark-2.1.3-bin-hadoop2.7.tgz -C ../servers/

1.3 可选择重命名解压后的安装目录

cd /export/servers/

mv spark-2.1.3-bin-hadoop2.7/ spark

1.4 修改配置文件

修改配置文件spark-env.sh

先将conf中的模板文件spark-env.sh.template进行重命名为spark-env.sh,然后进行修改

cd conf/

mv spark-env.sh.template spark-env.sh

vim spark-env.sh

配置JAVA_HOME 和master的主机和端口

#配置java环境变量

export JAVA_HOME=/export/servers/jdk1.8.0_141

#指定master的主机

export SPARK_MASTER_HOST=node01

#指定master的端口

export SPARK_MASTER_PORT=7077

修改配置文件slaves

先把slaves.template重命名为slaves

mv slaves.template slaves

vim slaves

配置Spark Worker的主机,这里将node02/node03配置为Worker

# A Spark Worker will be started on each of the machines listed below.

node02

node03

注意:以上配置均在node01中进行。

1.5 拷贝安装包到其他主机

通过scp 命令将spark的安装目录拷贝到其他机器上

scp -r /export/servers/spark node2:/export/servers

scp -r /export/servers/spark node3:/export/servers

1.6 配置spark环境变量

将spark添加到环境变量中,三台设备均执行以下操作。

vim /etc/profile

export SPARK_HOME=/export/servers/spark

export PATH=$PATH:$SPARK_HOME/bin

使配置文件立即生效

source /etc/profile

1.7 spark启动

这里已经设置node01为主节点,在主节点上启动spark.所以需要在node01上进行启动。

/export/servers/spark/sbin/start-all.sh

任意目录下执行该命令。

注意:虽然已经将spark加入到了环境变量中,但不要通过直接输入start-all.sh 的方式进行启动。因为在hadoop的sbin目录下,有相同的指令。直接输入,会默认启动hadoop集群。

需要通过相对路径或绝对路径下进行启动或停止spark.

1.8 停止spark

同上,执行以下命令停止spark集群:

/export/servers/spark/sbin/stop-all.sh