在java应用中使用JDBC连接Spark SQL(HiveServer2)

根据Spark官网所述,Spark SQL实现了Thrift JDBC/ODBC server:

The Thrift JDBC/ODBC server implemented here corresponds to the HiveServer2 in Hive 1.2.1 You can test the JDBC server with the beeline script that comes with either Spark or Hive 1.2.1.

这就意味着我们可以像HIVE那样通过JDBC远程连接Spark SQL发送SQL语句并执行。

准备

在这之前需要先将${HIVE_HOME}/conf/hive-site.xml 拷贝到${SPARK_HOME}/conf目录下,由于我的hive配置了元数据信息存储在MySQL中,所以Spark在访问这些元数据信息时需要mysql连接驱动的支持。添加驱动的方式有三种:

第一种是在${SPARK_HOME}/conf目录下的spark-defaults.conf中添加:spark.jars /opt/lib/mysql-connector-java-5.1.26-bin.jar

第二种是通过 添加 :spark.driver.extraClassPath /opt/lib2/mysql-connector-java-5.1.26-bin.jar 这种方式也可以实现添加多个依赖jar,比较方便

第三种是在运行时 添加 --jars /opt/lib2/mysql-connector-java-5.1.26-bin.jar

做完上面的准备工作后,spark sql和Hive就继承在一起了,spark sql可以读取hive中的数据

启动thrift

在spark根目录下执行:./sbin/start-thriftserver.sh 开启thrift服务器

start-thriftserver.sh 和spark-submit的用法类似,可以接受所有spark-submit的参数,并且还可以接受--hiveconf 参数。

不添加任何参数表示以local方式运行。

默认的监听端口为10000

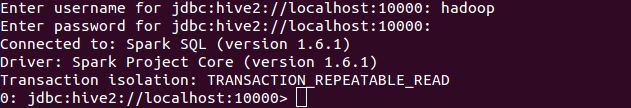

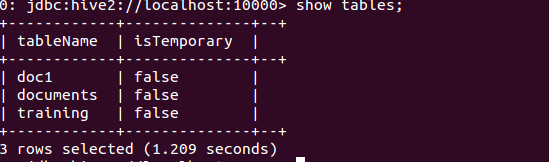

用beeline测试

在java代码中用jdbc连接

org.apache.hive

hive-jdbc

1.2.1

org.apache.hadoop

hadoop-common

2.4.1

jdk.tools

jdk.tools

1.6

system

${JAVA_HOME}/lib/tools.jar

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.ResultSet;

import java.sql.SQLException;

import java.sql.Statement;

public class Test1 {

public static void main(String[] args) throws SQLException {

String url = "jdbc:hive2://192.168.1.131:10000/default";

try {

Class.forName("org.apache.hive.jdbc.HiveDriver");

} catch (ClassNotFoundException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

Connection conn = DriverManager.getConnection(url,"hadoop","");

Statement stmt = conn.createStatement();

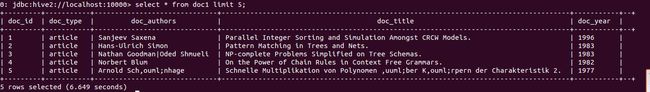

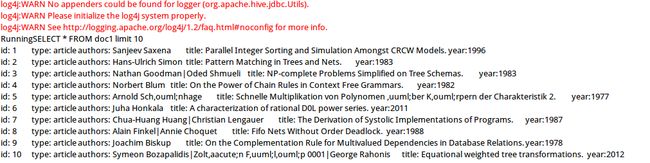

String sql = "SELECT * FROM doc1 limit 10";

System.out.println("Running"+sql);

ResultSet res = stmt.executeQuery(sql);

while(res.next()){

System.out.println("id: "+res.getInt(1)+"\ttype: "+res.getString(2)+"\tauthors: "+res.getString(3)+"\ttitle: "+res.getString(4)+"\tyear:" + res.getInt(5));

}

}

}打印输出: