Android FFmpeg系列——1 播放视频

Android FFmpeg系列——0 编译.so库

Android FFmpeg系列——1 播放视频

Android FFmpeg系列——2 播放音频

Android FFmpeg系列——3 C多线程使用

Android FFmpeg系列——4 子线程播放音视频

Android FFmpeg系列——5 音视频同步播放

Android FFmpeg系列——6 Java 获取播放进度

Android FFmpeg系列——7 实现快进/快退功能

由于公司项目原因,现在才得空来学习关于FFmpeg库的使用。

前言

在使用FFmpeg库的过程中,哎呦,各种心酸!!项目重新创建了N次,调试了N次,终于把视频流播放出来,心里甚是激动呀!

环境搭建

Android Studio 创建Demo项目,记得把 “Include c++ support” 勾上。

这里主要说2点:

- 项目目录结构;

- 文件配置,主要是app模块build.gradle 和 CMakeLists.txt 的配置;

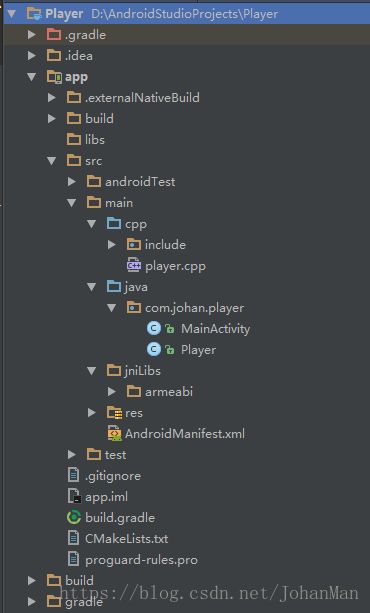

项目目录结构

每个人放so位置不一样,这个会影响到配置文件,所以还是放出来会好一点。

app模块build.gradle

...

android {

...

defaultConfig {

...

externalNativeBuild {

cmake {

cppFlags "-std=c++11 -frtti -fexceptions"

}

ndk {

abiFilters "armeabi"

}

}

}

...

externalNativeBuild {

cmake {

path "CMakeLists.txt"

}

}

}

...

CMakeLists.txt

cmake_minimum_required(VERSION 3.4.1)

# 自己库文件

add_library(

player

SHARED

src/main/cpp/player.cpp

)

# FFmpeg include 文件

include_directories(src/main/cpp/include)

# 编解码库

add_library(

avcodec-lib

SHARED

IMPORTED

)

set_target_properties(

avcodec-lib

PROPERTIES IMPORTED_LOCATION

${CMAKE_SOURCE_DIR}/src/main/jniLibs/armeabi/libavcodec.so

)

# 滤镜库 暂时没用上

add_library(

avfilter-lib

SHARED

IMPORTED

)

set_target_properties(

avfilter-lib

PROPERTIES IMPORTED_LOCATION

${CMAKE_SOURCE_DIR}/src/main/jniLibs/armeabi/libavfilter.so

)

# 文件格式库 大部分操作都需要这个库

add_library(

avformat-lib

SHARED

IMPORTED

)

set_target_properties(

avformat-lib

PROPERTIES IMPORTED_LOCATION

${CMAKE_SOURCE_DIR}/src/main/jniLibs/armeabi/libavformat.so

)

# 工具库

add_library(

avutil-lib

SHARED

IMPORTED

)

set_target_properties(

avutil-lib

PROPERTIES IMPORTED_LOCATION

${CMAKE_SOURCE_DIR}/src/main/jniLibs/armeabi/libavutil.so

)

# 重采样库 主要用于音频的转换

add_library(

swresample-lib

SHARED

IMPORTED

)

set_target_properties(

swresample-lib

PROPERTIES IMPORTED_LOCATION

${CMAKE_SOURCE_DIR}/src/main/jniLibs/armeabi/libswresample.so

)

# 视频格式转换库 主要用于视频的转换

add_library(

swscale-lib

SHARED

IMPORTED

)

set_target_properties(

swscale-lib

PROPERTIES IMPORTED_LOCATION

${CMAKE_SOURCE_DIR}/src/main/jniLibs/armeabi/libswscale.so

)

# 主要 android 库 native window 需要这个库

target_link_libraries(

player

log

android

avcodec-lib

avfilter-lib

avformat-lib

avutil-lib

swresample-lib

swscale-lib

)

C 代码

#include 使用 FFmpeg 播放视频流程如下:

- 注册组件

- 打开视频文件

- 查找视频文件的流信息

- 查找视频编码器并打开

- 播放视频准备

- 视频格式转换准备

- 循环读取帧

- 解码

- 视频格式转换

- 播放视频

- 释放

代码已经注释得比较清楚了,相信大家看得懂!!

Java 代码

布局文件:

<LinearLayout xmlns:android="http://schemas.android.com/apk/res/android"

android:orientation="vertical"

android:layout_width="match_parent"

android:layout_height="match_parent">

<SurfaceView

android:id="@+id/surface_view"

android:layout_width="match_parent"

android:layout_height="250dp"

/>

<Button

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:text="Play"

android:onClick="play"

/>

LinearLayout>

Player Native 代码:

public class Player {

static {

System.loadLibrary("player");

}

public native void playVideo(String path, Surface surface);

}

Activity 播放代码:

public class MainActivity extends AppCompatActivity {

private SurfaceView surfaceView;

private SurfaceHolder surfaceHolder;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

surfaceView = (SurfaceView) findViewById(R.id.surface_view);

surfaceHolder = surfaceView.getHolder();

}

public void play(View view) {

String videoPath = Environment.getExternalStorageDirectory() + "/mv.mp4";

Player player = new Player();

player.playVideo(videoPath, surfaceHolder.getSurface());

}

}

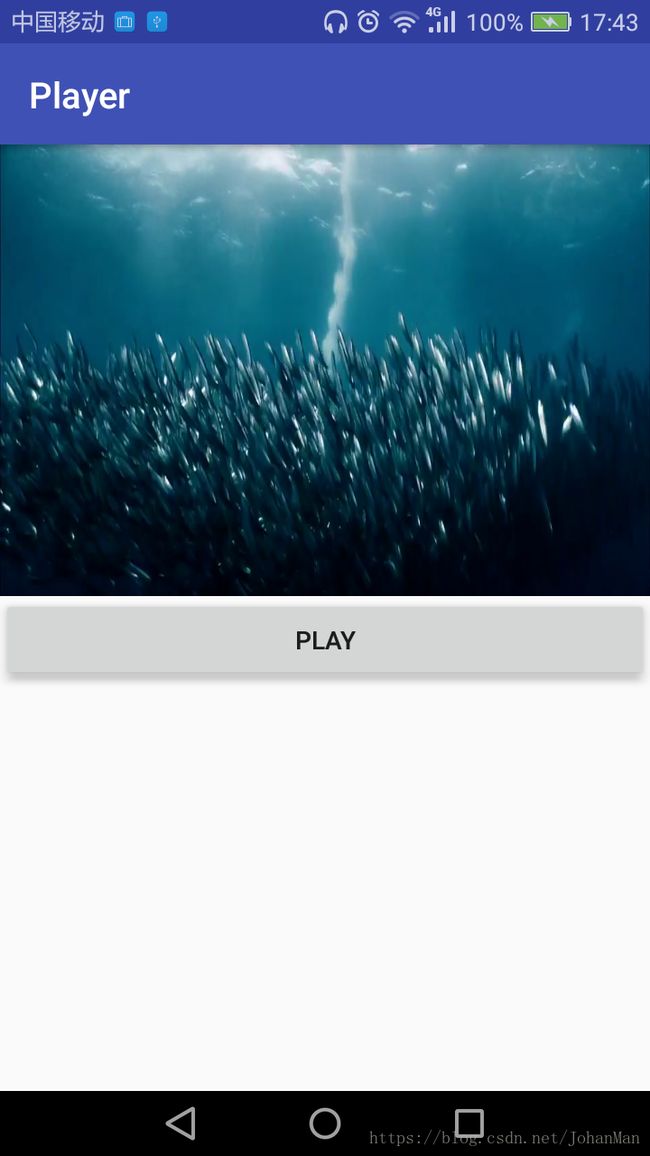

效果图

小结

使用FFmpeg主要是集成时需要谨慎,还有就是对这个库不太了解!

接下来继续摸索!加油!!