leapMotion概述(API Overview)

****************************************************************************

***************翻译的不准确的地方,请大家指出*************************

****************************************************************************

LM系统识别和追踪手、指头,以及像指头一样的工具。这个设备在很高的准确度和追踪帧率下操作,并且可以报告离散的位置,姿态和运动。

LM控制器使用optical传感器(光学传感器)和infrared light(红外灯)。当控制器在其垂直操作的位置上,传感器沿着方向向上的Y轴,有一个150度的感知区域。LM控制器的有效范围大约在设备上方的25mm到600m之间的区域。

当控制器有一个清晰的,高对比度的物体轮廓时,有较好的识别和追踪效果。LM的软件与传感器传递的数据相结合,加之人手模型,共同处理充满挑战趣味的追踪环境。

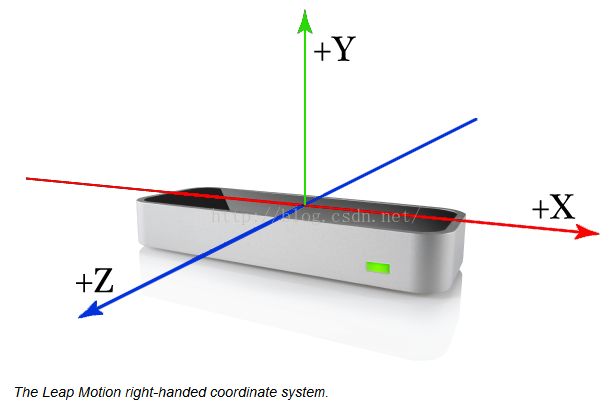

协调系统(coordinate system)

LM采用右手直角坐标系,控制器的顶部是坐标原点,X和Z轴在水平面上,X轴与设备的长边平行,Y是垂直方向,正方向向上。

LM的度量单位

距离:毫米;

时间:毫秒(除非标明单位)

速度:mm/s

角度:弧度制

运动追踪数据(Motion tracking data)

当在LM视场上追踪手势时,设备以数据集或数据帧的形式来更新数据,每一个数据帧的数据包括轨迹名称的列表,内容有手、指头、工具以及屏幕中被识别的手势和表示运动的因素。帧对象则是LM运动模型的根本。

手(Hands)

手模型提供身份、位置和其他已识别手的特征信息,手连接的手臂以及指头的信息。

LM软件使用人手的模型150554262提供去预测手的轨迹,甚至手的看不到的那部分也可以预测出来。手模型总是有五根手指的位置,不过在手的轮廓和五根指头都能清晰可见是,追踪才能达到最理想的情况。软件通过使用看得见的部分和前一时刻的观察来计算当前看不见的那部分。值得注意的是,被手挡住的和传感器看不到的手指的细微运动一般不能被识别。

当超过一双手或类似手的物体出现在视野中,数据帧可以显示把他们显示在手列表内。但是为了获得最好的追踪质量,LM控制器的视野最多保持一双手。

手臂(Arms)

手臂如骨头似得物体,提供了方向、长度、宽度和手臂终点。当肘部不在LM控制器视野中时,控制器可以根据前一时刻的位置和典型人体比例来估计它的位置。

手指(Fingers)

LM控制器提供每一根手指的信息。如果一根或多根手指看不到时,LM则会基于最近的观察和 解剖学手模型,来进行估计。手指通过名称来区分,如:thumb,index,middle,ring,和pinky。

一根手指提供提过了每一个解刨学意义上的骨头的方向和位置,所有的指头包含从根部到顶部的四个部分组成

这个模型在拇指上,并不是和标准的解剖学上的拇指很匹配。真实的拇指是比其他的指头少一个骨头。然而,为了编程的方便,LM包含了一个长度为零的骨头(掌骨),作为拇指最后一节,这样就可以保持所有指头都是有四节骨头组成。

工具(tools)

工具就像是一支铅笔。也只有细的、圆柱状的物体被作为工具追踪。值得注意的是,在第二版中,工具已经独立于手了。

手势(Gestures)

LM软件识别的某一个运动样式你被称之为手势,这个样式是包含了用户的某种意图或倾向。每一根手指或工具,他们的手势是分开来识别的。LM软件汇报在数据帧中的所观察的手势。

贴士:在使用应用中使用手势之前,必须了解你所要使用的手势的意义。controller类有一个enableGesture()方法,你可以用来识别你的手势的种类。

运动(Motion)

传感器图像(Sensor Images)

原文地址:https://developer.leapmotion.com/documentation/cpp/devguide/Leap_Overview.html