linux Hadoop环境变量安装及应用

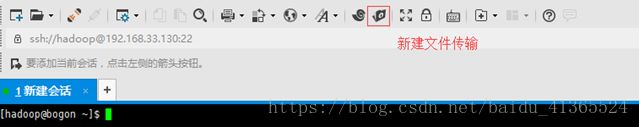

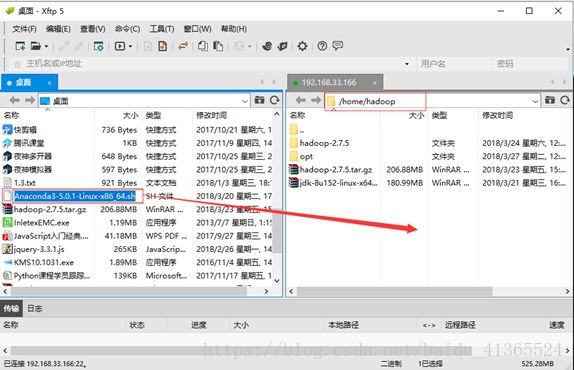

1.上传hadoop(切记在hadoop用户下)

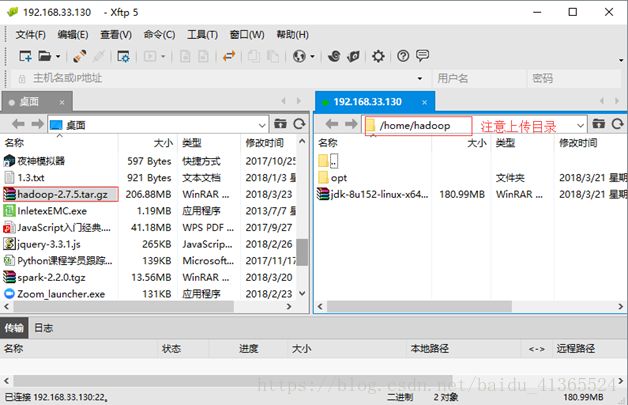

1.解压缩 tar -xzfhadoop-2.7.5.tar.gz

1.配置环境变量

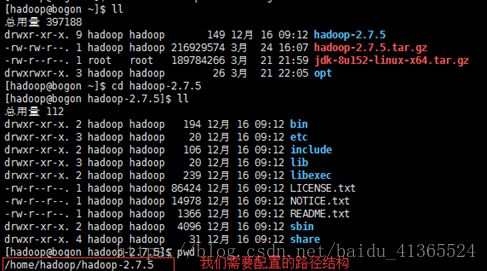

(1)首先进入hadoop的根目录

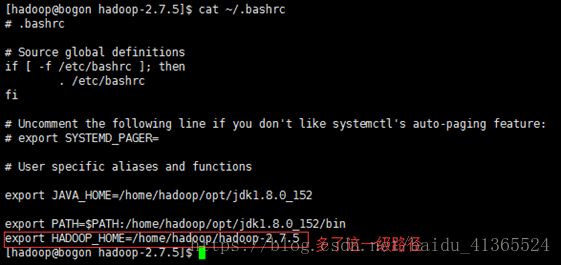

(2)配置HADOOP_HOME

![]()

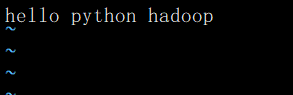

查看 bashrc文件

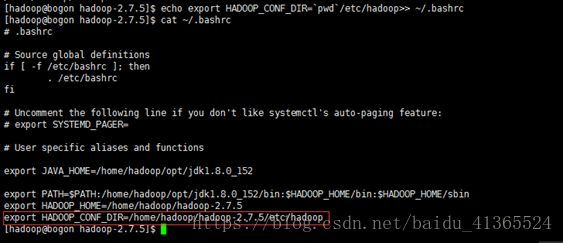

(3)配置HADOOP_CONF_DIR

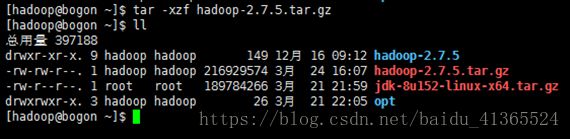

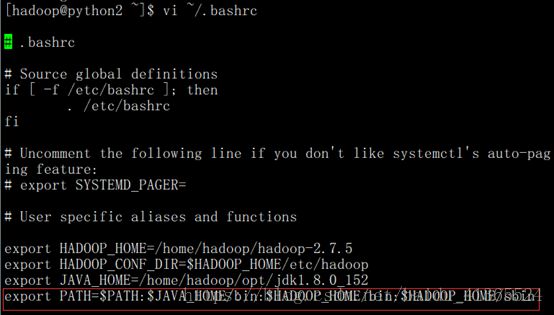

(4)配置PATH vi ~/.bashrc (删除上面的PATH,重新写入一个新的)

exportPATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

vi 进入环境变量配置文件,添加上面圈选部分,:wq保存退出(PATH路径好像要在最底下,不然PATH无法使用$JAVA_HOME、$HADOOP_HOME路径)

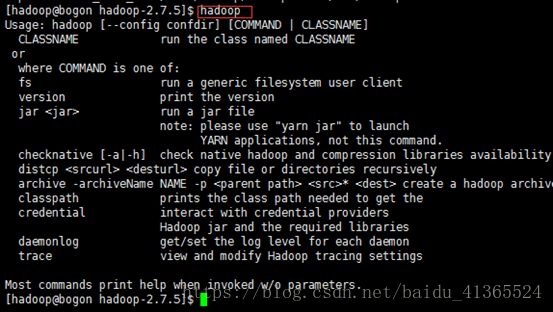

(5)source更新文件

(6)输入hadoop测试环境变量生效了没,证明生效

一.搭建hadoop

1.配置静态IP

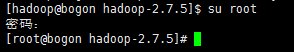

(1)切换root用户(否则下面的操作没有权限)

(2)查看你的网段

(3)vi/etc/sysconfig/network-scripts/ifcfg-ens33(这里的33不是我的网段!!!)

修改BOOTPROTO=static onroot = yes

添加

IPADDR=192.168.33.110 (33设置成你的网段,最后随便设置,请牢记这个ip)

NETMASK=255.255.255.0

GATEWAY=192.168.33.2(这里的33也请改成你的网段)

DNS1=202.106.0.20

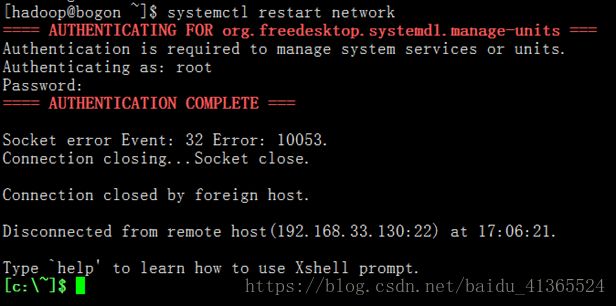

(4)重启network systemctl restart network

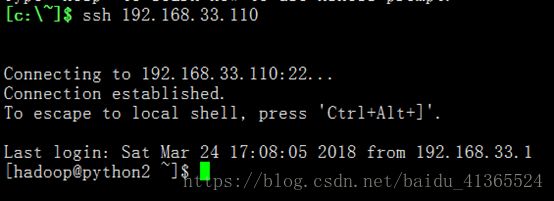

(5)输入 ssh 192.168.33.110,看看配置的生效了没

输入用户和密码成功登陆上了,证明整成功了

2.修改主机名和映射

(1)切换root用户,修改需要权限

(2)修改主机名 vi/etc/hostname

保存退出

(3)修改主机映射 vi /etc/hosts

保存退出

(4)重启

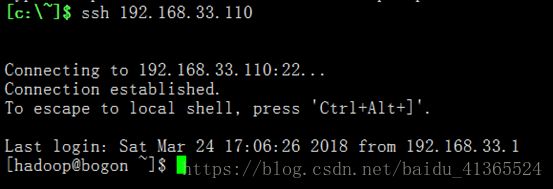

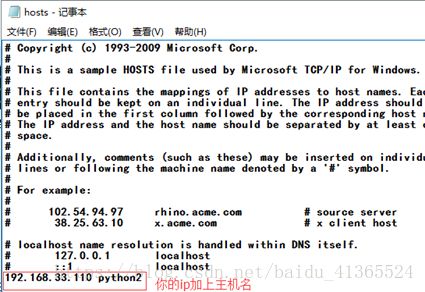

(5)修改window下的映射

在桌面打开这个文件(记事本),输入以下内容,记住一定输入你配置的静态ip,保存关闭

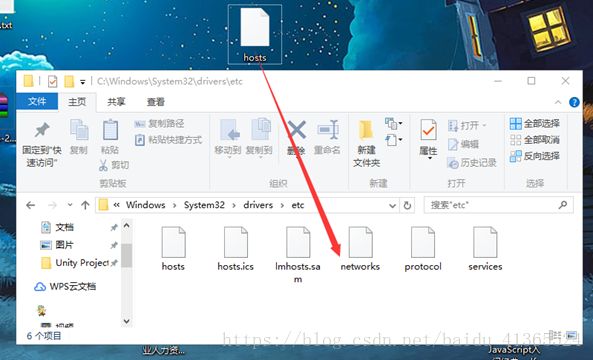

将桌面的文件拖到原来的文件夹下

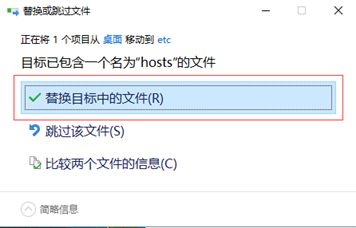

选择替换

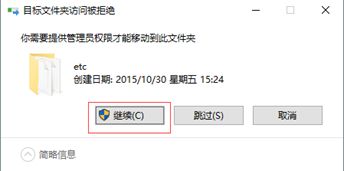

以管理员继续

完成

3.修改配置文件

(1)重新连上linux

(1)进入配置目录

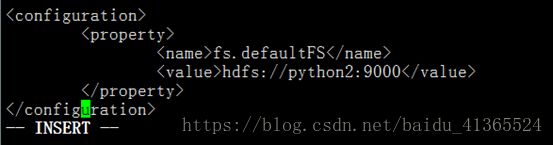

(3)配置 core-site.xml

在configuration添加以下内容 然后保存退出

![]()

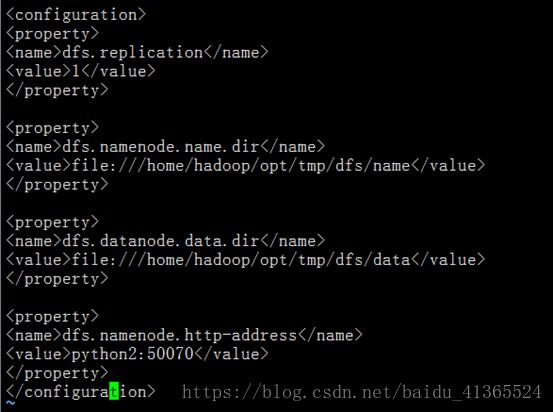

(1)配置hdfs-site.xml

在configuration添加以下内容 然后保存退出

![]()

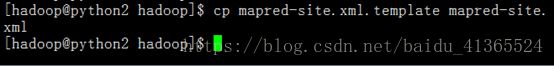

(5)配置mapred-site.xmll

ll查看当前目录会发现没有mapred-site.xml文件,只有一个mapred-site.xml.template的文件,我们复制一份命名为mapred-site.xml: cpmapred-site.xml.template mapred-site.xml

在configuration添加以下内容 然后保存退出

![]()

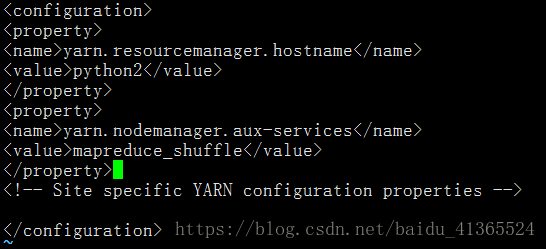

(6)配置yarn-site.xml

在configuration添加以下内容 然后保存退出

![]()

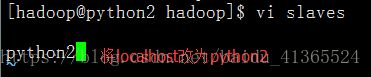

(7)修改 slaves

slaves

配置datanode的主机名称

python2

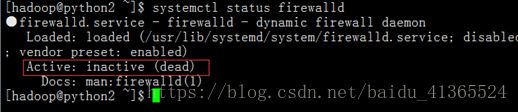

1.关闭防火墙和selinux

切换到root用户

关闭防火墙

临时关闭:systemctlstop firewalld

永久关闭:systemctldisable firewalld

查看状态:systemctlstatus firewalld

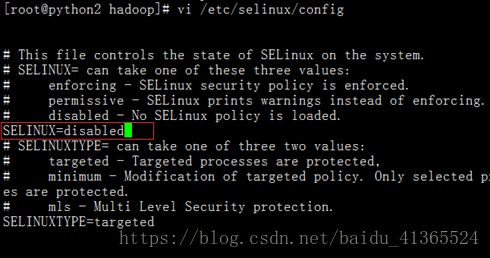

关闭selinux

临时关闭:setenforce0

永久关闭:vi/etc/selinux/config

修改 SELINUX=disabled

getenforce:查看状态

切换到root用户

关闭防火墙

![]()

关闭selinux

重启机器 reboot

![]()

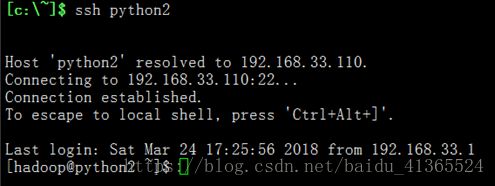

重新连接,登录hadoop

查看防火墙和selinux状态

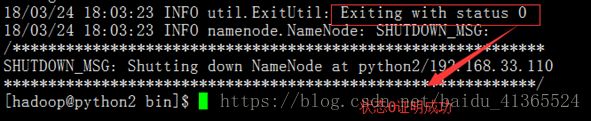

5.执行hdfs文件系统格式化:hdfsnamenode -format

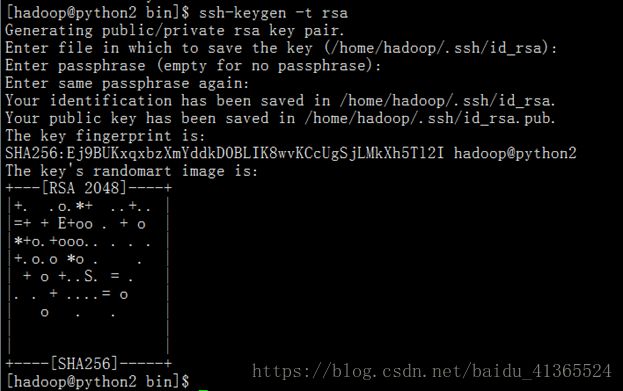

6.配置ssh无密码登录

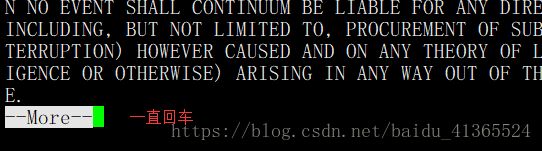

输入ssh-keygen -t rsa 一直回车

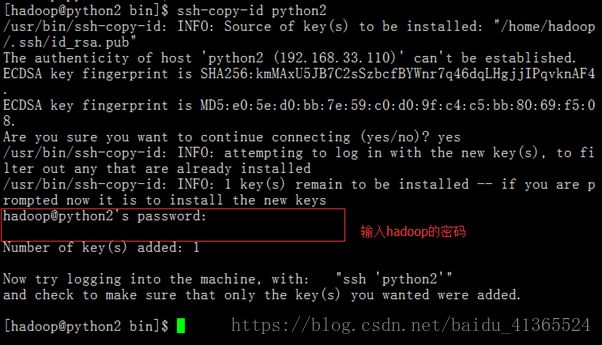

ssh-copy-id 你想登录到的计算机名 输入hadoop的密码

启动服务 start-dfs.sh(如果没有配置ssh 无密码登录,那么这里会一直提示输入密码)

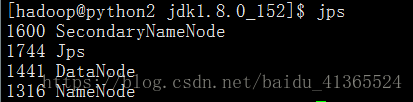

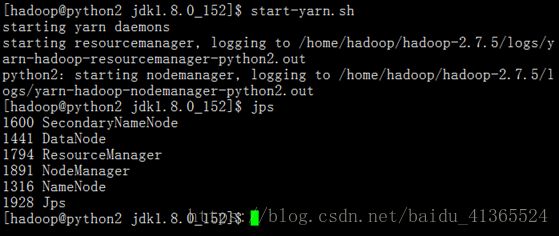

查看启动的服务 jps

start-yarn.sh 及jps

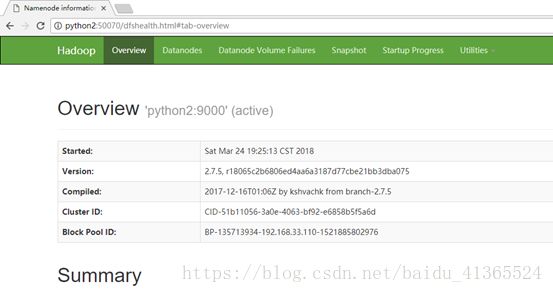

1.浏览器访问,输入python2:50070

成功显示!

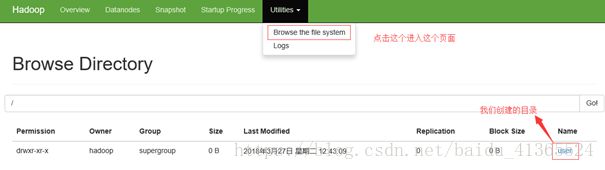

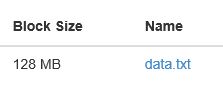

七.文件上传

1.创建一个目录 hadoop fs-mkdir -p /user/hadoop

![]()

1.文件上传

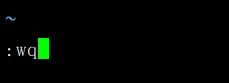

新建一个文件

![]()

写入内容

保存退出(快捷键 esc-shift(按住)-z-z)

上传

查看

八.Anaconda的安装

1.上传

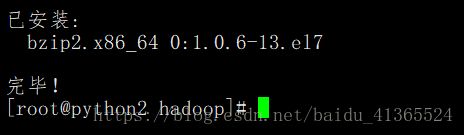

1.安装前需要安装bzip2 yum -y install bzip2

(1)需要root用户,切换用户

(2)yum -y install bzip2 安装bzip2

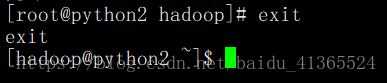

(3)退出root用户

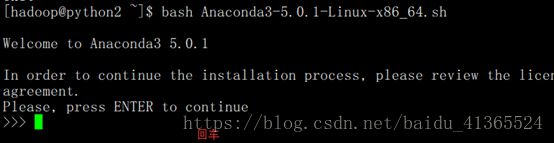

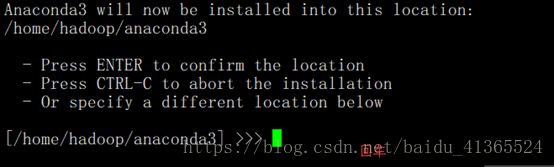

3.开始安装Anaconda bash Anaconda3-5.0.1-Linux-x86_64.sh

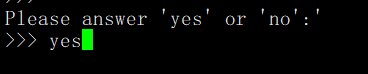

输入yes

等待

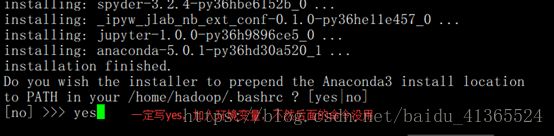

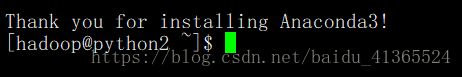

完成

4.更新环境变量

![]()

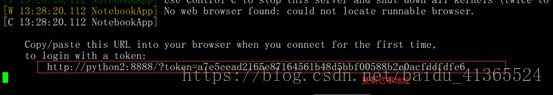

5.查看jupter地址 jupyter-notebook --ip python2

6.进浏览器,输入你复制的地址