搭建hadoop的高可用性(HA)集群

本文为传智播客八天——第五天学习笔记

因为电脑配置问题,只能同时运行三台虚拟机。三台是hadoop高可用性集群的最小数目。不能再少了。

前期准备:

1、修改linux主机名和IP

2、修改主机名和IP的映射关系

3、关闭防火墙

4、ssh免登录

5、安装JDK,配置环境变量

集群规划:

主机名 IP 安装的软件 运行的进程

hadoop-master 172.16.123.1 JDK、hadoop、zookeeper namenode、DFSZKFailoverController(zkfc)、QuorumPeerMain、JournalNode、DataNode

hadoop-slave1 172.16.123.128 JDK、hadoop、zookeeper namenode、DFSZKFailoverController(zkfc)、QuorumPeerMain、JournalNode、DataNode、ResourceManager

hadoop-slave2 172.16.123.128 JDK、hadoop、zookeeper QuorumPeerMain、JournalNode、DataNode、ResourceManager

1、安装hadoop集群(在hadoop-master上配置)

2.1修改hadoop-env.sh

export JAVA_HOME=/home/kun/soft/jdk1.8.0_602.2、修改core-site.xml

fs.default.name

hdfs://ns1/

hadoop.tmp.dir

/home/kun/soft/hadoop-2.7.1/tmp

ha.zookeeper.quorum

hadoop-master:2181,hadoop-slave1:2181,hadoop-slave2:2181

2.3、修改hdfs-site.xml

dfs.nameservices

ns1

dfs.ha.namenodes.ns1

nn1,nn2

dfs.namenode.rpc-address.ns1.nn1

hadoop-master:9000

dfs.namenode.http-address.ns1.nn1

hadoop-master:50070

dfs.namenode.rpc-address.ns1.nn2

hadoop-slave1:9000

dfs.namenode.http-address.ns1.nn2

hadoop-slave1:50070

dfs.namenode.shared.edits.dir

qjournal://hadoop-master:8485;hadoop-slave1:8485;hadoop-slave2:8485/ns1

dfs.journalnode.edits.dir

/home/kun/soft/hadoop-2.7.1/journaldata

dfs.ha.automatic-failover.enabled

true

dfs.client.failover.proxy.provider.ns1

org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider

dfs.ha.fencing.methods

sshfence

shell(/bin/true)

dfs.ha.fencing.ssh.private-key-files

/home/kun/.ssh/id_rsa

dfs.ha.fencing.ssh.connect-timeout

30000

2.4、 将mapred-site.xml.template修改mapred-site.xml

mapreduce.framework.name

yarn

yarn.resourcemanager.ha.enabled

true

yarn.resourcemanager.cluster-id

yrc

yarn.resourcemanager.ha.rm-ids

rm1,rm2

yarn.resourcemanager.hostname.rm1

hadoop-slave1

yarn.resourcemanager.hostname.rm2

hadoop-slave2

yarn.resourcemanager.zk-address

hadoop-master:2181,hadoop-slave1:2181,hadoop-slave2:2181

yarn.nodemanager.aux-services

mapreduce_shuffle

2.6、修改slaves

hadoop-master

hadoop-slave1

hadoop-slave23 、将hadoop-2.7.1拷贝到hadoop-slave1和hadoop-slave2上面

拷贝之前可以讲share中的doc文档删除,提高拷贝速度

4、配置zookeeper

见这里http://blog.csdn.net/beidiqiuren/article/details/51234325

5、启动zookeeper集群(在hadoop-master、hadoop-slave1、hadoop-slave2中都要启动)

nanda@hadoop-master:~/soft/zookeeper-3.4.5/bin$ ./zkServer.sh start

nanda@hadoop-master:~/soft/zookeeper-3.4.5/bin$ ./zkServer.sh status

nanda@hadoop-master:~/soft/hadoop-2.7.1/sbin$ ./hadoop-daemon.sh start journalnode

6725 Jps

6460 QuorumPeerMain

6671 JournalNode

7、格式化HDFS

在hadoop-master上执行命令(也可以在hadoop-slave1上执行)

hdfs namenode -format

也可以在hadoop-slave1上执行

hdfs namenode -bootstrapStandby总算成功了,这一步耽搁了三天。不知道怎么错的,总是格式化失败。最后只好把虚拟机删了,重新配置环境。

8、格式化ZKFC(ZKFC做两个namenode的失败切换管理)

在hadoop-master上执行

hdfs zkfc -formatZK./zkCli.shls /

9、启动HDFS

在hadoop-master上执行

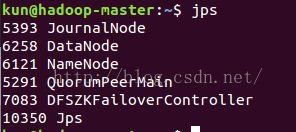

start-dfs.sh此时hadoop-master上的进程有Jps、JournalNode、 DataNode、 NameNode、QuorumPeerMain、DFSZKFailoverController

hadoop-slave1上的进程有Jps、JournalNode、 DataNode、 NameNode、QuorumPeerMain、DFSZKFailoverController

hadoop-slave2上的进程有JournalNode、QuorumPeerMain、 Jps、DataNode

10、启动yarn

在hadoop-slave1和hadoop-slave2上启动,namenode和resourcemanager都需要占用大量的资源,条件允许的情况下把它们在不同的机器上启动

start-yarn.sh

此时,HA下的hadoop就搭建完成了。可以通过浏览器来访问

hadoop-master:50070

hadoop-slave1:8088

在eclipse测试一下文件的上传

import java.net.URI;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class HdfsUtilHA {

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://ns1/"),conf); //FileSystem.get(URI,conf,"身份");

fs.copyFromLocalFile(new Path("/home/kun/exam/a"), new Path("hdfs://ns1/"));

}

}