谷歌新技术:使用概念激活向量 (CAVs) 理解深度网络

全文共2617字,预计学习时长5分钟

可解释性仍是现代深度学习应用中最严峻的挑战之一。随着计算模型和深度学习研究领域不断进展,如今可建立包含数千隐藏神经层和上千万神经元的复杂模型。尽管在深度神经网络模型上取得巨大进步似乎还算简单,但理解这些模型的创建和推理过程仍是一大难题。最近,Google Brain团队发布了一篇文章,提出通过使用一种叫做概念激活向量的方法从新角度理解深度学习模型的可解释性。

传送门:https://arxiv.org/pdf/1711.11279.pdf?source=post_page---------------------------

可解释性VS准确性

要理解概念激活向量技术,必须先理解深度学习模型中普遍存在的可解释性难题。就目前的深度学习技术而言,保证模型准确性和人为解释模型实现原理之间一直存在阻力。可解释性-准确性之间的矛盾在于能够完成复杂任务和真正理解任务如何完成之间的差别。平衡好准确性和可解释性的关系,也就相当于理解了知识VS控制,性能VS可靠度,效率VS简洁性之间的矛盾。

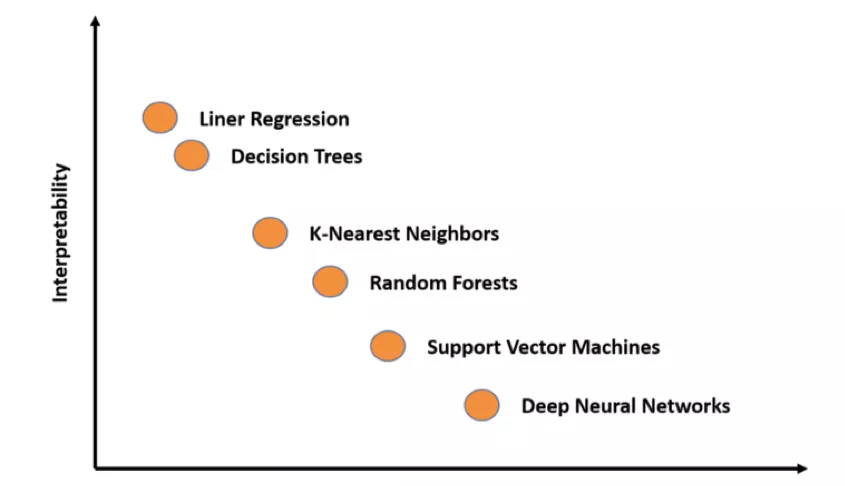

应该注重取得最好结果还是注重理解结果产生的过程?在任何深度学习场景中,数据科学家都需要考虑这一问题。许多深度学习技术本身十分复杂,即便大多数情况下都得到了准确的最终结果,人们却很难对其进行解释。如果用图表来表示一些广为人知的深度学习模型中准确性和可解释性的关系,将得到如下结果:

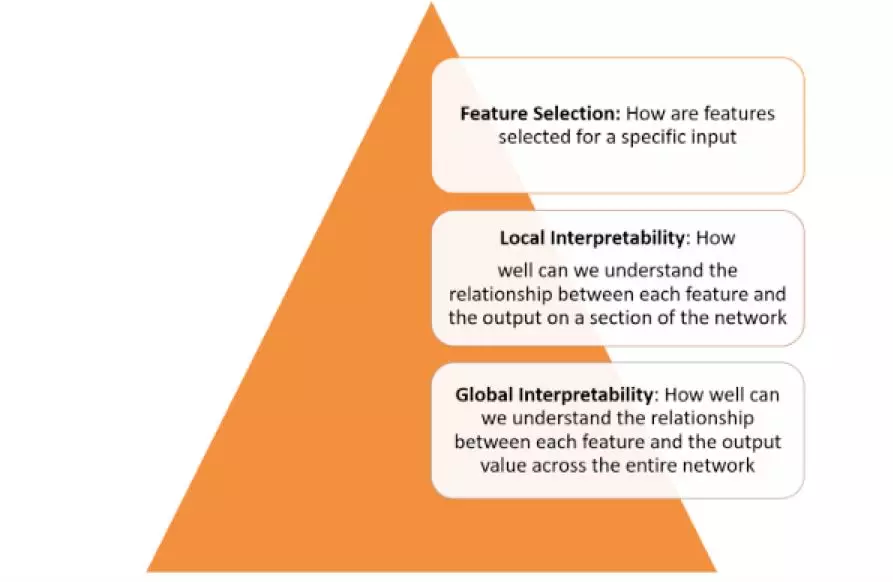

深度学习模型的可解释性不是一个简单的概念,应从多个层次看待:

要想如上图所示,实现各层面的可解释性,需要一些基本构件。谷歌研究人员在最近发表的文章中列出了他们认为实现可解释性所需的一些基本要素。

谷歌对可解释性的根本原则做出如下解释:

-明白隐藏层的作用:深度学习模型中的许多原理都是在隐藏层中实现的。宏观了解各个隐藏层功能对解释深度学习模型而言至关重要。

-明白节点激活方式:可解释性的关键不是理解单个神经元在网络中的功能,而在于明白相同空间位置中互相联系的各组神经元之间的作用。在拆分神经网络之时,对相互关联的神经元分组将有助于理解该网络的功能。

-明白概念形成过程:了解深度神经中枢网络形成自身概念进而得出最终结果的过程是建立可解释性的另一关键。

以上原则是谷歌最新概念激活向量技术的理论基础。

概念激活向量

根据上文所述,实现可解释性的一个根本方法是根据深度学习模型考虑的输入特征描述其预测过程。一个典型案例是逻辑回归分类,其中系数权重通常被解释为每个特征的重要性。然而,许多深度学习模型基于如像素值之类的参数特征进行操作,这些特征和人类易于理解的高级概念不相对应。此外,一个模型的内部值(如神经中枢激活)似乎也是无法理解的。尽管此类技术能有效测量特定像素区域的重要性,它们却无法与更高级的概念相关联。

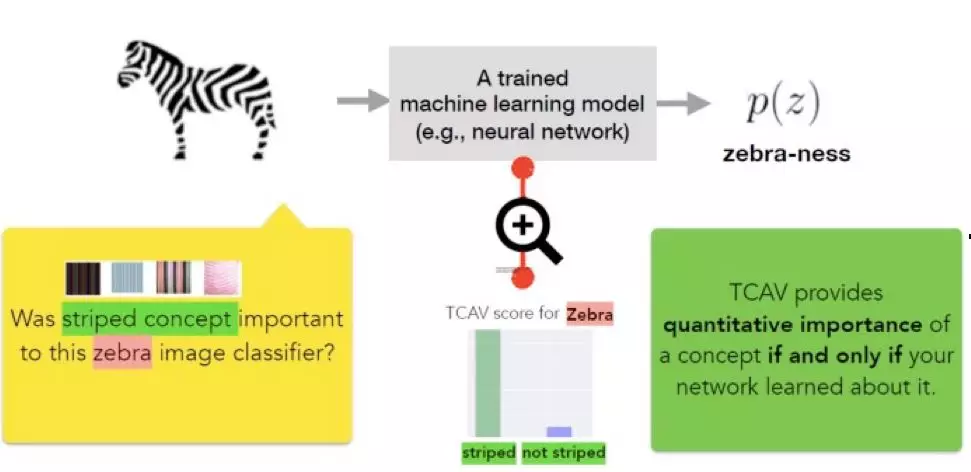

概念激活向量的核心原理在于测量模型输出结果中的概念关联性。某一概念的概念激活向量指该概念一组示例的值(如激活)的向量。谷歌研究团队在发布的论文中概述了一种名为概念激活向量测试(TCAV)的新型线性可解释性方法。该方法使用方向导数来量化模型预测对概念激活向量学习的基础高级概念的敏感性。从概念上讲,概念激活向量测试有四个目标:

-可行性:使用者几乎无需具备深度学习知识

-定制性:适配于任何概念(如性别等)且不仅限于训练时使用的概念

-内嵌可读性:无需深度学习模型再次训练或优化。

-全球定量:可使用单个定量度量来解释整类或整组示例,而非解释单一数据输入。

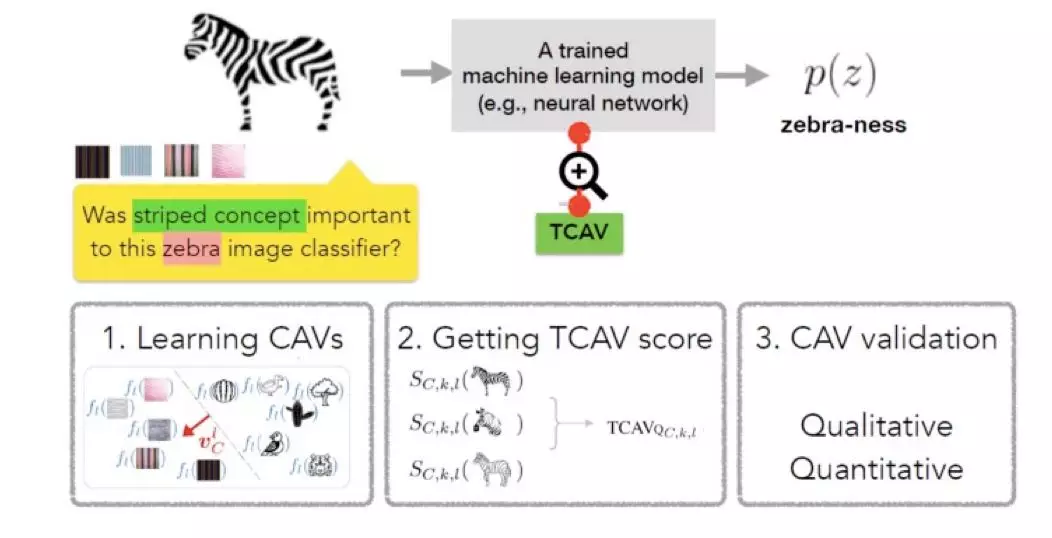

为实现上述目标,概念激活向量测试方法分为三个基本步骤:

1)定义模型的相关概念。

2)理解这些概念预测结果的敏感性。

3)推断各概念对各模型预测类相对重要性,做出全局定量解释。

概念激活向量测试方法的第一步是定义一个感兴趣的概念(概念激活向量).概念激活向量测试通过选择一组代表该概念的例子或者找到一个标有概念的独立数据集来实现这一步。训练线性分类器区分概念示例和任何层中的示例所产生的激活结果,从而使概念激活向量得到学习。

第二步是生成一个概念激活向量测试分数,用于量化预测特定概念的敏感性。要实现这一步骤,可通过使用定向导数来衡量机器学习预测对神经激活层概念方向输入变化的敏感性。

最后一步是评估所学习概念激活向量的全局相关性,以避免依赖不相关的概念激活向量。毕竟,概念激活向量测试技术的一个缺陷是有可能学习无意义的概念激活向量。再者,使用随机选择的一组图像也能产生概念激活向量。基于这样一个随机概念进行的测试毫无意义。为解决这一问题,概念激活向量测试引入了一项统计显着性检验,可以根据随机次数的训练运行来评估概念激活向量,通常为500次。该办法的依据在于有意义的概念激活向量测试分数在训练运行中会表现一致。

概念激活向量测试实际应用

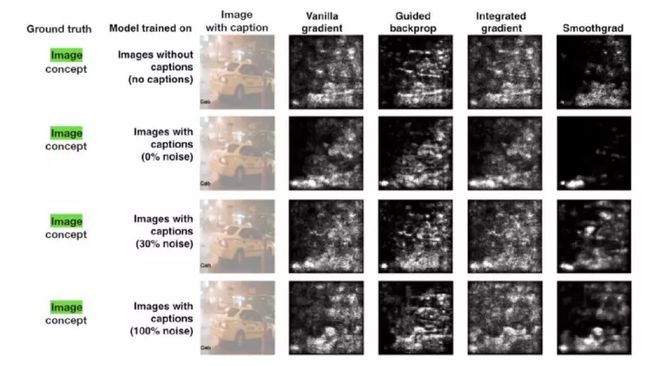

Google Brain团队进行了几项实验来评估与其他可解释性方法相比概念激活向量测试的效率。在最著名的一次测试中,该团队使用了一个显着图,试图通过预测标题或图像的相关性以理解出租车这一概念。显着图的输出结果如下所示:

Google Brain团队使用这些图像作为测试数据集,在Amazon Mechanical Turk上对50人进行了实验。每个工作人员执行针对单个模型的一系列六个任务(3个对象类x 2种显着图类型)。任务顺序随机。每项任务中,工作人员首先看到四个图像及其相应的显着性掩模。然后评估他们认为图像对模型的重要程度(10分制)、标题对模型的重要性(10分制),以及他们对答案的自信程度(5分制)。共评估60个独特的图像(120个独特的显着图)。

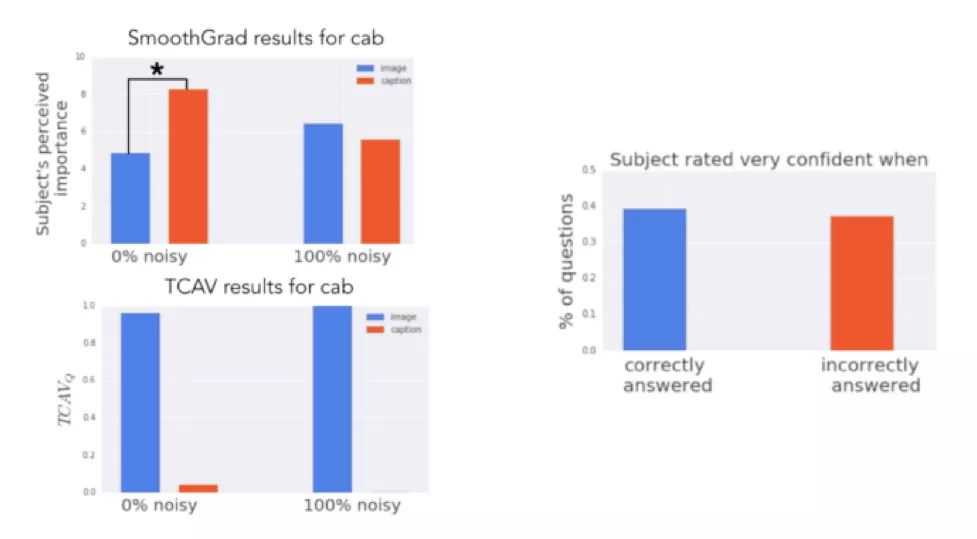

实验实况显示,图像概念比标题概念更相关。然而,观察显着性图时,人们认为标题概念更重要(0%噪声标签的模型),或认为两者并无差异(100%噪声标签的模型)。相比之下,概念激活向量测试结果正确地表明图像概念更重要。

概念激活向量测试是最近几年来实现神经网络可解释性的最新方式之一。可以在GitHub上获取这项先进技术的代码,未来这项技术的一些想法也将被主流深度学习框架采用。

传送门:https://github.com/tensorflow/tcav?source=post_page---------------------------

留言 点赞 关注

我们一起分享AI学习与发展的干货

欢迎关注全平台AI垂类自媒体 “读芯术”

(添加小编微信:dxsxbb,加入读者圈,一起讨论最新鲜的人工智能科技哦~)