Hadoop环境的搭建

1、修改服务器的主机名

a、可以通过hostname进行临时性的修改,但为便于管理,需直接进行永久性的修改

b、永久性的修改,可以直接修改/etc/sysconfig/network中的hostname名称

c、修改/etc/hosts域名映射,采用外网ip进行映射

2、srt上传文件

通过点击打开SFTP连接窗口,相关命令如下:

服务器命令不变,本地命令为在服务器命令之前加一个l,代表本地

如:cd/lcd,ls/lls

上传文件是put,上传某个目录下的所有文件可以采用put ./*

下载文件是get,下载某个目录下的所有文件可以采用get ./*

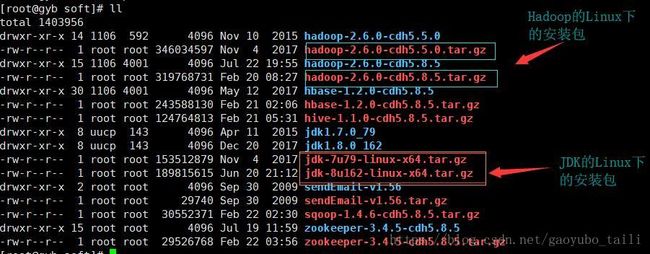

3、jdk的安装(先把安装包上传到指定的目录下)

3.1、解压释放文件,如tar -zvxf jdk-7u79-linux-x64.tar.gz

![]()

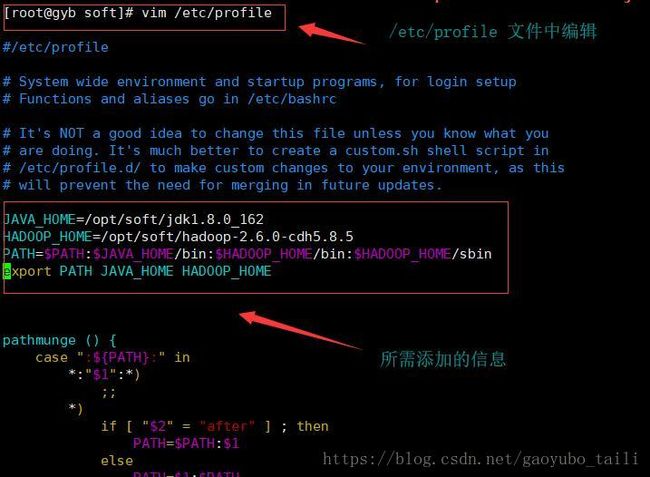

3.2、在/etc/profile文件中配置JAVA_HOME路径,如:

JAVA_HOME=/opt/soft/jdk1.7.0_79

PATH=$PATH:$JAVA_HOME/bin

export JAVA_HOME PATH

3.3、保存/etc/profile文件,通过source /etc/profile进行更新操作

3.4、通过java -version查询是否安装成功

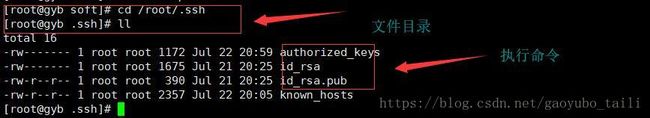

4.ssh面密码登陆

4.1 现在客户端机器上通过命令ssh-keygen -t rsa生成一对公钥和私钥

4.2 将客户端上面的私钥通过scp命令传输到服务器上,例如:

scp id_rsa.pub root@vdata2:/root

4.3 cat id_rsa.pub >>/root/.ssh/authorized_keys

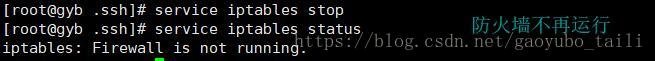

5、关闭服务器的防火墙

5.1 通过service iptables stop命令进行关闭,然后可以

通过service iptables status命令进行查看

5.2 关闭防火墙自动开启的功能,命令如下

chkconfig iptables off

可以通过chkconfig --list |grep iptables进行查看

6、hadoop集群的安装

6.1 先打通服务器上面的免密码登陆,并安装jdk1.7

6.2 下载hadoop安装包,并上传到服务器对应的管理目录下

6.3 然后将安装包进行解压,如tar -zxvf hadoop.tar.gz

![]()

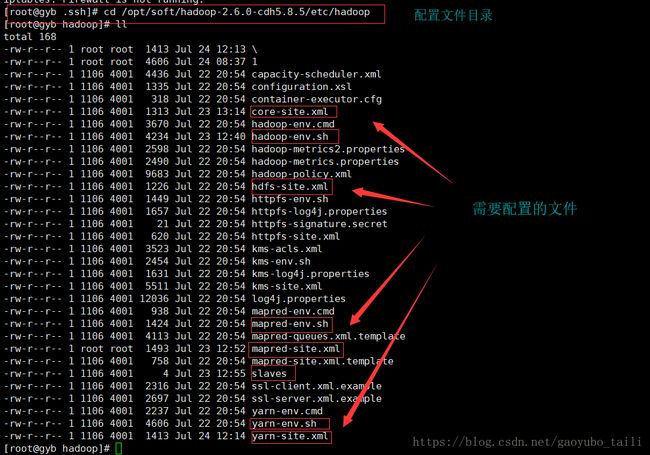

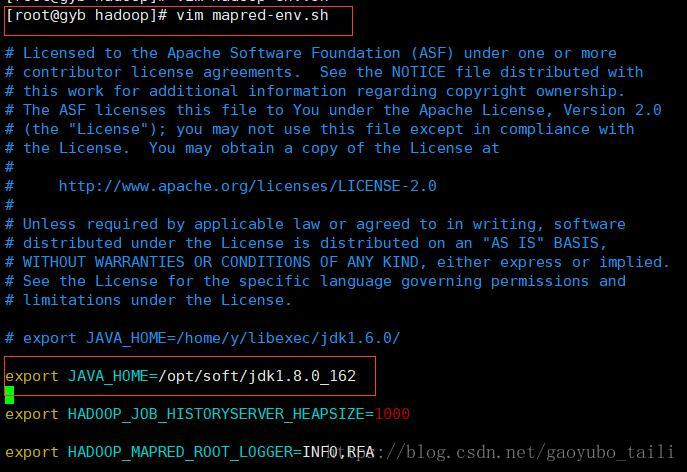

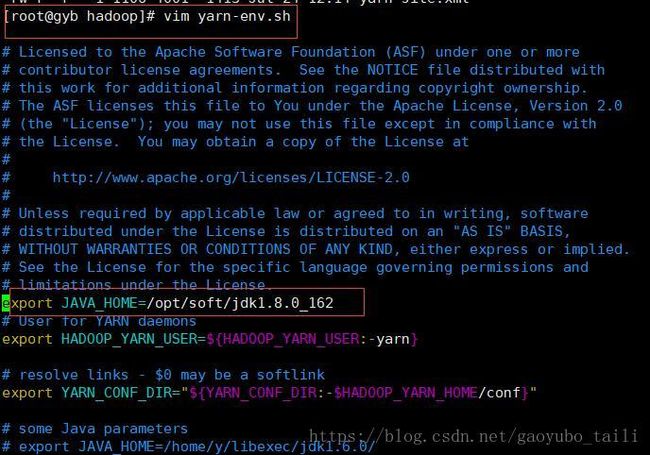

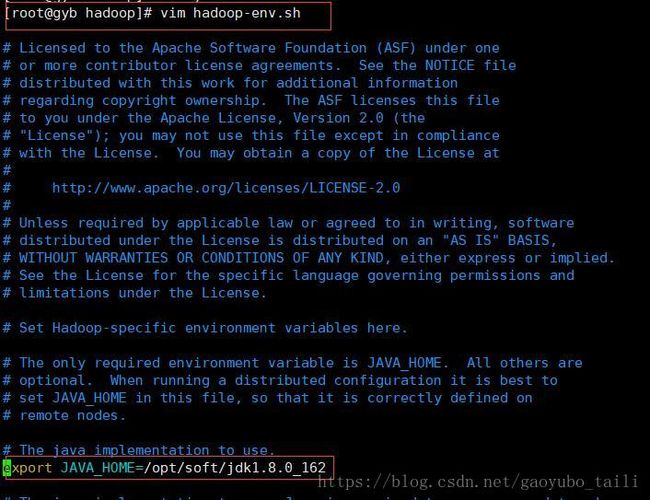

6.4 修改相关配置文件

6.4.1 修改hadoop-env.sh配置文件,添加JAVA_HOME

6.4.2 修改yarn-env.sh配置文件,添加JAVA_HOME

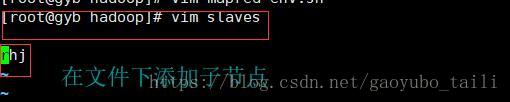

6.4.3 修改slaves配置文件,添加相关从节点的主机名

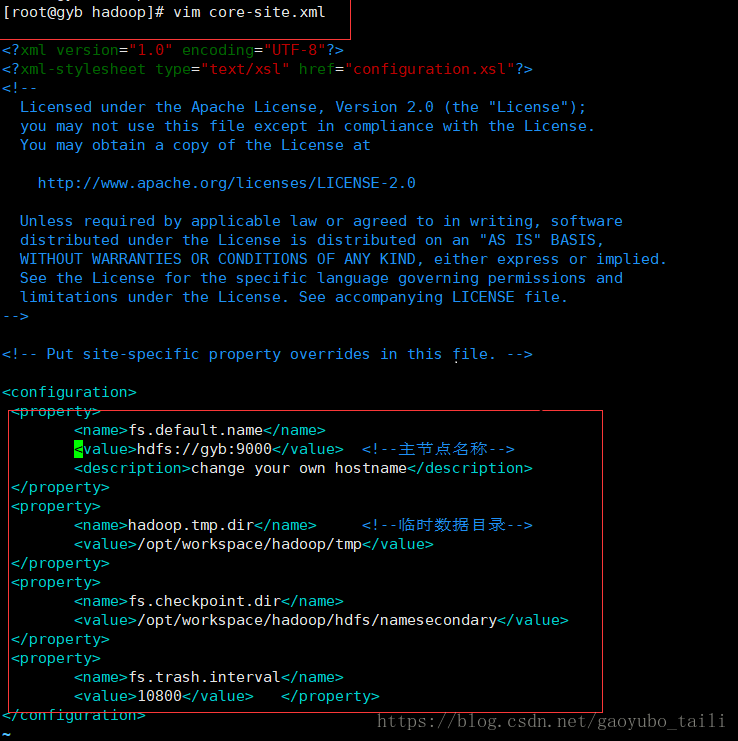

6.4.4 修改core-site.xml配置文件,添加如下内容

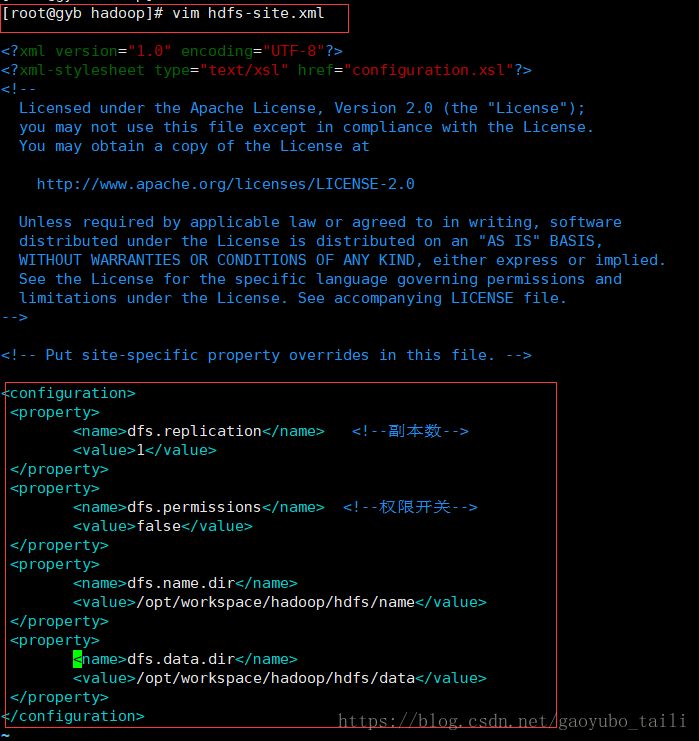

6.4.5 修改hdfs-site.xml配置文件,添加如下内容

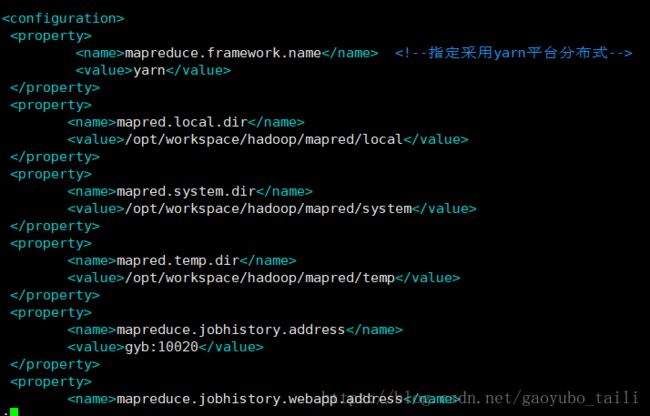

6.4.6 修改 mapred-site.xml配置文件

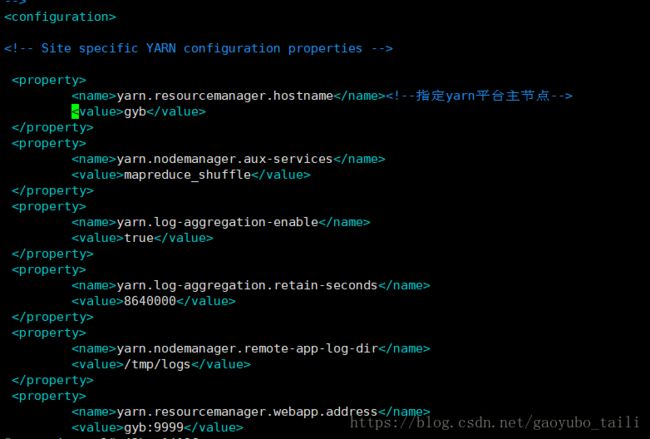

6.4.7 修改yarn-site.xml配置文件

6.4.8 将相关的配置文件复制到其它的子节点上,如下:

scp * root@vdata3:/opt/soft/hadoop-2.6.0-cdh5.5.0/etc/hadoop/

6.4.9 格式化namenode,命令如下:

hdfs namenode -format

为了执行命令方便可以将HADOOP_HOME配置到/etc/profile的path路径下

6.4.10 启动集群,可以通过如下命令方式

start-all.sh /stop-all.sh