(该列族的StoreFiles)

/hbase

/WALs

/ (RegionServers)

/ (WAL files for the RegionServer)

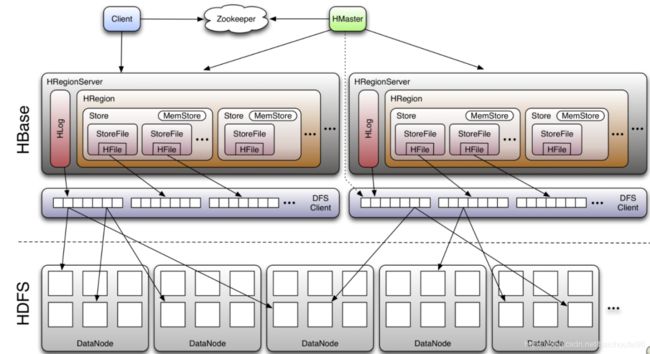

3.6 Region

3.6.1 概述

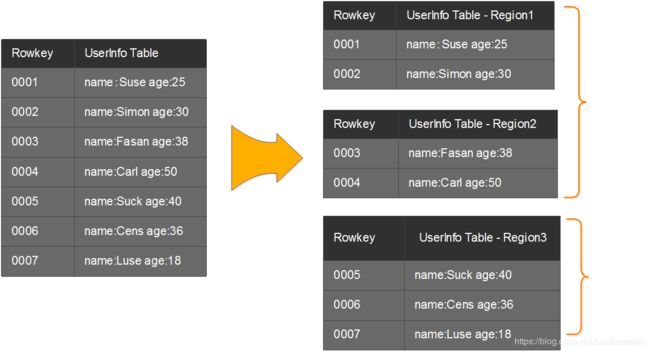

一个Region水平切分的示例:

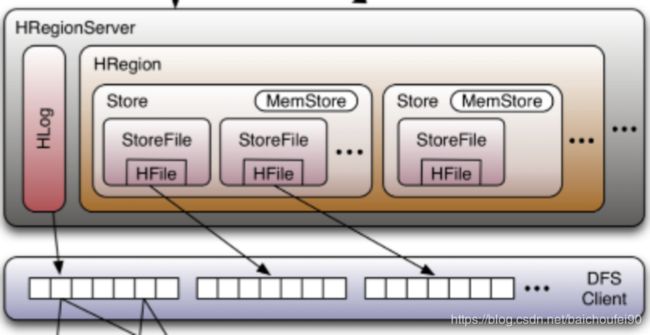

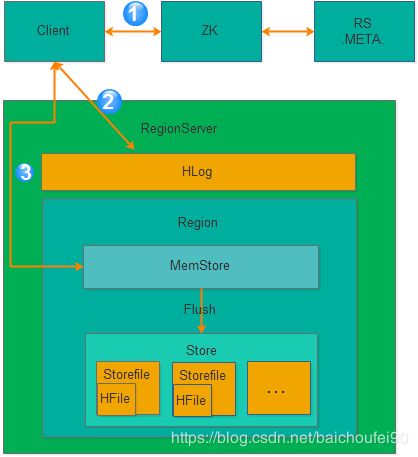

一个RegionServer上存在多个Region和一个Hlog实例。

Region属于某个表水平拆分的结果(初始一个Region),每个表的Region分部到多个RegionServer。

Region上按列族划分为多个Store

每个Store有一个MemStore,当有读写请求时先请求MemStore。MemStore内部是根据RowKey, Column, Version排序

每个Store又有多个StoreFile

3.6.2 Region分配

HMaster使用AssignmentManager,他会通过.META.表检测Region分配的合法性,当发现不合法(如RegionServer挂掉)时,调用LoadBalancerFactory来重分配Region到其他RS。

分配完成并被RS打开后,需要更新.META.表。

3.6.3 Region Merge(合并)

可参考:

HBase Compaction的前生今世-身世之旅

3.6.3.1 手动合并

注意,这里说的是Region级别的合并,一旦手动触发,HBase会不做很多自动化检查,直接执行合并。

手动合并目的

线上业务可能因为自动major compaction影响读写性能,因此选择低峰期手动触发;

用户在执行完alter操作之后希望立刻生效;

管理员发现硬盘容量不够,手动触发major compaction删除大量过期数据;

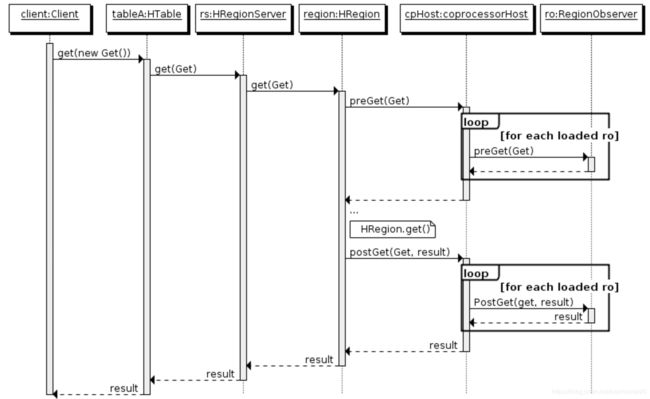

该过程对Client来说是异步的,是Master和RegionServer共同参与,步骤如下:

Client通过RPC发送请求给Master

Master将regions移动到目标RS

Master发送合并请求给此RS

RS运行合并

3.6.3.2 自动合并

这里指的是StoreFile级别的合并。

原因

时机

Memstore Flushhbase.hstore.blockingStoreFiles,则会阻塞该Region的更新写入操作,直到有Compact发生减少了StoreFile数量或等待until hbase.hstore.blockingWaitTime超时,然后继续正常Flush。

后台线程周期性检查

手动触发

Compact过程Compact过程,就是RegionServer定期将多个小StoreFile合并为大StoreFile,具体如下:

筛选出需要合并的HFile list。

HRegion创建StoreFileScannaer,来将待合并文件中的所有KeyValue读出再按从小到大排序后写入位于./tmp目录下的临时文件。此时就会忽略TTL过期数据。

将该临时文件移动至对应Region的数据目录。

将Compact输入(合并前的StoreFile)/输出(合并后的StoreFile)文件路径封装为KeyValue后写入WAL,并打上Compact标记,然后强制sync刷入磁盘。

最后将合并前的StoreFile删除即可。这也就是LSM小树合并为大树思想。

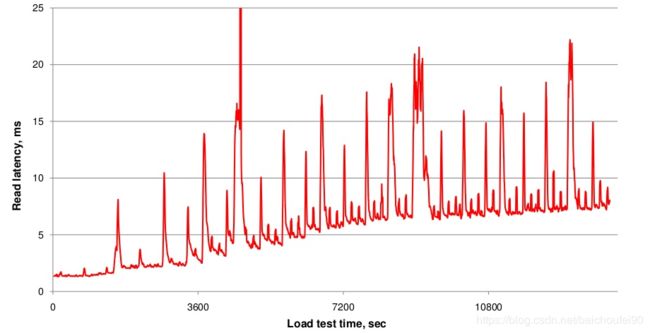

Compact影响

读放大

写放大hbase.hstore.blockingStoreFiles的StoreFiles,则会阻塞此Region的更新,直到Compact使得文件数低于该值或阻塞时间超出hbase.hstore.blockingWaitTime。这种阻塞行为可在RS的日志中查看到。

影响小结

自动合并分为Minor Compact和Major Compact:

Minor Compact

合并概述:

Minor Compact会合并TTL过期的数据:合并时会删除这些TTL过期数据,不再写入合并后的StoreFile。(注意TTL删除的数据无墓碑)

Minor Compact一般速度很快,对业务的影响也比较小,就是使用短时间的IO消耗以及带宽消耗换取后续查询的低延迟。

合并过程

分别读取出待合并的StoreFile文件的KeyValues,并顺序 地写入到位于./tmp目录下的临时文件中

将临时文件移动到对应的Region目录中

将合并前的待合并文件路径和输出的已合并文件路径封装成KeyValues写入WAL日志,并打上compaction标记,最后强制自行sync

将对应region数据目录下的合并的输入文件全部删除,合并完成

输出

Major Compact

合并过程

有更新时,老的数据就无效了,最新的那个就被保留

被删除的数据,将墓碑和旧的都删掉

通过maxVersion制定了最大版本的数据,超出的旧版本数据会在合并时被清理掉不再写入合并后的StoreFile

有Split的父Region的数据会迁移到拆分后的子Region

输出

3.6.3.3 合并策略

3.6.3.3.1 关于Major Compact

默认Major Compact 7天执行一次,可能会导致异常开销,影响系统表现,所以可以进行手动调优。

3.6.3.3.2 ExploringCompactionPolicy

当前版本(1.2.0版)采用的合并策略为ExploringCompactionPolicy,挑选最佳的StoreFiles集合以使用最少量的工作进行压缩,可以减少合并带来的消耗。使用ExploringCompactionPolicy,主要Major Compact的频率要低得多,因为Minor Compaction效率更高。

流程如下:

列出目标Store中所有现有的StoreFiles,待过滤此列表以提出将被选择用于Compact的HFile子集。

如果这是手动执行的Compact,则尝试执行手动请求的压缩类型。

请注意,即使用户请求Major Compact,也可能无法执行 。原因可能是列族中某些StoreFiles不可Compact,或者因为列族中的StoreFiles太多。

某些StoreFiles会被自动排除掉:

大于hbase.hstore.compaction.max.size的StoreFile

使用hbase.mapreduce.hfileoutputformat.compaction.exclude排除的批量加载操作的StoreFile

遍历步骤1中的列表,并列出所有可合并的StoreFiles Set,将他们合并成一个StoreFile。这里的Set是指那些列表中的按hbase.hstore.compaction.min大小连续分组的StoreFile。对于每个备选Set执行一些检查来确定最佳合并Set:

排除那些StoreFile数小于hbase.hstore.compaction.min或大于hbase.hstore.compaction.max的Set

比较该Set和list中已检查过的最小的Set,如果本Set更小就作为算法卡住时的fall back。

依次对这组Set中的StoreFile进行基于大小的检查:

排除大小大于hbase.hstore.compaction.max.size的StorFile

如果大小大于或等于hbase.hstore.compaction.min.size,则根据基于文件的比率进行健全性检查,以查看它是否太大而排除掉。 如果符合以下条件,则完整性检查成功:

此Set中只有一个StoreFile

对于每个StoreFile的文件大小,需要小于该Set中的其他所有HFile的总大小乘以hbase.hstore.compaction.ratio(如果配置非高峰时间且检查时恰好是非高峰时间,则为hbase.hstore.compaction.ratio.offpeak)的结果。(比如FileX = 5MB, FileY = 2MB, FileZ = 3MB,此时5 <= 1.2 x (2 + 3)=6,所以FileX筛选通过;FileX大小大于6MB就不通过Compact筛选。)

如果该Set通过筛选,请将其与先前选择的最佳Compact Set进行比较。如果更好就替换。

当处理完整个潜在CompactFileList后,执行我们已经找到的最佳Compact。

如果没有成功选择出Compact Set,但存在多个StoreFiles,则认为此事属于算法卡住,就执行步骤4.2中找到的最小Set进行Compact。

RatioBasedCompactionPolicy想找到第一个”可行解“即可,而ExploringCompactionPolicy却在尽可能的去寻求一种自定义评价标准中的”最优解“。

3.6.3.3.3 RatioBasedCompactionPolicy

HBase 0.96.x之前使用RatioBasedCompactionPolicy,从老到新扫描潜在可选CompactStoreFile,选择那些没有在CompactQueue且比比正在Compact的StoreFile更新的StoreFile组成List且按SequenceId排序。此时如果算法卡住,则强制执行开销巨大的Major Compact。作为对比,更优的ExploringCompactionPolicy则是Minor Compact最小Set。

接下来的步骤和ExploringCompactionPolicy基本相同。

但如果剩余未遍历的待合并文件list数量少于hbase.hstore.compaction.min,则放弃Minor Compact。一旦找到满足条件的第一个StoreFile Set就停止扫描并开始Compact。Minor Compact的peak规则如下:

此StoreFile大小 < 其他StoreFile总大小 * hbase.hstore.compaction.ratio。也可使用hbase.hstore.compaction.ratio.offpeak, hbase.offpeak.start.hourhbase.offpeak.end.hour配置非高峰期选项。

最后,如果检查到最近一次Major Compact是很久以前的并且目前需要合并多个StoreFile,则会运行一个Major Compact,即使本应是Minor Compact。

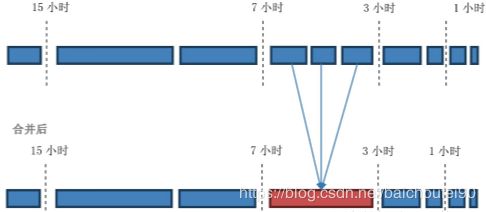

3.6.3.3.4 DateTieredCompaction

以上合并策略选取文件未考虑最近写入数据往往也更容易被读取这一特点,所以还是有缺陷。大量合并那些读的很少的老文件是没有必要的,因为他们合并后也不会对读性能有很多提升。

DateTieredCompaction(日期分层合并)是一种日期感知的StoreFile合并策略,将StoreFile按日期分为多个不同分区,并加入时间窗口概念,有利于的时序数据的time-range scan。

性能提升:

Compact提升:

老的数据很少读不需要频繁Compact,且特别老的数据永不再合并。

新的数据读频繁,合并后可减少扫描的文件数,减少了Compact开销。

读提升

适合场景:

有限时间范围的数据读取,尤其是对最近数据的scam

比如微信朋友圈或者微博,新发的最有可能被别人看,但很长时间以前发的没人或很少有人阅读。这类HFile就可以分为旧和新两类数据,将较新的和新的HFile合并,旧的一起合并。

不适合的场景:

无界的时间范围的随机Get

频繁删除和更新

由于频繁的乱序数据写入会导致长尾,尤其是具有未来时间戳的写入

频繁的批量加载,且时间范围有很大重叠

性能提升:

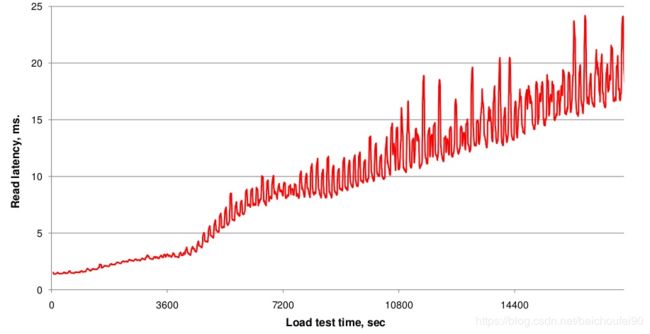

DateTieredCompaction性能测试表明,time-range scan的性能在有限的时间范围内有很大改善,特别是对最近数据的scan。

要为表或列族启用DateTieredCompaction:

需将hbase.hstore.engine.class设置为org.apache.hadoop.hbase.regionserver.DateTieredStoreEngine。

需将hbase.hstore.blockingStoreFiles设置为较大数字,例如60,而不是默认值12)。

需将hbase.hstore.compaction.max设置为与hbase.hstore.blockingStoreFiles相同的值,避免Major Compat时发生写入阻塞。

DateTieredCompaction主要参数如下:

参数

含义

默认值

hbase.hstore.compaction.date.tiered.max.storefile.age.millis

Storefile的最大Timestamp值比该参数还小的永不会被合并

Long.MAX_VALUE

hbase.hstore.compaction.date.tiered.base.window.millis

毫秒级的基础时间窗口大小,后面会越来越大

6小时

hbase.hstore.compaction.date.tiered.windows.per.tier

每个层级的增加的窗口倍数,比如为2,则窗口大小变动为6小时->12小时->24小时

4

hbase.hstore.compaction.date.tiered.incoming.window.min

在incoming窗口中Compact的最小文件数。 将其设置为窗口中预期的文件数,以避免浪费资源进行极少文件Compact

6

hbase.hstore.compaction.date.tiered.window.policy.class

在同一时间窗口内挑选Storefile的策略,该策略不适用于incoming窗口。

ExploringCompactionPolicy

hbase.regionserver.throughput.controller

推荐将Compact节流阀设为org.apache.hadoop.hbase.regionserver.compactions.PressureAwareCompactionThroughputController,因为分层Compact中所有急群众的RS会同时提升窗口到高层级

-

下面是基础窗口为1小时,窗口成长倍数为2,最小合并文件数为3的一个例子:[3-7)这个窗口有3个文件满足了最小合并文件数,所以会被Compact。

如果HFile跨窗口,则会被计入时间更老的窗口。

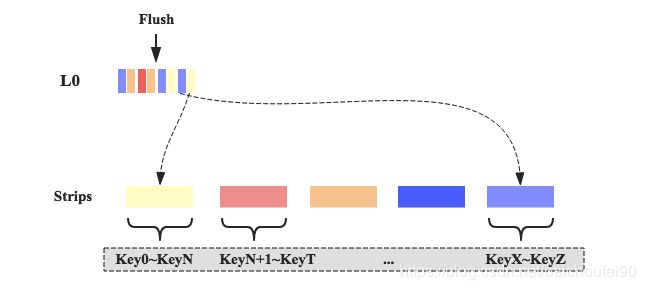

3.6.3.3.5 StripeCompactionPolicy

MemStore数据Flush后的HFile属于L0,当L0的文件数达到可配的阈值后触发写入,即将L0数据读取后写入L1。

L1的数据按ROWKEY范围进行划分,划分结果是多个户不重叠的Stripe,思想可类比将Region拆分多个子Region。

从L0写入L1的KeyValue数据就是根据Key来定位到具体的某个Stripe。

StripeCompactionPolicy提升如下:

Compact提升

读取提升

读写稳定性提升

StripeCompactionPolicy的适用场景:

Region巨大。

RowKey需要具有统一格式,才能进行Stripe切分。比如时间格式Key数据,就可以让老的数据不合并,只合并接收新数据的那些Stripe。

3.6.3.4 CompactThreadPool

HBase CompactSplitThead线程负责Compact和Split,内部又分为Split线程池和用于Compact的largeCompactions、smallCompactions线程池。分入哪个线程池的判断依据:

待compact的文件总大小大于hbase.regionserver.thread.compaction.throttle,则用largeCompactions。该阈值默认值为2 x hbase.hstore.compaction.max(默认10) x hbase.hregion.memstore.flush.size(默认128MB)

否则使用smallCompactions

这两个Compact线程池默认单线程,可通过hbase.regionserver.thread.compaction.large和hbase.regionserver.thread.compaction.small修改。

3.6.3.5 合并/scan并发问题

当scan查询时遇到合并正在进行,解决此问题方案点这里

3.6.3.5 合并限流

Compact或多或少会影响HBase其他功能的表现,所以HBase在1.5之后有对Compact进行限流,2.x后默认会自动限流Compact,在压力大时降低合并吞吐量,压力小时增加。需要注意的是Compact限流是RegionServer级别,而非Compact级别。

具体来说:

HBase根据系统外部压力(即相当对于最大文件数阈值的当前StoreFile数量,越多则压力越高),调整允许的合并时的吞吐量阈值(每秒写入的字节范围),可在给定的上下界之间变动(Compact实际会工作在吞吐量为lower + (higer – lower) * pressureRatio的限制下,其中ratio是一个取值范围在(0,1),它由当前store中待参与Compation的Hfile数量动态决定。文件数量越多,ratio越小,反之越大)。

如果HFile数量达到了hbase.hstore.blockingStoreFiles限制则阻塞MemStore Flush,直到Compact使得文件数低于该值或阻塞时间超出hbase.hstore.blockingWaitTime。

如果MemStore Flush达到hbase.hregion.memstore.block.multiplier 乘以 hbase.hregion.memstore.flush.size字节时,会阻塞写入,主要是为了防止在update高峰期间MemStore大小失控,造成其flush的文件需要很长时间来compact或split,甚至造成OOM服务直接down掉。内存足够大时,可调大该值。

关于pressureRatiopressureRatio默认为flushPressure,throughput.controller设为PressureAwareCompactionThroughputController时为compactionPressure。

compactionPressure=(当前HFile数-minFilesToCompact)/(blockingStoreFiles-minFilesToCompact),其中 minFilesToCompact为hbase.hstore.compaction.min。所以该值越大说明堆积的HFile越多,越可能达到阈值导致写入阻塞,需要加快合并,所以吞吐量限制阈值会变高。当pressureRatio大于1时,即当前HFile数大于blockingStoreFiles,发生写入阻塞,此时会直接不再限制合并吞吐量,疯狂Compact。如果当前HFile数小于minFilesToCompact则不会发生合并。

flushPressure= globalMemstoreSize(当前MemStore总大小) / memstoreLowerLimitSize(hbase.regionserver.global.memstore.lowerLimit,RS级别MemStore flush下界)

主要配置如下:

参数

释义

默认值

hbase.hstore.compaction.throughput.lower.bound

吞吐量下界,默认50MB/s

52428800

hbase.hstore.compaction.throughput.higher.bound

吞吐量上界,默认100MB/s

104857600

hbase.regionserver.throughput.controller

RS吞吐量控制器,若想无限制设为org.apache.hadoop.hbase.regionserver.throttle.NoLimitThroughputController;控制合并相关指标org.apache.hadoop.hbase.regionserver.compactions.PressureAwareCompactionThroughputController;

控制刷写相关指标:PressureAwareFlushThroughputController

hbase.hstore.blockingStoreFiles

如果任何一个Region的Store中存在超过hbase.hstore.blockingStoreFiles的StoreFiles,则会阻塞此Region的MemStore flush,直到Compact使得文件数低于该值或阻塞时间超出hbase.hstore.blockingWaitTime。这种阻塞行为可在RS的日志中查看到。

16

hbase.hstore.compaction.ratio

对于MinorCompac,此比率用于确定大于hbase.hstore.compaction.min.size的StoreFile是否有资格进行Compact,目的是限制大型StoreFile Compact。

1.2F

hbase.offpeak.start.hour

非高峰期的起始小时,[0-23]

-1(禁用)

hbase.offpeak.end.hour

非高峰期的终止小时,[0-23]

-1(禁用)

hbase.hstore.compaction.ratio.offpeak

非高峰时段使用的Compact ratio,默认很激进的策略,用来决定非高峰期时段内大型StoreFile被涵盖在Compact内的策略。 表示为浮点小数。 这允许在设定的时间段内更积极(或更低级,如果您将其设置为低于hbase.hstore.compaction.ratio)的Compact。 如果禁用非高峰时则忽略本参数。 本参数与hbase.hstore.compaction.ratio的工作方式相同。具体可以参考ExploringCompactionPolicy

5.0F

3.6.4 Region Split(拆分)

可参考Region切分细节

默认情况下,HBase表初始创建时只有一个Region,放在一个RegionServer上。HBase有自动Split,也可以pre-split或手动触发split。

3.6.4.1 自动Split策略

本段转自Hbase 技术细节笔记(下)

用到的参数主要是hbase.hregion.max.filesize,即HFile大小超过此值就Split。

HBase Region的拆分策略有比较多,比如除了3种默认过的策略,还有DelimitedKeyPrefixRegionSplitPolicy、KeyPrefixRegionSplitPolicy、DisableSplitPolicy等策略,这里只介绍3种默认的策略。分别是ConstantSizeRegionSplitPolicy策略、IncreasingToUpperBoundRegionSplitPolicy策略和SteppingSplitPolicy策略。

ConstantSizeRegionSplitPolicyhbase.hregion.max.filesize(默认10G)后拆分。

这种拆分策略对于小表不太友好,按照默认的设置,如果1个表的Hfile小于10G就一直不会拆分。注意10G是压缩后的大小,如果使用了压缩的话。如果1个表一直不拆分,访问量小也不会有问题,但是如果这个表访问量比较大的话,就比较容易出现性能问题。这个时候只能手工进行拆分。还是很不方便。

IncreasingToUpperBoundRegionSplitPolicy

是Hbase的0.94~2.0版本默认的拆分策略,这个策略相较于ConstantSizeRegionSplitPolicy策略做了一些优化,该策略的算法为:min(r^2*flushSize,maxFileSize ),最大为maxFileSize 。

从这个算是我们可以得出flushsize为128M、maxFileSize为10G的情况下,可以计算出Region的分裂情况如下:

从上面的计算我们可以看到这种策略能够自适应大表和小表,但是这种策略会导致小表产生比较多的小region,对于小表还是不是很完美。

SteppingSplitPolicy

if region=1

then: flush size * 2

else: MaxRegionFileSize

还是以flushsize为128M、maxFileSize为10场景为列,计算出Region的分裂情况如下:

从上面的计算我们可以看出,这种策略兼顾了ConstantSizeRegionSplitPolicy策略和IncreasingToUpperBoundRegionSplitPolicy策略,对于小表也有比较好的适配。

一般情况下使用默认切分策略即可,也可以在cf级别设置region切分策略,命令为:

create ’table’, {NAME => ‘cf’, SPLIT_POLICY => ‘org.apache.hadoop.hbase.regionserver. ConstantSizeRegionSplitPolicy'}

3.6.4.2 自动Split

可参考

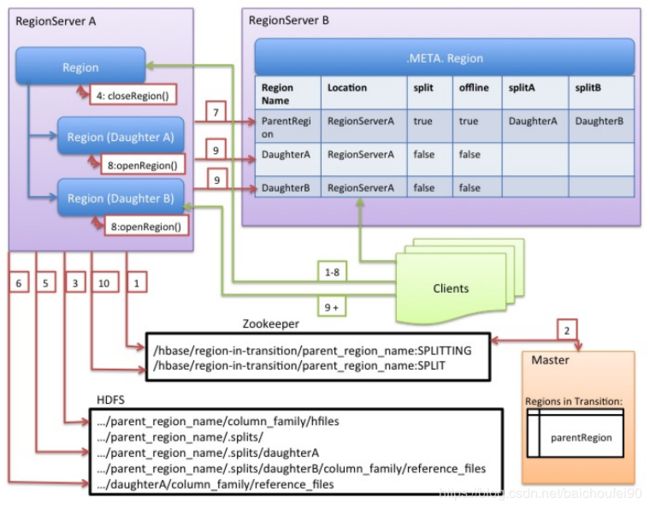

注意:Split过程是RegionServer进行的,没有Master参与。

当Region大小超过一定阈值后,RS会把该Region拆分为两个(Split),

将原Region做离线 操作

把新生成的Region放入.META.表。

打开新Region,以使得可访问

通知Master该次Split,可按需用自动平衡等机制迁移子Region到其他RegionServer。

上图中,绿色箭头为客户端操作;红色箭头为Master和RegionServer操作:

RegionServer决定拆分Region,并准备拆分。此时,Split事务已经开始 。RegionServer在表上获取共享读锁,以防止在他人在拆分过程中修改表的schema;然后在ZK的/hbase/region-in-transition/region-name下创建一个znode,并将该节点状态设置为SPLITTING。

Master在/hbase/region-in-transition设置了Watcher,所以会感知到这个znode变更,从而得知该split事件,在Master页面RIT模块可以看到region执行split的状态信息。

RegionServer在HDFS的/hbase/region-in-transition/region-name目录下创建一个名为.splits的子目录。

RegionServer关闭该待split的Region,并在其本地数据结构中将该Region标记为离线状态。被分裂的Region现在处于离线状态。此时,如果客户端请求该Region将抛出NotServingRegionException,客户端将自动重试 。

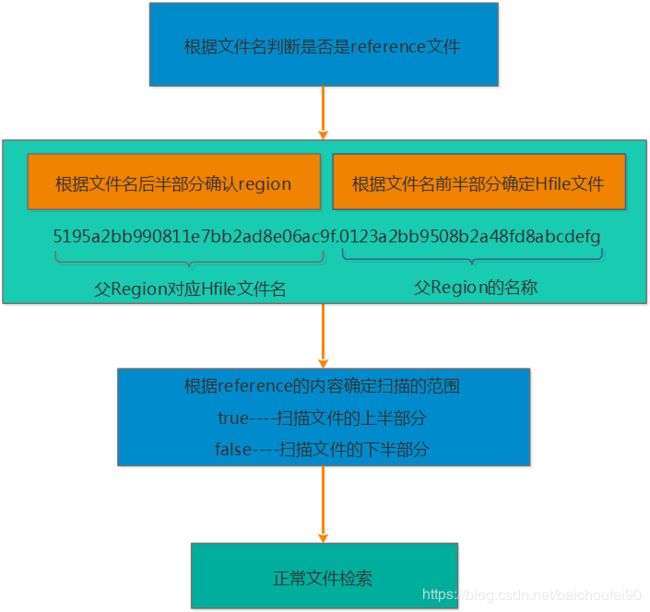

RegionServer在父Region.splits目录下为子Region A和B创建目录和必要的数据结构。然后它将拆分StoreFiles,在子Region目录中为每个父Region的StoreFile创建两个指针reference文件来指向父Region的文件。

reference文件名的前半部分是父Region对应的HFile文件名,.号后的部分是父Region名称。

文件内容主要有两部分构成:

切分点splitkey

boolean类型的变量(true或者false),true表示该reference文件引用的是父文件的上半部分(top),而false表示引用的是下半部分 (bottom)。

RegionServer为子Region们在HDFS中创建实际的Region目录,并移动每个子Region的指针文件。

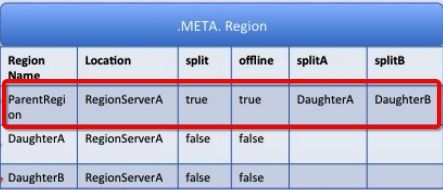

RegionServer向.META表发送Put请求,将父Region设置为离线 ,并添加子Region的信息(此时客户端不可见)。在.META表更新即将父Region Offline列设为true,Region拆分将由Master推进。.META.成功更新之后,region split的流程还会继续进行下去。相当于是个补偿机制,下次在打开这个parent region的时候会进行相应的清理操作。

RegionServer并行打开子Region A和B.

RegionServer将子Region A和B的信息添加到.META表,具体来说在.META表更新即将子Region Offline列设为false。此时,这些子Region现在处于在线状态 。在此之后,客户端可以发现新Region并向他们发出请求了。客户端会缓存.META到本地,但当他们向RegionServer或.META表发出请求时,原先的ParentRegion的缓存将失效,此时将从.META获取新Region信息。

RegionServer将ZooKeeper中的znode/hbase/region-in-transition/region-name更新为状态SPLIT ,Master可以感知到该事件。如有必要,平衡器可以自由地将子Region重新分配给其他RegionServer。Split拆分事务现已完成 。

拆分完成后,.META和HDFS仍将包含对父Region的引用。当子Region进行Major Compact,读取父Regionx相应数据进行数据文件重写时,才删除这些引用 。当检查线程发现SPLIT=TRUE的父Region对应的子Region已经没有了索引文件时,就删除父Region文件。Master的GC任务会定期检查子Region是否仍然引用父Region的文件。如果不是,则将删除父Region。

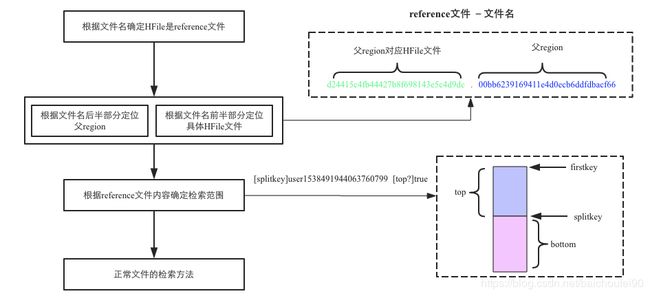

也就是说,Region自动Split并不会有数据迁移,而只是在子目录创建了到父Region的引用。而当Major Compact时才会进行数据迁移,在此之前查询子Region数据流程如下:

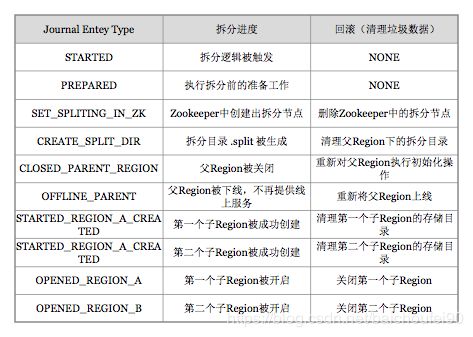

关于rollback:JournalEntryType 来表征各阶段:

关于RegionSplit的事务性

关于中间状态RIT和HBCK

3.6.4.3 pre-split预分区

在以下情况可以采用预分区(预Split)方式提高效率:

rowkey按时间递增(或类似算法),导致最近的数据全部读写请求都累积到最新的Region中,造成数据热点。

扩容多个RS节点后,可以手动拆分Region,以均衡负载

在BulkLoad大批数据前,可提前拆分Region以避免后期因频繁拆分造成的负载

为避免数据rowkey分布预测不准确造成的Region数据热点问题,最好的办法就是首先预测split的切分点做pre-splitting,以后都让auto-split来处理未来的负载均衡。

官方建议提前为预分区表在每个RegionServer创建一个Region。如果过多可能会造成很多表拥有大量小Region,从而造成系统崩溃。

注意合理分区方式Admin.createTable(byte[] startKey, byte[] endKey, 10)构建的"0000000000000000" 到 "ffffffffffffffff"的预分区如下:[0-9]和[a-f]从而使得仅有1,2,10号Region有数据,而其他Region无数据。

例子

# 创建了t1表的f列族,有4个预分区

create 'test_0807_1','cf1',SPLITS => ['10','20','30']

# 指定切分点建预分区表

create 'test_0807_2','cf1',SPLITS => ['\x10\x00', '\x20\x00', '\x30\x00', '\x40\x00']

# 建表,使用随机字节数组来进行预分4个Region

create 'test_0807_3','cf1', { NUMREGIONS => 4 , SPLITALGO => 'UniformSplit' }

# 建表,假设RowKey都是十六进制字符串来进行拆分,预分5个Region

create 'test_0807_4','cf1', { NUMREGIONS => 5, SPLITALGO => 'HexStringSplit' }

3.6.4.4 pre-split算法

一般来说,手动拆分是弥补rowkey设计的不足。我们拆分region的方式必须依赖数据的特征:

字母/数字类rowkey

自定义算法RegionSplitter工具可根据特点,传入算法、Region数、列族等,自定义拆分:

HexStringSplit

只需传入要拆分的Region数量,会将数据从00000000到FFFFFFFF之间的数据长度按照N等分,并算出每一分段的startKey和endKey来作为拆分点。

UniformSplit

DecimalStringSplit

可使用SplitAlgorithm开发自定义拆分算法

3.6.4.5 手动强制split

HBase 允许客户端强制执行split,在hbase shell中执行以下命令:

//其中forced_table 为要split的table , ‘b’ 为split 点

split 'forced_table', 'b'

更多内容可以阅读这篇文章Apache HBase Region Splitting and Merging

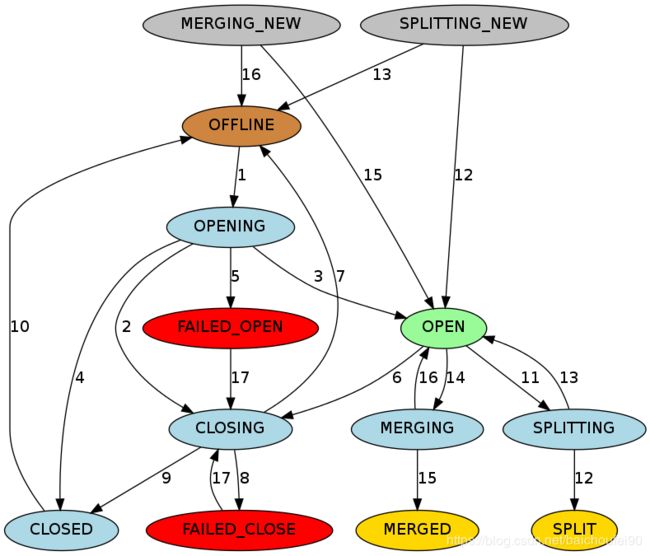

3.6.5 Region状态

HBase的HMaster 负责为每个Region维护了状态并存在META表,持久化到Zookeeper。

OFFLINE: Region离线且未打开

OPENING: Region正在打开过程中

OPEN: Region已经打开,且RegionServer已经通知了Master

FAILED_OPEN: RegionServer打开该Region失败

CLOSING: Region正在被关闭过程中

CLOSED: Region已经关闭,且RegionServer已经通知了Master

FAILED_CLOSE: RegionServer关闭该Region失败

SPLITTING: RegionServer通知了Master该Region正在切分(Split)

SPLIT: RegionServer通知了Master该Region已经结束切分(Split)

SPLITTING_NEW: 该Region是由正在进行的切分(Split)创建

MERGING: RegionServer通知了Master该Region和另一个Region正在被合并

MERGED: RegionServer通知了Master该Region已经被合并完成

MERGING_NEW: 该Region正在被两个Region的合并所创建

棕色:离线状态。是一个特殊的瞬间状态。

绿色:在线状态,此时Region可以正常提供服务接受请求

浅蓝色:瞬态

红色:失败状态,需要引起运维人员会系统注意,手动干预

黄色:Region切分/合并后的引起的终止状态

灰色:由切分/合并而来的Region的初始状态

具体状态转移说明如下:

OFFLINE->OPENINGOFFLINE状态移动到OPENING状态,并尝试将该Region分配给RegionServer。 Master会重试发送请求直到响应通过或重试次数达到阈值。RegionServer收到该请求后开始打开该Region。

OPENING->CLOSINGCLOSING并试图关闭它。即使RegionServer已经开始打开该区域也会这么做。如果Master没有重试,且之前的请求超时,就认为失败,然后将该Region设为CLOSING并试图关闭它。即使RegionServer已经开始打开该区域也会这么做。

OPENING->OPENOPEN状态并通知RegionServer。

OPENING->CLOSEDCLOSED,并尝试在其他的RegionServer上打开该Region。

OPENING->FAILED_OPEN如果Master无法在任何RegionServer中打开该Region,则会将该Region设为到FAILED_OPEN。HBase shell进行手动干预或服务器停止之前不会再有其他操作 。

OPEN->CLOSINGOPEN状态转到CLOSING状态。持有该Region的RegionServer可能已/未收到该关闭请求。Master重试发送关闭请求,直到RPC通过或重试次数达到阈值。

CLOSING->OFFLINENotServingRegionException,则Master将该Region移至OFFLINE状态,并将其重新分配给其他RegionServer。

CLOSING->FAILED_CLOSEFAILED_CLOSE状态,并且在管理员从HBase shell进行干预或服务器已停止之前不会采取进一步操作。

CLOSING->CLOSEDCLOSED状态,并将其重新分配给其他RegionServer。

CLOSED->OFFLINECLOSED状态,则Master会自动将Region移动到OFFLINE状态。

OPEN->SPLITINGOPEN切换到SPLITTING状态,并将拆分后要创建的两个新Region添加到RegionServer。这两个Region最初处于SPLITTING_NEW状态。

SPLITING->SPLITno return点,RegionServer就会再次通知Master以便更新META表。但在通知拆分完成之前,Master不会真正更新Region状态。如果拆分成功,则拆分区域将从SPLITTING移至SPLIT状态,并且两个新Region将从SPLITTING_NEW移至OPEN状态(13)。

SPLITTING->OPEN, SPLITTING_NEW->OFFLINESPLITTING移回OPEN状态,并且创建的两个新Region将从SPLITTING_NEW移至OFFLINE状态。

OPEN->MERGINGOPEN迁移到MERGING状态,并将用来保存合并后内容的新Region添加到RegionServer。新Region最初处于MERGING_NEW状态。

MERGING->MERGED, MERGING_NEW->OPENno return点,RegionServer就会再次通知r,以便Master可以更新META。但在通知合并已完成之前,Master不会更新区域状态。如果合并成功,则两个合并Region从MERGING状态转移到MERGED状态;新Region从MERGING_NEW移动到OPEN状态。

MERGING->OPEN, MEGING_NEW->OFFLINEMERGING移回到OPEN状态;而那个用于存放合并后内容的新Region则从MERGING_NEW转移到OFFLINE状态。

FAILED_CLOSE->CLOSING, FAILED_OPEN->CLOSINGFAILED_OPEN或FAILED_CLOSE状态的Region,当Master通过HBase Shell重新分配它们时会先尝试再次关闭它们。

3.6.6 负载均衡

由Master的LoadBalancer线程周期性的在各个RegionServer间移动region维护负载均衡。

3.6.7 Failover

请点击这里

3.6.8 Region不能过多

可参考官网-Why should I keep my Region count low?

MSLABMemStore-local allocation buffer,Memstore内存本地分配缓冲,将JVM Heap分为很多Chunk) ,它有助于防止堆内存的碎片化,减轻Full GC的问题(CMS会因为是标记-清除算法而导致老年代内存碎片,碎片过小无法分配新对象导致FullGC整理内存),默认开启,但他与MemStore一一对应,每个就占用2MB空间。比如一个HBase表有1000个region,每个region有2个CF,那也就是不存储数据就占用了3.9G内存空间,如果极多可能造成OOM需要关闭此特性。

HBase不适用TLAB线程私有化分配的原因是一个线程管理了多个Region的多个MemStore,无法隔离各个MemStore内存。比如5个Region(A-E),然后分别写入ABCDEABCEDDAECBACEBCED,然后B的MemStore发生了Flush,内存情况现在是:A CDEA CEDDAEC ACE CED,显然产生了内存碎片!如果后面的写入还是如之前一样的大小,不会有问题,但一旦超过就无法分配。也就是说,一个Region的MemStore内的内容其实在老年代内存物理地址上并不连续。于是HBase参考TLAB实现了一套以MemStore为最小分配单元的内存管理机制MSLAB。

RegionServer维护了一个全局MemStoreChunkPool实例,而每个MemStore实例又维护了一个MemStoreLAB实例,每个MemStore独占若干Chunk。所以MemStore收到KeyValue数据后先从MemStoreChunkPool中申请一个Chunk放入数据(放入curChunk并移动偏移量),放满了就重新申请Chunk来放数据。该过程是LockFree的,基于CAS。

如果MemStore因为flush而释放内存,则以chunk为单位来清理内存,避免内存碎片。注意,虽然能解决内存碎片,但会因为Chunk放小数据而降低内存利用率。

MSLAB还有一个好处是使得原本分开的MemStore内存分配变为老年代中连续的Chunk内分配。

最大的好处就是几乎完全避免了GC STW!

每个Region的每个列族就有一个Memstore,Region过多那么MemStore更多,总内存过大频繁触发Region Server级别阈值导致Region Server级别flush,会对用户请求产生较大的影响,可能阻塞服务响应或产生compaction storm(因为Region过多导致StoreFile也过多,不断合并)。

HMaster要花大量的时间来分配和移动Region,且过多Region会增加ZooKeeper的负担。

默认MR任务一个region对应一个mapper,region太多会造成mapper任务过多。

推荐的每个RegionServer的Region数量公式如下:((RS memory) * (total memstore fraction)) / ((memstore size)*(# column families))

3.6.9 Region不能过大

在生产环境中如果Region过大会造成compaction尤其是major compaction严重影响性能,目前推荐的region最大10-20Gb,最优5-10Gb。参数hbase.hregion.max.filesize控制单个region的HFile总大小最大值,再大就会触发split了:

当hbase.hregion.max.filesize比较小时,触发split的机率更大,系统的整体访问服务会出现不稳定现象。

当hbase.hregion.max.filesize比较大时,由于长期得不到split,因此同一个region内发生多次compaction的机会增加了。这样会降低系统的性能、稳定性,因此平均吞吐量会受到一些影响而下降。

3.6.10 Region-RegionServer Locality(本地性)

RegionServer本地性是通过HDFS Block副本实现。

当某个RS故障后,其他的RS也许会因为Region恢复而被Master分配非本地的Region的StoreFiles文件(其实就是之前挂掉的RS节点上的StoreFiles的HDFS副本)。但随着新数据写入该Region,或是该表被合并、StoreFiles重写等之后,这些数据又变得相对来说本地化了。

3.7 Region元数据-META表

3.7.1 概述

Region元数据详细信息存于.META.表(没错,也是一张HBase表,只是HBase shell的list命令看不到)中(最新版称为hbase:meta表),该表的位置信息存在ZK中。

该表的结构如下:

3.7.2 表结构

Key

Values

3.8 MemStore

3.8.1 概述

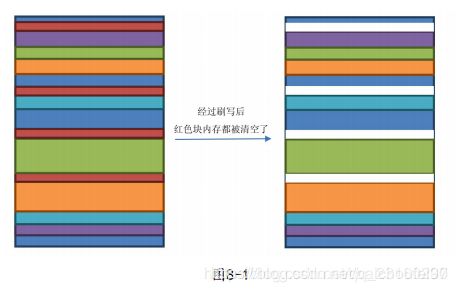

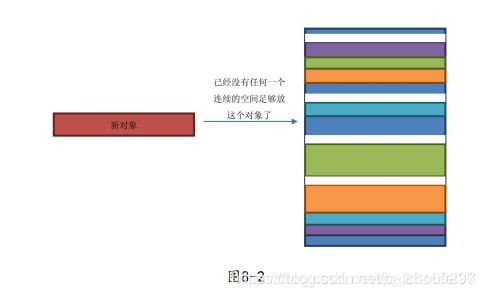

一个Store有一个MemStore,保存数据修改。当flush后,当前MemStore就被清理了。

注意,MemStorez中的数据按 RowKey 字典升序排序。

HBase需要将写入的数据顺序写入HDFS,但因写入的数据流是未排序的及HDFS文件不可修改特性,所以引入了MemStore,在flush的时候按 RowKey 字典升序排序进行排序再写入HDFS。

充当内存缓存,在更多是访问最近写入数据的场景中十分有效

可在写入磁盘前进行优化,比如有多个对同一个cell进行的更新操作,那就在flush时只取最后一次进行刷盘,减少磁盘IO。

3.8.2 Flush

注意:Memstore Flush最小单位是Region,而不是单个MemStore。

3.8.2.1 flush过程

为了减少flush过程对读写影响,HBase采用了类似于2PC的方式,将整个flush过程分为三个阶段:

prepare

然后再新建一个新的kvset Memstore(SkipList),服务于后来的写入。

prepare阶段需要加一把写锁对写请求阻塞,结束之后会释放该锁。因为此阶段没有任何费时操作,因此持锁时间很短。

flush.tmp下。这个过程因为涉及到磁盘IO操作,因此相对比较耗时,但不会影响读写。

commitColumnFamily目录下,针对HFile生成对应的storefile和Reader,随后把storefile添加到HStore的storefiles列表中。最后清空prepare阶段生成的snapshot。

整个flush过程还可能涉及到compact和split

3.8.2.2 Snapshot-快照读

当Flush发生时,当前MemStore实例会被移动到一个snapshot中,然后被清理掉。在此期间,新来的写操作会被新的MemStore和刚才提到的备份snapshot接收,直到flush成功后,snapshot才会被废弃。

3.8.2.3 MemStore Flush时机

Region级别-跨列族hbase.hregion.memstore.flush.size),该Region所有MemStore一起发生Flush,输入磁盘。

RegionServer级别hbase.regionserver.global.memstore.upperLimit),那么会一起按Region的MemStore用量降序排列flush,直到降低到阈值(hbase.regionserver.global.memstore.lowerLimit)以下。

另有一个新的参数hbase.regionserver.global.memstore.size,设定了一个RS内全部Memstore的总大小阈值,默认大小为Heap的40%,达到阈值以后就会阻塞更新请求,并开始RS级别的MemStore flush,和上述行为相同。

HLog-WAL文件hbase.regionserver.max.logs,该server上多个region的MemStore会被刷写到磁盘(按照时间顺序),以降低WAL的大小。否则会导致故障恢复时间过长。

手动触发

3.8.2.4 其他Flush重要点

MemStore Flush不会更新BlockCache

如果是Get最新版本,则会先搜索MemStore,如果有就直接返回,否则需要查找BlockCache和HFile且做归并排序找到最新版本返回。

如果是查找多个版本,则会先搜索MemStore,如果有足够的版本就返回,否则还需要查找BlockCache和HFile且做归并排序找到足够多的的最新版本返回。

Flush阻塞hbase.hregion.memstore.block.multiplier 乘以 hbase.hregion.memstore.flush.size字节时,会阻塞写入,主要是为了防止在update高峰期间MemStore大小失控,造成其flush的文件需要很长时间来compact或split,甚至造成OOM服务直接down掉。内存足够大时,可调大该值。

所以,针对此,我们需要避免Region数量或列族数量过多造成MemStore太大。

3.8.2.5 HBase 2.0 Flush

可参考hbase实践之flush and compaction

增加了内存中Compact逻辑。MemStore变为由一个可写的Segment,以及一个或多个不可写的Segments构成。

3.8.3 Snapshot

MemStore Flush时,为了避免对读请求的影响,MemStore会对当前内存数据kvset创建snapshot,并清空kvset的内容。

读请求在查询KeyValue的时候也会同时查询snapshot,这样就不会受到太大影响。但是要注意,写请求是把数据写入到kvset里面,因此必须加锁避免线程访问发生冲突。由于可能有多个写请求同时存在,因此写请求获取的是updatesLock的readLock,而snapshot同一时间只有一个,因此获取的是updatesLock的writeLock。

3.8.4 写入

数据修改操作先写入MemStore,在该内存为有序状态。

3.8.5 读取

先查MemStore,查不到再去查StoreFile。

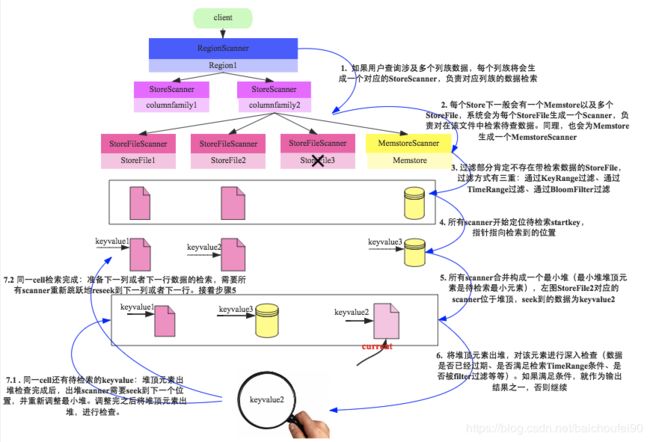

Scan具体读取步骤如下:

客户端对table发起scan操作时,HBase的RegionServer会为每个region构建一个RegionScanner

RegionScanner包含一个StoreScanner列表,每个列族创建了一个StoreScanner

StoreScanner又为每个StoreFile创建了一个StoreFileScanner构成list,以及为MemStore传了一个KeyValueScanner列表。

上述两个列表最终会合并为一个最小堆(其实是优先级队列),其中的元素是上述的两类scanner,元素按seek到的keyvalue大小按升序排列。

HBase中,Key大小首先比较RowKey,RowKey越小Key就越小;RowKey如果相同就看CF,CF越小Key越小;CF如果相同看Qualifier,Qualifier越小Key越小;Qualifier如果相同再看Timestamp,Timestamp越大表示时间越新,对应的Key越小;如果Timestamp还相同,就看KeyType,KeyType按照DeleteFamily -> DeleteColumn -> Delete -> Put 顺序依次对应的Key越来越大。

当构建StoreFileScanner后,会自动关联一个MultiVersionConcurrencyControl Read Point,他是当前的MemStore版本,scan操作只能读到这个点之前的数据。ReadPoint之后的更改会被过滤掉,不能被搜索到。这也就是所谓的读提交(RC)。

查询的scanner会组成最小堆,每次pop出堆顶的那个scanner seek到的KeyValue,进行如下判定:

检查该KeyValue的KeyType是否是Deleted/DeletedCol等,如果是就直接忽略该列所有其他版本,跳到下列(列族)

检查该KeyValue的Timestamp是否在用户设定的Timestamp Range范围,如果不在该范围,忽略

检查该KeyValue是否满足用户设置的各种filter过滤器,如果不满足,忽略

检查该KeyValue是否满足用户查询中设定的versions,比如用户只查询最新版本,则忽略该cell的其他版本;反之,如果用户查询所有版本,则还需要查询该cell的其他版本。

上一步检查KeyValue检查完毕后,会对当前堆顶scanner执行next方法检索下一个scanner,并重新组织最小堆,又会按KeyValue排序规则重新排序组织。不断重复这个过程,直到一行数据被全部查找完毕,继续查找下一行数据。

更多关于数据读取流程具体到scanner粒度的请阅读HBase原理-数据读取流程解析

3.9 Storefile

3.9.1 概述

一个Store有>=0个SotreFiles(HFiles)。

StoreFiles由块(Block)组成。块大小( BlockSize)是基于每个列族配置的。压缩是以块为单位。

3.9.2 HFile

可参考:

Apache HBase-HFile format

HBase – 存储文件HFile结构解析

HBase – 探索HFile索引机制

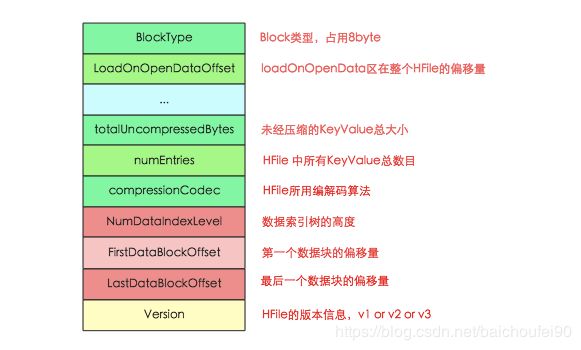

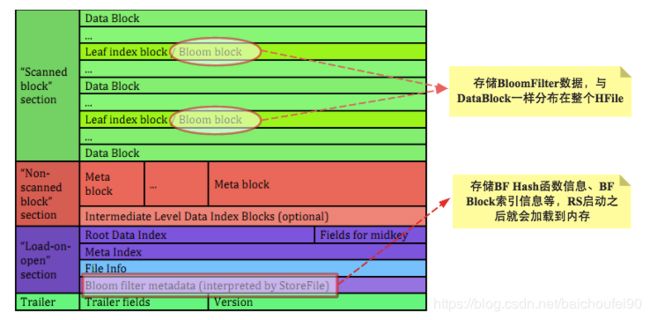

注:目前HFile有v1 v2 v3三个版本,其中v2是v1的大幅优化后版本,v3只是在v2基础上增加了tag等一些小改动,本文介绍v2版本。

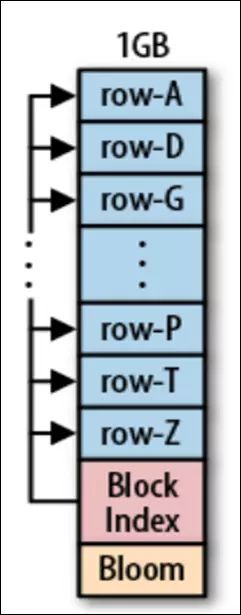

HFile格式基于BigTable论文中的SSTable。StoreFile对HFile进行了轻度封装。HFile是在HDFS中存储数据的文件格式。它包含一个多层索引,允许HBase在不必读取整个文件的情况下查找数据。这些索引的大小是块大小(默认为64KB),key大小和存储数据量的一个重要因素。

注意,HFile中的数据按 RowKey 字典升序排序。

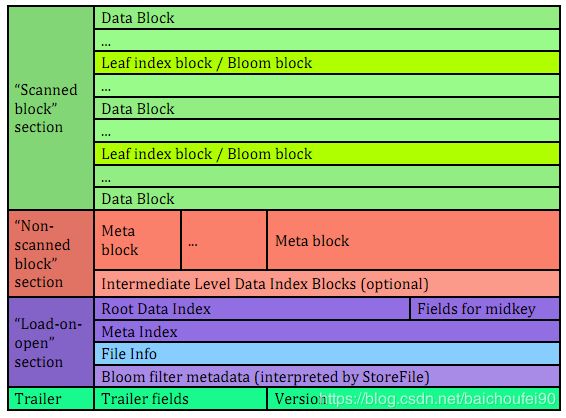

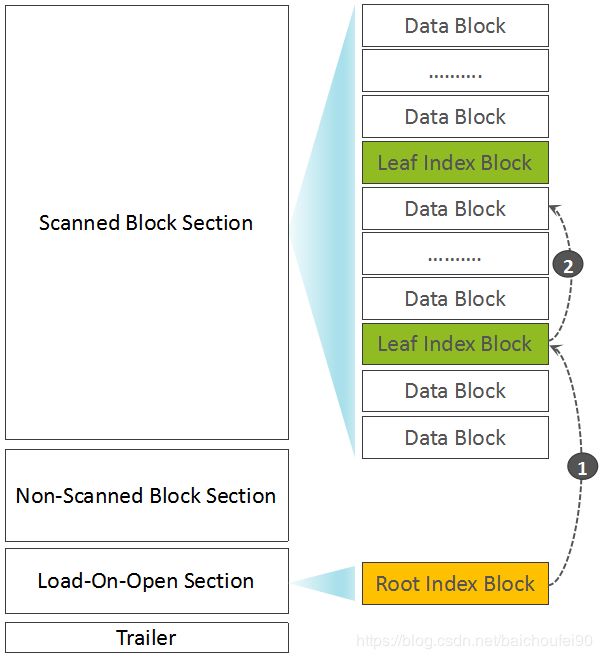

数据分布

Scanned block section

Non-scanned block section

Load-on-open-section

Trailer

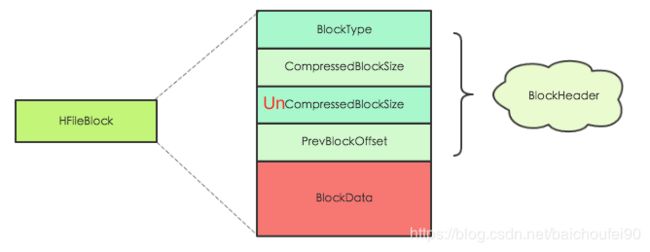

HFIle Block

BlockHeader

BlockType

DATA – KeyValue数据

ROOT_INDEX – 多层DataBlock索引中的根索引块

INTERMEDIATE_INDEX – 多层DataBlock索引中的中间层索引块

LEAF_INDEX – 多层DataBlock索引中的叶节点

META – 存放元数据 ,V2后不再跟布隆过滤器相关

FILE_INFO – 文件信息,极小的key-value元数据

BLOOM_META – 布隆过滤器元数据

BLOOM_CHUNK – 布隆过滤器

TRAILER – 固定大小,记录各Block段偏移值

INDEX_V1 – 此块类型仅用于传统的HFile v1块

CompressedBlockSize

UncompressedBlockSize

PrevBlockOffset

BlockData

HFile各部分详解

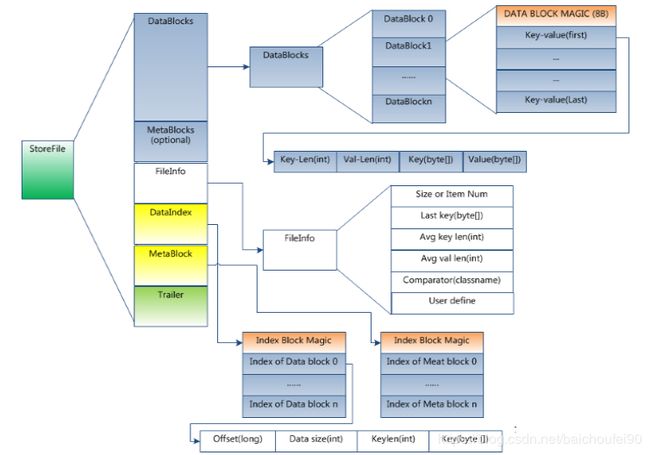

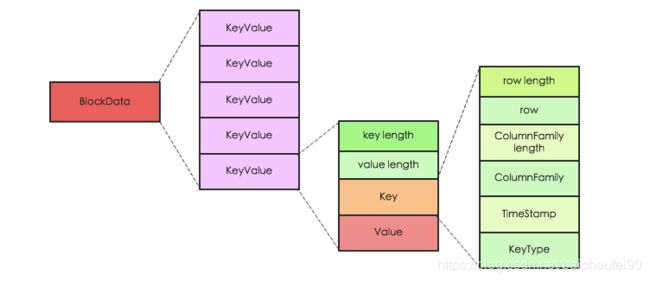

DataBlock

保存表中的数据,可被压缩,大小默认为64K(由建表时创建cf时指定或者HColumnDescriptor.setBlockSize(size))。

每一个DataBlock由MagicHeader和一些KeyValue组成,key的值是严格按照顺序存储的。

在查询数据时,是以DataBlock为单位从硬盘load到内存,顺序遍历该块中的KeyValue。

DataIndex

格式为:(MagicHeader,(DataBlock在HFile的offset + DataBlockLength + DataBlockFirstKey),(DataBlock在HFile的offset + DataBlockLength + DataBlockFirstKey),……..)。

MetaBlock (可选的)

MetaIndex (可选的)

格式为:(MagicHeader,(MetaBlock在HFile的offset + MetaBlockLength + MetaBlockName),(MetaBlock在HFile的offset + MetaBlockLength + MetaBlockName),……..)。

BloomIndex

FileInfoAVG_KEY_LEN, AVG_VALUE_LEN, LAST_KEY, COMPARATOR, MAX_SEQ_ID_KEY等,用户也可以在这一部分添加自定义元数据。

Trailer

这样一来,当检索某个key时,不需要扫描整个HFile,而只需从内存中的DataBlockIndex找到key所在的DataBlock,随后通过一次磁盘io将整个DataBlock读取到内存中,再找到具体的KeyValue。

Trailer部分格式为:CompressionCodec为int,压缩算法为enum类型,表示压缩算法:LZO-0,GZ-1,NONE-2。

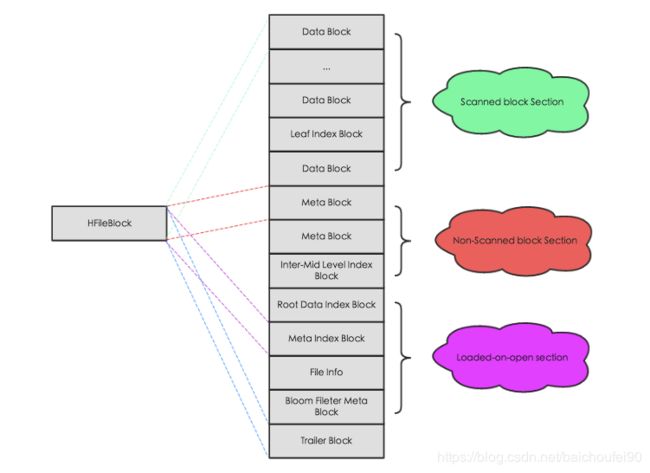

3.9.3 HFile-Block

HFileBlock默认大小是64KB,而HadoopBlock的默认大小为64MB。顺序读多的情况下可配置使用较大HFile块,随机访问多的时候可使用较小HFile块。

不仅是DataBlock,DataBlockIndex和BloomFilter都被拆成了多个Block,都可以按需读取,从而避免在Region Open阶段或读取阶段一次读入大量的数据而真正用到的数据其实就是很少一部分,可有效降低时延。

HBase同一RegionServer上的所有Region共用一份读缓存 。当读取磁盘 上某一条数据时,HBase会将整个HFile block读到cache中。此后,当client请求临近的数据时可直接访问缓存,响应更快,也就是说,HBase鼓励将那些相似的,会被一起查找的数据存放在一起。

注意,当我们在做全表scan时,为了不刷走读缓存中的热数据,记得关闭读缓存的功能(因为HFile放入LRUCache后,不用的将被清理)

更多关于HFile BlockCache资料请查看HBase BlockCache 101

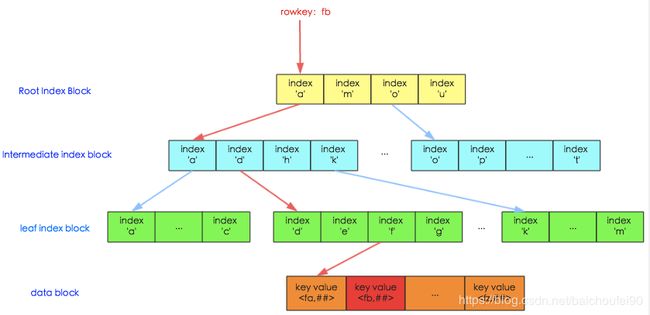

3.9.4 HFile索引

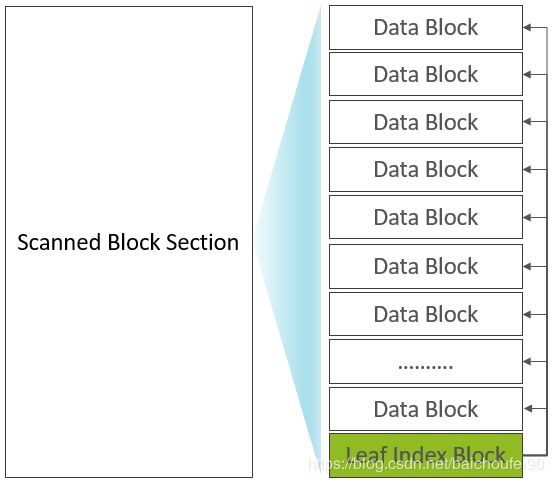

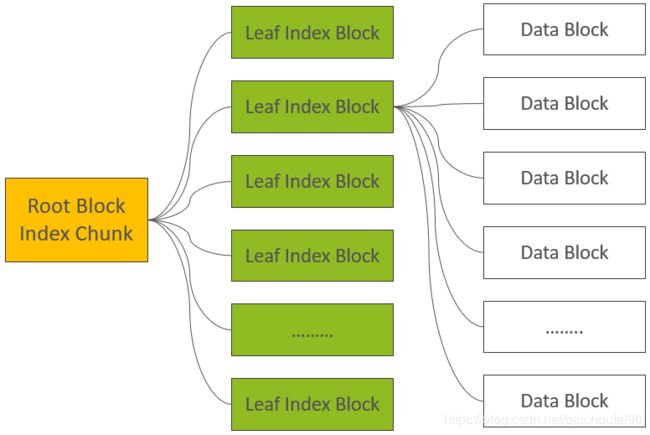

初始只有一层,数据多时分裂为多层索引(最多可支持三层索引,即最底层的Data Block Index称之为Leaf Index Block,可直接索引到Data Block;中间层称之为Intermediate Index Block,最上层称之为Root Data Index,Root Data index存放在一个称之为"Load-on-open Section"区域,Region Open时会被加载到内存中),使用LruBlockCache::

Load-on-open SectionRoot Data index,Region打开时就会被加载到内存中

Scanned Block Section

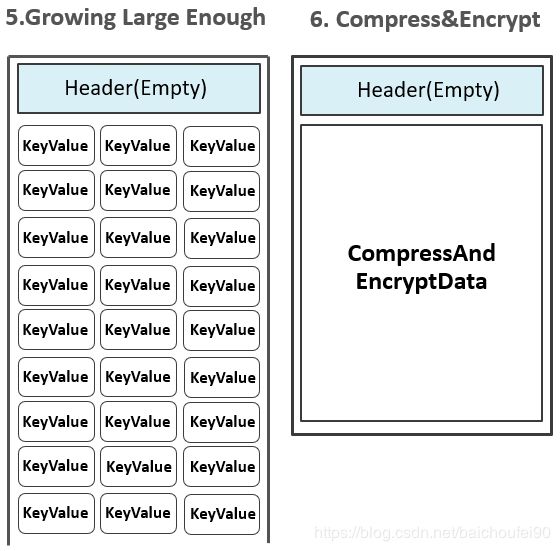

3.9.5 HFile生成

初始HFile无Block,数据在MemStore

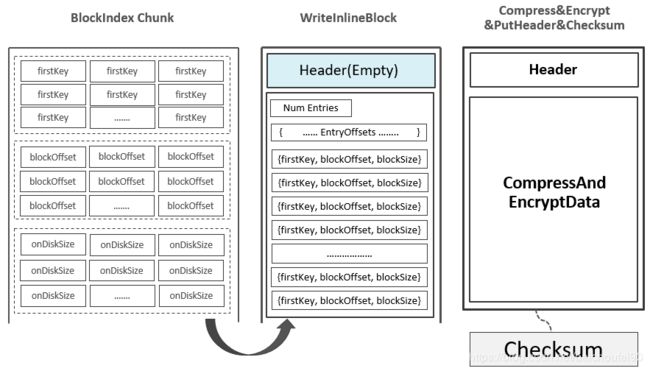

flush发生,HFileWriter初始,DataBlock生成,此时Header为空

开始写入,Header被用来存放该DataBlock的元数据信息

MemStore的KeyValue,写入DataBlock。如果设置了Data Block Encoding,此时需要进行编码。

KeyValue达到Block大小,停止写入

对KeyValue进行压缩,再进行加密

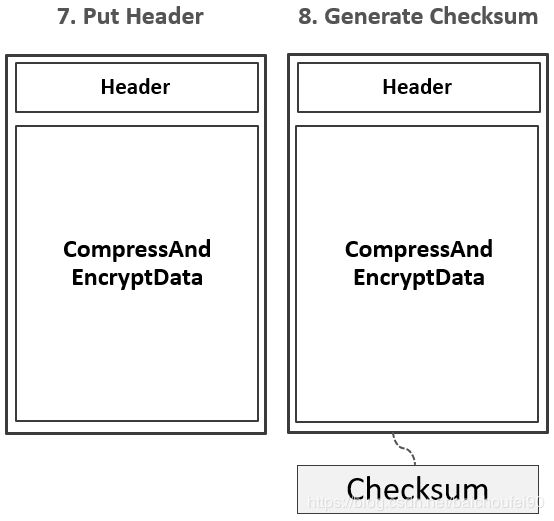

在Header区写入对应DataBlock元数据信息,包含{压缩前的大小,压缩后的大小,上一个Block的偏移信息,Checksum元数据信息}等信息。

生成Checksum校验和信息

通过HFileWriter将DataBlock/Checksum写入HDFS

为DataBlock生成包含StartKey,Offset,Size等信息的索引,先写入内存中的Block Index Chunk,累积到阈值后刷入HDFS,形成Leaf Index Block。

DataBlock和DataBlockIndex(Leaf Index Block)在Scanned Block Section交叉存在。

而HBase中还存在Root Index Chunk用来记录每个DataBlockIndex的信息,即为DataBlock的索引的索引。

当MemStore Flush中最后一个KeyValue写入到最后一个DataBlock即最后一个DataBlockIndex时,随机开始flush Root Index Chunk。

注意,如果Root Index Chunk大小超出阈值,则会生成位于Non-Scanned Block Section区域的Intermediate Index Block,由Root Index生成索引来指向。

无论如何,都会输出位于的Load-On-Open Section的Root Index Block。

生成FileInfo,记录HFile的元数据

写入BloomFilter元数据与索引数据

最后写入Trailer部分信息

3.9.6 BloomFilter

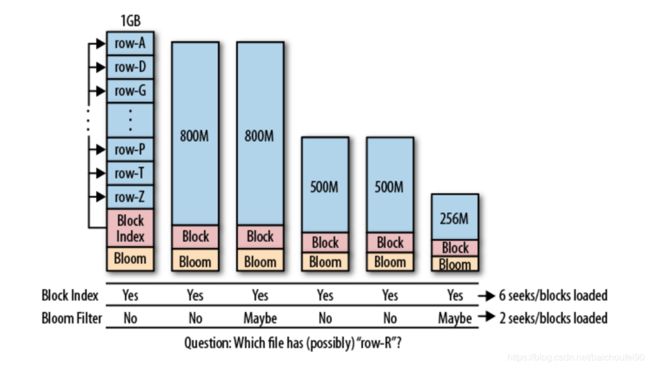

目的Get(BloomFilter不能与Scans一起使用,而是Scan中的每一行来使用)的磁盘读取次数减少到仅可能包含所需Row的StoreFiles,而且性能增益随着并行读取的数量增加而增加。

和BlockIndex区别key range扫描很多BlockIndex来判断目标key是否可能在该文件中,但仍需要加载该HFile中的若干Block并scan才能确定是否真的存在目标key。(比如一个1GB的HFile,就包含16384个64KB的Block,且BlockIndex只有StartKey信息。查询一个给点key则可能落在两个Block的StartKey范围之间,需要全部load-scan)。

而BloomFilter对于Get操作以及部分Scan操作可以过滤掉很多肯定不包含目标Key的HFile文件,大大减少实际IO次数,提高随机读性能。

使用场景

存储位置启动时加载区中;而具体的存放数据的BloomFilterBlock,会随着数据变多而变为多个Block以便按需一次性加载到内存,这些BloomFilterBlock散步在HFile中扫描Block区,不需要更新(因为HFile的不可变性),只是会在删除时会重建BloomFilter,所以不适合大量删除场景。

加载时机

HBase中的BloomFilter实现

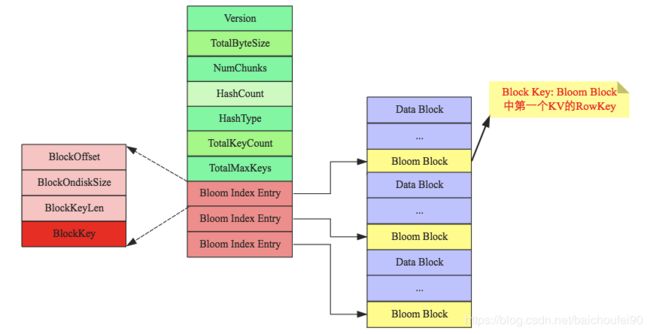

当然,因为HBase为了权衡内存使用和命中率等,将BloomFilter数组进行了拆分,并引入了BloomIndex,查找时先通过StartKey找到对应的BloomBlock再进行上述查找过程。

BloomFilterIndex

弹性

行-列模式

行模式

行+列模式

可禁用BloomFilter

例子

行模式BloomFilter,Get(r1)时可过滤掉h2;Get(r4)时可过滤掉h1和h3;Get(r1,c1)也只会过滤掉h2而不会过滤h3

行+列模式BloomFilter,Get(r1,c1)过滤掉h2和h3

指标blockCacheHitRatio可观察到RegionServer上的BlockCache缓存命中率,如果开启BloomFilter来过滤那些不包含目标key的Block,则blockCacheHitRatio应该增加。

创建BloomFilterHColumnDescriptor.setBloomFilterType(NONE/ROW (default)/ ROWCOL)或用以下命令创建BloomFilter:

create 'mytable',{NAME => 'colfam1', BLOOMFILTER => 'ROWCOL'}

3.10 BlockCache

可参考HBase BlockCache系列 - 探求BlockCache实现机制

HBase提供两种不同的BlockCache实现,来缓存从HDFS读取的数据:

堆内的LRUBlockCache。

内存由JVM管理,LRU规则,具体是由MinMaxPriorityQueue实现

默认占HBase用的Java堆大小的40%

分为single-access区(25%,存随机读入的Block块)、mutil-access区(50%,single区中数据被多次读就移入本区)、in-memory区(25%,存储访问频繁且量下的数据,如元数据)

数据、META表(永远开启缓存)、HFile、key、BloomFilter等大量使用LRUBlockCache。

默认情况下,对所有用户表都启用了块缓存,也就是说任何读操作都将加载LRU缓存 。

缺点是随着multi-access区的数据越来越多,会造成CMS FULL GC,导致应用程序长时间暂停

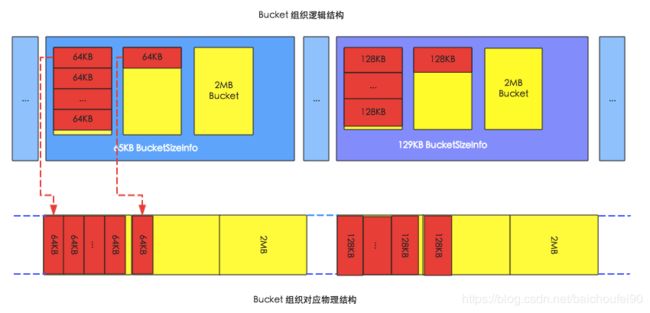

通常在堆外的BucketCache

申请多种不同规格的多个Bucket,每种存储指定Block大小的DataBlock。当某类Bucket不够时,会从其他Bucket空间借用内存,提高资源利用率。如下就是两种规格的Bucket,注意他们的总大小都是2MB。

三种工作模式:

heap

offheap

file

实践

一般可用LRUBlockCache保存 DataBlockIndex 和BloomFilter,其他数据(比如最主要的DataBlock)放在BucketCache

3.11 KeyValue

3.11.1 概述

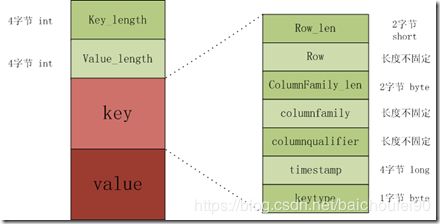

KeyValue的构成KeyValue是HBase的最核心内容。他主要由keylength, valuelength, key, value 四部分组成:

keyPut、Delete、 DeleteColumn和DeleteFamily)等信息

value

KeyValue与BloomFilter

当然,实际上HBaseHFile可能特别大,那么所使用的数组就会相应的变得特别大,所以不可能只用一个数组,所以又加入了BloomIndexBlock来查找目标RowKey位于哪个BloomIndex,然后是上述BloomFilter查找过程。

3.11.2 例子

一个put操作如下:

Put #1: rowkey=row1, cf:attr1=value1

他的key组成如下:

rowlength -----------→ 4

row -----------------→ row1

columnfamilylength --→ 2

columnfamily --------→ cf

columnqualifier -----→ attr1

timestamp -----------→ server time of Put

keytype -------------→ Put

3.11.3 小结

所以我们在设计列族、列、rowkey的时候,要尽量简短,不然会大大增加KeyValue大小。

3.12 WAL(Write-Ahead Logging)-HLog

3.12.1 基本概念

WAL(Write-Ahead Logging)是一种高效的日志算法,相当于RDBMS中的redoLog,几乎是所有非内存数据库提升写性能的不二法门,基本原理是在数据写入之前首先顺序写入日志,然后再写入缓存,等到缓存写满之后统一落盘。

之所以能够提升写性能,是因为WAL将一次随机写转化为了一次顺序写加一次内存写。提升写性能的同时,WAL可以保证数据的可靠性,即在任何情况下数据不丢失。假如一次写入完成之后发生了宕机,即使所有缓存中的数据丢失,也可以通过恢复日志还原出丢失的数据(如果RegionServer崩溃可用HLog重放恢复Region数据)。

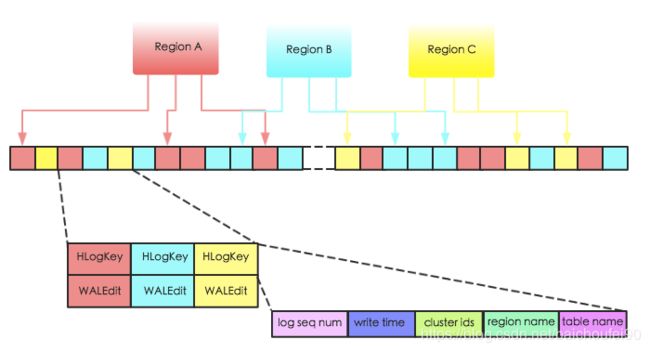

一个RegionServer上存在多个Region和一个WAL实例,注意并不是只有一个WAL文件,而是滚动切换写新的HLog文件,并按策略删除旧的文件。

一个RS共用一个WAL的原因是减少磁盘IO开销,减少磁盘寻道时间。

可以配置MultiWAL,多Region时使用多个管道来并行写入多个WAL流。

当WAL文件数量达到最大个数的时候,就触发该RegionServer上的所有MemStore 按FIFO顺序进行Flush,直到WAL数量降到hbase.regionserver.max.logs以下。此后,那些对应的HLog被视为过期,会被移动到.oldlogs,随后被自动删除

WAL的意义就是和Memstore一起将随机写转为一次顺序写+内存写,提升了写入性能,并能保证数据不丢失。

3.12.2 生命周期

注:本段转自Hbase 技术细节笔记(上)

Hlog从产生到最后删除需要经历如下几个过程:

产生

滚动hbase.regionserver.logroll.period控制,默认是1个小时,时间达到hbase.regionserver.logroll.period 设置的时间,HBase的一个后台线程就会创建一个新的Hlog文件。这就实现了HLog滚动的目的。HBase通过hbase.regionserver.maxlogs参数控制Hlog的个数。滚动的目的,为了控制单个HLog文件过大的情况,方便后续的过期和删除。

过期与sequenceid.oldlogs目录。

这里有个问题,为什么要将过期的Hlog移动到.oldlogs目录,而不是直接删除呢?

删除hbase.master.cleaner.interval(默认60秒)时间会去检查.oldlogs目录下的所有Hlog,确认对应的Zookeeper的Hlog节点是否被删除,如果Zookeeper 上不存在对应的Hlog节点,那么就直接删除对应的Hlog。

hbase.master.logcleaner.ttl(默认10分钟)这个参数设置Hlog在.oldlogs目录保留的最长时间。

3.12.3 WAL持久化等级

SYNC_WAL: 默认 . 所有操作先被执行sync操作到HDFS(不保证落盘),再返回.

FSYNC_WAL: 所有操作先被执行fsync操作到HDFS(强制落盘),再返回。最严格,但速度最慢。

SKIP_WAL: 不写WAL。提升速度,但有极大丢失数据风险!

ASYNC_WAL: 异步写WAL,可能丢失数据。

3.12.4 WAL数据结构

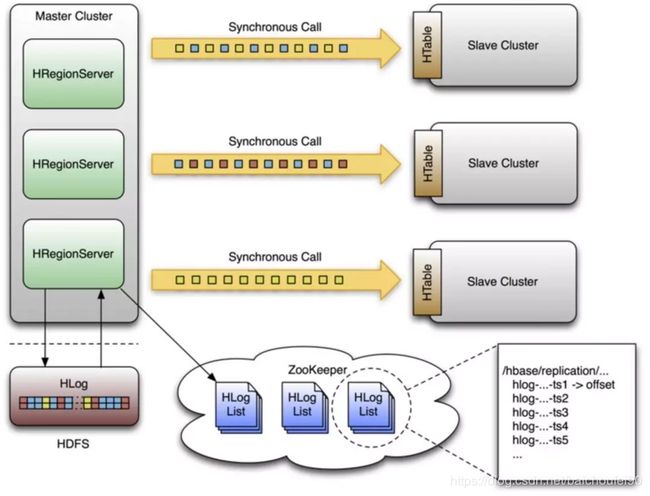

前面提到过,一个RegionServer共用一个WAL。下图是一个RS上的3个Region共用一个WAL实例的示意图:

HLogKey主要包括:

LogSequenceNumber(SequenceId)

WriteTime

RegioNname

TableName

ClusterIds

WALEditc1,c2,c3分别做了修改,那么HLog为了行级事务原子性日志片段如下所示:: WALEdit会被序列化为格式<-1, # of edits, , , > ,比如<-1, 3, , , > ,其中-1作为标示符表征这种新的日志结构。

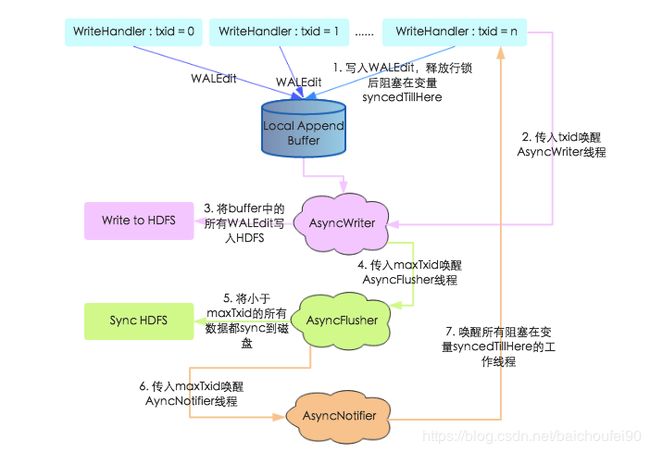

3.12.5 WAL写入流程

见这里

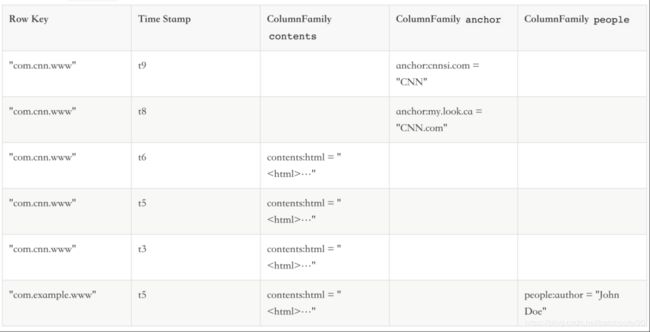

4 HBase数据模型

4.1 逻辑模型

4.1.1 逻辑视图与稀疏性

4.1.2 HBase数据模型基本概念

Namespacedefault namespace。

Table

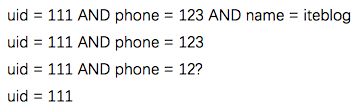

RowKey

是Byte Array(字节数组),是表中每条记录的“主键”,即唯一标识某行的元素,方便快速查找,RowKey的设计非常重要。

MemStore和HFile中按RowKey的字典升序排列。

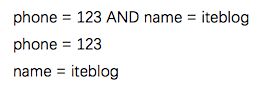

且RowKey符合最左匹配原则。如设计RowKey为uid + phone + name,那么可以匹配一下内容:

Column Family

Column

Version Number

Value(Cell)

Region

4.2 物理模型

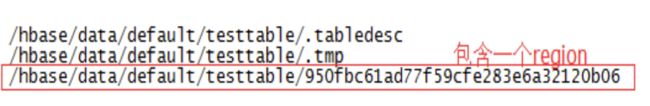

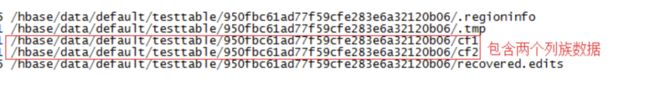

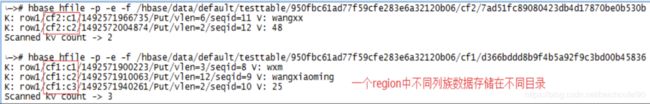

HBase表的同一个region放在一个目录里

一个region下的不同列族放在不同目录

4.3 有序性

每行的数据按rowkey->列族->列名->timestamp(版本号)逆序排列,也就是说最新版本数据在最前面。

4.4 ACID

请查看事务章节。

5 HBase 容错

5.1 RegionServer

Region Failover:发现失效的Region,先标记这些Region失效,然后到正常的RegionServer上恢复他们

RegionSever Failover:由HMaster对其上的region进行迁移

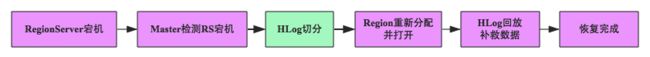

具体来说

RegionServer定时向Zookeeper发送心跳

RegionServer挂掉后一段时间(SessionTimeout),在ZK注册的临时节点会被删除,此时该RS上的Region立刻变得不可用

HMaster监听到ZK事件得知该RS挂掉,HMaster会认为其上的Region分配非法,开启Region重分配流程。

将该RegionServer在HDFS上的那个HLog文件按Region进行切分,并待不可用的那些Region重分配到其他RegionServer后,对HLog按照Region和sequenceid由小到大进行重放补足HLog中的数据。

在此过程中的客户端查询会被重试,不会丢失

详细流程可以参考:

Hbase 技术细节笔记(下)

HBase原理-RegionServer宕机数据恢复

5.2 Master Failover

Zookeeper选举机制选出一个新的Leader Master。但要注意在没有Master存活时:

数据读写仍照常进行,因为读写操作是通过.META.表进行。

无master过程中,region切分、负载均衡等无法进行(因为master负责)

5.3 Zookeeper容错

Zookeeper是一个可靠地分布式服务

5.4 HDFS

HDFS是一个可靠地分布式服务

6 HBase数据流程

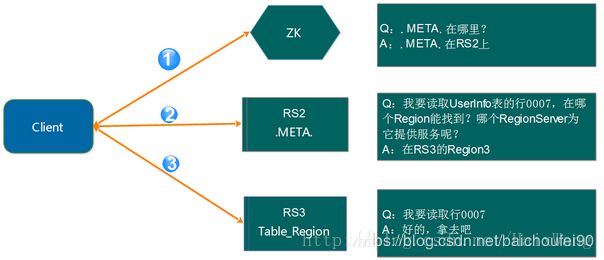

6.1 客户端Region定位和Scan流程

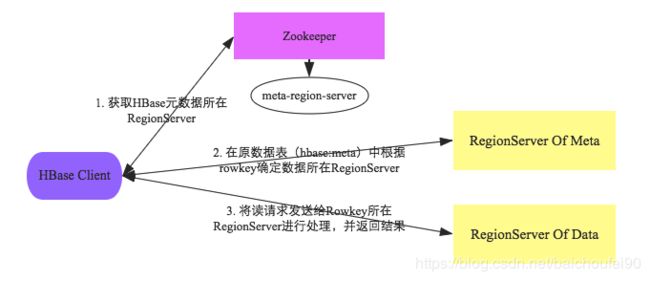

注意,该过程中Client不会和Master联系,只需要配置ZK信息。

Client访问Zookeeper,找到hbase:meta表所在RegionServer

根据所查数据的Namespace、表名和rowkey在hbase:meta表顺序查找找到对应的Region信息,并会对该Region位置信息进行缓存。

如果Region由master负载均衡重新分配,或因为相关RegionServer挂掉,则Client将重新查询hbase:meta表以确定Region的新位置然后放入缓存。

下一步就可以请求Region所在RegionServer了,会初始化三层scanner实例来一行一行的每个列族分别查找目标数据:

RegionScanner

StoreScanner

统筹扫描对应列族数据,构建一个MemStoreScanner和StoreFile个StoreFileScanner。

随后还需要根据TimeRange/KeyRange/BloomFilter 过滤掉肯定不包含目标Key的 StoreFileScanner和MemStoreScanner。

MemStoreScanner

StoreFileScanner

定位DataBlock:从BlockCache中读取该HFile的索引结构,确定目标Key所在的DataBlock的Offset

加载DataBlock:根据Offset,首先在BlockCache中查找,若没找到就IO读取HFile来加载目标DataBlock

定位Key:在DataBlock中二分查找定位目标Key

随后将上述MemStoreScanner和StoreFileScanner合并,并用PriorityQueue优先级队列来构建最小堆,排序规则是RowKey分别比较RowKey(小优先),ColumnFamily(小优先),Qualifier(小优先),TimeStamp(大优先),KeyType(DeleteFamily -> DeleteColumn -> Delete -> Put),这样便于客户端取数据(比如需要获取最新版本数据时只需要再按版本号排次序即可)

将堆顶数据出堆,进行检查,比如是否ttl过期/是否KeyType为Delete*/是否被用户设置的其他Filter过滤掉,如果通过检查就加入结果集等待返回。如果查询未结束,则剩余元素重新调整最小堆,继续这一查找检查过程,直到结束。

RegionScanner将多个StoreScanner按列族小优先规则来合并构建最小堆

块索引

布隆过滤器

功能

快速定位记录在HFile中可能的块

快速判断HFile块中是否包含目标记录

读写请求一般会先访问MemStore

6.2 写流程

6.2.1 Client

Client默认设置autoflush=true,表示put请求直接会提交给服务器进行处理;也可设置autoflush=false,put请求会首先放到本地buffer,等到本地buffer大小超过一定阈值(默认为2M,可以通过配置文件配置)之后才会异步批量提交。很显然,后者采用批处理方式提交请求,可极大地提升写入性能,但因为没有保护机制,如果该过程中Client挂掉的话会因为内存中的那些buffer数据丢失导致提交的请求数据丢失!

Client定位到数据所在RegionServer。若是批量请求,还会将rowkey按HRegionLocation分组,每个分组可对应一次RPC请求MultiServerCallable|

。

Client为通过rpcCallerFactory. newCaller() 执行调用,忽略掉失败重新提交和错误处理。

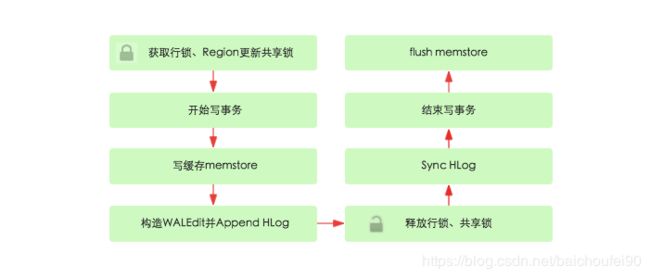

6.2.2 Server

Server尝试获取行锁(行锁可保证行级事务原子性)来锁定目标行(或多行),检索当前的WriteNumber(可用于MVCC的非锁读),并获取Region更新锁,写事务开始。

Server把数据构造为WALEdit对象,然后按顺序写一份到WAL(一个RegionServer共用一个WAL实例)。当RS突然崩溃时且事务已经写入WAL,那就会在其他RS节点上重放。

Server把数据再写一份到MemStore(每个Store一个MemStore实例),此时会把获取到的WriteNumber附加到KeyValue。

Flush

Compact

Split

Server提交该事务。随后,ReadPoint(即读线程能看到的WriteNumber)就能前移,从而检索到该新的事务编号,使得scan和get能获取到最新数据

Server释放行锁和共享锁。选择这个时间释放行锁的原因是可尽量减少持有互斥的行级写锁时间,提升写性能。

Server SyncHLog。此时如果Sync操作失败,会对写入Memstore内的数据进行移除,即回滚。

如果上一步提交,则flush memstore

6.3 读流程

定位到数据所在RegionServer进行读请求

先从写缓存MemStore找数据

如果没有,再到读缓存HFile BlockCache上读

如果还是没有,再到HFile文件上读

若Region元数据如位置发生了变化,那么使用.META.表缓存区访问RS时会找不到目标Region,会进行重试,重试次数达到阈值后会去.META.表查找最新数据并更新缓存。

6.4 删除

在执行delete命令时,hbase只是添加

有墓碑时,该key对应数据被查询时就会被过滤掉。

在Major Compact中被删除的数据和此墓碑标记才从StoreFile会被真正删除。

6.5 TTL过期

CF默认的TTL值是FOREVER,也就是永不过期。

过期数据不会创建墓碑,如果一个StoreFile仅包括过期的rows,会在Minor Compact的时候被清理掉,不再写入合并后的StoreFile。

TTL分为两类即Cell和CF:

Cell TTL 以毫秒为单位,不可超过CF级别的TTL

CF TTL以秒为单位

注意:修改表结构之前,需要先disable 表,否则表中的记录被清空!

还可参考:

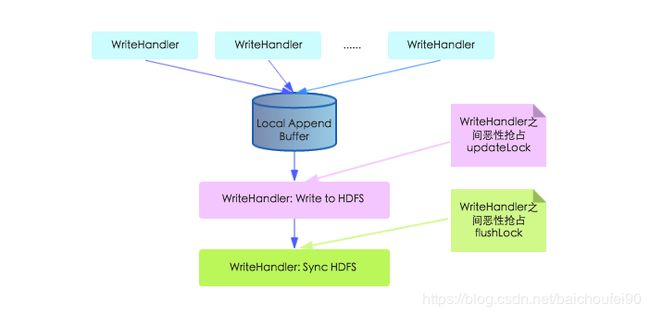

6.6 WAL写入

总的来说,分为三个步骤:

若干

Buffer Flush到HDFS,此时不保证落盘

HDFS fsync落盘

老写入模型

新写入模型

同时,工作线程在将WALEdit写入本地Buffer之后并没有马上阻塞,而是释放行锁之后阻塞等待WALEdit落盘,这样可以尽可能地避免行锁竞争,提高写入性能。

关于此过程详细可参考网易范欣欣-HBase - 数据写入流程解析

7 HBase数据结构

7.1 概述

B树存在的问题:

查找

写入

总的来说,B树随机IO会造成低效的磁盘寻道,严重影响性能。

7.2 LSM树简介

可参考LSM树

7.3 LSM树在HBase的应用

HFile格式基于Bigtable论文中SSTable。

7.3.1 写入

先写入WAL的HBase实现 -> HLog,方式是顺序磁盘追加

然后写入对应列簇的Store中的MemStore

MemStore大小达到阈值后会被刷入磁盘成为StoreFile。注意此文件内部是根据RowKey, Version, Column排序,但多个StoreFile之间在合并前是无序的。

HBase会定时把这些小的StoreFile合并为大StoreFile(B+树),减少读取开销(类似于LSM中的树合并)

7.3.2 读取

先搜索内存小树即MemStore,

不存在就到StoreFile中寻找

7.3.3 读取优化

布隆过滤器。

合并

7.3.4 删除

添加标记,称为墓碑。

在Major Compact中被删除的数据和此墓碑标记才会被真正删除。

7.3.5 合并

HBase Compact过程,就是RegionServer定期将多个小StoreFile合并为大StoreFile,也就是LSM小树合并为大树。这个操作的目的是增加读的性能,否则搜索时要读取多个文件。

HBase中合并有两种:

Minor Compact

Major Compact就被保留;被删除的数据,将墓碑和旧的都删掉)。很多小树会合并为一棵大树,大大提升度性能。

7.3.4 LSM与B+树

RDBMS使用B+树,需要大量随机读写;

而LSM树使用WALog和Memstore将随机写操作转为顺序写。

8 HBase事务

可参考数据库事务系列-HBase行级事务模型

8.1 ACID

HBase和RDBMS类似,也提供了事务的概念,只不过HBase的事务是行级事务,可以保证行级数据的ACID性质。

8.1.1 A-原子性

针对同一行(就算是跨列)的所有修改操作具有原子性,所有put操作要么全成功要么全失败。

HBase有类似CAS的操作:

boolean checkAndPut(byte[] row, byte[] family, byte[] qualifier,

byte[] value, Put put) throws IOException;

原子性的原理

8.1.2 C/I-一致性/隔离性

一致性概述

Get一致性

Scan一致性

scan不是表的一致性视图,但返回结果中的每一行是一致性的视图(该行数据同一时间的版本)

scan结果总是能反映scan开始时的数据版本(包括肯定反映之前的数据修改后状态和可能反映在scanner构建中的数据修改状态)

以上的时间不是cell中的时间戳,而是事务提交时间。

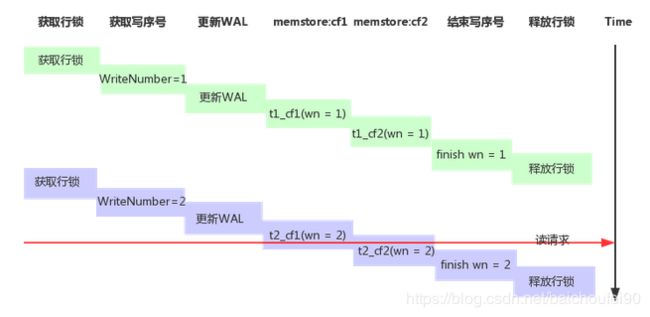

隔离性-读提交StoreFileScanner后,会自动关联一个MultiVersionConcurrencyControl Read Point,他是当前的MemStore版本,scan操作只能读到这个点之前的数据。ReadPoint之后的更改会被过滤掉,不能被搜索到。

这类事务隔离保证在RDBMS中称为读提交(RC)

不保证任何 Region 之间事务一致性注意:由于 HBase 不保证任何 Region 之间(每个 Region 只保存在一个 Region Server 上)的一致性,故 MVCC 的数据结果只需保存在每个 RegionServer 各自的内存中。

8.1.3 V-可见性

当没有使用writeBuffer时,客户端提交修改请求并收到成功响应时,该修改立即对其他客户端可见。原因是行级事务。

HBase读数据时的scanner有一个Readpoint,该取值是写数据线程写入WriteNumber到KeyValue并提交事务后更新的。scan结果中会滤掉所有大于该 ReadPoint 的 KeyValues。

当一个 KeyValue 的 memstore timestamp(WriteNumber) 比最老的scanner(实际是 scanner 持有的 ReadPoint)还要老时,会被清零(置为0),这样该 KeyValue会对所有的 scanner 可见,当然,此时比该 KeyValue 原 memstore timestamp 更早的 scanner 都已经结束了。

8.1.4 D-持久性

所有可见数据也是持久化的数据。也就是说,每次读请求不会返回没有持久化的数据(注意,这里指hflush而不是fsync到磁盘)。

而那些返回成功的操作,就已经是持久化了;返回失败的,当然就不会持久化。

8.1.5 可调性

HBase默认要求上述性质,但可根据实际场景调整,比如修改持久性为定时刷盘。

关于ACID更多内容,请参阅HBase-acid-semantics和ACID in HBase

8.2 事务原理

可参考:

网易范欣欣-数据库事务系列-HBase行级事务模型

8.2.1 简介

HBase支持单行ACID性质,但在HBASE-3584新增了对多操作事务支持,还在HBASE-5229新增了对跨行事务的支持。HBase所有事务都是串行提交的。

为了实现事务特性,HBase采用了各种并发控制策略,包括各种锁机制、MVCC机制等,但没有实现混合的读写事务。

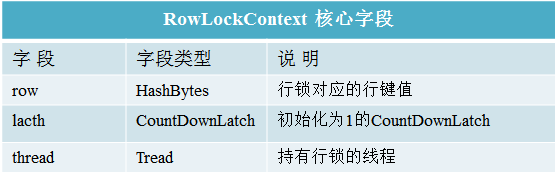

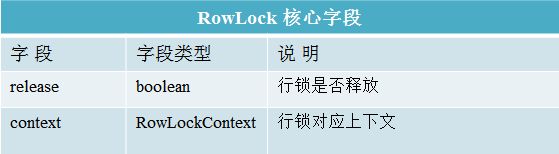

8.2.2 行级锁CountDownLatch

HBase采用CountDownLatch行锁实现更新的原子性,要么全部更新成功,要么失败。

所有对HBase行级数据的更新操作,都需要首先获取该行的行锁,并且在更新完成之后释放,等待其他线程获取。因此,HBase中对多线程同一行数据的更新操作都是串行操作。

行锁主要相关类为RowLock和RowLockContext:

RowLockContext存储行锁内容包括持锁线程、被锁对象以及可以实现互斥锁的CountDownLatch对象等RowLock包含表征行锁是否已经释放的release字段以及一个RowLockContext对象。

使用rowkey以及自身Thread对象生成RowLockContext对象,此时共享的CountDownLatch对象初始化计数为1

将rowkey作为key,RowLockContext对象作为value,putIfAbsert到全局map lockedRows中,会返回一个existingContext对象,有三种情况:

null

本线程创建的RowLockContext

其他线程创建的RowLockContextlatch.await方法阻塞在此RowLockContext对象上,直至该行锁被释放或者阻塞超时。待行锁释放,该线程会重新竞争该锁,一旦竞争成功就持有该行锁,否则继续阻塞。而如果阻塞超时,就会抛出异常,不会再去竞争该锁。

释放流程rowLock.release()方法,其主要逻辑为:

从全局map中将该row对应的RowLockContext移除

调用latch.countDown()方法,唤醒其他阻塞在await上等待该行锁的线程

CountDownLatch在加锁时的应用

8.2.3 读写锁ReentrantReadWriteLock

另一种是基于ReentrantReadWriteLock实现的读写锁,该锁可以给临界资源加上read-lock或者write-lock。其中read-lock允许并发的读取操作,而write-lock是完全的互斥操作。HBase利用读写锁实现了Store级别、Region级别的数据一致性

Region更新读写锁

Region Close保护锁

Store snapshot保护锁

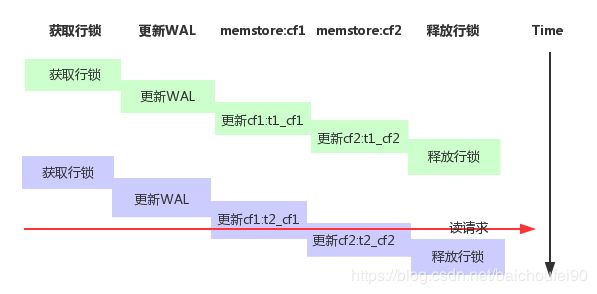

8.2.4 MVCC

8.2.4.1 概述

HBase还提供了MVCC机制实现数据的读写并发控制。cf1:t2_cf1同时读到列族2cf2:t1_cf2,这就产生了行数据不一致的情况。但如果想直接采用读写线程公用行锁来解决此问题,会产生严重性能问题。

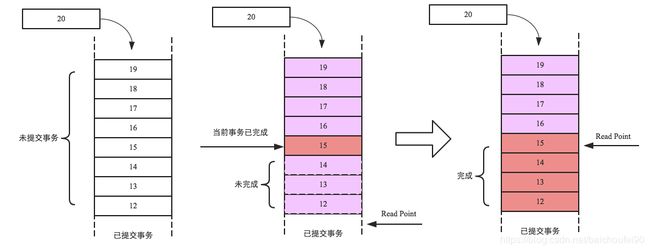

HBase采用了一种MVCC思想,每个RegionServer维护一个严格单调递增的事务号:

当写入事务(一组PUT或DELETE命令)开始时,它将检索下一个最高的事务编号。这称为WriteNumber。每个新建的KeyValue都会包括这个WriteNumber,又称为Memstore timestamp,注意他和KeyValue的timestamp属性不同 。

当读取事务(一次SCAN或GET)启动时,它将检索上次提交的事务的事务编号。这称为ReadPoint。

因为HBase事务不能跨Region ,所以这些MVCC信息就分别保存在RegionServer内存中。

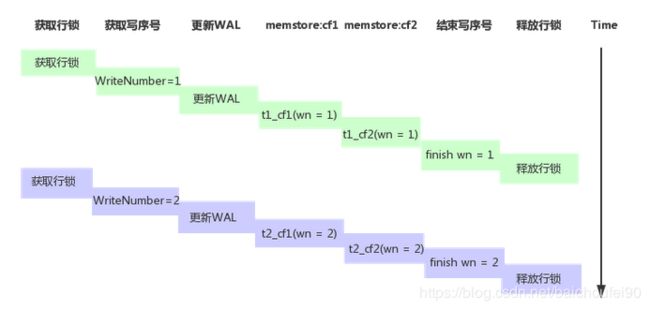

8.2.4.2 事务写流程

具体来说,MVCC思想优化后的写流程如下:

锁定行(或多行),事务开始。行锁可保证行级事务原子性。

开始写事务,检索当前的WriteNumber

将更新应用于WAL。当RS突然崩溃时且事务已经写入WAL,那就会在其他RS节点上重放。

将更新应用于Memstore,具体来说是把获取到的WriteNumber附加到KeyValue

提交该事务。随后,ReadPoint(即读线程能看到的WriteNumber)就能前移,从而检索到该新的事务编号,使得scan和get能获取到最新数据

释放行锁。选择这个时间释放行锁的原因是可尽量减少持有互斥的行级写锁时间,提升写性能。

SyncHLog。此时如果Sync操作失败,会对写入Memstore内的数据进行移除,即回滚。

如果上一步提交,则flush memstore

8.2.4.3 事务读流程

打开scanner

获取的当前ReadPoint。ReadPoint的值是所有的写操作完成序号中的最大整数

scan时,过滤掉那些WriteNumber(Memstore timestamp) 大于 ReadPoint的 KeyValue

scan完毕,返回结果 。一次读操作的结果就是读取点对应的所有cell值的集合

例子:t1_cf1和t1_cf2,这样就可以实现以无锁的方式读取到行一致的数据。

更多详细讨论可见HBase之七:事务和并发控制机制原理

8.3 隔离性+锁实现

8.3.1 写写并发

写时先获取行锁CountDownLatch

获取到锁的执行写操作

没获取到的自旋重试等待

写操作完成后,释放锁

其他等待锁的写入者竞争锁

8.3.3 批量写写并发

写入前统一获取所有行的行锁,获取到才进行操作。

执行写操作

完成后统一释放所有行锁,避免死锁。

8.3.3 读写并发

读写并发控制原因

实现思想

当写入事务(一组PUT或DELETE命令)开始时,它将检索下一个最高的事务编号。这称为WriteNumber。

当读取事务(一次SCAN或GET)启动时,它将检索上次提交的事务的事务编号。这称为ReadPoint。

原理

8.4 scan和合并

当scan时遇到合并正在进行,HBase处理方案如下:

跟踪scanner使用的最早的ReadPoint,不返回Memstore timestamp大于该ReadPoint的那些KeyValue。

该Memstore timestamp删除的时机就是当它比最早的那个scanner还早时,因为这个时候所有scanner都能获取该数据。

8.5 第三方实现

通过集成Tephra,Phoenix可以支持ACID特性。Tephra也是Apache的一个项目,是事务管理器,它在像HBase这样的分布式数据存储上提供全局一致事务。HBase本身在行层次和区层次上支持强一致性,Tephra额外提供交叉区、交叉表的一致性来支持可扩展性、一致性。

9 HBase协处理器

可参考官方博客-coprocessor_introduction

9.1 简介

协处理器可让我们在RegionServer服务端运行用户代码,实现类似RDBMS的触发器、存储过程等功能。

9.2 风险

运行在协处理器上的代码能直接访问数据,所以存在数据损坏、中间人攻击或其他恶意数据访问的风险。

当前没有资源隔离机制,所以一个初衷良好的协处理器可能实际上会影响集群性能和稳定性。

9.3 使用场景

在一般情况下,我们使用Get或Scan命令,加上Filter,从HBase获取数据然后进行计算。这样的场景在小数据规模(如几千行)和若干列时性能表现尚好。然而当行数扩大到十亿行、百万列时,网络传输如此庞大的数据会使得网络很快成为瓶颈,而客户端也必须拥有强大的性能、足够的内存来处理计算这些海量数据。

在上述海量数据场景,协处理器可能发挥巨大作用:用户可将计算逻辑代码放到协处理器中在RegionServer上运行,甚至可以和目标数据在相同节点。计算完成后,再返回结果给客户端。

9.4 类比

9.4.1 触发器和存储过程

Observer协处理器

Endpoint协处理器protocl来定义接口实现客户端代码进行rpc通信,以此来进行数据的搜集归并。

具体来说,在各个region上并行执行的Endpoint代码类似于MR中的mapper任务,会将结果返回给Client。Client负责最终的聚合,算出整个表的指标,类似MR中的Reduce。

9.4.2 MR任务

MR任务思想就是将计算过程放到数据节点,提高效率。思想和Endpoint协处理器相同。

9.4.3 AOP

将协处理看做通过拦截请求然后运行某些自定义代码来应用advice,然后将请求传递到其最终目标(甚至更改目标)。

9.4.4 过滤器

过滤器也是将计算逻辑移到RS上,但设计目标不太相同。

9.5 协处理器的实现

9.5.1 概览

实现某个协处理器接口,如 Coprocessor(协处理器祖先接口), RegionObserver(Observer), CoprocessorService(Endpoint)

配置文件静态方式或动态加载协处理器

通过客户端代码调用协处理器,由HBase处理协处理器执行逻辑

9.6 协处理器分类

9.6.1 Observer

9.6.1.1 简介

9.6.1.2 应用

权限验证preGet或prePost中执行权限验证。

外键

二级索引

9.6.2 Endpoint

9.6.2.1 简介

可在数据位置执行计算。

具体执行调用过程必须继承通过客户端实现CoprocessorService接口的方法,显示进行代码调用实现。

Endpoint通过protobuf实现

Endpoint 协处理器类似传统数据库中的存储过程,客户端可以调用这些 Endpoint 协处理器执行一段 Server 端代码,并将 Server 端代码的结果返回给客户端进一步处理,最常见的用法就是进行聚集操作。

如果没有协处理器,当用户需要找出一张表中的最大数据,即 max 聚合操作,就必须进行全表扫描,在客户端代码内遍历扫描结果,并执行求最大值的操作。这样的方法无法利用底层集群的并发能力,而将所有计算都集中到 Client 端统一执行,势必效率低下。

利用 Coprocessor,用户可以将求最大值的代码部署到 HBase Server 端,HBase 将利用底层 cluster 的多个节点并发执行求最大值的操作。即在每个 Region 范围内执行求最大值的代码,将每个 Region 的最大值在 Region Server 端计算出,仅仅将该 max 值返回给客户端。在客户端进一步将多个 Region 的最大值进一步处理而找到其中的最大值。这样整体的执行效率就会提高很多。

9.6.2.2 应用

9.7 加载方法

9.7.1 静态加载(系统级全局协处理器)

加载

hbase-site.xml中配置一个SumEndPoint:

hbase.coprocessor.region.classes

org.myname.hbase.coprocessor.endpoint.SumEndPoint

HBase在服务端用默认的ClassLoader加载上述配置的协处理器,所以说我们必须将协处理器和相关依赖代码打成jar后要放到RegionServer上的classpath才能运行。

这种方式加载的协处理器对所有表的所有Region可用,所以可称为system Coprocessor。

列表中首个协处理器拥有最高优先级,后序的优先级数值依次递增。注意,优先级数值越高优先级越低 。调用协处理器时,HBase会按优先级顺序调用回调方法。

重启HBase即可

卸载

从hbase-site.xml中去掉协处理器配置

重启HBase

按需从HBase lib目录删除不用的协处理器 JAR文件

9.7.2 动态加载(表级协处理器)

该种方式加载的协处理器只能对加载了的表有效。加载协处理器时,表必须离线。

动态加载,需要先将包含协处理器和所有依赖打包成jar,比如coprocessor.jar,放在了HDFS的某个位置(也可放在每个RegionServer的本地磁盘,但是显然很麻烦)。

HBase Shell

将需要加载协处理器的表离线禁用:

hbase> disable 'users'

加载协处理器:|分隔。其中1073741823代表优先级;arg1=1,arg2=2代表协处理器参数,可选。

hbase alter 'users',

METHOD => 'table_att',

'Coprocessor'=>'hdfs://:/user//coprocessor.jar| org.myname.hbase.Coprocessor.RegionObserverExample|1073741823|arg1=1,arg2=2'

恢复表可用

hbase(main):003:0> enable 'users'

验证协处理器可用性

hbase(main):04:0> describe 'users'

可以在user表的TABLE_ATTRIBUTES属性中看到已加载的协处理器。

Java API

TableName tableName = TableName.valueOf("users");

Path path = new Path("hdfs://:/user//coprocessor.jar");

Configuration conf = HBaseConfiguration.create();

Connection connection = ConnectionFactory.createConnection(conf);

Admin admin = connection.getAdmin();

admin.disableTable(tableName);

HTableDescriptor hTableDescriptor = new HTableDescriptor(tableName);

HColumnDescriptor columnFamily1 = new HColumnDescriptor("personalDet");

columnFamily1.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily1);

HColumnDescriptor columnFamily2 = new HColumnDescriptor("salaryDet");

columnFamily2.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily2);

hTableDescriptor.addCoprocessor(RegionObserverExample.class.getCanonicalName(), path,

Coprocessor.PRIORITY_USER, null);

admin.modifyTable(tableName, hTableDescriptor);

admin.enableTable(tableName);

动态卸载

HBase Shell

将需要加载协处理器的表离线禁用:

hbase> disable 'users'

移除协处理器:

alter 'users', METHOD => 'table_att_unset', NAME => 'coprocessor$1'

恢复表可用

hbase(main):003:0> enable 'users'

Java API

TableName tableName = TableName.valueOf("users");

String path = "hdfs://:/user//coprocessor.jar";

Configuration conf = HBaseConfiguration.create();

Connection connection = ConnectionFactory.createConnection(conf);

Admin admin = connection.getAdmin();

admin.disableTable(tableName);

HTableDescriptor hTableDescriptor = new HTableDescriptor(tableName);

// columnFamily2.removeCoprocessor()

HColumnDescriptor columnFamily1 = new HColumnDescriptor("personalDet");

columnFamily1.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily1);

HColumnDescriptor columnFamily2 = new HColumnDescriptor("salaryDet");

columnFamily2.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily2);

admin.modifyTable(tableName, hTableDescriptor);

admin.enableTable(tableName);

9.8 代码例子

9.8.1 背景

官方文档例子。

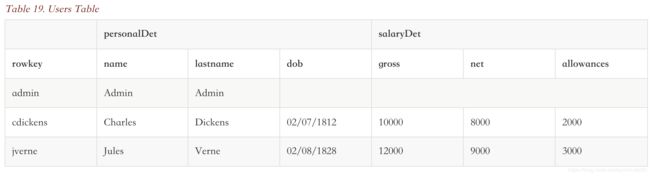

一个users表,拥有两个列族personalDet(用户详情) 和 salaryDet(薪水详情)

9.8.2 Observer例子

该协处理器能阻止在对users表的Get或Scan操作中返回用户admin的详情信息:

实现RegionObserver接口方法preGetOp(),在该方法中加入代码判断客户端查询的值是admin。如果是,就返回错误提示,否则就返回查询结果:

public class RegionObserverExample implements RegionObserver {

private static final byte[] ADMIN = Bytes.toBytes("admin");

private static final byte[] COLUMN_FAMILY = Bytes.toBytes("details");

private static final byte[] COLUMN = Bytes.toBytes("Admin_det");

private static final byte[] VALUE = Bytes.toBytes("You can't see Admin details");

@Override

public void preGetOp(final ObserverContext e, final Get get, final List results)

throws IOException {

if (Bytes.equals(get.getRow(),ADMIN)) {

Cell c = CellUtil.createCell(get.getRow(),COLUMN_FAMILY, COLUMN,

System.currentTimeMillis(), (byte)4, VALUE);

results.add(c);

e.bypass();

}

}

@Override

public RegionScanner preScannerOpen(final ObserverContext e, final Scan scan,

final RegionScanner s) throws IOException {

// 使用filter从scan中排除ADMIN结果

// 这样的缺点是会覆盖原有的其他filter

Filter filter = new RowFilter(CompareOp.NOT_EQUAL, new BinaryComparator(ADMIN));

scan.setFilter(filter);

return s;

}

@Override

public boolean postScannerNext(final ObserverContext e, final InternalScanner s,

final List results, final int limit, final boolean hasMore) throws IOException {

Result result = null;

Iterator iterator = results.iterator();

while (iterator.hasNext()) {

result = iterator.next();

if (Bytes.equals(result.getRow(), ADMIN)) {

// 也可以通过postScanner方式从结果中移除ADMIN

iterator.remove();

break;

}

}

return hasMore;

}

}

|

将协处理器和依赖一起打包为.jar文件

上传该jar文件到HDFS

用我们之前提到过的一种方式来加载该协处理器

写一个Get、Scan测试程序来验证

9.8.3 Endpoint例子

该例子实现一个Endpoint协处理器来计算所有职员的薪水之和:

以protobuf标准,创建一个描述我们服务的.proto文件:

option java_package = "org.myname.hbase.coprocessor.autogenerated";

option java_outer_classname = "Sum";

option java_generic_services = true;

option java_generate_equals_and_hash = true;

option optimize_for = SPEED;

message SumRequest {

required string family = 1;

required string column = 2;

}

message SumResponse {

required int64 sum = 1 [default = 0];

}

service SumService {

rpc getSum(SumRequest)

returns (SumResponse);

}

对以上.proto文件执行protoc命令来生成java代码Sum.java到src目录:

$ mkdir src

$ protoc --java_out=src ./sum.proto

Endpoint协处理器代码编写Coprocessor和CoprocessorService接口的方法:

public class SumEndPoint extends Sum.SumService implements Coprocessor, CoprocessorService {

private RegionCoprocessorEnvironment env;

@Override

public Service getService() {

return this;

}

@Override

public void start(CoprocessorEnvironment env) throws IOException {

if (env instanceof RegionCoprocessorEnvironment) {

this.env = (RegionCoprocessorEnvironment)env;

} else {

throw new CoprocessorException("Must be loaded on a table region!");

}

}

@Override

public void stop(CoprocessorEnvironment env) throws IOException {

// do nothing

}

@Override

public void getSum(RpcController controller, Sum.SumRequest request, RpcCallback done) {

Scan scan = new Scan();

// 列族

scan.addFamily(Bytes.toBytes(request.getFamily()));

// 列

scan.addColumn(Bytes.toBytes(request.getFamily()), Bytes.toBytes(request.getColumn()));

Sum.SumResponse response = null;

InternalScanner scanner = null;

try {

scanner = env.getRegion().getScanner(scan);

List| results = new ArrayList<>();

boolean hasMore = false;

long sum = 0L;

do {

hasMore = scanner.next(results);

// 按cell(rowkey/列/timestamp)遍历结果

for (Cell cell : results) {

// 累加结果

sum = sum + Bytes.toLong(CellUtil.cloneValue(cell));

}

results.clear();

} while (hasMore);

// 构建带结果的相应

response = Sum.SumResponse.newBuilder().setSum(sum).build();

} catch (IOException ioe) {

ResponseConverter.setControllerException(controller, ioe);

} finally {

if (scanner != null) {

try {

// 用完记得关闭scanner

scanner.close();

} catch (IOException ignored) {}

}

}

// 返回结果

done.run(response);

}

}

|

客户端调用代码:

Configuration conf = HBaseConfiguration.create();

Connection connection = ConnectionFactory.createConnection(conf);

TableName tableName = TableName.valueOf("users");

Table table = connection.getTable(tableName);

// 构建 对salaryDet列族 gross列 求和 的rpc请求

final Sum.SumRequest request = Sum.SumRequest.newBuilder().setFamily("salaryDet").setColumn("gross").build();

try {

// 调用Entpoint协处理器方法,得到结果

Map results = table.coprocessorService(

Sum.SumService.class,

null, /* start key */

null, /* end key */

// 回调方法

new Batch.Call() {

@Override

public Long call(Sum.SumService aggregate) throws IOException {

BlockingRpcCallback rpcCallback = new BlockingRpcCallback<>();

// 得到结果

aggregate.getSum(null, request, rpcCallback);

Sum.SumResponse response = rpcCallback.get();

return response.hasSum() ? response.getSum() : 0L;

}

}

);

// 遍历打印结果

for (Long sum : results.values()) {

System.out.println("Sum = " + sum);

}

} catch (ServiceException e) {

e.printStackTrace();

} catch (Throwable e) {

e.printStackTrace();

}

加载Endpoint协处理器

执行上述客户端代码,进行测试

9.8.3 HBase同步数据到ES

使用Hbase协作器(Coprocessor)同步数据到ElasticSearch

通过HBase Observer同步数据到ElasticSearch

10 过滤器

可参考Apache HBase Filter

过滤器使用不当会造成性能下降,必须经过严格测试才能投入生产环境。

过滤器可按RowKey/CF/Column/Timestamp等过滤数据,他们在于Scan/Get等配合使用时可直接在服务端就过滤掉不需要的数据,大大减少传回客户端的数据量。

11 HBase网络和线程模型

12 HBase实践

12.1 API

可参考

HBase基本操作-java api

HBase Java API

12.1.1 scan

按指定条件获取范围数据

scan可以通过setCaching, setBatch, setMaxResultSize等方法以空间换时间的思想来提高效率;

setCaching => .setNumberOfRowsFetchSize (客户端每次 rpc fetch 的行数,默认Integer.MAX_VALUE)

setMaxResultSize => .setMaxResultByteSize (客户端缓存的最大字节数,默认2MB)

setBatch => .setColumnsChunkSize (客户端每次获取的列数,默认-1代表所有列)

scan可以通过setStartRow与setEndRow来限定范围([start,end)start是闭区间,end是开区间)。范围越小,性能越高。

scan可以通过setFilter方法添加过滤器,这也是分页、多条件查询的基础(但BloomFilter不适用于Scan)。

ResultScanner使用完后必须关闭

频繁访问的行可setCacheBlocks开启块缓存

12.1.2 get

传入rowkey得到最新version数据或指定maxversion得到指定版本数据。除了查单一RowKey,也可以在构造 Get 对象的时候传入一个 rowkey 列表,这样一次 RPC 请求可以返回多条数据。

注意点

有助于减小读取时间。

HBase中实现了一个轻量级的内存BF结构,可以使得Get操作时从磁盘只读取可能包含目标Row的StoreFile。

BF本身存储在每个HFile的元数据中 ,永远不需要更新。当因为Region部署到RegionServer而打开HFile时,BF将加载到内存中。默认开启行级BF,可根据数据特征修改如 行+列级

衡量BF开启后影响是否为证明,可以看RS的blockCacheHitRatio(BlockCache命中率)指标是否增大,增大代表正面影响。

需要在删除时重建,因此不适合具有大量删除的场景。

BF分为行模式和行-列模式,在大量列级PUT时就用行列模式,其他时候用行模式即可。

12.1.3 put

放入一行数据.

注意点:

该过程会先把put放入本地put缓存writeBuffer,达到阈值后再提交到服务器。

批量导入

海量数据写入前预拆分Region,避免后序自动Split过程阻塞数据导入

当对安全性要求没那么高时可以使用WAL异步刷新写入方式。甚至在某些场景下可以禁用WAL

12.1.4 delete

删除指定数据

12.1.5 append

在指定RowKey数据后追加数据

12.1.6 increment

可参考HBase Increment(计数器)简介及性能测试

在RegionServer端原子性的对某个Value数值加或减,而不是加锁的Read-Modify-Write。可作为计数器使用。

12.2 HBase Shell

进入到HBase RS机器的$HBASE_HOME/bin目录后,使用hbase shell命令启动 shell客户端即可。

12.3 二级索引

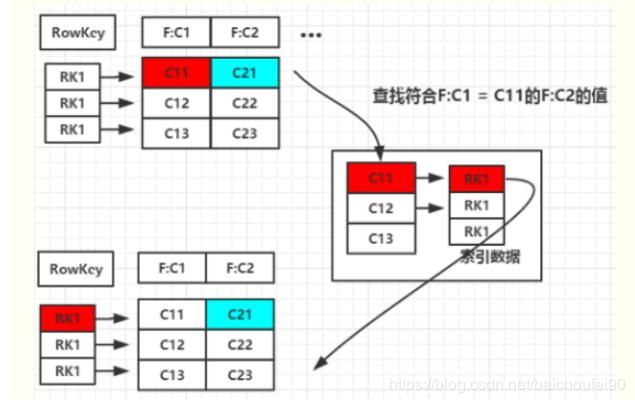

12.3.1 基本思路

那么,当要查找满足F:C1=C11的F:C2列数据,就可以去索引表找到F:C1=C11对应的RowKey,再回原表查找该行的F:C2数据。

12.3.2 协处理器的实现方案

用RegionObserver的prePut在每次写入主表数据时,写一条到索引表,即可建立二级索引。

12.4 Schema设计

更多例子可以看http://hbase.apache.org/book.html#schema.casestudies

12.4.1 列族

列族数量越少越好

列族多的坏处

总的来说最好是设计一个列族就够了,因为一般查询请求也只访问某个列族。

列族名不宜过长

BlockSizeBlockSize(默认64KB)。当cell较大时需加大此配置。且该值和StoreFile的索引文件大小成反比。

内存列族

12.4.2 Region

一个Region的大小一般不超过50GB。

一个有1或2个列族的表最佳Region总数为50-100个

12.4.3 RowKey设计

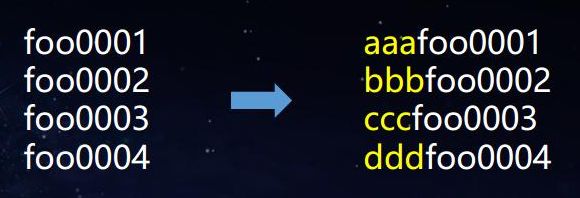

避免设计连续RowKey导致数据热点,导致过载而请求响应过慢或无法响应,甚至影响热点Region所在RS的其他Region。如果Rowkey是按时间戳的方式递增,不要将时间放在二进制码的前面,建议将Rowkey的高位作为散列字段,由程序循环生成,低位放时间字段,这样将提高数据均衡分布在每个Regionserver实现负载均衡的几率。常用措施如下:

Salting-加盐

foo0001

foo0002

foo0003

foo0004

a-foo0003

b-foo0001

c-foo0003

c-foo0004

d-foo0002

优缺点:Salting可增加写的吞吐量,但会降低读效率,因为有随机前缀,Scan和Get操作都受影响。

Hash算法

examples: substring(MD5(设备ID),0,x) + 设备的ID,其中(x一般会取5到6位.)

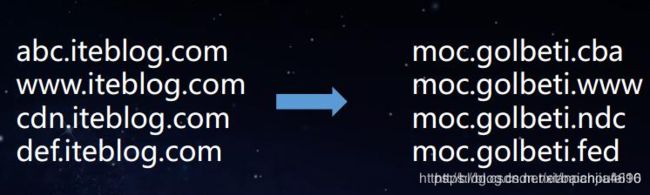

逆置Key

业务必须用时间序列或连续递增数字时,可以在开头加如type这类的前缀使得分布均匀。

定位cell时,需要表名、RowKey、列族、列名和时间戳。而且StoreFile(HFile)有索引,cell过大会导致索引过大(使用时会放入内存)。所以需要设计schema时:

列族名尽量简短,甚至只用一个字符;

列名尽量简短:

RowKey保证唯一性,长度可读、简短,尽量使用数字。

版本号采用倒序的时间戳,这样可以快速返回最新版本数据

同一行不同列族可以拥有同样的RowKey

RowKey具有不可变性

RowKey长度

数据的持久化文件HFile中是按照KeyValue存储的,如果Rowkey过长如100个字节,1000万列数据光Rowkey就要占用100*1000万=10亿个字节,近1G数据,这会极大影响HFile的存储效率;

MemStore将缓存部分数据到内存,如果Rowkey字段过长内存的有效利用率会降低,系统将无法缓存更多的数据,这会降低检索效率。因此Rowkey的字节长度越短越好。

操作系统大多64位,内存8字节对齐,控制在16个字节即8字节整数倍利用可利用OS最佳特性。

12.4.4 Versions

指定一个RowKey数据的最大保存的版本个数,默认为3。越少越好,减小开销。compact时OOM。

如果非要使用很多版本,那最好考虑使用不同的行进行数据分离。

12.4.5 压缩

详见http://hbase.apache.org/book.html#compression

12.4.6 Cell

一个cell不应超过10MB,否则就应该把数据存入HDFS,而只在HBase存指针指向该数据。

12.5 join

HBase本身不支持join。

可以自己写程序比如MR实现。

Phoenix里面有join函数,但是性能很差,稍不注意会把集群打挂。最好不要用hbase系来做join,这种还是用hive来搞比较好。

13 HBase对比其他技术

13.1 对比HDFS/MR

13.2 对比Cassandra

13.3 对比Kudu

Kudu很多地方的设计借鉴了HBase思想

Kudu限制较多

Kudu顺序写较HBase速度更快,但慢于HDFS;Kudu随机读较HBase慢,但比HDFS快得多。总的来说Kudu是一个折中设计。

Kudu是真正的列存储,而HBase是列族存储。指定查询某几列时,一般来说Kudu会更快

14 调优

14.1 参考

14.2 操作系统

可参考:

调优点:

内存

使用64位OS和JVM

关闭SWAPvm.swappiness = 0

14.3 GC

可参考:

HBase最佳实践-CMS GC调优

普通内存时用-XX:+UseConcMarkSweepGC,即老年代CMS并发搜集,年轻带使用ParNew并行搜集;

大内存时启用G1 GC,针对大内存(>=32GB)优化。

Concurrent Mode Failure-XX:CMSInitiatingOccupancyFraction(比如60-70%),否则可能导致老年代占满并发搜集失败触发STW的FullGC。但不能过低,否则会导致过多的GC次数和CPU使用。

老年代内存碎片hbase-env.sh中设置-XX:PretenureSizeThreshold小于hbase.hregion.memstore.mslab.chunksize以使得MSLAB直接在老年代分配内存,这样可以省去在年轻带Survivor区复制成本已经发生MinorGC时复制到老年代成本。

相关配置如下:

hbase.hregion.memstore.mslab.enabled

hbase.hregion.memstore.mslab.chunksize

hbase.hregion.memstore.mslab.max.allocation

hbase.hregion.memstore.chunkpool.maxsize

14.4 HBase参数

可参考Recommended Configurations

14.4.1 hedged对冲读

14.4.2 Region Compact

在某些场景中,put会被阻塞在MemStore上,因为太多的小StoreFile文件被反复合并。

可在某些重要场景的关闭hbase表的major compact,在非高峰期的时候再手动调用major compact,可以减少split的同时显著提供集群的性能和吞吐量。

14.4.3 MemStoreFlush

Memstore配置适合与否对性能影响很大,频繁的flush会带来额外负载影响读写性能。

还需要看这里

14.4.4 综合

hbase.regionserver.handler.count

hfile.block.cache.size

Prefetch Option for Blockcache

hbase.hstore.blockingStoreFiles

hbase.hregion.memstore.block.multiplier

hbase.regionserver.checksum.verify

hbase.ipc.server.num.callqueue

14.5 Zookeeper

14.6 Schema设计

14.7 代码优化

14.7.1 Bytes.toBytes

尽量少用Bytes.toBytes,因为在循环或MR任务中,这种重复的转换代价昂贵,应该如下定义:

public static final byte[] CF = "cf".getBytes();

public static final byte[] ATTR = "attr".getBytes();

...

Get get = new Get(rowkey);

Result r = table.get(get);

byte[] b = r.getValue(CF, ATTR); // returns current version of value

14.8 写优化

14.8.1 批量数据加载

使用基于MR的BulkLoad相较于HBaseAPI,使用更少的CPU和网络资源。

14.8.2 预分区

14.8.3 WAL优化

在允许的场景,可将WALflush设为异步甚至禁用,坏处是丢数据风险。

可在批量加载数据时禁用WALflush。

14.8.4 防止Region写入热点

14.9 读优化

14.9.1 GC

14.9.2 磁盘

对实时性要求高的使用SSD

14.9.3 HFile Compact

关闭自动Marjor Compact,转为业务低峰期手动

根据具体场景调整Compact触发阈值/每次Compact文件数量等,减少每次scan时的HFile数,但必须综合考虑

14.9.4 BlockCache缓存

CombinedBlockCache

hfile.block.cache.size

14.9.5 本地性

RS与DN混合部署,提升数据读写本地性。

14.9.6 对冲读

Hedged Reads(对冲读),是Hadoop 2.4.0 引入的一项HDFS特性。

普通的每个HDFS读请求都对应一个线程

对冲读开启后,如果读取未返回,则客户端会针对相同数据的不同HDFS Block副本生成第二个读请求。

使用先返回的任何一个读请求,并丢弃另一个。

可通过hedgedReadOps(已触发对冲读取线程的次数。 这可能表明读取请求通常很慢,或者对冲读取的触发过快) 和 hedgeReadOpsWin(对冲读取线程比原始线程快的次数。 这可能表示给定的RegionServer在处理请求时遇到问题) 指标评估开启对冲读的效果

在追求最大化吞吐量时,开启对冲读可能导致性能下降

需要在hbase-site.xml配置如下内容:

dfs.client.hedged.read.threadpool.size

50

dfs.client.hedged.read.threshold.millis

100

14.9.7 短路读

如果不开启,则读取本地DN上的数据时也需要RPC请求使用Socket,层层处理后返回

开启短路读后,可以直接由DN打开目标文件和对应校验文件并把文件描述符直接返回,Client收到后可直接打开、读取数据即可

配置方式如下:hbase-site.xml文件:

dfs.client.read.shortcircuit

true

This configuration parameter turns on short-circuit local reads.

dfs.domain.socket.path

/home/stack/sockets/short_circuit_read_socket_PORT

Optional. This is a path to a UNIX domain socket that will be used for

communication between the DataNode and local HDFS clients.

If the string "_PORT" is present in this path, it will be replaced by the

TCP port of the DataNode.

14.9.8 高可用读

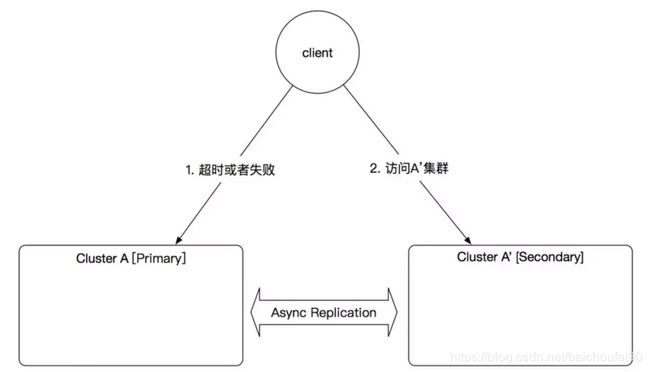

为了防止RS挂掉时带来的其上Region不可用及恢复的时间空档,可使用HBase Replication:

14.9.9 scan只选择要读的列

Scan时建议指定需要的Column Family,减少通信量,否则scan操作默认会返回整个row的所有CF/Column的数据.

Scan s = new Scan();

// 选择列族进行Scan

s.addFamily(Bytes.toBytes("cf1"));

// 选择列族/列进行scan

s.addColumn(Bytes.toBytes("cf1"), Bytes.toBytes("c1"));

// 仅检索列族cf下的c1列和c2列

Map> familyMap = new HashMap<>();

NavigableSet cs = new TreeSet();

cs.add("c1");

cs.add("c2");

familyMap.put(Bytes.toBytes("cf1"), cs);

s.setFamilyMap(familyMap);

14.9.10 记得关闭资源

使用完后,关闭Connection/Table/ResultScanner,特别是不关闭ResultScanner可能导致RegionServer出现性能问题,所以最好是把他放在try中:

Scan scan = new Scan();

// set attrs...

ResultScanner rs = table.getScanner(scan);

try {

for (Result r = rs.next(); r != null; r = rs.next()) {

// process result...

} finally {

rs.close(); // always close the ResultScanner!

}

table.close();

14.9.11 合理使用Filter

14.9.12 合理使用BloomFilter

按需调整BloomFilter,默认是Row模式

14.10 HBase删除优化

切记删除的原理是写入一个墓碑,会有写入开销和读数据时开销

批量删除Table.delete(Delete)就会有一个RPC请求发送到RS,而不能利用writerBuffer,所以大量删除时请使用Table.delete(List)

14.11 HDFS

15 Phoenix on HBase

关于Phoenix on HBase,即Sql化的HBase服务,可以参考Phoenix学习

常见问题

1 为什么HBase查询速度快

首先是可以从hbase:meta快速的定位到Region,而且优先MemStore(SkipList跳表)查询,因为HBase的写入特性所以MemStore如果找到符合要求的肯定就是最新的直接返回即可。

如果找不到还能通过BloomFilter/DataBlock索引等高效的从BlockCache查找,

还是没有的话就相对快速的从已按RowKey升序排序的HFile中查找。

2 为什么HBase写入速度快

虽然HBase很多时候是随机写入,但因为引入了内存中的MemStore(由SkipList实现,是多层有序数据结构),批量顺序输入HDFS,所以可先写入将随机写转为了顺序写

3 频繁出现数据无法写入

检查RSMemStore内存设置

检查hbase.hstore.blockingStoreFiles参数

Flush后如果该Store的StoreFile数量如果超过了hbase.hstore.blockingStoreFiles,则会阻塞该Region的更新写入操作,直到有Compact发生减少了StoreFile数量或等待until hbase.hstore.blockingWaitTime超时,然后继续正常Flush。

检查hbase.hregion.memstore.flush.size hbase.hregion.memstore.block.multiplierhbase.hregion.memstore.block.multiplier 乘以 hbase.hregion.memstore.flush.size字节时,会阻塞写入,主要是为了防止在update高峰期间MemStore大小失控,造成其flush的文件需要很长时间来compact或split,甚至造成OOM服务直接down掉。内存足够大时,可调大该值。

检查hbase.regionserver.global.memstore.sizehbase.regionserver.global.memstore.size设定了一个RS内全部Memstore的总大小阈值,默认大小为Heap的40%,达到阈值以后就会阻塞更新请求,并开始RS级别的MemStore flush。

4 RegionServer挂掉或失联

4.1 问题描述

RS因为长时间FullGC 导致STW,无法及时发送心跳到ZK,所以被ZK标为宕机。此时会Master会注意到该RS节点挂掉,将其上的Region迁移到其他RS节点。待故障RS恢复后,发现自己被标为宕机,所以只能自杀,否则会出现错乱。

4.2 解决方案

5 部分转自网易范欣欣-HBase原理-数据读取流程解析

5.1 HBase作为列式存储,为什么它的scan性能这么低呢,列式存储不是更有利于scan操作么?Parquet格式也是列式,但它的scan这么优秀,他们的性能差异并不是因为数据组织方式造成的么?谢谢啦

HBase不完全是列式存储,确切的说是列族式存储,HBase中可以定义一个列族,列族下可以有都个列,这些列的数据是存在一起的。而且通常情况下我们建议列族个数不大于2个,这样的话每个列族下面必然会有很多列。因此HBase并不是列式存储,更有点像行式存储。

HBase扫描本质上是一个一个的随机读,不能做到像HDFS(Parquet)这样的顺序扫描。试想,1000w数据一条一条get出来,性能必然不会很好。问题就来了,HBase为什么不支持顺序扫描?

因为HBase支持更新操作以及多版本的概念,这个很重要。可以说如果支持更新操作以及多版本的话,扫描性能就不会太好。原理是HBase是一个类LSM数据结构,数据写入之后先写入内存,内存达到一定程度就会形成一个文件,因此HBase的一个列族会有很多文件存在。因为更新以及多版本的原因,一个数据就可能存在于多个文件,所以需要一个文件一个文件查找才能定位出具体数据。

所以HBase架构本身个人认为并不适合做大规模scan,很大规模的scan建议还是用Parquet,可以把HBase定期导出到Parquet来scan

5.2 Kudu也是采用的类LSM数据结构,但是却能达到parquet的扫描速度(kudu是纯列式的),kudu的一个列也会形成很多文件,但是好像并没影响它的性能?

kudu性能并没有达到parquet的扫描速度,可以说介于HBase和HDFS(Parquet)之间

kudu比HBase扫描性能好,是因为kudu是纯列存,扫描不会出现跳跃读的情况,而HBase可能会跳跃seek,这是本质的区别。

但kudu扫描性能又没有Parquet好,就是因为kudu是LSM结构,它扫描的时候还是会同时顺序扫描多个文件,并比较key值大小。

而Parquet只需要顺序对一个Block块中的数据进行扫描即可,这个是两者的重要区别。

所以说hbase相比parquet,这两个方面都是scan的劣势。

好文推荐

综合

Apache HBase 全攻略

Hadoop之HBase综述

HBase中文文档

原理

HBase原理-数据读取流程解析

总结HBase各种级别的锁以及对读写的阻塞

网易范欣欣-HBase – Memstore Flush

网易范欣欣-HBase - Compaction的前生今世-身世之旅

网易范欣欣-HBase - Compaction的前生今世-改造之路

网易范欣欣-HBase - 数据写入流程解析

网易范欣欣-HBase原理-数据读取流程解析

网易范欣欣-HBase-数据读取流程部分细节

网易范欣欣-HBase – Region切分

网易范欣欣-HBase BlockCache系列 – 走进BlockCache

网易范欣欣-HBase BlockCache系列 - 探求BlockCache实现机制

网易范欣欣-HBase – 存储文件HFile结构解析

网易范欣欣-HBase – 探索HFile索引机制

网易范欣欣-HBase – 分布式系统中snapshot

网易范欣欣-数据库事务系列-HBase行级事务模型

网易范欣欣-HBase最佳实践-多租户机制简析

HBase-拆分&合并

HBase原理机制:Region的拆分与合并

索引

HBase二级索引方案

调优

有赞技术-HBase 读流程解析与优化的最佳实践

hbase优化之旅(一)探索regionserver参数优化

hbase优化之旅(二)regionserver的G1 GC优化探索

(1.3版)hbase优化之旅(三)-regionserver g1 执行细节和参数调优方法论详解

hbase优化之旅(四)-regionserver从17优化到10台的小结

网易范欣欣-HBase最佳实践-CMS GC调优

网易范欣欣-HBase最佳实践-内存规划

网易范欣欣-HBase最佳实践 – 客户端重试机制

网易范欣欣-HBase最佳实践-客户端超时机制

网易范欣欣-HBase最佳实践-集群规划

网易范欣欣-HBase最佳实践-用好你的操作系统

网易范欣欣-HBase最佳实践-列族设计优化

网易范欣欣-HBase最佳实践-写性能优化策略

网易范欣欣-HBase最佳实践-读性能优化策略

网易范欣欣-HBase最佳实践 – Scan用法大观园

0xFF 参考文档

Apache HBase

HBase 官方文档中文版

数据结构-常用树总结

HBase写请求分析

HBase Scan 中 setCaching setMaxResultSize setBatch 解惑

HBase二级索引实现方案

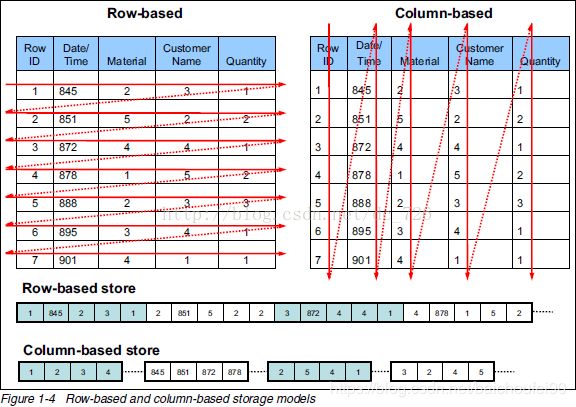

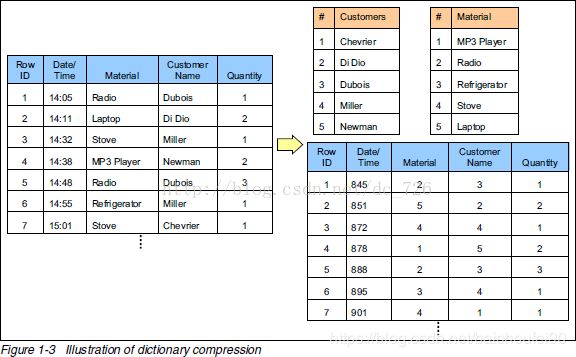

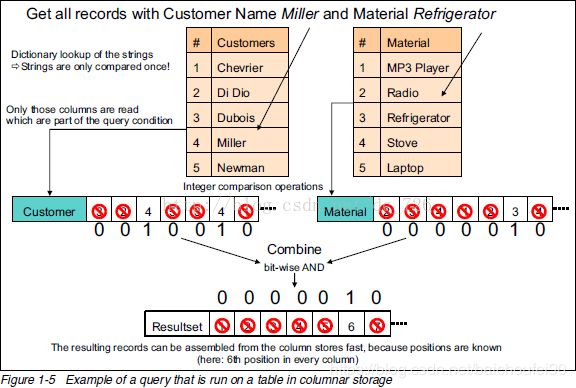

传统的行存储和(HBase)列存储的区别

大数据存取的选择:行存储还是列存储?

处理海量数据:列式存储综述(存储篇)

Hbase行级事务模型

HBase使用总结

Hbase split的三种方式和split的过程

Hbase 技术细节笔记(上)

Hbase 技术细节笔记(下)

HBase原理-数据读取流程解析

Apache HBase 全攻略

Hbase的Rowkey设计以及如何进行预分区

HBase之七:事务和并发控制机制原理

[翻译]HBase 中的 ACID

Hbase split的三种方式和split的过程

HBase数据存储格式

Hbase最佳实战:Region数量与大小的重要影响

网易范欣欣-HBase – Memstore Flush深度解析

网易范欣欣-HBase Compaction的前生今世-身世之旅

网易范欣欣-HBase - 数据写入流程解析

HBase篇(4)-你不知道的HFile

网易范欣欣-HBase-数据读取流程解析

网易范欣欣-HBase-迟到的‘数据读取流程’部分细节

Hbase 布隆过滤器BloomFilter介绍

HBase高性能随机查询之道 – HFile原理解析

HBase 读流程解析与优化的最佳实践

HBase-拆分合并和调优参考

hbase-hug-presentation

HBASE(Memstore的专属JVM策略MSLAB)

HBase MSLAB和MemStoreChunkPool源码

你可能感兴趣的:(HBase应该知道的)

guava loadingCache代码示例

IM 胡鹏飞

Java 工具类介绍

publicclassTest2{publicstaticvoidmain(String[]args)throwsException{LoadingCachecache=CacheBuilder.newBuilder()//设置并发级别为8,并发级别是指可以同时写缓存的线程数.concurrencyLevel(8)//设置缓存容器的初始容量为10.initialCapacity(10)//设置缓存

系统学习Python——并发模型和异步编程:进程、线程和GIL

分类目录:《系统学习Python》总目录在文章《并发模型和异步编程:基础知识》我们简单介绍了Python中的进程、线程和协程。本文就着重介绍Python中的进程、线程和GIL的关系。Python解释器的每个实例都是一个进程。使用multiprocessing或concurrent.futures库可以启动额外的Python进程。Python的subprocess库用于启动运行外部程序(不管使用何种

C++11堆操作深度解析:std::is_heap与std::is_heap_until原理解析与实践

文章目录堆结构基础与函数接口堆的核心性质函数签名与核心接口std::is_heapstd::is_heap_until实现原理深度剖析std::is_heap的验证逻辑std::is_heap_until的定位策略算法优化细节代码实践与案例分析基础用法演示自定义比较器实现最小堆检查边缘情况处理性能分析与实际应用时间复杂度对比典型应用场景与手动实现的对比注意事项与最佳实践迭代器要求比较器设计C++标

为什么会出现“与此站点的连接不安全”警告?

当浏览器弹出“与此站点的连接不安全”的红色警告时,不仅会让访客感到不安,还可能直接导致用户流失、品牌信誉受损,甚至引发数据泄露风险。作为网站运营者,如何快速解决这一问题?一、为什么会出现“与此站点的连接不安全”警告?浏览器提示“不安全连接”,本质上是检测到当前网站与用户之间的数据传输未经过加密保护。以下是触发警告的常见原因:1.未安装SSL证书SSL(SecureSocketsLayer)证书是网

什么是证书吊销列表?CRL 解释

WoTrusSSL

ssl https

数字证书是安全在线互动的支柱,用于验证身份和确保加密通信。但是,当这些证书被盗用或滥用时,必须立即撤销它们以维持信任。这就是证书撤销列表(CRL)的作用所在。CRL由证书颁发机构(CA)维护,对于识别和撤销已撤销的证书,防止其造成危害至关重要。在本指南中,我们将探讨什么是CRL、它们如何运作以及为什么它们对网络安全至关重要。什么是证书吊销列表(CRL)?证书吊销列表(CRL)是证书颁发机构(CA)

有必要获得WHQL测试认证吗,有什么好处?

什么是WHQL认证?WHQL是MicrosoftWindowsHardwareQualityLab的缩写,中文意思是Windows硬件设备质量实验室,主要是对Windows操作系统的兼容性测试,检验硬件产品和驱动程序在windows系统下的兼容性和稳定性。当某一硬件或软件通过WHQL测试时,制造商可以在其产品包装和广告上使用“DesignedforWindows”标志。该标志可以证明硬件或软件已经

Flask框架入门:快速搭建轻量级Python网页应用

「已注销」

python-AI python基础 网站网络 python flask 后端

转载:Flask框架入门:快速搭建轻量级Python网页应用1.Flask基础Flask是一个使用Python编写的轻量级Web应用框架。它的设计目标是让Web开发变得快速简单,同时保持应用的灵活性。Flask依赖于两个外部库:Werkzeug和Jinja2,Werkzeug作为WSGI工具包处理Web服务的底层细节,Jinja2作为模板引擎渲染模板。安装Flask非常简单,可以使用pip安装命令

驱动程序为什么要做 WHQL 认证?

GDCA SSL证书

网络协议 网络

驱动程序进行WHQL(WindowsHardwareQualityLabs)认证的核心价值在于解决兼容性、安全性和市场准入三大关键问题,具体必要性如下:️一、规避系统拦截,保障驱动可用性消除安装警告未认证的驱动在安装时会触发Windows的红色安全警告(如“无法验证发布者”),甚至被系统强制拦截。通过WHQL认证的驱动获得微软数字签名,用户可无阻安装。满足系统强制要求Windows1

求是网:“内卷式”竞争的突出表现和主要危害有哪些?

加百力

财经研究 科技知识 人工智能 大数据

"内卷式"竞争主要表现为:企业层面的低价竞争、同质化竞争和营销"逐底竞争";地方政府层面的违规优惠政策、盲目重复建设和设置市场壁垒。危害体现在三个层面:微观上导致"劣币驱逐良币",损害消费者利益;中观上破坏行业生态,挤压产业链利润空间;宏观上扭曲资源配置,抑制创新活力。什么是“内卷式”竞争?概括其一般特征,是指经济主体为了维持市场地位或争夺有限市场,不断投入大量精力和资源,却没有带来整体收益增长的

WHQL签名怎么申请

GDCA SSL证书

windows

WHQL(WindowsHardwareQualityLabs)签名是微软对硬件和驱动程序进行认证的一种方式,以确保它们与Windows操作系统的兼容性和稳定性。以下是申请WHQL签名的基本步骤,供您参考:1.准备阶段准备硬件设备和驱动程序:确保您的硬件设备已经准备好,并且对应的驱动程序已经经过充分的测试,能够在各种配置和环境下正常工作。获取EV代码签名证书:根据微软的要求,驱动程序进行WHQL认

JSON 与 AJAX

Auscy

json ajax 前端

一、JSON(JavaScriptObjectNotation)1.数据类型与语法细节支持的数据类型:基本类型:字符串(需用双引号)、数字、布尔值(true/false)、null。复杂类型:数组([])、对象({})。严格语法规范:键名必须用双引号包裹(如"name":"张三")。数组元素用逗号分隔,最后一个元素后不能有多余逗号。数字不能以0开头(如012会被解析为12),不支持八进制/十六进制

发票合并工具

小朋的软件园

前端 javascript java html 服务器

"发票合并工具"是一款专为高效整理票据设计的实用工具,支持将来自不同渠道的发票文件(如PDF文档、各类图片格式)快速整合为排版规范的PDF文件,尤其适用于财务报销场景下的批量票据处理需求。核心功能亮点多格式兼容:无缝导入PDF文件及常见图片格式(.png/.jpg/.jpeg/.bmp),适配多来源发票整合需求。智能布局配置:提供灵活的页面布局选项(每页2/3/4张发票),其中"2合1"模式针对报

Python Flask 框架入门:快速搭建 Web 应用的秘诀

Python编程之道

Python人工智能与大数据 Python编程之道 python flask 前端 ai

PythonFlask框架入门:快速搭建Web应用的秘诀关键词Flask、微框架、路由系统、Jinja2模板、请求处理、WSGI、Web开发摘要想快速用Python搭建一个灵活的Web应用?Flask作为“微框架”代表,凭借轻量、可扩展的特性,成为初学者和小型项目的首选。本文将从Flask的核心概念出发,结合生活化比喻、代码示例和实战案例,带你一步步掌握:如何用Flask搭建第一个Web应用?路由

C++ 11 Lambda表达式和min_element()与max_element()的使用_c++ lamda函数 min_element((1)

2401_84976182

程序员 c语言 c++ 学习

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上CC++开发知识点,真正体系化!由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新如果你需要这些资料,可以戳这里获取#include#include#includeusingnamespacestd;boolcmp(int

C++ 11 Lambda表达式和min_element()与max_element()的使用_c++ lamda函数 min_element(

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。需要这份系统化的资料的朋友,可以添加戳这里获取一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!intmain(){vectormyvec{3,

k8s:安装 Helm 私有仓库ChartMuseum、helm-push插件并上传、安装Zookeeper

云游

docker helm helm-push

ChartMuseum是Kubernetes生态中用于存储、管理和发布HelmCharts的开源系统,主要用于扩展Helm包管理器的功能核心功能集中存储:提供中央化仓库存储Charts,支持版本管理和权限控制。跨集群部署:支持多集群环境下共享Charts,简化部署流程。离线部署:适配无网络环境,可将Charts存储在本地或局域网内。HTTP接口:通过HTTP协议提供服务,用户

上位机知识篇---SD卡&U盘镜像

常用的镜像烧录软件balenaEtcherbalenaEtcher是一个开源的、跨平台的工具,用于将操作系统镜像文件(如ISO和IMG文件)烧录到SD卡和USB驱动器中。以下是其使用方法、使用场景和使用注意事项的介绍:使用方法下载安装:根据自己的操作系统,从官方网站下载对应的安装包。Windows系统下载.exe文件后双击安装;Linux系统若下载的是.deb文件,可在终端执行“sudodpkg-

【LeetCode 热题 100】24. 两两交换链表中的节点——(解法一)迭代+哨兵

xumistore

LeetCode leetcode 链表 算法 java

Problem:24.两两交换链表中的节点题目:给你一个链表,两两交换其中相邻的节点,并返回交换后链表的头节点。你必须在不修改节点内部的值的情况下完成本题(即,只能进行节点交换)。文章目录整体思路完整代码时空复杂度时间复杂度:O(N)空间复杂度:O(1)整体思路这段代码旨在解决一个经典的链表操作问题:两两交换链表中的节点(SwapNodesinPairs)。问题要求将链表中每两个相邻的节点进行交换

Guava LoadingCache

sqyaa.

java并发编程 Java知识 jvm 缓存 guava

LoadingCache是GoogleGuava库提供的一个高级缓存实现,它通过自动加载机制简化了缓存使用模式。核心特性自动加载机制当缓存未命中时,自动调用指定的CacheLoader加载数据线程安全:并发请求下,相同key只会加载一次灵活的过期策略支持基于写入时间(expireAfterWrite)和访问时间(expireAfterAccess)的过期可设置最大缓存大小,基于LRU策略淘汰丰富的

JavaScript 树形菜单总结

Auscy

microsoft

树形菜单是前端开发中常见的交互组件,用于展示具有层级关系的数据(如文件目录、分类列表、组织架构等)。以下从核心概念、实现方式、常见功能及优化方向等方面进行总结。一、核心概念层级结构:数据以父子嵌套形式存在,如{id:1,children:[{id:2}]}。节点:树形结构的基本单元,包含自身信息及子节点(若有)。展开/折叠:子节点的显示与隐藏切换,是树形菜单的核心交互。递归渲染:因数据层级不固定,

基于定制开发开源AI智能名片S2B2C商城小程序的社群游戏定制策略研究

说私域

人工智能 小程序 游戏

摘要:本文聚焦社群游戏定制领域,深入探讨以社群文化和用户偏好为导向的定制策略。通过分析互动游戏活动、社群文化塑造等关键要素,结合定制开发开源AI智能名片S2B2C商城小程序的技术特性,提出针对性游戏定制方案。研究旨在提升社群用户参与度与游戏体验,为社群游戏发展提供理论支持与实践指导。关键词:社群游戏定制;定制开发开源AI智能名片S2B2C商城小程序;社群文化;用户偏好一、引言在数字化社交蓬勃发展的

冒泡、选择、插入排序:三大基础排序算法深度解析(C语言实现)

xienda

算法 排序算法 数据结构

在算法学习道路上,排序算法是每位程序员必须掌握的基石。本文将深入解析冒泡排序、选择排序和插入排序这三种基础排序算法,通过C语言代码实现和对比分析,帮助读者彻底理解它们的差异与应用场景。算法原理与代码实现1.冒泡排序(BubbleSort)工作原理:通过重复比较相邻元素,将较大元素逐步"冒泡"到数组末尾。voidbubbleSort(intarr[],intn){ for(inti=0;iarr[

Leetcode 148. 排序链表

文章目录前引题目代码(首刷看题解)代码(8.9二刷部分看解析)代码(9.15三刷部分看解析)前引综合性比较强的一道题,要求时间复杂度必须O(logn)才能通过,最适合链表的排序算法就是归并。这里采用自顶向下的方法步骤:找到链表中点(双指针)对两个子链表排序(递归,直到只有一个结点,记得将子链表最后指向nullptr)归并(引入dummy结点)题目Leetcode148.排序链表代码(首刷看题解)c

全面触摸屏输入法设计与实现

长野君

本文还有配套的精品资源,点击获取简介:触摸屏输入法是针对触摸设备优化的文字输入方案,包括虚拟键盘、手写、语音识别和手势等多种输入方式。本方案通过提供主程序文件、用户手册、界面截图、示例图、说明文本和音效文件,旨在为用户提供一个完整的、多样的文字输入体验。开发者通过持续优化算法和用户界面,使用户在无物理键盘环境下也能高效准确地进行文字输入。1.触摸屏输入法概述简介在现代信息技术飞速发展的今天,触摸屏

LeetCode 148. 排序链表:归并排序的细节解析

进击的小白菜

2025 Top100 详解 leetcode 链表 算法

文章目录题目描述一、方法思路:归并排序的核心步骤二、关键实现细节:快慢指针分割链表1.快慢指针的初始化问题2.为什么选择`fast=head.next`?示例1:链表长度为偶数(`1->2->3->4`)三、完整代码实现四、复杂度分析五、总结题目描述LeetCode148题要求对链表进行排序,时间复杂度需为O(nlogn),且空间复杂度为O(logn)。由于链表的特殊结构(无法随机访问),归并排序

前端项目架构设计要领

1.架构设计的核心目标在设计前端项目架构时,核心目标是模块化、可维护、可扩展、可测试,以及开发效率的最大化。这些目标可以通过以下几个方面来实现:组件化:将UI功能封装为可复用的组件。模块化:将业务逻辑分解为独立的模块或服务。自动化构建与部署:实现自动化构建、测试和部署流程,减少人为操作的错误。代码规范化与检查:确保团队协作时,代码风格和质量一致。2.项目目录结构设计一个清晰合理的目录结构对大型项目

精通Canvas:15款时钟特效代码实现指南

烟幕缭绕

本文还有配套的精品资源,点击获取简介:HTML5的Canvas是一个用于绘制矢量图形的API,通过JavaScript实现动态效果。本项目集合了15种不同的时钟特效代码,帮助开发者通过学习绘制圆形、线条、时间更新、旋转、颜色样式设置及动画效果等概念,深化对Canvas的理解和应用。项目中的CSS文件负责时钟的样式设定,而JS文件则包含实现各种特效的逻辑,通过不同的函数或类处理时间更新和动画绘制,提

高效批量单词翻译工具的设计与应用

本文还有配套的精品资源,点击获取简介:在信息技术飞速发展的今天,批量单词翻译工具通过计算机的数据处理能力,大大提高了语言学习和文字处理的效率。用户通过简单输入单词列表到一个文本文件,并运行翻译程序,即可获得翻译结果并保存至指定文件。该工具集成了内置或外部翻译引擎,利用自然语言处理技术实现快速准确的翻译,并可能提供词性识别等附加功能。尽管机器翻译无法完全取代人工校对,但它为用户提供了一种高效的翻译解

嵌入式系统LCD显示模块编程实践

本文还有配套的精品资源,点击获取简介:本文档提供了一个具有800x480分辨率的3.5英寸液晶显示模块LW350AC9001的驱动程序代码,以及嵌入式系统中使用C/C++语言进行硬件编程的实践指南。该模块的2mm厚度使其适用于空间受限的便携式设备。内容包括驱动程序源代码、硬件控制接口使用方法,以及如何在嵌入式系统中进行图形处理、电源管理与性能优化。1.嵌入式系统原理1.1嵌入式系统概念嵌入式系统是

深入剖析OpenJDK 18 GA源码:Java平台最新发展

想法臃肿

本文还有配套的精品资源,点击获取简介:OpenJDK18GA作为Java开发的关键里程碑,提供了诸多新特性和改进。本文章深入探讨了OpenJDK18GA源码,揭示其内部机制,帮助开发者更好地理解和利用这个版本。文章还涵盖了PatternMatching、SealedClasses、Records、JEP395、JEP406和JEP407等特性,以及HotSpot虚拟机、编译器、垃圾收集器、内存模型

html页面js获取参数值

0624chenhong

html

1.js获取参数值js

function GetQueryString(name)

{

var reg = new RegExp("(^|&)"+ name +"=([^&]*)(&|$)");

var r = windo

MongoDB 在多线程高并发下的问题

BigCat2013

mongodb DB 高并发 重复数据

最近项目用到 MongoDB , 主要是一些读取数据及改状态位的操作. 因为是结合了最近流行的 Storm进行大数据的分析处理,并将分析结果插入Vertica数据库,所以在多线程高并发的情境下, 会发现 Vertica 数据库中有部分重复的数据. 这到底是什么原因导致的呢?笔者开始也是一筹莫 展,重复去看 MongoDB 的 API , 终于有了新发现 :

com.mongodb.DB 这个类有

c++ 用类模版实现链表(c++语言程序设计第四版示例代码)

CrazyMizzz

数据结构 C++

#include<iostream>

#include<cassert>

using namespace std;

template<class T>

class Node

{

private:

Node<T> * next;

public:

T data;

最近情况

麦田的设计者

感慨 考试 生活

在五月黄梅天的岁月里,一年两次的软考又要开始了。到目前为止,我已经考了多达三次的软考,最后的结果就是通过了初级考试(程序员)。人啊,就是不满足,考了初级就希望考中级,于是,这学期我就报考了中级,明天就要考试。感觉机会不大,期待奇迹发生吧。这个学期忙于练车,写项目,反正最后是一团糟。后天还要考试科目二。这个星期真的是很艰难的一周,希望能快点度过。

linux系统中用pkill踢出在线登录用户

被触发

linux

由于linux服务器允许多用户登录,公司很多人知道密码,工作造成一定的障碍所以需要有时踢出指定的用户

1/#who 查出当前有那些终端登录(用 w 命令更详细)

# who

root pts/0 2010-10-28 09:36 (192

仿QQ聊天第二版

肆无忌惮_

qq

在第一版之上的改进内容:

第一版链接:

http://479001499.iteye.com/admin/blogs/2100893

用map存起来号码对应的聊天窗口对象,解决私聊的时候所有消息发到一个窗口的问题.

增加ViewInfo类,这个是信息预览的窗口,如果是自己的信息,则可以进行编辑.

信息修改后上传至服务器再告诉所有用户,自己的窗口

java读取配置文件

知了ing

1,java读取.properties配置文件

InputStream in;

try {

in = test.class.getClassLoader().getResourceAsStream("config/ipnetOracle.properties");//配置文件的路径

Properties p = new Properties()

__attribute__ 你知多少?

矮蛋蛋

C++ gcc

原文地址:

http://www.cnblogs.com/astwish/p/3460618.html

GNU C 的一大特色就是__attribute__ 机制。__attribute__ 可以设置函数属性(Function Attribute )、变量属性(Variable Attribute )和类型属性(Type Attribute )。

__attribute__ 书写特征是:

jsoup使用笔记

alleni123

java 爬虫 JSoup

<dependency>

<groupId>org.jsoup</groupId>

<artifactId>jsoup</artifactId>

<version>1.7.3</version>

</dependency>

2014/08/28

今天遇到这种形式,

JAVA中的集合 Collectio 和Map的简单使用及方法

百合不是茶

list map set

List ,set ,map的使用方法和区别

java容器类类库的用途是保存对象,并将其分为两个概念:

Collection集合:一个独立的序列,这些序列都服从一条或多条规则;List必须按顺序保存元素 ,set不能重复元素;Queue按照排队规则来确定对象产生的顺序(通常与他们被插入的

杀LINUX的JOB进程

bijian1013

linux unix

今天发现数据库一个JOB一直在执行,都执行了好几个小时还在执行,所以想办法给删除掉

系统环境:

ORACLE 10G

Linux操作系统

操作步骤如下:

第一步.查询出来那个job在运行,找个对应的SID字段

select * from dba_jobs_running--找到job对应的sid

&n

Spring AOP详解

bijian1013

java spring AOP

最近项目中遇到了以下几点需求,仔细思考之后,觉得采用AOP来解决。一方面是为了以更加灵活的方式来解决问题,另一方面是借此机会深入学习Spring AOP相关的内容。例如,以下需求不用AOP肯定也能解决,至于是否牵强附会,仁者见仁智者见智。

1.对部分函数的调用进行日志记录,用于观察特定问题在运行过程中的函数调用

[Gson六]Gson类型适配器(TypeAdapter)

bit1129

Adapter

TypeAdapter的使用动机

Gson在序列化和反序列化时,默认情况下,是按照POJO类的字段属性名和JSON串键进行一一映射匹配,然后把JSON串的键对应的值转换成POJO相同字段对应的值,反之亦然,在这个过程中有一个JSON串Key对应的Value和对象之间如何转换(序列化/反序列化)的问题。

以Date为例,在序列化和反序列化时,Gson默认使用java.

【spark八十七】给定Driver Program, 如何判断哪些代码在Driver运行,哪些代码在Worker上执行

bit1129

driver

Driver Program是用户编写的提交给Spark集群执行的application,它包含两部分

作为驱动: Driver与Master、Worker协作完成application进程的启动、DAG划分、计算任务封装、计算任务分发到各个计算节点(Worker)、计算资源的分配等。

计算逻辑本身,当计算任务在Worker执行时,执行计算逻辑完成application的计算任务

nginx 经验总结

ronin47

nginx 总结

深感nginx的强大,只学了皮毛,把学下的记录。

获取Header 信息,一般是以$http_XX(XX是小写)

获取body,通过接口,再展开,根据K取V

获取uri,以$arg_XX

&n

轩辕互动-1.求三个整数中第二大的数2.整型数组的平衡点

bylijinnan

数组

import java.util.ArrayList;

import java.util.Arrays;

import java.util.List;