hadoop细节---Mapreduce过程详解

一.先回顾一下hadoop api中的数据类型:

BooleanWritable:标准布尔型数值

ByteWritable:单字节数值

DoubleWritable:双字节数值

FloatWritable:浮点数

IntWritable:整型数

LongWritable:长整型数

Text:使用UTF8格式存储的文本(类似java中的string)

NullWritable:当

二.Map-Reduce执行过程:

1.Job类初始化JobClient实例,JobClient中生成JobTracker的RPC实例,这样可以保持与JobTracker的通讯,JobTracker的地址和端口等都是外部配置的,通过Configuration对象读取并且传入。

2.JobClient提交作业。

3.JobClient生成作业目录。

4.从本地拷贝MapReduce的作业jar文件(一般是自己写的程序代码jar)。

5.如果DistributedCache中有需要的数据,从DistributedCache中拷贝这部分数据。

6.根据InputFormat实例,实现输入数据的split,在作业目录上生成job.split和job.splitmetainfo文件。

7.将配置文件写入到作业目录的job.xml文件中。

8.JobClient和JobTracker通讯,提交作业。

9.JobTracker将job加入到job队列中。

10.JobTracker的TaskScheduler(任务调度器)对job队列进行调度。

11.TaskTracker通过心跳和JobTracker保持联系,JobTracker收到后根据心跳带来的数据,判断是否可以分配给TaskTracker Task,TaskScheduler会对Task进行分配。

12.TaskTracker启动TaskRunner实例,在TaskRunner中启动单独的JVM进行Mapper运行。

13.Map端会从HDFS中读取输入数据,执行之后Map输出数据先是在内存当中,当达到阀值后,split到硬盘上面,在此过程中如果有combiner的话要进行combiner,当然sort是肯定要进行的。

14.Map结束了,Reduce开始运行,从Map端拷贝数据,称为shuffle阶段,之后执行reduce输出结果数据。

15.当jobtracker收到作业最后一个任务完成通知后,便把作业的状态设置为“完成”。

16.在jobclient查询状态时,便知道任务已经完成,于是从runjob()方法返回。

三.Map端机制:

自定义一个类,继承于基类Mapper,该基类是一个泛型,有4个形参类型:用来指定map函数的输入键、输入值,输出键、输出值,如下public class Map extends Mapper

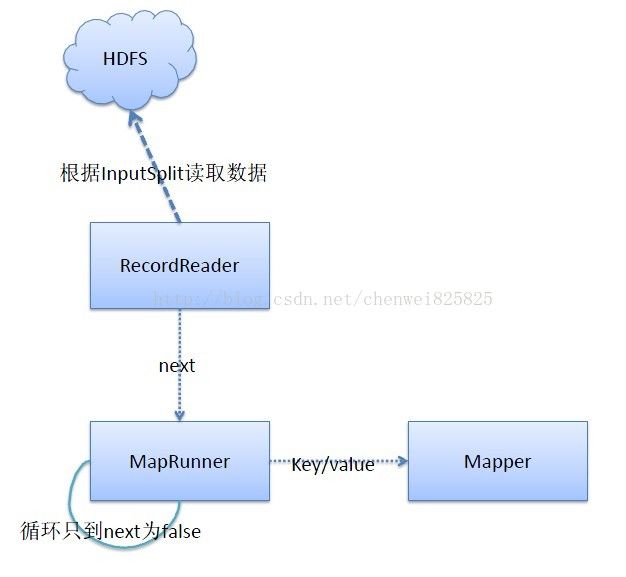

(一)map输入做的事:

1.反射构造InputFormat.

2.反射构造InputSplit.

3.创建RecordReader.

4.反射创建MapperRunner

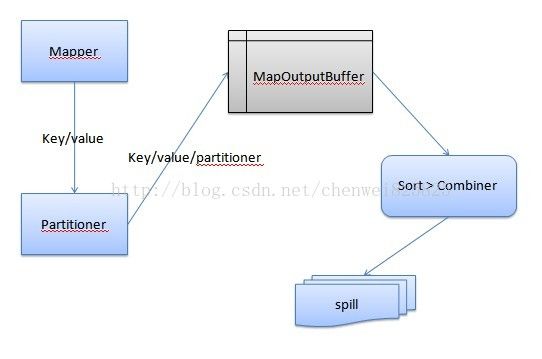

(二)map输出做的事:

1.如果有Partitioner的话,反射构造Partitioner。

2.将key/value/Partitioner数据写入到内存当中。

3.当内存当中的数据达到一定阀值了,需要spill到硬盘上面,在spill前,需要进行排序,如果有combiner的话需要进行combiner。

4.sort的规则是先进行Partitioner的排序,然后再进行key的字典排序,默认的是快速排序。

5.当生成多个spill文件时,需要进行归并,最终归并成一个大文件。

关于排序:

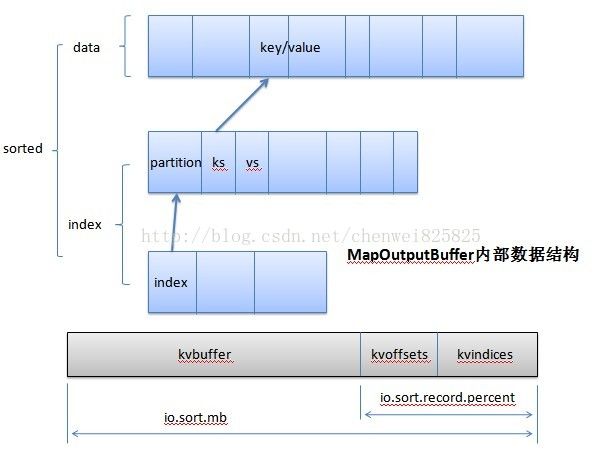

1.在内存中进行排序,整个数据的内存不会进行移动,只是再加上一层索引的数据,排序只要调整索引数据就可以了

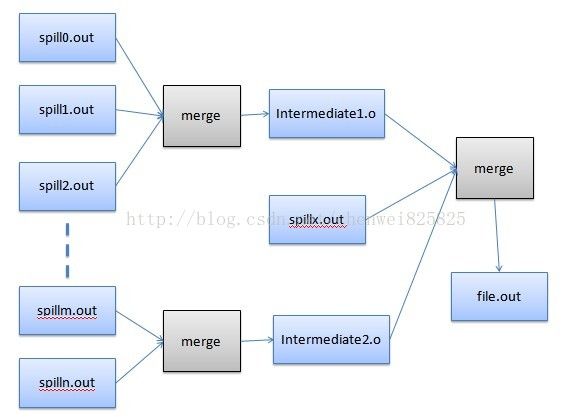

2.多个spill文件归并到一个大文件时,是一个归并排序的过程,每一个spill文件都是按分区和key排序好的,所以归并完的文件也是按分区和key排序好的。

在进行归并的时候,也不是一次性的把所有的spill文件归并成一个大文件,而是部分spill文件归并成中间文件,然后中间文件和剩下的spill文件再进行一次归并,依次类推,这个的考虑还是因为一次归并文件太多的话IO消耗太大了,如下图:

四.Reduce端机制:

自定义一个类,继承于基类Reducer,该基类是一个泛型,有4个形参类型:用来指定reduce函数的输入键、输入值,输出键、输出值、

public class Reduce extends Reducer

(一)reduce输入做的事:

1。ReduceTask有一个线程和TaskTracker联系,之后TaskTracker和JobTracker联系,获取MapTask完成事件

2. ReduceTask会创建和MapTask数目相等的拷贝线程,用于拷贝MapTask的输出数据,MapTask的数据一般都是非本地的

3. 当有新的MapTask完成事件时,拷贝线程就从指定的机器上面拷贝数据,是通过http的形式进行拷贝

4. 当数据拷贝的时候,分两种情况,当数据量小的时候就会写入内存当中,当数据量大的时候就会写入硬盘当中,这些工作分别由两个线程完成

5. 因为所有的数据都来自不同的机器,所以有多个文件,这些文件需要归并成一个文件,在拷贝文件的时候就会进行归并动作

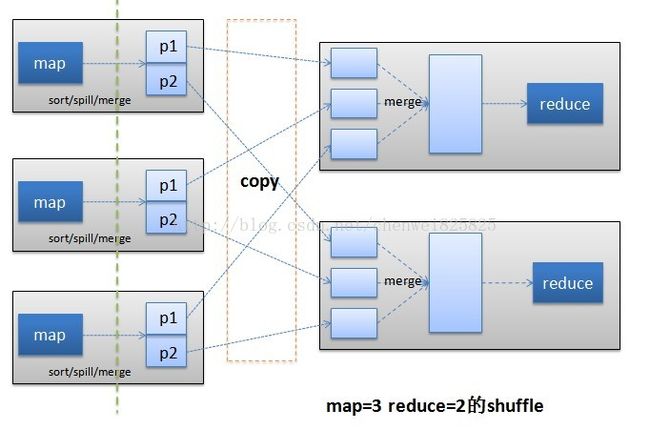

6. 拷贝和归并过程统称为shuffle过程。

(二)Reduce输出做的事:

1.构造RecordWriter,这个是根据客户端设置的OutputFormat中getRecordWriter()方法得到

2.通过OutputFormat和RecordWriter将结果输出到临时文件中

3.Rudece进行commit过程,和TaskTracker进行通信,TaskTracker和JobTracker进行通信,然后JobTracker返回commit的指令,Reduce进行

commit,将临时结果文件重命名成最终的文件

4.commit成功后,kill掉其他的TaskAttempt

五.主函数(作业的配置方法):

publicstatic void main(String[] args) throws Exception{

Configuration conf = newConfiguration();

String[]otherArgs = new GenericOptionsParser(conf,args).getRemainingArgs();

if(otherArgs.length != 2) {

System.err.println("Usage:Data **

System.exit(2);

}

Jobjob = new Job(conf, "**");

job.setJarByClass(**.class);

/ /设置Map和Reduce处理类

job.setMapperClass(Map.class);

//job.setCombinerClass(IntSumReducer.class);

job.setReducerClass(Reduce.class);

//设置输出类型

job.setOutputKeyClass(IntWritable.class);

job.setOutputValueClass(IntWritable.class);

//设置输入和输出目录

FileInputFormat.addInputPath(job,new Path(otherArgs[0]));

FileOutputFormat.setOutputPath(job,new Path(otherArgs[1]));

System.exit(job.waitForCompletion(true)? 0 : 1);

}