Jeff Dean执笔:一文看尽2018谷歌AI重大突破

对于谷歌的研究团队来说,2018年是令人兴奋的一年。Google Research通过多种方式推动技术研究工作,包括基础计算机科学研究成果和出版物,以及多项研究被应用在谷歌的新兴领域(如医疗保健和机器人)、开源软件贡献,以及与谷歌产品团队的密切合作,所有这些都旨在提供有用的工具和服务。

接下来,我们将重点介绍谷歌研究院在2018年所做的一些工作。

道德和AI

在过去几年中,我们看到了AI的重大进步,以及这些进步为我们的产品和数十亿用户日常生活带来的积极影响。我们深切地希望AI能够造福我们的世界,并且能够充分遵守道德原则,帮助我们解决对社会有益的问题。今年,我们发布了“谷歌AI原则”(https://ai.google/principles/ ),并提供了一系列实践支持,其中概述了用于实现AI的技术建议。总的来说,它们为评估我们的AI开发提供了一个框架,我们希望其他组织也能够使用这些原则来帮助他们塑造自己的思维。

值得注意的是,由于这一领域的发展非常迅速,随着我们和其他人在ML公平性和模型可解释性等领域进行新的研究,原则中提到的一些最佳实践,如“避免创建或加强不公平的偏见”或“对人类负责”,也在不断变化和改进。这项研究反过来促进了我们的产品的进步,使其更具包容性并减少偏见,例如我们在谷歌翻译中减少性别偏见,并允许探索和发布更具包容性的图像数据集和模型,让计算机视觉推动全球文化的多样性。此外,我们借助这项工作与广泛的研究社区分享一些最佳实践,例如机器学习速成课程中的公平模块。

AI和社会公益

AI将对社会多个领域产生巨大的潜在影响,这是显而易见的。应用AI来解决现实问题的一个例子是我们在洪水预测方面所做的工作。我们与谷歌的其他多个团队合作,旨在及时提供发生洪灾的可能性和受灾范围的准确信息,让洪灾易发地区的人们能够更好地决定如何最好地保护自己和他们的财产。

第二个例子是我们关于地震余震预测的工作。我们展示了一个机器学习模型,它可以比传统的基于物理的模型更准确地预测余震位置。更重要的是,因为ML模型的设计是可解释的,科学家们已经能够对余震的行为做出新的发现,所以不仅可以得到更准确的预测,而且可以达到新的理解水平。

我们还看到了大量的外部参与者,他们与谷歌研究人员和工程师合作,使用TensorFlow等开源软件来解决各种科学问题和社会问题,例如使用卷积神经网络识别座头鲸呼叫、检测新的系外行星、识别患病的木薯植物,等等。

为了促进这一领域的创新活动,我们与google.org合作发布了“Google AI for Social Impact Challenge”,个人和组织可以从总计2500万美元的资金中获得资助,以及来自谷歌研究科学家的指导和建议。

辅助技术

我们的大部分研究都集中在使用ML和计算机科学来帮助用户更快更有效地完成任务。通常,这涉及到与各种产品团队合作,以便将研究成果应用在各种产品中。其中的一个例子是Google Duplex(https://ai.googleblog.com/2018/05/duplex-ai-system-for-natural-conversation.html ),这个系统涉及了多项技术,包括自然语言处理和对话理解、语音识别、文本到语音转换、用户理解和有效的UI设计,这样用户就可以说“你能帮我预订今天下午4点钟的理发吗?”,然后一个虚拟代理将通过电话帮你处理其余的事情。

其他例子还包括Smart Compose(https://ai.googleblog.com/2018/05/smart-compose-using-neural-networks-to.html ),一种使用预测模型提供有关如何撰写电子邮件的相关建议、让编辑电子邮件变得更快更容易的工具,以及Sound Search(https://ai.googleblog.com/2018/09/googles-next-generation-music.html ),一种基于Now Playing(https://support.google.com/pixelphone/answer/7535326?hl=en )的技术,让你可以更快更准确地知道正在播放的是什么歌曲。

此外,Android中的Smart Linkify(https://ai.googleblog.com/2018/08/the-machine-learning-behind-android.html )通过设备上的ML模型来了解用户选择的文本类型,然后在手机屏幕上显示对用户来说更有用的文本类型(例如,如果用户选择文本是地址类型,那么就提供这个地址的地图链接)。

我们研究的一个重点是让像谷歌智能助理这样的产品支持更多的语言,并且可以更好地理解语义相似性,即使用户使用了不同的方式来表达相同的概念或想法。这些新功能是基于我们在改进语音合成和文本到语音转换方面的工作。

量子计算

量子计算是一种新兴的计算范式,它承诺能够解决经典计算机无法解决的挑战性问题。在过去的几年中,我们一直在积极从事这方面的研究。我们相信,我们至少在一个问题上已经进入状态(所谓的量子霸权),这将是该领域的一个分水岭事件。在过去的一年里,我们取得了很多令人兴奋的进展,包括开发了一种新的72量子位计算设备Bristlecone。

我们还发布了量子计算机开源编程框架Cirq,并探讨了如何将量子计算机用于神经网络。最后,我们分享了我们在量子处理器性能波动方面的经验和技术,以及如何将量子计算机作为神经网络计算基板的一些想法。我们期待2019年量子计算领域会取得更加令人兴奋的成果!

自然语言理解

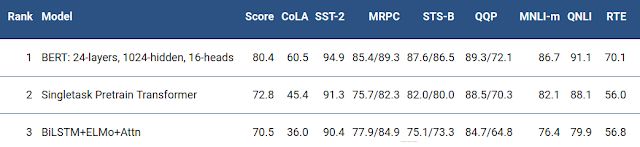

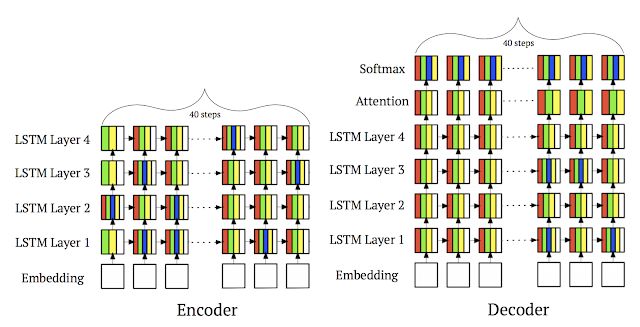

2018年,谷歌在自然语言方面的研究也相当令人振奋,其中包括基础性研究和以产品为中心的合作成果。我们对2017年的Transformer工作进行了改进,得到了一个叫作Universal Transformer的并行版本,在包括翻译和语言推理在内的多个自然语言任务中都显示出巨大的进步。我们还开发了BERT,这是第一个深度双向的无监督语言表示,仅使用纯文本语料库进行预训练,然后通过转移学习对各种自然语言任务进行调优。BERT在11种自然语言任务中比之前的最新成果具有更好的表现。

除了与各种研究团队合作以实现Smart Compose和Duplex之外,我们还努力让谷歌智能助理能够更好地处理多语言,目标是让助理能够自然地与用户进行对话。

感知研究

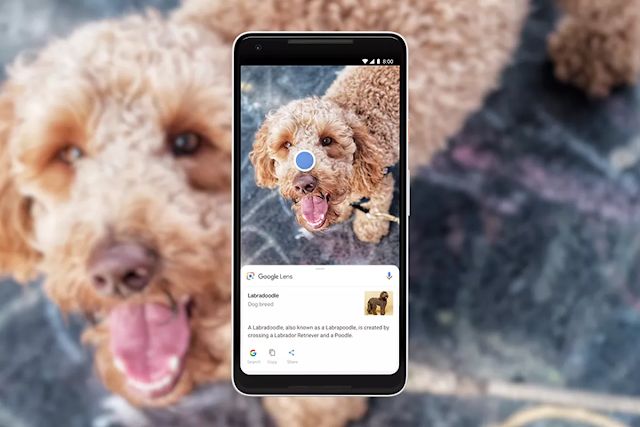

我们的感知研究解决了计算机在理解图像、声音、音乐和视频方面的大难题,并为图像捕获、压缩、处理、创造性表达和增强现实提供了更强大工具。2018年,我们通过技术改进了Google Photos组织用户最关心的内容的能力,例如人和宠物。Google Lens和Google Assistant帮助用户了解自然世界、实时回答用户的问题。谷歌AI的一个关键使命是让人们能够从我们的技术中受益。今年,我们在改进Google API的功能和构建块方面取得了很大进展,包括Cloud ML API中的视觉和视频能力增强和基于ML Kit的面部识别相关的构建块。

2018年,我们在学术研究方面的贡献还包括用于3D场景理解的深度学习,例如立体放大(https://arxiv.org/abs/1805.09817 ),可以合成新型的场景视图。我们在更好地理解图像和视频方面的研究让用户能够在谷歌产品(例如Photos、YouTube、Search等)中查找、组织、增强和改进图像和视频。2018年的一些值得注意的进展还包括一个用于人体关节姿势估计和人体实例分割的模型、一个用于可视化复杂运动的系统、一个用于模拟人与物体之间的时空关系的系统,以及基于蒸馏(distillation)和3D卷积的视频动作识别的改进。

在音频方面,我们提出了一种用于语义音频表示的无监督学习方法,以及对可表达和近似人类的语音合成做出了显著的改进。多模态感知是一个越来越重要的研究课题。“Looking to Listen”(https://ai.googleblog.com/2018/04/looking-to-listen-audio-visual-speech.html )将输入视频中的视觉和听觉因素结合起来,以便隔离和增强视频中发声主体的语音。这项技术可以支持一系列应用,从语音增强和视频识别、视频会议到助听器改进,尤其是在有多人讲话的情况下。

在资源有限的平台上实现感知变得越来越重要。MobileNetV2是谷歌的下一代移动计算机视觉模型,我们的MobileNets被广泛应用于学术界和工业界。MorphNet提出了一种有效的方法来学习深度网络结构,从而能够在计算资源有限的情况下在图像和音频模型上实现全面的性能改进。

计算摄影

在过去几年中,在手机相机的质量和多功能性方面的改进一直值得我们关注。其中一方面是手机使用的物理传感器的改进,另一个主要的方面是计算摄影科学的进步。我们的研究团队发布了他们的新研究技术,并与谷歌Android和消费者硬件团队密切合作,将这项研究应用在最新的Pixel和Android手机及其他设备上。2014年,我们引入了HDR+技术,让镜头捕获图像帧,在软件中对齐帧,并通过计算软件将它们合并在一起。最开始我们是为了让图片具有比单次曝光更高的动态范围。不过,先捕获帧然后对这些帧执行计算分析是一种通用方法,可以在2018年的相机中实现很多高级功能。例如,Pixel 2提供的Motion Photos,以及Motion Stills中的增强现实模式。

2018年,我们在计算摄影方面的主要工作之一是开发了一种叫作Night Sight的新功能,让Pixel手机的摄像头能够“看到黑暗中的东西”,赢得了媒体和用户的赞誉。当然,Night Sight只是我们团队开发的能够帮助用户拍摄完美的照片的众多新功能之一,其他的还包括使用ML提供更好的肖像拍摄模式、使用Super Res Zoom进行进一步的取景,以及使用Top Shot和Google Clips捕捉精彩的瞬间。

算法与理论

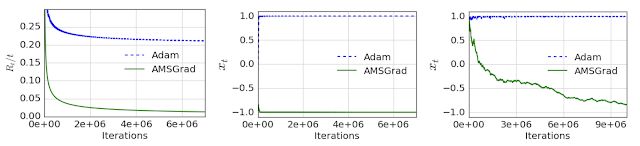

算法是谷歌系统的核心,触及我们所有的产品,从Google Trips背后的路由算法到谷歌云的一致性哈希算法。在过去的一年中,我们继续研究算法和理论,涵盖了从理论基础到应用算法、从图形挖掘到隐私保护计算等领域。在优化算法方面,我们的工作涉及从研究机器学习的持续优化到分布式组合优化。在机器学习的持续优化方面,我们在训练神经网络随机优化算法收敛性(获得ICLR 2018年最佳论文奖)方面的研究揭示了基于梯度的优化方法(例如ADAM的一些变体)存在的问题,同时为提出基于梯度的新优化方法奠定了基础。

在分布式优化方面,我们致力于改进组合优化问题的通用性和通信复杂性。在其他应用方面,我们开发了一些算法,例如,通过草拟覆盖大规模数据集,对具有数万亿条边的图进行平衡分区和层次聚类。我们在线交付服务方面的工作获得WWW2018最佳论文奖。最后,我们的开源优化平台OR-tools在2018年Minizinc约束编程竞赛中获得了4枚金牌。

在算法选择理论方面,我们提出了新的模型,并研究了重建和学习多项分对数混合的问题。我们还研究了可通过神经网络学习的函数类,以及如何使用机器学习来改进经典的在线算法。

在谷歌,保证学习技术的严格私密性对我们来说非常重要。我们开发了两种新方法来分析如何通过迭代和重排来放大隐私差异。我们还应用差异隐私技术来设计在游戏方面具有健壮性的激励感知学习方法。这种学习技术在高效的在线市场设计中得到了应用。我们在市场算法领域的新研究还包括帮助广告客户测试广告竞价的激励兼容性,以及针对应用内广告的优化技术。我们还进一步推动了重复竞价方面最先进的动态机制的边界,提出了强大的动态竞价。最后,在在线优化和在线学习的健壮性方面,我们开发了新的用于流量峰值时刻的随机输入的在线分配算法,以及对损坏的数据具有健壮性的新强盗算法。

软件系统

我们对软件系统的大部分研究仍然与构建机器学习模型和TensorFlow有关。例如,我们发布了TensorFlow 1.0的动态控制流程。我们的一些新研究引入了一个叫作Mesh TensorFlow的系统,可以很容易地指定具有模型并行性的大规模分布式计算,还支持数十亿个参数。另外,我们还发布了一个可扩展的深度神经排序库。

我们还发布了JAX,这是NumPy的一个变体。虽然JAX不是TensorFlow的一部分,但它利用了一些相同的底层软件基础设施(例如XLA),并且它的一些想法和算法对我们的TensorFlow项目有所帮助。最后,我们继续研究机器学习的安全性和隐私性,并开发AI系统的安全和隐私开源框架,如CleverHans和TensorFlow Privacy。

对我们来说,另一个重要的研究方向是将ML应用于软件系统。例如,我们继续研究如何将带有层次模型的计算移到设备上,并在学习内存访问模式方面做出了一些贡献。我们还继续探索如何使用学习索引来取代数据库系统和存储系统中的传统索引结构。

2018年,Spectre和Meltdown是在现代计算机处理器中出现的新型安全漏洞。在我们继续努力模拟CPU的行为时,我们的编译器研究团队将他们用于测量机器指令延迟和端口压力的工具集成到LLVM中,从而可以做出更好的编译决策。

谷歌产品、我们的云产品和机器学习模型推理严重依赖于为计算、存储和网络提供大规模、可靠、高效的技术基础设施的能力。过去一年的一些研究亮点包括谷歌软件定义网络WAN的发展——这是一个独立的联合查询处理平台,可以在很多存储系统(BigTable、Spanner、Google Spreadsheets等)中针对基于不同文件格式的数据执行SQL查询,以及我们的代码评审报告——调查谷歌代码评审背后的动机、当前实践以及开发人员的满意度和面临的挑战。

运行一个托管内容的大型Web服务需要在动态环境中实现稳定的负载均衡。我们开发了一致性哈希方案,可以保证每台服务器具有最大的负载,并将其部署到Google Cloud Pub/Sub中。Vimeo的工程师找到了我们发布的早期论文,在haproxy中实现了这个方案,然后将其开源(https://github.com/arodland/haproxy/commit/b02bed24daf64743cb9a571e93ed29ee4bc7efe7 ),并将其用于Vimeo的负载均衡项目中。结果很是令人感到兴奋,这些算法帮助他们将缓存带宽减少了近8倍,同时消除了缩放瓶颈。

AutoML

AutoML,也称为元学习,即通过机器学习来自动化机器学习。多年来,我们一直在研究这个领域,我们的长期目标是开发出可以利用从之前已解决的其他问题中得出的见解和能力来找出新问题并自动解决问题的系统。我们在这个领域的早期工作主要使用强化学习,但我们对使用进化算法也很感兴趣。

去年,我们展示了如何使用进化算法自动发现各种视觉任务的神经网络架构。我们还探讨了如何将强化学习应用于除神经网络架构搜索之外的其他问题。我们的工作表明,它可以被用于自动生成图像变换序列,用以提高各种图像模型的准确性,以及找到新的符号优化表达式,比常用的优化更新规则更有效。我们在AdaNet方面的工作展示了如何拥有一个具有学习保证的快速灵活的自动算法。

我们的另一个重点是自动发现计算效率高的神经网络架构,这样它们就可以在移动电话或自动驾驶汽车上运行,这些环境对计算资源或推理时间有严格的限制。我们的工作表明,在强化学习架构搜索的奖励函数中将模型的准确性与其推理计算时间相结合,就可以找到高度准确的模型,同时满足特定的性能约束。我们还探索了使用ML来学习自动压缩ML模型,以便可以使用更少的参数和更少的计算资源。

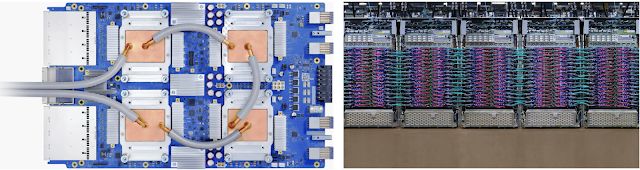

TPU

张量处理单元(简称TPU)是谷歌公司内部开发的一种ML硬件加速器,其自设计之初就专门用于执行大规模训练与推理任务。TPU帮助谷歌公司实现了研究层面的一系列突破,包括之前已经讨论过的BERT。此外,其还使得世界各地的研究人员能够以开源方式享受谷歌研究带来的成果,并以此为基础寻求新的突破。例如,任何人都可以免费通过Colab对运行在TPU之上的BERT进行微调,而TensorFlow Research Cloud则让成千上万研究人员有机会在规模更为可观的免费云TPU计算能力当中受益。

我们还对TPU硬件进行了多次迭代,并将其以云TPU的形式推向商用——其中包括Cloud TPU Pod机器学习超级计算机,旨在显著降低大规模ML训练的难度。着眼于谷歌内部,除了在机器学习研究领域实现更快进步之外,TPU还给谷歌公司的一系列核心产品带来重大改进,包括搜索引擎、YouTube、Gmail、谷歌智能助手以及谷歌翻译等等。我们期待看到谷歌以及来自其它方面的机器学习团队,能够利用TPU提供的前所未有的计算规模在机器学习领域带来更多斩获。

开源软件与数据集

在与研究以及软件工程社区开展协作的过程当中,发布开源软件与建立新的公共数据集一直是我们两大最主要的贡献方式。我们在这一领域中最为显著的成果之一正是TensorFlow,这是我们于2015年11月发布、目前得到广泛流行的机器学习计算系统。我们在2018年庆祝了TensorFlow项目的三周岁生日,在此期间其被下载超过3000万次,并有超过1700名贡献者为其带来4万5千多次commit。

回顾2018年,TensorFlow先后迎来八个主要版本,同时增加了多项重要功能——例如急切执行以及分发策略等。我们在开发过程当中还启动了社区公众设计评审机制,并以特殊兴趣小组的形式吸纳更多贡献者。随着TensorFlow Lite、TensorFlow.js以及TensorFlow Probability等相关产品的推出,整体TensorFlow生态系统都在2018年得到大幅成长。

我们很高兴地看到,TensorFlow在全部顶级机器学习与深度学习框架当中,拥有着最强大的Github用户保留率与吸引力。TensorFlow团队还致力于快速解决Github问题,并为外部贡献者提供顺畅的参与途径。根据Google Scholar统计的数据,在研究过程当中,我们不断在已发表论文的基础之上为全世界大部分机器学习与深度学习研究提供支持。

TensorFlow Lite在面世的短短一年之后,目前已经被安装在全球超过15亿台设备上。此外,TensorFlow.js则成为JavaScript中的头号机器学习框架;其推出刚刚9个月,就在内容交付网络(简称CSN)上得到200多万次点击与25万次下载,并在Github上获得超过1万颗星。

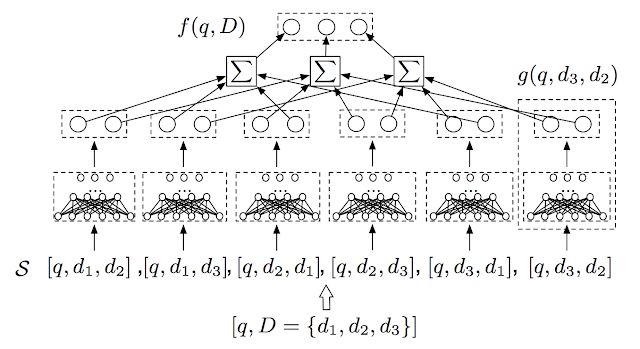

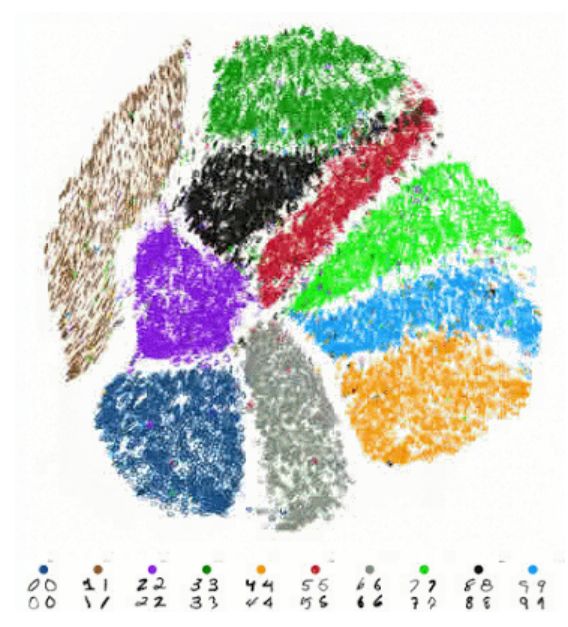

除了继续开发现有开源生态系统之外,我们在2018年还引入了一套新的框架,用于实现灵活且可重复的强化学习能力、建立新的可视化工具、快速了解数据集中存在的种种特征(而无需编写任何代码)、新增一套用于表达排名学习问题的高级库(这类问题旨在以最符合列表效能需求的方式对其中的条目进行排序,这种能力对于搜索引擎、推荐系统、机器翻译以及对话系统乃至计算生物学等领域都有着重要意义)、发布了一套快速灵活且具有学习保证的AutoML解决方案框架、利用TensorFlow.js构建一套浏览器内置实时t-SNE可视化库,同时添加了能够与电子医疗数据对接的FHIR工具与软件(在本文的医疗保健部分做出详尽说明)。

演示链接:https://nicola17.github.io/tfjs-tsne-demo/

公共数据集通常能够成为激发灵感的重要基础,并凭借着为更广泛的社区带来大量有趣数据及问题的方式,帮助来自多个领域的研究人员取得巨大进步。此外,公共数据集还能够激发人们在不同任务当中获得更佳成绩的热情,从而保证相关社区拥有健康的竞争态势。

2018年,我们很高兴地发布了Google Dataset Search,这是一款从全部网络当中查找公共数据集的新工具。多年以来,我们一直在策划及发布各类具有创新性的数据集,包括大量注释图像或视频、用于语音识别的孟加拉地区人群数据集,乃至机械手臂抓取数据集等等。2018年,我们继续向这一重要储备添加更多数据集资源。

我们还发布了Open Images V4,这套数据集包含1540万个边框(对应190万张图片上的600种对象类别)以及3010万个归属于19794种类别的人工验证图像级标签。此外,我们通过使用crowdsource.google.com从世界各地的数万名用户处获得了550万条注释,希望向其中引入来自世界各地的更多人群与场景,从而扩展这套数据集的规模水平。

我们也发布了Atomic Visual Actions(简称AVA)数据集,其负责为视频内容提供视听注释,从而改善对人类行为的理解以及对视频语音的处理能力。我们还更新了YouTube-8M,并举办第二届YouTube-8M大规模视频理解挑战赛与研讨会。我们的HDR+ Burst Photography数据集主要用于实现计算摄影领域的各项研究,而Google-Landmarks则是另一套新型数据集,用于解决地标识别方面的种种挑战。

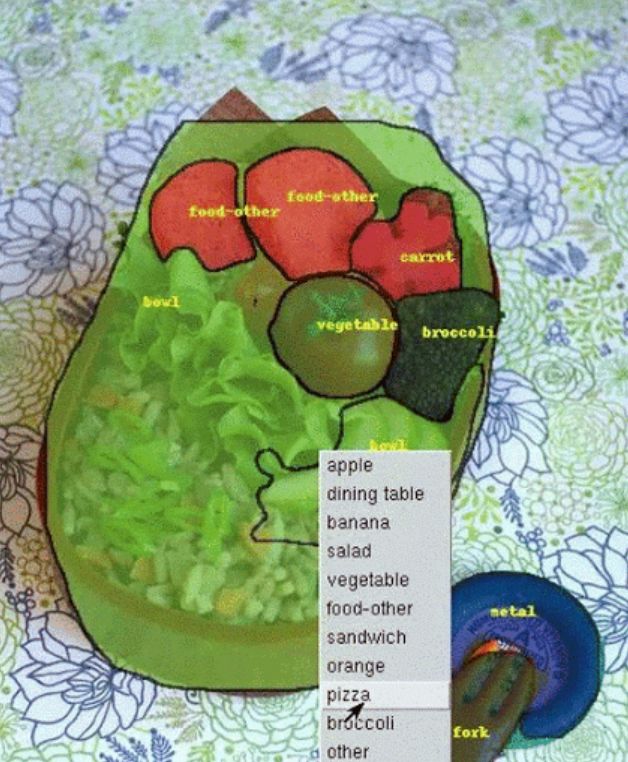

在具体数据集之外,我们还在Fluid Annotation项目中进行了一系列探索,相关技术成果能够加快数据集的创建与可视化速度。Fluid Annotation是一种探索性机器学习驱动接口,能够更快地对图像内容进行注释。

我们还不时帮助研究界发现新的挑战方向,从而确保双方共同努力以解决棘手的研究问题。这方面工作通常是通过发布新型数据集实现的,但也存在不少例外。

今年,我们围绕包容性图像难题组织了新的挑战赛,致力于开发出更强大的模型以避免各类偏见问题。iNaturalist 2018挑战赛旨在使计算机能够更细致地区分视觉对象的类别(例如图片当中特定植物的种类)。Kaggle “Quick,Draw!”涂鸦识别挑战赛希望建立起更出色的涂鸦内容分类器。而Conceptual Captions作为一套大规模图像捕捉数据集也有了自己的挑战赛,旨在进一步推动图像字幕模型的研究工作。

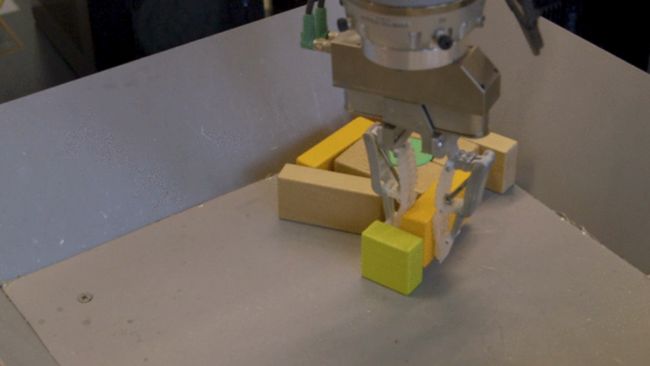

机器人

2018年,我们在理解机器学习技术如何教授机器人在真实环境当中行动以及教授机器人操作新物体方面迎来了新的里程碑(CoRL’18最佳系统论文)以及重大的应用级进展。机器人能够在无需人为监督的情况下凭借机器学习理解物体性状。

此外,我们还将机器学习与基于采样的方法相结合(ICRA’18服务机器人最佳论文)以研究机器人行动,同时探索机器人几何学以加快这种行动掌握速度。我们在确保机器人以自主方式观察并感知环境结构方面取得了重大进展。我们第一次能够在真实的机器人设备上成功实现深层强化学习模型的在线训练,并开始寻找新的、基础性理论方法,从而真正为机器人带来稳定的控制学习能力。

人工智能在其它领域的应用

2018年,我们将机器学习技术应用于物理以及生物科学当中的诸多问题。利用机器学习技术,我们可以为科学家提供相当于数百甚至数千名研究助理的数据挖掘能力,从而显著提升科学家们的创造力与生产力水平。

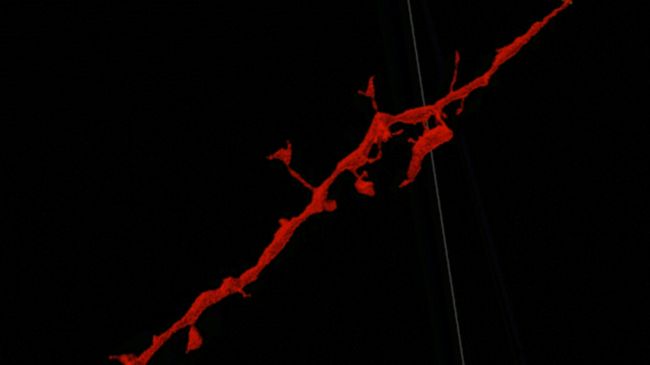

我们在《自然——方法学》杂志上发布的神经元高精度自动重建论文中提出了一种新的模型,该模型能够将原有深度学习技术中的连通组数据自动解释在准确性层面提高一个数量级。

机器学习在科学领域的其它应用案例还包括:

通过数据挖掘汇总星体的光线曲线,从而在太阳系之外寻找新的行星

识别短DNA序列的起源或功能

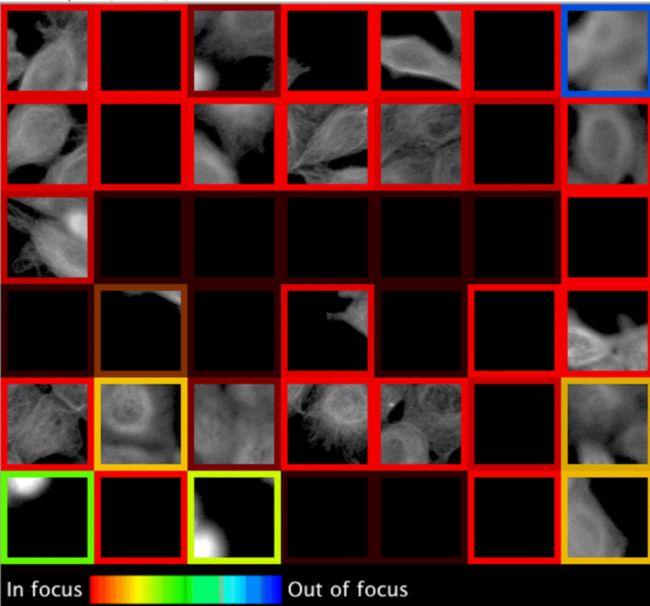

自动检测失焦显微镜图像

以数字化方式创建具有多个染色特征的同类细胞图像

自动将质谱输出结果映射为肽链

健康

过去几年以来,我们一直致力于将机器学习技术应用于健康领域——这一领域直接影响到我们每一个人,我们也坚信机器学习将能够在健康行业中显著增强医疗专业人员的直觉与经验,最终为人类的生活质量带来巨大提升。在这一领域,我们采取的常规方法是同医疗保健组织建立合作以解决各项基础研究问题(利用临床专家的反馈支持我们的研究结果),而后将结果发表在声誉卓著且需要经过同行评审的科学与临床期刊上。

一旦研究结果得到临床与科学验证,我们下一步将进行用户与HCI研究,以了解应该如何将其实际部署在临床环境当中。2018年,我们在计算机辅助的广阔空间中进一步扩展了研究范围,希望将计算机辅助诊断打造成临床流程中的全新组成部分。

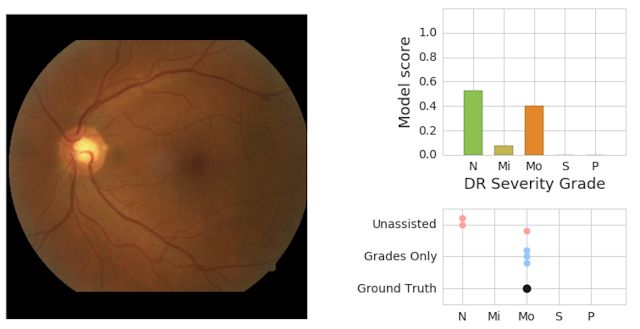

2016年年底,我们发表的一项研究结果表明,一套通过评估视网膜眼底图像检测糖尿病视网膜病变迹象的模型在具体成效方面,完全能够等同甚至略优于美国医疗委员会认证眼科医师。在2018年,我们更进一步,得以通过使用眼科专家标记的训练图像配合最终裁定诊断结果(由多位视网膜专家进行会诊,并对每份眼底图像进行集体评估)证明,我们的模型确实达到了可以与视网膜诊疗专家相媲美的分析水平。

在此之后,我们又发表了一项评估,结果显示眼科医师在使用这套机器学习模型之后,能够得到高于独立判断的诊断准确度。我们与Alphabet的同事们还切实展开合作,共同为印度的Aravind眼科医院以及泰国卫生部附属的Rajavithi医院等十多个机构部署了这种糖尿病视网膜病变检测系统。

除了与眼科专家碰撞出耀眼的火花之外,我们还在医学研究过程中发布了一套新的机器学习模型。该模型能够评估视网膜图像与心血管疾病风险之间的关系。这亦带来了一种新的希望,即通过非侵入性生物标记方式帮助临床医生更好地了解患者的健康状况。

这一年当中,我们也在继续关注病理学领域,包括展示如何利用机器学习改善前列腺癌的分级,通过深度学习技术检测转移性乳腺癌,同时开发出增强现实显微镜原型——可以通过数字图像覆盖的方式帮助病理学家与其他科学家将视觉信息从计算机视觉模型中实时导入至显微镜视野之内。

在过去四年当中,我们进行了大量的研究工作,思考如何利用深度学习技术处理电子健康记录作出临床相关预测。2018年,我们与芝加哥大学医学院、加州大学旧金山分校以及斯坦福医学院合作,在《自然——数字医学》杂志上发表了工作成果,展示如何利用机器学习模型识别电子病历内容,从而为各类临床诊疗提供超越现有最佳实践的有力支持。

作为这项工作中的重要组成部分,我们还开发出一系列工具,使得研究人员能够立足完全不同的任务以及完全不同的基础电子健康记录数据集轻松创建出此类模型。我们还在此项工作当中建立起快速医疗保健互操作性资源(简称FHIR)标准与相关开源软件,希望帮助从业者们以更轻松、更符合行业标准的方式处理医疗数据(请参阅GitHub repo)。

另外,我们还提高了基于深度学习技术的变体调用器DeepVariant的准确度、速度表现与实用性。DeepVariant团队与合作伙伴通力配合,最近亦在《自然——生物技术》杂志上发表了同行评审论文。

在将机器学习技术应用于历史数据收集时,了解以往真实存在的人群结构特征与偏见直接决定着数据的编纂质量。机器学习给我们带来了发现并解决偏见问题的机会,我们也在积极设计谷歌的AI系统以努力推动这种健康与公平的趋势。

研究外展

我们以多种方式与外部研究社区开展交互,包括教师参与与学生支持等形式。我们为谷歌公司能够吸纳数百位本科生、硕士生以及博士生担任实习生,并为来自北美、欧洲以及中东地区的学生们提供多年博士奖学金感到无比自豪。除了财务层面的支持以外,每位奖学金获得者都将拥有一名或者多名谷歌研究人员作为导师。我们将所有研究员汇集在一起,每年组织一次谷歌博士学位奖学金峰会。在这里,他们将接触到谷歌正在进行的最前沿研究项目,并有机会与谷歌内部研究人员以及来自世界各地的其他博士研究员建立联系。

另外,我们还建立起Google Ai Residency项目以作为上述奖学金计划的补充。我们希望通过这样的方式为希望了解深度学习研究的学生提供一年时间,期间他们将与谷歌的研究人员们一道工作并接受指导。今年已经是该项目建立的第三个年头,参与者们在谷歌全球办事处的各个团队当中发挥着自己的作用,并努力探索机器学习、感知、算法与优化、语言理解以及医疗保健等各个领域。此项计划的第四年参加申请刚刚结束,我们很高兴能够在2019年伊始迎来一批充满朝气的新成员。

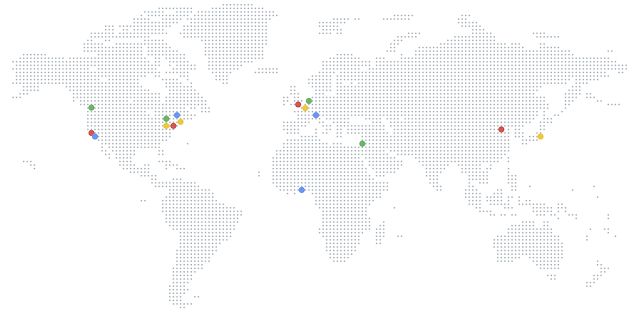

每一年,我们还通过Google Faculty Research Awards计划为众多教师以及学生提供研究项目支持。2018年,我们不断在各谷歌办事处为特定领域的教师及研究生们举办研讨会,包括在印度班加罗尔办事处召开AI/ML研究与实践研讨会,在我们的苏黎世办事处举办算法与优势研讨会,在桑尼维尔举办机器学习医疗保健应用研讨会,以及在马萨诸塞州堪布里奇办事处举办机器学习公平与偏见研讨会等等。

我们相信,为更广泛的研究团队做出公开贡献,正是保持自身研究生态系统健康、高效且富有活力的必要前提。除了我们的开源项目与数据集发布之外,我们的大部分研究结果也都公开发表于顶级大会以及学术期刊当中。我们也积极参与到各类不同学科会议活动的组织与赞助事务中来。我们先后参与了ICLR 2018、NAACL 2018、ICML 2018、CVPR 2018、NeurIPS 2018、ECCV 2018以及EMNLP 2018等会议,这还只是谷歌2018年学术交流经历中的一小部分。此外,谷歌员工还广泛出席了ASPLOS、HPCA、ICSE、IEEE Security \u0026amp; Privacy、OSDI以及SIGCOMM等其它重大会议。

新的环境,新的面孔

2018年,我们骄傲地迎来更多具有广泛背景的新人加入到我们的研究组织当中。我们在加纳阿克拉建立起非洲的第一个人工智能研究办事处。我们扩大了位于巴黎、东京以及阿姆斯特丹的人工智能研究设施,并在普林斯顿开设新的研究实验室。我们持续邀请才华横溢的人们加入我们全球各地的办事机构,您可以在这里了解更多关于加入我们研究工作的详细信息。

展望2019年

这篇博文仅仅对2018年谷歌公司进行的一小部分研究进行了简要总结。回望2018年,我们对我们所取得成就的广度与深度感到兴奋与自豪!着眼于2019年,我们期待着谷歌公司在自身发展方向与产品研发,乃至于更为广泛的科学研究与工程技术领域产生更为重大且深远的影响!

原文链接:

https://ai.googleblog.com/2019/01/looking-back-at-googles-research.html