攻防世界-web-新手练习区(1)

0x01view source

题目

Where is the FLAG

查看页面源代码,但是右键好像不管用了~

writeup

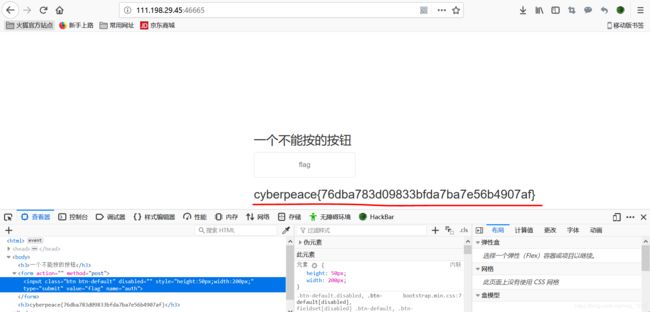

F12查看,发现flag

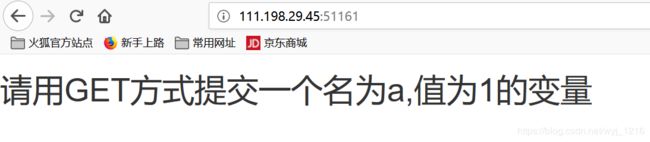

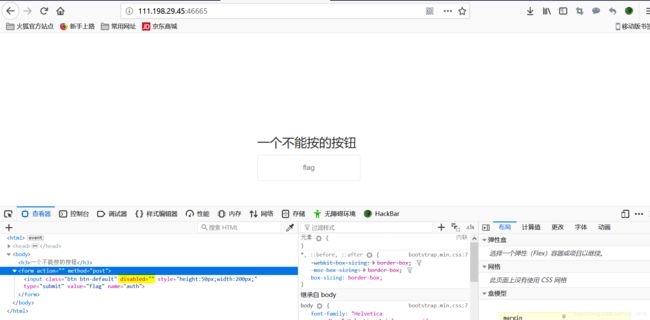

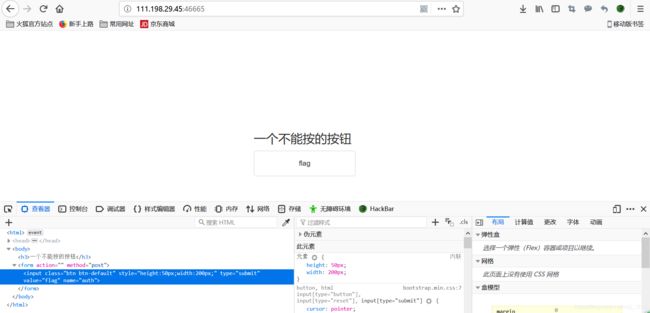

0x02get post

题目

GET&POST

writeup

首先用GET方式提交一个名为a,值为1的变量

在Firefox中,有个很好用的HackBar

知识点

1、HTTP请求方法:

GET、POST、HEAD、OPTION、PUT、DELETE、TRACE、CONNECT

2、HTTP请求报文(GET)

GET / HTTP/1.1

Host: 111.198.29.45:51161

User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:66.0) Gecko/20100101 Firefox/66.0

Accept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8

Accept-Language: zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2

Accept-Encoding: gzip, deflate

Connection: close

Upgrade-Insecure-Requests: 1

Cache-Control: max-age=0

---这里有一个空行---

3、用GET方式提交一个名为a,值为1的变量~

GET /?a=1 HTTP/1.1

Host: 111.198.29.45:51161

User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:66.0) Gecko/20100101 Firefox/66.0

Accept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8

Accept-Language: zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2

Accept-Encoding: gzip, deflate

Connection: close

Upgrade-Insecure-Requests: 1

Cache-Control: max-age=0

---这里有一个空行---

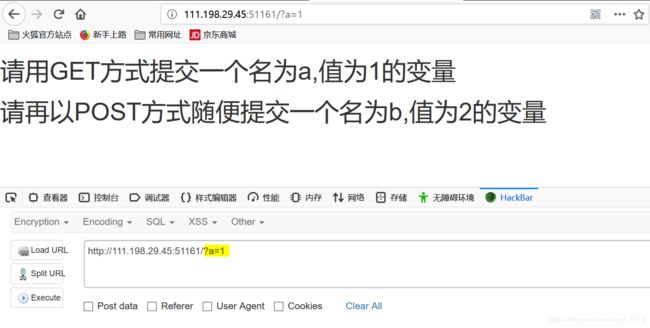

4、以POST方式提交一个名为b,值为2的变量~

POST /?a=1 HTTP/1.1

Host: 111.198.29.45:51161

User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:66.0) Gecko/20100101 Firefox/66.0

Accept: text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8

Accept-Language: zh-CN,zh;q=0.8,zh-TW;q=0.7,zh-HK;q=0.5,en-US;q=0.3,en;q=0.2

Accept-Encoding: gzip, deflate

Content-Type: application/x-www-form-urlencoded

Connection: close

Upgrade-Insecure-Requests: 1

Cache-Control: max-age=0

---这里有一个空行---

b=2

注意~POST与GET有一个明显不同

Content-Type: application/x-www-form-urlencoded //POST中才有~

本题可不用HackBar,利用burpsuit对HTTP的请求报文作如上改动即可

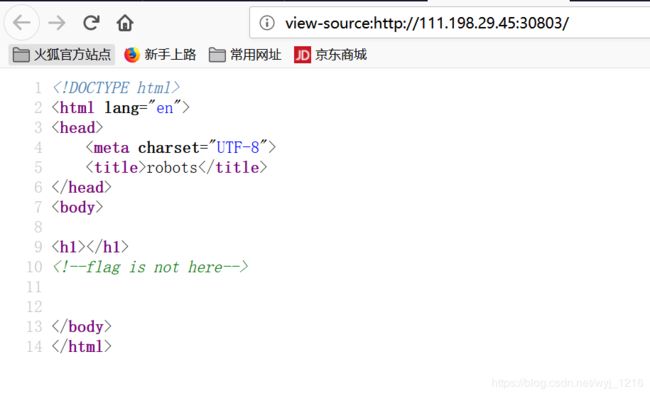

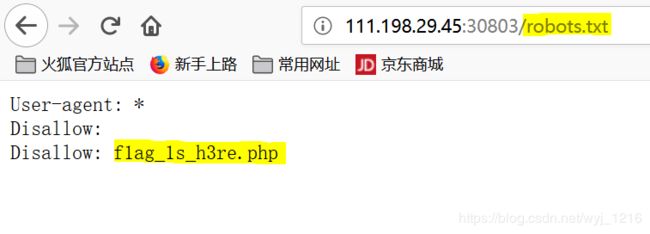

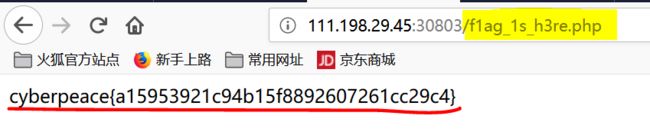

0x03Robots

题目

writeup

查看页面源代码~

于是尝试读取robots.txt

知识点

robots协议

Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。

robots.txt文件是一个文本文件。robots.txt是一个协议,而不是一个命令。robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

当一个搜索蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。

-

文件写法

User-agent: * //这里的*代表的所有的搜索引擎种类,*是一个通配符 Disallow: /admin/ //这里定义是禁止爬寻admin目录下面的目录 Disallow: /require/ //这里定义是禁止爬寻require目录下面的目录 Disallow: /ABC/ //这里定义是禁止爬寻ABC目录下面的目录 Disallow: /cgi-bin/*.htm //禁止访问/cgi-bin/目录下的所有以".htm"为后缀的URL(包含子目录)。 Disallow: /*?* //禁止访问网站中所有包含问号 (?) 的网址 Disallow: /.jpg$ //禁止抓取网页所有的.jpg格式的图片 Disallow:/ab/adc.html //禁止爬取ab文件夹下面的adc.html文件。 Allow: /cgi-bin/ //这里定义是允许爬寻cgi-bin目录下面的目录 Allow: /tmp //这里定义是允许爬寻tmp的整个目录 Allow: .htm$ //仅允许访问以".htm"为后缀的URL。 Allow: .gif$ //允许抓取网页和gif格式图片 Sitemap: 网站地图 //告诉爬虫这个页面是网站地图

禁止所有机器人访问

User-agent: *

Disallow: /

允许所有机器人访问

User-agent: *

Disallow:

禁止特定机器人访问

User-agent: BadBot

Disallow: /

允许特定机器人访问

User-agent: GoodBot

Disallow:

禁止访问特定目录

User-agent: *

Disallow: /images/

仅允许访问特定目录

User-agent: *

Allow: /images/

Disallow: /

禁止访问特定文件

User-agent: *

Disallow: /*.html$

仅允许访问特定文件

User-agent: *

Allow: /*.html$

Disallow: /

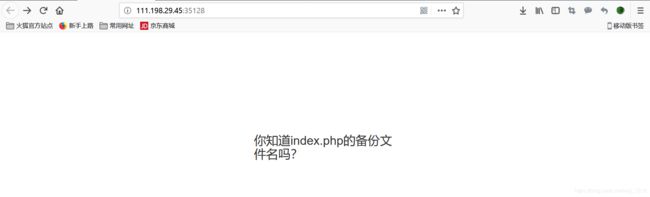

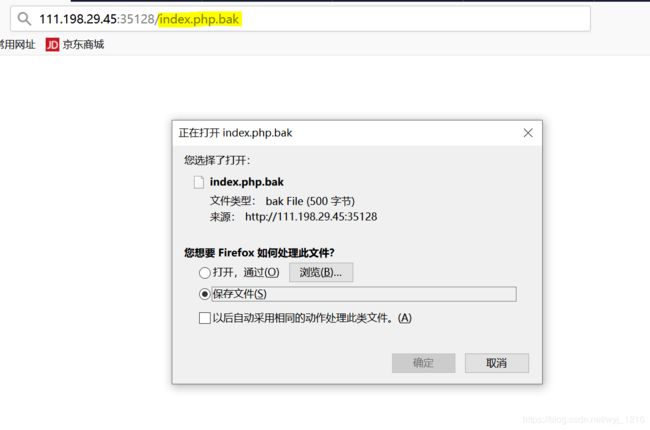

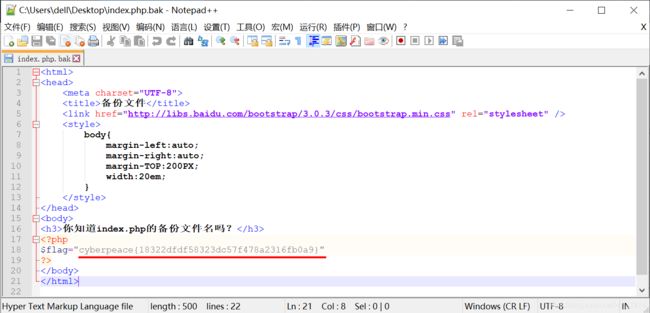

0x04Backup

题目

writeup

根据提示,index.php的备份文件,于是得到index.php.bak

备份文件

你知道index.php的备份文件名吗?

知识点

.php.bak

是在编辑这个文件时,自动生成的备份文件。

如果编辑后没有什么问题,可以删除.BAK文件。

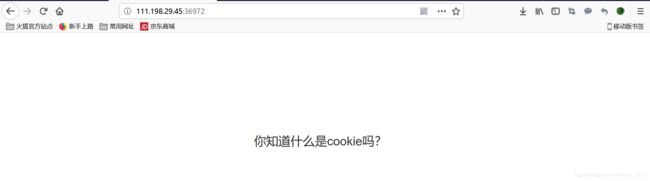

0x05Cookie

题目

writeup

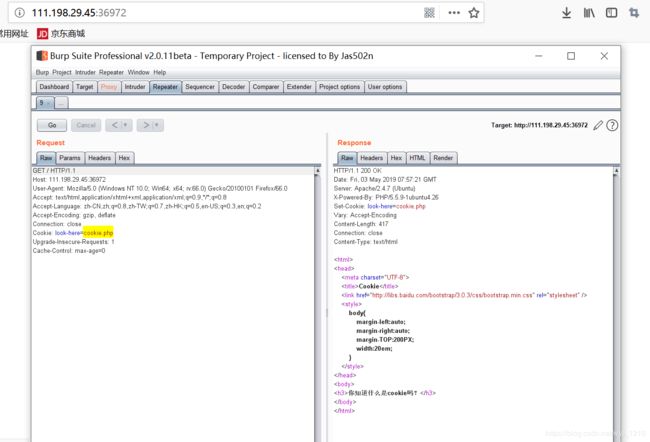

根据提示,利用burpsuit查看cookie

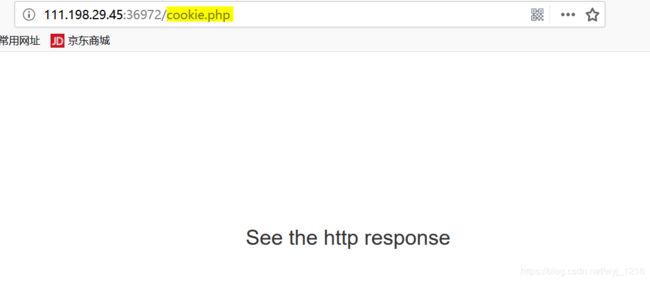

于是,查看cookie.php

于是,查看cookie.php

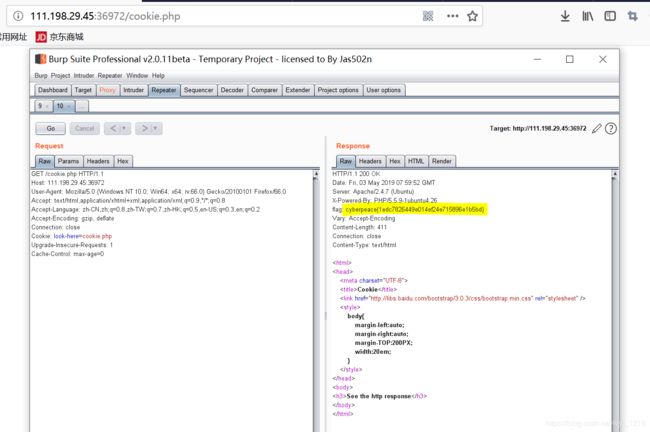

根据提示,再次利用burpsuit查看http response

得到flag~

得到flag~