- Kafka 消息丢失如何处理?

架构文摘JGWZ

学习

今天给大家分享一个在面试中经常遇到的问题:Kafka消息丢失该如何处理?这个问题啊,看似简单,其实里面藏着很多“套路”。来,咱们先讲一个面试的“真实”案例。面试官问:“Kafka消息丢失如何处理?”小明一听,反问:“你是怎么发现消息丢失了?”面试官顿时一愣,沉默了片刻后,可能有点不耐烦,说道:“这个你不用管,反正现在发现消息丢失了,你就说如何处理。”小明一头雾水:“问题是都不知道怎么丢的,处理起来

- 【六】阿伟开始搭建Kafka学习环境

能源恒观

中间件学习kafkaspring

阿伟开始搭建Kafka学习环境概述上一篇文章阿伟学习了Kafka的核心概念,并且把市面上流行的消息中间件特性进行了梳理和对比,方便大家在学习过程中进行对比学习,最后梳理了一些Kafka使用中经常遇到的Kafka难题以及解决思路,经过上一篇的学习我相信大家对Kafka有了初步的认识,本篇将继续学习Kafka。一、安装和配置学习一项技术首先要搭建一套服务,而Kafka的运行主要需要部署jdk、zook

- Java面试题精选:消息队列(二)

芒果不是芒

Java面试题精选javakafka

一、Kafka的特性1.消息持久化:消息存储在磁盘,所以消息不会丢失2.高吞吐量:可以轻松实现单机百万级别的并发3.扩展性:扩展性强,还是动态扩展4.多客户端支持:支持多种语言(Java、C、C++、GO、)5.KafkaStreams(一个天生的流处理):在双十一或者销售大屏就会用到这种流处理。使用KafkaStreams可以快速的把销售额统计出来6.安全机制:Kafka进行生产或者消费的时候会

- Kafka是如何保证数据的安全性、可靠性和分区的

喜欢猪猪

kafka分布式

Kafka作为一个高性能、可扩展的分布式流处理平台,通过多种机制来确保数据的安全性、可靠性和分区的有效管理。以下是关于Kafka如何保证数据安全性、可靠性和分区的详细解析:一、数据安全性SSL/TLS加密:Kafka支持SSL/TLS协议,通过配置SSL证书和密钥来加密数据传输,确保数据在传输过程中不会被窃取或篡改。这一机制有效防止了中间人攻击,保护了数据的安全性。SASL认证:Kafka支持多种

- Kafka详细解析与应用分析

芊言芊语

kafka分布式

Kafka是一个开源的分布式事件流平台(EventStreamingPlatform),由LinkedIn公司最初采用Scala语言开发,并基于ZooKeeper协调管理。如今,Kafka已经被Apache基金会纳入其项目体系,广泛应用于大数据实时处理领域。Kafka凭借其高吞吐量、持久化、分布式和可靠性的特点,成为构建实时流数据管道和流处理应用程序的重要工具。Kafka架构Kafka的架构主要由

- Kafka 基础与架构理解

StaticKing

KAFKAkafka

目录前言Kafka基础概念消息队列简介:Kafka与传统消息队列(如RabbitMQ、ActiveMQ)的对比Kafka的组件Kafka的工作原理:消息的生产、分发、消费流程Kafka系统架构Kafka的分布式架构设计Leader-Follower机制与数据复制Log-basedStorage和持久化Broker间通信协议Zookeeper在Kafka中的角色总结前言Kafka是一个分布式的消息系

- 全面指南:用户行为从前端数据采集到实时处理的最佳实践

数字沉思

营销流量运营系统架构前端内容运营大数据

引言在当今的数据驱动世界,实时数据采集和处理已经成为企业做出及时决策的重要手段。本文将详细介绍如何通过前端JavaScript代码采集用户行为数据、利用API和Kafka进行数据传输、通过Flink实时处理数据的完整流程。无论你是想提升产品体验还是做用户行为分析,这篇文章都将为你提供全面的解决方案。设计一个通用的ClickHouse表来存储用户事件时,需要考虑多种因素,包括事件类型、时间戳、用户信

- Docker安装Kafka和Kafka-Manager

阿靖哦

本文介绍如何通过Docker安装kafka与kafka界面管理界面一、拉取zookeeper由于kafka需要依赖于zookeeper,因此这里先运行zookeeper1、拉取镜像dockerpullwurstmeister/zookeeper2、启动dockerrun-d--namezookeeper-p2181:2181-eTZ="Asia/Shanghai"--restartalwayswu

- 主流行架构

rainbowcheng

架构架构

nexus,gitlab,svn,jenkins,sonar,docker,apollo,catteambition,axure,蓝湖,禅道,WCP;redis,kafka,es,zookeeper,dubbo,shardingjdbc,mysql,InfluxDB,Telegraf,Grafana,Nginx,xxl-job,Neo4j,NebulaGraph是一个高性能的,NOSQL图形数据库

- 月度总结 | 2022年03月 | 考研与就业的抉择 | 确定未来走大数据开发路线

「已注销」

个人总结hadoop

一、时间线梳理3月3日,寻找到同专业的就业伙伴3月5日,着手准备Java八股文,决定先走Java后端路线3月8月,申请到了校图书馆的考研专座,决定暂时放弃就业,先准备考研,买了数学和408的资料书3月9日-3月13日,因疫情原因,宿舍区暂封,这段时间在准备考研,发现内容特别多3月13日-3月19日,大部分时间在刷Hadoop、Zookeeper、Kafka的视频,同时在准备实习的项目3月20日,退

- 分布式消息队列Kafka

叶域

大数据分布式kafkascalaspark

分布式消息队列Kafka简介:Kafka是一个分布式消息队列系统,用于处理实时数据流。消息按照主题(Topic)进行分类存储,发送消息的实体称为Producer,接收消息的实体称为Consumer。Kafka集群由多个Kafka实例(Server)组成,每个实例称为Broker。主要用途:广泛应用于构建实时数据管道和流应用程序,适用于需要高吞吐量和低延迟的数据处理场景依赖:Kafka集群和消费者依

- K8S学习之PV&&PVC

david161

部署mysql之前我们需要先了解一个概念有状态服务。这是一种特殊的服务,简单的归纳下就是会产生需要持久化的数据,并且有很强的I/O需求,且重启需要依赖上次存储到磁盘的数据。如典型的mysql,kafka,zookeeper等等。在我们有比较优秀的商业存储的前提下,非常推荐使用有状态服务进行部署,计算和存储分离那是相当的爽的。在实际生产中如果没有这种存储,localPV也是不错的选择,当然local

- Kafka系列之:kafka命令详细总结

快乐骑行^_^

日常分享专栏KafkaKafka系列kafka命令详细总结

Kafka系列之:kafka命令详细总结一、添加和删除topic二、修改topic三、平衡领导者四、检查消费者位置五、管理消费者群体一、添加和删除topicbin/kafka-topics.sh--bootstrap-serverbroker_host:port--create--topicmy_topic_name\--partitions20--replication-factor3--con

- 搭建Kafka+zookeeper集群调度

krb___

kafka分布式

前言硬件环境172.18.0.5kafkazk1Kafka+zookeeperKafkaBroker集群172.18.0.6kafkazk2Kafka+zookeeperKafkaBroker集群172.18.0.7kafkazk3Kafka+zookeeperKafkaBroker集群软件环境zookeeper3.5.9资源调度、写作Kafka2.8.0消息通信中间件安装JDK1.8安装搭建zo

- Kafka和Pulsar深入解析

jasen91

大数据开发kafka分布式

Kafka多租户:单租户系统数据迁移:依赖MirrorMaker,需要额外维护。市场上也有ConfluentReplicator等供应商工具。分层存储:由供应商提供商业使用。组件依赖:KafkaRaft(KRaft)从Kafka2.8开始处于早期访问模式,允许Kafka在没有ZooKeeper的情况下工作。这对Kafka来说是一个显著的优势,因为它简化了Kafka的体系结构并降低了学习成本。云原生

- Linux系统部署Kafka教学

情书学长

linux学习笔记kafka

第一步:Zookeeper安装(准备工作)1、解压安装将安装包上传到/opt/software目录下,解压并修改名称tar-zxvfapache-zookeeper-3.5.7-bin.tar.gz-C/opt/module/mvapache-zookeeper-3.5.7-bin/zookeeper2、配置服务器编号1)在/opt/module/zookeeper-3.5.7/这个目录下创建zk

- 数仓开发之DWD层完整使用 (第五章)

小坏讲微服务

数据仓库hadoopscalakafka

数仓开发之DWD层完整使用一、流量域未精加工的事务事实表1、主要任务1)数据清洗(ETL)2)新老访客状态标记修复3)分流2、思路1)数据清洗(ETL)2)新老访客状态标记修复(1)前端埋点新老访客状态标记设置规则(2)新老访客状态标记修复思路3)利用侧输出流实现数据拆分(1)埋点日志结构分析(2)分流日志分类(3)分流思路3、图解4、代码1)在KafkaUtil工具类中补充getKafkaPro

- Kafka 应用场景

zinuxer

kafka分布式

数据流处理:Kafka支持实时数据流处理,能够在数据流动时进行处理和分析,确保应用程序与最新信息保持同步!日志聚合:可以将来自不同来源的日志集中和聚合,简化应用程序的调试和监控!消息队列:Kafka充当高性能的消息队列,确保不同系统组件之间可靠且可扩展的通信!网络活动追踪:Kafka可以追踪网络活动,改进用户体验和推动业务增长!数据复制:Kafka允许在多个集群之间实现无缝数据复制,确保高可用性和

- Kafka的ack机制

香山上的麻雀

ack=0/1/-1的不同情况:0:producer不等待broker的ack,broker一接收到还没有写入磁盘就已经返回,当broker故障时有可能丢失数据;1:producer等待broker的ack,partition的leader落盘成功后返回ack,如果在follower同步成功之前leader故障,那么将会丢失数据;-1:producer等待broker的ack,partition的

- Kafka 实战 - Kafka分区和副本机制理解

用心去追梦

kafka分布式

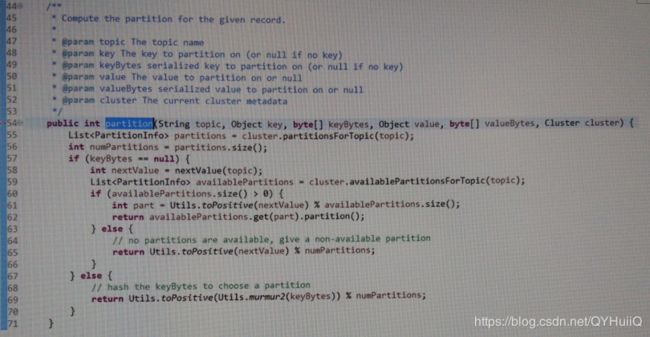

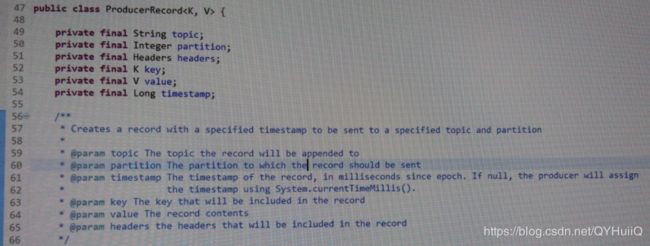

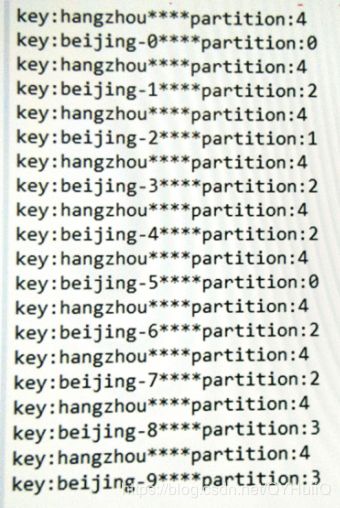

ApacheKafka的分区(Partition)和副本(Replica)机制是其核心架构和可靠性保证的关键组成部分。以下是对其理解的详细解释:分区(Partition)分区概念:在Kafka中,每个主题(Topic)可以被划分为多个分区。分区是一个有序的、不可变的消息序列。这意味着消息在分区中按生成顺序存储,每个消息都有一个唯一的偏移量(Offset)。目的:分区的主要目的是为了水平扩展和并行处

- 编程常用命令总结

Yellow0523

LinuxBigData大数据

编程命令大全1.软件环境变量的配置JavaScalaSparkHadoopHive2.大数据软件常用命令Spark基本命令Spark-SQL命令Hive命令HDFS命令YARN命令Zookeeper命令kafka命令Hibench命令MySQL命令3.Linux常用命令Git命令conda命令pip命令查看Linux系统的详细信息查看Linux系统架构(X86还是ARM,两种方法都可)端口号命令L

- zookeeper+kafka消息队列部署

TBF610218

zookeeperkafka分布式

消息队列的概念什么是消息队列消息是指在应用间传送的数据消息队列是一种应用间的通信方式解决方法,确保消息的可靠传递专门为消息做缓存的消息队列的特征存储将消息存储在某个类型的缓冲区中,指导目标进读取这些消息或者将其从消息队列中显示移除为止异步消息队列通过缓冲消息可以在应用程序当中公开一定程度的异步性,允许源进程发送消息并在队列当中累积消息,而且目标进程可以挑选消息并进行处理为什么需要消息队列解耦冗余扩

- 分布式中间件-几个常用的消息中间件

问道飞鱼

分布式技术分布式中间件

文章目录常见消息中间件1.RabbitMQ2.ApacheKafka3.RedisPub/Sub4.ActiveMQ5.AmazonSimpleNotificationService(SNS)和SimpleQueueService(SQS)6.RocketMQ差异总结消息协议1.AMQP(AdvancedMessageQueuingProtocol)2.STOMP(SimpleTextOrient

- kafka php 教程,php 使用kafka

weixin_39713841

kafkaphp教程

准备工作gitclonehttps://github.com/edenhill/librdkafka.git./configuremakesudomakeinstall$gitclonehttps://github.com/arnaud-lb/php-rdkafka.git#生成configure文件$/Users/shiyibo/LNMP/php/bin/phpize#编译安装$./config

- Kafka快速入门

G丶AEOM

速成学习区kafkalinq分布式

讲一下什么是Kafka首先引入这样一个场景:A服务可以发送200qps(QueriesPerSecond,是指每秒查询率),而B服务可以处理100qps。很显然,B服务很可能会被A服务压垮掉。怎么为了保证B不被压垮的同时还能处理A消息,没有什么是不能通过一层中间件解决的,如果有,那就再加一层。开始很容易想到,可以在B服务中增加一个队列,其实就是个链表,B服务根据自己的消费能力,消费链表中的消息。每

- 【Python系列】异步任务的终止

Kwan的解忧杂货铺@新空间代码工作室

s2Pythonpython开发语言

欢迎来到我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。推荐:kwan的首页,持续学习,不断总结,共同进步,活到老学到老导航檀越剑指大厂系列:全面总结java核心技术,jvm,并发编程redis,kafka,Spring,微服务等常用开发工具系列:常用的开发工具,IDEA,Mac,Alfred,Git,

- 老版本kafka查询topic消费情况(python查询)

代码是谁

kafkapython分布式

由于老版本的kafka缺少shell,导致无法通过命令直接进行查询,所以通过python代码,实现消费情况查询安装必须的包#pyhon2.5pipinstallkafka-python==1.4.7python脚本#!/usr/bin/envpythonimportsysfromkafkaimportKafkaConsumer,TopicPartitioniflen(sys.argv)!=2:pr

- 【Python系列】使用切片移动元素位置

Kwan的解忧杂货铺@新空间代码工作室

s2Pythonpython开发语言

欢迎来到我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。推荐:kwan的首页,持续学习,不断总结,共同进步,活到老学到老导航檀越剑指大厂系列:全面总结java核心技术,jvm,并发编程redis,kafka,Spring,微服务等常用开发工具系列:常用的开发工具,IDEA,Mac,Alfred,Git,

- 字节架构师:来说说 Kafka 的消费者客户端详解,你都搞懂了吗?

2401_84049200

程序员kafkalinq分布式

点对点模式基于队列,类似于同一个消费者组中的数据,由生产者发送数据到分区,然后消费者拉取分区的消息进行消费,此时消息只能被同一个消费者组的消费者消费一次。发布订阅模式模式就是kafka中的分区消息可以被不同消费者组的消费者消费。这就是一对多的广播模式应用。当然,消费者组是一个逻辑的概念,通过客户端参数group.id来配置,默认值为空字符串。而消费者并不是逻辑的概念,它是真正消费数据的实体,可以是

- Java Kafka生产者实现

stormsha

Javawebjavakafkalinq

欢迎莅临我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。推荐:「stormsha的主页」,「stormsha的知识库」持续学习,不断总结,共同进步,为了踏实,做好当下事儿~专栏导航Python系列:Python面试题合集,剑指大厂Git系列:Git操作技巧GO系列:记录博主学习GO语言的笔记,该笔记专栏

- Java常用排序算法/程序员必须掌握的8大排序算法

cugfy

java

分类:

1)插入排序(直接插入排序、希尔排序)

2)交换排序(冒泡排序、快速排序)

3)选择排序(直接选择排序、堆排序)

4)归并排序

5)分配排序(基数排序)

所需辅助空间最多:归并排序

所需辅助空间最少:堆排序

平均速度最快:快速排序

不稳定:快速排序,希尔排序,堆排序。

先来看看8种排序之间的关系:

1.直接插入排序

(1

- 【Spark102】Spark存储模块BlockManager剖析

bit1129

manager

Spark围绕着BlockManager构建了存储模块,包括RDD,Shuffle,Broadcast的存储都使用了BlockManager。而BlockManager在实现上是一个针对每个应用的Master/Executor结构,即Driver上BlockManager充当了Master角色,而各个Slave上(具体到应用范围,就是Executor)的BlockManager充当了Slave角色

- linux 查看端口被占用情况详解

daizj

linux端口占用netstatlsof

经常在启动一个程序会碰到端口被占用,这里讲一下怎么查看端口是否被占用,及哪个程序占用,怎么Kill掉已占用端口的程序

1、lsof -i:port

port为端口号

[root@slave /data/spark-1.4.0-bin-cdh4]# lsof -i:8080

COMMAND PID USER FD TY

- Hosts文件使用

周凡杨

hostslocahost

一切都要从localhost说起,经常在tomcat容器起动后,访问页面时输入http://localhost:8088/index.jsp,大家都知道localhost代表本机地址,如果本机IP是10.10.134.21,那就相当于http://10.10.134.21:8088/index.jsp,有时候也会看到http: 127.0.0.1:

- java excel工具

g21121

Java excel

直接上代码,一看就懂,利用的是jxl:

import java.io.File;

import java.io.IOException;

import jxl.Cell;

import jxl.Sheet;

import jxl.Workbook;

import jxl.read.biff.BiffException;

import jxl.write.Label;

import

- web报表工具finereport常用函数的用法总结(数组函数)

老A不折腾

finereportweb报表函数总结

ADD2ARRAY

ADDARRAY(array,insertArray, start):在数组第start个位置插入insertArray中的所有元素,再返回该数组。

示例:

ADDARRAY([3,4, 1, 5, 7], [23, 43, 22], 3)返回[3, 4, 23, 43, 22, 1, 5, 7].

ADDARRAY([3,4, 1, 5, 7], "测试&q

- 游戏服务器网络带宽负载计算

墙头上一根草

服务器

家庭所安装的4M,8M宽带。其中M是指,Mbits/S

其中要提前说明的是:

8bits = 1Byte

即8位等于1字节。我们硬盘大小50G。意思是50*1024M字节,约为 50000多字节。但是网宽是以“位”为单位的,所以,8Mbits就是1M字节。是容积体积的单位。

8Mbits/s后面的S是秒。8Mbits/s意思是 每秒8M位,即每秒1M字节。

我是在计算我们网络流量时想到的

- 我的spring学习笔记2-IoC(反向控制 依赖注入)

aijuans

Spring 3 系列

IoC(反向控制 依赖注入)这是Spring提出来了,这也是Spring一大特色。这里我不用多说,我们看Spring教程就可以了解。当然我们不用Spring也可以用IoC,下面我将介绍不用Spring的IoC。

IoC不是框架,她是java的技术,如今大多数轻量级的容器都会用到IoC技术。这里我就用一个例子来说明:

如:程序中有 Mysql.calss 、Oracle.class 、SqlSe

- 高性能mysql 之 选择存储引擎(一)

annan211

mysqlInnoDBMySQL引擎存储引擎

1 没有特殊情况,应尽可能使用InnoDB存储引擎。 原因:InnoDB 和 MYIsAM 是mysql 最常用、使用最普遍的存储引擎。其中InnoDB是最重要、最广泛的存储引擎。她 被设计用来处理大量的短期事务。短期事务大部分情况下是正常提交的,很少有回滚的情况。InnoDB的性能和自动崩溃 恢复特性使得她在非事务型存储的需求中也非常流行,除非有非常

- UDP网络编程

百合不是茶

UDP编程局域网组播

UDP是基于无连接的,不可靠的传输 与TCP/IP相反

UDP实现私聊,发送方式客户端,接受方式服务器

package netUDP_sc;

import java.net.DatagramPacket;

import java.net.DatagramSocket;

import java.net.Ine

- JQuery对象的val()方法执行结果分析

bijian1013

JavaScriptjsjquery

JavaScript中,如果id对应的标签不存在(同理JAVA中,如果对象不存在),则调用它的方法会报错或抛异常。在实际开发中,发现JQuery在id对应的标签不存在时,调其val()方法不会报错,结果是undefined。

- http请求测试实例(采用json-lib解析)

bijian1013

jsonhttp

由于fastjson只支持JDK1.5版本,因些对于JDK1.4的项目,可以采用json-lib来解析JSON数据。如下是http请求的另外一种写法,仅供参考。

package com;

import java.util.HashMap;

import java.util.Map;

import

- 【RPC框架Hessian四】Hessian与Spring集成

bit1129

hessian

在【RPC框架Hessian二】Hessian 对象序列化和反序列化一文中介绍了基于Hessian的RPC服务的实现步骤,在那里使用Hessian提供的API完成基于Hessian的RPC服务开发和客户端调用,本文使用Spring对Hessian的集成来实现Hessian的RPC调用。

定义模型、接口和服务器端代码

|---Model

&nb

- 【Mahout三】基于Mahout CBayes算法的20newsgroup流程分析

bit1129

Mahout

1.Mahout环境搭建

1.下载Mahout

http://mirror.bit.edu.cn/apache/mahout/0.10.0/mahout-distribution-0.10.0.tar.gz

2.解压Mahout

3. 配置环境变量

vim /etc/profile

export HADOOP_HOME=/home

- nginx负载tomcat遇非80时的转发问题

ronin47

nginx负载后端容器是tomcat(其它容器如WAS,JBOSS暂没发现这个问题)非80端口,遇到跳转异常问题。解决的思路是:$host:port

详细如下:

该问题是最先发现的,由于之前对nginx不是特别的熟悉所以该问题是个入门级别的:

? 1 2 3 4 5

- java-17-在一个字符串中找到第一个只出现一次的字符

bylijinnan

java

public class FirstShowOnlyOnceElement {

/**Q17.在一个字符串中找到第一个只出现一次的字符。如输入abaccdeff,则输出b

* 1.int[] count:count[i]表示i对应字符出现的次数

* 2.将26个英文字母映射:a-z <--> 0-25

* 3.假设全部字母都是小写

*/

pu

- mongoDB 复制集

开窍的石头

mongodb

mongo的复制集就像mysql的主从数据库,当你往其中的主复制集(primary)写数据的时候,副复制集(secondary)会自动同步主复制集(Primary)的数据,当主复制集挂掉以后其中的一个副复制集会自动成为主复制集。提供服务器的可用性。和防止当机问题

mo

- [宇宙与天文]宇宙时代的经济学

comsci

经济

宇宙尺度的交通工具一般都体型巨大,造价高昂。。。。。

在宇宙中进行航行,近程采用反作用力类型的发动机,需要消耗少量矿石燃料,中远程航行要采用量子或者聚变反应堆发动机,进行超空间跳跃,要消耗大量高纯度水晶体能源

以目前地球上国家的经济发展水平来讲,

- Git忽略文件

Cwind

git

有很多文件不必使用git管理。例如Eclipse或其他IDE生成的项目文件,编译生成的各种目标或临时文件等。使用git status时,会在Untracked files里面看到这些文件列表,在一次需要添加的文件比较多时(使用git add . / git add -u),会把这些所有的未跟踪文件添加进索引。

==== ==== ==== 一些牢骚

- MySQL连接数据库的必须配置

dashuaifu

mysql连接数据库配置

MySQL连接数据库的必须配置

1.driverClass:com.mysql.jdbc.Driver

2.jdbcUrl:jdbc:mysql://localhost:3306/dbname

3.user:username

4.password:password

其中1是驱动名;2是url,这里的‘dbna

- 一生要养成的60个习惯

dcj3sjt126com

习惯

一生要养成的60个习惯

第1篇 让你更受大家欢迎的习惯

1 守时,不准时赴约,让别人等,会失去很多机会。

如何做到:

①该起床时就起床,

②养成任何事情都提前15分钟的习惯。

③带本可以随时阅读的书,如果早了就拿出来读读。

④有条理,生活没条理最容易耽误时间。

⑤提前计划:将重要和不重要的事情岔开。

⑥今天就准备好明天要穿的衣服。

⑦按时睡觉,这会让按时起床更容易。

2 注重

- [介绍]Yii 是什么

dcj3sjt126com

PHPyii2

Yii 是一个高性能,基于组件的 PHP 框架,用于快速开发现代 Web 应用程序。名字 Yii (读作 易)在中文里有“极致简单与不断演变”两重含义,也可看作 Yes It Is! 的缩写。

Yii 最适合做什么?

Yii 是一个通用的 Web 编程框架,即可以用于开发各种用 PHP 构建的 Web 应用。因为基于组件的框架结构和设计精巧的缓存支持,它特别适合开发大型应

- Linux SSH常用总结

eksliang

linux sshSSHD

转载请出自出处:http://eksliang.iteye.com/blog/2186931 一、连接到远程主机

格式:

ssh name@remoteserver

例如:

ssh

[email protected]

二、连接到远程主机指定的端口

格式:

ssh name@remoteserver -p 22

例如:

ssh i

- 快速上传头像到服务端工具类FaceUtil

gundumw100

android

快速迭代用

import java.io.DataOutputStream;

import java.io.File;

import java.io.FileInputStream;

import java.io.FileNotFoundException;

import java.io.FileOutputStream;

import java.io.IOExceptio

- jQuery入门之怎么使用

ini

JavaScripthtmljqueryWebcss

jQuery的强大我何问起(个人主页:hovertree.com)就不用多说了,那么怎么使用jQuery呢?

首先,下载jquery。下载地址:http://hovertree.com/hvtart/bjae/b8627323101a4994.htm,一个是压缩版本,一个是未压缩版本,如果在开发测试阶段,可以使用未压缩版本,实际应用一般使用压缩版本(min)。然后就在页面上引用。

- 带filter的hbase查询优化

kane_xie

查询优化hbaseRandomRowFilter

问题描述

hbase scan数据缓慢,server端出现LeaseException。hbase写入缓慢。

问题原因

直接原因是: hbase client端每次和regionserver交互的时候,都会在服务器端生成一个Lease,Lease的有效期由参数hbase.regionserver.lease.period确定。如果hbase scan需

- java设计模式-单例模式

men4661273

java单例枚举反射IOC

单例模式1,饿汉模式

//饿汉式单例类.在类初始化时,已经自行实例化

public class Singleton1 {

//私有的默认构造函数

private Singleton1() {}

//已经自行实例化

private static final Singleton1 singl

- mongodb 查询某一天所有信息的3种方法,根据日期查询

qiaolevip

每天进步一点点学习永无止境mongodb纵观千象

// mongodb的查询真让人难以琢磨,就查询单天信息,都需要花费一番功夫才行。

// 第一种方式:

coll.aggregate([

{$project:{sendDate: {$substr: ['$sendTime', 0, 10]}, sendTime: 1, content:1}},

{$match:{sendDate: '2015-

- 二维数组转换成JSON

tangqi609567707

java二维数组json

原文出处:http://blog.csdn.net/springsen/article/details/7833596

public class Demo {

public static void main(String[] args) { String[][] blogL

- erlang supervisor

wudixiaotie

erlang

定义supervisor时,如果是监控celuesimple_one_for_one则删除children的时候就用supervisor:terminate_child (SupModuleName, ChildPid),如果shutdown策略选择的是brutal_kill,那么supervisor会调用exit(ChildPid, kill),这样的话如果Child的behavior是gen_