云计算学习中的错误解决

Hadoop集群搭建参考网址:

Hadoop单机模式和伪分布式搭建教程CentOS

1 etc/hosts文件如何立即生效?

sudo /etc/init.d/network restart

2 VMware 中的Centos系统登不上网络

参考网址:虚拟机Linux不能上网简单有效的解决办法

上面参考文章中使用的是Linux系统,与本文中所用的Centos系统其实一样,只是界面稍有不同。

3 修改.bashrc配置文件

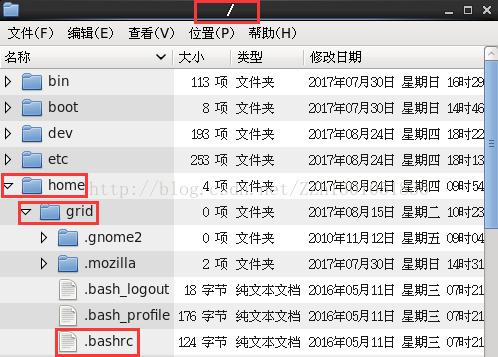

1 首先.bashrc配置文件在哪儿?

.bashrc配置文件是一个隐藏文件,需要使文件显示器“显示隐藏文件”

都说在/home目录下,其实是在/home/grid目录下

4 hdfs: command not found

原因:未在/etc/profile文件中添加Hadoop的文件路径

解决办法:打开/etc/profile文件,添加Hadoop的文件路径

export HADOOP_HOME=/usr/local/hadoop/bin

export PATH=$PATH:$HADOOP_HOME

export PATH=$PATH:$HADOOP_HOME

然后使用source /etc/profile命令使文件生效

参考网站:hdfs:commond not found

5 hdfs namenode -format 执行出错,commond not found

hdfs dfsadmin -report 也会出现这样的错误。

关于找不到hdfs命令的解决方法都是下面这样:

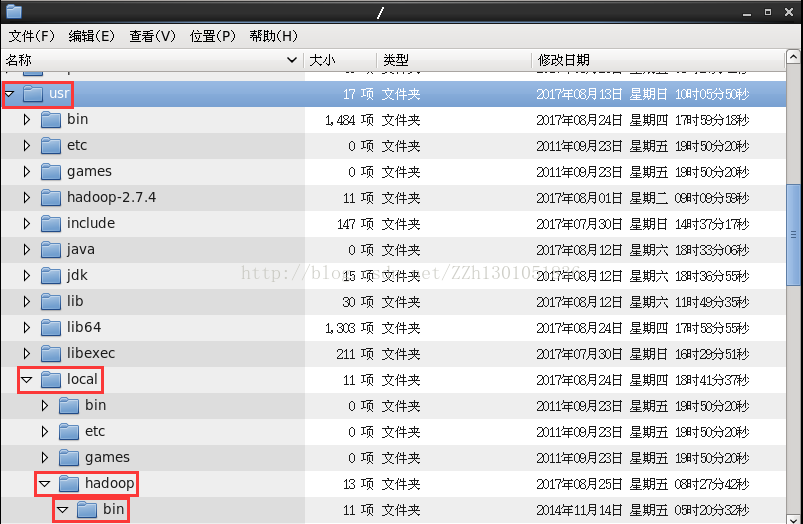

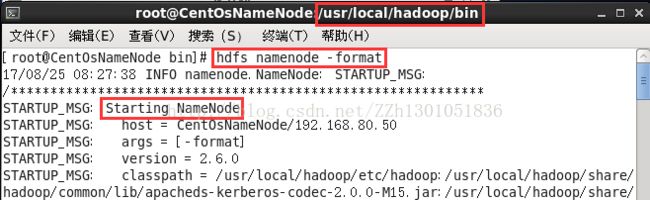

该命令在执行时,须首先进入hadoop安装目录的bin目录下。

文件管理器示意图:

命令执行示意图:

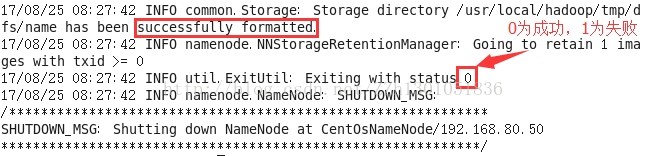

执行成功截图:

6 启动hdfs,执行start-dfs.sh :commond not found

解决方法:

首先查看${HADOOP_HOME}/bin目录下是否有

start-dfs.sh文件,若没有,进入hadoop/sbin目录,执行start-

dfs.sh命令。

参考网址:start-dfs.sh:commond not found

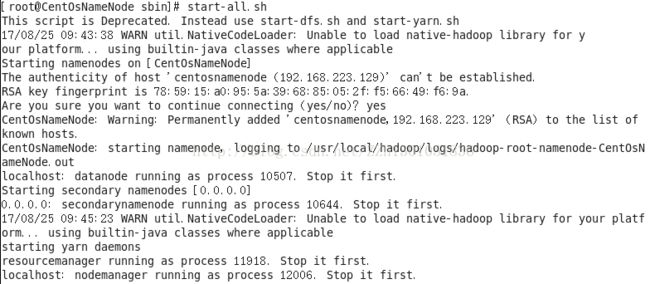

启动hdfs命令也可在hadoop/sbin目录下执行start-all.sh命令。、

7 在hadoop/sbin目录下执行start-all.sh命令时出现错误

错误描述:

Starting namenodes on [CentOsNameNode]

CentOsNameNode: ssh: connect to host CentOsNameNode port 22: Connection refused

错误原因:

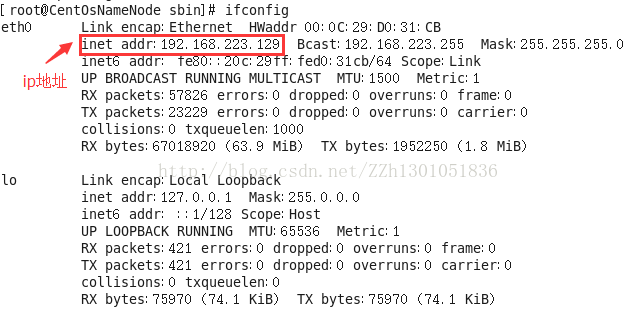

在命令行界面下输入ifconfig命令,查看ip地址,笔者的显示如下:

再去到/etc/hosts文件中查看主机的ip地址为192.168.80.50与上图中的实际ip地址不同。

解决方法:将/etc/hosts文件中主机对应的ip地址设置为192.168.223.129。

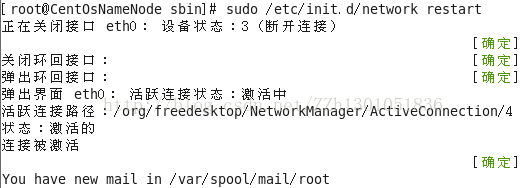

然后执行命令sudo /etc/init.d/network restart使文件生效,如下图所示:

之后再执行start-all.sh命令即可,成功后如下所示:

参考网址:hadoop启动start-all.sh出错

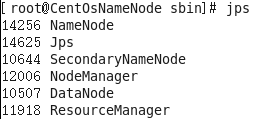

执行命令jps,显示所有已启动的服务:

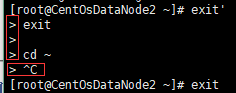

8 在 Linux命令行界面出现">"符号后,怎么退出

问题及解决方法如下图所示:

输入Ctrl+C即可退出。

9 用SSH从一台linux登录到另一台Linux之后如何退出。

输入"exit"

10 xshell如何连接到虚拟机中的系统

参考网址:xshell入门使用教程

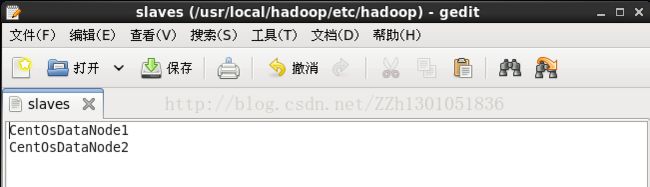

11 关于usr/local/hadoop/etc/hadoop/slaves文件

作用:hadoop采用的cluster/slaves的模式,slaves文件就是指明哪几个数据节点在哪台机上部署datanode。

完全分布式模式配置:

(1)首先编辑master结点的slaves文件,之后再拷贝到其他结点中。

(2)编辑slaves文件时,需要在hadoop用户下进行操作。

(3)slaves的内容:将默认的localhost删除,将所有作为DataNode结点的主机名写入。如下图所示:

12 linux中的su命令

切换为系统的其他用户。

比如从root用户下,切换为hadoop用户:

13 hdfs-site.xml中的dfs.replication

想保存几个副本,这个结点对应的值便是几。

不必非得与dataNode数一致,一般默认是3,设置地越大,对空间的要求越高。

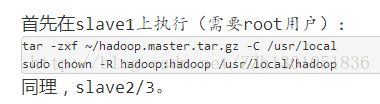

14 参考网址中的补充

I

这一步即在DataNode结点中,解压从NameNode传过来的数据。

所以可以将参考网址中的改为:

(1)打开datanode系统,切换为root用户。

(2)在命令行界面中进入上一步中传入的/home/hadoop目录下

(3)然后执行命令tar -zxf ~/hadoop.master.tar.gz -C /usr/local

II