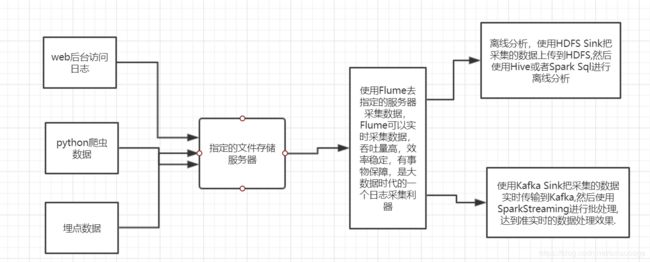

Flume从入门到上手

第 1 章 Flume 概述

1.1 Flume 定义 :

Flume 是 Cloudera 提供的一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统。Flume 基于流式架构,灵活简单。

1.2 Flume架构

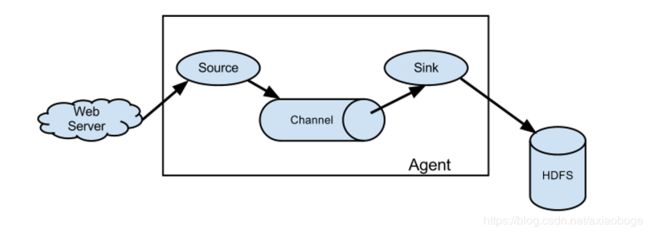

1.2.1 Agent

Agent 是一个 JVM 进程,它以事件的形式将数据从源头送至目的。

Agent 主要有 3 个部分组成,Source、Channel、Sink。

1.2.2 Source

Source 是负责接收数据到 Flume Agent 的组件。Source 组件可以处理各种类型、各种

格式的日志数据,包括 avro、thrift、exec、jms、spooling directory、netcat、sequence

generator、syslog、http、legacy。

1.2.3 Sink

Sink 不断地轮询 Channel 中的事件且批量地移除它们,并将这些事件批量写入到存储

或索引系统、或者被发送到另一个 Flume Agent。Sink 组件目的地包括 hdfs、logger、avro、thrift、ipc、file、HBase、 solr、自定义。

1.2.4 Channel

Channel 是位于 Source 和 Sink 之间的缓冲区。因此,Channel 允许 Source 和 Sink 运

作在不同的速率上。Channel 是线程安全的,可以同时处理几个 Source 的写入操作和几个

Sink 的读取操作。

Flume 自带两种 Channel:Memory Channel 和 File Channel 以及 Kafka Channel。

Memory Channel 是内存中的队列。Memory Channel 在不需要关心数据丢失的情景下适

用。如果需要关心数据丢失,那么 Memory Channel 就不应该使用,因为程序死亡、机器宕

机或者重启都会导致数据丢失。

File Channel 将所有事件写到磁盘。因此在程序关闭或机器宕机的情况下不会丢失数

据。

1.2.5 Event

传输单元,Flume 数据传输的基本单元,以 Event 的形式将数据从源头送至目的地。

Event 由 Header 和 Body 两部分组成,Header 用来存放该 event 的一些属性,为 K-V 结构,

Body 用来存放该条数据,形式为字节数组。

第 2 章 Flume 安装与部署

2.1 Flume官网 可以看看,文档写的简单明了

官网 :flume.apache.org 用户文档 版本1.8 : http://flume.apache.org/releases/content/1.8.0/FlumeUserGuide.html

2.2 下载安装

linux上直接使用 wget http://archive.apache.org/dist/flume/1.8.0/apache-flume-1.8.0-bin.tar.gz 下载,解压,安装

基本不用配置,jdk必须要1.8+,其他内存,磁盘,文件权限都应该没啥问题,遇到问题自行修改就好了.

第一步 :解压:tar -zxvf apache-flume-1.8.0-bin.tar.gz

第二步: 重命名 :mv apache-flume-1.8.0-bin flume-1.8.0

3.Flume入门例子

3.1 使用Flume监听本地一个端口,收集端口输入的数据,打印到控制台

我们进入Flume的conf目录下,编辑一个配置文件,自定命名 example1.conf

# example.conf: A single-node Flume configuration

# Name the components on this agent

a1代表agent,一个agent由source,channel,sink组成

a1.sources = r1 #source的名称

a1.sinks = k1 #sink的名称

a1.channels = c1 #channel的名称

# Describe/configure the source 配置source组件

a1.sources.r1.type = netcat #source类型

a1.sources.r1.bind = 192.168.1.4 #绑定的ip

a1.sources.r1.port = 16888 #绑定的端口

# Describe the sink 配置sink组件

a1.sinks.k1.type = logger #输出日志是到控制台

# Use a channel which buffers events in memory #配置channel管道,使用的是内存

a1.channels.c1.type = memory #管道收集数据的类型

a1.channels.c1.capacity = 1000 #管道容量大小,一个代表一个event

a1.channels.c1.transactionCapacity = 100 #表示收到100Event再去提交事务

#配置完需要把流程组件绑定起来,就是告诉source收集的数据给谁,sink找谁要数据

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1配置完成后,我们保存退出,然后启动一个本地端口.

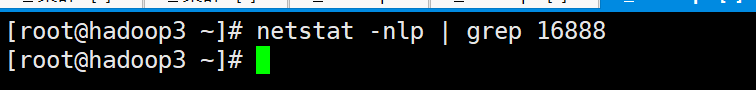

我们先检测本地有没有要启动端口

检查端口并没哟被使用.然后我们启动一个本地端口

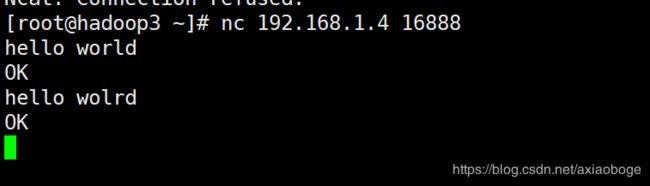

很明显,我们没有安装nc组件

yum install nc 安装一下,不是root用户需要授权一下

bin/flume-ng agent --conf conf/ --conf-file example1.conf --name a1 -Dflume.root.logger=INFO,console参数说明:

--conf :表示配置文件存储在 conf/目录

--name:表示给 agent 起名为 a1

--conf-file:flume 本次启动读取的配置文件是在 conf文件夹下的example1.conf文件。

-Dflume.root.logger=INFO,console :-D 表示 flume 运行时动态修改 flume.root.logger

参数属性值,并将控制台日志打印级别设置为 INFO 级别。日志级别包括:log、info、warn、

error。

然后我们输入数据

至此,我们第一个例子完成了。

3.2 监控一个文本,实时监测动态发生的数据变化

我们到Flume的conf下,复制一个conf,命名为example2.log

# example.conf: A single-node Flume configuration

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source 只修改这个source

a1.sources.r1.type = exec #(Exec source在启动时运行一个给定的Unix命令,并期望该进程在标准输出上不断地生成数据(除非将属性logStdErr设置为true,否则将直接丢弃stderr)。如果进程出于任何原因退出,源也将退出,并且不会产生进一步的数据。这意味着像cat [named pipe]或tail - f [file]这样的配置将产生预期的结果,而as date可能不会产生这种结果——前两个命令将产生数据流,而后者将产生单个事件并退出。)

a1.sources.r1.command = tail -F /usr/local/dynamic.log #动态查看一个文本

# Describe the sink

a1.sinks.k1.type = logger

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

其他的配置不动,然后我们启动Flume,上次的Flume已经被我kill掉了,

没有kill 的 ,使用 jps -ml监测flume进程 然后kill

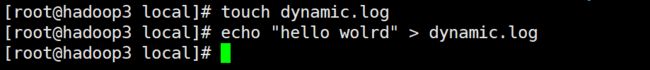

在我们指定的路径下创建文件,然后写入数据

至此,入门案列结束.