yolov2训练自己的数据库

拿到了训练图片和标注文件xml

开始按voc结构来构造自己的数据集

--VOC

--Annotations

--ImageSets

--Main

--JPEGImages

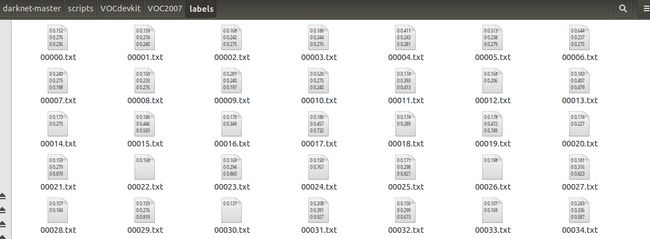

这里只列出关键的,之后还会建立一个labels目录(Ubuntu大小写有无空格好敏感!!!)

这里面用到的文件夹是Annotation、ImageSets和JPEGImages。其中文件夹Annotation中主要存放xml文件,每一个xml对应一张图像,并且每个xml中存放的是标记的各个目标的位置和类别信息,命名通常与对应的原始图像一样;而ImageSets我们只需要用到Main文件夹,这里面存放的是一些文本文件,通常为train.txt、test.txt、2018_train.txt等,train.txt、test.txt该文本文件里面的内容是需要用来训练或测试的图像的名字(无后缀无路径),2018_train.txt包含所有的路径;JPEGImages文件夹中放我们已按统一规则命名好的原始图像。

3.在ImageSets文件夹中,新建三个空文件夹Layout、Main、Segmentation,然后把写了训练或测试的图像的名字的文本拷到Main文件夹下,按目的命名,我这里所有图像用来训练,故而Main文件夹下只有train.txt文件。

生成脚本:creat_list.py:

# coding=utf-8

#这个小脚本是用来打开图片文件所在文件夹,把前900个用于训练的图片的名称保存在tain.txt,后103个用于验证的图片保存在val.txt

import os

from os import listdir, getcwd

from os.path import join

if __name__ == '__main__':

source_folder='/home/yolo_v2_tinydarknet/darknet/infrared/image/dout/'#地址是所有图片的保存地点

dest='/home/yolo_v2_tinydarknet/darknet/infrared/train.txt' #保存train.txt的地址

dest2='/home/yolo_v2_tinydarknet/darknet/infrared/val.txt' #保存val.txt的地址

file_list=os.listdir(source_folder) #赋值图片所在文件夹的文件列表

train_file=open(dest,'a') #打开文件

val_file=open(dest2,'a') #打开文件

for file_obj in file_list: #访问文件列表中的每一个文件

file_path=os.path.join(source_folder,file_obj)

#file_path保存每一个文件的完整路径

file_name,file_extend=os.path.splitext(file_obj)

#file_name 保存文件的名字,file_extend保存文件扩展名

file_num=int(file_name)

#把每一个文件命str转换为 数字 int型 每一文件名字都是由四位数字组成的 如 0201 代表 201 高位补零

if(file_num<900): #保留900个文件用于训练

#print file_num

train_file.write(file_name+'\n') #用于训练前900个的图片路径保存在train.txt里面,结尾加回车换行

else :

val_file.write(file_name+'\n') #其余的文件保存在val.txt里面

train_file.close()#关闭文件

val_file.close()上面说的小代码运行后会生成该文件,把它拷进去即可。

1.生成相关文件

- import xml.etree.ElementTree as ET

- import pickle

- import os

- from os import listdir, getcwd

- from os.path import join

- #sets=[('2012', 'train'), ('2012', 'val'), ('2007', 'train'), ('2007', 'val'), ('2007', 'test')]

- #classes = ["aeroplane", "bicycle", "bird", "boat", "bottle", "bus", "car", "cat", "chair", "cow", "diningtable", "dog", "horse", "motorbike", "person", "pottedplant", "sheep", "sofa", "train", "tvmonitor"]

- sets=[('2007', 'train')]

- classes = [ "person"]

- def convert(size, box):

- dw = 1./size[0]

- dh = 1./size[1]

- x = (box[0] + box[1])/2.0

- y = (box[2] + box[3])/2.0

- w = box[1] - box[0]

- h = box[3] - box[2]

- x = x*dw

- w = w*dw

- y = y*dh

- h = h*dh

- return (x,y,w,h)

- def convert_annotation(year, image_id):

- in_file = open('VOCdevkit/VOC%s/Annotations/%s.xml'%(year, image_id)) #(如果使用的不是VOC而是自设置数据集名字,则这里需要修改)

- out_file = open('VOCdevkit/VOC%s/labels/%s.txt'%(year, image_id), 'w') #(同上)

- tree=ET.parse(in_file)

- root = tree.getroot()

- size = root.find('size')

- w = int(size.find('width').text)

- h = int(size.find('height').text)

- for obj in root.iter('object'):

- difficult = obj.find('difficult').text

- cls = obj.find('name').text

- if cls not in classes or int(difficult) == 1:

- continue

- cls_id = classes.index(cls)

- xmlbox = obj.find('bndbox')

- b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text), float(xmlbox.find('ymax').text))

- bb = convert((w,h), b)

- out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

- wd = getcwd()

- for year, image_set in sets:

- if not os.path.exists('VOCdevkit/VOC%s/labels/'%(year)):

- os.makedirs('VOCdevkit/VOC%s/labels/'%(year))

- image_ids = open('VOCdevkit/VOC%s/ImageSets/Main/%s.txt'%(year, image_set)).read().strip().split()

- list_file = open('%s_%s.txt'%(year, image_set), 'w')

- for image_id in image_ids:

- list_file.write('%s/VOCdevkit/VOC%s/JPEGImages/%s.jpg\n'%(wd, year, image_id))

- convert_annotation(year, image_id)

- list_file.close()

2.配置文件修改

做好了上述准备,就可以根据不同的网络设置(cfg文件)来训练了。在文件夹cfg中有很多cfg文件,应该跟caffe中的prototxt文件是一个意思。这里以tiny-yolo-voc.cfg为例,该网络是yolo-voc的简版,相对速度会快些。主要修改参数如下

- .

- .

- .

- [convolutional]

- size=1

- stride=1

- pad=1

- filters=30 //修改最后一层卷积层核参数个数,计算公式是依旧自己数据的类别数filter=num×(classes + coords + 1)=5×(1+4+1)=30

- activation=linear

- [region]

- anchors = 1.08,1.19, 3.42,4.41, 6.63,11.38, 9.42,5.11, 16.62,10.52

- bias_match=1

- classes=1 //类别数,本例为1类

- coords=4

- num=5

- softmax=1

- jitter=.2

- rescore=1

- object_scale=5

- noobject_scale=1

- class_scale=1

- coord_scale=1

- absolute=1

- thresh = .6

- random=1

修改好了cfg文件之后,就需要修改两个文件,首先是data文件下的voc.names。打开voc.names文件可以看到有20类的名称,本例中只有一类,检测人,因此将原来所有内容清空,仅写上person并保存。名字仍然用这个名字,如果喜欢用其他名字则请按一开始制作自己数据集的时候的名字来修改。

接着需要修改cfg文件夹中的voc.data文件。也是按自己需求修改,我的修改之后是这样的画风:

- classes= 1 //类别数

- train = /home/kinglch/darknet-master/scripts/2007_train.txt //训练样本的绝对路径文件,也就是上文2.1中最后生成的

- //valid = /home/pjreddie/data/voc/2007_test.txt //本例未用到

- names = data/voc.names //上一步修改的voc.names文件

- backup = /home/kinglch/darknet-master/results/ //指示训练后生成的权重放在哪

3.运行训练

上面完成了就可以命令训练了,可以在官网上找到一些预训练的模型作为参数初始值,也可以直接训练,训练命令为

- $./darknet detector train cfg/voc.data cfg/yolo-voc.cfg

- $./darknet detector train cfg/voc.data cfg/yolo-voc.cfg darknet19_448.conv.23

不过我没试成功,加上这个模型直接就除了final,不知道啥情况。当然也可以用自己训练的模型做参数初始化,万一训练的时候被人终端了,可以再用训练好的模型接上去接着训练。

训练过程中会根据迭代次数保存训练的权重模型,然后就可以拿来测试了,测试的命令同理:

./darknet detector test cfg/voc.data cfg/yolo-voc.cfg results/yolo-voc_6000.weights data/images.jpg