- Hadoop相关面试题

努力的搬砖人.

java面试hadoop

以下是150道Hadoop面试题及其详细回答,涵盖了Hadoop的基础知识、HDFS、MapReduce、YARN、HBase、Hive、Sqoop、Flume、ZooKeeper等多个方面,每道题目都尽量详细且简单易懂:Hadoop基础概念类1.什么是Hadoop?Hadoop是一个由Apache基金会开发的开源分布式计算框架,主要用于处理和存储大规模数据集。它提供了高容错性和高扩展性的分布式存

- Flink读取kafka数据并写入HDFS

王知无(import_bigdata)

Flink系统性学习专栏hdfskafkaflink

硬刚大数据系列文章链接:2021年从零到大数据专家的学习指南(全面升级版)2021年从零到大数据专家面试篇之Hadoop/HDFS/Yarn篇2021年从零到大数据专家面试篇之SparkSQL篇2021年从零到大数据专家面试篇之消息队列篇2021年从零到大数据专家面试篇之Spark篇2021年从零到大数据专家面试篇之Hbase篇

- Apache storm

赵世炎

stormhadoop

Apachestorm是一个分布式的实时大数据处理系统。用于在容错和水平可拓展方法中处理大量数据。它是一个流数据框架,具有很高的摄取率,无状态。通过zk管理分布式环境和集群状态,并行地对实时数据执行各种操作。storm易于设置和操作,并且它保证每个消息将通过拓扑至少处理一次。基本上Hadoop和Storm框架用于分析大数据。两者互补,在某些方面有所不同。ApacheStorm执行除持久性之外的所有

- 什么是Apache Avro?

maozexijr

apache

什么是ApacheAvro?ApacheAvro是一个开源的数据序列化框架,主要用于高效的数据交换和存储。它由ApacheHadoop项目开发,广泛应用于大数据生态系统中(如Hadoop、Kafka等)。Avro提供了一种紧凑、快速的二进制数据格式,同时支持丰富的数据结构和模式演化。核心特性跨语言支持Avro支持多种编程语言(如Java、Python、C++、Go等),使得不同语言之间的数据交换变

- 计算机毕业设计之基于Hadoop的热点新闻分析系统的设计与实现

微信bishe69

课程设计pythondjangomysql

近些年来,随着科技的飞速发展,互联网的普及逐渐延伸到各行各业中,给人们生活带来了十分的便利,热点新闻分析系统利用计算机网络实现信息化管理,使整个热点新闻分析的发展和服务水平有显著提升。本文拟采用PyCharm开发工具,django框架、Python语言、Hadoop大数据处理技术进行开发,后台使用MySQL数据库进行信息管理,设计开发的热点新闻分析系统。通过调研和分析,系统拥有管理员和用户两个模块

- Hadoop 实战笔记(二)-- HDFS 常用 shell 命令总结

dazhong2012

Hadoophdfshadoop

一、HDFS命令显示当前目录结构#显示当前目录结构hadoopfs-ls#递归显示当前目录结构hadoopfs-ls-R#显示根目录下内容hadoopfs-ls/创建目录#创建目录hadoopfs-mkdir#递归创建目录hadoopfs-mkdir-p删除操作#删除文件hadoopfs-rm#递归删除目录和文件hadoopfs-rm-R从本地加载文件到HDFS#二选一执行即可hadoopfs-p

- How Spark Read Sftp Files from Hadoop SFTP FileSystem

IT•轩辕

CloudyComputationsparkhadoop大数据

GradleDependenciesimplementation('org.apache.spark:spark-sql_2.13:3.5.3'){excludegroup:"org.apache.logging.log4j",module:"log4j-slf4j2-impl"}implementation('org.apache.hadoop:hadoop-common:3.3.4'){exc

- 中电金信25/3/18面前笔试(需求分析岗+数据开发岗)

苍曦

需求分析前端javascript

部分相同题目在第二次数据开发岗中不做解析,本次解析来源于豆包AI,正确与否有待商榷,本文只提供一个速查与知识点的补充。一、需求分析第1题,单选题,Hadoop的核心组件包括HDFS和以下哪个?MapReduceSparkStormFlink解析:Hadoop的核心组件是HDFS(分布式文件系统)和MapReduce(分布式计算框架)。Spark、Storm、Flink虽然也是大数据处理相关技术,但

- Spark集群启动与关闭

陈沐

sparksparkhadoopbigdata

Hadoop集群和Spark的启动与关闭Hadoop集群开启三台虚拟机均启动ZookeeperzkServer.shstartMaster1上面执行启动HDFSstart-dfs.shslave1上面执行开启YARNstart-yarn.shslave2上面执行开启YARN的资源管理器yarn-daemon.shstartresourcemanager(如果nodeManager没有启动(正常情况

- Hive函数大全:从核心内置函数到自定义UDF实战指南(附详细案例与总结)

一个天蝎座 白勺 程序猿

大数据开发从入门到实战合集hivehadoop数据仓库

目录背景一、Hive函数分类与核心函数表1.内置函数分类2.用户自定义函数(UDF)分类二、常用函数详解与实战案例1.数学函数2.字符串函数3.窗口函数4.自定义UDF实战三、总结与优化建议1.核心总结2.性能优化建议3.常问问题背景Hive作为Hadoop生态中最常用的数据仓库工具,其强大的函数库是高效处理和分析海量数据的核心能力之一。Hive函数分为内置函数和用户自

- Hadoop MapReduce 词频统计(WordCount)代码解析教程

我不是少爷.

Java基础hadoopmapreduce大数据

一、概述这是一个基于HadoopMapReduce框架实现的经典词频统计程序。程序会统计输入文本中每个单词出现的次数,并将结果输出到HDFS文件系统。二、代码结构packagecom.bigdata.wc;//Hadoop核心类库导入importorg.apache.hadoop.conf.Configuration;importorg.apache.hadoop.fs.Path;//数据类型定义

- 从“笨重大象”到“敏捷火花”:Hadoop与Spark的大数据技术进化之路

Echo_Wish

大数据大数据hadoopspark

从“笨重大象”到“敏捷火花”:Hadoop与Spark的大数据技术进化之路说起大数据技术,Hadoop和Spark可以说是这个领域的两座里程碑。Hadoop曾是大数据的开山之作,而Spark则带领我们迈入了一个高效、灵活的大数据处理新时代。那么,它们的演变过程到底有何深意?背后技术上的取舍和选择,又意味着什么?一、Hadoop:分布式存储与计算的奠基者Hadoop诞生于互联网流量爆发式增长的时代,

- hadoop集群关闭命令顺序_启动和关闭Hadoop集群命令步骤

氪老师

hadoop集群关闭命令顺序

启动和关闭Hadoop集群命令步骤总结:1.在master上启动hadoop-daemon.shstartnamenode.2.在slave上启动hadoop-daemon.shstartdatanode.3.用jps指令观察执行结果.4.用hdfsdfsadmin-report观察集群配置情况.5.通过http://npfdev1:50070界面观察集群运行情况.(如果遇到问题看https://

- 在kali linux中配置hadoop伪分布式

we19a0sen

三数据分析分布式linuxhadoop

目录一.配置静态网络二.配置主机名与IP地址映射三.配置SSH免密登录四.配置Java和Hadoop环境五.配置Hadoop伪分布式六.启动与验证一.配置静态网络原因:Hadoop集群依赖稳定的网络通信,动态IP可能导致节点失联。静态IP确保节点始终通过固定地址通信。操作步骤:#修改网络配置文件sudovim/etc/network/interfaces#添加内容(根据实际网络修改):autoet

- Spark任务读取hive表数据导入es

小小小小小小小小小小码农

hiveelasticsearchsparkjava

使用elasticsearch-hadoop将hive表数据导入es,超级简单1.引入pomorg.elasticsearchelasticsearch-hadoop9.0.0-SNAPSHOT2.创建sparkconf//spark参数设置SparkConfsparkConf=newSparkConf();//要写入的索引sparkConf.set("es.resource","");//es集

- hive-进阶版-1

数据牧马人

hivehadoop数据仓库

第6章hive内部表与外部表的区别Hive是一个基于Hadoop的数据仓库工具,用于对大规模数据集进行数据存储、查询和分析。Hive支持内部表(ManagedTable)和外部表(ExternalTable)两种表类型,它们在数据存储、管理方式和生命周期等方面存在显著区别。以下是内部表和外部表的主要区别:1.数据存储位置内部表:数据存储在Hive的默认存储目录下,通常位于HDFS(HadoopDi

- 大数据手册(Spark)--Spark安装配置

WilenWu

数据分析(DataAnalysis)大数据spark分布式

本文默认在zsh终端安装配置,若使用bash终端,环境变量的配置文件相应变化。若安装包下载缓慢,可复制链接到迅雷下载,亲测极速~准备工作Spark的安装过程较为简单,在已安装好Hadoop的前提下,经过简单配置即可使用。假设已经安装好了hadoop(伪分布式)和hive,环境变量如下JAVA_HOME=/usr/opt/jdkHADOOP_HOME=/usr/local/hadoopHIVE_HO

- 虚拟机中Hadoop集群NameNode进程缺失问题解析与解决

申朝先生

hadoop大数据分布式linux

目录问题概述问题分析解决办法总结问题概述在虚拟机中运行Hadoop集群时,通过执行jps命令检查进程时,发现NameNode进程缺失。这通常会导致Hadoop集群无法正常运行,影响数据的存储和访问。问题分析导致NameNode进程缺失的原因可能有以下几点:集群未正确停止:在关闭虚拟机或重启Hadoop集群之前,未执行stop-all.sh命令正确停止集群,导致Hadoop服务异常退出,留下残留数据

- 大数据学习(67)- Flume、Sqoop、Kafka、DataX对比

viperrrrrrr

大数据学习flumekafkasqoopdatax

大数据学习系列专栏:哲学语录:用力所能及,改变世界。如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦工具主要作用数据流向实时性数据源/目标应用场景Flume实时日志采集与传输从数据源到存储系统实时日志文件、网络流量等→HDFS、HBase、Kafka等日志收集、实时监控、实时分析Sqoop关系型数据库与Hadoop间数据同步关系型数据库→Hadoop生态系统(HDFS、Hive、

- Kubernetes集群版本升级

程序员Realeo

Java后端kubernetes容器云原生

集群升级注意事项升级集群版本建议逐步升级,比如v1.20.1–>v1.21.1–>v1.22.1–>v1.23.1–>v1.24.1,不能跨度过大,否则会报错。升级步骤查看集群版本[root@hadoop102~]#kubectlgetnodesNAMESTATUSROLESAGEVERSIONhadoop102Ready,SchedulingDisabledcontrol-plane,maste

- Kubernetes集群版本升级

后端java

集群升级注意事项升级集群版本建议逐步升级,比如v1.20.1–>v1.21.1–>v1.22.1–>v1.23.1–>v1.24.1,不能跨度过大,否则会报错。升级步骤查看集群版本[root@hadoop102~]#kubectlgetnodesNAMESTATUSROLESAGEVERSIONhadoop102Ready,SchedulingDisabledcontrol-plane,maste

- Hive高级SQL技巧及实际应用场景

小技工丨

大数据随笔sqlhive数据仓库大数据

Hive高级SQL技巧及实际应用场景引言ApacheHive是一个建立在Hadoop之上的数据仓库基础设施,它提供了一个用于查询和管理分布式存储中的大型数据集的机制。通过使用类似于SQL(称为HiveQL)的语言,Hive使得数据分析变得更加简单和高效。本文将详细探讨一些Hive高级SQL技巧,并结合实际的应用场景进行说明。HiveSQL的高级使用技巧1.窗口函数描述:窗口函数允许我们在不使用GR

- hive 数字转换字符串_Hive架构及Hive SQL的执行流程解读

weixin_39756416

hive数字转换字符串

1、Hive产生背景MapReduce编程的不便性HDFS上的文件缺少Schema(表名,名称,ID等,为数据库对象的集合)2、Hive是什么Hive的使用场景是什么?基于Hadoop做一些数据清洗啊(ETL)、报表啊、数据分析可以将结构化的数据文件映射为一张数据库表,并提供类SQL查询功能。Hive是SQL解析引擎,它将SQL语句转译成M/RJob然后在Hadoop执行。由Facebook开源,

- 在hadoop上运行python_hadoop上运行python程序

廷哥带你小路超车

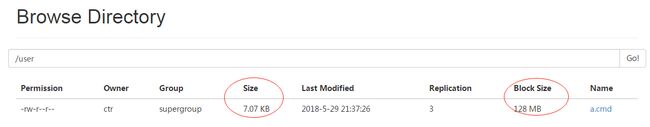

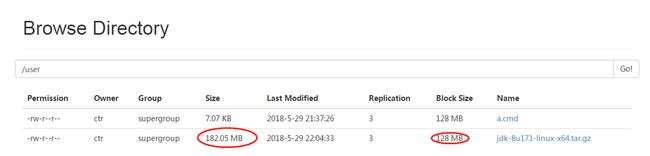

数据来源:http://www.nber.org/patents/acite75_99.zip首先上传测试数据到hdfs:[root@localhost:/usr/local/hadoop/hadoop-0.19.2]#bin/hadoopfs-ls/user/root/test-inFound5items-rw-r--r--1rootsupergroup1012010-10-2414:39/us

- ranger集成starrock报错

蘑菇丁

大数据+机器学习+oracle大数据

org.apache.ranger.plugin.client.HadoopException:initConnection:UnabletoconnecttoStarRocksinstance,pleaseprovidevalidvalueoffield:{jdbc.driverClassName}..com.mysql.cj.jdbc.Driver.可能的原因JDBC驱动缺失:运行环境中没有安

- 深入大数据世界:Kontext.TECH的Hadoop之旅

钱桦实Emery

深入大数据世界:Kontext.TECH的Hadoop之旅winutils项目地址:https://gitcode.com/gh_mirrors/winut/winutils在大数据的浩瀚宇宙中,Hadoop作为一颗璀璨的星辰,一直扮演着至关重要的角色。对于渴望探索这一领域的开发者和学习者而言,Kontext.TECH提供了一扇独特而便捷的大门,让你的学习之旅更加顺畅。项目介绍Kontext.Ha

- 大数据学习(61)-Impala与Hive计算引擎

viperrrrrrr

学习impalahiveyarnhadoop

&&大数据学习&&系列专栏:哲学语录:承认自己的无知,乃是开启智慧的大门如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦一、impala与yarn资源管理YARN是ApacheHadoop生态系统中的一个资源管理器,它采用了master/slave的架构,使得多个处理框架能够在同一集群上共享资源。Impala作为Hadoop生态系统中的一个组件,可以与YARN集成,以便更好地管理

- 大数据学习(62)- Hadoop-yarn

viperrrrrrr

大数据yarn

&&大数据学习&&系列专栏:哲学语录:承认自己的无知,乃是开启智慧的大门如果觉得博主的文章还不错的话,请点赞+收藏⭐️+留言支持一下博主哦一、YARN概述1.YARN简介Hadoop-YARN是ApacheHadoop生态系统中的一个集群资源管理器。它作为Hadoop的第二代资源管理框架,负责管理和分配集群中的计算资源。YARN的设计目标是提供一个通用的资源管理框架,使得Hadoop集群可以同时运

- HBase2.6.1部署文档

CXH728

zookeeperhbase

1、HBase概述ApacheHBase是基于Hadoop分布式文件系统(HDFS)之上的分布式、列存储、NoSQL数据库。它适合处理结构化和半结构化数据,能够存储数十亿行和数百万列的数据,并支持实时读写操作。HBase通常应用于需要快速随机读写、低延迟访问以及高吞吐量的场景,例如大规模日志处理、社交网络数据存储等。HBase特性列存储模型:HBase的数据是按列族存储的,适合高稀疏数据。行键分区

- Hive-4.0.1版本部署文档

CXH728

hivehadoop数据仓库

1.前置要求操作系统:建议使用CentOS7或Ubuntu20.04(本试验使用的是CentOSLinuxrelease7.9.2009(Core))Java环境:建议安装Java8或更高版本。Hadoop:Hive需要依赖Hadoop进行分布式存储,建议安装Hadoop3.x版本(本实验采用的是hadoop3.3.6)。数据库:HiveMetastore需要数据库支持,建议使用MySQL、Pos

- iOS http封装

374016526

ios服务器交互http网络请求

程序开发避免不了与服务器的交互,这里打包了一个自己写的http交互库。希望可以帮到大家。

内置一个basehttp,当我们创建自己的service可以继承实现。

KuroAppBaseHttp *baseHttp = [[KuroAppBaseHttp alloc] init];

[baseHttp setDelegate:self];

[baseHttp

- lolcat :一个在 Linux 终端中输出彩虹特效的命令行工具

brotherlamp

linuxlinux教程linux视频linux自学linux资料

那些相信 Linux 命令行是单调无聊且没有任何乐趣的人们,你们错了,这里有一些有关 Linux 的文章,它们展示着 Linux 是如何的有趣和“淘气” 。

在本文中,我将讨论一个名为“lolcat”的小工具 – 它可以在终端中生成彩虹般的颜色。

何为 lolcat ?

Lolcat 是一个针对 Linux,BSD 和 OSX 平台的工具,它类似于 cat 命令,并为 cat

- MongoDB索引管理(1)——[九]

eksliang

mongodbMongoDB管理索引

转载请出自出处:http://eksliang.iteye.com/blog/2178427 一、概述

数据库的索引与书籍的索引类似,有了索引就不需要翻转整本书。数据库的索引跟这个原理一样,首先在索引中找,在索引中找到条目以后,就可以直接跳转到目标文档的位置,从而使查询速度提高几个数据量级。

不使用索引的查询称

- Informatica参数及变量

18289753290

Informatica参数变量

下面是本人通俗的理解,如有不对之处,希望指正 info参数的设置:在info中用到的参数都在server的专门的配置文件中(最好以parma)结尾 下面的GLOBAl就是全局的,$开头的是系统级变量,$$开头的变量是自定义变量。如果是在session中或者mapping中用到的变量就是局部变量,那就把global换成对应的session或者mapping名字。

[GLOBAL] $Par

- python 解析unicode字符串为utf8编码字符串

酷的飞上天空

unicode

php返回的json字符串如果包含中文,则会被转换成\uxx格式的unicode编码字符串返回。

在浏览器中能正常识别这种编码,但是后台程序却不能识别,直接输出显示的是\uxx的字符,并未进行转码。

转换方式如下

>>> import json

>>> q = '{"text":"\u4

- Hibernate的总结

永夜-极光

Hibernate

1.hibernate的作用,简化对数据库的编码,使开发人员不必再与复杂的sql语句打交道

做项目大部分都需要用JAVA来链接数据库,比如你要做一个会员注册的 页面,那么 获取到用户填写的 基本信后,你要把这些基本信息存入数据库对应的表中,不用hibernate还有mybatis之类的框架,都不用的话就得用JDBC,也就是JAVA自己的,用这个东西你要写很多的代码,比如保存注册信

- SyntaxError: Non-UTF-8 code starting with '\xc4'

随便小屋

python

刚开始看一下Python语言,传说听强大的,但我感觉还是没Java强吧!

写Hello World的时候就遇到一个问题,在Eclipse中写的,代码如下

'''

Created on 2014年10月27日

@author: Logic

'''

print("Hello World!");

运行结果

SyntaxError: Non-UTF-8

- 学会敬酒礼仪 不做酒席菜鸟

aijuans

菜鸟

俗话说,酒是越喝越厚,但在酒桌上也有很多学问讲究,以下总结了一些酒桌上的你不得不注意的小细节。

细节一:领导相互喝完才轮到自己敬酒。敬酒一定要站起来,双手举杯。

细节二:可以多人敬一人,决不可一人敬多人,除非你是领导。

细节三:自己敬别人,如果不碰杯,自己喝多少可视乎情况而定,比如对方酒量,对方喝酒态度,切不可比对方喝得少,要知道是自己敬人。

细节四:自己敬别人,如果碰杯,一

- 《创新者的基因》读书笔记

aoyouzi

读书笔记《创新者的基因》

创新者的基因

创新者的“基因”,即最具创意的企业家具备的五种“发现技能”:联想,观察,实验,发问,建立人脉。

第一部分破坏性创新,从你开始

第一章破坏性创新者的基因

如何获得启示:

发现以下的因素起到了催化剂的作用:(1) -个挑战现状的问题;(2)对某项技术、某个公司或顾客的观察;(3) -次尝试新鲜事物的经验或实验;(4)与某人进行了一次交谈,为他点醒

- 表单验证技术

百合不是茶

JavaScriptDOM对象String对象事件

js最主要的功能就是验证表单,下面是我对表单验证的一些理解,贴出来与大家交流交流 ,数显我们要知道表单验证需要的技术点, String对象,事件,函数

一:String对象;通常是对字符串的操作;

1,String的属性;

字符串.length;表示该字符串的长度;

var str= "java"

- web.xml配置详解之context-param

bijian1013

javaservletweb.xmlcontext-param

一.格式定义:

<context-param>

<param-name>contextConfigLocation</param-name>

<param-value>contextConfigLocationValue></param-value>

</context-param>

作用:该元

- Web系统常见编码漏洞(开发工程师知晓)

Bill_chen

sqlPHPWebfckeditor脚本

1.头号大敌:SQL Injection

原因:程序中对用户输入检查不严格,用户可以提交一段数据库查询代码,根据程序返回的结果,

获得某些他想得知的数据,这就是所谓的SQL Injection,即SQL注入。

本质:

对于输入检查不充分,导致SQL语句将用户提交的非法数据当作语句的一部分来执行。

示例:

String query = "SELECT id FROM users

- 【MongoDB学习笔记六】MongoDB修改器

bit1129

mongodb

本文首先介绍下MongoDB的基本的增删改查操作,然后,详细介绍MongoDB提供的修改器,以完成各种各样的文档更新操作 MongoDB的主要操作

show dbs 显示当前用户能看到哪些数据库

use foobar 将数据库切换到foobar

show collections 显示当前数据库有哪些集合

db.people.update,update不带参数,可

- 提高职业素养,做好人生规划

白糖_

人生

培训讲师是成都著名的企业培训讲师,他在讲课中提出的一些观点很新颖,在此我收录了一些分享一下。注:讲师的观点不代表本人的观点,这些东西大家自己揣摩。

1、什么是职业规划:职业规划并不完全代表你到什么阶段要当什么官要拿多少钱,这些都只是梦想。职业规划是清楚的认识自己现在缺什么,这个阶段该学习什么,下个阶段缺什么,又应该怎么去规划学习,这样才算是规划。

- 国外的网站你都到哪边看?

bozch

技术网站国外

学习软件开发技术,如果没有什么英文基础,最好还是看国内的一些技术网站,例如:开源OSchina,csdn,iteye,51cto等等。

个人感觉如果英语基础能力不错的话,可以浏览国外的网站来进行软件技术基础的学习,例如java开发中常用的到的网站有apache.org 里面有apache的很多Projects,springframework.org是spring相关的项目网站,还有几个感觉不错的

- 编程之美-光影切割问题

bylijinnan

编程之美

package a;

public class DisorderCount {

/**《编程之美》“光影切割问题”

* 主要是两个问题:

* 1.数学公式(设定没有三条以上的直线交于同一点):

* 两条直线最多一个交点,将平面分成了4个区域;

* 三条直线最多三个交点,将平面分成了7个区域;

* 可以推出:N条直线 M个交点,区域数为N+M+1。

- 关于Web跨站执行脚本概念

chenbowen00

Web安全跨站执行脚本

跨站脚本攻击(XSS)是web应用程序中最危险和最常见的安全漏洞之一。安全研究人员发现这个漏洞在最受欢迎的网站,包括谷歌、Facebook、亚马逊、PayPal,和许多其他网站。如果你看看bug赏金计划,大多数报告的问题属于 XSS。为了防止跨站脚本攻击,浏览器也有自己的过滤器,但安全研究人员总是想方设法绕过这些过滤器。这个漏洞是通常用于执行cookie窃取、恶意软件传播,会话劫持,恶意重定向。在

- [开源项目与投资]投资开源项目之前需要统计该项目已有的用户数

comsci

开源项目

现在国内和国外,特别是美国那边,突然出现很多开源项目,但是这些项目的用户有多少,有多少忠诚的粉丝,对于投资者来讲,完全是一个未知数,那么要投资开源项目,我们投资者必须准确无误的知道该项目的全部情况,包括项目发起人的情况,项目的维持时间..项目的技术水平,项目的参与者的势力,项目投入产出的效益.....

- oracle alert log file(告警日志文件)

daizj

oracle告警日志文件alert log file

The alert log is a chronological log of messages and errors, and includes the following items:

All internal errors (ORA-00600), block corruption errors (ORA-01578), and deadlock errors (ORA-00060)

- 关于 CAS SSO 文章声明

denger

SSO

由于几年前写了几篇 CAS 系列的文章,之后陆续有人参照文章去实现,可都遇到了各种问题,同时经常或多或少的收到不少人的求助。现在这时特此说明几点:

1. 那些文章发表于好几年前了,CAS 已经更新几个很多版本了,由于近年已经没有做该领域方面的事情,所有文章也没有持续更新。

2. 文章只是提供思路,尽管 CAS 版本已经发生变化,但原理和流程仍然一致。最重要的是明白原理,然后

- 初二上学期难记单词

dcj3sjt126com

englishword

lesson 课

traffic 交通

matter 要紧;事物

happy 快乐的,幸福的

second 第二的

idea 主意;想法;意见

mean 意味着

important 重要的,重大的

never 从来,决不

afraid 害怕 的

fifth 第五的

hometown 故乡,家乡

discuss 讨论;议论

east 东方的

agree 同意;赞成

bo

- uicollectionview 纯代码布局, 添加头部视图

dcj3sjt126com

Collection

#import <UIKit/UIKit.h>

@interface myHeadView : UICollectionReusableView

{

UILabel *TitleLable;

}

-(void)setTextTitle;

@end

#import "myHeadView.h"

@implementation m

- N 位随机数字串的 JAVA 生成实现

FX夜归人

javaMath随机数Random

/**

* 功能描述 随机数工具类<br />

* @author FengXueYeGuiRen

* 创建时间 2014-7-25<br />

*/

public class RandomUtil {

// 随机数生成器

private static java.util.Random random = new java.util.R

- Ehcache(09)——缓存Web页面

234390216

ehcache页面缓存

页面缓存

目录

1 SimplePageCachingFilter

1.1 calculateKey

1.2 可配置的初始化参数

1.2.1 cach

- spring中少用的注解@primary解析

jackyrong

primary

这次看下spring中少见的注解@primary注解,例子

@Component

public class MetalSinger implements Singer{

@Override

public String sing(String lyrics) {

return "I am singing with DIO voice

- Java几款性能分析工具的对比

lbwahoo

java

Java几款性能分析工具的对比

摘自:http://my.oschina.net/liux/blog/51800

在给客户的应用程序维护的过程中,我注意到在高负载下的一些性能问题。理论上,增加对应用程序的负载会使性能等比率的下降。然而,我认为性能下降的比率远远高于负载的增加。我也发现,性能可以通过改变应用程序的逻辑来提升,甚至达到极限。为了更详细的了解这一点,我们需要做一些性能

- JVM参数配置大全

nickys

jvm应用服务器

JVM参数配置大全

/usr/local/jdk/bin/java -Dresin.home=/usr/local/resin -server -Xms1800M -Xmx1800M -Xmn300M -Xss512K -XX:PermSize=300M -XX:MaxPermSize=300M -XX:SurvivorRatio=8 -XX:MaxTenuringThreshold=5 -

- 搭建 CentOS 6 服务器(14) - squid、Varnish

rensanning

varnish

(一)squid

安装

# yum install httpd-tools -y

# htpasswd -c -b /etc/squid/passwords squiduser 123456

# yum install squid -y

设置

# cp /etc/squid/squid.conf /etc/squid/squid.conf.bak

# vi /etc/

- Spring缓存注解@Cache使用

tom_seed

spring

参考资料

http://www.ibm.com/developerworks/cn/opensource/os-cn-spring-cache/

http://swiftlet.net/archives/774

缓存注解有以下三个:

@Cacheable @CacheEvict @CachePut

- dom4j解析XML时出现"java.lang.noclassdeffounderror: org/jaxen/jaxenexception"错误

xp9802

java.lang.NoClassDefFoundError: org/jaxen/JaxenExc

关键字: java.lang.noclassdeffounderror: org/jaxen/jaxenexception

使用dom4j解析XML时,要快速获取某个节点的数据,使用XPath是个不错的方法,dom4j的快速手册里也建议使用这种方式

执行时却抛出以下异常:

Exceptio