五分钟搭建BERT服务,实现1000+QPS,这个Service-Streamer做到了

作者 | 刘欣

深度学习模型在训练和测试时,通常使用小批量(mini-batch)的方式将样本组装在一起,这样能充分利用GPU的并行计算特性,加快运算速度。

但在将使用了深度学习模型的服务部署上线时,由于用户请求通常是离散和单次的,若采取传统的循环服务器或多线程服务器,在短时间内有大量请求时,会造成GPU计算资源闲置,用户等待时间线性变长。

基于此,我们开发了service-streamer,它是一个中间件,将服务请求排队组成一个完整的batch,再送进GPU运算。这样可以牺牲最小的时延(默认最大0.1s),提升整体性能,极大优化GPU利用率。

功能特色

- 简单易用: 只需添加两三行代码即可让模型服务提速上数十倍。

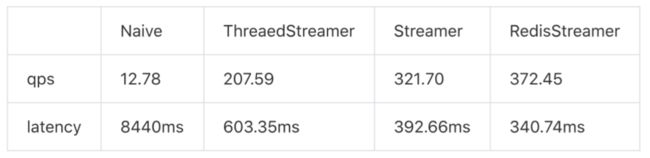

- 处理高速: 高QPS、低延迟,专门针对速度做了优化,见基准测试。

- 扩展性好: 可轻松扩展到多GPU场景,处理大量请求,见分布式。

- 适用性强: 中间件,适用于所有深度学习框架和web框架。

安装步骤

可通过pip安装,要求Python>=3.5:

pip install service_streamer

五分钟搭建BERT服务

为了演示API使用方法,service-streamer提供了一个完整的教程和示例代码。如何在五分钟搭建起基于BERT模型的完形填空服务,每秒处理1000+请求。

GitHub链接:https://github.com/ShannonAI/service-streamer

1、首先我们定义一个完型填空模型(bert_model.py),其predict方法接受批量的句子,并给出每个句子中[MASK]位置的预测结果。

class TextInfillingModel (object);

...

batch=["twinkletwinkle [MASK] star",

"Happy birthday to [MASK]",

'the answer to life, the [MASK], andeverything']

model=TextaInfillingModel()

outputs=model.predict(batch)

print(outputs)

#['little', 'you', 'universe' ]

2、然后使用Flask将模型封装成web服务flask_example.py。这时候你的web服务每秒钟只能完成12句请求。

model=TextInfillingModel()

@app.route("/naive", methods=["POST"])

def naive_predict( ):

inputs =request.form.getlist("s")

outputs =model.predict(inputs)

return jsonify(outputs)

app.run(port=5005)

3、下面我们通过service_streamer封装你的模型函数,三行代码使BERT服务的预测速度达到每秒200+句(16倍QPS)。

from service_streamer import ThreadStreamer

streamer=ThreadedStreamer (model.predict,batch_size=64, max_latency=0.1)

@app.route("/stream", methods=["POST"])

def stream_predict( ):

inputs =request.form.getlist("s")

outputs= streamer.predict(inputs)

returnisonify(outputs)

app.run(port=5005,debug=False)

4、最后,我们利用Streamer封装模型,启动多个GPU worker,充分利用多卡性能实现每秒1000+句(80倍QPS)。

import multiprocessing

from service_streamer import ManagedModel, Streamer

multiprocessing.set_start_method("spawn", force=True)

class ManagedBertModel(ManagedModel):

def init_model(self):

self.model = TextInfillingModel( )

def predict(self, batch):

return self.model.predict(batch)

streamer =Streamer(ManageBertModel, batch_size=64, max_latency=0.1,

worker_num = 8, cuda_devices=(0,1,2,3))

app.run(port=5005,debug=False)

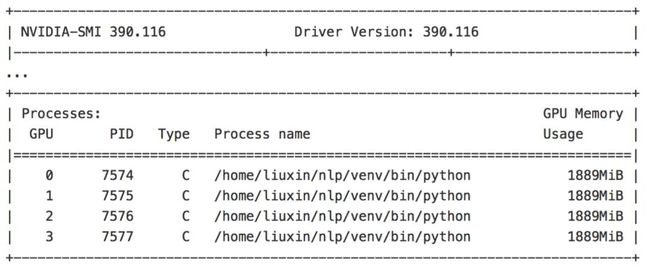

运行flask_multigpu_example.py这样即可启动8个GPUworker,平均分配在4张卡上。

更多指南

除了上面的5分钟教程,service-streamer还提供了:

分布式API使用方法,可以配合gunicorn实现web server和gpuworker的分布式;

异步FutureAPI,在本地高频小batch调用的情形下如何利用service-streamer加速;

性能Benchmark,利用wrk进行单卡和多卡的性能测试数据。

API介绍

快速入门

通常深度学习的inference按batch输入会比较快。

outputs= model.predict(batch_inputs)

用service_streamer中间件封装predict函数,将request排队成一个完整的batch,再送进GPU。牺牲一定的时延(默认最大0.1s),提升整体性能,极大提高GPU利用率。

from service_streamer import ThreadedStreamer

# 用Streamer封装batch_predict函数

streamer= ThreadedStreamer(model.predict, batch_size=64, max_latency=0.1)

# 用Streamer封装batch_predict函数

outputs= streamer.predict(batch_inouts)

然后你的web server需要开启多线程(或协程)即可。

短短几行代码,通常可以实现数十(batch_size/batch_per_request)倍的加速。

分布式GPU worker

上面的例子是在web server进程中,开启子线程作为GPUworker进行 batch predict,用线程间队列进行通信和排队。

实际项目中web server的性能(QPS)远高于GPU模型的性能,所以我们支持一个web server搭配多个GPUworker进程。

import multiprocessing;

multiprocessing.set_start_method("spawn",force=True)

from service_streamer import Streamer

#spawn出4个gpu worker进程

streamer= Streamer(model.predict, 64, 0.1,worker_num=4)

outputs= streamer.redict(batch)

Streamer默认采用spawn子进程运行gpuworker,利用进程间队列进行通信和排队,将大量的请求分配到多个worker中处理,再将模型batch predict的结果传回到对应的web server,并且返回到对应的http response。

上面这种方式定义简单,但是主进程初始化模型,多占了一份显存,并且模型只能运行在同一块GPU上,所以我们提供了ManageModel类,方便模型lazy初始化和迁移,以支持多GPU。 from service_streamer import ManagedModel class ManagedBertModel(ManagedModel): def init_model(self): self.model = Model( ) def predict(self, batch): return self.model.predict(batch) # spawn出4个gpu worker进程,平均分数在0/1/2/3号GPU上

streamer=Streamer(ManagedBertModel, 64, 0.1,worker_num=4,cuda_devices=(0,1,2,3)) outputs = streamer.predict(batch) 分布式web server 有时候,你的web server中需要进行一些CPU密集型计算,比如图像、文本预处理,再分配到GPU worker进入模型。 CPU资源往往会成为性能瓶颈,于是我们也提供了多web server搭配(单个或多个)GPU worker的模式。 使用跟任意RedisStreamer指定所有web server 和GPU worke的模式。 # 默认参数可以省略,使用localhost:6379 streamer = RedisStreamer (redis_broker="172.22.22.22:6379") 然后跟任意python web server的部署一样,用gunicorn或uwsgi实现反向代理和负载均衡。 cd example gunicorn -c redis_streamer_gunicorn.py flask_example:app 这样每个请求会负载均衡到每个web server中进行CPU预处理,然后均匀的分布到GPU worke中进行模型predict。 Future API 如果你使用过任意concurrent库,应该对future不陌生。 当你的使用场景不是web service,又想使用service_streamer进行排队或者分布式GPU计算,可以直接使用Future API。 from service_streamer import ThreadedStreamer streamer = ThreadedStreamer(model.predict , 64, 0.1) xs ={} for i in range(200): future =streamer.submit(["Happy birthday to [MASK]", "Today is my lucky [MASK]"]) xs.append(future) # 先拿到所有future对象,再等待异步返回 for future in xs: outputs = future.result() print(outputs) 基准测试 如何做基准测试 我们使用wrk来使做基准测试。 环境

GPU : Titan Xp

cuda : 9.0

python : 1.1

#benchmark stream api with service_streamer ./wrk -t 4 -c 128 -d 20s --timeout=10s -s scripts/streamer.luahttp://127.0.0.1:5005/naive

多个GPU进程 这里对比单web server进程的情况下,多GPU worker的性能,验证通过和负载均衡机制的性能损耗。 Flask多线程server已经成为性能瓶颈,故采用gevent server。

利用Future API使用多个GPU

为了规避web server的性能瓶颈,我们使用底层Future API本地测试多GPU worker的benchmark。

可以看出service_streamer的性能跟GPUworker数量及乎成线性关系,其中进程间通信的效率略高于redis通信。

利用Future API使用多个GPU

为了规避web server的性能瓶颈,我们使用底层Future API本地测试多GPU worker的benchmark。

可以看出service_streamer的性能跟GPUworker数量及乎成线性关系,其中进程间通信的效率略高于redis通信。

(*本文为 AI科技大本营转载文章,转载请联系原作者)

社群福利

扫码添加小助手,回复:大会,加入2019 AI开发者大会福利群,每周一、三、五更新技术福利,还有不定期的抽奖活动~

◆

精彩推荐

◆

60+技术大咖与你相约 2019 AI ProCon!大会早鸟票已售罄,优惠票速抢进行中......2019 AI开发者大会将于9月6日-7日在北京举行,这一届AI开发者大会有哪些亮点?一线公司的大牛们都在关注什么?AI行业的风向是什么?2019 AI开发者大会,倾听大牛分享,聚焦技术实践,和万千开发者共成长。

推荐阅读

通俗易懂:图解10大CNN网络架构

BERT的成功是否依赖于虚假相关的统计线索

AI+DevOps正当时

5天破10亿的哪吒,为啥这么火,Python来分析

5G+AI重新定义生老病死

如何从零开始设计一颗芯片?

在其他国家被揭穿骗子又盯上非洲? 这几个骗子公司可把非洲人民坑苦了…

国内首款 5G 机型开售;Google Chrome 大部分插件无人用;Firefox 69 Beta 9 发布