摄像机成像、畸变模型

一 摄像机成像模型

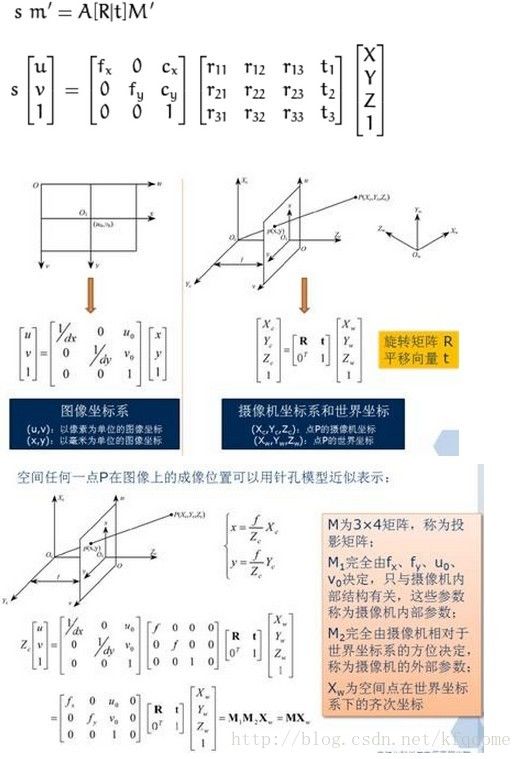

成像的过程实质上是几个坐标系的转换。首先空间中的一点由世界坐标系转换到摄像机坐标系,然后再将其投影到成像平面(摄像机的CCD),最后再将成像平面上的数据转换到图像平面(最后生成的图像)。

图1-1

世界空间内的一个点在图像上成像的过程称为投影成像过程,这中间转换过程构成的矩阵M称为投影矩阵。

摄像机的畸变参数与相机成像时采用的分辨率无关,而fx,fy和光心位置cx,cy与分辨率有关,但是成倍数关系,例如在分辨率320×240分辨率标定得到内参数为fx0,fy0,cx0,cy0,那么在分辨率640×480下对应的参数则为2fx0,2fy0,2cx0,2cy0。

上面这些参数中,f,t所采用的量纲都是mm,而dx和dy指的是每个像素个数的大小,即mm/pixel,那么经过换算最后得到的u、v的量纲自然也就是像素。fx和fy是由f/dx,f/dy计算而来,表示的是长度值为f时对应的像素个数,也即长度值为f(mm)时,在图像平面的x方向和y方向的像素个数,fx、fy、u0、v0构成A,A右边的数据为[R|t]M’,看起来[R|t]M’对应的数据的量纲好像是mm,因为M’和t的量纲都是mm,这样A里面的量纲又为像素,这样乘起来的量纲就是mm*pixel了,这显然不对。但是事实情况并不是真的这样,最后[R|t]M’与A相乘的时候,[R|t]M’的结果是需要进行归一化的,即[xc yc zc 1] →[xc/zc yc/zc 1],这个时候它的量纲其实就只是倍数了。整个过程如下图

图 1-2

opencv标定出来的内参数矩阵一般为(分辨率为640×480)

5.3193633829444082e+002 0. 3.1950000000000000e+002 0.

5.3193633829444082e+002 2.3950000000000000e+002 0. 0. 1.

这里的fx≈531.9,fy≈531.9,u0=319.5,v0=239.5。u0和v0比较好理解,差不多就是图像的中心,但是这里的fx和fy为500多还是有点抽象,虽然前面已经说了表示焦距长度对应的像素个数。根据上图中u和v的计算公式,还有标定的内参矩阵值,其实可以反推出x’、y’的大致大小,这里u的最大值是640,v的最大值为480,用这些值可以算出x’和y’的最大值分别为0.6025和0.4521,它们分别代表经过Z值归一化后的比例值,这个值实质上反映了相机的视角。

二 成像畸变

在没有畸变的情况下,理想的成像的过程是如图1-2所示

但是在实际的情况中,真正的镜头通常有一些形变,主要的变形为径向形变,也会有轻微的切向形变。所以上面的模型需要扩展为:

图2-1

k1和k2是径向形变系数,p1和p2是切向形变系数。OpenCV中没有考虑高阶系数。形变系数跟拍摄的场景无关,因此它们是内参数,而且与拍摄图像的分辨率无关。参见opencv中文wiki

opencv计算得到的畸变参数形式为:

6.7442695842244271e-002 2.4180872220967919e-001 0. 0.

-3.3970575589699975e-001

对应存放的畸变参数为[k1,k2,p1,p2[,k3[,k4,k5,k6]]

三 畸变校正

根据前面的说明,可以知道摄像机拍下来的图片是存在畸变的,现在需要根据内参矩阵和畸变参数对存在畸变的图像进行校正。校正的过程就是就是图2-1描述的过程。

首先是根据拍摄得到的存在畸变图像的坐标,计算出根据畸变模型得到的校正图像对应的坐标,这样就建立了畸变图像坐标和校正图像坐标之间的映射关系。同时计算出来的校正坐标存在小数,所以就需要对其插值。

例如XYsrc(1,1)<-->XYrect(1.5,1.0),那么假如采用简单的线性插值的话,Irect(1.5,1.0)=[Isrc(1,1)+Isrc(2,1)]*0.5

Irect就是算出来的校正后的像素值。

进行畸变的matlab校正代码(参见stackoverflow)如下:

clear;

clc;

A =[5.9418398977142772e+002 0 3.1950000000000000e+002;

0 5.941839897714e+002 2.3950000000000000e+002;

0 0 1];

D = [6.7442695842244271e-002 2.4180872220967919e-001 0 0 -3.3970575589699975e-001];

fx = A(1,1);

fy = A(2,2);

cx = A(1,3);

cy = A(2,3);

k1 = D(1);

k2 = D(2);

k3 = D(5);

p1 = D(3);

p2 = D(4);

K = A;

Idistorted = imread('logi.jpg');

Idistorted = rgb2gray(Idistorted);

Idistorted = im2double(Idistorted);

I = zeros(size(Idistorted));

[i j] = find(~isnan(I));

% Xp = the xyz vals of points on the z plane

Xp = inv(K)*[j i ones(length(i),1)]';

% Now we calculate how those points distort i.e forward map them through the distortion

r2 = Xp(1,:).^2+Xp(2,:).^2;

x = Xp(1,:);

y = Xp(2,:);

x = x.*(1+k1*r2 + k2*r2.^2) + 2*p1.*x.*y + p2*(r2 + 2*x.^2);

y = y.*(1+k1*r2 + k2*r2.^2) + 2*p2.*x.*y + p1*(r2 + 2*y.^2);

% u and v are now the distorted cooridnates

u = reshape(fx*x + cx,size(I));

v = reshape(fy*y + cy,size(I));

% Now we perform a backward mapping in order to undistort the warped image coordinates

I = interp2(Idistorted, u, v);

subplot(121); imagesc(Idistorted);

subplot(122); imagesc(I);

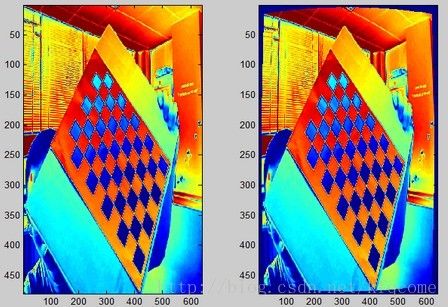

得到的结果图为: