RocketMQ源码分析之Message拉取与消费(上Broker把消息推送到对应的消费队列)

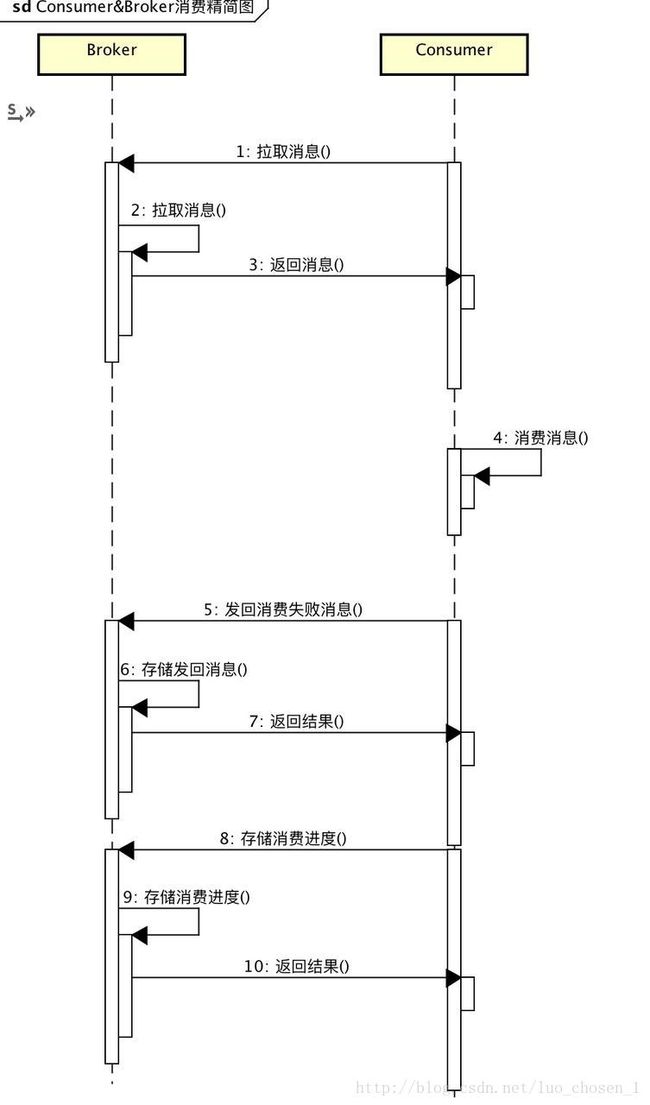

消费逻辑图:

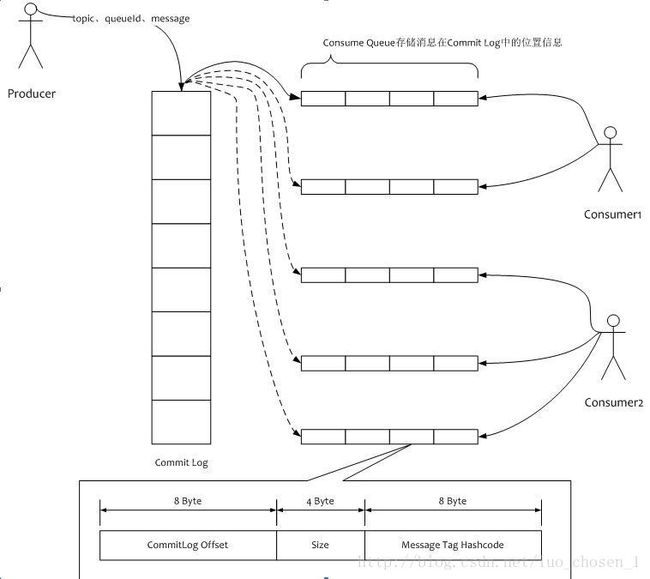

消费者队列根据Topic、QueueId分别存储相应的消息在CommitLog中的位置信息(offset、size、tagsCode),因此Consume Queue并没有存储实际要消费的信息,而是需要通过实际存储的CommitLog中的位置信息在找一遍真正的要消费的信息

消费顺序简图

ConsumeQueue存储消息

主要有两个服务组件:

- ReputMessageService:用来对消费队列执行写操作

- FlushConsumeQueueService:用来执行消费队列中的消息的刷盘服务,即将消费者队列中的内存消息刷盘到本地磁盘做持久化处理

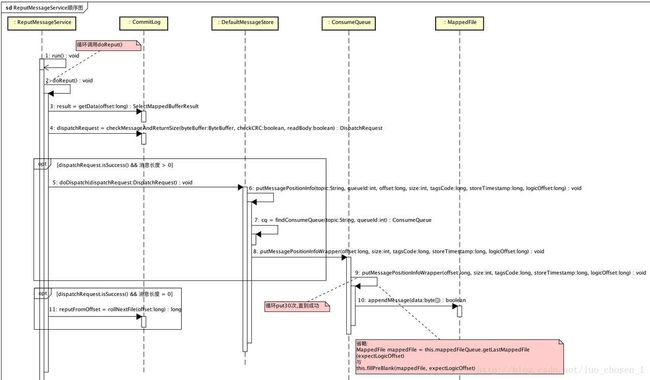

ReputMessageService

1、只要该线程服务没有停掉,就会一直调用deReput方法生成消息位置信息到消费队列,并且会不断生成消息索引到索引文件(IndexFile)

public void run() {

DefaultMessageStore.log.info(this.getServiceName() + " service started");

while (!this.isStopped()) {

try {

Thread.sleep(1);

this.doReput();

} catch (Exception e) {

DefaultMessageStore.log.warn(this.getServiceName() + " service has exception. ", e);

}

}

DefaultMessageStore.log.info(this.getServiceName() + " service end");

}2、在这个doReput中,只要CommitLog可以重放消息(通过比较reputFromOffset < DefaultMessageStore.this.commitLog.getMaxOffset()),就会一直进行循环拉取操作,除非消息能够在多个MeesageStore中存储或者reput起始位大于所规定的的固定起始位,doReput方法会直接结束。

private void doReput() {

52: for (boolean doNext = true; this.isCommitLogAvailable() && doNext; ) {

53:

54: // TODO 疑问:这个是啥

55: if (DefaultMessageStore.this.getMessageStoreConfig().isDuplicationEnable() //

56: && this.reputFromOffset >= DefaultMessageStore.this.getConfirmOffset()) {

57: break;

58: }

59:

60: // 获取从reputFromOffset开始的commitLog对应的MappeFile对应的MappedByteBuffer

//这里的reputFromOffset是不断变化的,就好比你读完一条消息后,你再去读下一条消息在CommitLogd中的位置起始点会发生变化;如果这个点到达了了这个CommitLog的最大值,就会找下一个mappedFile再读,再移动这个值

61: SelectMappedBufferResult result = DefaultMessageStore.this.commitLog.getData(reputFromOffset);

62: if (result != null) {

63: try {

64: this.reputFromOffset = result.getStartOffset();

65:

66: // 遍历MappedByteBuffer

67: for (int readSize = 0; readSize < result.getSize() && doNext; ) {

68: // 生成重放消息重放调度请求

69: DispatchRequest dispatchRequest = DefaultMessageStore.this.commitLog.checkMessageAndReturnSize(result.getByteBuffer(), false, false);

70: int size = dispatchRequest.getMsgSize(); // 消息长度

71: // 根据请求的结果处理

72: if (dispatchRequest.isSuccess()) { // 构建重放消息调度请求成功了(将buffer的消息全部读取到这个请求里面去了)

73: if (size > 0) { // 读取到了Message,那么会立即执行将消息放到消费队列的调度任务

74: DefaultMessageStore.this.doDispatch(dispatchRequest);//这个调度任务里面会将非事务消息 或 事务提交消息 建立 消息位置信息 到 ConsumeQueue【putMessagePositionInfo(String topic, int queueId, long offset, int size, long tagsCode, long storeTimestamp,

long logicOffset)实现的】,并且会建立索引信息到 、IndexFile

75: // 并且如果该Broker是主节点且一直保持长连接的话,会立即通知对应的Topic、queue时间监听器将会有新消息到达,让其做好准备

76: if (BrokerRole.SLAVE != DefaultMessageStore.this.getMessageStoreConfig().getBrokerRole()

77: && DefaultMessageStore.this.brokerConfig.isLongPollingEnable()) {

78: DefaultMessageStore.this.messageArrivingListener.arriving(dispatchRequest.getTopic(),

79: dispatchRequest.getQueueId(), dispatchRequest.getConsumeQueueOffset() + 1,

80: dispatchRequest.getTagsCode());

81: }

82: // FIXED BUG By shijia

83: this.reputFromOffset += size;

84: readSize += size;

85: // 统计

86: if (DefaultMessageStore.this.getMessageStoreConfig().getBrokerRole() == BrokerRole.SLAVE) {

87: DefaultMessageStore.this.storeStatsService

88: .getSinglePutMessageTopicTimesTotal(dispatchRequest.getTopic()).incrementAndGet();

89: DefaultMessageStore.this.storeStatsService

90: .getSinglePutMessageTopicSizeTotal(dispatchRequest.getTopic())

91: .addAndGet(dispatchRequest.getMsgSize());

92: }

93: } else if (size == 0) { // 读取到MappedFile文件尾,就指向下一个MappedFile

94: this.reputFromOffset = DefaultMessageStore.this.commitLog.rollNextFile(this.reputFromOffset);

95: readSize = result.getSize();

96: }

97: } else if (!dispatchRequest.isSuccess()) { // 完全读取buffer失败

98: if (size > 0) { // 读取到Message不是完整的Message

99: log.error("[BUG]read total count not equals msg total size. reputFromOffset={}", reputFromOffset);

100: this.reputFromOffset += size;

101: } else { //主节点出BUG了

102: doNext = false;

103: if (DefaultMessageStore.this.brokerConfig.getBrokerId() == MixAll.MASTER_ID) {

104: log.error("[BUG]the master dispatch message to consume queue error, COMMITLOG OFFSET: {}",

105: this.reputFromOffset);

106:

107: this.reputFromOffset += result.getSize() - readSize;

108: }

109: }

110: }

111: }

112: } finally {

113: result.release();

114: }

115: } else {

116: doNext = false;

117: }

118: }

119: }第 61 行 :获取 reputFromOffset 开始的 CommitLog 对应的 MappedFile 对应的 MappedByteBuffer。

第 67 行 :遍历 MappedByteBuffer。

第 69 行 :生成重放消息重放调度请求 (DispatchRequest) 。请求里主要包含一条消息 (Message) 或者 文件尾 (BLANK) 的基本信息。

第 72 至 96 行 :请求是有效请求,进行逻辑处理。

第 75 至 81 行 :当 Broker 是主节点 && Broker 开启的是长轮询,通知消费队列有新的消息。NotifyMessageArrivingListener 会 调用 PullRequestHoldService#notifyMessageArriving(…) 方法

第 73 至 92 行 :请求对应的是 Message,进行调度,生成 ConsumeQueue 和 IndexFile 对应的内容。

第 93 至 96 行 :请求对应的是 Blank,即文件尾,跳转指向下一个 MappedFile。

第 97 至 110 行 :请求是无效请求。出现该情况,基本是一个BUG。

第 127 至 128 行 :每 1ms 循环执行重放逻辑。

第 18 至 30 行 :shutdown时,多次 sleep(100) 直到 CommitLog 回放到最新位置。恩,如果未回放完,会输出警告日志。

FlushComsumeQueueService

class FlushConsumeQueueService extends ServiceThread {

//在进行消费队列flush不成功时,最多循环重复尝试3次

2: private static final int RETRY_TIMES_OVER = 3;

3: /**

4: * 最后flush时间戳,用来判断当前时间与最后一次flush时间的间隔

*如果超过了规定的一次flush间隔时间,就算消费队列中的页数没达到最小flush页数,也必须进行flush

5: */

6: private long lastFlushTimestamp = 0;

7:

8: private void doFlush(int retryTimes) {

9: int flushConsumeQueueLeastPages = DefaultMessageStore.this.getMessageStoreConfig().getFlushConsumeQueueLeastPages();

10:

11: // retryTimes == RETRY_TIMES_OVER时,进行强制flush。主要用于shutdown时。

12: if (retryTimes == RETRY_TIMES_OVER) {

13: flushConsumeQueueLeastPages = 0;

14: }

15: // 当时间满足flushConsumeQueueThoroughInterval时,即使写入的数量不足flushConsumeQueueLeastPages,也进行flush

16: long logicsMsgTimestamp = 0;

17: int flushConsumeQueueThoroughInterval = DefaultMessageStore.this.getMessageStoreConfig().getFlushConsumeQueueThoroughInterval();

18: long currentTimeMillis = System.currentTimeMillis();

19: if (currentTimeMillis >= (this.lastFlushTimestamp + flushConsumeQueueThoroughInterval)) {

20: this.lastFlushTimestamp = currentTimeMillis;

21: flushConsumeQueueLeastPages = 0;

22: logicsMsgTimestamp = DefaultMessageStore.this.getStoreCheckpoint().getLogicsMsgTimestamp();

23: }

24: // 先获得消费队列表,然后两次循环flush消费队列,是对Broker里面的所有的消费队列进行flush,并不是单个flush

25: ConcurrentHashMap> tables = DefaultMessageStore.this.consumeQueueTable;

26: for (ConcurrentHashMap maps : tables.values()) {

27: for (ConsumeQueue cq : maps.values()) {

28: boolean result = false;

29: for (int i = 0; i < retryTimes && !result; i++) {

30: result = cq.flush(flushConsumeQueueLeastPages);

31: }

32: }

33: }

34: // flush 存储 check point

35: if (0 == flushConsumeQueueLeastPages) {

36: if (logicsMsgTimestamp > 0) {

37: DefaultMessageStore.this.getStoreCheckpoint().setLogicsMsgTimestamp(logicsMsgTimestamp);

38: }

39: DefaultMessageStore.this.getStoreCheckpoint().flush();

40: }

41: }

42:

43: public void run() {

44: DefaultMessageStore.log.info(this.getServiceName() + " service started");

45: //只要这个刷盘服务线程没有停止,就会一直不断刷盘

46: while (!this.isStopped()) {

47: try {

48: int interval = DefaultMessageStore.this.getMessageStoreConfig().getFlushIntervalConsumeQueue();//保证每隔interval时间执行一次flush,这个间隔内就等待不执行flush,提高性能

49: this.waitForRunning(interval);

50: this.doFlush(1);

51: } catch (Exception e) {

52: DefaultMessageStore.log.warn(this.getServiceName() + " service has exception. ", e);

53: }

54: }

55:

56: this.doFlush(RETRY_TIMES_OVER);//就算flush线程停止服务,也能保证对之前的消费队列进行刷盘,确保数据的正确性和完整得持久到磁盘

57:

58: DefaultMessageStore.log.info(this.getServiceName() + " service end");

59: }

60:

61: @Override

62: public String getServiceName() {

63: return FlushConsumeQueueService.class.getSimpleName();

64: }

65:

66: @Override

67: public long getJointime() {

68: return 1000 * 60;

69: }

70: } Broker提供(拉取消息)接口

PullMessagerRequestHeader提供了封装拉取消息请求的类,里面包括consumerGroup、topic、queueId、queueOffset、maxMsgNums(消息数量)、sysFlag(系统标识位)、commitOffset(消息提交进度位置)、suspendTimeoutMillis(挂起超时时间)、subscription(订阅表达式)、subVersion(订阅版本号)

sysFlag :系统标识位,第0位与消息提交进度位置有关、第一位标记请求时候挂起、第二位标识是否过滤订阅表达式

subVersion :订阅版本号。请求时,如果版本号不对,则无法拉取到消息,需要重新获取订阅信息,使用最新的订阅版本号。

PullMessageProcessor#processRequest(源码太长不贴出来)

- 校验Broker是否可读

- 校验SubscriptionGroupConfig订阅分组位置是否存在并且可以消费

- 处理PullMessageRequestHeader.sysFlag对应的标识位

- 校验 TopicConfig(主题配置) 是否存在 && 可读 && 队列编号正确

- 校验 SubscriptionData(订阅信息) 是否正确

- 调用 MessageStore#getMessage(…) 获取 GetMessageResult(消息)

- 根据getMeessageStatus获取消息状态进行相应的switch语句处理

- 根据hasConsumeMessageHook()钩子判断后分别再做不同的处理

- 如果请求要求持久化进度并且Broker不是主节点,那么就执行持久化进度【consumerOffset.json :消费进度存储文件。consumerOffset.json.bak :消费进度存储文件备份。每次写入 consumerOffset.json,将原内容备份到 consumerOffset.json.bak】

- 最后返回response

MessageStore#getMessage()重点

根据 消息分组(group) + 主题(Topic) + 队列编号(queueId) + 队列位置(offset) + 订阅信息(subscriptionData) 获取 指定条数(maxMsgNums) 消息(Message)。

1: /**

2: * 获取消息结果

3: *

4: * @param group 消费分组

5: * @param topic 主题

6: * @param queueId 队列编号

7: * @param offset 队列位置

8: * @param maxMsgNums 消息数量

9: * @param subscriptionData 订阅信息

10: * @return 消息结果

11: */

12: public GetMessageResult getMessage(final String group, final String topic, final int queueId, final long offset, final int maxMsgNums,

13: final SubscriptionData subscriptionData) {

14: // 是否关闭

15: if (this.shutdown) {

16: log.warn("message store has shutdown, so getMessage is forbidden");

17: return null;

18: }

19: // 是否可读

20: if (!this.runningFlags.isReadable()) {

21: log.warn("message store is not readable, so getMessage is forbidden " + this.runningFlags.getFlagBits());

22: return null;

23: }

24:

25: long beginTime = this.getSystemClock().now();

26:

27: GetMessageStatus status = GetMessageStatus.NO_MESSAGE_IN_QUEUE;

28: long nextBeginOffset = offset;

29: long minOffset = 0;

30: long maxOffset = 0;

31:

32: GetMessageResult getResult = new GetMessageResult();

33:

34: final long maxOffsetPy = this.commitLog.getMaxOffset();

35:

36: // 获取消费队列

37: ConsumeQueue consumeQueue = findConsumeQueue(topic, queueId);

38: if (consumeQueue != null) {

39: minOffset = consumeQueue.getMinOffsetInQueue(); // 消费队列 最小队列编号

40: maxOffset = consumeQueue.getMaxOffsetInQueue(); // 消费队列 最大队列编号

41:

42: // 判断 队列位置(offset)

43: if (maxOffset == 0) { // 消费队列无消息

44: status = GetMessageStatus.NO_MESSAGE_IN_QUEUE;

45: nextBeginOffset = nextOffsetCorrection(offset, 0);

46: } else if (offset < minOffset) { // 查询offset 太小

47: status = GetMessageStatus.OFFSET_TOO_SMALL;

48: nextBeginOffset = nextOffsetCorrection(offset, minOffset);

49: } else if (offset == maxOffset) { // 查询offset 超过 消费队列 一个位置

50: status = GetMessageStatus.OFFSET_OVERFLOW_ONE;

51: nextBeginOffset = nextOffsetCorrection(offset, offset);

52: } else if (offset > maxOffset) { // 查询offset 超过 消费队列 太多(大于一个位置)

53: status = GetMessageStatus.OFFSET_OVERFLOW_BADLY;

54: if (0 == minOffset) { // TODO blog 这里是??为啥0 == minOffset做了特殊判断

55: nextBeginOffset = nextOffsetCorrection(offset, minOffset);

56: } else {

57: nextBeginOffset = nextOffsetCorrection(offset, maxOffset);

58: }

59: } else {

60: // 获得 映射Buffer结果(MappedFile)

61: SelectMappedBufferResult bufferConsumeQueue = consumeQueue.getIndexBuffer(offset);

62: if (bufferConsumeQueue != null) {

63: try {

64: status = GetMessageStatus.NO_MATCHED_MESSAGE;

65:

66: long nextPhyFileStartOffset = Long.MIN_VALUE; // commitLog下一个文件(MappedFile)对应的开始offset。

67: long maxPhyOffsetPulling = 0; // 消息物理位置拉取到的最大offset

68:

69: int i = 0;

70: final int maxFilterMessageCount = 16000;

71: final boolean diskFallRecorded = this.messageStoreConfig.isDiskFallRecorded();

72: // 循环获取 消息位置信息

73: for (; i < bufferConsumeQueue.getSize() && i < maxFilterMessageCount; i += ConsumeQueue.CQ_STORE_UNIT_SIZE) {

74: long offsetPy = bufferConsumeQueue.getByteBuffer().getLong(); // 消息物理位置offset

75: int sizePy = bufferConsumeQueue.getByteBuffer().getInt(); // 消息长度

76: long tagsCode = bufferConsumeQueue.getByteBuffer().getLong(); // 消息tagsCode

77: // 设置消息物理位置拉取到的最大offset

78: maxPhyOffsetPulling = offsetPy;

79: // 当 offsetPy 小于 nextPhyFileStartOffset 时,意味着对应的 Message 已经移除,所以直接continue,直到可读取的Message。

80: if (nextPhyFileStartOffset != Long.MIN_VALUE) {

81: if (offsetPy < nextPhyFileStartOffset)

82: continue;

83: }

84: // 校验 commitLog 是否需要硬盘,无法全部放在内存

85: boolean isInDisk = checkInDiskByCommitOffset(offsetPy, maxOffsetPy);

86: // 是否已经获得足够消息

87: if (this.isTheBatchFull(sizePy, maxMsgNums, getResult.getBufferTotalSize(), getResult.getMessageCount(),

88: isInDisk)) {

89: break;

90: }

91: // 判断消息是否符合条件

92: if (this.messageFilter.isMessageMatched(subscriptionData, tagsCode)) {

93: // 从commitLog获取对应消息ByteBuffer

94: SelectMappedBufferResult selectResult = this.commitLog.getMessage(offsetPy, sizePy);

95: if (selectResult != null) {

96: this.storeStatsService.getGetMessageTransferedMsgCount().incrementAndGet();

97: getResult.addMessage(selectResult);

98: status = GetMessageStatus.FOUND;

99: nextPhyFileStartOffset = Long.MIN_VALUE;

100: } else {

101: // 从commitLog无法读取到消息,说明该消息对应的文件(MappedFile)已经删除,计算下一个MappedFile的起始位置

102: if (getResult.getBufferTotalSize() == 0) {

103: status = GetMessageStatus.MESSAGE_WAS_REMOVING;

104: }

105: nextPhyFileStartOffset = this.commitLog.rollNextFile(offsetPy);

106: }

107: } else {

108: if (getResult.getBufferTotalSize() == 0) {

109: status = GetMessageStatus.NO_MATCHED_MESSAGE;

110: }

111:

112: if (log.isDebugEnabled()) {

113: log.debug("message type not matched, client: " + subscriptionData + " server: " + tagsCode);

114: }

115: }

116: }

117: // 统计剩余可拉取消息字节数

118: if (diskFallRecorded) {

119: long fallBehind = maxOffsetPy - maxPhyOffsetPulling;

120: brokerStatsManager.recordDiskFallBehindSize(group, topic, queueId, fallBehind);

121: }

122: // 计算下次拉取消息的消息队列编号

123: nextBeginOffset = offset + (i / ConsumeQueue.CQ_STORE_UNIT_SIZE);

124: // 根据剩余可拉取消息字节数与内存判断是否建议读取从节点

125: long diff = maxOffsetPy - maxPhyOffsetPulling;

126: long memory = (long) (StoreUtil.TOTAL_PHYSICAL_MEMORY_SIZE

127: * (this.messageStoreConfig.getAccessMessageInMemoryMaxRatio() / 100.0));

128: getResult.setSuggestPullingFromSlave(diff > memory);

129: } finally {

130: bufferConsumeQueue.release();

131: }

132: } else {

133: status = GetMessageStatus.OFFSET_FOUND_NULL;

134: nextBeginOffset = nextOffsetCorrection(offset, consumeQueue.rollNextFile(offset));

135: log.warn("consumer request topic: " + topic + "offset: " + offset + " minOffset: " + minOffset + " maxOffset: "

136: + maxOffset + ", but access logic queue failed.");

137: }

138: }

139: } else {

140: status = GetMessageStatus.NO_MATCHED_LOGIC_QUEUE;

141: nextBeginOffset = nextOffsetCorrection(offset, 0);

142: }

143: // 统计

144: if (GetMessageStatus.FOUND == status) {

145: this.storeStatsService.getGetMessageTimesTotalFound().incrementAndGet();

146: } else {

147: this.storeStatsService.getGetMessageTimesTotalMiss().incrementAndGet();

148: }

149: long eclipseTime = this.getSystemClock().now() - beginTime;

150: this.storeStatsService.setGetMessageEntireTimeMax(eclipseTime);

151: // 设置返回结果

152: getResult.setStatus(status);

153: getResult.setNextBeginOffset(nextBeginOffset);

154: getResult.setMaxOffset(maxOffset);

155: getResult.setMinOffset(minOffset);

156: return getResult;

157: }

158:

159: /**

160: * 根据 主题 + 队列编号 获取 消费队列

161: *

162: * @param topic 主题

163: * @param queueId 队列编号

164: * @return 消费队列

165: */

166: public ConsumeQueue findConsumeQueue(String topic, int queueId) {

167: // 获取 topic 对应的 所有消费队列

168: ConcurrentHashMap map = consumeQueueTable.get(topic);

169: if (null == map) {

170: ConcurrentHashMap newMap = new ConcurrentHashMap<>(128);

171: ConcurrentHashMap oldMap = consumeQueueTable.putIfAbsent(topic, newMap);

172: if (oldMap != null) {

173: map = oldMap;

174: } else {

175: map = newMap;

176: }

177: }

178: // 获取 queueId 对应的 消费队列

179: ConsumeQueue logic = map.get(queueId);

180: if (null == logic) {

181: ConsumeQueue newLogic = new ConsumeQueue(

182: topic,

183: queueId,

184: StorePathConfigHelper.getStorePathConsumeQueue(this.messageStoreConfig.getStorePathRootDir()),

185: this.getMessageStoreConfig().getMapedFileSizeConsumeQueue(),

186: this);

187: ConsumeQueue oldLogic = map.putIfAbsent(queueId, newLogic);

188: if (oldLogic != null) {

189: logic = oldLogic;

190: } else {

191: logic = newLogic;

192: }

193: }

194:

195: return logic;

196: }