SqueezeNet | 轻量级深层神经网络

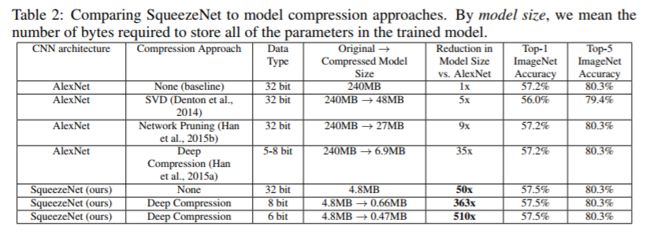

SqueezeNet的作者来自Berkeley和Stanford,论文的题目毫无学术气息,且有一股浓烈的网络爆文感。SqueezeNet: AlexNet-level accuracy with 50x fewer parameters and <0.5MB model size. 论文的题目直接的表达了论文的结果,实现了与AlexNet相同精度,但只用了1/50的参数量。且模型的参数量最少可以压缩到0.5M,这是AlexNet的1/510的参数量。SqueezeNet提出了FireModule模块实现了参数优化。

论文链接:http://arxiv.org/abs/1602.07360

代码链接(Caffe):https://github.com/DeepScale/SqueezeNet

代码链接(Keras):https://github.com/rcmalli/keras-squeezenet

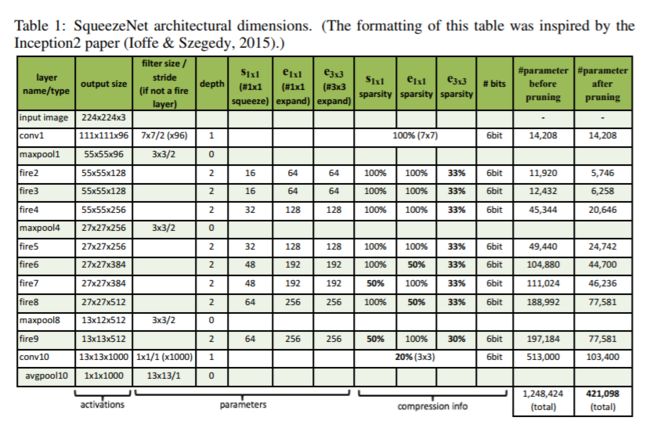

1.SqueezeNet网络结构

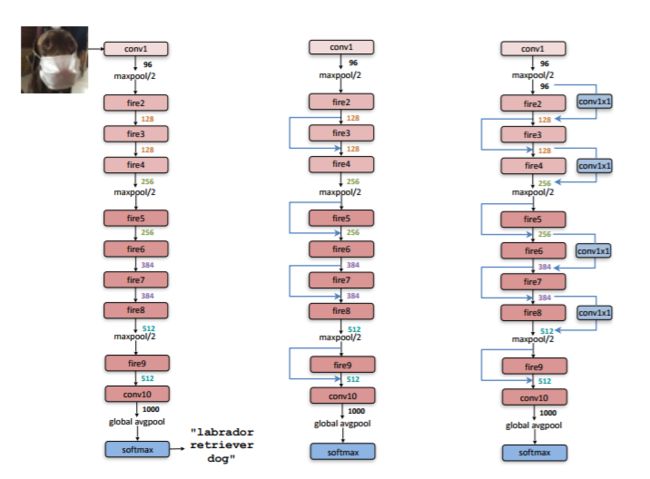

SqueezeNet网络结构如下,其核心结构FireModule的组合形式。左图是SqueezeNet的整体结构,中图和右图是将ResNet网络中的shortcut引入所构建的网络,所以只是一种提升策略与SqueezeNet无关,本文不多做解释。

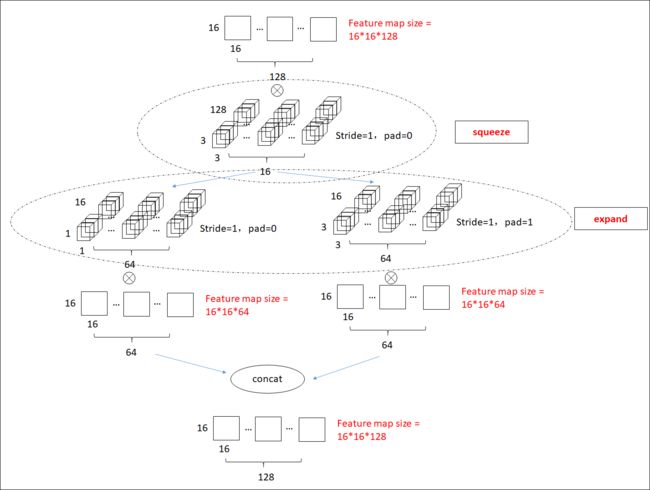

2.FireModule详解

接下来通过图文并茂的方式来解释FireModule是如何工作的。

如上图所示,FireModule由squeeze模块和expand模块。该模块的主要有两大特性。

(1)squeeze模块:利用1*1卷积进行降维(所以如图中的16<128)

(2)expand模块:利用11卷积+33卷积组合升维。

整个网络还有一个特性:

(3)将poolint采样操作延后,可以给卷积层提供更大的激活图:更大的激活图保留了更多的信息,可以提供更高的分类准确率

其中,(1)和(2)可以显著减少参数数量,(3)可以在参数数量受限的情况下提高准确率。