我站在湖边,看到了岸,而我们的人却迷失在了湖心。——致所有已逝项目

前言

文章写了一年多了,一直不敢发,这是一篇幻想性比较大的文章。

本文可能会浪费您10分钟左右时间,也有可能给你一次菩提灌顶。

这个本文想说的结构,发上来之前已经修改了里面诸多跟项目相关的内容,如果有不通的地方,敬请谅解。

正文:

试想一下:

在无数的科幻电影中,我们都曾看过薄如纸的平板电脑,还能投射出立体的影像,并且能进行定位性的即时通讯,将双方的实景情况进行场景的模拟在线。

听起来不可思议,很多行业从业者曾经将目光投射于实体的终端机上,不断的加强终端机的性能、功能等等因素。然这种现象的实际措施却犹如数学上的解题方法,看似几何问题的函数题目,而这个函数的题目却同时拥有多个未知函数的假设进行运算,这种解题中会遇到两种情况,盲点和路径。盲点:网络时代让终端机显得未必那么重要;路径:未必只有实现终端机性能的一种方式。

我们项目的设想:

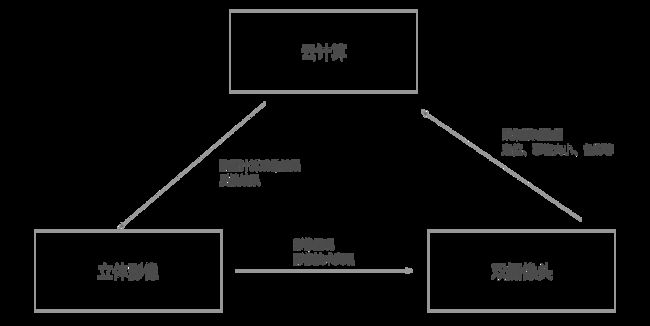

云技术和网络技术很有效的解决了这一现实因素,至少终端机上所能搭载的一切pc端软件的可能被提升到最大,这使得终端机能做很多意想不到的事情,因为所有的软件处理、影像处理都在云端进行完成。服务器端将完成用户大量的数据处理和影像建模,并且把所有设备的性能利用率使用到极限,资源的整合是对人类可持续发展的重要理念,能量的消耗和利用率,新生代几乎都能理解能量的关系。人们无需携带一个庞大的处理机器进行实时的人机交互,这便是云端的最大优势,一个庞大的超级计算机解决所有性能问题。

而实际可被终端机所使用的,是传输和再现影像,因为用户所关注的是五官的感受,而并非犹如CPU那般需要处理大量的信息,这一点唐纳德诺曼的情感化设计很好的解释了人与机器的内在关系。由而摆脱了性能的束缚,终端机还需要做什么?犹如斯塔克手中的pad一般,展现全息投影和立体交互的神奇效果,Ted的讲座完美的展现了穿戴设备实现这一景象的可能。

终端机和云端的完美结合,从而实现了人们不一样的人机体验,进而为沉浸式体验设计提供了坚实的功能基础,这就是我们所要做的事情。(美好憧憬)

现实是:

此刻我们必须清楚的认识到,我们产品的雏形只是一个移动的服务器+附带图像的玻璃屏。

真正的联系?

言归正传,而这件事和iPhone7的双摄像头有何联系?我想看过Ted那次演讲的读者通过上文的浏览隐约已经知道了,苹果公司在为新的革命书写乐章。

如果要高度还原场景需要终端机上两个硬件设备——摄像头和投影镜头。

在iPhone系列多次的镜头升级后,iPhone7 Plus终于用上了后置双摄像头,但请注意,它的双摄像头功能是目前绝无仅有的——一广角镜+一长焦镜的组合。有了长焦镜的帮助,iPhone终于历史性地实现了光学变焦,而且这种光学变焦并非卡片机常见的伸缩式,虽然只有两倍的光变倍率,但光学变焦的代名词便是无损画质。相比数码变焦强行拉伸像素点令画质拙劣的不足,光学变焦的优势显而易见。(来源于网易)(请吐槽双摄像头的同学自行脑补)

下面要进行有关摄像头的技术详解了:

光学变焦

光学变焦主要是左右摄像头使用不同的FOV(可视角),这样两个摄像头取景不同。当用户需要广角照片,则用视角为85度的左摄像头取景,获得广角效果。当用户需要长焦照片,则用视角为45度的右摄像头取景,获得长焦效果。

为了使左右摄像头拍摄的物体重叠度高,光学变焦的双摄像头模组不能像做距离应用的摄像头的模组那样距离过大,而是需要将左右摄像头摆得越近越好。

距离相关应用

人眼是很容易对一个物体的距离进行定位,但当人闭上其中一个眼睛后,定位能力就会下降很多。

哔哔了那么多,其实想说的是双摄像头就是模拟人眼的应用。

简单的说,测距离的话,就是通过算法算出,被拍摄物体与左/右摄像头的角度θ1和θ2,再加上固定的y值(即两个摄像头的中心距),就非常容易算出z值(即物体到Camera的距离)

不过这也很容易推算,若两个摄像头中心距过小的话,可计算的物体距离就会很近。若想算出很远距离,就必须让左右摄像头的距离拉远。

3D拍摄和3D建模

3D拍摄和3D建模的算法其实跟距离应用十分相似,因为考虑到半角或全角的移动,因此它的精度要求更高,必要的时候需要用红外测距进行更准确的距离判断。

对ISP的要求

提到双摄像头的算法,不得不提到ISP(Image Signal Processing 图像信号处理器),ISP主要作用是对前端图像传感器输出的信号做后期处理,主要功能有线性纠正、噪声去除、坏点去除、内插、白平衡、自动曝光控制等,依赖于ISP才能在不同的光学条件下都能较好的还原现场细节,ISP技术在很大程度上决定了手机的成像质量。

功能机时代,ISP都是做在摄像头上的,不同像素的摄像头搭配不同性能的ISP。随着手机摄像头像素越来越高,对ISP性能的要求越来越高,若将ISP集成到摄像头Sensor上,势必造成摄像头的模组过大,甚至影响拍照效果。所以智能机时代,ISP一般都是在主芯片SoC上。部分品牌客户为了实现更好的效果,甚至不惜成本的外加一颗ISP用来达到更好更专业的拍照效果。

7p的两个摄像头并没有独立的ISP,有两个独立传感器,应该是集成在 a10处理器上了(这里讲的不对,希望专业人士纠正)。

好的拍照算法就需要搭配好的ISP,ISP和算法相辅相成,缺一不可。而双摄像头对ISP性能要求更多。首先,为了使的左右摄像头的信号能够同时被处理,单一的ISP已经无法满足双摄像头的需求。这就需要双路ISP实现此功能。

以暗光增强为例,彩色/黑白图像分别进入各自的ISP通道和校准通道,然后将两副图片做匹配(如将两幅图片相同的部分提取出来,去除只有一个摄像头拍到的部分),然后通过遮挡,检测,补偿等算法 处理相关的图片。最后将两幅图片融合起来,实现颜色的增强。当然实际上ISP配合算法做的事情,远远比这图片上写的要多。Apple的图像算法我估计国内没人知道,就不在这误导大家了。

在虎嗅上看大神拆机图里没有看到苹果独立的ISP,但还是在这里面说一个小小的插曲。如果是两个ISP,两个ISP多少有一些处理速度,处理能力不同的问题。为了保证两个ISP能在同一时间上取样,就需要双摄像头拍出来的图片是同一时间拍出来的。其中一个解决办法就是让Sensor有一个同步信号引脚。将两个摄像头的同步信号对接,在每次读取图片时,将图片都打上一个时间戳,ISP通过时间戳,保证左右摄像头拍出来的照片在同一时间拍摄,最终再进行融合。

虽然苹果这几年在半导体方面和相机拍照品质的大量投资,但没有使用独立的ISP,应该有其独到之处。

摄像头的接口

一般来讲,目前的智能手机的摄像头接口都是MIPI接口。之前手机平台都只有2路MIPI接口,分别给前摄像头和后摄像头。做双摄像头,就要求平台至少支持三路MIPI接口。其实在之前的高端平台上,为了实现更高像素,已经用双路ISP了(比如为了支持16M的摄像头,会用2路8M能力的ISP),这类平台很有可能只有两路MIPI。但这个无法阻止工程师去做前单摄像头+后双摄像头。只需要加一个小小的Swtich,就可以轻松实现双摄像头。

(以上部份内容来源于半导体行业观察网)

至于投影镜头,有点类似摄影头反编译化的程序,将摄像头捕捉的3d影像,通过投影镜头在另一个时空中表达出来。现在图像捕捉、采集的技术已经相对比较先进了,但是投影的技术尚未获得重大的突破,目前的全息投影技术,主要分两类:180度的平面投影和360的全方位投影。很抱歉现在我们还没有完全实现……

在互联网的浪潮下,我们处在云端技术的风口浪尖,我们无法把控方向,但是我们知道,终有一天,风浪会将我们推向彼岸。