今日资料:

《Tensorflow 实战》-策略网络

代码:

https://github.com/awjuliani/DeepRL-Agents/blob/master/Policy-Network.ipynb

强化学习是机器学习的一个重要分支,可以解决连续决策的问题。

一个强化学习问题,主要包含三个概念,环境状态,行动,奖励, 强化学习的目标就是获得最多的累计奖励。

它有很多应用,比如控制机器人,无人驾驶,商品定价,库存管理,玩游戏,例如AlphaGo。

例如在围棋这个游戏中,环境状态指的是已经出现的某个局势,行动指在某个位置落子,奖励是指当前这步棋获得的目数,最终的目标就是在结束时总目数超过对手,它是以最终结果为目标,而不是只看当下某个行动带来的利益。

强化学习不像无监督学习那样完全没有学习目标,也不像监督学习那样有非常明确的目标,他的目标一般是变化的不明确的。在围棋游戏中19×19的棋盘带来了3^361种状态,这是无法通过暴力搜索来战胜人类的,所以就需要给计算机抽象思维的能力。AlphaGo 主要使用了快速走子,策略网络,估值网络,和蒙特卡洛搜索树等技术。

深度强化学习模型本质上也是神经网络,主要分为策略网络和估值网络。

强化学习中最重要的两类方法, Policy-based , Valu-based。

第一种是直接预测在某个环境状态下应该采取的行动,第二种是预测在某个环境状态下所有行动的期望价值,然后通过选择 Q 值最高的行动执行策略。

今天要先来实现一下策略网络,就是要建立一个神经网络模型,可以通过观察环境状态预测出目前最应该执行的策略以及可以获得的最大的期望收益。

我们不会告诉它什么才是比较好的行动,而是需要它通过试验样本自己学习出什么才是某个环境状态下比较好的行动, 也就是它的学习目标是期望价值,包括当前的奖励和未来潜在的奖励,会把未来所有的奖励乘以衰减系数。

策略模型的训练方法是 Policy Gradients,好的行动会带来高期望值,差的行动会带来低期望值,通过对这些样本的学习,模型会逐渐增加,选择好行动的概率。

今天的代码是要用 Tensorflow 创建一个基于策略网络的 Agent 来解决 CartPole 问题。这个问题是一个经典的可以用强化学习来解决的控制问题。就是在它的环境中有一个小车,在一个一维的无阻力轨道上行动,在车上绑着一个连接不太结实的杆儿,这个杆儿会左右摇晃。每个环境信息包含四个值,例如小车的位置速度等,我们不需要编写逻辑来控制小车,而是设计一个策略网络,让它自己从这些数值中学习到环境信息,并制定最佳策略。

安装gym,创建 CartPole 问题的环境。

import gym

env = gym.make('CartPole-v0')

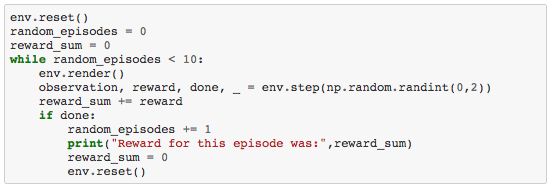

首先,初始化环境,然后进行十次随机试验,在产生随机的行动,然后执行这些行动,并获得,然后把 reward 累加。

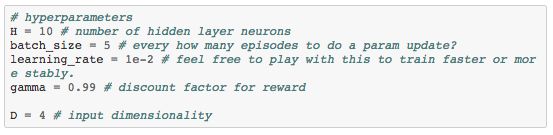

我们的策略网络是要使用一个简单的带有一个隐含层的 MLP,隐含层节点数为10,环境信息的维度为4。

首先创建 observation 的 placeholder,然后用 xavier 这个初始化算法来创建隐含层的权重W1,再用ReLu激活函数得到隐藏层的输出,同样初始化W2,再用 sigmoid 激活函数得到最后的输出概率。

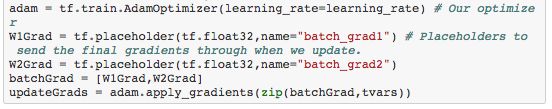

优化器用adam算法,然后执行 updategrads 更新模型参数。

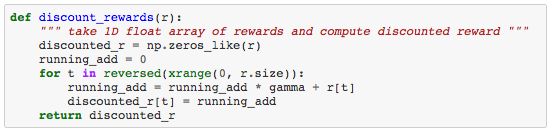

下面这个函数是用来估算每一个行动对应的潜在价值,越靠后的行动的期望价值越小,越靠前的价值越大。running add 就是潜在价值,GSM是衰减系数,我们要从后向前累计这些价值。

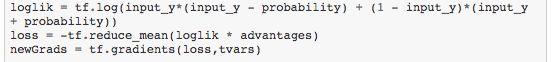

loglik 是当前行动对应的概率的对数,loss就是我们要做的优化目标。

总是验证次数为一万次,直到累计奖励达到200时停止训练。

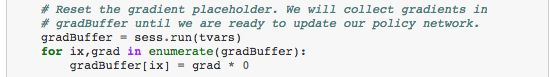

gradbuffer 用来存储参数的梯度,完成一个 batch 试验之后再将总梯度更新到模型参数。

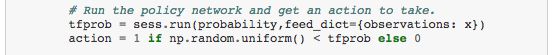

用 reshape 得到策略网络输入的格式,然后获得网络输出的概率 tfprob,然后在 0-1 之间随机抽样得到 action,如果它小于这个概率就利用行动取值为1,否则为0。

然后用 discount rewards 函数来计算每一步行动的潜在价值,并进行标准化。

用 newgrads 求解梯度,再将获得的梯度累加。

推荐阅读 历史技术博文链接汇总

http://www.jianshu.com/p/28f02bb59fe5

也许可以找到你想要的